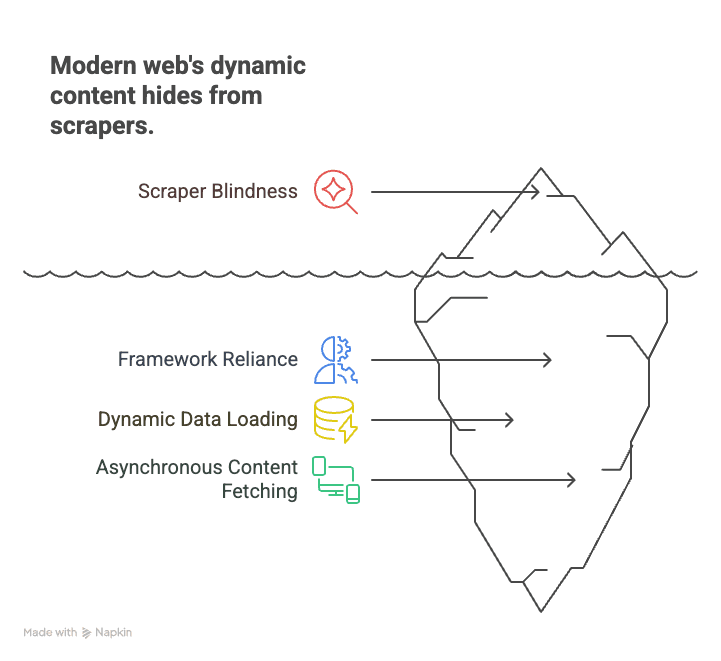

Wer schon mal versucht hat, von einer modernen Webseite wie einem Immobilienportal, Online-Shop oder Social-Media-Feed Daten zu ziehen, kennt das Problem: Die Seite lädt, du checkst den HTML-Code – und findest… nichts. Die Infos, die du suchst – Preise, Angebote, Bewertungen – sind einfach nicht da. Der Grund: Das Web besteht heute fast komplett aus clientseitigem JavaScript. Fast 99 % aller Websites nutzen JavaScript, um Inhalte anzuzeigen (). Herkömmliche Crawler sind da wie jemand, der nur das Drehbuch liest, aber nie den Film sieht.

Aus meiner Erfahrung im SaaS- und Automatisierungsbereich weiß ich, wie sehr das viele Unternehmen, Vertriebsteams und Analysten ins Schwitzen bringt. Die gute Nachricht: javascript crawling ist längst nicht mehr nur was für Entwickler. Mit den richtigen Tools – und ein bisschen KI wie bei – kann heute jeder Daten auch von dynamischen, interaktiven Seiten holen. In diesem Guide erfährst du, was crawling von javascript-generierten seiten bedeutet, warum es so wichtig ist und wie du ganz ohne Programmierkenntnisse loslegen kannst.

Was ist JavaScript Crawling? Und warum ist es für moderne Web-Daten so entscheidend?

Lass uns mit den Basics starten. JavaScript Crawling heißt, dass ein Tool oder Bot die Webseite komplett lädt, alles JavaScript ausführt und erst dann die sichtbaren Inhalte extrahiert. Das ist ein riesiger Unterschied zum klassischen HTML-Scraping, das nur den Roh-Quellcode vom Server abgreift. Heute ist dieses HTML oft nur ein leeres Gerüst – die echten Inhalte (wie Produktlisten, Bewertungen oder Preise) werden erst durch JavaScript nachgeladen, oft erst nach Scrollen, Klicken oder anderen Aktionen.

Warum ist das so wichtig? Moderne Websites setzen auf Frameworks wie React, Angular oder Vue. Diese sogenannten Single-Page-Apps (SPAs) laden Daten dynamisch nach, sodass statische Scraper den Großteil der Inhalte gar nicht sehen. Beispiele:

- E-Commerce: Preise und Lagerbestände erscheinen erst nach Scrollen oder Filtern.

- Immobilien: Angebote werden beim Herunterscrollen dynamisch nachgeladen.

- Social Media: Beiträge, Kommentare und Likes werden asynchron geladen und sind im HTML nicht sichtbar.

Klassische Crawler sehen nur eine leere Hülle und verpassen alles Wichtige. javascript crawling funktioniert dagegen wie ein echter Nutzer: Die Seite wird im Browser geöffnet, alle Skripte laufen ab, und erst dann werden die sichtbaren Inhalte extrahiert.

Kurz gesagt: Wer 2025 Daten von modernen Websites holen will, kommt an google javascript crawling nicht vorbei ().

Die größten Herausforderungen beim JavaScript Crawling (und wie du sie meisterst)

javascript crawling ist mehr als „Scraping mit ein paar Extras“. Es bringt eigene Hürden mit sich. Hier die wichtigsten – und wie du sie knackst.

Dynamische Inhaltsdarstellung

Das Problem: Die meisten Inhalte stehen gar nicht im HTML, sondern werden erst nach dem Laden per JavaScript eingefügt – manchmal erst nach Scrollen, Klicken oder Netzwerkaufrufen. Wer nur das HTML abruft, bekommt Platzhalter oder leere Container.

Die Lösung: Nutze einen Headless Browser – ein Tool, das wie ein echter Browser funktioniert, alle Skripte ausführt und wartet, bis die Inhalte sichtbar sind. Tools wie und sind hier Standard. Sie ermöglichen:

- Seitenaufruf mit kompletter JavaScript-Ausführung

- Warten auf bestimmte Elemente (z. B. „.product-list“)

- Extraktion der komplett gerenderten Inhalte aus dem DOM

Diese Methode ist heute der Goldstandard für das Scraping dynamischer Seiten ().

Anti-Bot- und Automatisierungs-Schutzmechanismen

Das Problem: Websites werden immer besser darin, Bots zu erkennen und zu blockieren. Typische Hürden sind:

- CAPTCHAs

- IP-Sperren oder Rate-Limiting

- Browser-Fingerprinting (Prüfung, ob echter Nutzer)

- Honeypots (Fallen für Bots)

Die Lösung: Verhalte dich wie ein Mensch und halte dich an die Regeln:

- Respektiere robots.txt und die Nutzungsbedingungen.

- Drossle deine Anfragen – baue zufällige Pausen ein, überlaste den Server nicht.

- Wechsle IPs bei großem Umfang (aber immer fair bleiben).

- Nutze echte Browser-Header und vermeide typische Bot-Merkmale.

- Keine Logins umgehen oder CAPTCHAs ohne Erlaubnis aushebeln.

Thunderbit empfiehlt zum Beispiel, nur öffentlich zugängliche Daten zu extrahieren und setzt auf Best Practices für rechtliche Konformität ().

Unendliches Scrollen und nutzergesteuerte Events

Das Problem: Viele Seiten laden Inhalte erst beim Scrollen oder nach Klicks nach. Wer nur das Sichtbare abruft, verpasst den Großteil der Daten.

Die Lösung: Browser-Automatisierung nutzen, um:

- Scrollen zu simulieren (wie ein echter Nutzer)

- „Mehr laden“-Buttons oder Tabs zu klicken

- Warten, bis neue Inhalte erscheinen, bevor extrahiert wird

Thunderbits KI erkennt solche Muster und übernimmt das Scrollen oder die Paginierung automatisch – ganz ohne eigene Skripte ().

Performance und Skalierbarkeit

Das Problem: Für jede Seite einen Headless Browser zu starten, ist ressourcenintensiv. Hunderte oder tausende Seiten zu scrapen, kann den Rechner schnell ausbremsen.

Die Lösung: Paralleles Crawling – mehrere Browser oder Tabs gleichzeitig nutzen. Oder noch besser: Die Arbeit in die Cloud auslagern. Thunderbits Cloud-Scraping-Beschleuniger (Lightning Network) kann bis zu 50 Seiten gleichzeitig verarbeiten und beschleunigt große Projekte enorm ().

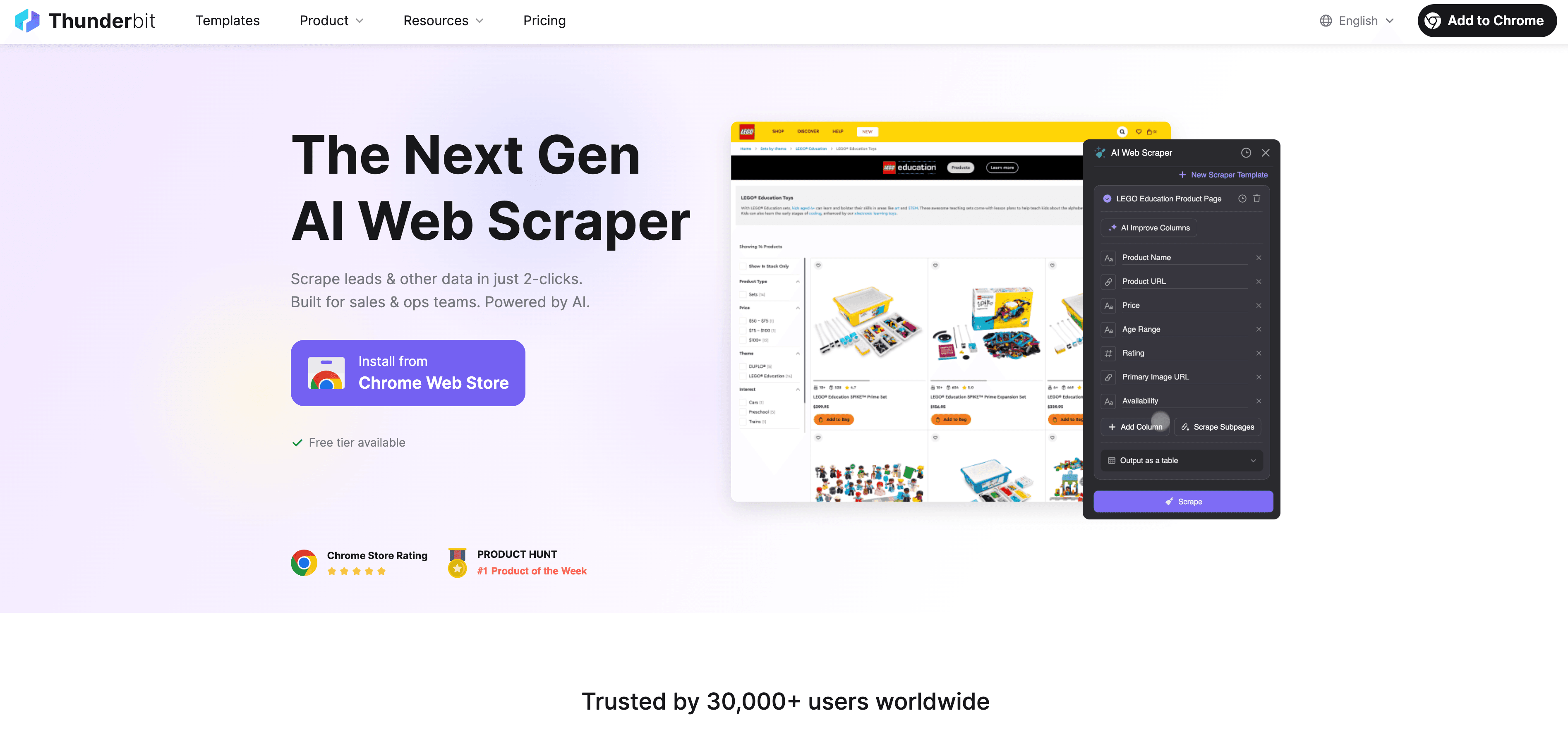

Thunderbit: JavaScript Crawling einfach und leistungsstark

Mal ehrlich: Die wenigsten Business-Anwender wollen Code schreiben, Selektoren debuggen oder Skripte überwachen. Genau deshalb gibt es – einen KI-Web-Scraper, der speziell für Nicht-Entwickler gemacht ist, die Daten von dynamischen, JavaScript-lastigen Seiten brauchen.

So macht Thunderbit javascript crawling super easy:

- KI-Feldvorschläge: Mit einem Klick analysiert Thunderbits KI die Seite, schlägt passende Spalten vor und erkennt automatisch die richtigen Datentypen. Kein Rätselraten mehr.

- Extraktion per natürlicher Sprache: Einfach in Alltagssprache beschreiben, was du brauchst („Produktname, Preis und Bewertung extrahieren“) – Thunderbit erledigt den Rest.

- Dynamische Inhalte meistern: Thunderbit läuft im echten Browser (Chrome oder Cloud), führt alles JavaScript aus und wartet, bis die Inhalte geladen sind – wie ein Mensch.

- Unterseiten & Paginierung: Mehrere Seiten oder Unterseiten (z. B. Produktdetails) werden automatisch besucht und die Daten in einer Tabelle zusammengeführt.

- Cloud-Beschleunigung: Für große Projekte übernimmt Thunderbits Lightning Network das Scraping von bis zu 50 Seiten gleichzeitig in der Cloud – dein Rechner bleibt entspannt.

- No-Code, intuitive Bedienung: Wer Excel bedienen kann, kommt auch mit Thunderbit klar. Alles läuft per Mausklick, ohne technische Hürden.

- Kostenloser Datenexport: Exportiere deine Ergebnisse nach Excel, Google Sheets, Airtable, Notion oder als JSON – ohne Zusatzkosten.

Thunderbit wird weltweit von über 30.000 Nutzern eingesetzt – von Vertriebsteams über Online-Händler bis zu Immobilienprofis ().

KI-Feldvorschläge & Extraktion per natürlicher Sprache

Hier spielt Thunderbit seine Stärken aus: Statt im HTML zu suchen oder XPath-Selektoren zu schreiben, genügt ein Klick – die KI übernimmt die Analyse, versteht die Seitenstruktur und schlägt die passenden Felder vor. Wer etwas Spezielles braucht, tippt es einfach in Alltagssprache ein – Thunderbit findet die richtigen Elemente.

Gerade für Einsteiger ist das ein echter Gamechanger. HTML, CSS oder JavaScript-Kenntnisse sind nicht nötig. Einfach beschreiben, was du willst – die KI erledigt den Rest ().

Paginierung und Unterseiten-Crawling

Thunderbit kann mehr als nur eine Seite abgreifen. Es erkennt und verarbeitet:

- Paginierung (z. B. „Weiter“-Klicks oder Scrollen für mehr Ergebnisse)

- Unterseiten (z. B. Produktdetails, Autorenprofile, Bewertungen) und fügt die Daten zur Haupttabelle hinzu

- Unendliches Scrollen durch Simulation von Nutzeraktionen – so erhältst du alle Daten, nicht nur das Sichtbare

Beispiel: Du willst eine Kategorie mit 20 Produktseiten scrapen? Thunderbit klickt automatisch durch alle Seiten und sammelt die Ergebnisse. Für Details auf Unterseiten folgt Thunderbit jedem Link, holt die Zusatzinfos und reichert deinen Datensatz an ().

Lightning Network & Cloud-Beschleunigung: JavaScript Crawling skalieren

Wer hunderte oder tausende Seiten scrapen will, kommt mit Einzelabrufen nicht weit. Hier hilft Thunderbits Lightning Network:

- Cloud-Scraping: Die Arbeit wird auf Thunderbits Cloud-Server (in den USA, EU und Asien) ausgelagert. Bis zu 50 Seiten werden parallel verarbeitet – große Projekte laufen so deutlich schneller.

- Paralleles Crawling: Statt jede Seite einzeln im Browser zu laden, verteilt Thunderbit die Aufgabe auf viele Worker. 1.000 Produktseiten? Die Cloud schafft das in Minuten statt Stunden.

- Geplantes Scraping: Preise oder Angebote regelmäßig überwachen? Einfach einen Zeitplan in Alltagssprache festlegen („jeden Tag um 9 Uhr“), und Thunderbit erledigt den Rest – inklusive Export zu Google Sheets oder Datenbanken ().

Gerade für Vertrieb, E-Commerce und Operations ist das ein echter Gewinn – frische Daten in großem Umfang, ganz ohne Entwickler oder eigene Server.

Multi-Page- und Massenextraktion

Mit Thunderbit kannst du ganz einfach:

- Komplette Verzeichnisse oder Kataloge scrapen (z. B. alle Produkte einer Kategorie, alle Angebote einer Region)

- Ergebnisse mit einem Klick exportieren – nach Excel, Google Sheets, Airtable oder Notion

- Stundenlange Handarbeit sparen – ein Nutzer extrahierte so hunderte Immobilienangebote samt Maklerdaten in weniger als 10 Minuten

Schritt-für-Schritt: So startest du mit JavaScript Crawling in Thunderbit

Bereit für den Einstieg? So funktioniert Thunderbit – auch ohne Vorkenntnisse:

Dein erster Crawl in wenigen Schritten

- Thunderbit installieren: Lade die herunter und registriere dich kostenlos.

- Zielseite auswählen: Gehe auf die Website, die du scrapen möchtest. Falls ein Login nötig ist, logge dich zuerst ein (Thunderbit arbeitet im Kontext deines Browsers).

- Thunderbit öffnen: Klicke auf das Thunderbit-Icon in der Chrome-Leiste. Wähle die Datenquelle (aktuelle Seite, URL-Liste oder Datei-Upload).

- Modus wählen: Für kleine Aufgaben oder Seiten mit Login nutze den Browser-Modus. Für große Projekte empfiehlt sich der Cloud-Modus für paralleles Scraping.

- KI-Feldvorschläge: Klicke auf „KI-Feldvorschläge“. Thunderbits KI scannt die Seite und schlägt passende Spalten vor (z. B. „Produktname“, „Preis“, „Bild-URL“).

- Spalten anpassen: Benenne Felder um, füge eigene hinzu oder entferne sie. Mit individuellen KI-Anweisungen kannst du Daten formatieren oder kategorisieren.

- Paginierung/Scrollen konfigurieren: Nutzt die Seite Paginierung oder unendliches Scrollen, aktiviere die entsprechende Option in den Einstellungen.

- „Scrapen“ klicken: Thunderbit lädt die Seite(n), führt alles JavaScript aus und extrahiert die Daten in eine Tabelle.

Daten extrahieren und exportieren

- Ergebnisse prüfen: Thunderbit zeigt die Daten in einer Tabelle an. Überprüfe Stichproben auf Vollständigkeit und Korrektheit.

- Exportieren: Mit einem Klick als Excel, CSV, JSON herunterladen oder direkt nach Google Sheets, Airtable oder Notion senden.

- Validieren: Vergleiche einige Zeilen mit der Live-Seite, um sicherzugehen, dass alles passt.

- Fehlerbehebung: Fehlen Daten, scrolle die Seite vorab, passe die KI-Anweisungen an oder wechsle für bessere Performance in den Cloud-Modus.

Ausführliche Anleitungen findest du in den oder auf dem .

Best Practices: Sicher und rechtlich sauber JavaScript crawlen

Mit großer Scraping-Power kommt auch Verantwortung. So bleibst du auf der sicheren Seite:

- robots.txt und Nutzungsbedingungen beachten: Prüfe immer, ob die Seite Scraping erlaubt. Steht dort „keine Bots“, dann halte dich daran ().

- Keine personenbezogenen Daten scrapen: Namen, E-Mails und Profile sind durch DSGVO und CCPA geschützt – auch wenn sie öffentlich sind. Nur mit berechtigtem Grund und Einwilligung extrahieren.

- Keine Logins oder CAPTCHAs umgehen: Das ist rechtlich heikel. Bleibe bei öffentlichen Daten.

- Anfragen drosseln: Überlaste keine Server. Thunderbits Cloud-Modus verteilt Anfragen und wechselt IPs, um Sperren zu vermeiden.

- Daten ethisch nutzen: Keine urheberrechtlich geschützten Inhalte veröffentlichen oder missbrauchen.

- Auf Anfrage löschen: Wenn jemand die Löschung seiner Daten verlangt, solltest du dem nachkommen.

Thunderbit ist so konzipiert, dass Compliance gefördert wird – nur öffentliche Daten, keine Hacks, klare Exportoptionen für verantwortungsvolle Nutzung.

Rechtliche Risiken vermeiden

- Nur öffentliche, nicht-personenbezogene Daten extrahieren.

- Keine Seiten scrapen, die es ausdrücklich verbieten.

- Im Zweifel um Erlaubnis fragen oder die offizielle API nutzen.

- Protokolliere, was und wann du gescrapt hast.

- Unterlassungsaufforderungen sofort befolgen.

Mehr dazu im Artikel .

JavaScript Crawling im Vergleich: Thunderbit vs. klassische Tools

| Aspekt | Puppeteer/Playwright (Code) | Sitebulb (SEO-Crawler) | Thunderbit (KI No-Code) |

|---|---|---|---|

| Einrichtungszeit | Stunden (Programmierung nötig) | Mittel (Konfiguration) | Minuten (Klick & los) |

| Erforderliche Kenntnisse | Hoch (nur Entwickler) | Mittel | Gering (jeder) |

| JavaScript-Inhalte | Ja (manuelles Skripting) | Ja (für SEO) | Ja (KI, automatisch) |

| Paginierung/Unterseiten | Manuelles Skripting | Eingeschränkt | Automatisch (KI erkennt) |

| Wartung | Hoch (bricht bei Änderungen) | Mittel | Gering (KI passt sich an) |

| Skalierbarkeit | Manuell (Code schreiben) | Eingeschränkt | Integrierte Cloud (50x) |

| Exportoptionen | Manuell (Code schreiben) | CSV/Excel | Excel, Sheets, Notion |

| Ideal für | Entwickler, individuelle Flows | SEO-Audits | Business-Anwender, Analysten |

Thunderbit ist die beste Wahl für alle, die schnell Ergebnisse wollen – ohne technische Hürden ().

Fazit & wichtigste Erkenntnisse

javascript crawling ist heute keine Nischentechnologie mehr – sondern ein Muss für alle, die 2025 Webdaten brauchen. Fast 99 % aller Websites setzen auf clientseitige Skripte, klassisches Scraping reicht nicht mehr aus (). Die gute Nachricht: Man muss kein Entwickler sein, um es zu meistern.

Das solltest du dir merken:

- Dynamische Inhalte sind Standard: Wer moderne Seiten scrapen will, braucht Tools, die JavaScript ausführen können.

- Herausforderungen sind lösbar: Headless Browser, intelligentes Warten und Cloud-Beschleunigung ermöglichen auch komplexe Extraktionen.

- Thunderbit macht’s einfach: Mit KI-Feldvorschlägen, natürlicher Sprache, Unterseiten- und Paginierungs-Support sowie Cloud-Beschleunigung ist javascript crawling für jeden zugänglich.

- Recht und Ethik beachten: Immer die Regeln der Website, Datenschutz und ethische Grundsätze einhalten.

- Jetzt starten: Thunderbit installieren, Zielseite wählen und mit wenigen Klicks Daten freischalten.

Mehr Tipps findest du im oder in unseren mit Schritt-für-Schritt-Anleitungen.

Viel Erfolg beim Crawlen – und auf viele dynamische, vollständige und einsatzbereite Datensätze!

Häufige Fragen (FAQ)

1. Was ist JavaScript Crawling und wie unterscheidet es sich vom klassischen Scraping?

Beim javascript crawling wird eine Webseite komplett geladen, alle JavaScript-Skripte werden ausgeführt und erst dann die angezeigten Inhalte extrahiert. Klassisches Scraping liest nur das Roh-HTML und verpasst so die meisten Inhalte moderner Seiten.

2. Warum brauche ich JavaScript Crawling für die Datenerfassung im Business?

Weil fast alle modernen Websites Inhalte dynamisch per JavaScript laden. Ohne javascript crawling verpasst du Produktlisten, Bewertungen, Preise und viele weitere wichtige Daten.

3. Wie vereinfacht Thunderbit JavaScript Crawling für Einsteiger?

Thunderbit nutzt KI, um Felder vorzuschlagen, dynamische Inhalte zu erkennen und Paginierung sowie Unterseiten automatisch zu verarbeiten. Du kannst einfach in Alltagssprache beschreiben, was du brauchst – ganz ohne Programmierung.

4. Ist JavaScript Crawling legal? Worauf muss ich achten?

javascript crawling ist legal, wenn du dich an die Regeln hältst: Nur öffentliche Daten extrahieren, robots.txt und Nutzungsbedingungen respektieren und keine personenbezogenen Daten ohne Einwilligung scrapen. Thunderbit fördert die Einhaltung dieser Grundsätze.

5. Wie kann ich JavaScript Crawling für große Projekte skalieren?

Mit Thunderbits Lightning Network (Cloud-Scraping) kannst du bis zu 50 Seiten gleichzeitig extrahieren – ideal für Preisüberwachung oder Lead-Generierung auf tausenden Seiten.

Mehr erfahren: