Lass mich mal ehrlich sein: Es gibt im digitalen Alltag kaum etwas Befriedigenderes, als endlich eine komplette, übersichtliche Liste aller Seiten einer Website vor sich zu haben – das fühlt sich fast so an, als hätte man nach dem Wäschewaschen endlich jedes einzelne Sockenpaar wieder zusammen. Wer schon mal versucht hat, für ein Content-Audit, eine Migration oder einfach zur Bestandsaufnahme alle Seiten einer Website zu erfassen, weiß: So easy, wie es klingt, ist es selten. Ich habe schon Teams erlebt, die stunden- oder tagelang Listen aus Sitemaps, Google-Suchen und CMS-Exporten zusammenbasteln – nur um am Ende festzustellen, dass sie trotzdem versteckte oder dynamische Seiten übersehen haben. Und fang gar nicht erst damit an, wie ich mal einem Freund helfen wollte, alle WordPress-URLs zu exportieren – sagen wir so: Es gab viel Kaffee und ein bisschen Existenzangst.

Die gute Nachricht? Du musst nicht länger Verstecken mit deiner eigenen Website spielen. In diesem Guide zeige ich dir alle gängigen Wege, wie du Website-URLs findest – von klassischen bis modernen Methoden. Außerdem erfährst du, wie KI-gestützte Tools wie diesen Prozess nicht nur schneller und vollständiger, sondern sogar richtig angenehm machen. Egal ob du im Marketing, in der Entwicklung oder einfach die „glückliche“ Person bist, die alle URLs zusammentragen soll: Hier findest du praktische Schritte, echte Beispiele und ehrliche Vergleiche, damit du die beste Lösung für dein Team findest.

Warum du alle Seiten einer Website brauchst: Praxisbeispiele

Bevor wir ins Wie einsteigen, lass uns das Warum klären. Warum müssen so viele Teams überhaupt alle Website-URLs finden? Das ist längst nicht nur ein SEO-Thema – Marketing, Vertrieb, IT und Operations stehen regelmäßig vor dieser Aufgabe. Hier die häufigsten Anwendungsfälle:

- SEO- und Content-Audits: Content-Audits sind Standard – . Eine vollständige URL-Liste ist die Basis, um Inhalte zu bewerten, zu aktualisieren und Rankings zu verbessern. .

- Website-Relaunch & Migration: ). Bei jeder Migration müssen bestehende URLs gemappt werden, um Fehlerseiten und SEO-Verluste zu vermeiden.

- Compliance & Wartung: Operations-Teams suchen nach verwaisten oder veralteten Seiten – manchmal schlummern alte Kampagnen-Microsites noch live und warten nur darauf, peinlich zu werden.

- Wettbewerbsanalyse: Marketing und Vertrieb listen Produktseiten, Preise oder Blogposts von Wettbewerbern auf, um Lücken oder Leads zu entdecken.

- Leadgenerierung & Outreach: Vertriebsteams erstellen Listen von Filialen, Händlerverzeichnissen oder Mitgliederseiten für gezielte Ansprache.

- Content-Inventar: Content-Marketer führen eine laufende Übersicht über alle Blogposts, Landingpages, PDFs usw., um Doppelungen zu vermeiden und den Wert zu maximieren.

Hier eine kompakte Übersicht:

| Szenario | Wer braucht es | Warum eine vollständige Seitenliste wichtig ist |

|---|---|---|

| SEO-/Content-Audit | SEO-Spezialisten, Content-Marketer | Jede Seite bewerten; fehlende Seiten = unvollständige Analyse, verpasste Optimierung |

| Website-Migration/Relaunch | Entwickler, SEO, IT, Marketing | Alte und neue URLs abgleichen, Weiterleitungen einrichten, Fehlerseiten und SEO-Verlust vermeiden |

| Wettbewerbsanalyse | Marketing, Vertrieb | Alle Wettbewerber-Seiten für Insights; versteckte Seiten zeigen Chancen |

| Leadgenerierung | Vertrieb | Kontakt-/Ressourcenseiten für Outreach sammeln; kein Lead wird übersehen |

| Content-Inventar | Content-Marketing | Aktuelles Verzeichnis pflegen, Lücken erkennen, Doppelungen vermeiden, alte Seiten prüfen |

Und was passiert, wenn Seiten fehlen oder versteckt sind? Das kann richtig ins Geld gehen. Stell dir vor, du planst einen Relaunch und vergisst eine versteckte Landingpage, die noch konvertiert – oder du übersiehst 5 % deiner Seiten beim Audit, weil sie nicht indexiert sind. Das bedeutet Umsatzverlust, SEO-Probleme und manchmal auch PR-Ärger, den niemand kommen sah.

Gängige Methoden, um Website-URLs zu finden: Die Klassiker erklärt

Jetzt wird’s praktisch: Wie kommt man an alle Seiten einer Website? Es gibt ein paar bewährte Methoden – manche sind schnell, andere gründlich (und manchmal schmerzhaft). Hier der Überblick:

Google-Suche und Suchoperatoren

So geht’s:

Einfach bei Google site:deinewebsite.com eingeben. Google zeigt alle Seiten, die für diese Domain indexiert sind. Mit weiteren Begriffen oder Unterverzeichnissen (z. B. site:deinewebsite.com/blog) kannst du das Ergebnis eingrenzen.

Das bekommst du:

Eine Liste der indexierten Seiten – also das, was Google über deine Website weiß.

Einschränkungen:

- Zeigt nur indexierte Seiten, nicht alles, was existiert

- Bricht meist nach ein paar Hundert Ergebnissen ab, auch bei großen Seiten

- Neue, versteckte oder absichtlich nicht indexierte Seiten fehlen

Wann sinnvoll:

Ideal für einen schnellen Überblick oder kleine Websites, aber nicht für ein vollständiges Audit.

robots.txt und Sitemap.xml prüfen

So geht’s:

Ruf deinewebsite.com/robots.txt auf und schau nach „Sitemap:“-Zeilen. Öffne die Sitemap (meist deinewebsite.com/sitemap.xml oder /sitemap_index.xml). Sitemaps listen die Seiten, die indexiert werden sollen.

Das bekommst du:

Eine Liste der wichtigsten Seiten – oft alle Blogposts, Produktseiten usw. .

Einschränkungen:

- Sitemaps enthalten nur Seiten, die der Betreiber indexiert haben möchte – versteckte oder verwaiste Seiten fehlen oft

- Sitemaps können veraltet sein, wenn sie nicht regelmäßig aktualisiert werden

- Manche Seiten haben mehrere Sitemaps; man muss sie ggf. suchen

Wann sinnvoll:

Perfekt, wenn du die Seite besitzt oder einen schnellen Überblick über die Hauptseiten eines Wettbewerbers willst. Aber: Du siehst nur, was der Betreiber zeigen will.

SEO-Spider-Tools und Website-Crawler

So geht’s:

Tools wie Screaming Frog, Sitebulb oder DeepCrawl simulieren einen Suchmaschinen-Crawler. Du gibst die URL ein, das Tool folgt allen internen Links und erstellt eine Liste aller gefundenen Seiten.

Das bekommst du:

Potentiell jede verlinkte Seite, plus Infos wie Statuscodes und Metadaten.

Einschränkungen:

- Verwaiste Seiten (ohne interne Links) werden nur gefunden, wenn man sie manuell hinzufügt

- Dynamische oder JavaScript-generierte Seiten werden ggf. übersehen, wenn das Tool kein Headless-Browsing unterstützt

- Große Seiten zu crawlen dauert lange und beansprucht viel Arbeitsspeicher

- Erfordert technisches Know-how und Einrichtung

Wann sinnvoll:

Ideal für SEO-Profis oder Entwickler bei tiefgehenden Audits. Für Nicht-Techniker eher ungeeignet.

Google Search Console und Analytics

So geht’s:

Mit Zugriff auf die Website kannst du in der Google Search Console (GSC) und Analytics URL-Listen exportieren.

- GSC: Indexabdeckung und Leistungsberichte zeigen indexierte und ausgeschlossene URLs (bis zu 1.000 pro Export, mehr per API).

- Analytics: Zeigt alle Seiten, die im gewählten Zeitraum Traffic hatten (GA4 erlaubt bis zu 100.000 Zeilen pro Export).

Einschränkungen:

- GSC und Analytics zeigen nur Seiten, die Google kennt oder die Traffic hatten

- Export-Limits (1.000 Zeilen bei GSC, 100k bei GA4)

- Erfordert Website-Besitz/Verifizierung; nicht für Wettbewerbsrecherche nutzbar

- Seiten ohne Traffic oder nicht indexiert erscheinen nicht

Wann sinnvoll:

Super für die eigene Website, z. B. vor einer Migration oder einem Audit. Für Wettbewerbsanalysen ungeeignet.

CMS-Dashboards

So geht’s:

Bei WordPress, Shopify oder anderen CMS kannst du oft direkt aus dem Admin-Bereich eine Liste aller Seiten und Beiträge exportieren (ggf. mit Plugin).

Das bekommst du:

Eine Liste aller Inhalte – Seiten, Beiträge, Produkte usw.

Einschränkungen:

- Erfordert Admin-Zugang

- Enthält meist keine dynamischen oder Systemseiten

- Bei mehreren Systemen (Blog, Shop, Doku) müssen Exporte kombiniert werden

Wann sinnvoll:

Optimal für Website-Besitzer, die ein Content-Inventar oder Backup erstellen wollen. Für Wettbewerbsanalysen nicht geeignet.

Die Schwächen klassischer Methoden zur URL-Erfassung

Ganz ehrlich: Keine dieser Methoden ist perfekt. Hier die größten Hürden:

- Technische Hürden: Viele Methoden erfordern technisches Wissen oder Spezialtools. Für Nicht-Techniker ist das oft ein echtes Hindernis. Ein manuelles Content-Audit kann bei großen Seiten .

- Unvollständige Abdeckung: Jede Methode kann bestimmte Seiten übersehen – Google findet keine nicht indexierten oder neuen Seiten, Sitemaps keine verwaisten, Crawler keine unverketteten oder dynamischen Seiten, CMS-Exporte alles außerhalb des Systems nicht.

- Manueller Aufwand: Oft müssen Daten aus verschiedenen Quellen zusammengeführt, bereinigt und dedupliziert werden – mühsam und fehleranfällig. Es gibt sogar „Hacks“ wie Copy-Paste aus Sitemaps in Excel oder Kommandozeilenskripte.

- Aktualität: Listen veralten schnell. Klassische Methoden erfordern, dass der Prozess bei jeder Änderung neu angestoßen wird.

- Zugriffsrechte: Manche Methoden erfordern Admin-Zugang oder Website-Besitz – für Wettbewerbsanalysen ungeeignet.

- Datenflut: SEO-Spider liefern oft zu viele technische Daten, wenn man eigentlich nur eine einfache URL-Liste braucht.

Kurz gesagt: Der klassische Prozess ist wie „einen Kuchen backen, während das Rezept sich ständig ändert und der Ofen gelegentlich streikt.“ (Kein Witz – das stammt von einer Content-Strategin, und ich kann’s absolut nachvollziehen.)

Thunderbit kennenlernen: Die KI-Lösung für Website-URLs

Jetzt wird’s richtig spannend. Was wäre, wenn du einfach einen Assistenten bitten könntest: „Geh bitte durch die Website und liste mir alle Seiten auf“ – und es klappt, ganz ohne Code oder Aufwand? Genau das macht .

Thunderbit ist eine KI-Web-Scraper Chrome-Erweiterung, die speziell für Nicht-Techniker entwickelt wurde (aber auch Profis überzeugt). Die KI „liest“ Websites, strukturiert die Daten und exportiert alle URLs – inklusive versteckter, dynamischer und Unterseiten. Du musst keinen Code schreiben oder komplizierte Einstellungen vornehmen. Einfach die Seite öffnen, auf „KI Felder vorschlagen“ klicken und Thunderbit erledigt den Rest.

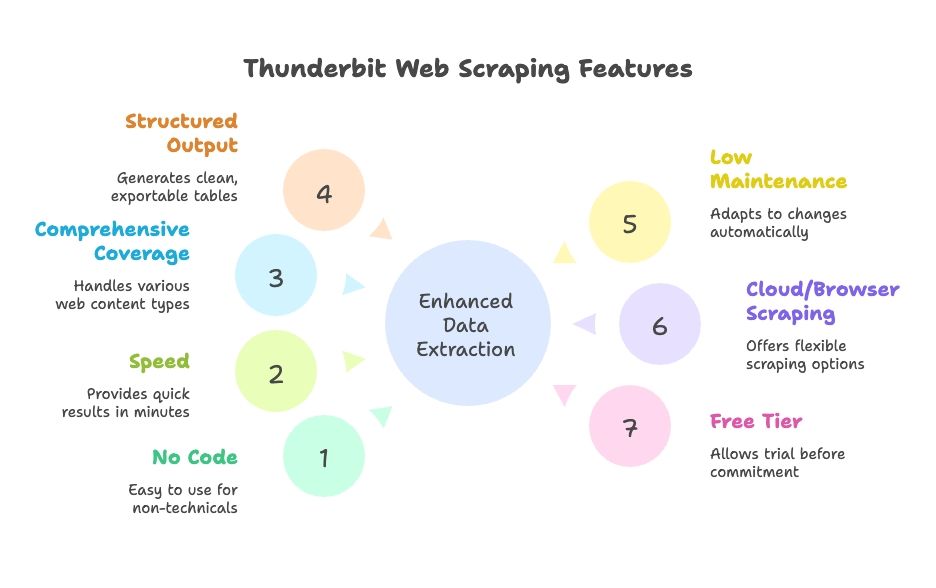

Was Thunderbit besonders macht:

- Kein Coding, keine Einrichtung: Intuitive Bedienung mit natürlicher Sprache, KI-gestützt. Jeder im Team kann es nutzen.

- Schnelligkeit: Ergebnisse in Minuten statt Stunden.

- Umfassende Abdeckung: Erkennt dynamische Inhalte, Paginierung, Infinite Scroll und Unterseiten.

- Strukturierte Ausgabe: Saubere Tabellen, direkt exportierbar nach Google Sheets, Excel, Airtable, Notion, CSV oder JSON.

- Wenig Wartung: Die KI passt sich automatisch an Website-Änderungen an; weniger Nachjustieren nötig.

- Cloud- oder Browser-Scraping: Du wählst, was am besten zu deinem Workflow passt.

- Kostenlose Version verfügbar: Teste Thunderbit, bevor du dich festlegst.

So einfach macht Thunderbit die URL-Erfassung

Schauen wir uns an, wie Thunderbit in der Praxis funktioniert. In wenigen Klicks von „Ich brauche alle Seiten meiner Website“ zu „Hier ist die Tabelle, Chef“.

Schritt 1: Thunderbit installieren und starten

Lade die herunter und pinne sie im Browser. Navigiere zur gewünschten Website (z. B. deine Startseite) und öffne Thunderbit über das Icon.

Profi-Tipp: Thunderbit bietet neuen Nutzern kostenlose Credits – du kannst es also risikofrei testen.

Schritt 2: Datenquelle wählen

Standardmäßig scrapt Thunderbit die aktuelle Seite, du kannst aber auch eine Liste von URLs (z. B. aus einer Sitemap oder Kategorie) eingeben, um gezielt zu starten.

- Für die meisten Seiten empfiehlt sich die Startseite oder eine Sitemap.

- Bei Shops kann ein Kategorie- oder Produktlisting sinnvoll sein.

Schritt 3: „KI Felder vorschlagen“ nutzen

Jetzt kommt die KI ins Spiel. Klicke auf „KI Felder vorschlagen“ (oder „KI Spalten vorschlagen“). Thunderbits KI scannt die Seite, erkennt Muster und schlägt Spalten wie „Seitentitel“ und „Seiten-URL“ für alle gefundenen Links vor. Du kannst die Spalten nach Bedarf anpassen.

- Auf der Startseite bekommst du z. B. Navigation, Footer und hervorgehobene Links.

- In einer Sitemap bekommst du eine saubere URL-Liste.

- Du kannst Spalten hinzufügen, entfernen oder die Extraktion verfeinern.

Thunderbits KI übernimmt die Arbeit – du musst keine XPaths oder CSS-Selektoren schreiben. Es ist wie ein Roboter-Praktikant, der wirklich versteht, was du willst.

Schritt 4: Subpage Scraping aktivieren

Die meisten Seiten listen nicht alle Unterseiten auf der Startseite. Hier kommt Thunderbits Subpage Scraping ins Spiel. Markiere die URL-Spalte als „Folge-Link“ und Thunderbit klickt alle gefundenen Links durch, um weitere URLs auf diesen Seiten zu scrapen. Du kannst sogar verschachtelte Templates für mehrstufiges Scraping anlegen.

- Bei paginierten Listen oder „Mehr laden“-Buttons aktivierst du Paginierung & Scrollen, damit Thunderbit alles findet.

- Bei Subdomains oder Bereichen (z. B. ein Blog auf ) kann Thunderbit diese ebenfalls folgen, wenn du es anweist.

Schritt 5: Scraping starten

Klicke auf „Scrapen“ und beobachte, wie Thunderbit die Tabelle mit URLs (und weiteren Feldern) in Echtzeit füllt. Bei großen Seiten kannst du das Tool im Hintergrund laufen lassen und später die Ergebnisse prüfen.

Schritt 6: Prüfen und exportieren

Nach Abschluss kannst du die Ergebnisse direkt in der App sortieren, filtern und Duplikate entfernen. Exportiere die Daten mit einem Klick nach Google Sheets, Excel, CSV, Airtable, Notion oder JSON. Kein Copy-Paste oder Formatierungschaos mehr.

Das Ganze? Bei kleinen bis mittleren Seiten dauert es weniger als 10 Minuten bis zur vollständigen URL-Liste. Auch bei großen Seiten ist es deutlich schneller (und entspannter) als das manuelle Zusammenstellen aus verschiedenen Quellen.

Versteckte und dynamische Seiten mit Thunderbit entdecken

Ein echtes Highlight von Thunderbit: Es findet Seiten, die klassische Tools oft übersehen:

- JavaScript-generierte Inhalte: Thunderbit läuft im echten Browser und erfasst auch dynamisch geladene Seiten (z. B. Infinite-Scroll-Jobbörsen oder Produktlisten).

- Verwaiste oder nicht verlinkte Seiten: Mit einem Hinweis (z. B. Sitemap oder Suchfunktion) kann Thunderbit auch Seiten finden, die sonst nirgends verlinkt sind.

- Subdomains oder Bereiche: Thunderbit folgt auf Wunsch auch Links über Subdomains hinweg und liefert so ein vollständiges Bild.

- Interaktion wie ein Nutzer: Musst du ein Suchfeld ausfüllen oder einen Filter klicken, um versteckte Seiten zu sehen? Thunderbits KI-Autofill übernimmt das für dich.

Praxisbeispiel: Ein Marketing-Team wollte alle alten Landingpages finden – viele waren nirgends mehr verlinkt, existierten aber noch. Durch das Scrapen von Google-Suchergebnissen mit Thunderbit und bekannten URL-Mustern wurden Dutzende vergessene Seiten entdeckt – das ersparte dem Unternehmen viel Verwirrung (und einige Kopfschmerzen).

Thunderbit vs. klassische Methoden: Geschwindigkeit, Einfachheit, Abdeckung

Hier der direkte Vergleich:

| Kriterium | Google „site:“-Suche | XML-Sitemap | SEO-Crawler (Screaming Frog) | Google Search Console | CMS-Export | Thunderbit KI-Web-Scraper |

|---|---|---|---|---|---|---|

| Geschwindigkeit | Sehr schnell, aber begrenzt | Sofort, falls vorhanden | Unterschiedlich (Minuten bis Stunden) | Schnell bei kleinen Seiten | Sofort bei kleinen Seiten | Sehr schnell, Konfiguration in Minuten, automatisches Scraping |

| Bedienkomfort | Sehr einfach | Einfach | Mittel (Einrichtung nötig) | Mittel | Einfach (bei Admin-Zugang) | Sehr einfach, kein Coding |

| Abdeckung | Gering (nur indexiert) | Hoch für gewünschte Seiten | Hoch für verlinkte Seiten | Hoch für indexierte, Export begrenzt | Mittel (nur Inhalte) | Sehr hoch, auch dynamische & Unterseiten |

| Ausgabe & Integration | Manuelles Copy-Paste | XML (muss geparst werden) | CSV mit vielen Zusatzdaten | CSV/Excel, bis 1.000 Zeilen | CSV/XML, evtl. Nachbearbeitung | Saubere Tabelle, 1-Klick-Export zu Sheets, Excel etc. |

| Wartung | Manuell neu starten | Muss aktualisiert werden | Erneutes Crawlen bei Änderungen | Regelmäßiger Export | Export nach Änderungen | Gering – KI passt sich an, Scraping planbar |

Thunderbit punktet bei Bedienkomfort, Vollständigkeit und Integration. Klassische Methoden haben jeweils ihre Stärken, erfordern aber mehr Aufwand, um Ergebnisse zu kombinieren und aktuell zu halten. Thunderbits KI passt sich automatisch an Website-Änderungen an – du musst nicht ständig Einstellungen anpassen oder manuelle Exporte wiederholen.

Die richtige Methode wählen: Wer profitiert wovon?

Welche Methode ist nun die beste? Hier meine Einschätzung aus jahrelanger Erfahrung mit Website-Daten:

- SEO-Profis / Entwickler: Wer tiefgehende technische Daten (Metadaten, Fehlerseiten etc.) braucht oder riesige Enterprise-Seiten auditiert, ist mit Crawlern oder eigenen Skripten gut beraten. Aber auch dann liefert Thunderbit schnell eine URL-Liste als Basis für weitere Tools.

- Marketer, Content-Strategen, Projektmanager: Thunderbit ist ein echter Gamechanger. Kein Warten mehr auf die IT, keine Exporte zusammenführen. Für Content-Inventar, Wettbewerbsanalyse oder schnelle Audits kannst du alles selbst erledigen.

- Vertrieb / Leadgenerierung: Thunderbit macht es einfach, Listen von Filialen, Eventseiten oder Mitgliederverzeichnissen von beliebigen Websites zu ziehen – ganz ohne Programmierkenntnisse.

- Kleine Websites / schnelle Aufgaben: Bei Mini-Seiten reicht oft ein manueller Check oder die Sitemap. Aber Thunderbit ist so schnell eingerichtet, dass es sich meist trotzdem lohnt, um nichts zu übersehen.

- Budget: Klassische Methoden sind günstig (abgesehen von deiner Zeit). Thunderbit bietet eine kostenlose Version, und die Bezahlpläne sind für die meisten Unternehmen erschwinglich. Denk dran: Deine Zeit ist wertvoll!

- Sehr spezielle Datenanforderungen: Wer extrem individuelle Daten oder komplexe Logik braucht, muss ggf. selbst coden. Aber Thunderbits KI deckt die meisten Anwendungsfälle mit minimalem Setup ab.

Entscheidungstipps:

- Bei weniger als 1.000 Seiten und Website-Besitz: Google Search Console Export – aber auf Vollständigkeit achten.

- Kein Zugriff auf die Seite oder Wettbewerbsdaten nötig? Thunderbit oder ein Crawler sind deine Freunde.

- Wer Wert auf Zeitersparnis und Skalierbarkeit legt, kommt an Thunderbit kaum vorbei.

- Für Teamarbeit ist der direkte Export zu Google Sheets ein großer Pluspunkt.

Viele Unternehmen nutzen einen Mix: Thunderbit für schnelle Aufgaben und Nicht-Techniker, klassische Tools für tiefe Audits.

Fazit: Website-Seiten für jeden Business-Case erfassen

Kurz und knapp:

- Eine vollständige Seitenliste ist entscheidend für SEO, Content-Strategie, Migrationen und Vertriebsrecherche. Sie verhindert böse Überraschungen, Fehlerseiten und verpasste Chancen. Die meisten Marketer führen inzwischen mindestens jährlich ein Content-Audit durch ().

- Klassische Methoden gibt es, aber jede hat Lücken. Keine Methode garantiert eine vollständige, aktuelle Liste. Oft sind technisches Know-how und das Kombinieren mehrerer Quellen nötig.

- KI-gestütztes Scraping (Thunderbit) ist die moderne Lösung. Thunderbit übernimmt das „Denken“ und Klicken, macht Web Scraping für alle zugänglich, erkennt dynamische Inhalte und Unterseiten und exportiert die Daten direkt nutzbar – spart Zeit und reduziert Fehler. Im Vergleich schafft Thunderbit in Minuten, wofür früher Stunden nötig waren, und das fast ohne Einarbeitung ().

- Methode passend zum Team wählen. Für riesige Seiten alle Tools nutzen, aber für die meisten Unternehmen reicht Thunderbit allein völlig aus.

- Regelmäßig aktualisieren. Nur so werden Probleme früh erkannt und die Website bleibt schlank und effektiv. Mit Thunderbits Zeitplanung ist das machbar – manuelle Prozesse werden dagegen oft aus Zeitgründen vernachlässigt.

Letzter Gedanke: Es gibt keine Ausrede mehr, nicht zu wissen, was auf der eigenen (oder der Wettbewerber-)Website steht. Mit dem richtigen Ansatz bekommst du eine vollständige Seitenliste und kannst dieses Wissen für SEO, Nutzererlebnis und Geschäftsstrategie nutzen. Arbeite smarter, nicht härter – lass die KI die Arbeit machen und stell sicher, dass keine Seite vergessen wird.

Nächste Schritte

Wenn du keine Lust mehr auf das „Hol mir alle URLs“-Chaos hast, und teste es auf deiner oder einer Wettbewerber-Website. Du wirst überrascht sein, wie viel Zeit (und Nerven) du sparst. Und wenn du tiefer ins Web Scraping einsteigen willst, schau in unsere anderen Guides im rein, z. B. oder .

FAQs

1. Warum sollte ich eine Liste aller Seiten einer Website benötigen?

Teams aus SEO, Marketing, Vertrieb und IT brauchen vollständige URL-Listen für Aufgaben wie Content-Audits, Website-Migrationen, Leadgenerierung und Wettbewerbsanalysen. Eine vollständige und korrekte Liste verhindert Fehlerseiten, doppelte oder vergessene Inhalte und deckt versteckte Chancen auf.

2. Was sind die klassischen Wege, um alle Website-URLs zu finden?

Typische Methoden sind die Google-„site:“-Suche, das Prüfen von sitemap.xml und robots.txt, Crawling mit SEO-Tools wie Screaming Frog, Exporte aus CMS-Systemen wie WordPress und das Auslesen indexierter/traffic-starker Seiten aus Google Search Console und Analytics. Jede Methode hat jedoch Einschränkungen bei Abdeckung und Bedienkomfort.

3. Wo liegen die Grenzen klassischer Methoden?

Klassische Methoden übersehen oft dynamische, verwaiste oder nicht indexierte Seiten. Sie erfordern technisches Know-how, viel Zeit für das Zusammenführen und Bereinigen der Daten und sind für große Seiten oder wiederholte Audits meist nicht skalierbar. Oft ist auch Website-Besitz oder Admin-Zugang nötig – das ist nicht immer möglich.

4. Wie vereinfacht Thunderbit das Finden aller Website-Seiten?

Thunderbit ist ein KI-gestützter Web-Scraper, der Websites wie ein Mensch durchsucht – inklusive Unterseiten, JavaScript-Inhalten und automatischer Datenstrukturierung. Es ist keine Programmierung nötig, läuft als Chrome-Erweiterung und exportiert saubere URL-Listen in Google Sheets, Excel, CSV und mehr – in wenigen Minuten.

5. Wer sollte Thunderbit statt klassischer Tools nutzen?

Thunderbit ist ideal für Marketer, Content-Strategen, Vertrieb und alle, die schnell und unkompliziert vollständige URL-Listen brauchen. Klassische Tools sind besser für technische Audits mit tiefgehenden Metadaten oder eigenen Skripten. Viele Teams nutzen beides – Thunderbit für Schnelligkeit und Komfort, klassische Tools für Detailanalysen.