Ich weiß noch genau, wie ich das erste Mal versucht habe, wirklich alle Seiten einer Website zu finden. Damals dachte ich, ich wäre clever: einfach durch die Navigation klicken, jeden Link aufschreiben, fertig. Aber dann tauchten immer wieder neue Seiten auf – versteckte Produktseiten, alte Kampagnen, Blogartikel, die irgendwo tief im endlosen Scrollen versteckt waren. Es fühlte sich an, als würde ich versuchen, eine ganze Stadt nur anhand der Hauptstraßen zu zeichnen – und dann merke ich plötzlich, dass es noch ein riesiges U-Bahn-Netz gibt, das ich komplett übersehen habe.

Wer schon mal für ein Content-Audit, ein SEO-Projekt oder eine Wettbewerbsanalyse wirklich alle Seiten einer Website zusammentragen wollte, weiß: Das klingt viel einfacher, als es tatsächlich ist. – das heißt, der Großteil des Contents bleibt für Nutzer und Suchmaschinen unsichtbar. Da gehen viele Chancen verloren und es sammelt sich digitaler Staub an. Wie kommt man also an eine vollständige Website-Linkliste? Und warum ist das für die Content-Planung so entscheidend? Lass uns das mal genauer anschauen.

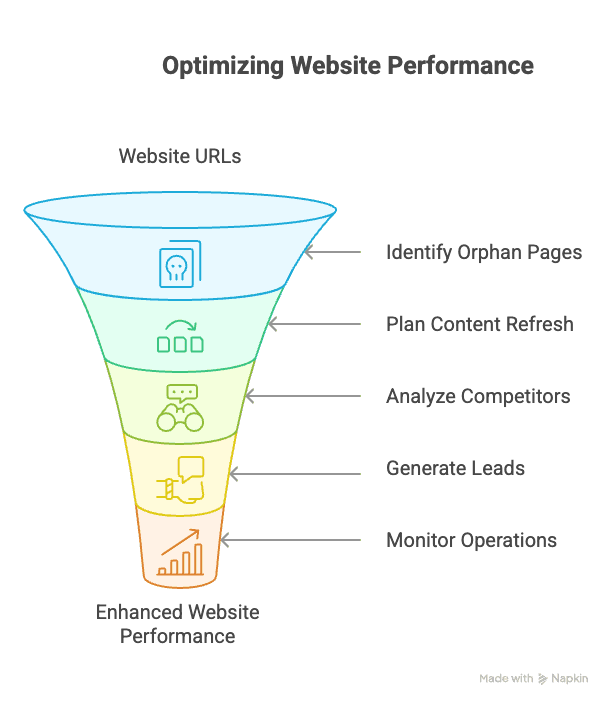

Warum eine vollständige Website-Linkliste für die Content-Planung so wichtig ist

Bevor wir zum „Wie“ kommen, erstmal das „Warum“: Eine vollständige Linkliste ist nicht nur was für SEO-Nerds (auch wenn ich zugeben muss, dass ich daran Spaß habe). Sie ist ein strategisches Tool für jedes Team, das Wert auf Content, Leads oder digitale Performance legt.

Warum jedes Team davon profitiert:

- Content- & SEO-Audits: Mit einer Übersicht aller URLs lassen sich veraltete, dünne oder verwaiste Seiten schnell erkennen. Gerade verwaiste Seiten – also solche ohne interne Links – sind tückisch. Sie können und die Autorität der Website schwächen.

- Content-Planung & Aktualisierung: Mit einer vollständigen Übersicht siehst du, welche Inhalte es gibt, was aktualisiert werden muss und wo Lücken sind. Viele Unternehmen entdecken bei Audits Dutzende vergessene Seiten – oft mit Potenzial für ein Update.

- Wettbewerbsanalyse: Du willst alle Landingpages, Produktkategorien oder versteckten Ressourcen deiner Konkurrenz sehen? Dafür brauchst du deren vollständige Sitemap, nicht nur das, was im Menü steht.

- Sales & Lead-Generierung: Wenn du alle Seiten mit Kontaktinfos oder Filialstandorten erfasst, entgeht dir kein Lead mehr.

- Betrieb & Monitoring: E-Commerce-Teams können jede Produktseite auf Preisänderungen oder Lagerbestand überwachen – auch solche, die nicht im Hauptmenü verlinkt sind.

So profitieren verschiedene Teams konkret:

| Team / Rolle | Anwendungsfall für vollständige Seitenliste | Vorteil |

|---|---|---|

| SEO / Web-Admin | Vollständiges Content-Audit – verwaiste Seiten, defekte Links, doppelte oder dünne Seiten identifizieren. | Bessere Seitenstruktur, Behebung von SEO-Problemen, bessere Indexierung (verwaiste Seiten schwächen die Autorität). |

| Content Marketing | Alle Blogposts, Landingpages etc. für die Content-Planung inventarisieren. | Alte Inhalte aktualisieren oder neu nutzen; konsistente Botschaften sicherstellen und Content-Lücken erkennen. |

| Sales / Lead-Gen | Alle Seiten mit Kontaktinfos, Filialen oder Referenzen finden. | Zielgerichtete Lead-Listen aufbauen, kein potenzieller Lead geht verloren. |

| Wettbewerbsanalyse | Die gesamte Website des Wettbewerbers crawlen (Produktseiten, Blog, Support). | Produktpalette, Preisseiten und Content-Strategie der Konkurrenz aufdecken (wie Sitemaps versteckte URLs zeigen). |

| E-Commerce Ops | Alle Produktseiten (auch nicht verlinkte) für Preis- oder Lagerüberwachung listen. | Preisänderungen oder Lagerstatus im gesamten Sortiment verfolgen; keine Produkte übersehen, die nicht in Kategorien gelistet sind. |

| IT / Compliance | Alle URLs entdecken (auch alte, versteckte oder versehentlich veröffentlichte Staging-Seiten). | Veraltete oder nicht konforme Seiten entfernen; sichere und aktuelle Webpräsenz gewährleisten. |

Fazit: Wer nur die Spitze des Eisbergs sieht, verpasst wertvolle Einblicke, Leads und Chancen.

Was bedeutet es wirklich, alle Seiten einer Website zu finden?

Ein häufiger Irrtum: „Alle Seiten einer Website finden“ heißt nicht, einfach immer wieder auf „Nächste Seite“ zu klicken. Websites sind trickreich. Sie nutzen Endlos-Scrollen, „Mehr laden“-Buttons, JavaScript-Links, URL-Parameter und verstecken ganze Bereiche vor der Navigation. Manche Seiten sind nur mit dem direkten Link erreichbar.

Wenn ich also von einer vollständigen Website-Linkliste spreche, meine ich:

- Endlos-Scroll-Feeds durchforsten (z. B. Twitter, News-Seiten)

- „Mehr laden“-Buttons anklicken, um versteckte Inhalte zu sehen

- Seiten erkennen, die durch URL-Parameter entstehen (z. B. Produktfilter)

- Verwaiste Seiten ohne interne Links aufspüren

- Private oder nicht verlinkte Bereiche finden (z. B. alte Kampagnenseiten)

Es ist weniger wie das Durchblättern eines Buchs – eher wie das Erkunden eines Hauses mit versteckten Räumen und Falltüren. Man braucht mehr als nur eine Taschenlampe – einen Bauplan und ein bisschen detektivisches Gespür.

Klassische Methoden, um alle Seiten einer Website zu entdecken

Bevor KI-Tools wie aufkamen, haben die meisten eine Mischung aus manuellen Tricks und spezieller Software genutzt, um eine Website-Linkliste zu erstellen. Diese Methoden funktionieren immer noch, haben aber auch ihre Schwächen.

Google-Suche und Site-Operatoren nutzen

Der Klassiker: site:beispiel.de bei Google eingeben. So siehst du alle Seiten, die Google für diese Domain indexiert hat. Mit site:beispiel.de/blog kannst du gezielt Bereiche durchsuchen.

Vorteile:

- Sehr einfach

- Gut für eine schnelle Schätzung

Nachteile:

- Zeigt nur, was Google indexiert hat (meist nur ein Bruchteil)

- Private, verwaiste oder gesperrte Seiten bleiben verborgen

Sitemaps und Robots.txt prüfen

Die meisten Websites haben eine sitemap.xml – eine Datei mit allen URLs für Suchmaschinen. Meist zu finden unter beispiel.de/sitemap.xml oder als Link in der robots.txt.

Vorteile:

- Hilfreich, um Seiten zu finden, die nicht im Menü stehen

- Enthält oft auch alte oder versteckte Seiten

Nachteile:

- Nicht immer aktuell oder vollständig

- Listet manchmal Seiten, die für Bots gesperrt sind (sichtbar, aber nicht zugänglich)

- Manche Seiten sind indexiert, aber nicht in der Sitemap ()

Crawling mit SEO-Tools

Tools wie Screaming Frog oder WebSite Auditor crawlen eine Website, indem sie Links folgen und so eine Seitenkarte erstellen.

Vorteile:

- Findet tief verlinkte Seiten

- Prüft auf defekte Links und die Seitenstruktur

Nachteile:

- Kommt mit dynamischen Inhalten (Endlos-Scroll, JavaScript-Links) oft nicht klar

- Erfordert Einrichtung und technisches Know-how

- Kostenlose Versionen haben Crawl-Limits (z. B. 500 URLs bei Screaming Frog)

- Verwaiste Seiten werden nicht gefunden (ohne Link keine Entdeckung)

Wo klassische Methoden bei der Website-Linkliste an ihre Grenzen stoßen

Hier wird’s knifflig. Selbst mit allen oben genannten Methoden übersieht man oft:

- Verwaiste Seiten: Keine internen Links, nicht in der Sitemap, nicht indexiert – digitale Einzelgänger.

- Dynamische Inhalte: Endlos-Scroll, „Mehr laden“-Buttons oder Inhalte, die per JavaScript/AJAX geladen werden.

- Seiten hinter Formularen oder Skripten: Manche Seiten erscheinen erst nach einer Nutzeraktion (z. B. Sucheingabe).

- Doppelte oder parameterbasierte URLs: Mehrere Wege zum gleichen Inhalt oder einzigartige Seiten, die nur über URL-Parameter erreichbar sind.

Kurz: Klassische Methoden sind wie ein Netz mit vielen Löchern – einiges bleibt immer unerkannt.

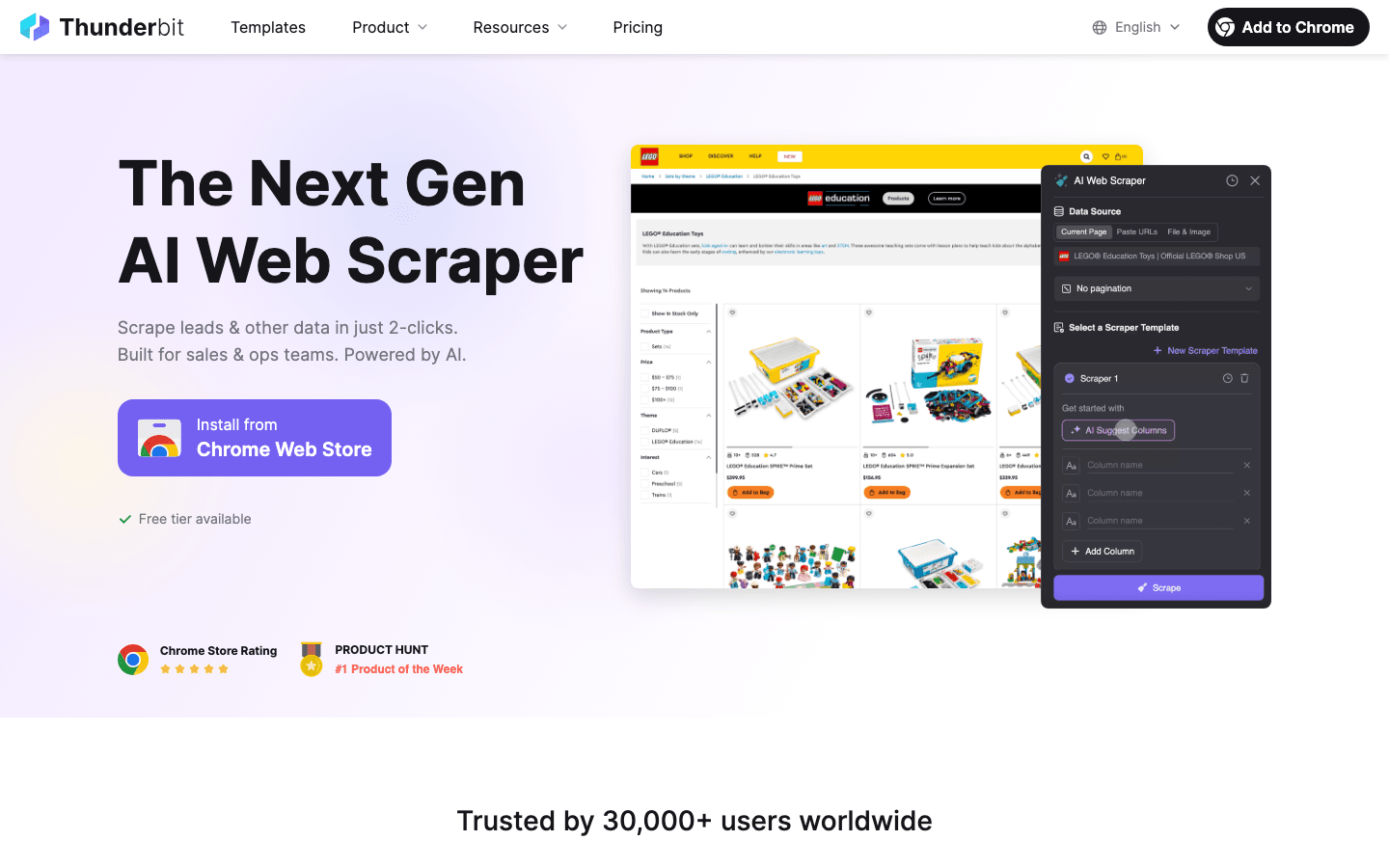

Thunderbits KI-Ansatz: So findest du wirklich alle Website-Seiten

Hier kommt der ins Spiel – und ich bin ehrlich begeistert, was wir da gebaut haben.

Thunderbit crawlt nicht einfach nur Links. Die KI „liest“ die Seite wie ein Mensch, wandelt den Inhalt vor der Extraktion in eine Markdown-ähnliche Struktur um. So versteht die KI den Kontext, erkennt Listen, Tabellen, Überschriften und kann sogar Navigationslogik ableiten. Es ist, als würde man der KI eine Lesebrille und einen Textmarker geben.

Warum ist das wichtig?

- Semantisches Verständnis: Durch die Vorverarbeitung in Markdown bekommt Thunderbits KI eine semantische Karte der Website. Sie erkennt z. B. den Unterschied zwischen Seitenmenü und Produktliste oder entdeckt „Mehr laden“-Buttons, die keine klassischen Links sind.

- Dynamische Inhalte meistern: Thunderbit kann scrollen, klicken und mit der Seite interagieren – wie ein echter Nutzer. Endlos-Scroll? Kein Problem. JavaScript-Links? Werden erkannt.

- KI-gestützte Link-Erkennung: Die KI findet Navigationselemente, die keine klassischen Links sind (z. B. Buttons oder Karten), und folgt ihnen zu Unterseiten.

- Natürliche Sprache als Prompt: Du kannst Thunderbit einfach sagen: „Finde alle Produktseiten und liste Titel und Preise auf“ – die KI erledigt den Rest.

Kurz gesagt: Thunderbit schließt die Lücke zwischen menschlichem Surfen und maschineller Datenerfassung. Es ist leistungsstark, flexibel und – ehrlich gesagt – macht richtig Spaß.

Paginierung meistern: Von Endlos-Scroll bis „Mehr laden“-Button

Ein typisches Szenario: Du bist auf einem Blog oder einer Produktliste und nach den ersten 10 Einträgen musst du entweder endlos scrollen oder ständig auf „Mehr laden“ klicken. Klassische Crawler stoppen beim initial geladenen Inhalt. Thunderbits KI hingegen weiß, wie es weitergeht.

Wie Thunderbit verschiedene Paginierungsarten erkennt

| Paginierungsart | Ablauf mit klassischen Tools | Thunderbit KI-Workflow |

|---|---|---|

| Nummerierte Seiten oder „Weiter“-Links | Folgt , wenn konfiguriert | Erkennt und klickt automatisch durch |

| „Mehr laden“-Button | Benötigt eigenes Skript für wiederholtes Klicken | KI findet und klickt bis zum Ende |

| Endlos-Scroll (Auto-Load) | Sieht nur die erste Ladung; Skripting nötig | KI scrollt und lädt alle Einträge |

| Versteckte oder JS-basierte Navigation | Wird oft komplett übersehen | KI interpretiert und navigiert wie nötig |

Mit Thunderbit reicht ein Klick auf „KI Felder vorschlagen“ und dann auf „Scrapen“. Die KI erkennt die Paginierungslogik – egal ob Button, Scroll oder URL-Parameter – und sammelt alle Daten ein. Kein Herumprobieren mit Crawl-Tiefe oder eigenen Skripten mehr.

Mehr dazu in den .

Subpage-Scraping: Mehr als nur die Hauptliste

Ein Anfängerfehler, den ich selbst gemacht habe: Ich habe eine Produkt- oder Artikelliste gescrapt, aber vergessen, jede Detailseite für die wichtigen Infos (wie Preis, Bewertungen oder Kontaktdaten) zu besuchen. Genau dafür gibt es das Subpage-Scraping.

Mit Thunderbits Subpage-Scraping-Funktion kannst du:

- Automatisch jede Detailseite aus deiner Hauptliste besuchen

- Zusätzliche Felder extrahieren (z. B. Produktspezifikationen, Autoreninfos, Kontaktdaten)

- Alle Daten in einer übersichtlichen Tabelle zusammenführen

Stell dir vor, du scrapest eine Immobilienseite: Du holst dir alle Angebote aus der Stadtübersicht, dann besucht Thunderbit jede einzelne Objektseite und sammelt Bettenzahl, Preis, Maklerkontakt usw. – alles in einem Durchgang. Kein Copy-Paste von URLs oder zweiter Crawl nötig.

Eine Schritt-für-Schritt-Anleitung findest du im .

Wann KI-Scraping, wann Website-Template?

Nicht jede Website braucht den vollen KI-Einsatz. Für Standard-Plattformen wie Amazon, Shopify oder Zillow bietet Thunderbit fertige Templates. Diese Scraper sind bereits auf die Datenstruktur abgestimmt – ein Klick genügt.

KI-Modus nutzen, wenn:

- Du auf unbekannten oder individuellen Seiten scrapen willst

- Komplexe Layouts oder spezielle Datenfelder brauchst

- Du Daten direkt transformieren oder kategorisieren möchtest

Template nutzen, wenn:

- Es sich um bekannte, standardisierte Seiten handelt (Amazon, LinkedIn, Instagram etc.)

- Du Wert auf Geschwindigkeit und höchste Genauigkeit legst

Thunderbit schlägt dir automatisch ein Template vor, wenn eines für die Seite existiert. Andernfalls einfach in den KI-Modus wechseln und die Arbeit der KI überlassen.

Website-Seiten gezielt nach Geschäftsinteresse entdecken

Ein wichtiger Punkt: „Alle Seiten finden“ ist nicht immer das eigentliche Ziel. Eigentlich geht es darum, alle relevanten Seiten für dein Geschäftsinteresse zu finden.

- Sales-Teams interessieren sich vor allem für Seiten mit Kontaktinfos.

- Marketing-Teams wollen alle Blogposts, Landingpages oder Kampagnen-URLs.

- Betriebsteams fokussieren auf Produkt- oder Compliance-Seiten.

Mit Thunderbit kannst du dein Ziel einfach in natürlicher Sprache beschreiben – „Alle Seiten mit E-Mail-Adressen finden“ oder „Jede Produktseite mit Preis und Artikelnummer auflisten“. Die KI passt den Scraping-Umfang entsprechend an, sodass du keine Zeit (oder Credits) für irrelevante Seiten verschwendest.

Tipps für effektive Scraping-Ziele:

- Sei präzise bei Feldnamen und Anweisungen

- Nutze dein Fachwissen („alle /resources/-Seiten scrapen“)

- Verfeinere deine Prompts, falls du zu viele oder zu wenige Ergebnisse bekommst

So sparst du Zeit, vermeidest Datenüberflutung und bekommst eine Linkliste, die wirklich nutzbar ist – statt nur einer riesigen URL-Sammlung.

Schritt für Schritt: Mit Thunderbit alle Seiten einer Website erfassen

Du willst es selbst ausprobieren? So erstelle ich mit Thunderbit eine vollständige Website-Linkliste – ganz ohne Programmierkenntnisse:

- : Schnelle Installation, kostenlose Version verfügbar.

- Zur Ziel-Website navigieren: Starte auf der Startseite oder in einem bestimmten Bereich.

- Thunderbit öffnen und Datenquelle festlegen: Meist ist „Aktuelle Seite“ voreingestellt.

- „KI Felder vorschlagen“ klicken: Thunderbit analysiert die Seite und schlägt Spalten wie „Seitentitel“, „URL“ usw. vor.

- Felder prüfen und anpassen: Benenne, füge hinzu oder entferne Felder nach Bedarf. Datentypen für Übersichtlichkeit festlegen.

- Subpage-Scraping aktivieren (falls nötig): Für Detailseiten „Subpages scrapen“ aktivieren und das Link-Feld auswählen.

- „Scrapen“ klicken: Thunderbit übernimmt Paginierung, Endlos-Scroll und Subpages automatisch.

- Fortschritt beobachten: Die Tabelle füllt sich. Stichproben zur Kontrolle machen.

- Linkliste exportieren: Als CSV herunterladen oder direkt nach Excel, Google Sheets, Notion oder Airtable exportieren.

- Verfeinern und wiederholen: Falls ein Bereich fehlt, neuen Scrape starten oder Prompts anpassen.

Mehr Details findest du im .

Fazit: So erstellst du mit Thunderbit eine vollständige Website-Linkliste

Die wichtigsten Erkenntnisse:

- Klassische Methoden (Google, Sitemaps, Crawler) sind hilfreich, übersehen aber oft versteckte, dynamische oder verwaiste Seiten.

- Thunderbits KI-Web-Scraper bringt ein neues Level an semantischem Verständnis, meistert komplexe Navigation, Endlos-Scroll und Subpages mit minimalem Aufwand.

- Scraping auf Geschäftsziele ausrichten – nicht einfach alles sammeln, sondern gezielt die relevanten Seiten erfassen.

- Thunderbits besonderer Vorteil: Durch die Umwandlung in Markdown vor der Extraktion erhält die KI ein tiefes, kontextuelles Verständnis der Seitenstruktur – und bleibt auch bei Layout-Änderungen oder dynamischen Inhalten robust.

- Auch für Nicht-Techniker geeignet: Kein Code, keine Skripte – einfach Ziel beschreiben und Thunderbit erledigt den Rest.

- Direkt nutzbare Ergebnisse: Strukturierte Daten exportieren und direkt loslegen – egal ob Content-Audit, SEO-Projekt oder Lead-Generierung.

Falls du KI-gestützte Website-Seiten-Entdeckung noch nicht ausprobiert hast, teste einfach mal. Du wirst überrascht sein, was sich auf deiner eigenen Website – oder bei der Konkurrenz – alles verbirgt.

Häufige Fragen (FAQ)

1. Warum ist eine vollständige Seitenliste für die Content-Planung wichtig?

Eine vollständige Liste hilft, veraltete oder verwaiste Inhalte zu erkennen, Content-Audits effizienter zu gestalten, SEO-Probleme aufzudecken und Chancen für Updates oder neue Inhalte zu finden. Sie unterstützt außerdem Lead-Generierung, Wettbewerbsanalysen und das Monitoring von Seiten.

2. Wo liegen die Grenzen klassischer Methoden, um alle Seiten zu finden?

Klassische Tools wie Google-Operatoren, Sitemaps und SEO-Crawler übersehen oft dynamische Inhalte, verwaiste Seiten oder Inhalte, die hinter Skripten und Nutzerinteraktionen verborgen sind. Komplexe Navigation und Rendering-Probleme führen dazu, dass nie alles gefunden wird.

3. Wie unterscheidet sich Thunderbits KI-Web-Scraper von klassischen Crawlern?

Thunderbit nutzt KI, um die semantische Struktur einer Seite zu verstehen, indem sie vor der Extraktion in Markdown umgewandelt wird. So kann die KI Endlos-Scroll, JavaScript-Links und „Mehr laden“-Buttons meistern und das Nutzerverhalten simulieren.

4. Welche Teams profitieren von einer vollständigen Linkliste und wie?

SEO, Content Marketing, Sales, E-Commerce und Compliance profitieren alle: SEO-Teams finden und beheben verwaiste Seiten, Sales extrahiert Kontaktseiten, Ops überwacht schwer auffindbare Produktseiten.

5. Wann sollte man den KI-Modus von Thunderbit nutzen und wann ein Template?

Den KI-Modus nutzt du bei unbekannten, individuellen oder komplexen Websites mit dynamischen Interaktionen oder speziellen Datenstrukturen. Templates sind ideal für bekannte Plattformen wie Shopify oder Amazon, da sie schnelle und präzise Ergebnisse liefern.

Mehr erfahren: