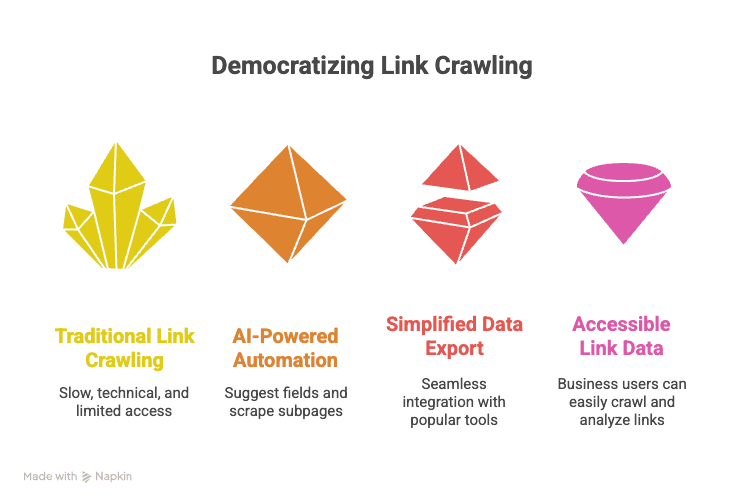

Früher war das alle links auf einer website crawlen eine Sache für Suchmaschinen-Profis oder besonders fleißige Praktikanten – heute ist das längst nicht mehr nur ein Thema für Google & Co. Egal ob Vertriebsteams auf Lead-Jagd, Marketing-Leute beim Wettbewerbs-Check oder Operations, die Produktkataloge prüfen: Die Fähigkeit, wirklich alle Links einer Website zu erfassen, ist zum Geheimtipp für alle geworden, die mit Webdaten arbeiten. Aus meiner Erfahrung im SaaS- und Automatisierungsbereich weiß ich: Mit den richtigen Tools wird aus einer nervigen, technischen Aufgabe ein echter Produktivitäts-Booster – und das mit nur ein paar Klicks.

Klar ist: Das Web ist riesig und alles läuft auf Highspeed. Laut aktuellen Branchenreports , und . Das Problem: Die meisten klassischen SEO crawler sind für Entwickler gebaut – nicht für Business-Anwender, die schnelle, präzise Ergebnisse ohne Programmierung wollen. Deshalb zeige ich dir, wie moderne KI-Tools wie es jedem ermöglichen, alle Links einer Website zu crawlen, die Daten zu strukturieren und direkt weiterzuverarbeiten – ganz ohne Python-Skripte oder SEO agentur uk-Fachchinesisch.

Was bedeutet es, „alle Links einer Website zu crawlen“?

Lass uns kurz die Begriffe klären. Alle links auf einer website crawlen heißt, systematisch jede erreichbare URL einer Seite zu erfassen – also eine komplette Landkarte aller Unterseiten zu erstellen, nicht nur die Startseite. Stell dir vor, ein Roboter läuft durch jedes Zimmer eines Hauses, öffnet jede Tür und notiert sich jede Zimmernummer. Genau das macht ein Web-Scraper (auch Spider genannt): Er startet auf einer Seite, folgt jedem Link, dann den Links auf den Folgeseiten – bis wirklich jede Ecke entdeckt ist ().

Wichtig: Crawling ist nicht das Gleiche wie Scraping oder Indexing. Crawling bedeutet, alle URLs zu finden. Scraping heißt, gezielt Daten von diesen URLs zu extrahieren (z. B. Preise oder E-Mail-Adressen). Indexing wiederum organisiert und speichert diese Daten für Suche oder Analyse (). Wenn wir von „alle Links einer Website crawlen“ sprechen, meinen wir den ersten Schritt: Mit einem Tool automatisch jede erreichbare URL erfassen – auch versteckte Seiten, die nicht im Hauptmenü stehen.

Warum ist das Crawlen aller Links für Vertrieb, Marketing und Operations so wertvoll?

Du fragst dich vielleicht: „Warum sollte ich als Business-Anwender alle Links crawlen?“ Die Antwort: Strukturierte Linkdaten sind die Basis für effizientere Workflows. So nutzen verschiedene Teams diese Daten:

| Team | Anwendungsbeispiel | Vorteile |

|---|---|---|

| Marketing | Die komplette Website eines Wettbewerbers crawlen, um alle Landingpages und Blogposts zu erfassen | Content-Strategien erkennen, Lücken aufdecken, Inspiration für Kampagnen gewinnen |

| Vertrieb | Das Mitgliederverzeichnis eines Branchenverbands crawlen, um alle Profil-Links zu sammeln | Zielgerichtete Lead-Listen in Sekunden erstellen, Kontaktdaten mit Tools wie Thunderbits E-Mail-Extraktor extrahieren |

| Operations | Alle Produktseiten eines Lieferanten oder Konkurrenten crawlen | Bestände, Preise oder Verfügbarkeiten im großen Stil überwachen; Kataloge automatisiert prüfen |

| Immobilien | Immobilienportale crawlen und alle Detailseiten der Objekte erfassen | Immobilieninfos, Preise und Kontaktdaten für Marktanalysen oder Lead-Generierung bündeln |

Der Mehrwert ist klar: Unternehmen, die Web Crawling so einsetzen, berichten von . So steigerte zum Beispiel John Lewis die Umsätze um 4 % durch Preis-Scraping bei Wettbewerbern, und ASOS verdoppelte die internationalen Verkäufe, indem sie regionale Inhalte crawlen und ihre Kampagnen optimieren konnten.

Das Entscheidende: Strukturierte Linkdaten machen aus Websites durchsuchbare Datenbanken. Statt jede Seite einzeln anzuklicken, bekommst du mit einem Crawl sofort eine Excel-Tabelle mit allen URLs – bereit zum Filtern, Analysieren oder Anreichern.

Klassische Methoden zum Crawlen aller Links: Vor- und Nachteile

Bevor es KI-Tools gab, war das alle links auf einer website crawlen oft mühsam oder technisch anspruchsvoll. So schneiden die traditionellen Methoden ab:

| Methode | Erforderliche Kenntnisse | Vorteile | Nachteile |

|---|---|---|---|

| Manuelles Klicken / Google-Suche | Keine | Für kleine Seiten machbar | Langsam, fehleranfällig, übersieht versteckte Seiten, nicht skalierbar |

| Sitemap/robots.txt | Gering (XML lesen) | Schnell, falls vorhanden | Nicht jede Seite hat eine Sitemap; oft unvollständig oder veraltet |

| SEO-Crawler (z. B. Screaming Frog) | Mittel | Gründlich, findet die meisten Links | Kostenlose Version auf 500 URLs limitiert; technische Oberfläche; Einarbeitung nötig |

| Eigene Skripte (Python etc.) | Hoch (Programmierung) | Maximale Kontrolle, anpassbar | Programmierkenntnisse nötig, bricht bei Website-Änderungen, hoher Wartungsaufwand |

| No-Code-Scraper (vor KI) | Gering-Mittel | Einfacher als Programmieren, einige Vorlagen | Einrichtung nötig, kommt mit dynamischen Seiten schlecht klar, wichtige Funktionen oft kostenpflichtig |

Für Nicht-Techniker waren diese Optionen meist zu langsam, zu kompliziert oder zu eingeschränkt. Ich habe schon viele Marketer erlebt, die bei Screaming Frog entnervt aufgegeben haben – und unzählige Vertriebler, die beim händischen Lead-Bau gescheitert sind.

Thunderbit: Der schnellste Weg, alle Links einer Website zu crawlen (ohne Programmierung)

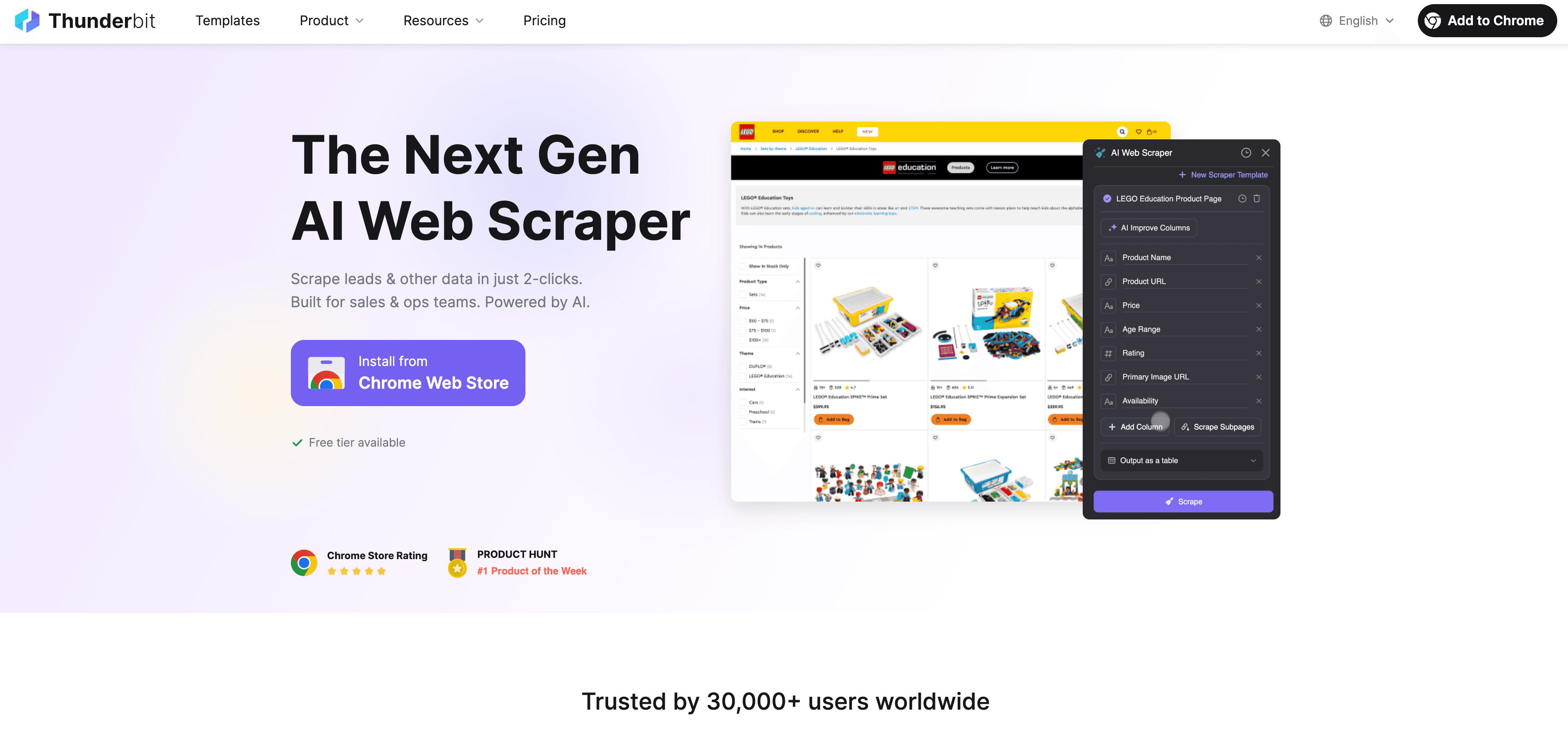

Hier kommt ins Spiel. Thunderbit ist eine KI-gestützte Chrome-Erweiterung für Business-Anwender, die Ergebnisse wollen – keine Kopfschmerzen. Unser Ziel: „Alle Links einer Website crawlen“ soll so einfach wie zwei Klicks sein – ohne Code, ohne Setup, ohne Fachbegriffe.

Wie Thunderbits KI-Feldvorschläge das Link-Crawling revolutionieren

So funktioniert’s:

- Öffne die Ziel-Website in Chrome.

- Klicke auf das Thunderbit-Icon.

- Wähle „KI-Felder vorschlagen“. Thunderbits KI analysiert die Seite, erkennt die Struktur und schlägt passende Felder vor – etwa „Link-Text“, „URL“ oder „Kategorie“, falls verschiedene Seitentypen erkannt werden.

- Übernimm oder passe die vorgeschlagenen Spalten an (umbenennen, hinzufügen, entfernen).

- Klicke auf „Scrapen“. Thunderbit crawlt die Seite, folgt den Links und erstellt eine strukturierte Tabelle aller gefundenen URLs.

Keine Rezepte, keine Selektoren, keine Einarbeitung. Einfach klicken und die KI erledigt den Rest. Mehr Details findest du in den .

Strukturierte Linkdaten exportieren: Excel, Google Sheets & mehr

Nach dem Crawl kannst du die Daten direkt nach exportieren. Der Export ist sauber, strukturiert und sofort einsatzbereit – egal ob für Outreach, Analyse oder CRM-Import. Und im Gegensatz zu vielen Tools sind Thunderbits Exporte .

Über die Startseite hinaus: Subpage Scraping für tiefere Link-Analysen

Hier spielt Thunderbit seine Stärken aus. Viele wichtige Seiten liegen mehrere Klicks tief – etwa Produktdetailseiten, Mitgliederprofile oder Downloads. Mit Thunderbits Subpage Scraping kannst du automatisch alle Unterseiten besuchen und dort weitere Links oder Daten extrahieren.

Beispiele:

- E-Commerce: Katalog crawlen, dann jede Produktseite besuchen und Preise, Verfügbarkeit, Bilder erfassen.

- Immobilien: Verzeichnis crawlen, dann auf jeder Objektseite Fläche, Preis und Maklerdaten extrahieren.

Mit Subpage Scraping erhältst du nicht nur eine flache Linkliste, sondern ein mehrstufiges, strukturiertes Datenset, das die Website-Struktur widerspiegelt.

Linkdaten kategorisieren und strukturieren: Mehr als nur eine URL-Liste

Beim Crawlen geht es nicht nur um eine Liste von URLs. Thunderbit kann Links automatisch kategorisieren (z. B. Produktseiten, Blogposts, Downloads, Kontaktformulare) und beim Scrapen entsprechend labeln. Das bringt Business-Anwendern echte Vorteile:

- Marketing: Sofort alle Landingpages oder Blogposts filtern und für Kampagnen analysieren.

- Vertrieb: Erkennen, welche Links zu Firmenprofilen, Kontaktformularen oder Downloads führen.

- Operations: Produktseiten von Support-Dokumenten oder FAQs trennen und gezielt prüfen.

Mit Thunderbits kannst du sogar festlegen, wie Links gelabelt oder angereichert werden – ganz ohne Nachbearbeitung.

Praxisbeispiele: Wie Teams „alle Links einer Website crawlen“ nutzen

Konkret sieht das so aus:

Marketing: Alle Landingpages eines Wettbewerbers extrahieren

Ein SaaS-Marketingteam wollte die Anzeigenstrategie eines Konkurrenten analysieren. Mit Thunderbit crawlen sie die komplette Website, filtern nach URLs mit „/landing“ und exportieren über 25 Landingpages. Anschließend extrahieren sie Meta-Beschreibungen und Überschriften, vergleichen die Botschaften und entdecken Lücken im eigenen Content. Das Ergebnis: Höhere Anzeigenqualität und bessere Conversion – ganz ohne Programmierung.

Vertrieb: Hochwertige B2B-Leadliste aufbauen

Ein B2B-Vertriebsteam nimmt das Mitgliederverzeichnis eines Branchenverbands ins Visier. Mit Thunderbit werden alle Profil-Links gecrawlt und mit dem integrierten die Kontaktdaten gesammelt. Was früher Wochen an Copy-Paste-Arbeit bedeutete, ist jetzt in Minuten erledigt – und die Leads landen direkt in Google Sheets.

Schritt-für-Schritt-Anleitung: So crawlst du alle Links einer Website mit Thunderbit

Du willst es selbst ausprobieren? So einfach geht’s – ganz ohne Technikkenntnisse:

Schritt 1: Thunderbit Chrome-Erweiterung installieren

- Rufe die auf.

- Klicke auf „Zu Chrome hinzufügen“.

- Melde dich an oder erstelle ein kostenloses Konto. Thunderbit läuft auf Chrome, Edge und anderen Chromium-Browsern und unterstützt 34 Sprachen.

Schritt 2: Ziel-Website öffnen und Thunderbit starten

- Gehe auf die gewünschte Website.

- Klicke auf das Thunderbit-Icon in der Browserleiste, um die Sidebar zu öffnen.

Schritt 3: Mit KI-Feldvorschlägen alle Links erkennen

- Klicke auf „KI-Felder vorschlagen“.

- Thunderbits KI scannt die Seite und schlägt Spalten wie „Link-Text“, „URL“ und „Kategorie“ vor.

- Prüfe und passe die Felder bei Bedarf an (umbenennen, hinzufügen, entfernen).

Schritt 4: Crawlen starten und Ergebnisse exportieren

- Klicke auf „Scrapen“.

- Thunderbit crawlt die Seite, folgt den Links und erstellt eine strukturierte Tabelle aller URLs.

- Nach Abschluss auf „Exportieren“ klicken, um die Daten nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON zu exportieren.

Schritt 5: (Optional) Subpages für vollständige Abdeckung crawlen

- In der Ergebnistabelle die Spalte mit den URLs auswählen.

- Klicke auf „Subpages scrapen“, damit Thunderbit jede Unterseite besucht und weitere Daten (z. B. Preise, Kontaktdaten, Beschreibungen) extrahiert.

- Das angereicherte Datenset exportieren und weiter analysieren.

Thunderbit im Vergleich zu anderen Link-Crawling-Lösungen

So schlägt sich Thunderbit im Vergleich zu klassischen Ansätzen:

| Ansatz | Erforderliche Kenntnisse | Setup-Aufwand | Export-Optionen | Subpage Scraping | Kostenlose Limits | Besondere Vorteile |

|---|---|---|---|---|---|---|

| Manuelles Browsen | Keine | Hoch | Manuelles Copy-Paste | Nein | N/A | Keine Tools nötig |

| Sitemap/robots.txt | Gering | Gering | XML-Import | Nein | N/A | Schnell, falls vorhanden |

| SEO-Crawler (Screaming Frog) | Mittel | Mittel | CSV, Excel | Nein | 500 URLs (free) | Gründlich, technische SEO-Features |

| Eigenes Skript (Python) | Hoch | Hoch | Individuell | Ja (wenn programmiert) | Unbegrenzt (bei Eigenentwicklung) | Flexibel, anpassbar |

| No-Code-Scraper (vor KI) | Gering-Mittel | Mittel | CSV, Excel, eingeschränkt | Teilweise | Oft kostenpflichtig | Einfacher als Code, aber Einrichtung nötig |

| Thunderbit | Keine | Sehr gering | Excel, Sheets, Notion | Ja | 6–10 Seiten (kostenlos), skalierbar | KI-gestützt, 2-Klick-Setup, unbegrenzter Export |

Thunderbits Vorteil? Kein Programmieren, keine Rezepte, sofortige Ergebnisse – und Subpages sowie Link-Kategorisierung inklusive. Für Business-Anwender ist das der Unterschied zwischen „Ich schau’s mir später mal an“ und „Erledigt, bevor der zweite Kaffee fertig ist“.

Fazit: Link-Crawling für alle – einfach, schnell, effizient

- Alle Links einer Website zu crawlen ist heute ein echter Gamechanger für Business-Teams – nicht nur für Entwickler oder SEO-Profis.

- Strukturierte Linkdaten ermöglichen smartere Workflows in Vertrieb, Marketing und Operations – von Lead-Generierung bis Wettbewerbsanalyse.

- Klassische Tools sind langsam, technisch oder eingeschränkt – Thunderbit macht’s für alle einfach und schnell.

- KI-Feldvorschläge + Subpage Scraping = Produktivität mit zwei Klicks – kein Copy-Paste, kein Skript-Stress.

- Export in Excel, Sheets, Notion oder Airtable in Sekunden – deine Daten sind sofort einsatzbereit.

Wenn du schon immer mal „alle Links einer Website crawlen“ wolltest – ohne Aufwand, dann ist jetzt der perfekte Zeitpunkt. , probier’s auf einer beliebigen Website aus und spar dir Zeit (und Nerven). Noch mehr Tipps, Anleitungen und Praxisbeispiele findest du im .

Häufige Fragen (FAQ)

1. Was ist der Unterschied zwischen Crawling, Scraping und Indexing?

Crawling bedeutet, alle URLs einer Website zu entdecken. Scraping heißt, gezielt Daten von diesen URLs zu extrahieren (z. B. Produktinfos oder Kontaktdaten). Indexing organisiert und speichert diese Daten für Suche oder Analyse.

2. Warum sollte ein Business-Anwender alle Links einer Website crawlen?

Strukturierte Linkdaten helfen Vertriebsteams beim Aufbau von Lead-Listen, Marketern bei der Wettbewerbsanalyse und Operations bei Katalogprüfungen oder Monitoring. Websites werden so zu durchsuchbaren Datenbanken für Outreach, Analyse und Automatisierung.

3. Was unterscheidet Thunderbit von klassischen Crawling-Tools?

Thunderbit nutzt KI, um Felder vorzuschlagen und das Crawling zu automatisieren – ohne Programmierung oder Setup. Es verarbeitet Subpages, kategorisiert Links und exportiert strukturierte Daten direkt nach Excel, Google Sheets, Notion oder Airtable.

4. Kann Thunderbit auch dynamische Seiten oder Seiten hinter Logins crawlen?

Ja! Thunderbit unterstützt sowohl browserbasiertes als auch cloudbasiertes Crawling. Für Seiten mit Login nutzt du den Browser-Modus; für öffentliche Seiten ist der Cloud-Modus schneller und kann bis zu 50 Seiten gleichzeitig crawlen.

5. Gibt es eine kostenlose Version von Thunderbit?

Klar! Mit dem kostenlosen Plan kannst du bis zu 6 Seiten crawlen (oder 10 mit Gratis-Test), und unbegrenzt exportieren. Bezahlpläne starten ab 15 $/Monat für größere Projekte.

Mehr erfahren: