In den letzten Jahren ist das Interesse an Web-Scraping regelrecht explodiert. Egal ob Vertrieb, E-Commerce, Immobilien oder Marktforschung – überall setzen Unternehmen auf Webdaten, um klügere Entscheidungen zu treffen. Aber: Den passenden Web-Scraping-Entwickler zu finden, fühlt sich oft an wie die Suche nach einer Nadel im Heuhaufen. Ich habe schon erlebt, wie Teams wochenlang Zeit und viel Geld in die falsche Person gesteckt haben – am Ende gab’s dann fehlerhafte Skripte, verpasste Deadlines oder schlichtweg falsche Daten.

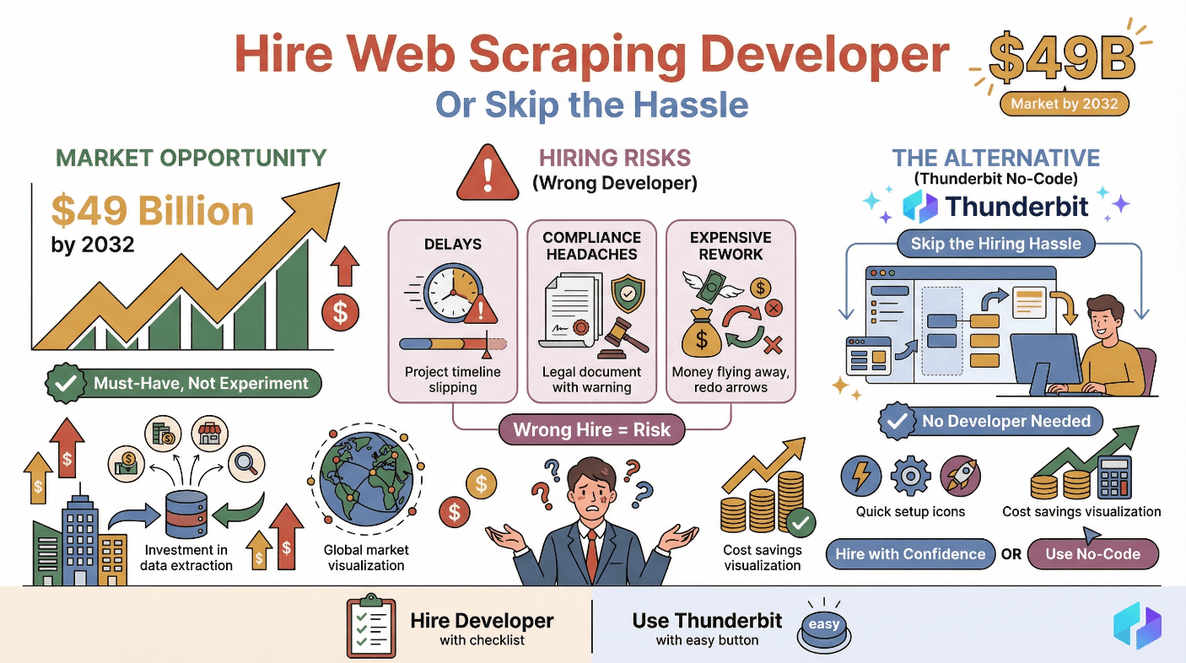

Falls du gerade überlegst, wie du einen Web-Scraping-Entwickler beauftragen kannst, bist du nicht allein. Der globale Markt für Web-Scraping wird bis , und immer mehr Unternehmen sehen die Datenextraktion als unverzichtbar an. Aber mit den Chancen kommen auch Risiken: Ein Fehlgriff bei der Auswahl kann zu Verzögerungen, Compliance-Problemen oder teuren Nachbesserungen führen (). Lass uns gemeinsam Schritt für Schritt anschauen, wie du gezielt Web-Scraping-Talente findest – oder dir den ganzen Aufwand mit einem No-Code-Tool wie einfach sparst.

Was macht ein Web-Scraping-Entwickler?

Im Grunde ist ein Web-Scraping-Entwickler so etwas wie dein Daten-Detektiv. Er entwickelt Tools und Skripte, um Infos von Webseiten zu holen – zum Beispiel Produktpreise, Kontaktdaten, Bewertungen oder Immobilienangebote – und liefert sie dir in einem praktischen Format wie Excel, CSV oder Google Sheets.

Typische Aufgaben eines Web-Scraping-Entwicklers:

- Daten extrahieren: Code schreiben (meist mit Python), um Daten von Webseiten, APIs oder PDFs zu sammeln.

- Daten strukturieren: Unstrukturierte Webinhalte aufbereiten und in übersichtliche Tabellen oder Datenbanken bringen.

- Ergebnisse liefern: Export der Daten als CSV, Excel oder JSON.

- Scraper pflegen: Skripte anpassen, wenn sich Webseiten ändern oder neue Anti-Bot-Maßnahmen auftauchen.

Gefragt sind Skills wie Python, , und API-Integration. Die besten Entwickler sind außerdem echte Problemlöser – zum Beispiel, wenn es darum geht, Anti-Scraping-Maßnahmen zu umgehen oder auf plötzliche Website-Änderungen zu reagieren.

Warum einen Web-Scraping-Entwickler beauftragen? Geschäftliche Vorteile und Anwendungsfälle

Warum lohnt es sich, in einen Web-Scraping-Entwickler zu investieren? Ganz einfach: Manuelles Datensammeln ist langsam, fehleranfällig und nicht skalierbar. Automatisierung spart deinem Team und liefert Einblicke, die sonst verborgen bleiben.

So setzen verschiedene Teams Web-Scraping ein:

| Geschäftsbereich | Anwendungsfall | Beispiel |

|---|---|---|

| Vertrieb | Lead-Generierung | Kontaktdaten aus Verzeichnissen oder LinkedIn extrahieren |

| Marketing | Wettbewerbsbeobachtung | Produktneuheiten oder Preise der Konkurrenz verfolgen |

| E-Commerce | Preisüberwachung | Preise und Lagerbestände von Mitbewerbern beobachten |

| Operations | Lieferantendaten sammeln | Lieferanteninfos und Produktspezifikationen aggregieren |

| Immobilien | Immobilienangebote | Angebote und Preistrends von verschiedenen Portalen erfassen |

Return on Investment: Unternehmen, die die Datenerfassung automatisieren, berichten von , und Teams mit KI-gestützten Scraper-Lösungen sparen bei Datentasks.

Schritt 1: Anforderungen für dein Web-Scraping-Projekt festlegen

Bevor du eine Stellenanzeige schaltest oder Freelancer kontaktierst, solltest du deine Anforderungen ganz klar definieren. Unklare Vorgaben sind der Hauptgrund, warum Web-Scraping-Projekte scheitern.

Fragen, die du dir stellen solltest:

- Von welchen Webseiten brauche ich Daten? Liste die URLs oder Seitentypen auf.

- Welche Datenfelder sind wichtig? (z. B. Produktname, Preis, E-Mail, Telefonnummer)

- Wie oft sollen die Daten aktualisiert werden? Einmalig, täglich, wöchentlich?

- In welchem Format sollen die Daten geliefert werden? Excel, CSV, Google Sheets, Datenbank?

- Bis wann brauche ich die Daten? Sei realistisch – komplexe Seiten brauchen Zeit.

Beispiel-Checkliste für Projektanforderungen:

- Ziel-Webseiten: [URLs auflisten]

- Datenfelder: [z. B. Name, E-Mail, Preis, SKU]

- Häufigkeit: [z. B. wöchentliche Updates]

- Ausgabeformat: [CSV, Excel, Google Sheets]

- Lieferzeitraum: [z. B. 2 Wochen]

- Login oder Anti-Bot-Maßnahmen? [Ja/Nein]

Mehr dazu, wie du Anforderungen richtig formulierst, findest du in .

Schritt 2: Wo und wie findest du Web-Scraping-Entwickler?

Sobald du weißt, was du brauchst, geht die Suche los. Hier starten die meisten Teams:

- Freelance-Plattformen: , Freelancer, Fiverr – super für kurzfristige oder einmalige Projekte.

- Spezialisierte Agenturen: Bieten gemanagte Teams für größere oder laufende Scraping-Projekte.

- Jobbörsen: Glassdoor, Indeed, LinkedIn – ideal für Festanstellungen oder langfristige Verträge.

- Globale Talent-Marktplätze: Toptal, Guru, PeoplePerHour – Zugang zu geprüften Entwicklern weltweit.

Regionale Kostenunterschiede:

- Indien/Osteuropa: Günstigere Stundensätze, gut für kostenbewusste Projekte ().

- USA/EU: Höhere Preise, oft mehr Erfahrung mit komplexen oder regulierten Projekten.

Tipps für die Stellenausschreibung:

- Nutze das Keyword „Web-Scraping-Entwickler gesucht“ im Titel und Text.

- Nenne Zielseiten, Datenfelder und gewünschtes Ausgabeformat.

- Liste die nötigen Skills (Python, Selenium, BeautifulSoup, API-Erfahrung).

- Erwähne Anti-Bot- oder Login-Anforderungen.

So schreibst du eine Stellenbeschreibung für einen Web-Scraping-Entwickler

Beispiel-Gliederung:

- Titel: Web-Scraping-Entwickler für [Projekttyp] gesucht

- Über uns: Kurzvorstellung deines Unternehmens

- Projektüberblick: Was soll gescraped werden, warum und wie oft

- Aufgaben: Konkrete Tätigkeiten (Datenextraktion, Bereinigung, Lieferung)

- Must-Have-Skills: Python, Selenium, BeautifulSoup, API-Integration

- Nice-to-Have: Erfahrung mit Proxies, CAPTCHAs, Datenbereinigung

- Lieferumfang: Was, wann und in welchem Format

- Bewerbungsanleitung: Bitte um ein Portfolio oder Beispielprojekt

Weitere Inspiration findest du in .

Schritt 3: Technische Fähigkeiten mit Praxistests prüfen

Lebensläufe sind nett, aber nichts geht über einen Praxistest. Gib Kandidaten eine kleine, bezahlte Probeaufgabe – zum Beispiel das Scrapen einer Beispielseite und die Lieferung der Daten im gewünschten Format.

Wichtige Technologien zum Testen:

- Python: Die Standardsprache fürs Scraping.

- Selenium: Für die Automatisierung von Browsern und dynamischen Seiten.

- BeautifulSoup: Zum Parsen von HTML und Extrahieren von Daten.

- API-Handling: Für Seiten mit offiziellen Datenschnittstellen.

Beispiel-Testaufgabe:

„Scrape die ersten 20 Produkte von [example.com], inklusive Name, Preis und URL. Lieferung als CSV.“

Warnsignale:

- Unsauberer Code oder fehlende Dokumentation

- Unvollständige oder fehlerhafte Daten

- Probleme mit Paginierung oder dynamischen Inhalten

Mehr zur Bewertung von Freelancern findest du in .

Problemlösungskompetenz und Anpassungsfähigkeit bewerten

Web-Scraping ist mehr als nur Code – es geht darum, flexibel auf Veränderungen zu reagieren. Gute Entwickler können:

- Sich an neue Webseitenlayouts anpassen.

- Anti-Scraping-Maßnahmen (z. B. CAPTCHAs, IP-Sperren) umgehen.

- Fehler schnell beheben und Lösungen klar kommunizieren.

Beispielfragen fürs Interview:

- „Was tun Sie, wenn eine Website Ihre Anfragen blockiert?“

- „Wie gehen Sie mit Seiten um, die Inhalte per JavaScript nachladen?“

- „Beschreiben Sie eine Situation, in der Sie einen Scraper nach einem Redesign anpassen mussten.“

Weitere Interviewideen findest du in .

Schritt 4: Soft Skills und Kommunikation prüfen

Technisches Know-how ist nur die halbe Miete. Die besten Web-Scraping-Entwickler sind außerdem:

- Kommunikativ: Sie erklären Fortschritte und Probleme verständlich.

- Zuverlässig: Sie halten Deadlines ein und melden Probleme frühzeitig.

- Proaktiv: Sie machen Verbesserungsvorschläge oder erkennen Risiken, bevor sie entstehen.

Beispielfragen fürs Gespräch:

- „Wie halten Sie Kunden über den Projektstatus auf dem Laufenden?“

- „Beschreiben Sie eine Situation, in der Sie unklare Anforderungen klären mussten.“

- „Wie gehen Sie mit Feedback oder sich ändernden Prioritäten um?“

Da Web-Scraping-Projekte meist remote laufen, achte auf Erfahrung mit Tools wie Slack, Trello oder Asana und auf die Fähigkeit, über Zeitzonen hinweg zu arbeiten ().

Schritt 5: Kosten vergleichen und Angebot machen

Jetzt wird’s konkret: Die Stundensätze für Web-Scraping-Entwickler schwanken je nach Region, Erfahrung und Projektumfang stark.

Typische Preismodelle:

- Stundensatz: Flexibel für laufende oder offene Projekte.

- Pauschalpreis: Fester Preis für klar umrissene Aufgaben.

- Retainer: Laufende Betreuung und Wartung.

Durchschnittliche Stundensätze nach Region:

| Region | Stundensatz (USD) | Hinweise |

|---|---|---|

| Indien/Osteuropa | $15–$35 | Kostengünstig, gut für Standardaufgaben |

| USA/Kanada | $40–$100+ | Höhere Preise, komplexe/Compliance-Projekte |

| Westeuropa | $45–$90 | Ähnlich wie USA, stark bei Datenschutz |

| Globaler Median | $20–$40 | Die meisten Upwork/Freelancer-Projekte liegen hier |

(, )

Tipps für die Verhandlung:

- Klare Absprachen zu Lieferumfang, Zeitplan und Zahlungsmodalitäten treffen.

- Eine Klausel für Wartung oder schnelle Fehlerbehebung bei Website-Änderungen einbauen.

- Datensicherheit mit NDAs und klarer Regelung der Datenrechte absichern.

Schritt 6: Onboarding und Zusammenarbeit mit deinem Web-Scraping-Entwickler

Nach der Einstellung sorgst du für einen reibungslosen Start:

- Alle Anforderungen und Beispieldaten bereitstellen.

- Zugangsdaten geben (falls Login nötig).

- Kommunikationskanäle einrichten (Slack, E-Mail, Projektmanagement-Tools).

- Meilensteine und Check-ins festlegen.

- Datensicherheit und Compliance besprechen – besonders bei sensiblen Informationen.

Onboarding-Checkliste:

- Projektbeschreibung und Anforderungen

- Zugang zu Ziel-Webseiten

- Vorlagen für Ausgabeformate

- Kommunikationsplan (wie oft, über welche Kanäle)

- Sicherheitsrichtlinien

Mehr zum Management von Remote-Tech-Talenten findest du in .

Thunderbit: Die No-Code-Alternative zum Web-Scraping-Entwickler

Und jetzt kommt das Beste: Was wäre, wenn du dir den ganzen Einstellungsprozess einfach sparen könntest? Genau dafür gibt’s . Als KI-basierter No-Code-Web-Scraper macht Thunderbit es jedem möglich, Webdaten zu extrahieren – ganz ohne Python, Selenium oder Entwickler.

So nimmt dir Thunderbit den Einstellungsstress ab:

- KI-Feldvorschläge: Einfach klicken, und Thunderbit schlägt dir die besten Spalten zur Extraktion vor.

- Unterseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch jede Unterseite (z. B. Produkt- oder Profilseiten) und reichert deine Daten an.

- Sofort-Export: Lade deine Daten direkt in Excel, Google Sheets, Airtable oder Notion – kostenlos und unbegrenzt.

- Kein Code nötig: Jeder kann’s nutzen, vom Vertrieb bis zum E-Commerce-Manager.

- Kostengünstig: Der Einstieg ist gratis, kostenpflichtige Pläne starten ab nur 15 $/Monat – viel günstiger als ein Entwickler für kleine Projekte.

Thunderbit vs. Entwickler beauftragen:

| Faktor | Entwickler beauftragen | Thunderbit |

|---|---|---|

| Einrichtungszeit | Tage bis Wochen | Minuten |

| Technische Kenntnisse | Erforderlich | Nicht nötig |

| Kosten | $500–$5.000+ pro Projekt | Kostenlos–$15/Monat für die meisten |

| Wartung | Laufend (bei Website-Änderungen) | KI passt sich automatisch an |

| Datenexport | Unterschiedlich (oft Skripte nötig) | 1-Klick zu Excel/Sheets/Notion |

| Unterseiten-Scraping | Individuelle Programmierung nötig | Integriert, keine Einrichtung |

| Am besten geeignet für | Komplexe, individuelle Projekte | 95 % aller Business-Scraping-Aufgaben |

Vertrau nicht nur auf mein Wort – und wird von über 30.000 Nutzern weltweit eingesetzt.

Wann solltest du trotzdem einen Entwickler beauftragen? Wenn du sehr individuelle Logik brauchst, besonders geschützte Seiten scrapen oder mit Altsystemen integrieren musst, ist ein Entwickler weiterhin die beste Wahl. Für die meisten Business-Scraping-Aufgaben aber bringt dich Thunderbit schneller, günstiger und stressfrei ans Ziel.

Fazit & wichtigste Erkenntnisse

Die Suche nach einem Web-Scraping-Entwickler muss kein Glücksspiel sein. Mein Tipp für dich:

- Starte mit klaren Anforderungen. Zielseiten, Datenfelder und Ausgabeformat vorher festlegen.

- Setze auf Praxistests. Nicht nur Lebensläufe zählen – fordere eine Beispiel-Extraktion an.

- Problemlösung und Kommunikation sind entscheidend. Die besten Entwickler sind flexibel und halten dich auf dem Laufenden.

- Kosten und Regionen vergleichen. Budget und Projektkomplexität abwägen.

- No-Code-Tools wie Thunderbit prüfen. Für die meisten Business-Anforderungen sparst du dir so den Einstellungsprozess und bekommst in Minuten Ergebnisse.

Bereit, deine Datensammlung zu automatisieren? und erlebe, wie einfach Web-Scraping sein kann – ohne Einstellung, ohne Code, einfach Resultate.

Noch mehr Tipps zu Web-Scraping, Automatisierung und Business-Produktivität findest du im .

Häufige Fragen (FAQ)

1. Was kostet es, einen Web-Scraping-Entwickler zu beauftragen?

Die Preise hängen von Region und Erfahrung ab. Die meisten Freelancer verlangen zwischen . Entwickler in den USA/EU liegen oft bei $40–$100+ pro Stunde, in Indien/Osteuropa meist bei $15–$35.

2. Welche Fähigkeiten sollte ein Web-Scraping-Entwickler mitbringen?

Erfahrung mit Python, Selenium, BeautifulSoup und API-Integration ist wichtig. Problemlösungskompetenz und Anpassungsfähigkeit sind essenziell, da Webseiten sich oft ändern und Schutzmechanismen haben können.

3. Wie kann ich die Fähigkeiten eines Kandidaten testen?

Gib eine kleine, bezahlte Probeaufgabe – zum Beispiel das Scrapen einer Beispielseite und Lieferung der Daten im gewünschten Format. Schau auf Codequalität, Datenkorrektheit und wie mit Paginierung oder dynamischen Inhalten umgegangen wird.

4. Welche Risiken gibt es bei der falschen Wahl eines Web-Scraping-Entwicklers?

Typische Probleme sind verpasste Deadlines, fehlerhafte Skripte bei Website-Änderungen, Compliance-Risiken und schlechte Datenqualität. Prüfe Referenzen, Beispielarbeiten und setze klare Verträge auf.

5. Wann sollte ich ein No-Code-Tool wie Thunderbit statt eines Entwicklers nutzen?

Wenn dein Projekt Standard-Datenextraktion (z. B. Produktlisten, Kontaktdaten, Preisüberwachung) umfasst und keine individuelle Logik braucht, sparst du mit Zeit und Geld – ganz ohne Einstellung oder Programmierung.

Bereit für den nächsten Schritt? Teste Thunderbit kostenlos oder starte deine Suche mit einem klaren Plan und den richtigen Fragen. Viel Erfolg beim Scraping!