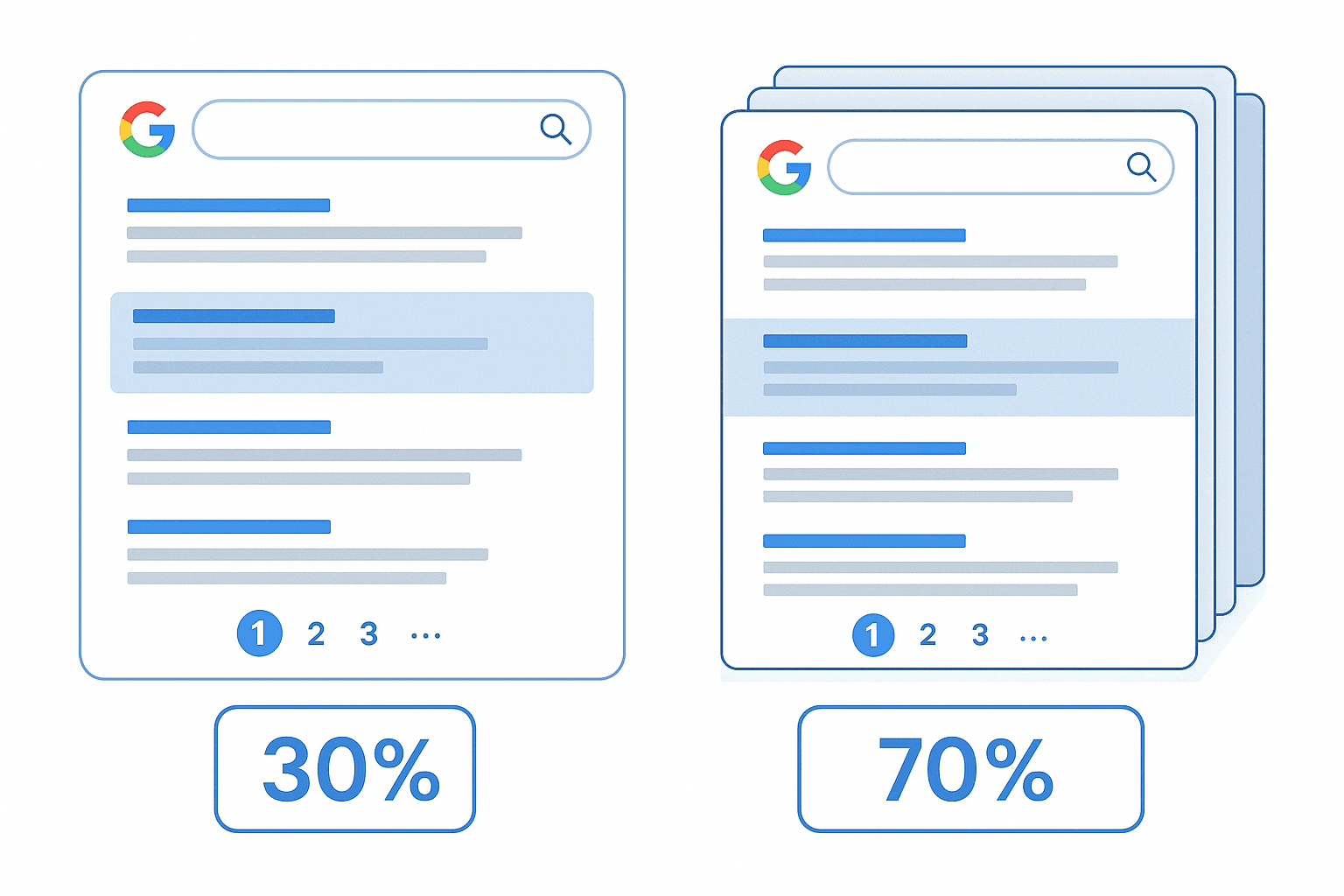

Ganz ehrlich: Als ich damals mit dem Scrapen von Daten für Vertrieb und Marktforschung gestartet bin, dachte ich, die erste Seite der Google-Ergebnisse reicht locker aus. Im Nachhinein ist das so, als würde man beim koreanischen All-you-can-eat-Buffet nach dem ersten Gang schon aufgeben. Die richtig spannenden Infos – egal ob neue Leads, Produktlisten oder tiefe Wettbewerbsanalysen – verstecken sich fast immer hinter Seite eins. Wer die Google-Paginierung ignoriert, lässt locker 70 % (oder sogar mehr) der wirklich wichtigen Daten liegen, die für den Erfolg deines nächsten Projekts entscheidend sein können ().

Nach Jahren in der Entwicklung von Automatisierungstools bei weiß ich: Paginierung ist wie ein unsichtbarer Türsteher zwischen dir und wirklich vollständigen, brauchbaren Daten. Egal ob du Google-Suchergebnisse, Produktlisten oder Bewertungen scrapen willst – ohne Paginierung bekommst du nur einen Bruchteil der Infos, statt das volle Daten-Buffet.

Was ist Google-Paginierung und warum ist sie beim Web Scraping so wichtig?

Kurz gesagt: Google-Paginierung heißt, dass Google – wie viele andere Seiten – die Inhalte auf mehrere Seiten aufteilt. Bei einer normalen Google-Suche bekommst du 10 Ergebnisse pro Seite, unten gibt’s Seitenzahlen und einen „Weiter“-Button. Mit jedem Klick auf „Weiter“ kommen neue Ergebnisse – und das geht so weiter. Dieses Prinzip findest du überall: bei Amazon-Produktlisten, Yelp-Bewertungen, Immobilienportalen wie Zillow und vielen anderen ().

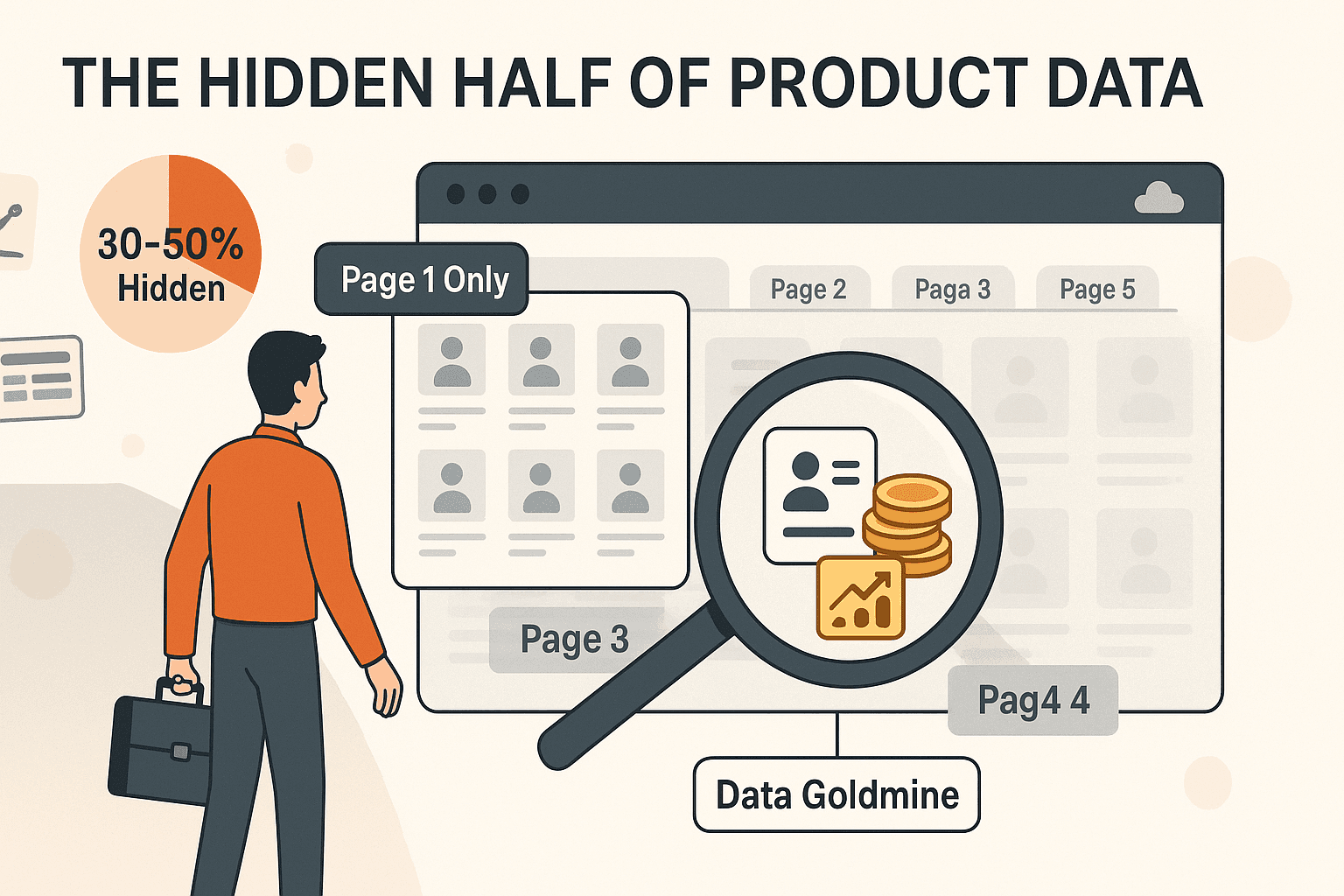

Warum ist das fürs Scraping so wichtig? Wer nur die erste Seite abruft, lässt den Großteil der Daten einfach liegen. Studien zeigen, dass 30–50 % der Produktinfos auf den Folgeseiten versteckt sind (), manchmal sogar noch mehr. Stell dir vor, du sammelst als Vertriebler nur die ersten 20 Kontakte aus einem Verzeichnis – die richtig interessanten Leads warten aber auf Seite 3, 4 oder 5. Unvollständige Daten bedeuten verpasste Chancen, fehlerhafte Analysen und, ganz ehrlich, verschwendete Zeit.

Im Business sind unvollständige Daten so nützlich wie eine leere Pizzaschachtel (). Deshalb ist der richtige Umgang mit Google-Paginierung Pflicht für alle, die ernsthaft scrapen wollen.

Im Business sind unvollständige Daten so nützlich wie eine leere Pizzaschachtel (). Deshalb ist der richtige Umgang mit Google-Paginierung Pflicht für alle, die ernsthaft scrapen wollen.

Die Herausforderungen der Google-Paginierung beim Web Scraping

Wäre das Scrapen von paginierten Daten doch nur so einfach wie ein paar Mal auf „Weiter“ zu klicken. In Wirklichkeit gibt’s da einige Stolpersteine:

- Standardmäßig unvollständige Daten: Die meisten einfachen Scraper (und viele Skripte) holen nur die erste Seite, es sei denn, du sagst ihnen explizit, dass sie weitermachen sollen. So gehen schnell 90 % der Daten verloren ().

- Komplizierte Navigation: Google nutzt Seitenzahlen und „Weiter“-Buttons, andere Seiten setzen auf „Mehr laden“-Buttons oder endloses Scrollen. Jede Variante braucht eine andere Scraping-Strategie ().

- Dynamische Inhalte: Manche Ergebnisse werden erst durch JavaScript beim Scrollen oder Klicken geladen – klassische HTML-Scraper übersehen die komplett.

- Fehlerquellen und Sonderfälle: Wer den „Weiter“-Button nicht erkennt, zu früh stoppt oder versehentlich dieselbe Seite doppelt abruft, macht schnell Fehler. Und zu aggressives Scrapen führt oft zu Blockaden durch Anti-Bot-Systeme ().

Fazit: Wer paginierte Inhalte scrapen will, muss echtes Nutzerverhalten nachahmen – über mehrere Seiten, mit verschiedenen Ladearten und ohne geblockt zu werden.

Manuelle Paginierung: Klassische Methoden

Bevor es KI-Tools wie Thunderbit gab, war die Handhabung der Google-Paginierung eine Mischung aus Techniktricks und Fleißarbeit. So lief das früher:

| Manuelle Methode | Nachteile |

|---|---|

| Jede Seite per Hand kopieren | Eintönig, fehleranfällig und bei vielen Seiten nicht praktikabel |

| URL-Parameter anpassen | Erfordert technisches Know-how; nicht jede Seite zeigt die Seitennummer in der URL |

| Eigene Skripte schreiben | Programmierkenntnisse nötig; Skripte brechen bei Website-Änderungen |

| Browser-Automatisierung (Selenium) | Aufwendig einzurichten, langsam und wartungsintensiv |

| No-Code-Tools mit manueller Einrichtung | „Weiter“-Button oder Seitenelemente müssen oft selbst ausgewählt werden; wenig intuitiv |

Selbst sogenannte „No-Code“-Scraper verlangen oft, dass du Einstellungen anpasst oder den „Weiter“-Button manuell auswählst (). Für Business-Anwender ist das frustrierend – oder führt zu lückenhaften Daten.

Automatisierte Paginierung: Thunderbits Lösung

Hier setzt neue Maßstäbe. Thunderbit ist eine KI-gestützte Chrome-Erweiterung, die das Handling von Google-Paginierung (und jeder anderen Paginierung) super easy macht. So läuft’s ab:

- Automatische Erkennung: Thunderbits KI erkennt Paginierungs-Elemente – egal ob Seitenzahlen, „Weiter“-Buttons, „Mehr laden“ oder endloses Scrollen ().

- Vollautomatische Navigation: Nach der Erkennung navigiert Thunderbit wie ein echter User durch die Seiten – klickt auf „Weiter“, scrollt oder lädt weitere Ergebnisse, bis alles eingesammelt ist ().

- Browser- und Cloud-Modus: Thunderbit läuft im Browser (perfekt für dynamische Inhalte) oder in der Cloud (bis zu 50 Seiten gleichzeitig für maximale Geschwindigkeit und Skalierung).

- No-Code, KI-gestützte Einrichtung: Einfach auf „KI-Felder vorschlagen“ klicken – Thunderbit erkennt sowohl die Datenfelder als auch die Paginierungslogik automatisch.

- Alle Paginierungsarten: Egal ob Klicken, Scrollen oder eine Mischung – Thunderbit passt sich flexibel an.

- Subpage-Scraping: Du brauchst mehr Details? Thunderbit kann auch jede Unterseite besuchen und deine Daten anreichern – ohne extra Aufwand ().

Kurz gesagt: Thunderbits KI macht Paginierung zum Selbstläufer – du musst dich um nichts mehr kümmern.

Schritt-für-Schritt-Anleitung: Google-Paginierung mit Thunderbit scrapen

So scrapest du alle Seiten der Google-Suchergebnisse mit Thunderbit – ganz ohne Programmieren oder Stress.

Schritt 1: Thunderbit Web-Scraper einrichten

- Installiere die aus dem Chrome Web Store.

- Erstelle ein kostenloses Thunderbit-Konto und pinne die Erweiterung für schnellen Zugriff an.

- Öffne Google und starte deine Suche (z. B. „beste CRM-Tools 2025“).

Schritt 2: Paginierungsunterstützung aktivieren

- Klicke auf das Thunderbit-Icon, um die Seitenleiste zu öffnen.

- Wähle „KI-Felder vorschlagen“ – Thunderbits KI analysiert die Seite und schlägt Felder wie Titel, URL und Snippet vor.

- Thunderbit erkennt die Paginierung automatisch. Falls ein „Paginieren“-Schalter angezeigt wird, stelle sicher, dass er aktiviert ist (bei mehrseitigen Ergebnissen ist das meist Standard).

- Bei endlosem Scrollen oder „Mehr laden“-Seiten schaltet Thunderbit automatisch in den Scroll-Modus.

Schritt 3: Daten prüfen und exportieren

- Klicke auf „Scrapen“ und lass Thunderbit die Arbeit machen. Die Erweiterung navigiert durch alle Seiten und sammelt die Ergebnisse.

- Sieh zu, wie die Datentabelle mit Ergebnissen von Seite 1, 2, 3 usw. gefüllt wird.

- Prüfe nach Abschluss, ob alle Seiten erfasst wurden.

- Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON (). Der Export ist immer kostenlos.

Das war’s – keine Skripte, kein manuelles Klicken, keine fehlenden Daten.

Manuelle vs. automatisierte Paginierung: Was passt zu deinem Unternehmen?

Hier ein schneller Vergleich:

| Aspekt | Manuelles Scraping | Thunderbit Automatisiertes Scraping |

|---|---|---|

| Einrichtungsaufwand | Hoch – manuelle Einrichtung oder Programmierung | Minimal – KI konfiguriert alles automatisch |

| Endloses Scrollen | Schwierig – erfordert eigene Skripte | Integriert – Thunderbit übernimmt das automatisch |

| Anpassungsfähigkeit | Gering – bricht bei Website-Änderungen | Hoch – KI passt sich neuen Mustern an |

| Geschwindigkeit & Skalierung | Langsam – Seiten werden nacheinander geladen | Schnell – Cloud-Modus scrapt bis zu 50 Seiten gleichzeitig |

| Wartungsaufwand | Hoch – Skripte müssen ständig aktualisiert werden | Gering – Thunderbits KI wird für dich gepflegt |

| Anti-Block-Maßnahmen | Manuell – Proxys, Verzögerungen nötig | Integriert – Thunderbit nutzt smarte Taktung und Cloud-IPs |

| Zugänglichkeit | Technisch – Programmierkenntnisse oder IT-Support | No-Code – auch für Nicht-Techniker sofort nutzbar |

Wenn du nur ein paar Ergebnisse brauchst, kannst du das manuell machen. Für ernsthafte Projekte wie Lead-Generierung, Preisüberwachung oder Marktforschung ist Thunderbits Automatisierung aber unschlagbar.

Best Practices für Google-Paginierung beim Web Scraping

Egal ob mit Thunderbit oder einem anderen Tool – diese Tipps helfen dir weiter:

- Paginierungsmuster erkennen: Gibt es Seitenzahlen, „Weiter“-Buttons oder endloses Scrollen? Thunderbit erkennt alles, aber es schadet nicht, das Muster zu kennen ().

- Alle Seiten erfassen: Prüfe, ob dein Datensatz die erwartete Anzahl an Ergebnissen enthält. Wenn Google „ca. 100 Ergebnisse“ anzeigt, solltest du nicht bei 10 oder 20 stehenbleiben.

- Dubletten vermeiden: Manche Seiten zeigen auf mehreren Seiten dieselben Ergebnisse. Nutze eindeutige Schlüssel (z. B. URLs), um doppelte Einträge zu entfernen.

- Anfragen drosseln: Scrape nicht zu schnell – vor allem bei Google. Thunderbits Cloud-Modus nutzt intelligente Taktung, aber bleib immer fair.

- Fehler einplanen: Manchmal lädt eine Seite nicht. Thunderbit versucht es automatisch erneut, aber prüfe deine Daten immer auf Vollständigkeit.

- Website nicht überlasten: Scrape nur, was du wirklich brauchst. Wenn du nur die ersten 5 Seiten brauchst, setze ein Limit.

- Zeitplanung nutzen: Für wiederkehrende Scrapes nutze Thunderbits natürliche Sprachplanung („jeden Montag um 9 Uhr“), um den Prozess zu automatisieren ().

- Organisation bewahren: Notiere dir, was, wann und wo du gescrapt hast. Websites ändern sich – bleib flexibel.

Bessere Nutzererfahrung: Thunderbits One-Click-Paginierung

Was ich an Thunderbit besonders mag: Jeder kann fortschrittliche Paginierung nutzen – nicht nur Entwickler:

- Kein Code, keine Selektoren: Einfach „KI-Felder vorschlagen“ klicken und loslegen. Thunderbit macht den Rest ().

- Natürliche Sprache: Beschreibe einfach, was du brauchst („alle Google-Ergebnisse mit Titel und URL scrapen“), Thunderbit richtet alles ein.

- Sofortige Vorlagen: Für beliebte Seiten wie Google, Amazon oder Zillow gibt’s Ein-Klick-Vorlagen mit integrierter Paginierungslogik.

- Nahtloser Export: Sende deine Daten direkt an Sheets, Notion oder Airtable – ohne Umwege.

- Weltweit nutzbar: Thunderbit unterstützt 34 Sprachen, sodass Teams weltweit damit arbeiten können.

Das Feedback der Nutzer ist durchweg positiv – viele sagen, es fühlt sich an, als hätte man einen Assistenten, der nie müde wird, auf „Weiter“ zu klicken. Und als jemand, der früher viel manuell gescrapt hat, kann ich bestätigen: Es ist eine echte Erleichterung.

Fazit & wichtigste Erkenntnisse

Der richtige Umgang mit Google-Paginierung ist kein technisches Detail – er ist der Schlüssel zu vollständigem, zuverlässigem Web Scraping. Wer sie ignoriert, arbeitet mit halben Infos. Wer sie meistert, holt das Maximum aus Webdaten raus.

Mit musst du weder programmieren noch Scraping-Profi sein. Einfach die Erweiterung installieren, „KI-Felder vorschlagen“ nutzen und Thunderbit übernimmt die Paginierung – klickt, scrollt und exportiert alle Ergebnisse. Schnell, präzise und für jeden zugänglich.

Neugierig, was dir bisher entgangen ist? und eine mehrseitige Google-Suche scrapen. Du wirst „Seite 2“ nie wieder unterschätzen.

FAQs

1. Was bedeutet Google-Paginierung beim Web Scraping?

Google-Paginierung beschreibt, wie Google Suchergebnisse auf mehrere Seiten verteilt – meist mit Seitenzahlen und einem „Weiter“-Button. Beim Scraping heißt das: Daten von allen Seiten erfassen, nicht nur von der ersten.

2. Warum ist die Handhabung der Paginierung für die Datenerfassung wichtig?

Die meisten wertvollen Daten liegen hinter der ersten Seite – manchmal bis zu 70 % oder mehr. Wer Paginierung ignoriert, erhält unvollständige Datensätze und verpasst wichtige Erkenntnisse.

3. Wie übernimmt Thunderbit die Google-Paginierung automatisch?

Thunderbits KI erkennt Paginierungs-Elemente (Seitenzahlen, „Weiter“-Buttons, endloses Scrollen) und navigiert durch alle Seiten, um die Daten zu sammeln. Kein manuelles Setup oder Programmieren nötig.

4. Welche Paginierungsarten kann Thunderbit verarbeiten?

Thunderbit unterstützt klickbasierte Paginierung (Seitenzahlen, „Weiter“-Links), endloses Scrollen und „Mehr laden“-Buttons. Die KI passt sich automatisch an die jeweilige Website an.

5. Was sind Best Practices beim Scrapen von paginierten Inhalten?

Stelle sicher, dass du alle Seiten erfasst, vermeide Dubletten, drossle deine Anfragen, um Blockaden zu vermeiden, und nutze ein Tool wie Thunderbit, das verschiedene Paginierungsarten erkennt. Für wiederkehrende Aufgaben empfiehlt sich die Nutzung von Zeitplänen.

Weitere Tipps und ausführliche Anleitungen findest du im . Viel Erfolg beim Scrapen – und mögen deine Datensätze immer vollständig sein, Seite für Seite. Mehr erfahren