Hand aufs Herz: 2025 fühlt sich das Internet an wie eine riesige, endlos wachsende Excel-Tabelle – nur leider fehlt der praktische „Exportieren“-Button. (Wäre das nicht genial?) Als jemand, der seit Jahren SaaS- und Automatisierungslösungen baut, weiß ich, wie sehr Teams aus Vertrieb, Marketing und Operations auf frische Webdaten angewiesen sind – egal ob für Lead-Listen, Preisvergleiche oder Immobilien-Trends. Der Bedarf an Web Scraping war noch nie so groß, aber die Tools und Methoden entwickeln sich rasant weiter.

Java war lange das Go-to für anspruchsvolles, großflächiges Web Scraping. Aber mal ehrlich: Wer nicht gerade Entwickler ist und Java im Schlaf beherrscht, fühlt sich beim Einrichten eines Java-Scrapers schnell wie beim IKEA-Möbelaufbau ohne Anleitung – und am Ende bleiben ein paar Schrauben übrig. Genau deshalb feiere ich die neuen KI-Web-Scraper wie , die wir entwickelt haben, um Datenerfassung so einfach wie zwei Klicks zu machen – komplett ohne Programmier- oder HTML-Kenntnisse. In diesem Guide zeige ich dir beide Welten: Warum Java immer noch relevant ist, wie ein Scraper aufgebaut wird und wie KI-Tools Web Scraping für alle zugänglich machen.

Warum Web Scraping mit Java auch 2025 noch eine Rolle spielt

Trotz des Booms von No-Code- und KI-Tools bleibt Java das Rückgrat vieler großer Web-Scraping-Projekte. Das hat gute Gründe: Java steht für Stabilität, Performance und die Detailkontrolle, die bei unternehmensweiten Datenprojekten entscheidend ist.

Wo Java glänzt

- Leadgenerierung & Vertrieb: Mit Java’s Multithreading kannst du Millionen von Profilen – zum Beispiel aus Verzeichnissen oder LinkedIn – über Nacht extrahieren. So füllst du deinen Vertriebstrichter im Schlaf, ganz ohne Koffein.

- Wettbewerber-Preisüberwachung: E-Commerce-Teams nutzen Java-Scraper, um tausende Produkte auf Konkurrenzseiten zu beobachten und Preise in Echtzeit anzupassen. Target konnte so zum Beispiel einen ) erzielen.

- Immobiliendaten sammeln: Makler und Investoren aggregieren mit Java Angebote, Preishistorien und demografische Daten aus verschiedenen Quellen, um Investmentchancen schneller zu erkennen ().

- Finanzmarktforschung: Investmentfirmen verlassen sich auf Java für das 24/7-Scraping von Aktienkursen, Nachrichten und Stimmungsanalysen – denn im Finanzbereich zählt jede Sekunde.

Der Kompromiss: Flexibilität vs. Zugänglichkeit

Mit Java hast du die volle Kontrolle: Du kannst jeden Aspekt deines Scrapers anpassen, Sonderfälle abdecken und direkt ins Backend integrieren. Aber: Dafür braucht es echtes Entwickler-Know-how. Für Nicht-Programmierer ist die Einstiegshürde hoch und der Wartungsaufwand nicht zu unterschätzen. Deshalb setzen immer mehr Business-Anwender für alltägliche Scraping-Aufgaben auf KI-basierte No-Code-Lösungen ().

Die Basics: Was bedeutet Web Scraping mit Java?

Kurz gesagt – ohne Fachchinesisch:

Web Scraping mit Java heißt, ein Programm zu schreiben, das wie ein Roboter-Browser Webseiten besucht, Inhalte liest und gezielt Daten herauszieht. Stell dir vor, du schickst einen digitalen Praktikanten los, der für dich kopiert und einfügt – nur viel schneller (und ohne Kaffeepausen).

So läuft’s ab:

- Anfrage senden: Dein Java-Programm ruft den HTML-Code einer Webseite ab – wie ein Browser.

- HTML parsen: Das Programm analysiert den Seitenaufbau (alle

<div>,<span>,<table>-Tags). - Daten extrahieren: Du gibst an, was gesucht werden soll (z.B. „alle Preise in

<span class='price'>“). - Exportieren: Die Daten werden als CSV, Excel-Datei oder in eine Datenbank gespeichert.

Bei statischen Seiten ist das recht easy. Bei dynamischen Seiten (wo Inhalte per JavaScript nachgeladen werden) brauchst du zusätzliche Tools, die einen echten Browser simulieren. Mehr dazu gleich.

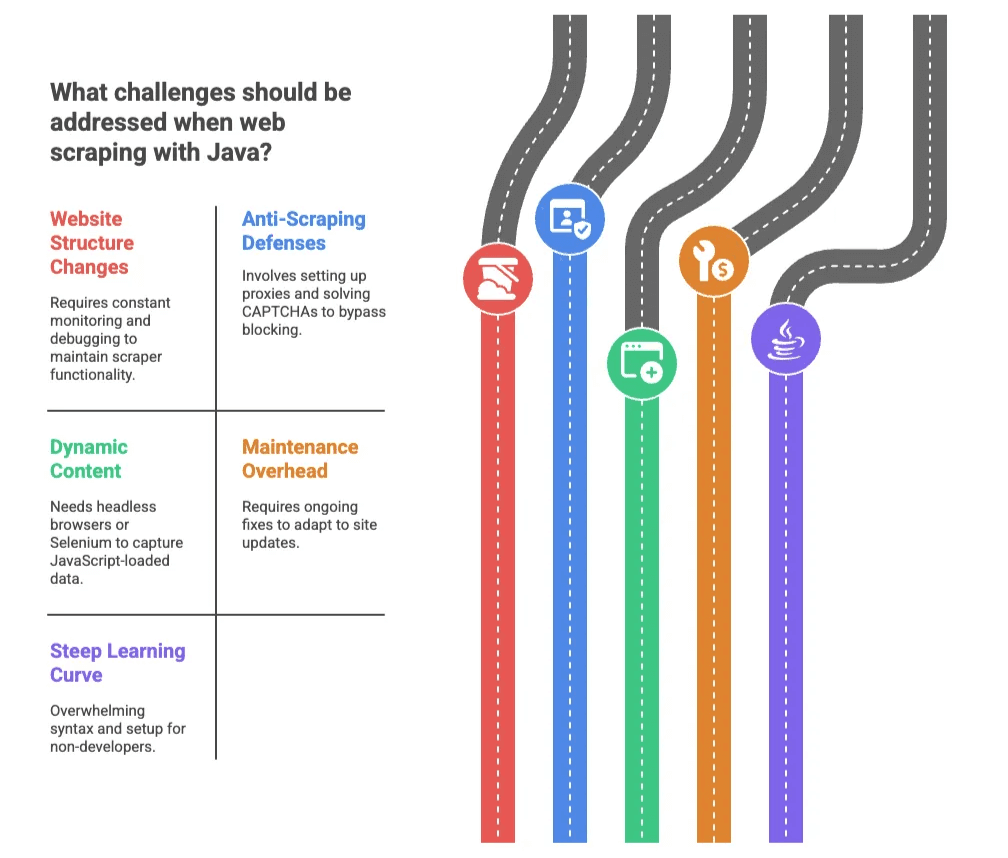

Die größten Herausforderungen beim Web Scraping mit Java

Java ist mächtig, aber nicht immer ein Spaziergang – es sei denn, du stehst auf CAPTCHAs, IP-Sperren und ständig wechselndes HTML. Die größten Stolpersteine:

1. Änderungen am Webseitenaufbau

Webseiten werden gerne dann umgebaut, wenn dein Scraper endlich läuft. Schon eine kleine Änderung – etwa ein neuer CSS-Klassenname – kann deinen Code lahmlegen. Plötzlich sammelt dein Scraper nur noch Luft, und du sitzt nachts am Debuggen ().

2. Anti-Scraping-Maßnahmen

Viele Seiten setzen auf CAPTCHAs, IP-Blockaden und Zugriffsbeschränkungen. Laut einer aktuellen Umfrage nannten Blockierungen als ihr größtes Scraping-Problem. In Java bedeutet das: Proxies einrichten, CAPTCHAs lösen und sich wie im digitalen „Whack-a-Mole“-Spiel fühlen.

3. Dynamische Inhalte

Moderne Webseiten laden viele Daten erst nachträglich per JavaScript. Einfache Java-Scraper sehen diese Inhalte nicht. Hier brauchst du Headless-Browser oder Tools wie Selenium – das macht alles komplexer und langsamer.

4. Wartungsaufwand

Auch nach dem Aufbau deines Scrapers bist du ständig gefragt: Jede Webseitenänderung kann zu Fehlern führen, die du (oder dein Entwicklerteam) beheben musst.

5. Hohe Einstiegshürde

Für Nicht-Entwickler ist Java mit seiner Syntax und Einrichtung oft abschreckend. Schon kleine Fehler führen zu kryptischen Fehlermeldungen. Es ist, als würde man Autofahren lernen – nur steht das Auto in Flammen und die Straße besteht aus HTML.

Klassisches Java-Web-Scraping: Was steckt dahinter?

Wer trotzdem selbst Hand anlegen will, findet hier den typischen Ablauf:

| Schritt | Java-Programmierung | KI/No-Code-Tool |

|---|---|---|

| Umgebung einrichten | JDK, IDE, Bibliotheken installieren (für Einsteiger zeitaufwändig) | Browser-Erweiterung installieren oder registrieren (Minuten) |

| Datenfelder bestimmen | HTML inspizieren, Selektoren schreiben (HTML/CSS-Kenntnisse nötig) | KI erkennt Felder automatisch oder per Klick auswählen |

| Dynamische Inhalte | Selenium oder HtmlUnit einbinden (aufwendig, langsam) | Tool übernimmt das automatisch |

| Debugging & Fehlerbehebung | Fehler lesen, Code anpassen, wiederholt testen | Tool löst die meisten Probleme, Nutzer passt Felder ggf. an |

| Datenexport | Code für CSV/DB schreiben, manuelle Integration | Ein Klick zu Excel, Google Sheets, Airtable, Notion |

| Wartung | Änderungen überwachen, Code anpassen (laufender Aufwand) | KI passt sich an, minimaler Aufwand |

Beliebte Java-Web-Scraping-Bibliotheken

- Jsoup: Ideal für statisches HTML. Einfach zu nutzen, aber nicht für JavaScript-Inhalte geeignet ().

- HtmlUnit: Simuliert einen Browser, kann JavaScript ausführen. Langsamer und manchmal überfordert mit modernen Webseiten.

- Selenium: Steuert echte Browser (Chrome, Firefox), perfekt für dynamische Seiten. Sehr leistungsfähig, aber komplex für Nicht-Programmierer.

Fazit: Für Entwickler sind diese Bibliotheken top, für Business-Anwender fühlt es sich aber oft an, als müsste man eine Rakete bauen, nur um eine Pizza zu holen.

KI-Web-Scraper: Web Scraping für alle zugänglich machen

Jetzt wird’s spannend: KI-basierte Web-Scraper wie machen Web Scraping für jeden möglich – komplett ohne Programmierkenntnisse.

So funktioniert Thunderbit

- KI-Felderkennung: Ein Klick, und die KI liest die Seite aus, schlägt Spalten und Datentypen vor. Kein HTML-Inspektor nötig.

- 2-Klick-Workflow: Einfach „KI-Felderkennung“ und „Scrapen“ – den Rest übernimmt die KI.

- Unterseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch Unterseiten (z.B. Produkt- oder Profilseiten) und ergänzt die Tabelle.

- Export überallhin: Mit einem Klick direkt nach Excel, Google Sheets, Airtable oder Notion.

- Cloud- oder Browser-Scraping: Wähle Cloud für Geschwindigkeit (bis zu 50 Seiten gleichzeitig) oder Browser für Seiten mit Login.

Und ja, es ist wirklich so einfach. Ich habe erlebt, wie Nutzer ohne Technikkenntnisse in weniger als 10 Minuten 500 Wettbewerber-Produkte extrahiert haben – ohne zu wissen, was ein Selektor ist.

Thunderbit vs. klassisches Java-Scraping: Der Direktvergleich

| Funktion | Klassisches Java | Thunderbit KI-Web-Scraper |

|---|---|---|

| Einrichtung | Stunden bis Tage | Minuten (Chrome-Erweiterung) |

| Erforderliche Kenntnisse | Java, HTML, CSS, Debugging | Keine (nur Web-Bedienung) |

| Wartung | Manuell, laufend | KI passt sich automatisch an |

| Datenexport | Manuelles Coding | 1-Klick zu Excel, Sheets, Airtable, Notion |

| Dynamische Inhalte | Komplex (Selenium/HtmlUnit) | Automatisch gelöst |

| Unterseiten-Scraping | Eigene Crawler-Logik nötig | Integriert, per Klick |

| Skalierbarkeit | Multithreading, Proxies programmieren | Cloud-Scraping, parallelisiert |

| Kosten | Entwicklerzeit, Infrastruktur | Günstige Tarife, Gratis-Version verfügbar |

Für die meisten Business-Anwender ist Thunderbit eine echte Erleichterung – wie der Umstieg vom Schaltwagen auf ein selbstfahrendes Auto.

Schritt-für-Schritt: So startest du mit Java-Web-Scraping

Du willst es trotzdem mit Java probieren? Hier ein grober, verständlicher Fahrplan:

-

Umgebung einrichten: Installiere das Java Development Kit (JDK) und eine IDE wie IntelliJ oder Eclipse. Füge eine Bibliothek wie Jsoup für das HTML-Parsing hinzu ().

-

Zielseite wählen: Öffne die Webseite im Browser, inspiziere das HTML und finde die gewünschten Elemente (z.B. Produktnamen, Preise).

-

Code schreiben: Mit Jsoup die Seite abrufen und die Daten selektieren. Beispiel:

1Document doc = Jsoup.connect("http://example.com/page").get(); 2Elements prices = doc.select("span.price"); 3for (Element price : prices) { 4 System.out.println(price.text()); 5} -

Paginierung umsetzen: Über mehrere Seiten iterieren, indem du die URL änderst oder „Weiter“-Links folgst.

-

Daten exportieren: Ergebnisse als CSV speichern, um sie in Excel oder Google Sheets zu öffnen.

-

Testen & optimieren: Scraper ausführen, Fehler beheben und Selektoren anpassen.

Tipps für die Wartung deines Java-Web-Scrapers

- Ergebnisse prüfen: Kontrolliere regelmäßig, ob Daten fehlen oder leer sind.

- Selektoren zentralisieren: Halte alle HTML-Selektoren an einer Stelle für schnelle Updates.

- Blockaden umgehen: Setze Proxies ein und wechsle User-Agents, falls du geblockt wirst.

- Dokumentation: Kommentiere deinen Code und notiere, was welcher Teil macht.

- Rechtliches beachten: Prüfe immer die Nutzungsbedingungen und robots.txt der Zielseite.

Klingt nach viel Aufwand? Ist es auch. Deshalb setzen immer mehr Teams auf KI-Tools.

Wann solltest du KI-Web-Scraper wie Thunderbit nutzen?

Welcher Weg ist der richtige? Nach vielen Jahren Erfahrung mein Fazit:

Java ist sinnvoll, wenn:

- Du sehr individuelle Logik, tiefe Integration oder riesige Datenmengen brauchst.

- Dein Unternehmen hohe Sicherheits- oder Compliance-Anforderungen hat.

- Entwicklerressourcen und Zeit für Wartung vorhanden sind.

Thunderbit (oder ein anderer KI-Web-Scraper) ist ideal, wenn:

- Du nicht programmierst (oder es nicht willst).

- Du schnell und unkompliziert an Daten kommen möchtest.

- Die Webseitenstruktur sich oft ändert oder du viele verschiedene Seiten scrapen willst.

- Du direkt nach Excel, Google Sheets, Airtable oder Notion exportieren möchtest.

- Du Wert auf deine Nerven legst.

Thunderbit eignet sich besonders für Vertriebs-, E-Commerce- und Immobilienteams, die wiederkehrende Datenerfassung automatisieren wollen, ohne auf die IT zu warten. Auch für Ad-hoc-Projekte, schnelle Lead-Generierung oder Wettbewerbsbeobachtung ist es perfekt – überall dort, wo Tempo und Einfachheit zählen.

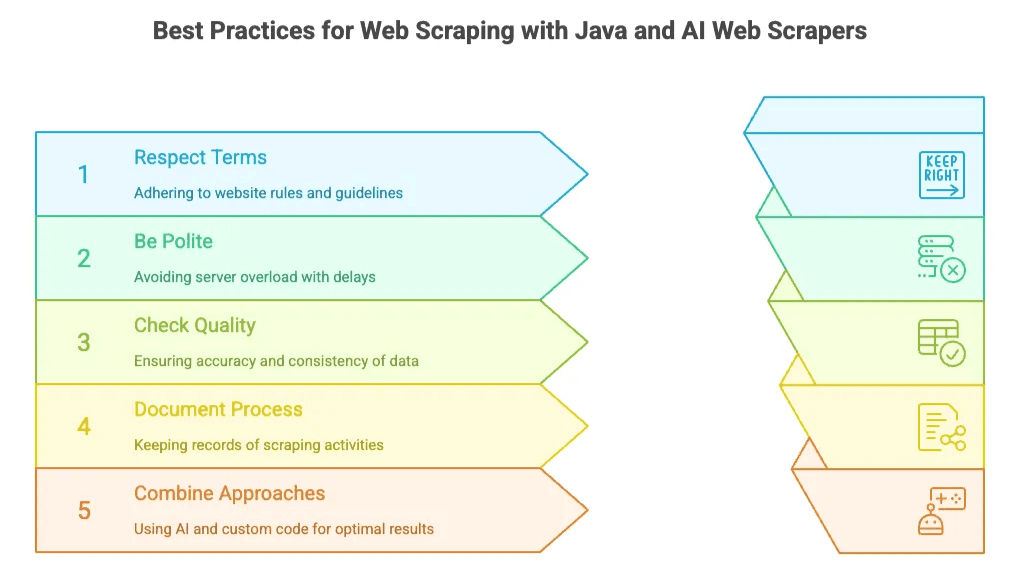

Best Practices für Web Scraping mit Java und KI-Web-Scrapern

Egal, welchen Weg du wählst – ein paar goldene Regeln gelten immer:

- Nutzungsbedingungen beachten: Prüfe immer robots.txt und die AGB. Keine privaten oder sensiblen Daten scrapen.

- Rücksichtsvoll scrapen: Server nicht überlasten – bei eigenem Code Pausen einbauen, bei KI-Tools die integrierte Drosselung nutzen.

- Datenqualität prüfen: Ergebnisse auf Vollständigkeit und Korrektheit kontrollieren. Thunderbits „Field AI Prompt“ hilft, Daten direkt zu bereinigen und zu strukturieren.

- Prozesse dokumentieren: Halte fest, was du wo und wie oft scrapest.

- Kombinieren erlaubt: Oft ist es am besten, mit einem KI-Tool schnell zu starten und für komplexe Anforderungen später auf eigenen Code umzusteigen.

Fazit: Die Zukunft des Web Scraping für Unternehmen

Web Scraping 2025 bedeutet vor allem: Wahlfreiheit. Java bleibt die erste Wahl für hochindividuelle, groß angelegte Projekte. Doch für die meisten Business-Anwender – Vertrieb, Marketing, Operations – sorgen KI-Web-Scraper wie dafür, dass man kein Entwickler mehr sein muss, um Webdaten zu nutzen.

Der Markt boomt: Die weltweite Web-Scraping-Software-Branche wird bis 2030 auf geschätzt, und werden bis 2028 automatisierte Analysetools nutzen. Die Botschaft ist klar: Datengetriebene Entscheidungen sind gekommen, um zu bleiben – und die Tools werden immer besser.

Unentschlossen? Probiere die einfach aus. Der Einstieg ist kostenlos – und du wirst überrascht sein, wie viel du mit wenigen Klicks erreichen kannst. (Und für Java-Fans: Keine Sorge, eure Skills bleiben gefragt – vor allem bei den richtig großen Scraping-Herausforderungen.)

Neugierig auf mehr? Im findest du ausführliche Anleitungen, Best Practices und Deep Dives – zum Beispiel oder .

Viel Erfolg beim Scrapen – und möge deine Datenquelle immer aktuell, vollständig und nur einen Klick entfernt sein. Wäre doch schön, wenn alles im Leben so einfach wäre, oder?

FAQs

1. Warum sollte man 2025 überhaupt noch Java fürs Web Scraping nutzen?

Java bleibt für groß angelegte, unternehmenskritische Scraping-Projekte erste Wahl – dank Geschwindigkeit, Zuverlässigkeit und Flexibilität. Besonders bei Finanzdaten, Preisüberwachung oder riesigen Lead-Datenbanken ist Java unschlagbar, wenn es auf Detailkontrolle oder Backend-Integration ankommt.

2. Was sind die Nachteile von Java beim Web Scraping?

Trotz aller Stärken bringt Java einige Herausforderungen mit: steile Lernkurve, hoher Wartungsaufwand, häufige Ausfälle durch HTML-Änderungen, Schwierigkeiten mit JavaScript-lastigen Seiten und komplexe Einrichtung von Proxies, CAPTCHAs und Paginierung.

3. Wie erleichtern KI-Tools wie Thunderbit das Scraping?

Thunderbit automatisiert den gesamten Scraping-Prozess: Die KI erkennt Felder, verarbeitet dynamische Inhalte, navigiert Unterseiten und exportiert Daten direkt nach Excel oder Notion. Kein Coding, kein HTML, keine Einrichtung – ideal für Nicht-Techniker.

4. Wann sollte ich Thunderbit statt Java fürs Scraping nutzen?

Thunderbit ist perfekt für Business-Anwender, die schnell und unkompliziert an Daten kommen wollen – etwa für Lead-Generierung, E-Commerce-Überwachung oder spontane Recherchen, bei denen Tempo und Einfachheit wichtiger sind als maximale Individualisierung.

5. Kann ich Java und KI-Scraper kombinieren?

Absolut. Viele Teams starten mit KI-Tools wie Thunderbit für schnelle Ergebnisse und wechseln bei komplexeren oder großflächigen Aufgaben zu Java. So kombinierst du Benutzerfreundlichkeit mit der Power von individuellem Code.

Mehr erfahren: