Ich erinnere mich noch genau an meinen allerersten Versuch, mit JavaScript potenzielle Kunden von einer Website zu sammeln. Damals dachte ich noch ganz optimistisch: „JavaScript kann ich doch – wie schwer kann das schon sein?“ Ein paar Stunden später saß ich dann ziemlich ratlos vor einem Haufen kaputter Selektoren, plötzlich verschwindenden Inhalten und ziemlich cleveren Anti-Bot-Sperren. Heute weiß ich: Damit bin ich nicht allein – sagen mittlerweile, dass Daten für ihr Business immer wichtiger werden. Und genau hier spielt Web Scraping eine zentrale Rolle. Je komplexer die Webseiten werden, desto mehr wird web scraping mit JavaScript zur echten Superkraft – aber auch zur echten Herausforderung.

In diesem Guide teile ich meine Erfahrungen rund ums web scraping mit JavaScript – von den Basics bis zu den kniffligen Details. Außerdem zeige ich dir, wie moderne KI-Tools wie dir jede Menge Ärger mit Selektoren abnehmen können. Egal, ob du Produktlisten für deinen Shop sammelst oder Leads für den Vertrieb brauchst – lass uns gemeinsam in die Praxis von web scraping mit JavaScript (und ein bisschen KI-Magie) eintauchen.

Web Scraping mit JavaScript: Basics und Stolpersteine

Starten wir mit dem Grundwissen: web scraping mit JavaScript heißt, dass du automatisiert Daten von Webseiten abgreifst – entweder direkt im Browser oder mit Node.js im Backend. Weil JavaScript die Sprache des Webs ist, liegt es nahe, sie auch fürs Scraping zu nutzen – vor allem dank der vielen Libraries wie Cheerio (für statisches HTML) und Puppeteer oder Playwright (für die Steuerung von Headless-Browsern).

Warum ist JavaScript beim Scraping so beliebt?

- Direkter Zugriff auf den DOM: Im Browser kannst du die Seite wie ein echter User untersuchen und manipulieren.

- Riesiges Ökosystem: Mit Node.js hast du starke Libraries für HTTP-Requests, Parsing und Automatisierung am Start.

- Flexibilität: Du kannst Logins, Klicks, Scrollen und vieles mehr automatisieren – alles, was auch im Chrome-Browser geht.

Aber: Moderne Webseiten sind ein bewegliches Ziel. Sie laden Inhalte dynamisch nach, ändern ständig ihre DOM-Struktur und setzen Anti-Bot-Technologien ein. Das heißt, dein Scraping-Skript kann heute laufen – und morgen schon nicht mehr. Du musst Selektoren ständig anpassen, Pop-ups abfangen und mit asynchron geladenen Daten jonglieren. Es fühlt sich manchmal an wie ein endloses Whack-a-Mole – nur mit mehr geschweiften Klammern.

Warum moderne Webseiten das JavaScript-Scraping erschweren

Früher war Scraping easy: HTML runterladen, gewünschte Daten rausfiltern, fertig. Heute sieht das ganz anders aus. Plattformen wie Facebook Marketplace, Amazon oder Immobilienportale setzen auf JavaScript-Frameworks, die Inhalte dynamisch nachladen, Daten hinter endlosem Scrollen verstecken und Infos tief in verschachtelten DOM-Strukturen ablegen.

Klassisches HTML-Parsing reicht da nicht mehr. Zum Beispiel ist das Extrahieren von Produktbewertungen oder verschachtelten Kommentaren nicht nur eine Frage des richtigen <div>, sondern erfordert ein Verständnis für die Beziehungen und Kontexte der Elemente – manchmal sogar für die Bedeutung der Daten.

Hier kommen smarte Vorverarbeitungen ins Spiel. Statt einfach nur das rohe HTML zu nehmen, brauchst du eine Möglichkeit, die Seite semantisch zu verstehen: Was ist der Produktname, was der Preis, was eine Nutzerbewertung? Das ist mit Standard-JavaScript kaum zu schaffen – aber genau hier glänzen KI-gestützte Tools.

Klassische JavaScript-Web-Scraping-Tools

Kommen wir zu den Werkzeugen. Der klassische JavaScript-Stack fürs Scraping besteht meistens aus einer oder mehreren dieser Lösungen:

- Cheerio: Perfekt für das Parsen von statischem HTML. Funktioniert wie jQuery, aber auf dem Server.

- Puppeteer/Playwright: Headless-Browser-Automatisierung. Diese Tools starten einen echten Browser, führen JavaScript aus und ermöglichen Interaktionen wie ein Mensch (oder ein sehr fleißiger Bot).

Typischer Ablauf:

- Seite anfordern (mit oder ohne Headless-Browser).

- Warten, bis Inhalte geladen sind (z. B. mit

waitForSelector). - DOM parsen und gewünschte Daten extrahieren.

- Ergebnisse strukturieren und weiterverarbeiten.

Klingt easy? Leider gibt’s einen Haken: Ändert die Website ihr Layout, brechen deine Selektoren. Kommt ein neues Pop-up dazu, bleibt dein Skript hängen. Werden Felder umsortiert, geraten deine Daten durcheinander. Die Wartung wird schnell zum Dauerjob.

Vergleich beliebter JavaScript-Scraping-Bibliotheken

| Funktion | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| Am besten geeignet für | Statisches HTML | Dynamische Seiten | Dynamische Seiten |

| Browser-Automatisierung | Nein | Ja | Ja |

| Verarbeitet JS-Inhalte | Nein | Ja | Ja |

| Geschwindigkeit | Schnell | Langsamer | Langsamer |

| API-Komplexität | Einfach | Mittel | Mittel |

| Anti-Bot-Umgehung | Eingeschränkt | Mittel | Mittel |

| Cross-Browser | Nein | Nur Chrome | Chrome, Firefox, WebKit |

| Einsatzgebiete | Einfache Seiten, APIs | Interaktive Seiten | Interaktive Seiten |

Cheerio ist super schnell für statische Seiten oder APIs, die HTML liefern, kann aber kein JavaScript ausführen. Puppeteer und Playwright sind die erste Wahl für dynamische Seiten, brauchen aber mehr Ressourcen und Einrichtung. Beide können Logins, Klicks und Scrollen automatisieren – aber du musst für jede Änderung der Seite eigene Logik schreiben.

Thunderbit: KI-Web-Scraper für JavaScript-Workflows

Jetzt wird’s spannend. Bei Thunderbit haben wir erkannt: Scraping ist mehr als nur HTML abgreifen – es geht darum, Webseiten wie ein Mensch zu verstehen. Deshalb haben wir entwickelt, eine KI-Web-Scraper Chrome-Erweiterung, die semantisches Verständnis ins Web Scraping bringt.

Wie läuft das ab?

- Thunderbit verwandelt die Webseite in eine Markdown-Darstellung – eine übersichtliche, strukturierte Version der Seite.

- Unsere KI analysiert dieses Markdown, erkennt Felder, Beziehungen und Kontexte – und weiß so, was ein Preis, eine Bewertung oder nur ein Deko-Emoji ist.

- Das Ergebnis: Du bekommst strukturierte, beschriftete Daten, die auch bei Layout-Änderungen, dynamischen Inhalten oder verschobenen DOM-Elementen stabil bleiben.

Für Unternehmen heißt das: Weniger manuelle Nachbearbeitung, weniger kaputte Skripte und mehr Zeit für echte Analysen. Entwickler können sich auf die Automatisierung von Logins, Klicks und Navigation konzentrieren – und Thunderbit übernimmt die eigentliche Extraktion.

Schritt-für-Schritt: Web Scraping mit JavaScript (klassisch & mit Thunderbit)

Jetzt wird’s praktisch. Wir nehmen ein Beispiel aus dem echten Leben: Produktlisten von einer Beispiel-E-Commerce-Seite extrahieren. Erst klassisch mit Puppeteer, dann mit Thunderbit als Turbo.

Schritt 1: JavaScript-Scraping-Umgebung aufsetzen

Zuerst brauchst du . Danach installierst du Puppeteer:

1npm install puppeteerFalls du Playwright bevorzugst (unterstützt mehrere Browser):

1npm install playwrightKeine Sorge, du musst kein JavaScript-Profi sein – einfach die Codebeispiele kopieren, ich erkläre jeden Schritt.

Schritt 2: Navigation und Interaktion mit dynamischen Seiten

Moderne Seiten verstecken Daten oft hinter Logins, Pop-ups oder endlosem Scrollen. So automatisierst du das mit Puppeteer:

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // Zur Login-Seite gehen

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'dein_benutzername');

8 await page.type('#password', 'dein_passwort');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // Zur Produktliste navigieren

12 await page.goto('https://example.com/products');

13 // Scrollen, um mehr Produkte zu laden

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // Warten, bis Produkte geladen sind

21 await page.waitForSelector('.product-card');

22 // ... (Datenextraktion folgt im nächsten Schritt)

23})();Dieses Skript loggt sich ein, navigiert zur Produktseite und scrollt, um mehr Einträge zu laden. Wichtig: Immer auf das Laden der Elemente warten – sonst bekommst du leere Ergebnisse.

Schritt 3: Daten mit JavaScript extrahieren

Jetzt holen wir die Daten. Angenommen, jedes Produkt steckt in einem .product-card-Div:

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);Typische Stolperfallen:

- Selektoren sind fragil. Ändert sich

.product-titlezu.title, läuft das Skript ins Leere. - Versteckte Daten. Preise oder Bewertungen werden manchmal erst nachträglich per AJAX geladen.

- Anti-Bot-Maßnahmen. Zu viele Anfragen führen schnell zu Sperren.

Schritt 4: Extraktion mit Thunderbit KI beschleunigen

Hier kommt Thunderbit ins Spiel. Statt dich mit Selektoren und fehleranfälliger Logik herumzuschlagen, kannst du das gerenderte HTML (oder sogar einen Screenshot) an Thunderbit übergeben und die KI erledigt den Rest.

Wie läuft das ab?

- Mit Puppeteer oder Playwright automatisierst du das Browsen, Logins und die Navigation.

- Sobald du auf der gewünschten Seite bist, holst du das HTML:

1const pageContent = await page.content();- Übermittle dieses HTML an Thunderbit (z. B. über die ) zur KI-gestützten Extraktion.

Thunderbit übernimmt dann:

- Umwandlung der Seite in Markdown für einfacheres semantisches Parsing.

- KI-gestützte Erkennung von Feldern, Beziehungen und Kontexten.

- Ausgabe strukturierter Daten, die du direkt nach Excel, Google Sheets, Airtable oder Notion exportieren kannst.

Keine kaputten Selektoren oder aufwändige Datenbereinigung mehr.

Dynamische Inhalte und asynchrones Laden meistern

Dynamische Inhalte sind der Albtraum jedes Scrapers. Viele Seiten laden Daten erst nach dem ersten Rendern – etwa durch endloses Scrollen, „Mehr laden“-Buttons oder AJAX.

Klassische Strategien:

- Mit

waitForSelectorwarten, bis Elemente erscheinen. - Auf „Netzwerk-Leerlauf“ warten, bevor gescraped wird.

- Scrollen oder Klicken automatisieren, um mehr Daten zu laden.

Doch diese Methoden sind anfällig. Ändert die Seite ihr Ladeverhalten, bricht das Skript.

Thunderbits Ansatz: Durch die Umwandlung in Markdown und die KI-Analyse ist Thunderbit weniger abhängig von bestimmten DOM-Strukturen oder IDs. Selbst wenn sich das Layout ändert – solange die Inhalte da sind, findet Thunderbit sie meist zuverlässig. Das bedeutet weniger Wartung und stabilere Daten.

Nachhaltige Datenpipelines: Vom Skript zu Business Insights

Scraping ist kein einmaliger Job – es ist der Startpunkt für eine Datenpipeline. So gehe ich vor:

- Browsing und Extraktion automatisieren mit JavaScript (Puppeteer/Playwright).

- An Thunderbit übergeben für KI-gestützte Strukturierung und Beschriftung.

- Ergebnisse exportieren in dein Lieblingstool: Excel, Google Sheets, Airtable, Notion.

- Wiederkehrende Aufgaben planen mit Thunderbits – einfach Intervall beschreiben („jeden Montag um 9 Uhr“), URLs eingeben und Thunderbit erledigt den Rest.

- Daten in Geschäftsprozesse einbinden – egal ob Vertrieb, Preisüberwachung oder Marktforschung.

Diese Kombi – JavaScript für die Automatisierung, Thunderbit für die KI-Extraktion – ermöglicht wiederholbare, wartungsarme Workflows mit immer aktuellen und zuverlässigen Daten.

Fazit: Die richtige Web-Scraping-Strategie für deinen Bedarf

Was ist nun der beste Weg, um mit JavaScript zu scrapen? Mein Fazit:

- Klassisches JavaScript-Scraping (Cheerio, Puppeteer, Playwright) eignet sich für einfache, statische Seiten oder wenn du volle Kontrolle über die Automatisierung brauchst. Allerdings ist der Wartungsaufwand hoch – Selektoren brechen, Layouts ändern sich, Anti-Bot-Maßnahmen werden immer ausgefeilter.

- KI-gestützte Extraktion mit Thunderbit bringt semantisches Verständnis ins Spiel. Das ist robuster gegenüber Änderungen, spart manuelle Nachbearbeitung und lässt dich dich auf die Analyse statt auf das Debuggen konzentrieren.

Wann was nutzen?

- Für schnelle, einmalige Scrapes einfacher Seiten: Cheerio oder Puppeteer.

- Für komplexe, dynamische Seiten – oder wenn du zukunftssichere Workflows willst: Kombiniere deine JavaScript-Skripte mit Thunderbits KI-Extraktion.

- Für Business-Anwender ohne Programmierkenntnisse: Die Thunderbit Chrome-Erweiterung bringt dich mit zwei Klicks von der Webseite direkt in die Tabelle.

Du willst mehr Beispiele? Schau auf vorbei – dort findest du Anleitungen zum , und vieles mehr.

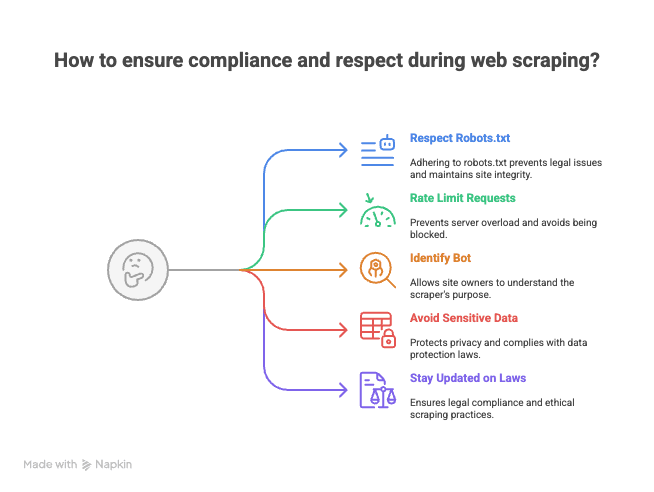

Bonus: Tipps für rechtssicheres und faires Scraping

Bevor du deine Scraping-Skripte losschickst, ein paar Hinweise (aus Erfahrung mit „freundlichen“ Mails von Website-Admins):

- Respektiere robots.txt und Nutzungsbedingungen. Nicht jede Seite möchte gescraped werden.

- Begrenze deine Anfragen. Überlaste keine Server – pausiere zwischen den Requests, um Sperren oder Blacklists zu vermeiden.

- Kennzeichne deinen Bot. Verwende einen eigenen User-Agent, damit Seitenbetreiber wissen, wer du bist.

- Keine sensiblen oder persönlichen Daten scrapen. Bleib bei öffentlichen Informationen und respektiere die Privatsphäre.

- Informiere dich über Gesetze und Best Practices. Web Scraping bewegt sich rechtlich in einer Grauzone.

Denk dran: Mit großer Scraping-Power kommt große Verantwortung (und manchmal eine Abmahnung).

web scraping mit JavaScript ist eine Mischung aus Handwerk und Wissenschaft. Mit den richtigen Tools – und etwas KI-Unterstützung – wird das Web zu deiner strukturierten Datenquelle. Und falls du mal nicht weiterkommst: Du weißt, wo du mich findest (wahrscheinlich beim Debuggen von Selektoren mit einer Tasse Kaffee und Thunderbit im Browser).

Viel Erfolg beim Scrapen!

FAQs

1. Was ist web scraping mit JavaScript und warum ist es so beliebt?

Beim web scraping mit JavaScript werden Daten automatisiert von Webseiten extrahiert – entweder durch Skripte im Browser oder mit Node.js im Backend. Es ist beliebt, weil JavaScript direkten Zugriff auf den DOM bietet, ein großes Ökosystem für HTTP-Anfragen und Automatisierung hat und Interaktionen wie Logins, Klicks und Scrollen flexibel automatisiert werden können.

2. Was sind die größten Herausforderungen beim Scrapen moderner, dynamischer Webseiten?

Moderne Seiten nutzen oft JavaScript-Frameworks, um Inhalte dynamisch zu laden, Daten hinter endlosem Scrollen oder Pop-ups zu verstecken und das Layout häufig zu ändern. Dadurch sind klassische Scraping-Ansätze anfällig, da Skripte leicht brechen, wenn sich Selektoren ändern oder Daten asynchron geladen werden.

3. Wie unterscheiden sich klassische JavaScript-Scraping-Tools wie Cheerio, Puppeteer und Playwright?

- Cheerio eignet sich am besten für statisches HTML und ist sehr schnell, kann aber keine JavaScript-Inhalte oder Browser-Automatisierung.

- Puppeteer und Playwright sind für dynamische Seiten konzipiert, unterstützen Browser-Automatisierung und können JavaScript-Inhalte verarbeiten, sind aber langsamer und aufwendiger in der Einrichtung. Playwright unterstützt mehrere Browser, Puppeteer hauptsächlich Chrome.

4. Welche Vorteile bietet Thunderbit gegenüber klassischen Scraping-Methoden?

Thunderbit nutzt KI, um Webseiten semantisch zu verstehen, indem sie in ein strukturiertes Markdown-Format umgewandelt und beschriftete Datenfelder extrahiert werden. Das ist robuster gegenüber Layout-Änderungen, reduziert manuellen Reinigungsaufwand und minimiert Wartung im Vergleich zu selektorbasiertem Scraping.

5. Was sind Best Practices für rechtssicheres und faires Web Scraping?

- Immer robots.txt und Nutzungsbedingungen der Website prüfen und respektieren.

- Anfragen begrenzen, um Server nicht zu überlasten.

- Den Bot mit einem eigenen User-Agent kennzeichnen.

- Keine sensiblen oder persönlichen Daten scrapen, sondern bei öffentlichen Informationen bleiben.

- Über rechtliche Rahmenbedingungen und Best Practices im eigenen Land informiert bleiben.

Mehr erfahren: