Ich weiß noch genau, wie ich beim Launch eines neuen Produkts unbedingt alle News im Blick behalten wollte. Drei Bildschirme, zig Google News Tabs – und trotzdem immer die Sorge, eine wichtige Meldung zu verpassen: Sei es eine plötzliche Ankündigung der Konkurrenz oder eine unerwartete PR-Krise. Damit bin ich definitiv nicht allein: Jeden Tag werden über veröffentlicht. Das sind so viele Schlagzeilen, dass ich sie selbst mit Dauerkaffee niemals alle lesen könnte.

Gerade im Vertrieb, Marketing, in der Unternehmenskommunikation oder im operativen Geschäft kennt man das Problem: Manuelles News-Tracking fühlt sich an, als würde man versuchen, aus einem Feuerwehrschlauch zu trinken. Genau hier wird das web scraping google news mit Python zum echten Gamechanger: Du automatisierst die Nachrichtenbeschaffung, kannst gezielt Daten auswerten und verpasst keine wichtigen Entwicklungen mehr – egal ob Markenmonitoring, Wettbewerbsanalyse oder das frühzeitige Erkennen von Trends. In diesem Guide zeige ich dir Schritt für Schritt, wie du von einem einfachen Beispiel bis hin zu einem robusten, wiederholbaren google news scraper python kommst. Wir gehen durch den Code, Best Practices und wie du deine Daten optimal für Analysen vorbereitest – inklusive ein paar Praxistipps und Anekdoten.

Warum google news scraping für Unternehmen unverzichtbar ist

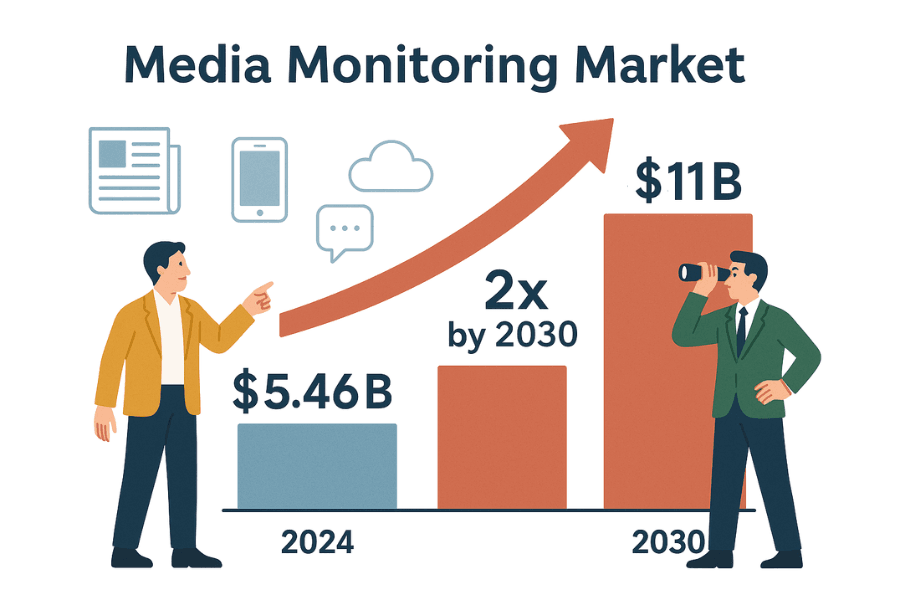

Klar ist: Im Business zählt jede Schlagzeile. Egal ob PR, Vertrieb oder Strategie – du musst wissen, was gerade über dein Unternehmen, deine Branche oder die Konkurrenz berichtet wird. Der Markt für Media-Monitoring-Tools ist bereits schwer und wird sich bis 2030 voraussichtlich verdoppeln. Warum? Weil Unternehmen es sich nicht leisten können, eine Story zu verpassen, die ihren Ruf, Umsatz oder ihre Compliance beeinflussen könnte.

So bringt dir das web scraping google news im Job echte Vorteile (und macht dich zum News-Profi im Team):

| Anwendungsfall | Vorteile automatisierter News-Daten |

|---|---|

| Markenmonitoring | Negative Berichterstattung oder Krisen frühzeitig erkennen und schnell reagieren (siehe, wie Dove durch News-Monitoring eine PR-Krise entschärfte). |

| Wettbewerbsanalyse | Produktlaunches, Führungswechsel oder M&A-Aktivitäten der Konkurrenz verfolgen und die eigene Strategie anpassen (Details). |

| Vertrieb & Lead Insights | Potenzielle Kunden auf Finanzierungsrunden, Expansionen oder andere relevante Ereignisse überwachen (Case Study). |

| Trend- & Marktanalyse | Branchennachrichten bündeln, um neue Trends und Stimmungen frühzeitig zu erkennen (Warum das wichtig ist). |

| Risikomanagement | Alerts für Klagen, Regulierungen oder politische Änderungen einrichten, die das Geschäft betreffen könnten (Beispiele). |

Manuelles Monitoring? Das ist langsam, fehleranfällig und du übersiehst schnell Chancen oder Risiken (). Automatisiertes Scraping liefert dir dagegen einen stetigen, strukturierten News-Feed – keine Angst mehr, etwas zu verpassen, sondern echte Entscheidungsgrundlagen.

Einstieg: Web Scraping Basics mit Python (Einsteigerfreundliches Beispiel)

Bevor wir uns an web scraping google news wagen, üben wir erstmal auf einer offenen Testseite: . Hier kannst du gefahrlos ausprobieren, ohne gesperrt zu werden oder Regeln zu verletzen.

Unser Plan:

- Anfrage an die Startseite schicken.

- HTML mit BeautifulSoup parsen.

- Buchtitel und Preise extrahieren.

- Daten in ein pandas DataFrame speichern und als CSV exportieren.

- Über mehrere Seiten blättern und Fehler abfangen.

Schritt 1: Anfrage senden und HTML parsen

Zuerst holen wir die Startseite mit der requests-Bibliothek:

1import requests

2url = "http://books.toscrape.com/index.html"

3response = requests.get(url)

4print(response.status_code) # Gibt 200 aus, wenn erfolgreichStatuscode 200? Dann läuft alles ().

Jetzt parsen wir das HTML:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(response.text, 'html.parser')Damit hast du ein soup-Objekt – so kannst du bequem durch das DOM der Seite navigieren ().

Schritt 2: Daten extrahieren und als CSV speichern

Alle Bücher auf der Seite holen:

1books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

2print(f"Gefunden: {len(books)} Bücher auf dieser Seite")Jetzt Titel und Preise extrahieren:

1book_list = []

2for item in books:

3 title = item.h3.a["title"]

4 price = item.find("p", class_="price_color").get_text()

5 book_list.append({"Title": title, "Price": price})Mit pandas als CSV speichern:

1import pandas as pd

2df = pd.DataFrame(book_list)

3df.to_csv("books.csv", index=False)Oder klassisch mit dem csv-Modul:

1import csv

2keys = book_list[0].keys()

3with open("books.csv", "w", newline="", encoding="utf-8") as f:

4 writer = csv.DictWriter(f, fieldnames=keys)

5 writer.writeheader()

6 writer.writerows(book_list)Öffne books.csv in Excel – und schon hast du deine ersten Daten automatisiert gesammelt.

Schritt 3: Über mehrere Seiten blättern und Fehler abfangen

Du willst alle Bücher, nicht nur die erste Seite? Dann brauchst du eine Schleife:

1all_books = []

2for page in range(1, 51): # Insgesamt 50 Seiten

3 url = f"http://books.toscrape.com/catalogue/page-{page}.html"

4 try:

5 res = requests.get(url, timeout=10)

6 if res.status_code != 200:

7 break

8 soup = BeautifulSoup(res.text, 'html.parser')

9 books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

10 for item in books:

11 title = item.h3.a["title"]

12 price = item.find("p", class_="price_color").get_text()

13 all_books.append({"Title": title, "Price": price})

14 except requests.exceptions.RequestException as e:

15 print(f"Request failed: {e}")

16 continueDiese Schleife blättert durch die Seiten, stoppt bei Fehlern und fängt Netzwerkprobleme ab. (Tipp: Mit time.sleep(1) zwischen den Anfragen bist du besonders höflich.)

Glückwunsch! Du kennst jetzt die Grundlagen von web scraping: Anfragen, Parsen, Extraktion, Pagination und Fehlerbehandlung. Genau diese Skills brauchst du auch für das scraping google news python.

google news scraping mit Python: Schritt für Schritt

Bereit für die Königsklasse? Wir bauen jetzt einen google news scraper python, der Schlagzeilen, Links, Quellen und Zeitstempel extrahiert – und so die Nachrichtenwelt in strukturierte Daten für deine Analysen verwandelt.

Python-Umgebung einrichten

Stelle sicher, dass du Python 3 und diese Bibliotheken installiert hast:

1pip install requests beautifulsoup4 pandas()

Du brauchst außerdem einen User-Agent-String, um einen echten Browser zu simulieren – sonst blockt Google dich schnell ().

Den google news scraper python bauen

So gehst du vor:

1. Such-URL und Parameter definieren

Google News-Such-URLs sehen so aus:

1https://news.google.com/search?q=YOUR_QUERY&hl=en-US&gl=US&ceid=US:enq: Suchbegriffhl: Sprache (z.B.de-DE)gl: Land (z.B.DE)ceid: Land:Sprache (z.B.DE:de)

In Python:

1base_url = "https://news.google.com/search"

2params = {

3 'q': 'technologie',

4 'hl': 'de-DE',

5 'gl': 'DE',

6 'ceid': 'DE:de'

7}

8headers = {

9 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)...'

10}()

2. Ergebnisse abrufen

1response = requests.get(base_url, params=params, headers=headers)

2html = response.text

3print(response.status_code)()

3. Daten parsen und extrahieren

HTML parsen und Artikel extrahieren:

1soup = BeautifulSoup(html, 'html.parser')

2articles = soup.find_all('article')

3news_data = []

4for art in articles:

5 headline_tag = art.find('h3')

6 title = headline_tag.get_text() if headline_tag else None

7 link_tag = art.find('a')

8 link = link_tag['href'] if link_tag else ''

9 if link.startswith('./'):

10 link = 'https://news.google.com' + link[1:]

11 source_tag = art.find(attrs={"class": "wEwyrc"})

12 source = source_tag.get_text() if source_tag else None

13 time_tag = art.find('time')

14 time_text = time_tag.get_text() if time_tag else None

15 snippet_tag = art.find('span', attrs={"class": "xBbh9"})

16 snippet = snippet_tag.get_text() if snippet_tag else None

17 news_data.append({

18 "title": title,

19 "source": source,

20 "time": time_text,

21 "link": link,

22 "snippet": snippet

23 })()

Jetzt als CSV speichern:

1df = pd.DataFrame(news_data)

2df.to_csv("google_news_results.csv", index=False)Fehlende Daten abfangen

Prüfe immer, ob ein Tag existiert, bevor du darauf zugreifst. Google ändert das HTML oft – manchmal gibt es einen Snippet, manchmal nicht. Fehlt ein Feld, setze es auf None oder einen leeren String.

Mehrere Seiten scrapen & Rate Limits beachten

Google News nutzt Infinite Scroll statt klassischer Seitenzahlen. Mit requests bekommst du meist nur die erste Ergebnis-Seite. Für mehr Ergebnisse:

- Nutze den RSS-Feed deiner Suche (liefert oft mehr Treffer; )

- Setze auf Headless-Browser wie Selenium oder Playwright (fortgeschritten)

- Oder scrape regelmäßig (z.B. stündlich), um neue Artikel zu erfassen

Wichtig: Google blockt dich, wenn du zu schnell scrapest. Schon nach 10 schnellen Anfragen kann ein 429-Fehler kommen ().

- Baue

time.sleep(random.uniform(2,6))zwischen die Anfragen - Wechsle User-Agents und IPs bei großem Umfang

- Erkenne CAPTCHAs oder Blockseiten im HTML und pausiere

So wird dein google news scraping reproduzierbar & analysefähig

Das Geheimnis: Gutes Scraping heißt nicht nur „Daten holen“, sondern sie auch reproduzierbar und auswertbar zu machen. Für BI-Dashboards, PR-Monitoring oder Wettbewerbsanalysen brauchst du Kontrolle über Sprache, Region, Zeit und Dubletten.

Nach Sprache, Region und Zeit filtern

Google News personalisiert stark. Für konsistente Ergebnisse:

- Nutze die Parameter

hl,glundceidfür Sprache und Land () - Beispiel:

hl=de&gl=DE&ceid=DE:defür deutsche News,hl=en-IN&gl=IN&ceid=IN:enfür indische News auf Englisch

Für Zeitfilter:

- Google News hat keinen direkten „letzte 24 Stunden“-Parameter, sortiert aber meist nach Aktualität

- Nach dem Scraping filtern: Wenn

time„Stunde“, „Minuten“ oder „Heute“ enthält, behalten; sonst überspringen - Für mehr Kontrolle: RSS-Feed oder erweiterte Suchoperatoren nutzen (funktioniert aber nicht immer zuverlässig)

News-Ergebnisse filtern & Dubletten vermeiden

Doppelte Einträge verfälschen jede Analyse. So gehst du dagegen vor:

- Quellen-/Themen-Whitelist: Filtere nach bestimmten Quellen oder Themen. Mit dem Operator

source:im Query (z.B.q=Tesla source:Reuters). - Nach URL deduplizieren: Entferne Tracking-Parameter (wie

utm_*). Beispiel:

1import urllib.parse

2clean_link = urllib.parse.urljoin(link, urllib.parse.urlparse(link).path)()

- Nach Titel deduplizieren: Bei sehr ähnlichen Titeln nur einen behalten. Titel kleinschreiben und Satzzeichen entfernen hilft beim Abgleich.

- Bereits gesehene Artikel tracken: Beim täglichen Scraping einen Hash der bereinigten URL speichern und vor dem Hinzufügen prüfen, ob der Artikel schon erfasst wurde.

So bleibt dein Datensatz sauber und bereit für Analysen – keine doppelten Schlagzeilen oder verzerrte Sentiment-Auswertungen mehr ().

Ansätze im Vergleich: Python-Scraper vs. Google News APIs

Selbst bauen oder auf eine Google News API setzen? Hier der Vergleich:

| Kriterium | Eigener Python-Scraper | Drittanbieter Google News API |

|---|---|---|

| Implementierungsaufwand | Code schreiben, debuggen, an Änderungen anpassen | API-Aufrufe, keine HTML-Analyse nötig |

| Flexibilität | Jedes Feld extrahieren, beliebig navigieren | Begrenzte Felder und Optionen |

| Datenkontrolle | Volle Kontrolle über Rohdaten | Vorgefertigte Daten, Parsing durch Anbieter |

| Skalierbarkeit & Geschwindigkeit | Begrenzung durch eigene IP/Hardware, Block-Risiko | Für Skalierung gebaut, Anbieter managt Proxies & Blocks |

| Zuverlässigkeit | Bricht bei Google-Änderungen oder IP-Blockaden | Sehr zuverlässig, APIs passen sich an |

| Wartung | Laufend: Selektoren anpassen, Anti-Bot-Maßnahmen | Minimal, Anbieter übernimmt Wartung |

| Kosten | Kostenlos (außer Zeit, evtl. Proxy-Kosten) | Kostenpflichtig – meist pro Anfrage oder Monatskontingent (Preisbeispiele) |

| Blockierungsrisiko | Hoch, wenn nicht vorsichtig; Google kann IP sperren | Gering, API übernimmt Blockhandling |

| Datenaktualität | Du bestimmst das Timing, zu häufiges Scraping kann blocken | Echtzeit, hohe Limits je nach Tarif |

| Rechtliches/ToS | Du bist für Einhaltung der Google-Richtlinien verantwortlich | Auch hier Vorsicht, aber APIs werben oft mit Fair Use (keine Rechtsberatung!) |

Für kleine Projekte oder zum Lernen ist DIY ideal. Für den produktiven Einsatz oder große Datenmengen sparen APIs Zeit und Nerven. (Oder du willst beides: keine Wartung, kein Code? Dann schau dir Thunderbit unten an.)

Häufige Probleme beim google news scraping & Lösungen

Nicht immer läuft alles glatt. Das kann passieren – und so löst du es:

- CAPTCHAs oder „ungewöhnlicher Traffic“: Anfragen verlangsamen, User-Agents rotieren, ggf. Proxies nutzen. Bei CAPTCHA: Scraping stoppen und abwarten ().

- HTTP 429/503 Fehler: Du wirst gebremst oder blockiert. Exponentielles Backoff, robots.txt prüfen, keine parallelen Scraper laufen lassen.

- HTML-Struktur ändert sich: Google passt das UI oft an. Selektoren aktualisieren, Extraction in try/except-Blöcke packen.

- Fehlende Felder: Nicht jeder Artikel hat Snippet oder Quelle. Code flexibel halten.

- Doppelte Einträge: Siehe oben: deduplizieren.

- Encoding-Probleme: Immer UTF-8 beim Speichern nutzen.

- JavaScript-Content: Die meisten Google News-Resultate sind serverseitig, für JS-Inhalte ggf. Selenium/Playwright nutzen (fortgeschritten).

Weitere Tipps findest du in und auf .

Best Practices für verantwortungsvolles google news scraping

Lass uns über Ethik und Best Practices sprechen – denn mit großer Scraping-Power kommt große Verantwortung:

- robots.txt respektieren: Google News verbietet das Crawlen bestimmter Pfade (). Auch wenn Scraping technisch möglich ist, solltest du die Regeln beachten.

- Server nicht überlasten: Pausen einbauen, außerhalb der Stoßzeiten scrapen, keine Daueranfragen.

- Daten nur für erlaubte Zwecke nutzen: Nur Schlagzeilen, Snippets und Links für Analysen verwenden. Keine Volltexte veröffentlichen ().

- Quellen angeben: Wenn du Erkenntnisse teilst, nenne Google News und die Originalquelle.

- Scraper regelmäßig aktualisieren: Das Web ändert sich – dein Code sollte es auch.

- Datenschutz & Compliance: Daten sicher speichern und Datenschutzgesetze beachten.

- Fair Use & Rate Limiting: Nicht übertreiben – in moderatem Umfang arbeiten und bei Aufforderung stoppen ().

Kurz: Scrape verantwortungsvoll. Dein zukünftiges Ich (und die IT) werden es dir danken.

Fazit & nächste Schritte

Zusammengefasst:

- Du hast die Grundlagen von web scraping google news gelernt – mit Python, requests und BeautifulSoup, von einer statischen Seite bis zu Google News.

- Du hast einen wiederholbaren google news scraping-Workflow gebaut: mit Kontrolle über Sprache, Region und Zeit, Dublettenfilter und Analysefähigkeit.

- Du kennst die Unterschiede zwischen DIY-Scraping und API-Lösungen: und weißt, wann sich welcher Ansatz lohnt.

- Du hast Troubleshooting- und Best Practice-Tipps für verantwortungsvolles Scraping an der Hand.

Was jetzt? Setze die Techniken für deine eigenen Projekte ein – ob Markenmonitoring, Wettbewerbsbeobachtung oder ein individuelles News-Dashboard. Lust auf mehr? Probiere Scraping auf anderen News-Seiten, automatisiere deine Datenpipeline oder führe Sentiment-Analysen auf Schlagzeilen durch.

Und wenn du keine Lust mehr auf Python-Skripte hast (oder einfach Zeit sparen willst), schau dir an. Thunderbit ist eine KI-gestützte Web-Scraper Chrome-Erweiterung, mit der du Google News und andere Seiten in wenigen Klicks scrapen kannst – ganz ohne Programmierkenntnisse. Features wie „KI-Feldvorschläge“, geplantes Scraping, Subpage-Navigation und Export nach Excel oder Google Sheets machen die Nachrichtenbeschaffung für dein Team so einfach wie nie. (Hier kannst du die Chrome-Erweiterung .)

Weitere Tipps findest du im oder in unseren Anleitungen zu , und .

Viel Erfolg beim Scrapen – und möge dein News-Feed immer aktuell, strukturiert und der Konkurrenz einen Schritt voraus sein.

Verfasst von Shuai Guan, Co-Founder & CEO bei Thunderbit. Ich beschäftige mich seit Jahren mit SaaS, Automatisierung und KI – und finde es immer wieder spannend, aus Datenchaos verwertbare Informationen zu machen. Fragen oder Lust auf einen Austausch? Melde dich gern!

FAQs

1. Warum sollten Unternehmen Google News mit Python scrapen?

Das scraping google news python ermöglicht es Unternehmen, relevante Nachrichten zu ihrer Marke, Konkurrenz oder Branche automatisiert zu erfassen. So lassen sich PR-Krisen in Echtzeit erkennen, Wettbewerber beobachten, Vertriebschancen identifizieren, Markttrends analysieren und Risiken frühzeitig managen. Manuelles Monitoring ist langsam und übersieht oft wichtige Updates – automatisiertes Scraping liefert dagegen einen strukturierten, aktuellen News-Feed.

2. Was sind die grundlegenden Schritte, um Google News mit Python zu scrapen?

Der Ablauf:

- Python-Umgebung mit Bibliotheken wie

requests,BeautifulSoupundpandaseinrichten. - Google News-Such-URL und Parameter (z.B. Suchbegriff, Sprache, Region) definieren.

- Anfrage mit passenden Headern (inkl. User-Agent) senden.

- HTML parsen und Artikeldetails wie Titel, Link, Quelle, Zeit und Snippet extrahieren.

- Die Daten als CSV für Analysen speichern.

- Fehlende Daten abfangen und Ergebnisse deduplizieren, um saubere Datensätze zu erhalten.

3. Welche Herausforderungen gibt es beim Scraping von Google News und wie kann ich sie lösen?

Typische Probleme:

- CAPTCHAs oder „ungewöhnlicher Traffic“: Anfragen verlangsamen, User-Agents rotieren, ggf. Proxies nutzen.

- Rate Limiting (HTTP 429/503): Pausen einbauen, keine parallelen Scraper.

- HTML-Änderungen: Selektoren regelmäßig prüfen und try/except nutzen.

- Fehlende oder inkonsistente Felder: Immer prüfen, ob ein Tag existiert.

- Doppelte Einträge: Nach URL oder Titel deduplizieren.

- Encoding-Probleme: Immer UTF-8 beim Speichern nutzen.

- JavaScript-Inhalte: Für komplexe Fälle Selenium oder Playwright einsetzen.

4. Wie mache ich meinen google news scraping-Workflow reproduzierbar und analysefähig?

Für saubere, wiederholbare Daten:

- Sprache und Region mit den Parametern

hl,glundceidsteuern. - Ergebnisse nach Zeit filtern – entweder nach dem Scraping oder per RSS-Feed.

- Artikel nach bereinigter URL und Titel deduplizieren.

- Bereits erfasste Artikel tracken, um Doppelungen zu vermeiden.

- Daten sicher speichern und den Scraping-Prozess dokumentieren.

5. Sollte ich meinen eigenen google news scraper bauen oder eine Drittanbieter-API nutzen?

Ein eigener Scraper bietet maximale Kontrolle, Flexibilität und ist meist kostenlos (abgesehen von Zeit und evtl. Proxy-Kosten). Allerdings ist er wartungsintensiv, bricht bei Google-Änderungen schnell und das Blockierungsrisiko ist höher. Drittanbieter-APIs sind zuverlässiger, skalierbar und übernehmen das Anti-Bot-Handling, kosten aber Geld und bieten weniger Kontrolle. Für kleine Projekte oder zum Lernen ist DIY ideal, für produktive oder große Anwendungen sind APIs meist die bessere Wahl.