Ich geb’s ehrlich zu: Als ich das erste Mal versucht habe, alle URLs einer großen Website zu sammeln, dachte ich mir: „Wie schwer kann das schon sein?“ Ein paar Stunden später saß ich immer noch da, klickte mich durch unzählige Seiten, kopierte Links in eine Tabelle und fragte mich, warum ich mir das eigentlich antue. Wer schon mal versucht hat, alle Seiten einer Website zu finden – egal ob für einen Content-Audit, eine Lead-Liste oder eine Wettbewerbsanalyse – weiß, wie nervig das ist. Es ist mühsam, fehleranfällig und ehrlich gesagt eine ziemliche Verschwendung von Zeit und Energie.

Die gute Nachricht: Das muss heute wirklich nicht mehr sein. KI-gestützte Tools wie krempeln die Datenerfassung komplett um und machen es möglich, alle URLs einer Domain in wenigen Minuten statt Tagen zu finden. Unternehmen, die auf KI-basierte Web-Scraping-Tools setzen, berichten von , manche sogar von im Vergleich zur Handarbeit. Das sind nicht nur Zahlen – das sind Stunden oder sogar Tage, die du zurückgewinnst.

Schauen wir uns also an, warum es so knifflig ist, alle Seiten einer Website zu finden, warum allgemeine KI-Modelle wie GPT oder Claude hier schnell an ihre Grenzen kommen und wie spezialisierte KI-Agenten wie Thunderbit das Ganze zum Kinderspiel machen. Und ja, ich zeige dir Schritt für Schritt, wie du jede gewünschte URL extrahierst – ganz ohne Programmierkenntnisse.

Warum ist es so schwierig, alle URLs einer Domain zu finden?

Fakt ist: Websites sind nicht dafür gebaut, dir eine komplette Liste aller Seiten zu präsentieren. Sie sind für Besucher gemacht, nicht für Leute, die alle Seiten auf einmal finden wollen. Das macht die Sache so tricky:

- Copy-Paste-Wahnsinn: Jeden Menüpunkt, jede Liste und jedes Verzeichnis durchzuklicken und die URLs einzeln zu kopieren, ist nicht nur ermüdend, sondern du übersiehst garantiert Seiten.

- Paginierung und Endlos-Scrollen: Viele Seiten verteilen Inhalte auf mehrere Unterseiten oder laden beim Scrollen immer mehr nach. Wenn du einen „Weiter“-Button übersiehst oder nicht weit genug scrollst, fehlen dir ganze Bereiche.

- Unterschiedliche Seitenstrukturen: Manche Seiten listen Links in einem bestimmten Format, andere wieder ganz anders. Da den Überblick zu behalten, ist fast unmöglich.

- Versteckte oder verwaiste Seiten: Nicht jede Seite ist über die Hauptnavigation erreichbar. Manche sind tief versteckt und nur über Sitemaps oder die interne Suche auffindbar.

- Menschliche Fehler: Je mehr Seiten du manuell kopierst, desto größer die Chance auf Fehler – doppelte URLs, Tippfehler oder schlichtes Übersehen.

Und wenn du es mit Hunderten oder Tausenden von Seiten zu tun hast? Vergiss es. Manuelles Extrahieren ist einfach nicht machbar. Wie ein Data-Team so schön sagt: .

Was heißt eigentlich, „alle Seiten einer Website zu finden“?

Bevor wir zu den Lösungen kommen, sollten wir klären, was genau gesucht wird:

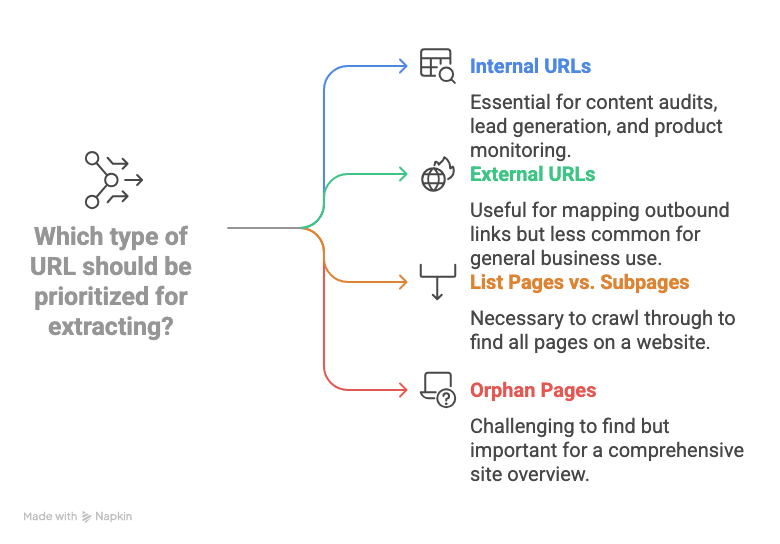

- Interne URLs: Das sind Links, die auf Seiten derselben Domain verweisen (z. B. /ueber-uns oder /produkte/widget-123). Für die meisten Business-Anwendungen – Content-Audits, Lead-Generierung, Produktüberwachung – sind interne URLs das Ziel.

- Externe URLs: Links, die auf andere Websites führen. Die sind meist nur relevant, wenn du ausgehende Verlinkungen analysieren willst.

- Listen- vs. Unterseiten: Viele Websites haben „Hub“- oder „Listen“-Seiten (z. B. Kategorien, Blog-Archive, Verzeichnisse), die auf Detailseiten (wie Produkt- oder Profilseiten) verweisen. Um wirklich alle Seiten einer Website zu finden, musst du diese Listen durchgehen und jede verlinkte Unterseite erfassen.

- Verwaiste Seiten: Seiten, die nirgendwo offensichtlich verlinkt sind. Manchmal findet man sie über Sitemaps oder die interne Suche – oft bleiben sie aber unentdeckt.

Kurz gesagt: Wenn wir von allen URLs einer Domain finden sprechen, meinen wir: Jede interne Seiten-URL – von der Startseite bis zur tiefsten Produkt- oder Artikelseite – am besten direkt in einer Tabelle.

Klassische Methoden, um alle URLs einer Domain zu finden

Es gibt ein paar klassische Ansätze, aber jeder hat so seine Haken:

Manuelles Copy-Paste und Browser-Tools

Das ist die „Holzhammer-Methode“: Jeden Link anklicken, jede URL kopieren, in eine Tabelle einfügen und hoffen, nichts zu übersehen. Manche nutzen Browser-Erweiterungen, um alle Links einer Seite zu erfassen – aber das muss für jede Seite wiederholt werden, und Paginierung oder versteckte Bereiche bleiben außen vor. Für eine Mini-Website okay – für größere Projekte absolut ungeeignet.

Site Search und Sitemaps nutzen

- Google’s site:-Suche: Mit site:deinedomain.com zeigt Google viele indexierte Seiten an. Aber Google zeigt nur, was es kennt (oft maximal 1.000 Ergebnisse) – neue, versteckte oder minderwertige Seiten fehlen. gibt zu, dass das keine vollständige Lösung ist.

- XML-Sitemaps: Viele Seiten haben eine /sitemap.xml mit wichtigen URLs. Super – wenn sie aktuell ist und alle Seiten enthält. Aber nicht jede Seite hat eine Sitemap, manche sind auf mehrere Dateien verteilt. Verwaiste Seiten fehlen oft.

Technische Crawler und Skripte

- SEO-Tools (wie Screaming Frog): Diese crawlen eine Website wie eine Suchmaschine und liefern eine URL-Liste. Sehr mächtig, aber erfordern Einrichtung, Konfiguration und oft eine kostenpflichtige Lizenz für große Seiten.

- Python-Skripte (wie Scrapy): Entwickler können eigene Skripte schreiben, um URLs zu extrahieren. Aber mal ehrlich: Wer nicht programmieren kann, kommt hier nicht weiter. Außerdem brechen Skripte bei Layout-Änderungen schnell.

Fazit: Die klassischen Methoden sind entweder zu aufwendig, zu unvollständig oder zu technisch für die meisten Business-Anwender. Kein Wunder, dass viele irgendwann entnervt aufgeben.

Warum allgemeine KI-Modelle die URL-Extraktion nicht automatisieren können

Vielleicht denkst du: „Kann ich nicht einfach ChatGPT oder Claude fragen, ob sie alle Seiten einer Website finden?“ Schön wär’s. Die Realität sieht so aus:

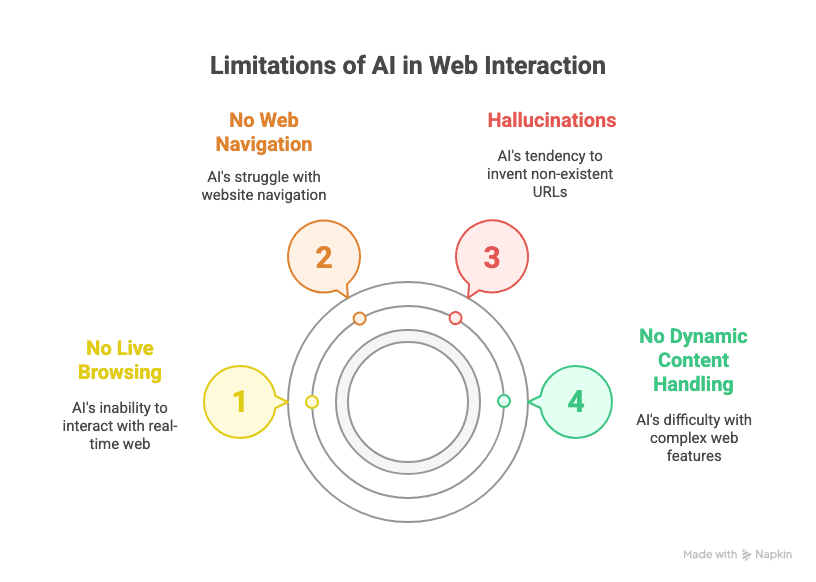

- Kein Live-Browsing: Allgemeine KI-Modelle wie GPT oder Claude können nicht in Echtzeit im Web surfen. Sie „sehen“ den aktuellen Stand einer Website nicht, sondern arbeiten nur mit Trainingsdaten oder dem, was du einfügst.

- Keine Web-Navigation: Selbst mit Plugins oder aktiviertem Browsing wissen LLMs nicht, wie sie auf „Weiter“ klicken, Endlos-Scrollen handhaben oder systematisch jedem Link folgen.

- Halluzinationen: Fragt man eine generische KI nach allen URLs einer Domain, erfindet sie oft plausible, aber nicht existierende Links. (Ich habe schon /ueber-uns-Seiten gesehen, die nie existierten.)

- Keine dynamischen Inhalte: Seiten, die Inhalte per JavaScript laden, Logins erfordern oder komplexe Navigation nutzen, sind für allgemeine LLMs tabu.

Wie : „Wenn du Hunderte oder Tausende Seiten extrahieren willst… reicht ChatGPT allein nicht aus.“ Du brauchst ein spezialisiertes Tool.

Vertikale KI-Agenten sind die Zukunft (und warum das wichtig ist)

Hier kommt meine Erfahrung aus SaaS und Automatisierung ins Spiel: Vertikale KI-Agenten – also KI-Tools, die für einen bestimmten Anwendungsfall wie Web-Datenextraktion entwickelt wurden – sind der einzige Weg zu zuverlässigen, skalierbaren Ergebnissen im Business-Kontext. Warum?

- Allgemeine LLMs sind gut für Texte oder Suche, aber sie neigen zu „Halluzinationen“ und können keine mehrstufigen, wiederholbaren Workflows mit der nötigen Stabilität abbilden.

- Unternehmens-Software muss viele strukturierte, sich wiederholende Aufgaben automatisieren. Genau hier glänzen vertikale KI-Agenten – sie sind für eine Aufgabe gebaut und erledigen diese zuverlässig und fehlerarm.

- Beispiele gibt’s in vielen Branchen: Thunderbit für Web-Daten, Devin AI für Softwareentwicklung, Alta für Vertriebsautomatisierung, Infinity Learn’s IL VISTA für Bildung, Rippling für HR, Harvey für Legal… die Liste ist lang.

Kurz gesagt: Wer alle Seiten einer Website zuverlässig finden will, braucht einen spezialisierten KI-Agenten – keinen Allzweck-Chatbot.

Thunderbit kennenlernen: KI-gestützte URL-Extraktion für alle

Hier kommt ins Spiel. Als KI-Web-Scraper Chrome-Erweiterung ist Thunderbit für Business-Anwender gemacht – kein Programmieren, keine technische Einrichtung, einfach Ergebnisse. Das macht Thunderbit besonders:

- Bedienung in natürlicher Sprache: Einfach beschreiben, was du möchtest („Alle Seiten-URLs dieser Website auflisten“), und Thunderbits KI übernimmt die Extraktion.

- KI-Feldvorschläge: Thunderbit scannt die Seite und schlägt automatisch passende Spaltennamen vor (z. B. „Seiten-URL“) – kein Herumärgern mit CSS-Selektoren oder XPath.

- Beherrscht Paginierung und Endlos-Scrollen: Thunderbit klickt automatisch auf „Weiter“ oder scrollt nach unten, damit keine Seite verloren geht.

- Navigation zu Unterseiten: Du willst tiefer gehen? Thunderbit folgt Links zu Unterseiten und extrahiert auch dort Daten.

- Strukturierter Export: Ergebnisse lassen sich direkt nach Google Sheets, Excel, Notion, Airtable oder als CSV exportieren – kostenlos und mit einem Klick.

- Kein Programmieren nötig: Wer eine Website bedienen kann, kann auch Thunderbit nutzen. So einfach ist das.

Und weil Thunderbit ein vertikaler KI-Agent ist, ist es auf Stabilität und Wiederholbarkeit ausgelegt – ideal für alle, die regelmäßig dieselben Aufgaben automatisieren möchten.

Schritt für Schritt: So findest du alle URLs einer Domain mit Thunderbit

Neugierig, wie das funktioniert? Hier eine einfache Anleitung – ganz ohne Technik-Kauderwelsch.

1. Thunderbit Chrome-Erweiterung installieren

Zuerst: . Funktioniert mit Chrome, Edge, Brave und anderen Chromium-Browsern. Am besten gleich an die Symbolleiste anheften.

2. Zielseite oder Verzeichnis öffnen

Geh auf die Website, von der du URLs extrahieren möchtest. Das kann die Startseite, eine Sitemap, ein Verzeichnis oder jede beliebige Liste sein, die auf die gewünschten Seiten verweist.

3. Thunderbit starten und Felder einrichten

Klick auf das Thunderbit-Icon, um die Erweiterung zu öffnen. Starte eine neue Scraper-Vorlage. Jetzt kommt der Clou:

- Klick auf „KI-Felder vorschlagen“. Thunderbits KI scannt die Seite und schlägt Spalten vor – achte auf Bezeichnungen wie „Seiten-URL“, „Link“ oder Ähnliches.

- Falls das gewünschte Feld nicht dabei ist, füge einfach eine Spalte namens „Seiten-URL“ (oder ähnlich) hinzu. Thunderbits KI erkennt diese Begriffe und ordnet sie den richtigen Daten zu.

4. Paginierung oder Scrollen aktivieren (falls nötig)

Hat deine Zielseite mehrere Unterseiten (z. B. „Seite 1, 2, 3…“ oder einen „Mehr laden“-Button), aktiviere die Paginierung in Thunderbit:

- Wechsel in den Modus „Paginierung klicken“ für Seiten mit „Weiter“-Button oder „Endlos-Scrollen“ für Seiten, die beim Scrollen nachladen.

- Thunderbit fordert dich auf, den „Weiter“-Button oder den Scrollbereich auszuwählen – einfach anklicken, den Rest übernimmt die KI.

5. Scraping starten und Ergebnisse prüfen

Klick auf „Scrapen“. Thunderbit durchforstet alle Seiten und sammelt jede gefundene URL. Die Ergebnisse erscheinen direkt in einer Tabelle in der Erweiterung. Bei großen Seiten dauert das ein paar Minuten – aber immer noch viel schneller als per Hand.

6. URL-Liste exportieren

Nach Abschluss des Scrapes klickst du auf Exportieren. Du kannst deine Daten direkt senden an:

- Google Sheets

- Excel/CSV

- Notion

- Airtable

Der Export ist kostenlos und erhält alle Formatierungen. Schluss mit Copy-Paste-Stress.

Thunderbit im Vergleich zu anderen URL-Extraktions-Lösungen

| Methode | Benutzerfreundlichkeit | Genauigkeit & Abdeckung | Skalierbarkeit | Exportoptionen |

|---|---|---|---|---|

| Manuelles Copy-Paste | Schmerzhaft | Niedrig (vieles wird übersehen) | Keine | Manuell (Excel etc.) |

| Browser-Link-Extractor | Für 1 Seite ok | Mittel | Schwach | Manuell |

Google site:-Suche | Einfach | Mittel (nicht vollständig) | Begrenzung bei ~1.000 | Manuell |

| XML-Sitemap | Einfach (falls vorhanden) | Gut (wenn aktuell) | Gut | Manuell/Skript |

| SEO-Tools (Screaming Frog) | Technisch | Hoch | Hoch (kostenpflichtig) | CSV, Excel |

| Python-Skripte (Scrapy etc.) | Sehr technisch | Hoch | Hoch | Individuell |

| Thunderbit | Sehr einfach | Sehr hoch | Hoch | Google Sheets, CSV etc. |

Thunderbit bietet dir die Genauigkeit und Skalierbarkeit eines Profi-Crawlers mit der Einfachheit einer Browser-Erweiterung. Kein Code, keine Einrichtung – einfach Ergebnisse.

Bonus: Mehr als nur URLs mit Thunderbit extrahieren

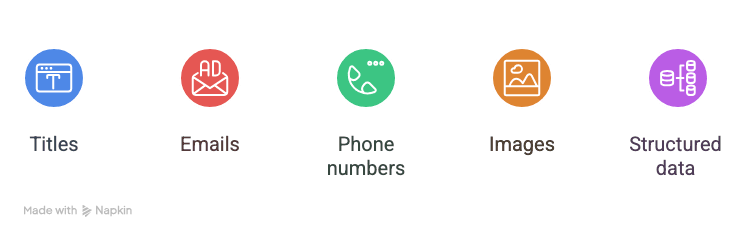

Jetzt wird’s richtig spannend: Thunderbit kann nicht nur URLs extrahieren, sondern auch:

- Titel

- E-Mail-Adressen

- Telefonnummern

- Bilder

- Beliebige strukturierte Daten auf der Seite

Wenn du zum Beispiel eine Lead-Liste erstellen willst, kann Thunderbit für jeden Eintrag die Profil-URL, den Namen, die E-Mail und die Telefonnummer erfassen – alles in einem Rutsch. Bei Produkt-Audits lassen sich Produkt-URL, Name, Preis und Lagerstatus extrahieren. Thunderbit unterstützt sogar , klickt also in jeden Link und holt sich dort die Details.

Und ja, die E-Mail- und Telefon-Extraktoren von Thunderbit sind komplett kostenlos – ein echter Vorteil für Vertriebs- und Marketingteams.

Fazit: So findest du mit KI alle Seiten einer Website

Zusammengefasst:

- Alle URLs einer Domain zu extrahieren ist mit manuellen oder generischen Tools mühsam.

- Allgemeine KI-Modelle wie GPT kommen mit Web-Navigation, Paginierung oder dynamischen Inhalten nicht klar.

- Vertikale KI-Agenten wie Thunderbit sind speziell für Web-Daten gebaut – stabil, wiederholbar und einfach für Business-Anwender.

- Mit Thunderbit geht’s ganz leicht: Erweiterung installieren, KI-Felder nutzen, Paginierung aktivieren, scrapen und exportieren. Kein Code, kein Aufwand.

- Du kannst mehr als nur URLs extrahieren: Titel, E-Mails, Telefonnummern und mehr – ideal für Lead-Generierung, Audits oder Recherche.

Wenn du genug vom Copy-Paste oder technischen Crawlern hast, . Es gibt eine kostenlose Version – überzeug dich selbst, wie viel Zeit (und Nerven) du sparst.

Und wenn du wissen willst, was Thunderbit sonst noch kann – etwa , oder – schau im vorbei.

Bereit, dich vom manuellen Datensammeln zu verabschieden? Die Zukunft der Web-Datenextraktion sind vertikale KI-Agenten – und Thunderbit ist ganz vorne mit dabei. Probier’s aus und mach deinen nächsten Audit, deine Lead-Liste oder dein Rechercheprojekt so einfach wie nie zuvor.

Mehr erfahren

P.S. Solltest du jemals in Versuchung geraten, 1.000 URLs per Hand zu kopieren – denk dran: Dafür gibt’s jetzt KI. Deine Handgelenke (und dein Chef) werden es dir danken.