Daten sind heutzutage das A und O – und der Wettlauf, sie clever zu nutzen, wird immer härter. Jeden Tag werden Milliarden von Webseiten mit Web-Scrapern durchsucht, um an Insights, Preise, Leads oder Forschungsdaten zu kommen – das ist der Motor für alles, von Preiskämpfen im Onlinehandel bis zu den nächsten KI-Meilensteinen (). Der weltweite Markt für Web-Scraping steuert darauf zu, bis Ende 2025 die 9-Milliarden-Dollar-Marke zu knacken. Wer keinen effizienten Web-Scraper nutzt, verschenkt bares Potenzial ().

Nach vielen Jahren in der SaaS- und Automatisierungswelt weiß ich: Der richtige Web-Scraper entscheidet, ob ein Projekt durchstartet oder im Sand verläuft. Besonders beeindruckt hat mich in letzter Zeit, was Rust in Sachen Web-Scraping draufhat. In diesem Guide zeige ich dir, warum Rust für Web-Scraper so stark ist, wie du Schritt für Schritt loslegst und wie du Rust mit KI-Tools wie kombinierst – für maximale Geschwindigkeit, Sicherheit und weniger Stress.

Warum solltest du für deinen Web-Scraper auf Rust setzen?

Kommen wir gleich zum Punkt: Warum Rust? Diese Frage höre ich oft, vor allem von Leuten, die bisher mit Python oder Node.js gecrawlt haben. Das spricht für Rust:

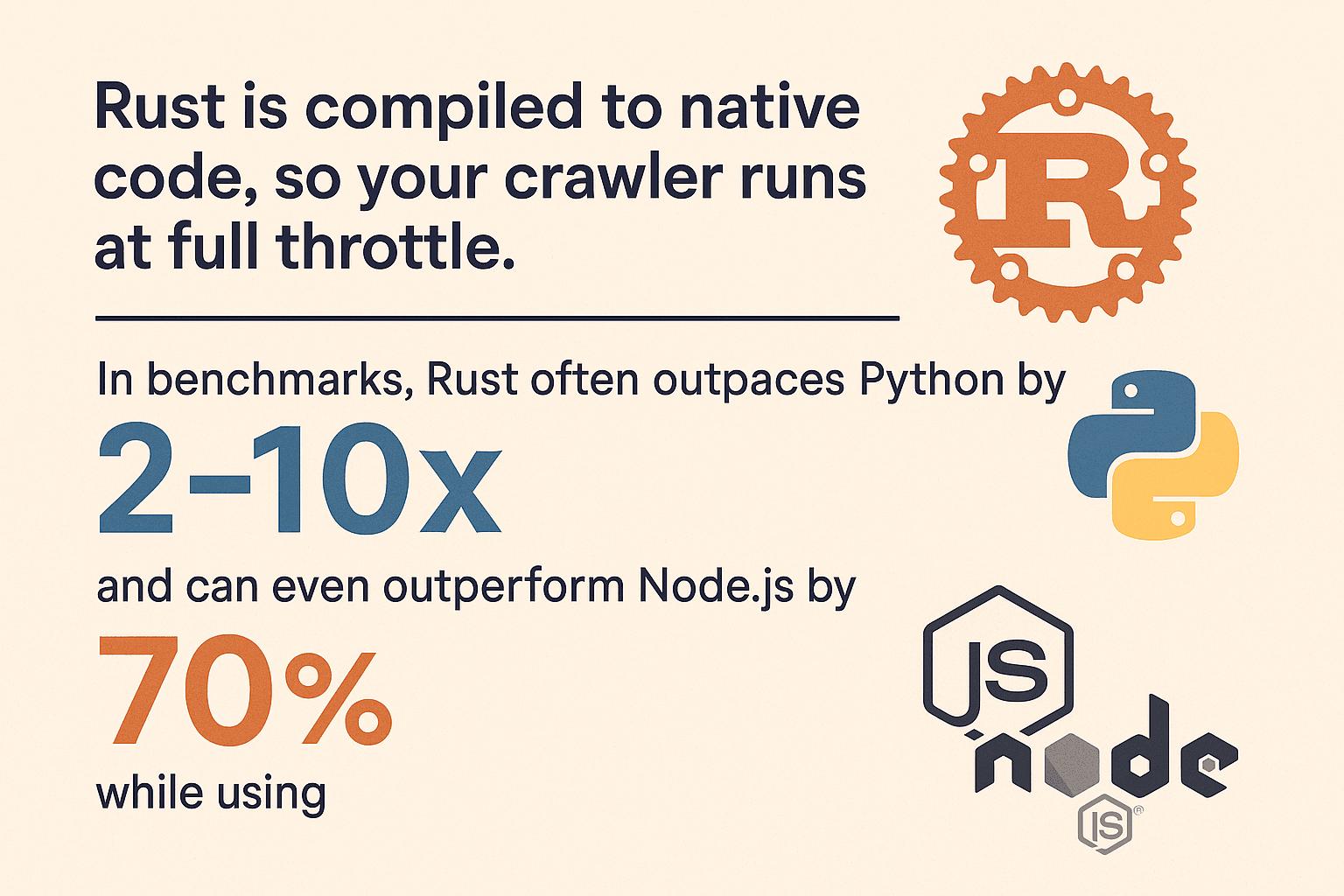

- Rasante Geschwindigkeit: Rust wird zu nativen Code kompiliert – dein Web-Scraper läuft also auf Top-Niveau. In Benchmarks ist Rust bei rechenintensiven Aufgaben oft 2–10× schneller als Python und kann Node.js um 70 % abhängen – bei 90 % weniger Speicherverbrauch (, ).

- Speichersicherheit: Das Ownership-Prinzip von Rust verhindert Speicherlecks und mysteriöse Abstürze. Fehler werden schon beim Kompilieren abgefangen.

- Sichere Parallelität: Rust ist wie gemacht für parallele Abläufe. 100 Seiten gleichzeitig abfragen? Kein Problem – Rust sorgt dafür, dass Threads sicher bleiben und Datenrennen keine Chance haben.

- Zuverlässigkeit: Durch das Fehler-Handling mit

ResultundOptionzwingt Rust dich, Fehlerfälle mitzudenken. Dein Web-Scraper crasht nicht einfach bei einer fehlerhaften Anfrage. - Sicherheit: Keine Buffer Overflows, keine Null-Pointer-Dereferenzierungen. Die Sicherheitsgarantien von Rust machen deinen Web-Scraper robuster gegen fehlerhafte oder bösartige Webinhalte.

Im Vergleich zu Python (simpel, aber langsam und speicherhungrig) oder Node.js (schnelles I/O, aber single-threaded und speicherintensiv) bietet Rust erstklassige Performance und Stabilität – vor allem, wenn dein Scraping-Projekt wächst ().

Rust Web-Scraper: So richtest du deine Entwicklungsumgebung ein

Bereit für den Start? So bringst du deine Rust-Umgebung an den Start:

1. Rust und Cargo installieren

Rust bekommst du über , das auch das Build-Tool cargo mitbringt. Lade einfach den Installer für dein Betriebssystem runter und folge den Anweisungen. Unter Windows kann es sein, dass du Visual C++ Build Tools brauchst.

Installation checken:

1rustc --version

2cargo --versionWenn du Versionsnummern siehst, bist du startklar.

2. Neues Projekt anlegen

Terminal öffnen und los geht’s:

1cargo new rust_web_crawler

2cd rust_web_crawlerJetzt hast du ein frisches Projekt mit Cargo.toml und src/main.rs.

3. Wichtige Abhängigkeiten hinzufügen

Fürs Web-Scraping brauchst du:

- (HTTP-Client)

- (HTML-Parsing mit CSS-Selektoren)

- (Async-Runtime für paralleles Scraping)

- (für den Datenexport)

Füge sie hinzu mit:

1cargo add reqwest scraper csv tokio --features fullOder direkt in deiner Cargo.toml:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. IDE und Tools auswählen

Ich empfehle dir VS Code mit der -Erweiterung. Damit bekommst du Autovervollständigung, Inline-Doku und Linting. Für größere Projekte sind JetBrains CLion oder IntelliJ mit Rust-Plugin auch super.

5. Tipps zur Fehlerbehebung

- Wird

cargonicht gefunden, prüfe, ob Rusts.cargo/bin-Verzeichnis im PATH ist. - Unter Windows ggf. fehlende C++ Build Tools installieren.

- Bei Abhängigkeitsfehlern:

cargo updateausführen oder dieCargo.tomlauf Tippfehler checken.

Schritt für Schritt: Dein erster Rust Web-Scraper

Wir bauen einen einfachen Web-Scraper, der eine Seite abruft, Produktdaten extrahiert und als CSV exportiert. Das Grundgerüst kannst du beliebig ausbauen.

Webseiten mit Rust abrufen

Importiere reqwest:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}In der Praxis solltest du Fehler besser abfangen:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};Daten parsen und extrahieren

Jetzt nutzen wir scraper, um das HTML zu parsen und Produktinfos rauszuziehen.

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}Diese Methode ist von inspiriert und funktioniert für die meisten E-Commerce- oder Verzeichnis-Seiten.

URLs verwalten und Duplikate vermeiden

Für einen echten rust web crawler solltest du Links folgen und doppelte Seiten vermeiden. Ein bewährtes Muster:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // Nutze das `url`-Crate!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}Vergiss nicht, URLs zu normalisieren (mit dem Crate), damit relative Pfade, Slashes und Fragmente sauber behandelt werden.

Parallelität für schnelleres Crawling nutzen

Hier spielt Rust seine Stärken voll aus. Seiten einzeln abzuarbeiten ist langsam – parallel geht’s viel flotter.

Option 1: Multi-Threading

Starte mehrere Threads, die gemeinsam die Queue abarbeiten. Für kleine Crawls reicht das, nutze dazu Arc<Mutex<>> für geteilte Daten.

Option 2: Async/Await mit Tokio

Für maximale Geschwindigkeit empfiehlt sich asynchrones Crawling. Mit tokio und asynchronem reqwest kannst du hunderte Anfragen parallel absetzen, ohne den Speicher zu sprengen.

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;Async Rust ist nicht nur schnell, sondern auch sicher: Keine Datenrennen, keine komischen Bugs – einfach maximale Performance ().

Gesammelte Daten exportieren und speichern

Nach dem Scraping willst du die Daten meist exportieren. Mit dem Crate geht das super easy:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();Du kannst auch direkt Structs mit serialisieren oder für komplexere Daten als JSON exportieren.

Mit Thunderbit Webdaten schneller und einfacher extrahieren

Jetzt zu : So gerne ich auch selbst codiere – manchmal will man einfach nur schnell an die Daten. Thunderbit ist eine KI-gestützte Chrome-Erweiterung, mit der du Webseiten ohne Programmieraufwand in wenigen Klicks scrapen kannst.

Thunderbit ist eine KI-Web-Scraper Chrome-Erweiterung, die es Business-Anwendern ermöglicht, mit Hilfe von KI Daten von Webseiten zu extrahieren. Das Tool spart Zeit und automatisiert wiederkehrende Aufgaben im Web.

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Thunderbit erkennt automatisch relevante Spalten wie Namen, E-Mails, Preise und mehr ().

- Ein-Klick-Scraping: Mit einem Klick auf „Scrape“ werden die Daten in eine strukturierte Tabelle übernommen.

- Unterseiten-Scraping: Informationen von Detailseiten? Thunderbit besucht automatisch alle Links und ergänzt die Tabelle ().

- Paginierung & Endlos-Scroll: Thunderbit erkennt und verarbeitet Seiten mit Paginierung oder unendlichem Scrollen.

- Kostenloser Datenexport: Exportiere nach Excel, Google Sheets, Notion, Airtable oder CSV – ohne Umwege.

- KI-Autofill: Automatisiere Formularausfüllungen oder Logins mit KI, um auch hinter Logins Daten zu extrahieren.

Thunderbit ist ein echter Gamechanger – für Business-Anwender wie für Entwickler, besonders bei dynamischen oder JavaScript-lastigen Seiten.

Wann Thunderbit, wann Rust?

- Thunderbit: Ideal für schnelle Prototypen, einmalige Scrapes oder wenn auch Nicht-Programmierer im Team Daten extrahieren sollen.

- Rust: Perfekt für große, maßgeschneiderte oder tief integrierte Web-Scraper, bei denen maximale Performance und Kontrolle gefragt sind.

Am besten ist oft die Kombi aus beidem.

Rust Web-Scraper im Vergleich zu anderen Technologien

Ein kurzer Technikvergleich: Wie schlägt sich Rust gegen die üblichen Verdächtigen?

| Sprache/Framework | Geschwindigkeit | Speicherverbrauch | Parallelität | Stabilität | Ökosystem |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 Niedrig | 🟢 Exzellent | 🟢 Hoch | Mittel |

| Python (Scrapy) | 🚀 | 🔴 Hoch | 🟡 Eingeschränkt | 🟡 Mittel | 🟢 Groß |

| Node.js | 🚀🚀 | 🔴 Hoch | 🟢 Gut | 🟡 Mittel | 🟢 Groß |

| Go | 🚀🚀 | 🟢 Niedrig | 🟢 Exzellent | 🟢 Hoch | Mittel |

- Rust ist oft 2–10× schneller als Python und braucht weniger als 10 % des Speichers (, ).

- Node.js ist stark bei I/O, aber durch das Single-Threading bei JS und aufwändiges Parsen schnell am Limit.

- Go ist ein starker Konkurrent, aber Rusts Speichersicherheit und Zero-Cost-Abstraktionen sind für große, langlebige Web-Scraper oft überlegen.

Wer große Datenmengen crawlt oder maximale Effizienz braucht, kommt an Rust kaum vorbei.

Thunderbit und Rust kombinieren: Das Beste aus beiden Welten

Mein Lieblings-Workflow: Thunderbit und Rust gemeinsam nutzen.

- Schnelles Prototyping: Mit Thunderbit schnell die Seitenstruktur erfassen und Beispieldaten holen – das spart Zeit beim Coden.

- Aufgabenteilung: Thunderbit übernimmt dynamische, komplexe oder authentifizierte Seiten (mit KI-Autofill und Unterseiten-Scraping), während Rust die Masse an statischen oder API-basierten Seiten abarbeitet.

- Geplantes Scraping: Mit Thunderbit regelmäßige Scrapes einrichten und die Ergebnisse im Rust-Backend weiterverarbeiten.

- Empowerment für Nicht-Entwickler: Marketing oder Operations können mit Thunderbit Ad-hoc-Daten holen, während Entwickler sich auf komplexere Aufgaben konzentrieren.

- Resilienz: Wenn sich das Layout ändert und der Rust-Scraper ausfällt, kann Thunderbits KI oft sofort reagieren – ohne Code-Anpassung.

So bekommst du maximale Flexibilität und Geschwindigkeit mit Thunderbit, volle Kontrolle und Power mit Rust.

Troubleshooting & Best Practices für Rust Web-Scraper

Ein robuster Web-Scraper braucht mehr als nur Code – du musst die Tücken des Webs einplanen.

Typische Herausforderungen

- Anti-Bot-Maßnahmen: Nutze realistische User-Agents, beachte

robots.txt, reguliere deine Anfragen und setze ggf. Proxies ein (). - CAPTCHAs und Logins: Bei CAPTCHAs oder komplexen Logins hilft Thunderbits KI-Autofill oder ein Headless-Browser (z. B. oder ) – aber nur, wenn nötig.

- JavaScript-lastige Seiten: Wird der Content per AJAX geladen, suche nach den zugrundeliegenden API-Calls. Falls du JS rendern musst, nutze Thunderbit oder einen Headless-Browser.

- Fehlerbehandlung: Immer sauberes Error-Handling (

Result,Option), Timeouts setzen und Fehler für die Analyse loggen. - Parallelitätsfallen: Nutze thread-sichere Strukturen (

Arc<Mutex<>>oderDashMap) und vermeide Engpässe bei gemeinsam genutzten Daten. - Speicherverwaltung: Schreibe Daten bei großen Crawls direkt auf die Festplatte, statt alles im RAM zu halten.

- Ethik & Compliance: Beachte die Nutzungsbedingungen der Seiten, überlaste keine Server und halte Datenschutzgesetze ein.

Best Practices

- Modularer Code: Trenne Logik für Abruf, Parsing und Speicherung für bessere Wartbarkeit.

- Konfigurierbare Parameter: Nutze Konfigurationsdateien oder CLI-Parameter für URLs, Parallelität, Delays etc.

- Logging: Verwende das

log-Crate für strukturiertes Logging. - Testing: Schreibe Unit-Tests für dein Parsing mit Beispiel-HTML.

- Monitoring: Überwache CPU, Speicher und Fehler – besonders bei langen Crawls.

Weitere Tipps findest du im und im .

Fazit & wichtigste Erkenntnisse

Einen Web-Scraper in Rust zu bauen ist nicht nur technisch spannend – es verschafft dir auch einen echten Vorsprung in der datengetriebenen Welt. Das solltest du mitnehmen:

- Rust ist ein Kraftpaket fürs Web-Scraping: schnell, sicher und für Parallelität gemacht.

- Schritt für Schritt zählt: Umgebung einrichten, Seiten abrufen und parsen, URLs verwalten, Parallelität nutzen und Daten exportieren.

- Thunderbit ist dein Geheimtipp für schnelles, no-code Scraping – besonders bei komplexen oder dynamischen Seiten.

- Kombiniere beides für maximale Effizienz: Thunderbit für Prototyping und schwierige Seiten, Rust für Skalierung und Individualisierung.

- Pragmatisch bleiben: Manchmal ist die beste Lösung ein paar Klicks – nicht hunderte Zeilen Code.

Wenn du dein Web-Scraping aufs nächste Level bringen willst, probiere Rust aus – und lass die Arbeit übernehmen, wenn es schnell gehen muss. Noch mehr Tipps und Automatisierungstricks findest du im .

Viel Erfolg beim Crawlen – auf dass deine Daten immer sauber, schnell und ein bisschen smarter sind.

FAQs

1. Warum sollte ich für einen Web-Scraper Rust statt Python oder Node.js nutzen?

Rust bietet deutlich mehr Performance, Speichersicherheit und Unterstützung für Parallelität. Python und Node.js sind zwar für schnelle Skripte praktisch, aber Rust ist ideal für große, langlebige oder kritische Web-Scraper, bei denen Geschwindigkeit und Zuverlässigkeit zählen ().

2. Welche Bibliotheken brauche ich für einen Rust Web-Scraper?

Du brauchst reqwest für HTTP-Anfragen, scraper fürs HTML-Parsing, tokio für asynchrone Parallelität und csv für den Export. Das url-Crate hilft beim Normalisieren von URLs.

3. Wie gehe ich mit JavaScript-lastigen oder geschützten Seiten in Rust um?

Bei JS-lastigen Seiten suche nach API-Calls oder nutze einen Headless-Browser wie fantoccini. Für geschützte Seiten kannst du Cookies mit reqwest verwalten oder Thunderbits KI-Autofill für Logins nutzen.

4. Was bringt die Kombination aus Thunderbit und Rust?

Thunderbit beschleunigt die Datenerfassung mit KI und No-Code – ideal für Prototypen, dynamische Seiten oder wenn Nicht-Entwickler Daten brauchen. Rust ist optimal für maßgeschneiderte, performante Web-Scraper. Zusammen bist du schnell und skalierbar unterwegs.

5. Wie vermeide ich Blockierungen beim Crawlen?

Beachte robots.txt, nutze realistische Header, reguliere deine Anfragen und setze ggf. Proxies ein. Immer ethisch scrapen und die Nutzungsbedingungen sowie Datenschutzgesetze einhalten ().

Du willst Thunderbit live erleben? und starte noch heute mit smarterem Scraping. Für weitere Deep Dives zu Web-Automatisierung schau im vorbei.

Mehr erfahren