Das Internet ist wie ein riesiger Daten-Schatz, in dem man sich schnell verlieren kann. Immer mehr Unternehmen treffen ihre Entscheidungen auf Basis von Infos, die sie direkt aus dem Netz ziehen – und dieser Trend wird immer stärker. Wusstest du, dass mittlerweile Web Data Extraction nutzen, um ihre Konkurrenz im Auge zu behalten? Web-Scraping hat die Flexibilität von Unternehmen total verändert: Was früher Tage oder Wochen gedauert hat, geht heute oft in wenigen Stunden. Aber je mehr über das Thema gesprochen wird, desto mehr Fragen tauchen auf: Was ist eigentlich „Data Scraping“? Wie unterscheidet es sich von „Web Data Extraction“? Und warum ist das für dein Unternehmen wichtig?

Ich entwickle seit Jahren Automatisierungstools (und habe dabei mehr Webseiten gescraped, als ich zugeben mag) und weiß aus eigener Erfahrung, wie sehr diese Methoden Bereiche wie Vertrieb oder Marktforschung aufmischen können. Lass uns gemeinsam klären, was Data Scraping und Web Data Extraction wirklich bedeuten, warum sie so wichtig sind und wie Tools wie den Einstieg super einfach machen – auch wenn du keine einzige Zeile Code schreiben willst.

Data Scraping vs. Web Data Extraction: Was steckt dahinter?

Starten wir mit den Basics. Data Scraping und Web Data Extraction werden oft gleichgesetzt, aber es gibt feine Unterschiede – perfekt, um beim nächsten Meeting mit Wissen zu glänzen.

Data Scraping meint das automatische Sammeln von Infos aus allen möglichen digitalen Quellen – egal ob Webseiten, PDFs, Bilder oder Datenbanken. Stell dir vor, ein Roboter übernimmt für dich das Kopieren und Einfügen – nur viel schneller und ohne Fehler.

Web Data Extraction ist eine spezielle Form von Data Scraping, bei der gezielt Infos von Webseiten gezogen werden. Es ist, als hättest du einen digitalen Assistenten, der das Internet nach genau den Daten durchforstet, die du brauchst (zum Beispiel Produktpreise oder Kontaktdaten) und sie ordentlich in eine Tabelle packt.

Ein Vergleich, den ich mag: Stell dir vor, du bist in einer Bibliothek. Data Scraping ist, als würdest du jemanden bitten, Infos aus allen Büchern, Zeitschriften oder sogar Notizzetteln zu kopieren. Web Data Extraction beschränkt sich auf die „Internet-Abteilung“ der Bibliothek.

Beide Methoden helfen dir, aus unübersichtlichen, chaotischen Infos nutzbare, strukturierte Daten zu machen – zum Beispiel als übersichtliche Tabelle in Excel oder Google Sheets. Für Unternehmen, die faktenbasiert entscheiden wollen, sind beide Ansätze Gold wert.

Für die Technik-Fans: beschreibt Web-Scraping als „den Einsatz von Bots, um Inhalte und Daten von Webseiten zu extrahieren“. sieht Data Scraping als Überbegriff für alles von Forschung bis KI-Training.

Warum Data Scraping & Web Data Extraction für Unternehmen heute Pflicht sind

Klar ist: Die Gewinner von morgen sind die, die Webdaten in echte Erkenntnisse verwandeln. Egal ob Vertrieb, Marketing, E-Commerce oder Operations – wer auf aktuelle, präzise Daten zugreifen kann, ist klar im Vorteil.

Deshalb sind diese Methoden so wertvoll:

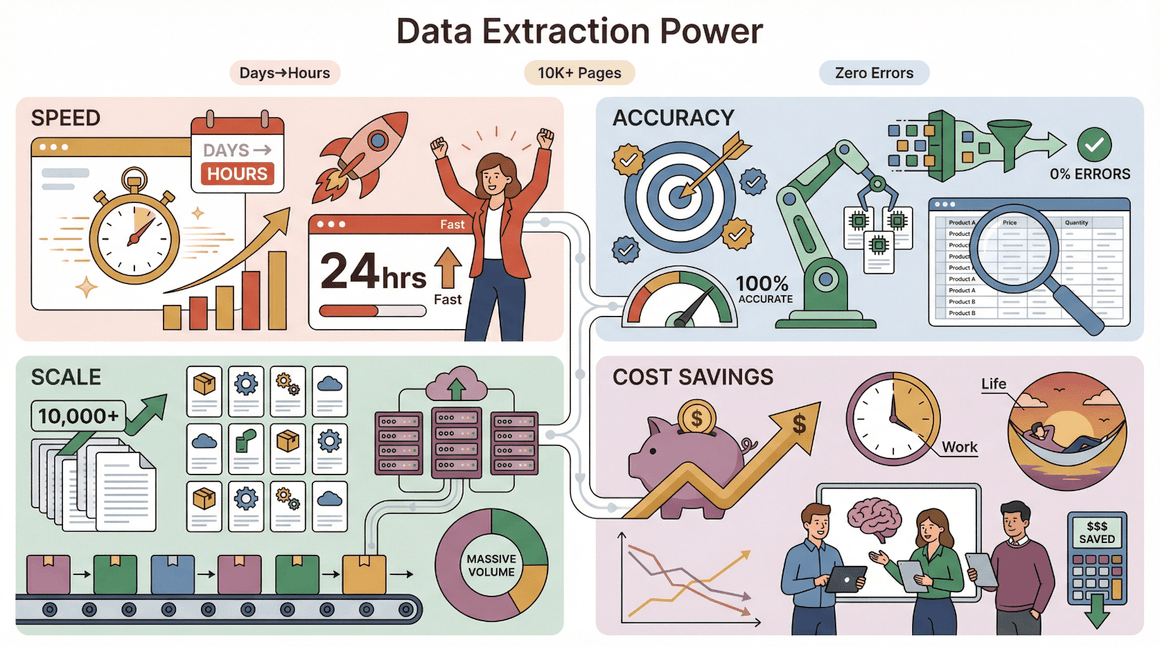

- Geschwindigkeit: Automatisierte Datenerfassung verkürzt die Zeit für Marktanalysen von Tagen auf Stunden ().

- Genauigkeit: Maschinen werden nicht müde oder unaufmerksam – das senkt Fehler im Vergleich zur Handarbeit.

- Skalierbarkeit: Du brauchst Daten von 10.000 Produktseiten? Kein Problem – Scraping-Tools schaffen das locker.

- Kosteneffizienz: Automatisierung spart Routinearbeit, sodass Teams sich auf die wichtigen Aufgaben konzentrieren können (und vielleicht sogar pünktlich Feierabend machen).

Hier siehst du typische Anwendungsfälle und wie sich der Aufwand durch automatisiertes Data Scraping verändert:

| Anwendungsfall | Manueller Aufwand | Vorteil durch automatisiertes Data Scraping |

|---|---|---|

| Lead-Generierung | Stundenlange Recherche | 1-Klick-Export von 1.000+ Leads |

| Preisüberwachung | Tägliche Kontrollen | Echtzeit-Benachrichtigungen bei Preisänderungen |

| Content-Aggregation | Artikel kopieren | Nachrichten in Minuten bündeln |

| Wettbewerbsanalyse | Aufwendiges Tracking | Sofortige Wettbewerberdaten-Feeds |

| Marktforschung | Umfragemüdigkeit | Aktuelle Trendanalysen |

Kein Wunder, dass täglich Wettbewerbsdaten scrapen, um vorne zu bleiben.

Typische Anwendungsfälle: So nutzen Unternehmen Data Scraping

Schauen wir uns an, wie Data Scraping und Web Data Extraction im Alltag eingesetzt werden:

Marktforschung & Wettbewerbsanalyse

Unternehmen nutzen Web Data Extraction, um die Konkurrenz zu beobachten, neue Produkte zu entdecken und Trends früh zu erkennen. Ein SaaS-Anbieter könnte zum Beispiel die Preis- und Feature-Seiten der Mitbewerber scrapen, um die eigene Strategie zu verbessern. Laut setzen große Marken gezielt auf automatisiertes Scraping, um keine Marktbewegung zu verpassen.

Preisüberwachung & dynamische Preisgestaltung

E-Commerce- und Einzelhandelsteams scrapen Preise, Lagerbestände und Aktionen der Konkurrenz. Das ist nicht nur „Spionage“, sondern hilft, die eigenen Margen zu optimieren und schnell auf Marktveränderungen zu reagieren. Eine zeigt, wie automatisierte Preisüberwachung Margen verbessert und Echtzeitreaktionen ermöglicht.

Content-Aggregation & News-Monitoring

Marketing- und Content-Teams nutzen Web Data Extraction, um News, Bewertungen und Social-Media-Stimmungen in einem Dashboard zu bündeln. So erkennen sie PR-Chancen, verfolgen Marken-Erwähnungen und bleiben über Branchengespräche informiert – ohne stundenlang Feeds zu durchforsten ().

Lead-Generierung & Kontaktsuche

Vertriebsteams extrahieren Kontaktdaten aus Verzeichnissen, LinkedIn oder branchenspezifischen Seiten, um gezielte Akquise-Listen zu erstellen. Eine zeigt: Durch Scraping öffentlicher Seiten konnten in nur drei Monaten 88 qualifizierte Leads generiert werden – viel schneller als per Hand.

Die Nachteile manueller Datenerfassung

Ganz ehrlich: Manuelle Datensammlung ist ungefähr so spannend wie Farbe beim Trocknen zuzusehen – und genauso ineffizient. Warum das heute nicht mehr zeitgemäß ist:

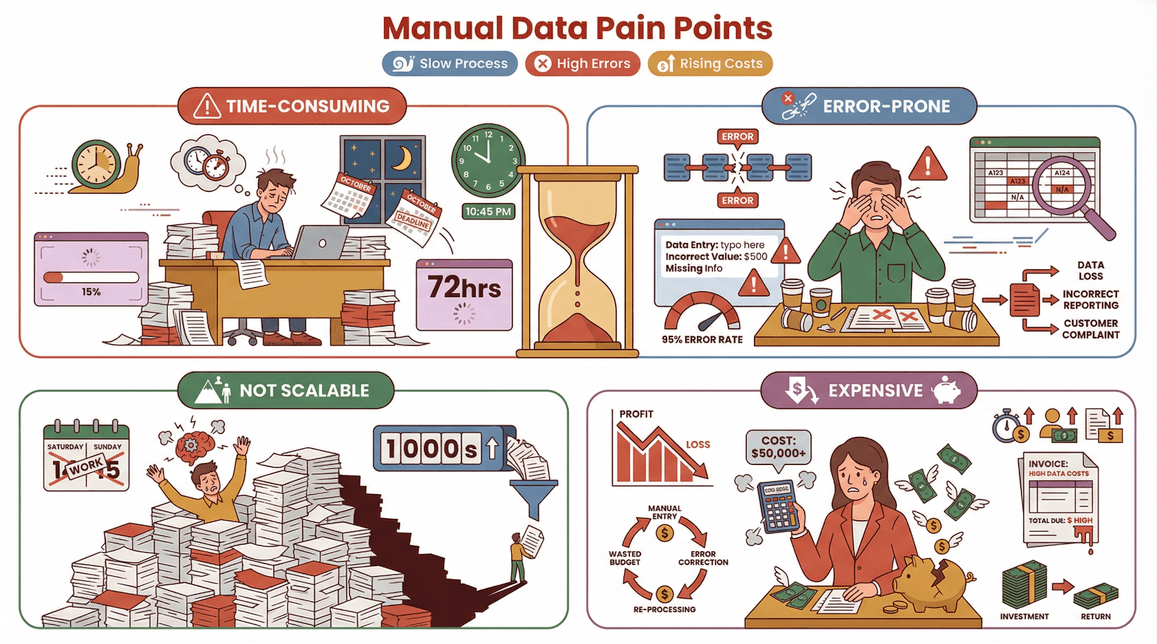

- Zeitaufwändig: Händisches Kopieren dauert – besonders bei großen Datenmengen.

- Fehleranfällig: Müdigkeit und Ablenkung führen zu Fehlern, die teuer werden können.

- Nicht skalierbar: Wer Tausende Seiten manuell auswerten will, verliert schnell die Nerven (und das Wochenende).

- Teuer: Personalkosten summieren sich, und fehlerhafte Daten müssen oft nachbearbeitet werden ().

Hier der direkte Vergleich:

| Methode | Geschwindigkeit | Genauigkeit | Kosten | Skalierbarkeit |

|---|---|---|---|---|

| Manuelle Erfassung | Langsam (Tage/Wochen) | Fehleranfällig | Hoch (Personal) | Gering |

| Automatisiertes Scraping | Schnell (Minuten/Stunden) | Über 95 % Genauigkeit (Retica) | Niedrig (Software) | Hoch |

Kein Wunder, dass immer mehr Unternehmen auf automatisierte Lösungen setzen.

Wie funktioniert Data Scraping? Vom Abruf zur strukturierten Tabelle

Wie läuft das Ganze eigentlich ab? Hier ein Überblick über den typischen Data-Scraping-Prozess – ganz ohne Informatikstudium:

- Abruf: Das Tool besucht die gewünschte Website oder Datenquelle.

- Extraktion: Es erkennt und sammelt die relevanten Infos (z. B. Produktnamen, Preise oder E-Mails).

- Aufbereitung & Strukturierung: Die Rohdaten werden bereinigt, formatiert und in eine Tabelle oder Datenbank überführt.

- Export: Das fertige Datenset wird in dein bevorzugtes Tool exportiert – etwa Excel, Google Sheets, Airtable, Notion oder wohin du willst.

Im Grunde ist es ein cleveres „Kopieren und Einfügen“ – nur viel leistungsfähiger.

Für die Technik-Interessierten: beschreibt moderne Data-Scraping-Systeme als Zusammenspiel von Datensammlern, Prozessoren und Speichern, die gemeinsam nutzbare Infos liefern.

Thunderbit: Web Data Extraction für alle – einfach und schnell

Jetzt wird’s spannend. Bei Thunderbit haben wir uns vorgenommen, Web Data Extraction so einfach zu machen, dass wirklich jeder – selbst der technisch unerfahrenste Kollege – damit arbeiten kann. Kein Code, keine komplizierten Vorlagen, keine Kopfschmerzen.

ist eine , mit der du Daten von jeder Website mit wenigen Klicks extrahieren kannst. Das macht Thunderbit besonders:

- KI-Feldvorschläge: Einfach auf „KI-Felder vorschlagen“ klicken – Thunderbit analysiert die Seite, schlägt passende Spalten (wie „Name“, „Preis“ oder „E-Mail“) vor und erstellt sogar die Extraktionsanweisungen automatisch.

- Subpage-Scraping: Du brauchst mehr Details? Thunderbit kann automatisch jede Unterseite (z. B. Produktdetails oder LinkedIn-Profile) besuchen und deine Tabelle anreichern – ganz ohne Zusatzaufwand.

- Sofort-Vorlagen: Für bekannte Seiten wie Amazon, Zillow oder Shopify gibt es 1-Klick-Vorlagen – du musst nichts einstellen.

- Kostenloser Datenexport: Exportiere deine Ergebnisse gratis nach Excel, Google Sheets, Airtable oder Notion.

- Geplanter Scraper: Richte wiederkehrende Jobs ein, um deine Daten immer aktuell zu halten – egal ob Preisüberwachung oder Lead-Tracking.

- Funktioniert auch mit PDFs & Bildern: Thunderbit kann dank KI-gestützter Texterkennung sogar Daten aus PDFs und Bildern extrahieren.

Das Beste: Du musst kein Entwickler sein. Thunderbit richtet sich an Vertriebs-, E-Commerce-, Marketing- und Operationsteams, die einfach schnell Ergebnisse wollen.

Mehr dazu findest du in unserem .

Thunderbits KI-Features für Nicht-Techniker

So einfach macht Thunderbit Web Data Extraction:

- KI-Feldvorschläge: Erweiterung öffnen, „KI-Felder vorschlagen“ klicken – Thunderbit liest die Seite und schlägt die besten Spalten vor. Du kannst diese anpassen oder weitere hinzufügen.

- Subpage-Scraping: Du hast eine Produktliste gescraped? Mit „Unterseiten scrapen“ besucht Thunderbit jede Produktseite und sammelt automatisch Spezifikationen, Bewertungen oder Bilder.

- Sofort-Vorlagen: Für Seiten wie Amazon oder Shopify einfach die Vorlage auswählen und Daten sofort exportieren.

- Kostenloser Datenexport: Nach dem Scraping kannst du deine Daten ohne Einschränkungen in dein Wunsch-Tool exportieren.

Thunderbit wird bereits von über 30.000 Nutzern weltweit eingesetzt – und das ist erst der Anfang.

Rechtliche Aspekte: Worauf du beim Data Scraping achten solltest

Jetzt zum wichtigen Punkt: Ist Data Scraping eigentlich legal? Die Antwort: Es kommt darauf an.

- Öffentlich zugängliche Daten: Das Scrapen öffentlich einsehbarer Daten (z. B. Produktlisten oder Branchenverzeichnisse) ist in der Regel erlaubt. Schau aber immer in die Nutzungsbedingungen und die robots.txt der Website ().

- Private oder geschützte Daten: Das Scrapen hinter Logins, Bezahlschranken oder für den Weiterverkauf kann rechtliche Probleme machen ().

- Datenschutzgesetze: Beim Sammeln personenbezogener Daten sind Gesetze wie DSGVO oder CCPA unbedingt zu beachten.

Best Practices für rechtssicheres Scraping:

- Respektiere robots.txt und die Nutzungsbedingungen.

- Scrape keine sensiblen oder privaten Daten.

- Begrenze die Abrufrate, um Server nicht zu überlasten.

- Nutze gescrapete Daten verantwortungsvoll – besonders bei personenbezogenen Infos.

Eine ausführliche Übersicht findest du im .

Fazit: So profitierst du von Data Scraping & Web Data Extraction

- Data Scraping und Web Data Extraction sind unverzichtbare Tools für moderne Unternehmen – sie ermöglichen eine schnellere, präzisere und skalierbare Datenerfassung.

- Manuelle Datenerfassung ist langsam, fehleranfällig und teuer. Mit Tools wie Thunderbit kannst du Webdaten einfach extrahieren, bereinigen und exportieren – ganz ohne Programmierkenntnisse.

- Thunderbit überzeugt durch KI-gestützte Bedienung, Subpage-Scraping, Sofort-Vorlagen und kostenlosen Datenexport – so wird Web Data Extraction für alle zugänglich.

- Rechtliche Aspekte beachten: Halte dich immer an die Regeln der Website und an Datenschutzgesetze.

Bereit, Webdaten für dein Unternehmen zu nutzen? und erlebe, wie einfach es ist, das Internet in deine persönliche Datenquelle zu verwandeln. Mehr Tipps und Anleitungen findest du im .

Häufige Fragen (FAQ)

1. Was ist der Unterschied zwischen Data Scraping und Web Data Extraction?

Data Scraping ist der Oberbegriff für das automatische Sammeln von Infos aus allen digitalen Quellen. Web Data Extraction bezieht sich speziell auf das Extrahieren von Daten aus Webseiten. Beide Methoden machen aus unstrukturierten Daten nutzbare Datensätze.

2. Ist Data Scraping legal?

Das Scrapen öffentlich zugänglicher Daten ist meist erlaubt, aber du solltest immer die Nutzungsbedingungen der Website prüfen und Datenschutzgesetze einhalten. Private oder geschützte Inhalte solltest du nicht ohne Erlaubnis scrapen.

3. Was sind die wichtigsten Vorteile von Web Data Extraction für Unternehmen?

Web Data Extraction ermöglicht eine schnellere, präzisere und skalierbare Datenerfassung – zum Beispiel für Lead-Generierung, Preisüberwachung, Marktforschung oder Content-Aggregation.

4. Wie erleichtert Thunderbit das Data Scraping?

Thunderbit nutzt KI, um Felder vorzuschlagen, Subpage-Scraping zu automatisieren und Sofort-Vorlagen für bekannte Seiten bereitzustellen. Es ist für Nicht-Techniker gemacht und bietet kostenlosen Datenexport nach Excel, Google Sheets und mehr.

5. Was muss ich beachten, um beim Scraping rechtlich auf der sicheren Seite zu sein?

Respektiere robots.txt, Nutzungsbedingungen und Datenschutzgesetze. Scrape keine sensiblen oder privaten Daten und gehe mit gescrapten Infos verantwortungsvoll um.

Du willst mehr wissen? Lies oder stöbere im für weitere Einblicke.

Mehr erfahren