Hast du dich schon mal gefragt, wie Google scheinbar jede Ecke des Internets kennt – sogar diesen uralten Blogpost, den du 2012 mal eben hochgeladen hast? Damit bist du definitiv nicht allein. Hinter diesem „Wunder“ steckt keine Magie und auch kein Team überarbeiteter Praktikanten, die Tag und Nacht das Web durchkämmen. Es sind sogenannte Crawler: digitale Spürnasen, die unermüdlich Webseiten erfassen, katalogisieren und indexieren. Nach Jahren in der Entwicklung von Automatisierungs- und KI-Tools (und ja, dabei ist auch mal die eine oder andere Seite zerschossen worden) weiß ich, wie sehr diese Bots bestimmen, was wir online überhaupt finden. Wer eine Website betreibt, sollte Crawler nicht als bloßes Technikdetail abtun – sie entscheiden, ob du sichtbar bist oder im Netz einfach untergehst.

Lass uns gemeinsam hinter die Kulissen schauen: Was sind Crawler eigentlich, wie „sehen“ sie deine Seite, warum sind sie das Rückgrat von SEO und wie sorgst du dafür, dass deine Inhalte nicht im digitalen Nirwana verschwinden? Und weil ich ein Fan von smarter Automatisierung bin, zeige ich dir, wie KI-gestützte Tools wie das Spiel für Website-Betreiber und datengetriebene Teams komplett verändern.

Crawler-Grundlagen: Was machen sie und wie funktionieren sie?

Stell dir einen Crawler wie einen digitalen Bibliothekar vor – oder wie eine Spinne mit perfektem Ordnungssinn –, der das Web Link für Link abklappert. Technisch gesehen ist ein Crawler (auch Spider oder Bot genannt) ein Software-Agent, der systematisch Webseiten besucht, Inhalte abruft, Links folgt und Infos sammelt. So bauen Suchmaschinen wie Google, Bing und Co. ihre riesigen Indizes auf.

So läuft das Ganze ab:

- Start mit einer Liste bekannter URLs (zum Beispiel deine Startseite oder ein paar „Seed“-Seiten).

- Abrufen des HTML-Inhalts jeder Seite.

- Extrahieren von Hyperlinks und Hinzufügen zur Besuchsliste.

- Wiederholen, indem von Link zu Link gesprungen, neue Seiten katalogisiert und der Suchmaschinenindex aktualisiert wird.

Stell dir vor, ein Bibliothekar sprintet durch endlose Regalreihen und notiert jeden Buchtitel samt Querverweisen – nur eben im Tempo und Umfang des Internets. Ohne Crawler wäre der Großteil des Webs für Suchmaschinen und damit für Nutzer unsichtbar.

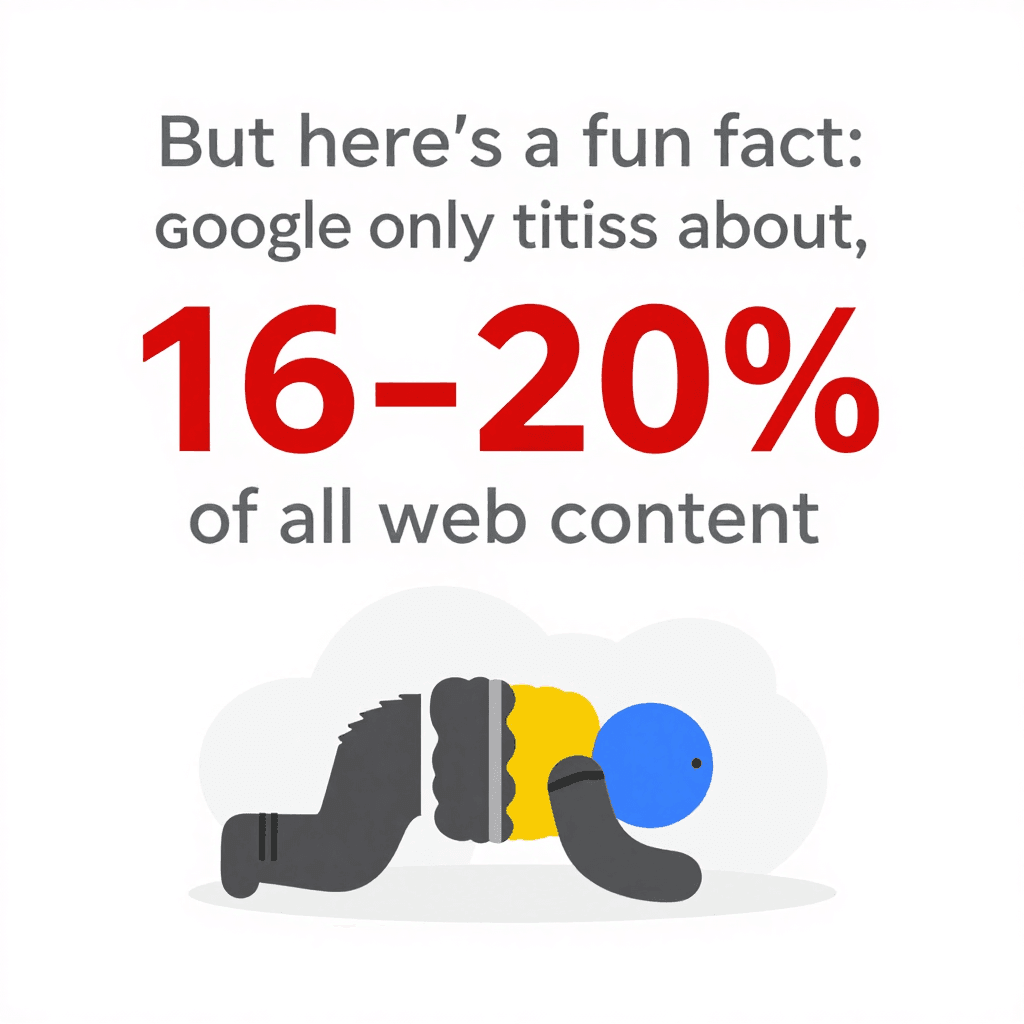

Fun Fact: Trotz aller Technik indexiert Google nur etwa . Der Rest liegt im „Deep Web“ und bleibt für die meisten Bots unsichtbar. Wie du deine Seite aufbaust und wie crawlerfreundlich sie ist, macht also einen riesigen Unterschied.

Fun Fact: Trotz aller Technik indexiert Google nur etwa . Der Rest liegt im „Deep Web“ und bleibt für die meisten Bots unsichtbar. Wie du deine Seite aufbaust und wie crawlerfreundlich sie ist, macht also einen riesigen Unterschied.

Wie Crawler Webseiten sehen und verstehen

Crawler nehmen deine Website ganz anders wahr als Menschen. Sie interessieren sich nicht für schicke Schriftarten, coole Bilder oder fancy Effekte. Stattdessen laden sie das rohe HTML, scannen den Text, lesen die Tags und folgen den Links. Es ist, als würde man den Bauplan eines Gebäudes studieren, statt durch die Räume zu schlendern.

Das ist Crawlern besonders wichtig:

- HTML-Struktur: Sie achten auf Überschriften, Absätze, Listen und Links.

- Interne Verlinkung: Diese Verbindungen führen Crawler zu allen Bereichen deiner Seite. Ist eine Seite nicht verlinkt, bleibt sie für Crawler praktisch unsichtbar.

- Navigation und Sitemaps: Gut strukturierte Menüs und aktuelle Sitemaps sind wie ein GPS, das Crawlern hilft, die wichtigsten Inhalte zu finden.

- Metadaten und strukturierte Daten: Tags wie

<title>,<meta description>und Schema.org-Markup helfen Crawlern, den Inhalt einer Seite zu verstehen – auch wenn das aus dem Fließtext nicht sofort ersichtlich ist.

Wenn du es technisch magst: Deine Website ist wie eine Stadt, Crawler sind die Lieferdienste, und interne Links sowie Sitemaps sind die Straßenschilder und Stadtpläne, die sie zu jedem Ziel führen.

Die Rolle von Sitemaps und robots.txt für das Crawler-Verhalten

Zwei Dateien sind entscheidend dafür, wie Crawler mit deiner Seite umgehen:

-

XML-Sitemap: Eine maschinenlesbare Liste deiner wichtigsten Seiten. Sie ist wie ein Inhaltsverzeichnis für den Bibliothekar. Eine gute Sitemap sorgt dafür, dass Crawler keine wichtigen Inhalte übersehen – selbst wenn die interne Verlinkung nicht perfekt ist. Gerade bei großen oder komplexen Seiten kann eine umfassende Sitemap .

-

robots.txt: Eine simple Textdatei im Root-Verzeichnis deiner Seite, die Crawlern sagt, wo sie hin dürfen – und wo nicht. Willst du Bots aus dem Admin-Bereich fernhalten oder doppelte Seiten blockieren? Hier ist der richtige Ort. Aber Vorsicht: Ein kleiner Fehler (wie

Disallow: /) kann versehentlich die gesamte Seite für Suchmaschinen sperren – ein klassischer SEO-Fauxpas. Nutze robots.txt, um .

Tipp: Verweise in der robots.txt immer auf deine Sitemap. Das ist wie ein „Start hier!“-Schild für Crawler.

Warum Crawler für deine Website wichtig sind: SEO und Besucher

Klartext: Wenn ein Crawler eine Seite nicht erreicht, ist sie praktisch unsichtbar. Kein Crawl = kein Index = kein Suchmaschinen-Traffic. All die Mühe für Content, Design und Marke? Umsonst, wenn Googlebot sie nicht findet.

Warum ist das so wichtig? Weil und . Ist deine Seite nicht crawlerfreundlich, verpasst du die größte Besucherquelle überhaupt.

Eine gut gecrawlte Seite bedeutet:

Eine gut gecrawlte Seite bedeutet:

- Mehr indexierte Seiten: Mehr Chancen, in den Suchergebnissen aufzutauchen.

- Bessere Rankings: Suchmaschinen können die Relevanz deiner Inhalte besser bewerten.

- Schnellere Updates: Neue Inhalte werden zügig indexiert und gerankt.

- Bessere Nutzererfahrung: Nutzer finden schneller, was sie suchen – das stärkt Vertrauen und Traffic.

Es gibt viele Beispiele von Websites, die durch das Beheben von Crawl-Problemen – etwa kaputte Links oder versehentliche noindex-Tags – enorme Traffic-Sprünge erlebt haben. Oft sind es die „versteckten“ Seiten, die das Potenzial haben.

Wie Crawler das Ranking beeinflussen

Suchmaschinen nutzen Crawler-Daten, um zu bestimmen, welche Seiten zu einer Suchanfrage am besten passen. Sie achten auf:

- Inhaltsqualität und Keywords

- Interne und externe Links

- Aktualität und Änderungsfrequenz

- Mobilfreundlichkeit (Google setzt auf Mobile-First-Indexierung)

Bei großen Seiten gibt es zudem das Konzept des Crawl-Budgets – also wie viele Seiten eine Suchmaschine in einem bestimmten Zeitraum besucht. Hat deine Seite 100.000 Seiten, aber Googlebot crawlt nur 5.000 pro Tag, dauert es Wochen, bis alles indexiert ist. Deshalb ist eine (bei der die meisten Seiten nur wenige Klicks von der Startseite entfernt sind) so effektiv: Sie hilft Crawlern, Inhalte schneller zu finden und erneut zu besuchen.

Die Grenzen klassischer Crawler: Herausforderungen moderner Websites

Hier wird’s spannend. Das moderne Web ist voll von JavaScript, dynamischen Inhalten und Login-Schranken. Klassische Crawler – vor allem einfache Varianten – stoßen da schnell an ihre Grenzen.

Typische Probleme:

- Dynamische Inhalte und JavaScript: Viele Crawler sehen nur das initiale HTML. Lädt dein Content erst per JavaScript (z. B. durch „Mehr laden“-Buttons), sieht ein einfacher Bot… nichts. Selbst Googles Crawler, der JavaScript ausführen kann, indexiert JS-lastige Seiten oft nur teilweise – vor allem, wenn Inhalte langsam oder erst nach Interaktion erscheinen ().

- Inhalte hinter Logins: Ist eine Seite nur nach Login erreichbar, bleiben die meisten Crawler draußen. Das ist meist gewollt, aber manchmal landen auch wichtige öffentliche Inhalte versehentlich hinter einer Login-Schranke.

- Fehlerhafte robots.txt oder Meta-Tags: Ein kleiner Fehler kann ganze Bereiche für Crawler sperren.

- Anti-Bot-Maßnahmen: CAPTCHAs, starke Zugriffsbeschränkungen oder das Blockieren unbekannter User Agents können Crawler komplett aussperren.

Da , mussten Crawler deutlich intelligenter werden. Trotzdem gibt es viele Wege, wie Inhalte unsichtbar bleiben können.

Wenn klassische Crawler an ihre Grenzen stoßen: Dynamische Inhalte und JavaScript

Angenommen, du betreibst einen Onlineshop, bei dem Produkte erst beim Scrollen geladen werden. Ein klassischer Crawler sieht dann vielleicht nur die ersten 20 Produkte – der Rest bleibt verborgen. Oder Bewertungen erscheinen erst nach Klick auf einen Tab – für viele Bots unsichtbar.

Das Ergebnis: Wertvolle Inhalte werden nicht indexiert, und du verlierst potenziellen Such-Traffic. Die Lösung: Alternative Pfade anbieten (z. B. Paginierung oder serverseitig gerendertes HTML) und mit Tools wie der URL-Prüfung in der Google Search Console testen, wie Crawler deine Seite sehen.

Smarte Crawler-Tools: Wie Thunderbit komplexe Seiten meistert

Jetzt wird’s richtig interessant – denn genau für diese Herausforderungen haben wir entwickelt. Thunderbit ist kein gewöhnlicher Crawler, sondern ein KI-gestützter Web-Scraper, der Webseiten wie ein Mensch „liest“, strukturierte Daten extrahiert und mit modernen Webdesigns problemlos klarkommt.

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Statt selbst HTML zu durchsuchen oder Code zu schreiben, scannt Thunderbits KI die Seite und schlägt passende Spalten vor – etwa „Produktname“, „Preis“ oder „Kontakt-E-Mail“. Du kannst die Vorschläge anpassen, aber die Hauptarbeit übernimmt die KI.

- Subpage-Scraping: Du brauchst mehr Details? Thunderbit besucht automatisch Unterseiten (z. B. Produktdetails oder Nutzerprofile), sammelt Zusatzinfos und ergänzt sie im Hauptdatensatz. Kein manuelles Klicken oder Kopieren mehr.

- Kompatibel mit JavaScript und Logins: Da Thunderbit als Chrome-Erweiterung (oder im echten Browser in der Cloud) läuft, kann es JavaScript ausführen, auf dynamische Inhalte warten und sogar Seiten scrapen, in die du eingeloggt bist.

- Reagiert auf Layout-Änderungen: Klassische Scraper brechen bei Layout-Änderungen oft ab. Thunderbits KI liest die Seite jedes Mal neu, kleine Anpassungen bringen den Workflow also nicht aus dem Takt.

- Geplantes Scraping: Du willst Preise überwachen oder eine Lead-Liste jeden Morgen aktualisieren? Einfach einen Zeitplan in natürlicher Sprache festlegen („jeden Montag um 9 Uhr“), und Thunderbit erledigt den Rest.

Thunderbit richtet sich an Business-Anwender – Vertrieb, Marketing, E-Commerce, Immobilien –, die Daten brauchen, aber keine Kopfschmerzen. Und ja, der Export zu Google Sheets, Notion oder Airtable ist mit einem Klick erledigt (und kostenlos).

Thunderbits KI-Funktionen für die Crawler-Optimierung

Das eigentliche Highlight von Thunderbit ist die Verarbeitung natürlicher Sprache. Die KI extrahiert nicht nur Rohdaten, sondern versteht den Kontext. Sie erkennt zum Beispiel, ob es sich um eine Telefonnummer, eine E-Mail-Adresse oder einen Produktpreis handelt, und kann Daten direkt beschriften oder sogar übersetzen.

Das Feedback der Nutzer ist super. Ein Anwender schrieb: „Thunderbit ist mein Favorit, um Influencer-Kontaktdaten zu sammeln. Früher habe ich für Datenbanken bezahlt, jetzt baue ich meine eigenen Listen in Minuten.“ Genau solche Workflow-Verbesserungen liebe ich.

Und wer schon mal versucht hat, eine Seite zu scrapen, deren Layout sich ständig ändert (Stichwort E-Commerce), wird Thunderbits „wartungsfreien“ Ansatz schätzen. Die KI passt sich an – du musst keine kaputten Skripte mehr reparieren.

So optimierst du deine Website für Crawler: Struktur, Strategie und smarte Tools

Was kannst du tun, damit sich Crawler auf deiner Website wohlfühlen? Hier ein paar bewährte Tipps:

- Logische Seitenarchitektur: Wichtige Seiten sollten maximal ein paar Klicks von der Startseite entfernt sein. Eine (breite Navigation, geringe Tiefe) verbessert die Crawl-Effizienz und Indexierungsrate.

- Starke interne Verlinkung: Verknüpfe verwandte Seiten mit sinnvollen Links. Prüfe regelmäßig auf kaputte Links und behebe sie.

- Aktuelle XML-Sitemap: Liste alle wichtigen URLs auf und reiche sie bei Google Search Console und Bing Webmaster Tools ein.

- Optimierte robots.txt: Erlaube den Zugriff auf relevante Inhalte, blockiere nur das Nötigste und prüfe regelmäßig auf versehentliche Sperren.

- Schnelle Ladezeiten: Fehlerfreie, schnelle Seiten werden effizienter gecrawlt. Optimiere Bilder, nutze ein CDN und behebe Serverfehler.

- Doppelte Inhalte vermeiden: Setze Canonical-Tags und verschwende kein Crawl-Budget für doppelte oder fast identische Seiten.

- Strukturierte Daten und Metadaten nutzen: Implementiere Schema.org-Markup für Produkte, Artikel, Events usw. und pflege deine Meta-Tags.

- Crawl-Aktivität überwachen: Nutze die Berichte „Indexabdeckung“ und „Crawling-Statistiken“ in der Google Search Console, um Probleme frühzeitig zu erkennen.

- Mit smarten Tools testen: Nutze Thunderbit oder ähnliche Tools, um zu sehen, wie deine Seite für Crawler aussieht und um eigene Datenpipelines reibungslos zu betreiben.

Website-Architektur auf Crawler-Bedürfnisse abstimmen

Eine durchdachte Seitenstruktur hilft nicht nur Bots, sondern auch deinen Nutzern. Regelmäßige Audits (z. B. mit Screaming Frog oder Sitebulb) helfen, Crawl-Probleme, kaputte Links und verwaiste Seiten frühzeitig zu erkennen.

Nicht vergessen: Mobile ist Pflicht! Mit Googles Mobile-First-Indexierung muss deine mobile Seite alle wichtigen Inhalte und Links der Desktop-Version enthalten. Sonst riskierst du, dass wertvolle Seiten nicht indexiert werden ().

Thunderbit vs. klassische Crawler-Tools: Der direkte Vergleich

Hier die wichtigsten Unterschiede:

| Aspekt | Thunderbit (KI-Web-Scraper) | Klassischer Crawler/Scraper |

|---|---|---|

| Benutzerfreundlichkeit | Kein Code nötig, KI schlägt Felder vor, Business-Anwender starten in 2 Klicks. | Technische Einrichtung, oft Programmierkenntnisse oder manuelle Selektoren erforderlich. |

| Anpassungsfähigkeit | KI passt sich Layout-Änderungen an, kaum Wartungsaufwand. | Bricht bei Strukturänderungen, manuelle Anpassungen nötig. |

| Dynamische Inhalte | Unterstützt JavaScript, Logins und interaktive Elemente standardmäßig. | Meist auf statisches HTML beschränkt, Probleme mit JS oder Login-Inhalten. |

| Subpage-Crawling | Integriertes Crawling von Unterseiten und Paginierung, Daten werden automatisch zusammengeführt. | Tiefe und rekursives Crawling müssen manuell eingerichtet werden. |

| Datenstrukturierung | KI liefert gebrauchsfertige Tabellen mit sinnvollen Spalten, unterstützt viele Datentypen (Text, Zahlen, E-Mails, Bilder, PDFs usw.). | Rohdaten, Nutzer muss Struktur selbst definieren, meist nur HTML ohne Zusatzfunktionen. |

| Integration | Export mit einem Klick zu Google Sheets, Notion, Airtable, CSV usw. | Meist manueller Export/Import, wenige direkte Integrationen. |

| Bot-Hindernisse | Nutzt automatisch Proxys, User Agents, Wiederholungen; „Waterfall“-Ansatz für maximale Erfolgsquote. | Nutzer muss IP-Sperren, CAPTCHAs usw. selbst managen – oft aufwendig und teuer. |

| Zielgruppe | Nicht-technische Business-Anwender: Vertrieb, Marketing, Operations, E-Commerce, Immobilien. | Entwickler, IT, Data Engineers. |

| Preisgestaltung | Kreditbasiert, kostenlose Stufe verfügbar, Bezahlung nach Nutzung. | Abonnements, nutzer- oder serverbasiert; oft versteckte Kosten für Proxys oder Wartung. |

Kurz gesagt: Thunderbit bringt fortschrittliches Crawling für alle – nicht nur für Entwickler. Schnell, präzise und flexibel für das sich ständig wandelnde Web.

Fazit: So holst du das Beste aus Crawlern für deine Website heraus

- Crawler sind die Türsteher deiner Webpräsenz. Ist deine Seite nicht crawlerfreundlich, verpasst du Such-Traffic und neue Besucher.

- Struktur und Strategie sind entscheidend. Logische Navigation, interne Links, Sitemaps und robots.txt sind deine besten Helfer.

- Moderne Websites brauchen smarte Crawler. JavaScript, dynamische Inhalte und Logins sind Stolpersteine für klassische Bots – KI-Tools wie meistern diese Herausforderungen.

- Kontinuierliches Monitoring ist Pflicht. Nutze Search Console, Crawl-Audits und smarte Scraping-Tools, um deine Seite sichtbar und gesund zu halten.

- Rüste dein Toolset auf. Egal ob für SEO-Optimierung oder eigene Datenpipelines: Smarte Crawler sparen Zeit, erhöhen die Genauigkeit und unterstützen bessere Geschäftsentscheidungen.

Bereit zu sehen, wie Thunderbit dir beim Crawlen, Indexieren und Extrahieren von Daten selbst auf komplexen Websites hilft? und probiere es aus. Für weitere Tipps zu Web Scraping, SEO und Automatisierung schau im vorbei.

FAQs

1. Was ist ein Crawler und warum ist er für meine Website wichtig?

Ein Crawler ist ein Software-Bot, der Webseiten systematisch durchsucht und für Suchmaschinen indexiert. Ist deine Seite nicht crawlerfreundlich, erscheinen deine Seiten nicht in den Suchergebnissen – Nutzer finden dich schwerer.

2. Wie beeinflussen Sitemaps und robots.txt Crawler?

Sitemaps lotsen Crawler gezielt zu deinen wichtigsten Seiten, während robots.txt ihnen sagt, wo sie hin dürfen und wo nicht. Beide sind essenziell für effizientes Crawling und Indexierung.

3. Welche Probleme haben klassische Crawler mit modernen Websites?

Klassische Crawler tun sich schwer mit JavaScript-lastigen Inhalten, dynamischen Elementen, Login-Pflicht und Anti-Bot-Maßnahmen. Dadurch werden wichtige Inhalte oft gar nicht oder nur teilweise indexiert.

4. Wie geht Thunderbit mit komplexen Websites um?

Thunderbit nutzt KI, um Seiten wie ein Mensch zu „lesen“, JavaScript und Logins zu verarbeiten und strukturierte Daten zu extrahieren – auch von Unterseiten und dynamischen Inhalten. Die KI passt sich Änderungen an und benötigt keinen Code.

5. Was sind Best Practices, damit meine Website crawlerfreundlich ist?

Halte die Seitenstruktur logisch, nutze interne Links, halte Sitemap und robots.txt aktuell, optimiere die Ladezeiten und überwache regelmäßig die Crawl-Aktivität. Teste und verbessere die Crawlability mit smarten Tools wie Thunderbit.

Du willst tiefer einsteigen? Entdecke weitere Anleitungen im oder abonniere unseren für die neuesten Tipps zu Web-Automatisierung und KI-Scraping.

Mehr erfahren