Webdaten sind heutzutage so wertvoll wie Öl – und 2025 sind sie der Motor für alles, von smarteren Vertriebsstrategien bis hin zu punktgenauer Marktforschung. Ich habe es selbst erlebt: Egal ob E-Commerce, Immobilien oder SaaS – überall versuchen Teams, das Chaos unstrukturierter Webseiten in saubere, nutzbare Tabellen zu verwandeln. Und wenn du hier gelandet bist, willst du bestimmt auch von diesem Trend profitieren. Die gute Nachricht: Für web scraping ist Python dein bester Freund – und der Einstieg war noch nie so einfach, selbst wenn du kein Entwickler bist.

In diesem Guide zeige ich dir, wie du mit Python ins web scraping einsteigst – von den ersten einfachen Skripten bis hin zu Frameworks wie Scrapy für größere Projekte. Außerdem schauen wir uns an, wie KI-Tools wie das Extrahieren von Webdaten für Unternehmen revolutionieren und so einfach machen wie nie zuvor. Egal, ob du gerade erst loslegst oder schon Erfahrung hast und dich weiterentwickeln willst: Hier findest du praktische Schritt-für-Schritt-Anleitungen, Codebeispiele und echte Tipps aus dem Alltag, damit du direkt loslegen kannst.

Was ist Web Scraping mit Python? Ein schneller Überblick

Web scraping heißt, dass du automatisiert Infos von Webseiten abziehst – stell dir vor, dein Rechner übernimmt das Copy-Paste für dich, nur viel schneller und in riesigem Umfang. Mit Python schreibst du Skripte, die Webseiten aufrufen, das HTML durchforsten und gezielt die Daten rausziehen, die du brauchst: Produktpreise, Kontaktdaten, Bewertungen und vieles mehr.

Für Unternehmen ist web scraping ein echter Schatz. Vertriebler bauen damit Lead-Listen, E-Commerce-Teams checken die Preise der Konkurrenz und Analysten beobachten Markttrends – alles, indem sie unstrukturierte Webinhalte in auswertbare Daten verwandeln. Python ist dabei besonders beliebt, weil es stark und gleichzeitig super zugänglich ist – perfekt für kleine und große scraping-Projekte ().

Warum Python die erste Wahl fürs Web Scraping ist

Warum setzen so viele beim web scraping auf Python? Drei Gründe: Die Sprache ist einfach, es gibt ein riesiges Angebot an Bibliotheken und die Community ist mega hilfsbereit.

- Klarer Code: Python ist leicht zu schreiben und zu lesen – du musst kein Profi sein, um loszulegen.

- Starke Bibliotheken: Tools wie BeautifulSoup, Scrapy und Requests machen das Scrapen, Parsen und Crawlen zum Kinderspiel.

- Vielseitig: Python eignet sich nicht nur fürs Scraping, sondern auch für Datenanalyse und Automatisierung – du kannst also direkt von Rohdaten zu Insights kommen.

- Große Community: Hängst du mal fest? Auf Stack Overflow findest du fast immer eine Lösung.

So schlägt sich Python im Vergleich zu anderen Sprachen:

| Sprache | Vorteile | Nachteile | Ideal für |

|---|---|---|---|

| Python | Einfache Syntax, viele Bibliotheken, Community | Langsamer als C++/Java bei reiner Geschwindigkeit | Alle Scraping-Projekte, klein bis groß |

| JavaScript | Kann JS-lastige Seiten direkt verarbeiten | HTML-Parsing weniger ausgereift, asynchrone Besonderheiten | Single-Page-Apps, dynamische Seiten |

| R | Gut für Datenanalyse | Weniger Scraping-Frameworks | Kleine, statistikfokussierte Aufgaben |

| Java/C# | Unternehmenslösungen, schnell | Viel Boilerplate, umständlicher | Große, integrierte Systeme |

Python ist schon seit Jahren eine der beliebtesten Sprachen fürs web scraping und hat 2023 sogar SQL als drittmeistgenutzte Sprache weltweit überholt ().

Unverzichtbare Tools & Bibliotheken fürs Web Scraping mit Python

Hier kommt dein Starter-Kit für web scraping mit Python:

- Requests: Die Standardbibliothek für HTTP-Anfragen. Holt Webseiten so easy ab wie im Browser.

- BeautifulSoup: Das Schweizer Taschenmesser zum Parsen von HTML und XML. Damit findest du gezielt die Daten, die du brauchst.

- Scrapy: Ein komplettes Framework für großes, automatisiertes Scraping und Crawling.

- Selenium: Automatisiert den Browser, um auch dynamische, JavaScript-lastige Seiten zu scrapen.

- Weitere:

lxmlfür schnelles Parsen,pandasfür Datenverarbeitung undPlaywrightfür moderne Browser-Automatisierung.

Wann solltest du was nehmen?

- Requests + BeautifulSoup: Perfekt für statische Seiten und kleine Projekte.

- Scrapy: Ideal, wenn du viele Seiten crawlen, Paginierung abbilden und große Datenmengen exportieren willst.

- Selenium/Playwright: Wenn du mit JavaScript interagieren oder Nutzeraktionen nachstellen musst.

Los geht’s: Deine Python-Umgebung fürs Web Scraping einrichten

So richtest du deine Umgebung ein – auch als Python-Anfänger bist du in wenigen Minuten startklar.

-

Python installieren: Lade Python 3.x von runter und achte darauf, dass es im Systempfad liegt.

-

Virtuelle Umgebung anlegen: Damit bleibt dein Projekt sauber und unabhängig.

1python3 -m venv venv 2# Aktivieren: 3# Unter Windows: 4venv\Scripts\activate 5# Unter Mac/Linux: 6source venv/bin/activate -

Bibliotheken installieren:

1pip install requests beautifulsoup4 scrapy selenium -

Projektstruktur: Für kleine Skripte reicht eine

.py-Datei. Bei Scrapy empfiehlt sichscrapy startproject meinprojektfür ein komplettes Grundgerüst. -

Setup testen:

1import requests, bs4, scrapy, selenium 2print("Alle Bibliotheken erfolgreich importiert!") -

User-Agent setzen (empfohlen): Manche Seiten blocken „Python-requests“ direkt. Gib dich als Browser aus:

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

Glückwunsch, du bist bereit fürs web scraping!

HTML parsen mit BeautifulSoup: Dein erster Python Web-Scraper

Lass uns zusammen einen einfachen Scraper bauen. Wir holen uns Zitate und Autoren von – einer Testseite.

Schritt 1: Die Webseitenstruktur checken

- Öffne die Seite in Chrome.

- Rechtsklick auf ein Zitat, dann „Untersuchen“.

- Jedes Zitat steckt in einem

<div class="quote">, der Text in<span class="text">und der Autor in<small class="author">.

Schritt 2: Deinen Scraper schreiben und ausführen

Hier ein simples Skript:

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"Request failed: {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")Typische Stolperfallen:

- Falls ein Element fehlt, prüfe auf

None, bevor du.get_text()nutzt. - Kontrolliere deine Selektoren immer im Browser.

Skalieren: Web Scraping mit Scrapy optimieren

Wenn du nicht nur eine Seite, sondern eine ganze Website samt Unterseiten scrapen willst, ist Scrapy das richtige Tool.

- Architektur: Scrapy arbeitet mit „Spidern“ (Klassen, die das Crawlen und Parsen übernehmen), Pipelines (zur Datenverarbeitung) und asynchronen Requests für Tempo.

- Warum Scrapy? Es ist für große Datenmengen gemacht – tausende Seiten abgrasen, Fehler abfangen und Daten easy als CSV/JSON exportieren.

Wann Scrapy statt BeautifulSoup nutzen?

- Wenn du viele Seiten automatisch abgrasen oder Links folgen willst.

- Wenn du eingebaute Unterstützung für Wiederholungen, Drosselung und Datenpipelines brauchst.

- Wenn du einen Scraper baust, der regelmäßig läuft oder im Team genutzt wird.

Scrapy in Aktion: Beispielprojekt

Hier ein Spider, der alle Zitate von allen Seiten einsammelt:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)Ausführen mit:

1scrapy crawl quotes -O quotes.jsonUnd du bekommst eine JSON-Datei mit allen Daten – ganz ohne manuelle Schleifen.

Wenn dein Scraping-Projekt wächst, ist Scrapy dank seiner Architektur und Geschwindigkeit die beste Wahl für große Datenmengen.

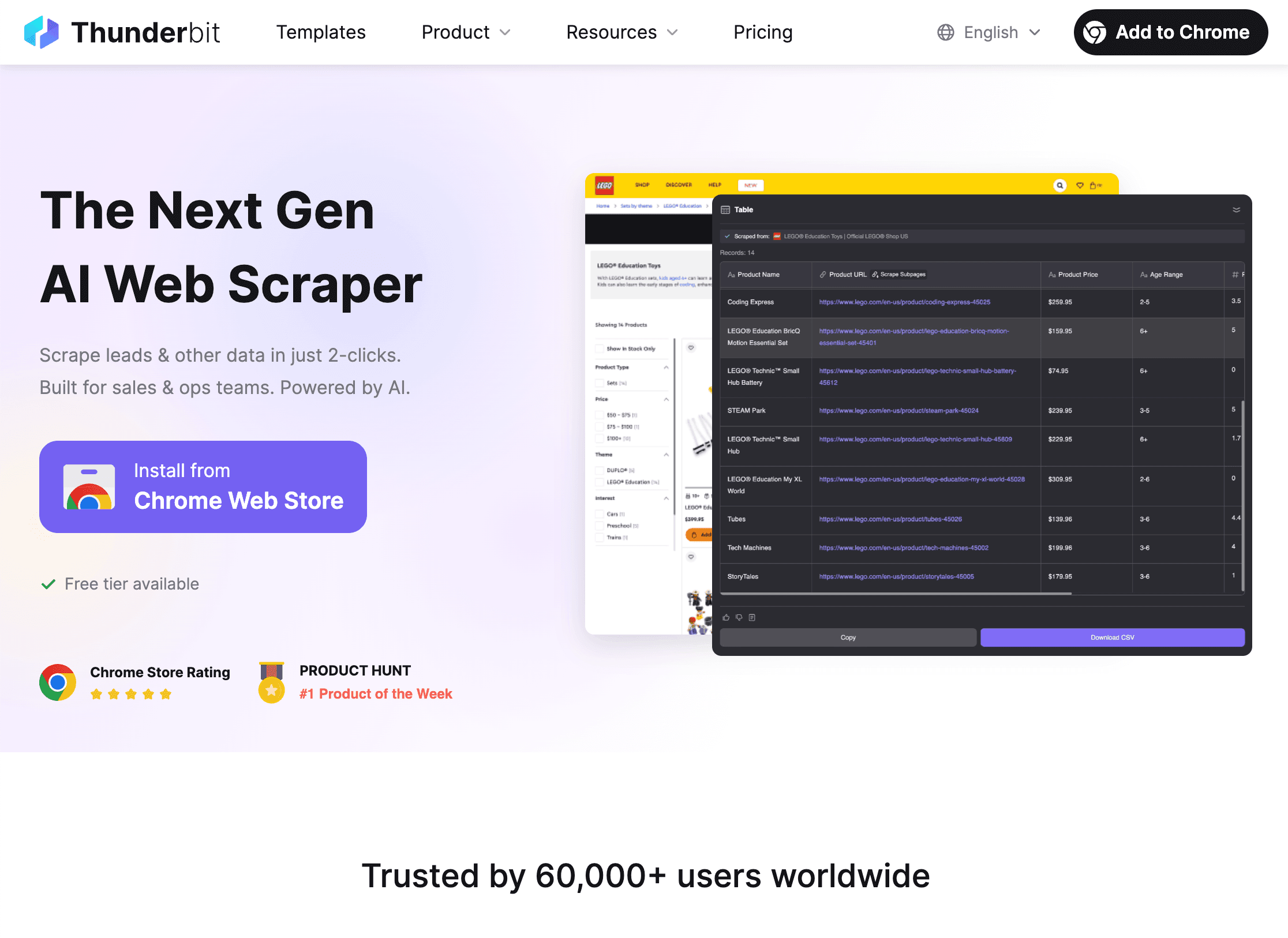

Thunderbit: KI-Tools, die Python Web Scraping auf das nächste Level heben

Hand aufs Herz: Auch mit Python kann Scraping knifflig werden – vor allem bei dynamischen Seiten, Unterseiten oder sich ständig ändernden Layouts. Genau hier kommt ins Spiel.

Thunderbit ist eine KI-gestützte Chrome-Erweiterung, mit der du Webseiten in nur zwei Klicks scrapen kannst:

- KI schlägt Felder vor: Die KI analysiert die Seite und schlägt passende Spalten vor (z. B. „Produktname“, „Preis“ usw.).

- Scrapen: Ein weiterer Klick, und Thunderbit sammelt alle Daten – inklusive Paginierung, Unterseiten und sogar unendlichem Scrollen.

Darum feiere ich Thunderbit:

- Kein Code nötig: Perfekt für Business-User und Analysten.

- Komplexe Seiten? Kein Problem: Dynamische Inhalte, Unterseiten oder Layoutänderungen? Die KI passt sich an.

- Sofortiger Export: Exportiere direkt nach Excel, Google Sheets, Airtable oder Notion.

- Unterseiten-Scraping: Du brauchst Details zu jedem Produkt oder Profil? Thunderbit besucht automatisch jede Unterseite und ergänzt deine Tabelle.

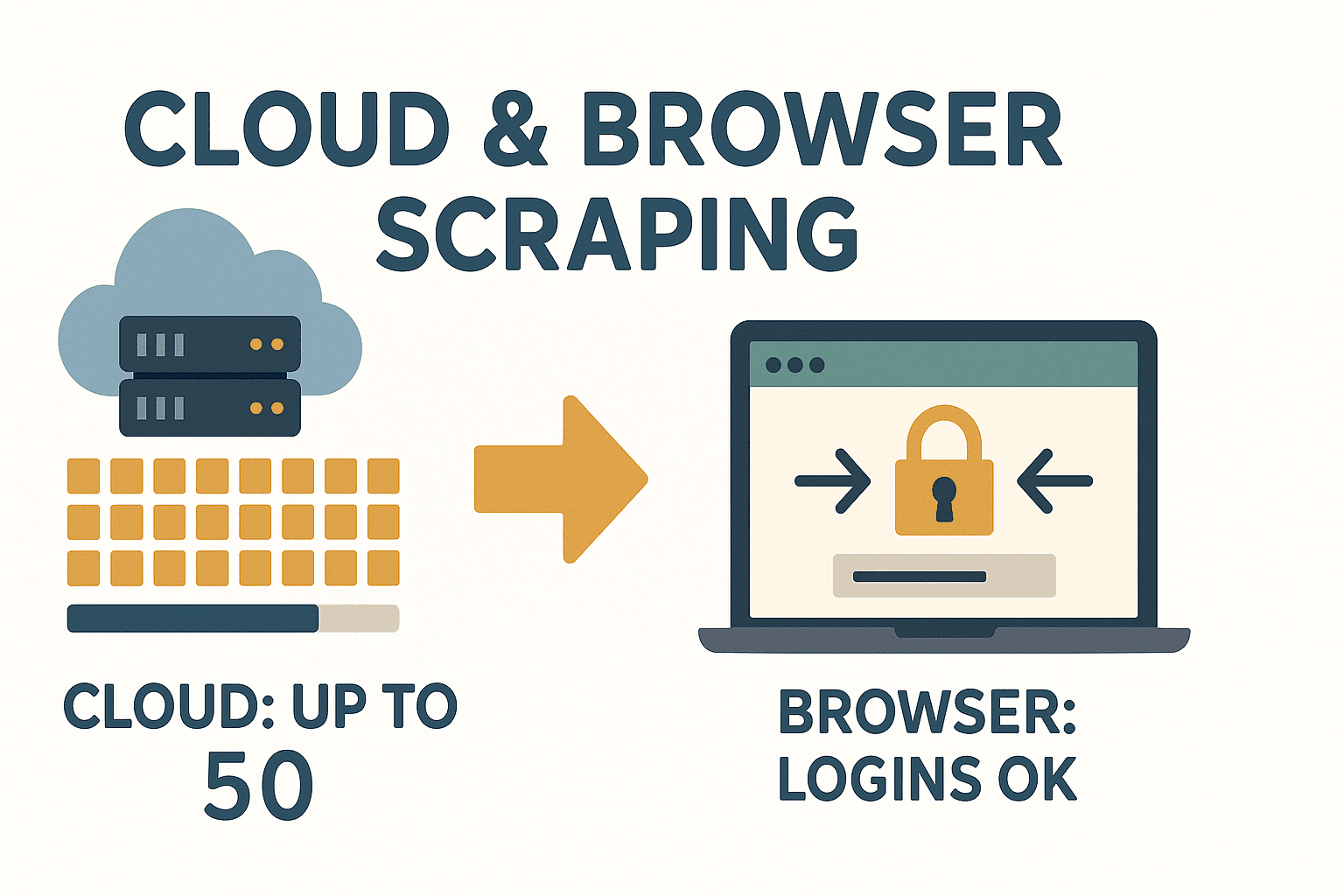

- Cloud- oder Browser-Modus: Bis zu 50 Seiten gleichzeitig in der Cloud scrapen oder den Browsermodus für Login-Seiten nutzen.

Thunderbit ist ein echter Gamechanger für alle, die schnell an Daten kommen wollen, ohne sich ständig mit Code und Anpassungen herumzuschlagen.

Thunderbit ist ein echter Gamechanger für alle, die schnell an Daten kommen wollen, ohne sich ständig mit Code und Anpassungen herumzuschlagen.

Wann KI-Tools wie Thunderbit nutzen?

- Du brauchst Daten sofort und willst nicht auf IT warten oder selbst programmieren.

- Die Seite ist komplex, dynamisch oder ändert sich häufig.

- Du möchtest auch Nicht-Technikern im Team das Sammeln von Daten ermöglichen.

- Du willst Daten in einem Schritt scrapen und anreichern (übersetzen, kategorisieren usw.).

Thunderbit ergänzt Python-Workflows perfekt – ideal für schnelles Prototyping, schwierige Seiten oder wenn du Wartungsaufwand vermeiden willst. Mehr dazu im .

Dynamische Inhalte und Paginierung beim Web Scraping mit Python meistern

Viele moderne Webseiten setzen voll auf JavaScript – das macht Scraping oft kniffliger. So gehst du damit um:

- Dynamische Inhalte: Wenn Daten erst durch JS geladen werden (und nicht im HTML stehen), nutze Selenium oder Playwright, um einen Browser zu steuern, warte auf das Laden und extrahiere dann die Daten.

- Paginierung: Durchlaufe „Weiter“-Links oder erhöhe die Seitenzahl in der URL. Scrapy erledigt das elegant mit seinem Request-Following.

Beispiel: Paginierung mit BeautifulSoup

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...Zitate extrahieren...

12 page += 1Für unendliches Scrollen oder „Mehr laden“-Buttons: Nutze Selenium zum Scrollen oder Klicken, oder prüfe im Netzwerk-Tab, ob du API-Aufrufe mit Requests nachbilden kannst.

Daten speichern: So nutzt du gescrapte Daten im Unternehmen

Sobald du deine Daten hast, willst du sie sinnvoll abspeichern.

- CSV: Universell und easy in Excel/Sheets nutzbar.

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel: Mit pandas schnell exportieren.

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - Datenbank: Für große oder laufende Projekte empfiehlt sich SQLite oder PostgreSQL.

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...Tabelle anlegen, Daten einfügen... 4conn.close()

Wähle das Format, das zu deinem Workflow passt. Für die Zusammenarbeit mit Nicht-Technikern sind Excel oder Google Sheets meist am praktischsten.

Rechtliche und ethische Aspekte beim Web Scraping mit Python

Scraping ist mächtig – aber mit großer Macht kommt auch Verantwortung. So bleibst du auf der sicheren Seite:

- Nur öffentliche Daten scrapen: Wenn Login oder Paywall nötig sind, besser zweimal überlegen.

- AGB prüfen: Manche Seiten verbieten Scraping ausdrücklich. Verstöße können zu Sperrungen oder Schlimmerem führen ().

- robots.txt respektieren: Nicht rechtlich bindend, aber ein Gebot der Höflichkeit.

- Keine personenbezogenen Daten: Durch DSGVO und CCPA kann das Scrapen von Namen, E-Mails oder Telefonnummern rechtliche Probleme verursachen.

- Server nicht überlasten: Pausen einbauen, Anfragen begrenzen und möglichst außerhalb der Stoßzeiten scrapen.

Schnelle Compliance-Checkliste:

- Lies die AGB und robots.txt der Seite.

- Verzichte auf das Scrapen sensibler oder persönlicher Daten.

- Gib deine Datenquellen an.

- Sei fair: Überlaste den Server nicht.

Mehr zu rechtlichen Best Practices findest du unter .

Fehlerbehebung und Best Practices für zuverlässiges Python Web Scraping

Web scraping läuft nicht immer reibungslos. So meisterst du die typischen Herausforderungen:

- HTTP-Fehler (403, 404, 429): Setze einen realistischen User-Agent, verlangsame die Anfragen und fange Fehler sauber ab.

- Gesperrte IPs: Nutze Proxys oder wechsle die IP, wenn du in großem Stil scrapest – aber prüfe immer, ob das ethisch vertretbar ist.

- CAPTCHAs: Wenn du auf ein CAPTCHA stößt, überlege, ob du weitermachen solltest. Es gibt zwar Lösungen, aber das ist rechtlich oft eine Grauzone.

- Seitenstruktur ändert sich: Verwende robuste Selektoren, prüfe auf

Noneund nutze try/except-Blöcke. - Zeichenkodierung: Immer UTF-8 verwenden und das Ergebnis in Excel oder Sheets testen.

Best Practices:

- Logge jeden Schritt – so findest du Fehler schnell.

- Wiederhole fehlgeschlagene Anfragen mit Backoff.

- Teste deinen Scraper erst auf wenigen Seiten, bevor du skalierst.

- Überwache die Ergebnisse – wenn weniger Daten kommen, hat sich vielleicht etwas geändert.

Und falls du keine Lust hast, bei jeder Layoutänderung nachzubessern: passt sich dank KI automatisch an neue Strukturen an.

Mit Thunderbits KI-Ansatz kannst du dich auf die Analyse konzentrieren – nicht auf die Wartung.

Fazit & wichtigste Erkenntnisse

Web scraping mit Python verschafft dir einen echten Vorsprung – du verwandelst das Chaos des Webs in strukturierte, nutzbare Daten. Das hast du gelernt:

- Python ist die Top-Wahl fürs web scraping – dank klarer Syntax und starker Bibliotheken.

- Requests + BeautifulSoup sind ideal für kleine, statische Aufgaben; Scrapy ist das Tool für große, automatisierte Crawls.

- Thunderbit bringt KI ins Spiel und macht Scraping für alle zugänglich – ohne Code, ohne Stress, einfach Daten.

- Dynamische Inhalte und Paginierung meisterst du mit Selenium oder Scrapy.

- Speichere deine Daten als CSV, Excel oder in Datenbanken – je nach Bedarf.

- Bleib legal und fair: Nur öffentliche Daten scrapen, Regeln beachten, keine persönlichen Infos sammeln.

- Baue robuste Scraper: Logge, wiederhole, überwache – oder lass Thunderbits KI die Arbeit machen.

Bereit für den Einstieg? Bau deinen ersten Python-Scraper – oder, wenn du den Code überspringen willst, und erlebe, wie einfach Webdaten-Extraktion sein kann. Noch mehr Tipps und Deep Dives findest du im .

FAQs

1. Ist Web Scraping mit Python legal?

Web scraping ist legal, solange du öffentlich zugängliche Daten sammelst und die Nutzungsbedingungen, robots.txt und Datenschutzgesetze wie die DSGVO beachtest. Verzichte auf das Scrapen persönlicher oder sensibler Daten und prüfe immer die Regeln, bevor du loslegst ().

2. Was ist der Unterschied zwischen BeautifulSoup und Scrapy?

BeautifulSoup ist ein schlanker HTML-Parser – ideal für kleine Aufgaben oder einzelne Seiten. Scrapy ist ein komplettes Framework für das Crawlen vieler Seiten, Paginierung und den Export großer Datenmengen. Für schnelle Skripte nimm BeautifulSoup, für große Projekte Scrapy ().

3. Wie gehe ich mit JavaScript-lastigen Webseiten in Python um?

Nutze Selenium oder Playwright, um einen Browser zu automatisieren, warte auf das Laden der JavaScript-Inhalte und extrahiere dann die Daten. Alternativ kannst du im Netzwerk-Tab nach API-Aufrufen suchen, die du mit Requests nachbilden kannst.

4. Was unterscheidet Thunderbit von Python-Scraping-Bibliotheken?

Thunderbit nutzt KI, um Felder vorzuschlagen, Unterseiten zu scrapen und sich an Layoutänderungen anzupassen – ganz ohne Code. Perfekt für Business-User und Teams, die schnell Daten brauchen, ohne sich um Wartung zu kümmern ().

5. Wie kann ich gescrapte Daten speichern und mit meinem Team teilen?

Exportiere deine Daten als CSV oder Excel für den einfachen Austausch oder nutze pandas, um sie in Datenbanken zu speichern. Mit Thunderbit kannst du direkt nach Google Sheets, Airtable, Notion exportieren oder als CSV/Excel herunterladen – kostenlos.

Viel Erfolg beim Scrapen – und möge deine Daten stets sauber, strukturiert und einsatzbereit sein.