Das Internet ist heutzutage wie ein riesiger Daten-Schatz – egal ob Produktpreise, Kundenmeinungen, Wettbewerbsanalysen oder Immobilienanzeigen, hier findet man einfach alles. Kein Wunder also, dass der Markt für Web-Scraping bis 2025 auf satte 9 Milliarden US-Dollar anwachsen und weiterhin zweistellig zulegen soll (). Warum? Wer gezielt auf öffentlich verfügbare Webdaten zugreift, verschafft sich einen echten Vorsprung. Ich habe schon erlebt, wie Teams quasi über Nacht von „aus dem Bauch heraus“ zu „datengetrieben“ wechseln – mit mehr Umsatz, besseren Preisen und dem Gespür für Trends, bevor andere überhaupt reagieren.

Aber: Früher war das Sammeln von Webdaten eine echte Geduldsprobe – stundenlanges Copy & Paste, Programmierarbeit oder teure, komplizierte Tools. Heute sieht das zum Glück ganz anders aus. In diesem Guide zeige ich dir, wie du mit KI-Tools wie Website-Daten schnell, sicher und für jeden zugänglich sammelst – selbst wenn du mit „HTML“ bisher nichts anfangen konntest.

Lass uns loslegen!

Warum Webdaten für Unternehmen so wichtig sind

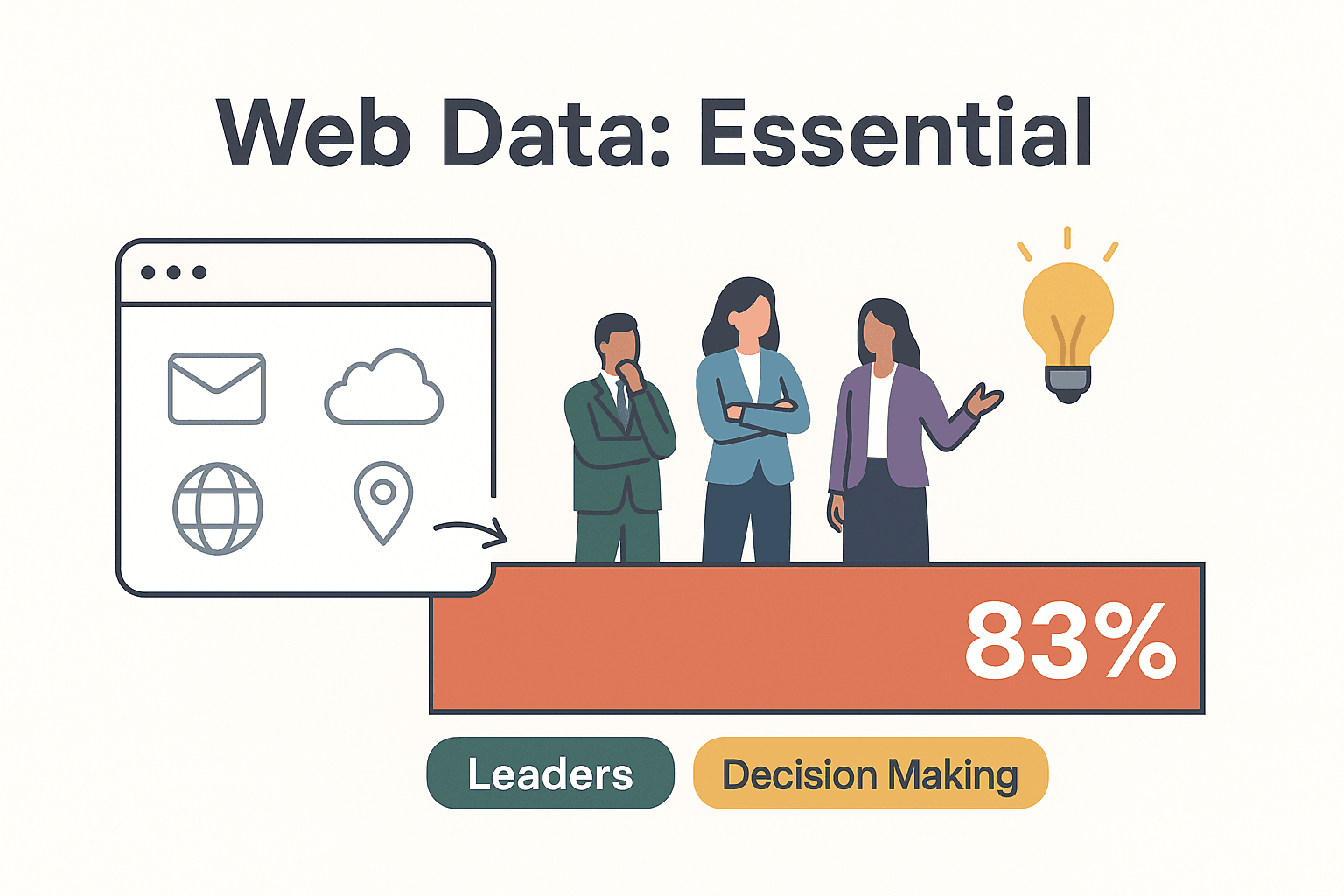

Klar ist: In der digitalen Wirtschaft sind Webdaten ein echter Gamechanger. Wer Website-Daten gezielt nutzt, trifft bessere und schnellere Entscheidungen – und das macht sich direkt im Geschäftserfolg bemerkbar.

So bringen Webdaten messbare Vorteile:

- Wettbewerbsanalyse & Marktforschung: Über 48 % aller Web-Scraping-Aktivitäten drehen sich um E-Commerce-Daten – also Produktlisten, Preise und Bewertungen (). Händler passen ihre Preise oft mehrmals täglich an die Konkurrenz an.

- Leadgenerierung: Automatisiertes Scraping von Branchenverzeichnissen und Websites liefert Vertriebsteams ständig neue, aktuelle Kontakte. 75 % der Marketer berichten von besseren Abschlussquoten nach der Automatisierung der Lead-Generierung ().

- Preisüberwachung: Mit Echtzeit-Preis-Scraping können Unternehmen ihre Preise optimal anpassen und sofort auf Marktveränderungen reagieren. Ein internationaler Händler steigerte so den ROI im ersten Jahr um 312 % ().

- Produktentwicklung & Trendanalyse: Durch das Auswerten von Bewertungen und Social-Media-Posts verkürzen Marken wie Zara ihre Entwicklungszyklen von Monaten auf Wochen ().

- Effizienzsteigerung: Immobilienfirmen bündeln Angebote aus verschiedenen Portalen, Finanzteams analysieren News und Meldungen für schnelle Investitionsentscheidungen.

Das Fazit: 83 % der Führungskräfte halten den Zugang zu externen Webdaten für „unverzichtbar“ bei Entscheidungen (). Wer Webdaten ignoriert, lässt bares Geld und wertvolle Insights liegen.

Wie funktioniert das Sammeln von Webdaten? Die Basics

Was heißt eigentlich „Daten von einer Website sammeln“? Kurz gesagt: Du wandelst die Infos, die du auf einer Webseite siehst, in ein strukturiertes Format um (zum Beispiel eine Tabelle), das du analysieren, teilen oder weiterverarbeiten kannst.

Strukturierte vs. unstrukturierte Daten:

- Strukturierte Daten sind ordentlich sortiert – etwa Produktlisten mit Spalten wie Name, Preis und Bewertung ().

- Unstrukturierte Daten sind wild gemischt – wie Blogartikel, Rezensionen oder Fließtext. Die meisten Webinhalte sind erstmal unstrukturiert, aber gute Tools machen daraus nutzbare Daten.

Typische Methoden zum Webdaten-Sammeln:

- Manuelles Kopieren: Seite öffnen, Infos kopieren, in Excel einfügen. Für fünf Zeilen okay – für 500 ein Albtraum.

- Tabellenfunktionen: Mit

IMPORTHTMLin Google Sheets lassen sich einfache Tabellen importieren, aber bei komplexen Seiten oder Navigation kommt man schnell an Grenzen. - Eigene Skripte: Mit Python, JavaScript oder Entwicklertools lassen sich Daten extrahieren – aber das braucht Programmierkenntnisse und Geduld.

- Browser-Erweiterungen & No-Code-Tools: Point-and-Click-Scraper ermöglichen die visuelle Auswahl von Elementen, brauchen aber oft Feintuning und können bei Website-Änderungen aussteigen.

Die beste Lösung? KI-gestützte Tools, die dir die Arbeit abnehmen – ganz ohne Code und Frust.

Die besten Wege: So sammelst du Webdaten (von No-Code bis Profi)

Hier ein Überblick über die gängigen Methoden – von klassisch bis modern:

| Methode | Bedienkomfort | Geschwindigkeit & Skalierbarkeit | Datenformat | Für wen geeignet? |

|---|---|---|---|---|

| Manuelles Kopieren | Am einfachsten, aber langsam | Sehr langsam | Fehleranfällig, unübersichtlich | Einzelne, kleine Aufgaben |

| Point-and-Click-Scraper | Kein Code, aber Einarbeitung nötig | Mittel | CSV, Excel | Growth Hacker, Analysten |

| Eigene Skripte (Python, JS) | Am anspruchsvollsten | Schnell, skalierbar | Beliebiges Format | Entwickler, Datenteams |

| KI-Tools (Thunderbit) | Am einfachsten | Schnell, parallel | Excel, Sheets, Notion, Airtable | Jeder – keine IT-Kenntnisse nötig |

Klassische Tools wie Webscraper.io oder Octoparse sind weit verbreitet, aber viele sagen: „No-Code ja, aber nicht ohne Aufwand“ – denn Selektoren, Paginierung und Anpassungen bei Website-Änderungen sind oft nötig ().

Hier kommt ins Spiel. Die KI-basierte Chrome-Erweiterung richtet sich an Business-Anwender statt Entwickler. Einfach auf „KI-Felder vorschlagen“ klicken, die KI erkennt die relevanten Daten auf der Seite, und mit „Scrape“ startet die Extraktion. So einfach war Webdaten-Sammeln noch nie.

Thunderbit: Webdaten sammeln mit KI – einfach, schnell, stressfrei

Ich bin vielleicht voreingenommen, aber aus Erfahrung: ist der einfachste Weg, Webdaten zu sammeln – vor allem, wenn es schnell gehen soll und du keine Lust auf Code oder komplizierte Vorlagen hast.

Was macht Thunderbit so besonders?

- KI „Felder vorschlagen“: Thunderbit analysiert die Seite und schlägt die optimalen Spalten vor – ganz ohne manuelle Einstellungen ().

- 2-Klick-Workflow: „KI-Felder vorschlagen“, prüfen, „Scrape“ – fertig.

- Unterseiten & Paginierung: Die KI folgt „Weiter“-Buttons, endlosem Scrollen oder springt in Detailseiten, um deine Daten zu vervollständigen ().

- Sofort-Vorlagen: Für bekannte Seiten wie Amazon, Zillow oder Instagram gibt es 1-Klick-Vorlagen – keine Einrichtung nötig ().

- Natürliche Sprache: Du willst nur den Preis als Zahl oder die Stimmung einer Bewertung? Sag es der KI einfach in Alltagssprache.

- Kostenloser Datenexport: Exportiere nach Excel, Google Sheets, Airtable, Notion oder als JSON – ohne Bezahlschranke, ohne Limit ().

- Cloud-Scraping: Bis zu 50 Seiten gleichzeitig im Cloud-Modus extrahieren – dein Rechner muss nicht laufen ().

- Geplanter Scraper: Automatisiere deine Scrapes nach Zeitplan – und lass Thunderbit im Hintergrund arbeiten.

Und das sagen nicht nur wir: Auf Trustpilot loben Nutzer Thunderbit als „den einzigen KI-Web-Scraper, der wirklich hält, was er verspricht“ und schätzen den „extrem einfachen Workflow“ ().

Schritt für Schritt: So sammelst du Webdaten mit Thunderbit

Bereit für die Praxis? So gehe ich beim Sammeln von Webdaten mit Thunderbit vor:

1. Thunderbit Chrome-Erweiterung installieren

Im Thunderbit hinzufügen und kostenlos registrieren. Die Erweiterung am besten gleich an die Symbolleiste anheften.

2. Zielseite aufrufen

Öffne die Seite mit den gewünschten Daten. Falls ein Login nötig ist (z. B. LinkedIn), zuerst einloggen – Thunderbit arbeitet mit deiner Browser-Session.

3. „KI-Felder vorschlagen“ klicken

Thunderbit öffnen, „KI-Felder vorschlagen“ anklicken und die KI die Seite analysieren lassen. Es werden Spalten wie Name, Preis, Bewertung usw. vorgeschlagen – inklusive Beispieldaten.

4. Felder prüfen und anpassen

Du kannst Felder hinzufügen, entfernen oder umbenennen. Willst du etwas Spezielles extrahieren? Einfach ein Feld hinzufügen und in Alltagssprache beschreiben („nur den numerischen Preis extrahieren“).

5. Scraping starten

Auf „Scrape“ klicken. Thunderbit sammelt die Daten von der aktuellen Seite – und folgt bei Bedarf automatisch „Weiter“-Buttons oder endlosem Scrollen. Die Ergebnisse erscheinen live.

6. Unterseiten extrahieren (optional)

Du brauchst mehr Details von den Einzelseiten? „Unterseiten scrapen“ wählen – Thunderbit besucht jeden Link, sammelt Zusatzinfos und ergänzt sie in deiner Tabelle.

7. Daten exportieren

Nach Abschluss kannst du die Daten mit einem Klick exportieren:

- Excel: Als .xlsx herunterladen.

- Google Sheets: Direkt in ein neues oder bestehendes Sheet senden.

- Airtable/Notion: Nach Freigabe als Datenbanktabelle exportieren (inklusive Bilder!).

- CSV/JSON: Für Entwickler oder individuelle Workflows.

8. Tipps zur Fehlerbehebung

- Endloses Scrollen? Thunderbit erkennt das automatisch – keine Extra-Einstellungen nötig.

- Feld fehlt? Ein benutzerdefiniertes Feld hinzufügen oder den KI-Prompt anpassen.

- Scraping gestoppt? Eventuelle CAPTCHAs im Browser lösen und fortsetzen.

- Login erforderlich? Nach dem Login den Browser-Modus (nicht Cloud) nutzen.

So kommst du in wenigen Minuten von „Ich hätte gern diese Daten“ zu „Hier ist meine Tabelle“.

Automatisierung: Geplantes und Cloud-basiertes Webdaten-Sammeln

Manuelles Scraping ist für Einzelaufgaben praktisch – aber die wahre Effizienz kommt mit Automatisierung. Mit Thunderbits Automatisierungsfunktionen sparst du Zeit, vermeidest Fehler und hältst deine Daten immer aktuell.

Geplanter Scraper: Lege wiederkehrende Scrapes fest (stündlich, täglich, wöchentlich) – einfach in natürlicher Sprache („jeden Montag um 9 Uhr“). Thunderbit erledigt den Job in der Cloud – auch wenn dein Rechner aus ist ().

Cloud-Scraping: Bis zu 50 Seiten gleichzeitig extrahieren – ideal für große Aufgaben wie das Überwachen von 1.000 Produkten oder Immobilienangeboten.

Praxisbeispiele:

- E-Commerce: Tägliche Preisvergleiche der Konkurrenz automatisch in ein Google Sheet exportieren.

- Immobilien: Neue Angebote in deiner Zielregion automatisch überwachen.

- Vertrieb: Wöchentliche Aktualisierung deiner Lead-Liste aus Verzeichnissen oder Firmenwebsites – keine veralteten Kontakte mehr.

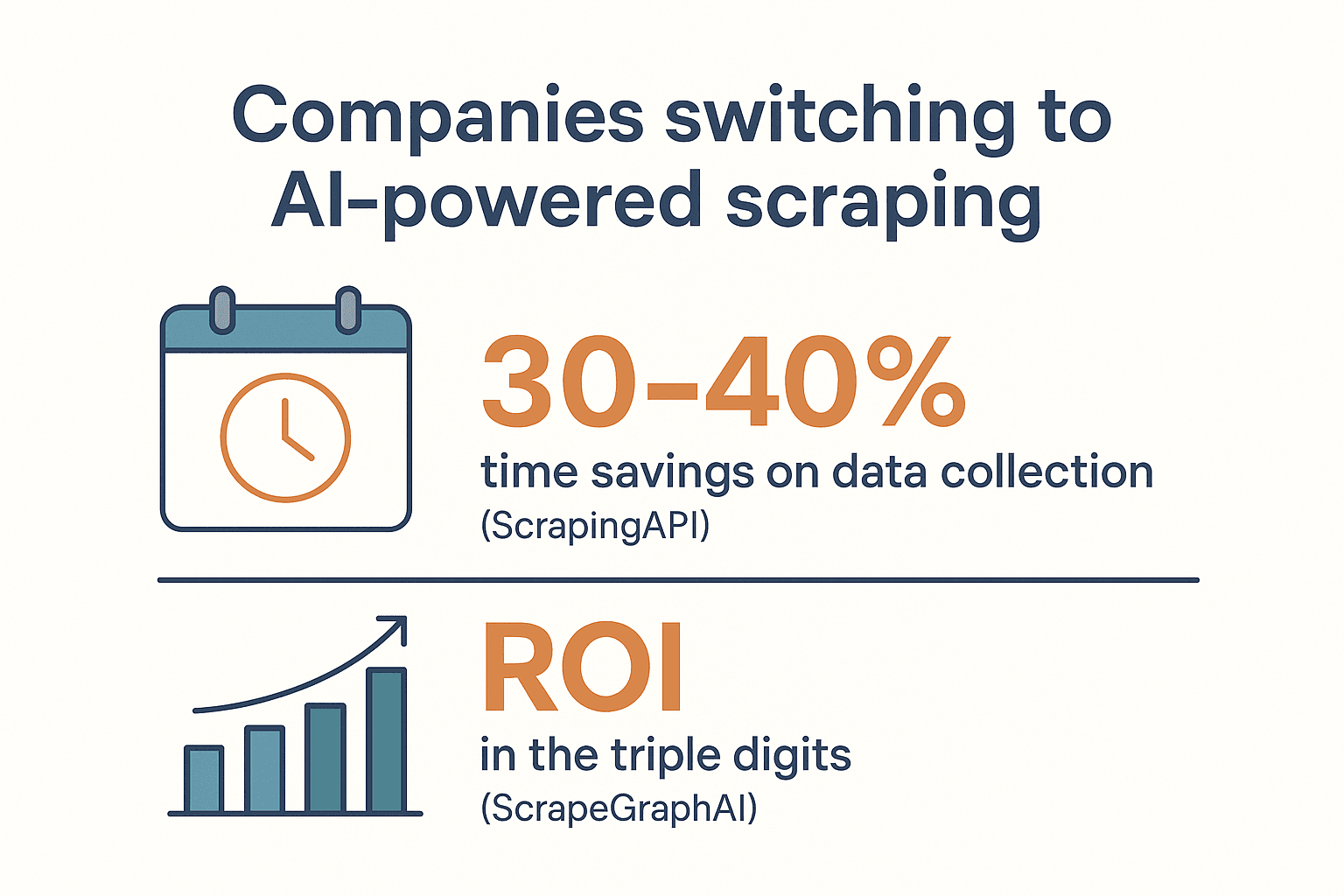

Unternehmen, die auf KI-gestütztes Scraping umsteigen, berichten von 30–40 % Zeitersparnis bei der Datensammlung (), manche erzielen sogar dreistellige ROI-Werte ().

Rechtliche und ethische Aspekte beim Webdaten-Sammeln

Mit großer Datenpower kommt auch Verantwortung. So bleibst du rechtlich und ethisch auf der sicheren Seite:

- AGB prüfen: Viele Websites verbieten Scraping in ihren Nutzungsbedingungen. Ein Verstoß ist nicht immer illegal, kann aber zu Sperrungen oder rechtlichen Schritten führen ().

- robots.txt respektieren: Nicht rechtlich bindend, aber ein Gebot der Fairness. Wenn eine Seite „keine Bots“ sagt, besser zweimal überlegen.

- Keine Inhalte stehlen: Fakten wie Preise oder Lagerbestände sind meist erlaubt, aber urheberrechtlich geschützte Texte oder Bilder dürfen nicht übernommen werden.

- Personenbezogene Daten schützen: Gesetze wie DSGVO oder CCPA regeln den Umgang mit Namen, E-Mails und Co. – auch wenn sie öffentlich sind. E-Mails nur verantwortungsvoll nutzen und Anti-Spam-Regeln beachten ().

- Kein Hacking: Nur das extrahieren, was du als eingeloggter Nutzer (mit eigenem Account) sehen kannst. Keine Logins oder CAPTCHAs umgehen.

- Schonend scrapen: Kleine Seiten nicht überlasten – Thunderbit ermöglicht die Steuerung von Geschwindigkeit und Parallelität.

- Transparenz: Wenn du gesammelte Daten in Berichten oder Produkten nutzt, immer die Quelle angeben.

Mehr dazu findest du im .

Tipps für maximalen Erfolg beim Webdaten-Sammeln

So holst du das Beste aus deinen Webdaten-Projekten heraus:

- Datenbedarf klären: Überlege vorher, welche Felder du wirklich brauchst – und warum. Unnötige Daten vermeiden.

- Daten prüfen & bereinigen: Nach dem Scraping auf Duplikate, fehlende Werte oder Formatfehler achten. Tools wie Excel, OpenRefine oder Thunderbits KI-Prompts helfen dabei.

- Änderungen überwachen: Webseiten ändern sich – wenn die Daten plötzlich nicht mehr passen, „KI-Felder vorschlagen“ erneut ausführen oder die Einstellungen anpassen.

- Automatisieren: Mit geplanten und Cloud-Scrapes bleiben deine Daten aktuell und Fehler werden minimiert.

- Daten organisieren & analysieren: Exportiere nach Google Sheets, Notion oder Airtable für die Zusammenarbeit. Mit Diagrammen und Filtern Trends erkennen.

- Ethik beachten: Nur das sammeln, was nötig ist, Privatsphäre respektieren und Websites nicht überlasten.

- Am Ball bleiben: Das Web entwickelt sich ständig weiter – ebenso die Tools. Bleib über Best Practices und neue Funktionen auf dem Laufenden ().

Fazit: Mit Webdaten zum Geschäftserfolg

Webdaten zu sammeln ist kein reiner Technik-Trick – es ist ein echter Wettbewerbsvorteil. Mit der richtigen Herangehensweise kannst du:

- Konkurrenten überholen dank aktueller Markt- und Preisinformationen.

- Deinen Vertrieb ankurbeln mit frischen, gezielten Leads.

- Trends und Chancen frühzeitig erkennen und nutzen.

- Zeit und Kosten sparen durch automatisierte Recherche.

Und mit KI-Tools wie ist Webdaten-Sammeln endlich für alle möglich – ohne Programmierung, ohne Stress, mit schnellen Ergebnissen. Ich habe erlebt, wie Teams ihre Arbeitsweise komplett verändern und neues Wachstum erschließen, nur weil sie das Potenzial von Webdaten nutzen.

Bereit für den Einstieg? , kostenlos ausprobieren und erleben, wie einfach sich Webseiten in Geschäftserfolge verwandeln lassen. Noch mehr Tipps, Anleitungen und Praxisbeispiele findest du im .

Häufige Fragen (FAQ)

1. Ist das Sammeln von Webdaten legal?

Das Extrahieren öffentlicher Daten ist meist erlaubt, solange Urheberrechte, Datenschutz (z. B. DSGVO/CCPA) und die Nutzungsbedingungen der Website beachtet werden. Niemals ohne Erlaubnis hinter Logins scrapen und personenbezogene Daten nur mit rechtlicher Grundlage nutzen ().

2. Wie sammle ich am einfachsten Webdaten ohne Programmierung?

Mit KI-Tools wie geht das in wenigen Klicks – kein Code, keine Vorlagen, einfach „KI-Felder vorschlagen“ und „Scrape“.

3. Kann ich das Sammeln von Webdaten automatisieren?

Ja! Thunderbit unterstützt geplante und Cloud-basierte Scrapes – so kannst du stündlich, täglich oder wöchentlich automatisch Daten sammeln, auch wenn dein Rechner aus ist.

4. Welche Daten kann ich von Websites sammeln?

Du kannst Produktinfos, Preise, Bewertungen, Kontaktdaten, Bilder und vieles mehr extrahieren. Thunderbit verarbeitet strukturierte Tabellen und unstrukturierten Text und folgt bei Bedarf auch Unterseiten.

5. Wie exportiere und nutze ich die gesammelten Daten?

Thunderbit ermöglicht den Export nach Excel, Google Sheets, Notion, Airtable, CSV oder JSON – bereit zur Analyse, zum Teilen oder für die Weiterverarbeitung.

Du willst Webdaten-Sammeln live erleben? und verwandle Webseiten noch heute in wertvolle Geschäftseinblicke.

Mehr erfahren