Das Internet wächst heute schneller als je zuvor – und wenn du im Business, in der IT oder einfach ein echter Daten-Nerd bist wie ich, hast du es bestimmt schon gemerkt: Der wahre Schatz liegt in den Daten, die du sammeln kannst – nicht nur in denen, die du direkt siehst. Unternehmen setzen mittlerweile alles daran, die Datenerfassung im Web zu automatisieren. Die Web-Scraper-Branche wird bis geschätzt. Und ein spannender Fakt: Über nutzen bereits Web-Scraper oder Crawler, um ihre KI, Analysen und Geschäftsprozesse mit frischen Daten zu versorgen.

Wie kannst du davon profitieren? Für die meisten heißt die Antwort: Python. Es ist die beliebteste Sprache, um Website-Crawler zu bauen – einfach, leistungsstark und mit einer riesigen Auswahl an Bibliotheken, die das Crawlen und Scrapen super easy machen. In diesem Guide zeige ich dir, was ein Website-Crawler ist, warum Python die beste Wahl ist, wie du Schritt für Schritt deinen eigenen Crawler baust und wie Tools wie das Ganze noch einfacher machen (vor allem, wenn du lieber klickst als programmierst). Egal ob Entwickler, datengetriebener Marketer oder jemand, der einfach Routineaufgaben automatisieren will – hier findest du das passende Know-how, um deine Webdaten-Strategie aufs nächste Level zu bringen.

Was ist ein Website-Crawler? (Und warum ist das wichtig?)

Kurz gesagt: Ein Website-Crawler ist ein Programm, das automatisch durchs Web surft, Seiten besucht, Links folgt und dabei (optional) Daten einsammelt. Stell dir einen Super-Websurfer vor, der nie schläft, nie müde wird und nie aus Versehen den falschen Tab schließt. Crawler sind das Rückgrat von Suchmaschinen (wie Googlebot), werden aber auch von Unternehmen für Preisüberwachung, Marktforschung und vieles mehr eingesetzt.

Aber was ist eigentlich der Unterschied zwischen Crawling und Scraping? Crawling bedeutet, Seiten zu finden und zu durchlaufen (wie eine Stadtkarte zu zeichnen), während Scraping das Extrahieren bestimmter Daten von diesen Seiten ist (wie alle Speisekarten der Restaurants in der Stadt zu sammeln). In der Praxis machen die meisten Projekte beides: Erst crawlen, um die Seiten zu finden, dann scrapen, um die gewünschten Daten zu holen ().

Typische Business-Anwendungen für Crawler:

- Lead-Generierung: Automatisches Sammeln von Kontaktdaten aus Verzeichnissen oder sozialen Netzwerken.

- Preisüberwachung: Konkurrenzpreise und Lagerbestände über tausende Produkte hinweg verfolgen.

- Content-Monitoring: Benachrichtigungen erhalten, wenn deine Marke in News, Blogs oder Foren erwähnt wird.

- SEO-Audits: Die eigene Website auf fehlerhafte Links oder fehlende Metadaten prüfen.

- Marktforschung: Immobilienanzeigen, Stellenangebote oder Produktbewertungen für Analysen aggregieren.

Wenn du dir schon mal gewünscht hast, dich für die Webrecherche klonen zu können, ist ein Crawler die beste Alternative.

Warum Website-Crawler für die Automatisierung im Business unverzichtbar sind

Kommen wir zum Alltag: Warum setzen Unternehmen auf Crawler und Scraper? Weil sich der Aufwand richtig lohnt. Hier ein Überblick, wie verschiedene Teams Crawler nutzen – und was sie davon haben:

| Anwendungsfall | Hauptvorteil | Wer nutzt es |

|---|---|---|

| Lead-Generierung | Automatisierte Erstellung von Kontaktlisten, spart Zeit | Vertrieb, Recruiting |

| Preisüberwachung | Echtzeit-Einblicke in die Konkurrenz, dynamische Preise | E-Commerce, Produktteams |

| Content-Monitoring | Markenschutz, Trends erkennen | Marketing, PR |

| SEO-Site-Audit | Website-Qualität, bessere Rankings | SEO, Webmaster |

| Marktforschung | Aktuelle, umfangreiche Datensätze für Analysen | Analysten, Research-Teams |

Eine Fallstudie zeigte: Die Automatisierung einer wöchentlichen Datensammlung (Scraping von 5–7 Websites) sparte einer einzelnen Person über 50 Stunden pro Jahr – multipliziert mit einem Team wird klar, warum , wenn sie einmal Crawler nutzen.

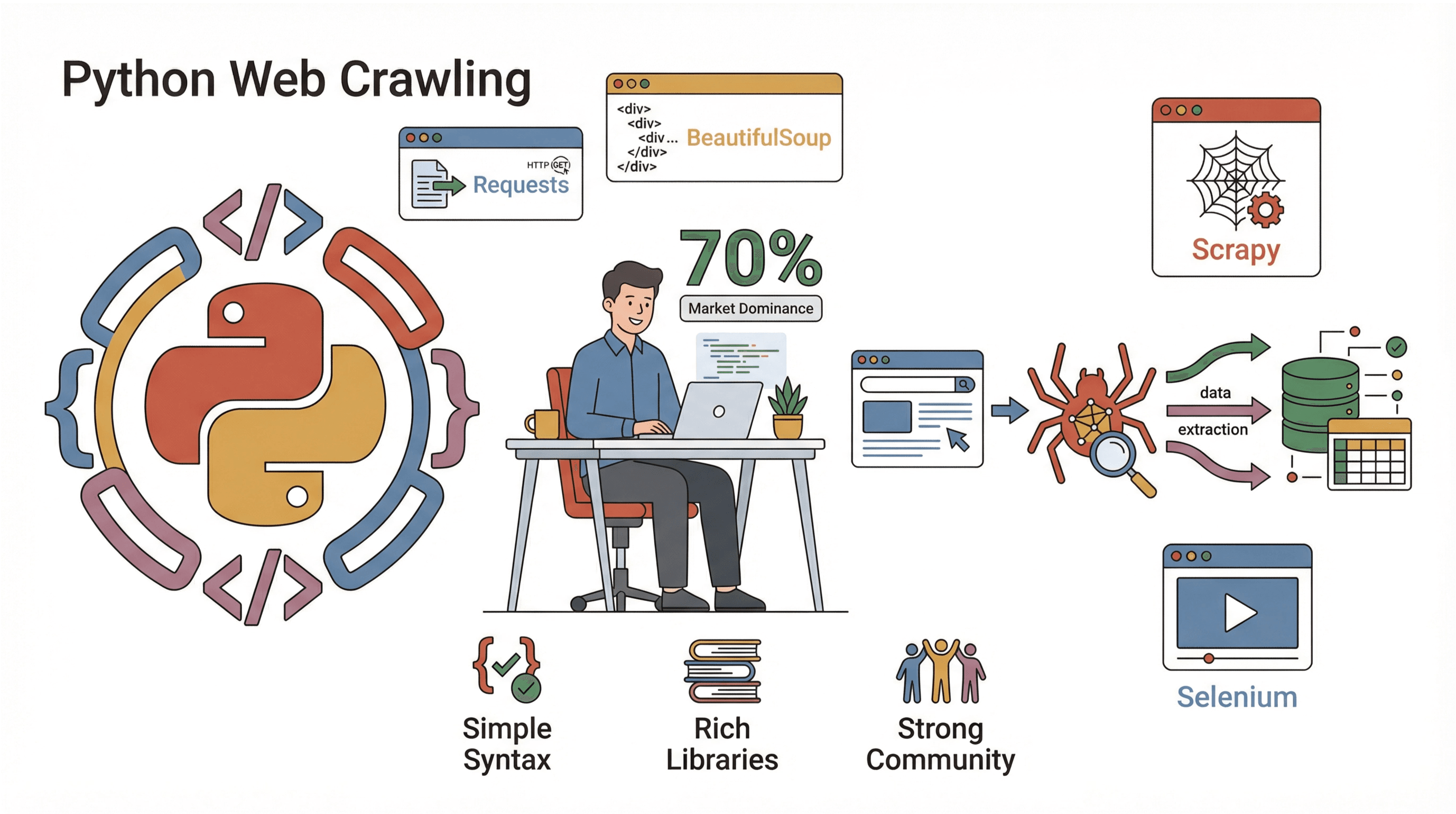

Python: Die erste Wahl für Website-Crawler

Warum ist Python der absolute Favorit beim Web-Crawling? Drei Hauptgründe:

Warum ist Python der absolute Favorit beim Web-Crawling? Drei Hauptgründe:

- Einfache Syntax: Python ist super lesbar, einsteigerfreundlich und du bekommst mit wenigen Zeilen Code schon funktionierende Crawler.

- Umfangreiche Bibliotheken: Für jeden Schritt gibt’s die passende Library – Seiten abrufen, HTML parsen, JavaScript verarbeiten und vieles mehr.

- Starke Community: Fast laufen mit Python – es gibt unzählige Tutorials und Lösungen für fast jedes Problem.

Die wichtigsten Python-Bibliotheken fürs Web-Crawling:

- Requests: Der einfachste Weg, Webseiten per HTTP abzurufen.

- BeautifulSoup: Der Standard zum Parsen von HTML und Finden von Elementen.

- Scrapy: Ein komplettes Framework für große Crawling-Projekte.

- Selenium: Automatisiert Browser, um auch JavaScript-lastige Seiten zu scrapen.

Im Vergleich zu anderen Sprachen (wie Java oder C#) kommst du mit Python viel schneller von der Idee zum funktionierenden Crawler. Und wer mit Daten arbeitet, kann die Ergebnisse direkt in Pandas weiterverarbeiten – ohne umständliches Exportieren.

Parsing-Methoden im Vergleich: Regex vs. BeautifulSoup vs. Scrapy

Beim Extrahieren von Daten aus Webseiten hast du verschiedene Möglichkeiten. So schneiden die wichtigsten Methoden ab:

| Methode | Funktionsweise | Vorteile 🟢 | Nachteile 🔴 | Ideal für |

|---|---|---|---|---|

| Regex | Sucht Muster im Roh-HTML | Schnell bei einfachen, bekannten Strukturen | Fehleranfällig bei HTML-Änderungen | Schnelle Lösungen, URL-Extraktion |

| BeautifulSoup | Parst HTML als Baum, sucht nach Tags | Einfach, flexibel, kommt mit „schlechtem“ HTML klar | Langsam bei sehr großen Seiten, Crawl-Logik manuell | Die meisten kleinen/mittleren Scraper |

| Scrapy | Komplettes Framework, CSS/XPath-Parsing | Schnell, skalierbar, Crawling & Parsing integriert | Höhere Einstiegshürde, mehr Setup | Große, produktive Crawler |

- Regex ist wie ein Metalldetektor am Strand – schnell, aber du übersiehst leicht etwas, wenn sich der Sand verschiebt.

- BeautifulSoup ist wie eine Karte und eine Schaufel – du kannst überall graben, musst aber selbst laufen.

- Scrapy ist wie ein ganzes Team mit LKWs und GPS – für kleine Sandkästen übertrieben, aber für große Projekte unschlagbar.

Für Einsteiger empfehle ich Requests + BeautifulSoup. Damit lernst du die Grundlagen und kannst später auf Scrapy umsteigen, wenn du skalieren willst.

Schritt für Schritt: Einen einfachen Website-Crawler in Python bauen

Bereit für die Praxis? Lass uns einen simplen Crawler bauen, der Seiten besucht, Links folgt und Daten sammelt. Ich führe dich durch jeden Schritt – inklusive Code zum Ausprobieren.

Schritt 1: Python-Umgebung einrichten

Stell sicher, dass Python 3.10+ installiert ist (prüfe mit python --version). Am besten legst du eine virtuelle Umgebung an:

1python -m venv venv

2source venv/bin/activate # Unter Windows: venv\Scripts\activateInstalliere dann die benötigten Bibliotheken:

1pip install requests beautifulsoup4Das war’s! Öffne deinen Lieblingseditor und los geht’s.

Schritt 2: Dein erstes Crawler-Skript schreiben

Starte mit dem Abrufen einer einzelnen Seite. Hier ein einfaches Beispiel:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # Fehler bei Status ≠ 200

5 print(response.text[:500]) # Zeigt die ersten 500 Zeichen

6crawl_page("https://www.scrapingcourse.com/ecommerce/")Du solltest einen HTML-Ausschnitt in der Konsole sehen – der Beweis, dass du mit dem Web sprichst.

Schritt 3: Links folgen und mehr Daten sammeln

Jetzt soll der Crawler Links folgen und mehrere Seiten besuchen. Wir führen eine Liste mit URLs, die noch besucht werden sollen, und eine Menge bereits besuchter URLs (um Schleifen zu vermeiden):

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # Sicherheitslimit

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Fehler beim Abrufen von {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Gecrawlt: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) and url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)Dieses Skript crawlt bis zu 20 Seiten und bleibt dabei auf der gleichen Website. Jede gecrawlte URL wird ausgegeben.

Schritt 4: Daten von den Seiten extrahieren

Angenommen, du möchtest Produktnamen und Preise sammeln. So könnte das aussehen:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ... (wie oben)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url oder current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ... (Rest wie oben)

18# Speichern als CSV

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"{len(product_data)} Produkte extrahiert.")Jetzt hast du eine CSV-Datei mit allen gesammelten Produkten – bereit für Analysen, Uploads oder zum Angeben bei Freunden.

Schritt 5: Crawler debuggen und optimieren

Einen Crawler zu bauen ist das eine – ihn robust zu machen das andere. Hier ein paar Tipps aus eigener Erfahrung:

- User-Agent setzen: Manche Seiten blockieren „Python-requests“ standardmäßig. Gib dich als Browser aus:

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - Fehler abfangen: Mit try/except kannst du fehlerhafte oder blockierte Seiten überspringen.

- Endlosschleifen vermeiden: Immer besuchte URLs tracken und ein Seitenlimit setzen.

- Anfragen drosseln: Mit

time.sleep(1)zwischen den Requests verringerst du das Blockrisiko. - robots.txt beachten: Halte dich an die Crawling-Regeln der Seite ().

- Fortschritt loggen: Jede gecrawlte URL ausgeben oder loggen – das hilft beim Debuggen enorm.

Wenn dein Crawler blockiert wird, seltsame Inhalte liefert oder Daten fehlen, prüfe die Header, verlangsame die Anfragen und achte auf Anti-Bot-Maßnahmen.

Thunderbit: Website-Crawling mit KI ganz einfach

Jetzt zum „Easy-Button“ fürs Web-Crawling: . So sehr ich Python liebe – manchmal will man einfach nur die Daten, ohne Setup, Debugging oder Wartung. Thunderbit ist eine KI-gestützte Web-Scraper Chrome-Erweiterung, mit der du Daten von jeder Website in wenigen Klicks extrahieren kannst.

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Thunderbits KI analysiert die Seite und schlägt vor, welche Daten du extrahieren kannst – ganz ohne HTML-Inspektion oder Selektoren.

- No-Code, direkt im Browser: Läuft im Browser, funktioniert also auch mit eingeloggten Seiten und JavaScript-lastigen Inhalten.

- Unterseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch Unterseiten (z. B. Produktdetails) und ergänzt deine Tabelle.

- Sofort-Export: Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable oder Notion – ganz ohne CSV-Gefrickel.

- Cloud- oder lokales Scraping: Wähle zwischen schnellem Cloud-Scraping (für öffentliche Seiten) oder Browser-Modus (für eingeloggte oder komplexe Seiten).

- Zeitplanung: Richte automatische Scrapes ein – ganz ohne Cronjobs oder Server.

Für Business-Anwender ist Thunderbit ein echter Gamechanger. Von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ in wenigen Minuten statt Stunden. Und für Entwickler ist Thunderbit die perfekte Ergänzung – für schnelle Jobs oder als Backup, wenn der eigene Code mal streikt.

Du willst es ausprobieren? und teste das Scraping auf deiner Lieblingsseite. Im kostenlosen Tarif kannst du einige Seiten extrahieren, die Bezahlpläne starten ab nur 15 $/Monat für 500 Credits.

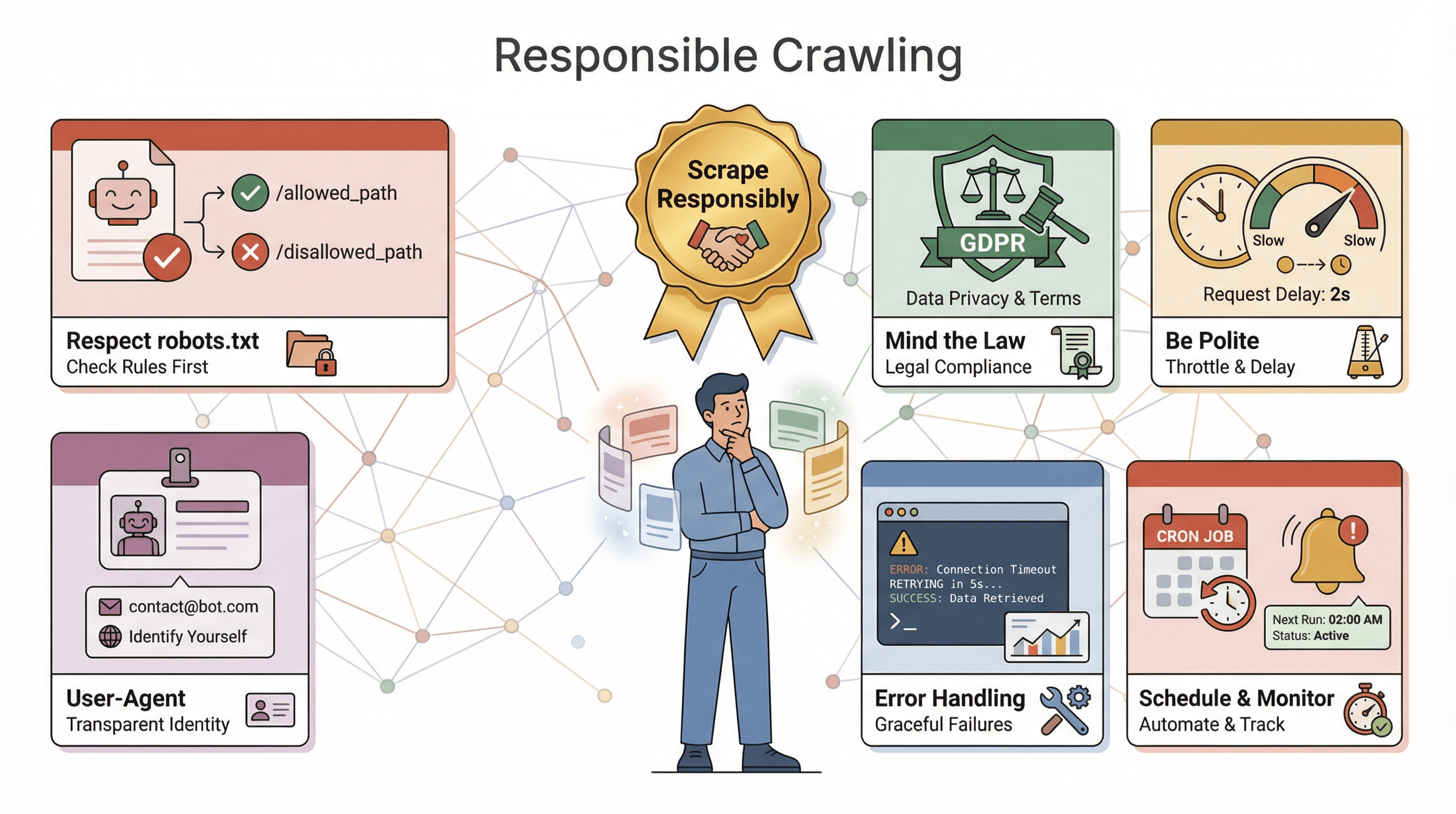

Wichtige Hinweise beim Bau eines Website-Crawlers mit Python

Bevor du deinen Crawler auf die Welt loslässt, ein paar wichtige Tipps:

Bevor du deinen Crawler auf die Welt loslässt, ein paar wichtige Tipps:

- robots.txt respektieren: Die meisten Seiten veröffentlichen eine

robots.txt, die Crawler-Regeln vorgibt. Wer sie ignoriert, riskiert Blockaden – oder Schlimmeres. Immer prüfen und einhalten (). - Rechtliche Vorgaben beachten: Manche Seiten verbieten Scraping in ihren Nutzungsbedingungen. Und beim Sammeln personenbezogener Daten gelten Datenschutzgesetze wie DSGVO oder CCPA (). Im Zweifel nur öffentliche, nicht-personenbezogene Daten sammeln.

- Höflich bleiben: Keine Flut an Anfragen – Crawler drosseln, Pausen einbauen und Stoßzeiten meiden.

- Sich identifizieren: Einen eigenen User-Agent nutzen, ggf. mit Kontaktinfo, besonders bei großem Umfang.

- Fehler und Logging: Webseiten ändern sich, Seiten können ausfallen, Daten werden chaotisch. Fehlerbehandlung, Logging und Monitoring einbauen, um schnell reagieren zu können.

- Zeitplanung und Überwachung: Für regelmäßige Crawls Zeitpläne (z. B. mit cron oder Thunderbits Scheduler) nutzen und Alarme einrichten, falls der Crawler ausfällt oder keine Daten mehr sammelt.

Die goldene Regel: Verantwortungsvoll scrapen. Das Web ist ein Gemeinschaftsgut – sei nicht der Bot, der alles kaputt macht.

Profi-Tipps: Python-Crawler skalieren und erweitern

Wenn du die Grundlagen drauf hast, kannst du deinen Crawler weiter ausbauen. Hier ein paar fortgeschrittene Tricks:

- JavaScript-Inhalte scrapen: Mit Selenium oder Playwright auch dynamisch geladene Daten extrahieren.

- Skalieren: Für große Projekte Scrapy oder asynchrone Bibliotheken (wie

aiohttp) für parallele Anfragen nutzen. - Proxies verwenden: IP-Adressen rotieren, um bei hohem Volumen Blockaden zu vermeiden.

- Datenpipelines automatisieren: Direkt in Datenbanken schreiben oder mit Cloud-Speicher für große Datenmengen arbeiten.

- Monitoring und Alarme: Logging, Health-Checks und Benachrichtigungen für langlaufende Crawler einrichten.

Wenn dein Crawler unternehmenskritisch wird, lohnt sich der Einsatz von Managed Services oder APIs. Und wenn du viele verschiedene Seiten scrapen willst, modularisiere deinen Code, damit du Parser schnell anpassen kannst.

Fazit & wichtigste Erkenntnisse

Einen Website-Crawler in Python zu bauen, ist eine der wertvollsten Skills in der heutigen datengetriebenen Welt. Das haben wir besprochen:

- Website-Crawler automatisieren das Besuchen und Extrahieren von Daten aus Webseiten – unverzichtbar für Automatisierung, Recherche und Wettbewerbsanalysen.

- Python ist die Top-Wahl für Crawler: einfache Syntax, starke Bibliotheken, riesige Community.

- Parsing-Methoden sind entscheidend: Regex für schnelle Lösungen, BeautifulSoup für die meisten Skripte, Scrapy für große Projekte.

- Schritt für Schritt kannst du von einer einzelnen Seite zum kompletten Website-Crawl und strukturierten Datenexport gelangen – ganz ohne Doktortitel.

- Thunderbit geht noch weiter: Mit KI, No-Code und Sofort-Export ist es ideal für Business-Anwender und alle, die schnell Ergebnisse wollen.

- Verantwortungsvolles Crawling ist Pflicht: Regeln beachten, Fehler abfangen, Ethik im Blick behalten.

- Skalierung ist mit den richtigen Tools möglich – ob Selenium für JavaScript, Scrapy für parallele Anfragen oder Thunderbit für No-Code-Automatisierung.

Am besten lernst du, indem du einfach loslegst – schreib ein Skript, probiere Thunderbit aus und entdecke, welche Daten du freischalten kannst. Das Web ist dein Datenbuffet – greif zu!

Du willst tiefer einsteigen? Hier findest du weitere Ressourcen:

- für weitere Tipps, Anleitungen und fortgeschrittene Techniken.

Viel Erfolg beim Crawlen – auf dass deine Scraper schnell, deine Daten sauber und dein Kaffee nie leer sind.

Häufige Fragen (FAQ)

1. Was ist der Unterschied zwischen einem Website-Crawler und einem Web-Scraper?

Ein Crawler besucht und entdeckt systematisch Webseiten (wie eine Karte erstellen), während ein Scraper gezielt Daten von diesen Seiten extrahiert. In der Praxis werden meist beide kombiniert: Erst crawlen, dann scrapen.

2. Warum ist Python so beliebt für Website-Crawler?

Python ist leicht zu lernen, bietet starke Bibliotheken (Requests, BeautifulSoup, Scrapy, Selenium) und hat eine riesige Community. Fast 70 % aller Web-Scraping-Projekte setzen auf Python – es ist der Branchenstandard.

3. Wann sollte ich Regex, BeautifulSoup oder Scrapy zum Parsen nutzen?

Regex eignet sich für einfache, vorhersehbare Muster. BeautifulSoup ist für die meisten Skripte ideal – einfach und flexibel. Scrapy ist perfekt für große oder produktive Crawler, die Geschwindigkeit, Parallelität und viele Features brauchen.

4. Wie unterscheidet sich Thunderbit vom Crawler-Coding in Python?

Mit Thunderbit kannst du Daten per KI und ohne Code extrahieren – einfach klicken, Felder auswählen und exportieren. Ideal für Business-Anwender oder schnelle Aufgaben. Python bietet mehr Kontrolle und Anpassung, erfordert aber Programmierung und Wartung.

5. Welche rechtlichen oder ethischen Aspekte muss ich beim Crawlen beachten?

Immer robots.txt prüfen und respektieren, die Nutzungsbedingungen der Seite einhalten, keine sensiblen oder personenbezogenen Daten ohne Einwilligung sammeln und die Anfragen drosseln, um Server nicht zu überlasten. Verantwortungsvolles Scraping hält das Web für alle offen.

Bereit zum Ausprobieren? oder starte deinen Lieblings-Python-Editor und leg los. Die Daten warten auf dich – hol sie dir!

Mehr erfahren