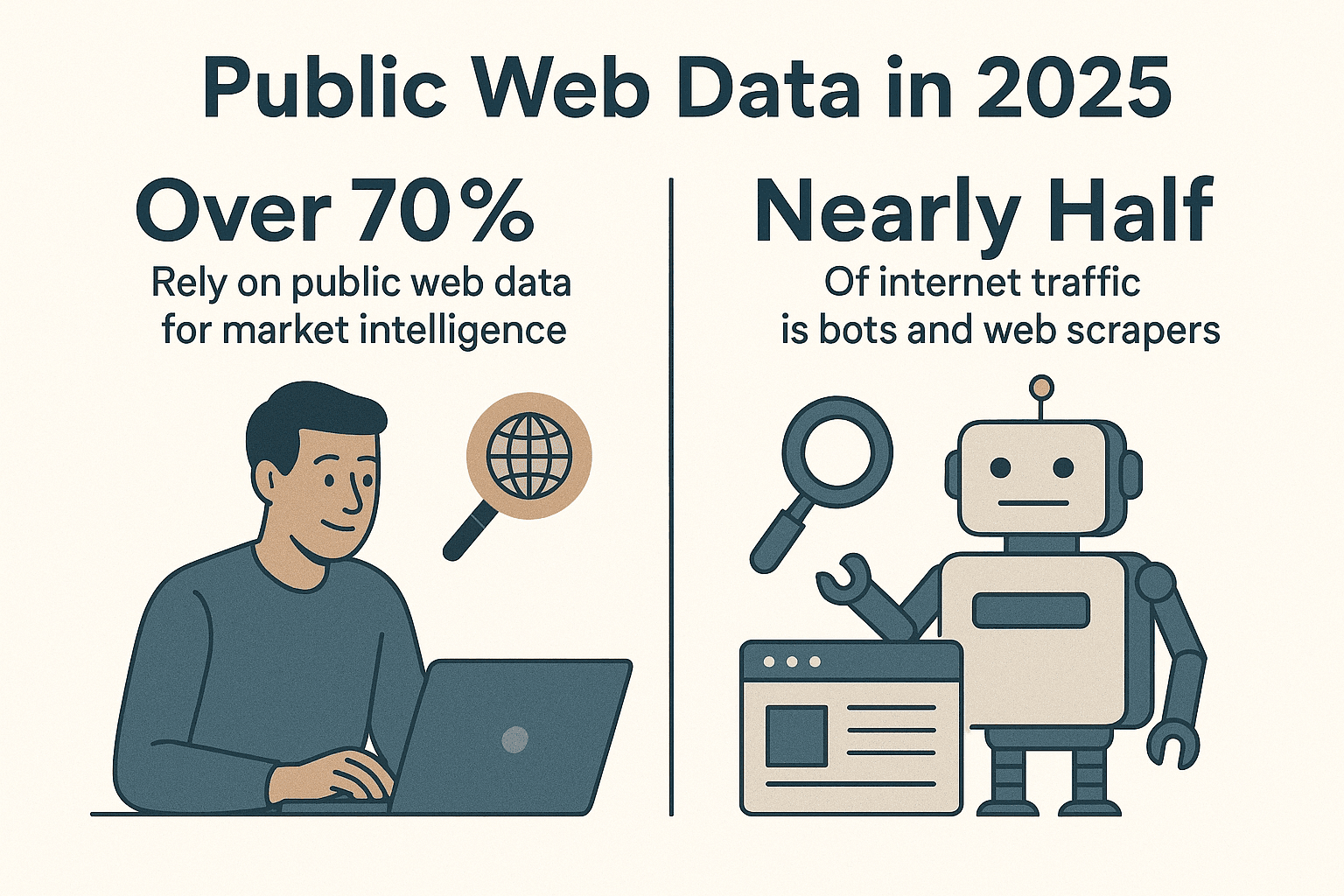

Das Internet ist ein riesiger Datenpool – und Unternehmen liefern sich ein Rennen darum, aus diesem Chaos echte Erkenntnisse zu ziehen. Über , und fast die Hälfte des gesamten Internet-Traffics wird heute von Bots und Web-Scrapern erzeugt, nicht von Menschen (). Nach vielen Jahren in der Automatisierung (und mit einigen Scraper-Skripten, die mehr Webseiten gesehen haben als ich selbst) kann ich nur sagen: Wer noch keinen Python-Web-Scraper für die Datenerfassung nutzt, lässt eine Menge Potenzial liegen.

Python ist beim Web Scraping einfach das Maß aller Dinge – und das aus gutem Grund. Egal ob Vertrieb, Marketing, Operations oder Forschung: Ein clever gebauter Python-Web-Scraper spart dir unzählige Stunden und liefert Einblicke, die du sonst kaum bekommen würdest. In dieser Anleitung zeige ich dir Schritt für Schritt, wie du einen effizienten Python-Web-Scraper aufsetzt, stelle meine Lieblingsbibliotheken und Best Practices vor und erkläre, wie Tools wie deinen Workflow aufs nächste Level bringen – gerade bei dynamischen Webseiten, die selbst erfahrene Entwickler manchmal zur Verzweiflung treiben.

Warum Python für Web-Scraper?

Ganz ehrlich: Python ist beim Web Scraping unschlagbar. Laut aktuellen Zahlen nutzen fast – weit vor JavaScript und anderen Sprachen. 2024 hat Python sogar JavaScript als beliebteste Sprache auf GitHub überholt (), vor allem dank seiner Stärke in Data Science und Automatisierung.

Was macht Python so stark für Web-Scraper?

- Lesbarkeit & Einfachheit: Die Syntax ist super klar – perfekt für Einsteiger und Profis, die schnell Ergebnisse wollen.

- Riesiges Bibliotheks-Ökosystem: Bibliotheken wie , , , und decken alles ab – vom Seitenabruf über HTML-Parsing bis zur Browser-Automatisierung.

- Aktive Community: Bei Problemen findest du unzählige Hilfestellungen, Tutorials und Codebeispiele.

- Flexibilität: Vom schnellen Einmal-Skript bis zum skalierbaren Scraper für tausende Seiten – alles ist möglich.

Im Vergleich zu anderen Sprachen bietet Python die perfekte Mischung aus Power und Zugänglichkeit. JavaScript (Node.js) ist zwar für dynamische Inhalte stark, aber das asynchrone Programmiermodell ist für viele Einsteiger eine echte Hürde. Java und C# sind robust, aber oft sperrig. Python nimmt dir die Hürden ab und lässt dich direkt mit den Daten arbeiten.

Die richtige Python-Umgebung für deinen Web-Scraper

Bevor du loslegst, solltest du deine Arbeitsumgebung sauber aufsetzen. So mache ich das:

1. Python 3 installieren

Hol dir die aktuelle Python 3.x-Version von oder nutze den Paketmanager deines Systems. Achte darauf, dass python oder python3 im Terminal funktioniert.

2. Virtuelle Umgebung anlegen

Halte die Abhängigkeiten deines Projekts sauber getrennt mit einer virtuellen Umgebung:

1python3 -m venv .venv

2# Auf Unix/Mac

3source .venv/bin/activate

4# Auf Windows

5.venv\Scripts\activateSo bleibt alles übersichtlich und Versionskonflikte sind kein Thema.

3. Wichtige Bibliotheken installieren

Mit aktivierter virtueller Umgebung installierst du die wichtigsten Pakete:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemyDas machen die einzelnen Bibliotheken:

- Requests: Holt Webseiten per HTTP ab.

- BeautifulSoup: Parst und durchsucht HTML.

- lxml: Schnelles HTML/XML-Parsing (wird von BeautifulSoup für Performance genutzt).

- Scrapy: Mächtiges Framework für große Crawling-Projekte.

- Selenium: Automatisiert Browser für dynamische, JavaScript-lastige Seiten.

- pandas: Für Datenbereinigung und -analyse.

- SQLAlchemy: Speichert Daten in Datenbanken.

Damit bist du startklar – vom schnellen Skript bis zum großen Scraper-Projekt.

Die passende Python-Scraper-Bibliothek wählen

Python bietet eine breite Auswahl an Tools fürs Scraping. So entscheide ich, was ich nutze:

| Bibliothek/Tool | Benutzerfreundlichkeit | Geschwindigkeit & Skalierung | Ideal für |

|---|---|---|---|

| Requests + BeautifulSoup | Sehr einfach | Mittel (eine Seite pro Durchlauf) | Einsteiger, statische Seiten, kleine Aufgaben |

| Scrapy | Etwas komplexer | Sehr schnell (async, parallel) | Große Crawls, ganze Websites |

| Selenium/Playwright | Mittel | Langsamer (Browser-Overhead) | JavaScript-Seiten, Login-Bereiche |

| aiohttp + asyncio | Mittel (async) | Sehr schnell (viele URLs gleichzeitig) | Massenscraping statischer Seiten |

| Thunderbit (No-Code) | Am einfachsten (KI-basiert) | Schnell (Cloud/Lokal) | Nicht-Programmierer, dynamische Seiten, schnelle Ergebnisse |

Meine Faustregel:

- Für ein paar statische Seiten: Requests + BeautifulSoup.

- Für hunderte oder tausende Seiten oder wenn du Crawling-Features brauchst: Scrapy.

- Für alles, was einen echten Browser benötigt (z. B. „Endlos-Scrollen“ oder Login): Selenium oder Playwright.

- Für „Ich brauche die Daten sofort und will nicht programmieren“: ist Gold wert.

Schritt-für-Schritt: Einen einfachen Python-Web-Scraper bauen

Wir bauen einen simplen Scraper, der die Story-Titel von Hacker News extrahiert – mein klassisches „Hello World“ fürs Web Scraping.

1. Webseite abrufen

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. HTML parsen

1soup = BeautifulSoup(html_content, "html.parser")3. Daten extrahieren

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. Paginierung behandeln

Hacker News hat unten einen „More“-Link. So folgst du ihm:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (Artikel wie oben extrahieren)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # Fair bleiben!

11 else:

12 page_url = None5. Fehlerbehandlung & Fairness

- Immer

response.status_codeprüfen. - Mit

time.sleep()Pausen einbauen, um Server nicht zu überlasten. - Einen eigenen User-Agent setzen:

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)Mit diesem Grundgerüst kannst du fast jede statische Seite scrapen. Für komplexere Aufgaben geht’s mit Scrapy weiter.

Deinen Scraper mit Scrapy erweitern

Wenn einfache Skripte nicht mehr reichen, ist Scrapy das nächste Level. So startest du:

1. Scrapy-Projekt anlegen

1scrapy startproject myspider2. Spider erstellen

In myspider/spiders/quotes_spider.py:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. Spider ausführen

1scrapy crawl quotes -o quotes.jsonScrapy übernimmt das Crawling, folgt Links, arbeitet parallel und exportiert die Daten direkt als JSON (oder CSV, XML etc.) – mit minimalem Code.

Warum ich Scrapy liebe:

- Integrierte Parallelisierung, Rate-Limiting und „freundliches“ Crawling

- Automatische Beachtung von robots.txt

- Einfache Datenexporte und Pipelines für Bereinigung/Speicherung

- Skaliert von wenigen Seiten bis zu Millionen

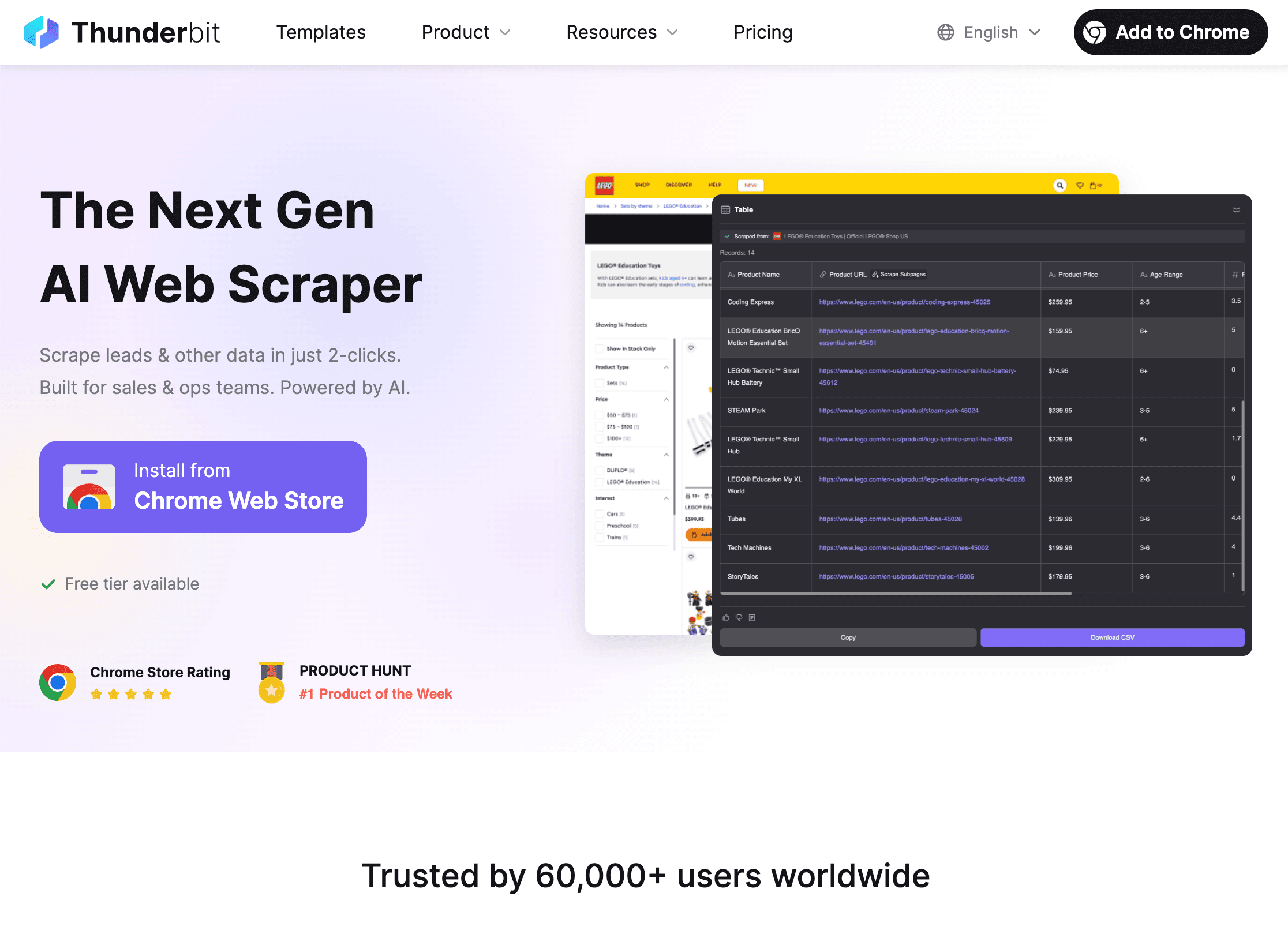

Mit Thunderbit Python-Scraper erweitern

Jetzt kommt der spannende Teil: dynamische Webseiten. So sehr ich Python mag – manche Seiten sind einfach nervig: endloses JavaScript, Anti-Bot-Maßnahmen oder ständig wechselnde Layouts. Genau hier kommt ins Spiel.

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Öffne die , klicke auf „KI-Felder vorschlagen“ und Thunderbit erkennt automatisch, welche Daten extrahiert werden sollten – ganz ohne HTML-Inspektion oder Selektoren.

- Unterseiten-Scraping: Thunderbit folgt Links zu Detailseiten (z. B. Produkt- oder Profilseiten) und fügt die Daten in deine Haupttabelle ein.

- Dynamische Inhalte meistern: Da Thunderbit im echten Browser läuft, lassen sich auch JavaScript-Seiten, Endlos-Scrolls und Formulare mit KI-Autofill extrahieren.

- No-Code, natürliche Sprache: Einfach beschreiben, was du brauchst („Alle Jobtitel und Standorte von dieser Seite extrahieren“) – Thunderbit erledigt den Rest.

- Sofortiger Datenexport: Exportiere deine Daten direkt nach CSV, Excel, Google Sheets, Airtable oder Notion – kostenlos und unbegrenzt.

- Geplantes Scraping: Lege wiederkehrende Jobs fest („jeden Tag um 9 Uhr“) und Thunderbit liefert automatisch frische Daten.

Wie Thunderbit Python ergänzt

Mein Lieblings-Workflow:

- Thunderbit nutzen für schwierige oder dynamische Seiten – besonders, wenn es schnell gehen muss oder du keinen fragilen Code pflegen willst.

- Daten als CSV oder Excel exportieren.

- In Python laden (z. B. mit pandas) für Bereinigung, Analyse oder weitere Automatisierung.

So bekommst du das Beste aus beiden Welten: Thunderbit übernimmt die Extraktion, Python die Datenverarbeitung.

Wann Thunderbit, wann Python?

- Thunderbit: Perfekt für Nicht-Programmierer, dynamische Seiten, schnelle Einzelaufgaben oder wenn Fachabteilungen selbst Daten ziehen wollen.

- Python: Für maßgeschneiderte Logik, große oder geplante Crawls oder tiefe Systemintegration.

- Beides: Thunderbit für die Extraktion, Python für Analyse und Automatisierung. Ich nenne das den „Erdnussbutter-und-Marmelade“-Ansatz – einzeln gut, zusammen unschlagbar.

Mehr zu hybriden Workflows findest du in .

Rechtliche Aspekte & Website-Regeln beachten

Web Scraping ist mächtig – aber mit großer Macht kommt auch Verantwortung (und manchmal eine wütende Mail vom Admin). So bleibst du auf der sicheren Seite:

1. robots.txt respektieren

Die meisten Seiten veröffentlichen eine robots.txt, die regelt, was gecrawlt werden darf. In Python kannst du das so prüfen:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("Scraping durch robots.txt untersagt")Scrapy hält sich standardmäßig an robots.txt (ROBOTSTXT_OBEY=True).

2. Fair bleiben

- Pausen einbauen (

time.sleep()oder Scrapy’sDOWNLOAD_DELAY), um Server nicht zu überlasten. - Einen klaren User-Agent mit Kontaktinfo setzen.

- Keine persönlichen oder geschützten Daten scrapen.

- Wenn eine Seite dich blockt oder darum bittet, aufzuhören: respektiere das.

3. Rate-Limits & CAPTCHAs beachten

- Bei 429-Fehlern („Too Many Requests“) langsamer werden oder Proxies nutzen.

- CAPTCHAs nicht umgehen – das ist ein Zeichen, dass du zu viel scrapest.

Mehr zu Ethik und Compliance beim Scraping findest du in .

Daten mit Python organisieren & speichern

Nach dem Scraping willst du die Daten bereinigen, transformieren und speichern. So gehe ich vor:

1. Mit pandas bereinigen & transformieren

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. Export nach CSV oder Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. In Datenbank speichern mit SQLAlchemy

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)So baust du dir eine komplette Datenpipeline – vom Scraper bis zum Dashboard.

Datenpipelines automatisieren

Für wiederkehrende Aufgaben alles automatisieren:

- Cronjobs: Python-Skripte regelmäßig (täglich, stündlich etc.) ausführen.

- Apache Airflow: Für komplexe Workflows – Airflow steuert Scraping, Bereinigung und Reporting.

- Thunderbit Scheduling: Thunderbit übernimmt das geplante Scraping, dein Python-Skript verarbeitet die neuen Daten weiter.

Mehr dazu in .

Python-Web-Scraper: Fehler beheben & optimieren

Auch die besten Scraper stoßen auf Probleme. Hier meine Checkliste für typische Fehlerquellen:

- Blockierte Anfragen (403/429): User-Agent rotieren, langsamer werden oder Proxies nutzen. robots.txt prüfen.

- Fehlende Daten: Selektoren kontrollieren – vielleicht hat sich das HTML geändert.

- Dynamische Inhalte: Selenium oder Thunderbit für JavaScript-Seiten nutzen.

- Performance: Async (aiohttp) oder Scrapy-Konkurrenz für Geschwindigkeit. Daten schrittweise speichern, um Speicher zu sparen.

- Debugging: Logs ausgeben, Browser-Dev-Tools nutzen und die Ergebnisse immer auf Plausibilität prüfen.

Weitere Tipps findest du in .

Fazit & wichtigste Erkenntnisse

Einen effizienten Python-Web-Scraper zu bauen, lohnt sich – du sparst Zeit und bekommst bessere Daten. Das Wichtigste im Überblick:

- Python ist die Top-Wahl für Web-Scraper – dank einfacher Syntax, starker Bibliotheken und großer Community.

- Richte deine Umgebung ein mit virtualenv und den passenden Bibliotheken (Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy).

- Wähle das richtige Tool: einfache Skripte für kleine Aufgaben, Scrapy für große Projekte, Selenium für dynamische Seiten, Thunderbit für No-Code/KI-Scraping.

- Schreibe saubere, faire Scraper, die robots.txt und die Regeln der Seiten respektieren.

- Daten speichern & verarbeiten mit pandas und SQLAlchemy – und automatisiere deine Pipeline für wiederkehrende Aufgaben.

- Python und Thunderbit kombinieren für maximale Flexibilität: KI übernimmt die Extraktion, Python die Analyse und Automatisierung.

Bereit für den nächsten Schritt? und erleben, wie einfach selbst komplexe Seiten gescraped werden können. Noch mehr Tipps und Praxisbeispiele gibt’s im .

Viel Erfolg beim Scraping – und möge dein Scraper immer die gewünschten Daten liefern (und nie im CAPTCHA-Netz hängen bleiben).

FAQs

1. Warum ist Python die beste Sprache für Web-Scraper?

Python überzeugt mit klarer Syntax, riesigem Bibliotheks-Ökosystem (Requests, BeautifulSoup, Scrapy) und einer aktiven Community. So lassen sich Web-Scraper schnell entwickeln, skalieren und pflegen – von Einsteigerprojekten bis zu professionellen Großprojekten.

2. Wann sollte ich Thunderbit statt eines eigenen Python-Scrapers nutzen?

Thunderbit ist ideal für Nicht-Programmierer, dynamische oder JavaScript-lastige Seiten oder wenn du schnell Daten brauchst, ohne Code zu schreiben oder zu pflegen. Für sehr individuelle, große oder tief integrierte Projekte bleibt Python die beste Wahl. Viele Teams nutzen beides: Thunderbit für die Extraktion, Python für die Analyse.

3. Wie stelle ich sicher, dass mein Web-Scraper legal und ethisch ist?

Immer robots.txt prüfen und respektieren, fair crawlen (Delays, User-Agent) und keine persönlichen oder geschützten Daten scrapen. Wenn eine Seite dich bittet, aufzuhören: Folge der Bitte. Mehr dazu in .

4. Wie speichere und verarbeite ich gescrapete Daten am besten?

Mit pandas Daten bereinigen und transformieren, für den Austausch als CSV/Excel exportieren und mit SQLAlchemy in Datenbanken (z. B. SQLite oder PostgreSQL) speichern – ideal für größere oder wiederkehrende Datensätze.

5. Wie kann ich meinen Web-Scraping-Workflow automatisieren?

Mit Cronjobs oder Apache Airflow Python-Skripte zeitgesteuert ausführen. Thunderbit unterstützt ebenfalls geplantes Scraping – kombiniert mit Python entsteht so eine vollautomatische Datenpipeline.

Mehr Praxistipps findest du in und auf dem mit Tutorials und Anleitungen.