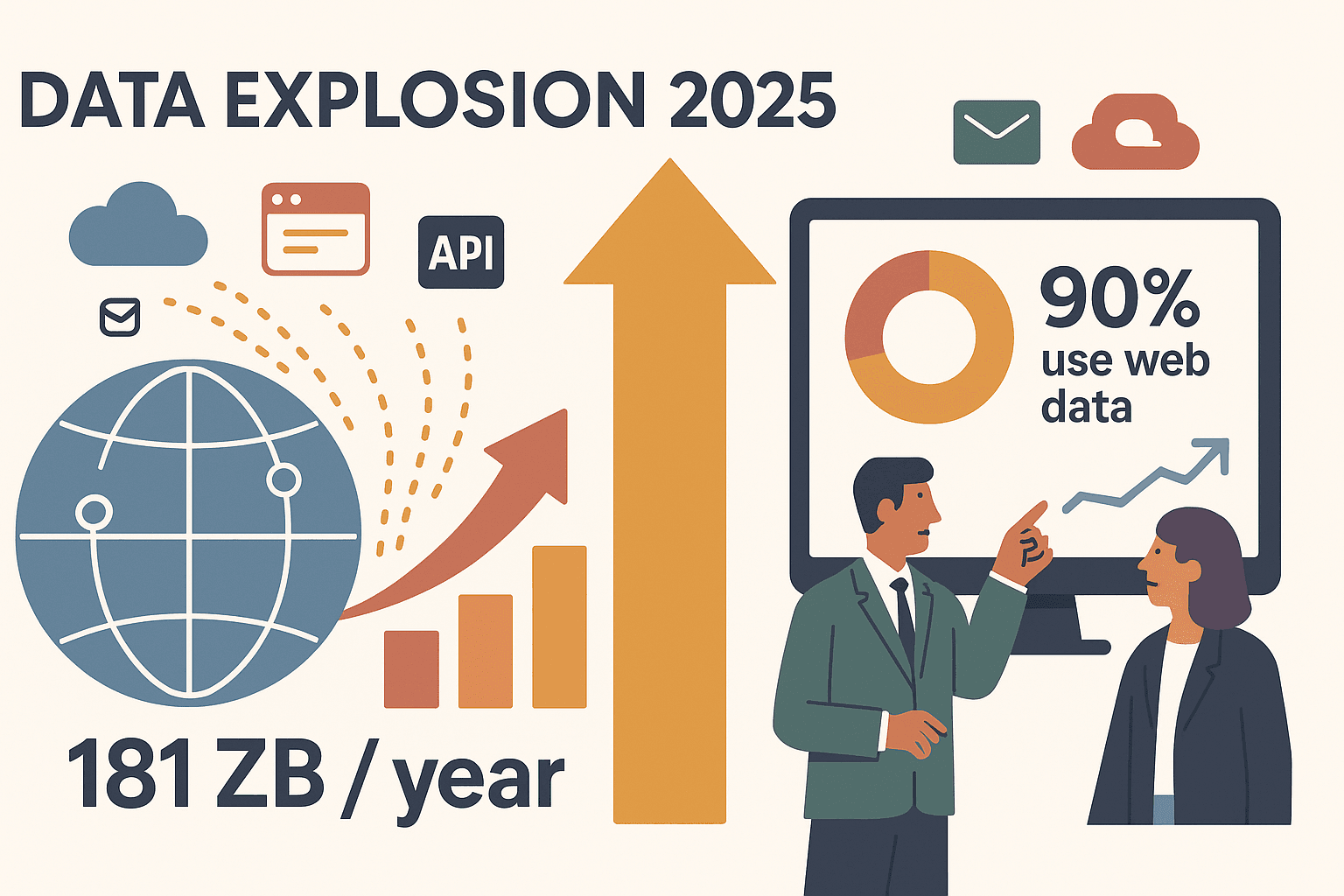

Das Internet ist im Jahr 2025 eine echte Goldmine an Daten – aber gleichzeitig auch ein ziemlich undurchsichtiger Dschungel. Unternehmen stehen jeden Tag vor der Aufgabe, aus diesem Chaos wertvolle Erkenntnisse, neue Leads und Umsatz zu ziehen. Ich habe es selbst erlebt: Teams, die früher stunden- oder tagelang Daten per Hand kopiert haben, automatisieren heute alles – von der Preisüberwachung bis zur Lead-Generierung – mit modernen scraping lösungen. Die Zahlen sprechen für sich: Bis 2025 werden weltweit über erzeugt, und fast setzen auf externe Webdaten für ihre Strategie.

Wie findet man nun das richtige Tool – egal ob Einzelunternehmer, Vertriebsteam oder Großunternehmen mit Big-Data-Plänen? Ich habe die 15 besten Web-Scraping-Lösungen für 2025 zusammengestellt: Von KI-gestützten No-Code-Tools wie bis hin zu Entwickler-Frameworks und Enterprise-Plattformen. Egal, ob du eine einfache Klick-Lösung oder maximale Anpassbarkeit suchst – dieser Guide hilft dir, das passende Werkzeug zu finden.

Warum Unternehmen 2025 scraping lösungen brauchen

Klartext: web scraping ist längst nicht mehr nur was für IT-Profis. Wer im Wettbewerb mithalten will, kommt daran nicht vorbei. Die wichtigsten Gründe:

- Schnellere Marktrecherche: Statt Praktikanten stundenlang Daten kopieren zu lassen, holen sich Unternehmen Produktinfos, Bewertungen oder News in wenigen Minuten. Immobilienfirmen analysieren so z. B. Angebote und Preistrends für Investitionsentscheidungen ().

- Lead-Generierung & Vertriebs-Insights: Vertriebsteams erstellen aktuelle Kontaktlisten durch Scraping von Verzeichnissen oder LinkedIn – schneller und mit frischeren Daten.

- Preisüberwachung & Wettbewerbsanalyse: E-Commerce-Teams checken täglich Preise und Lagerbestände der Konkurrenz. Da , ist Schnelligkeit entscheidend.

- Workflow-Automatisierung: Operations-Teams lassen Scraper regelmäßig Berichte erstellen oder Dashboards befüllen – und gewinnen so für wichtigere Aufgaben.

Das Fazit: scraping lösungen machen aus mühsamer Handarbeit automatisierte, zuverlässige Datenpipelines – damit dein Team sich auf die Analyse statt auf das Sammeln konzentrieren kann.

So haben wir die besten scraping lösungen ausgewählt

Bei der riesigen Auswahl an Tools habe ich mich auf die Kriterien konzentriert, die für Unternehmen 2025 wirklich zählen:

- Benutzerfreundlichkeit: Können auch Nicht-Programmierer direkt loslegen? Visuelle Editoren, Point-and-Click oder natürliche Sprache sind ein Plus.

- Anpassbarkeit: Wie viel Kontrolle gibt es für komplexe Projekte? Gibt es Scripting, KI oder einen Marktplatz für Vorlagen?

- Leistung & Skalierbarkeit: Kommt das Tool mit dynamischen Seiten, großen Datenmengen und geplanten Aufgaben klar? Ist es auch im großen Stil zuverlässig?

- Kompatibilität: Funktioniert es mit statischen Seiten, Infinite Scroll und Login-Bereichen?

- Preisgestaltung: Gibt es eine kostenlose Version? Ist das Preismodell für kleine Teams und große Unternehmen sinnvoll?

Die Liste deckt alles ab – von No-Code-Browser-Erweiterungen bis zu Enterprise-Plattformen und Entwickler-Frameworks. Los geht’s.

1. Thunderbit

ist meine Top-Empfehlung für Unternehmen, die eine KI-gestützte, komplett codefreie Lösung suchen. Als Mitgründer bin ich natürlich voreingenommen – aber ich habe Thunderbit entwickelt, weil ich gesehen habe, wie Vertrieb und Marketing an komplizierten Tools verzweifeln. Das macht Thunderbit besonders:

- KI-gestützte Einfachheit: Mit „KI Felder vorschlagen“ erkennt Thunderbit automatisch relevante Daten, schlägt Spalten vor und richtet den Web-Scraper ein. Einfach in Alltagssprache beschreiben, was du brauchst – ganz ohne Code oder Vorlagen.

- 2-Klick-Workflow: Seite aufrufen, „Scrapen“ klicken, fertig. Thunderbit übernimmt Unterseiten, Paginierung und sogar Bilder oder PDFs.

- Sofort-Export: Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable oder Notion – komplett kostenlos.

- Unterseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch jede Unterseite (z. B. Produktdetails oder LinkedIn-Profile) und ergänzt deine Tabelle.

- Vorlagen für beliebte Seiten: Für Amazon, Zillow, Instagram, Shopify und Co. gibt es fertige Templates für Ergebnisse mit nur einem Klick.

- Preise: Kostenlos für bis zu 6 Seiten (10 mit Testphase). Bezahlpläne ab 15 $/Monat für 500 Zeilen, größere Pakete für Teams.

Ideal für: Vertriebs-, Marketing-, E-Commerce- und Immobilienteams, die schnell und ohne Technikfrust an saubere Daten kommen wollen. Besonders beliebt bei Nicht-Technikern, die in Minuten statt Stunden Ergebnisse brauchen.

2. Octoparse

ist ein visuelles, komplett codefreies Web-Scraping-Tool mit Point-and-Click-Oberfläche. Besonders beliebt bei Einsteigern und kleinen Unternehmen dank:

- Intelligente Auto-Erkennung: Die KI erkennt oft Listen, Preise und Paginierung automatisch – einfach klicken und extrahieren.

- Cloud-Scraping & Zeitplanung: Aufgaben am Windows-PC erstellen, dann in der Cloud ausführen (PC muss nicht laufen). Wiederkehrende Jobs für tägliche oder wöchentliche Updates planen.

- Vorlagen für bekannte Seiten: Fertige Templates für Amazon, Google Maps, LinkedIn und mehr.

- Exportmöglichkeiten: Download als Excel, CSV, JSON oder direkt in Datenbanken und Google Sheets.

- Preise: Kostenlos für bis zu 10 lokale Aufgaben; Bezahlpläne ab ca. 89 $/Monat.

Ideal für: Kleine und mittlere Unternehmen, Analysten und Marketer, die ein leistungsstarkes No-Code-Tool mit Cloud-Skalierung suchen.

3. ParseHub

ist eine Desktop-App (Windows, Mac, Linux), die visuelle Einfachheit mit Low-Code-Power verbindet:

- Visueller Editor: Elemente anklicken, Daten auswählen, Workflows einrichten – inklusive Formulare, Dropdowns und mehrstufiger Navigation.

- Für dynamische Seiten: Funktioniert auch mit JavaScript-lastigen Seiten, Infinite Scroll und AJAX-Inhalten.

- Bedingte Logik: Mit Wenn/Dann-Verzweigungen und Schleifen auch komplexe Abläufe abbilden – ohne Code, aber mit viel Flexibilität.

- Cloud-Ausführung & API: Projekte in der Cloud ausführen, Jobs planen und per API integrieren.

- Preise: Kostenlos für 200 Seiten pro Durchlauf; Bezahlpläne ab 189 $/Monat.

Ideal für: Technikaffine Business-User und Analysten, die mehr Flexibilität als bei reinen No-Code-Tools wollen – besonders für Mac-Nutzer.

4. Scrapy

ist das Open-Source-Python-Framework und der Goldstandard für Entwickler:

- Vollständige Code-Kontrolle: Eigene Spider bauen, jede Website ansteuern und beliebig integrieren.

- Hochleistung: Asynchrones Crawling für riesige Datenmengen – Millionen von Seiten sind kein Problem.

- Großes Ökosystem: Viele Plugins, Middleware und eine starke Community.

- Kostenlos & Open Source: Keine Lizenzgebühren – nur Entwicklerzeit und Infrastruktur.

Ideal für: Entwicklerteams und Unternehmen, die großflächiges, individuell angepasstes Scraping benötigen. Mit Python-Kenntnissen ist Scrapy ein echtes Kraftpaket.

5. Import.io

ist eine Enterprise-Plattform für sofort nutzbare Webdaten:

- No-Code-Oberfläche + Managed Service: Point-and-Click-Einrichtung, auf Wunsch übernimmt das Import.io-Team Aufbau und Wartung der Scraper.

- Cloud-Automatisierung: Wiederkehrende Jobs planen, Logins verwalten und Daten in der Cloud verarbeiten.

- Datenintegration: Export per API, Webhooks oder direkt in Apps und Datenbanken.

- Datenaufbereitung: Daten vor dem Export mit Excel-ähnlichen Regeln bereinigen und transformieren.

- Preise: Individuelle Angebote, meist ab ca. 299 $/Monat.

Ideal für: Unternehmen, die zuverlässige, gemanagte Datenerfassung ohne eigenen Scraper-Bau suchen.

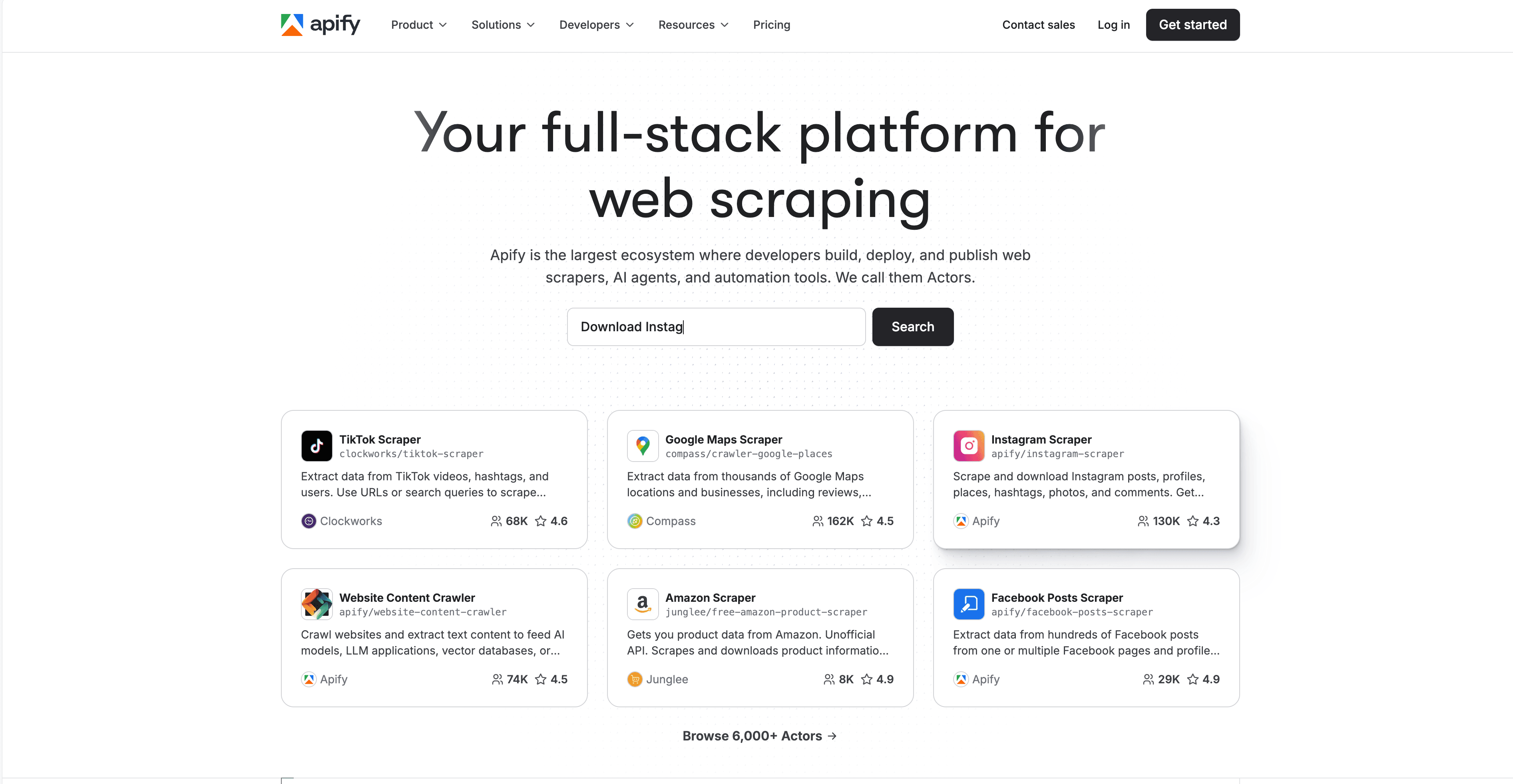

6. Apify

ist eine Cloud-Plattform mit einem einzigartigen Marktplatz für „Actors“ (vorgefertigte Scraper):

- Actor-Marktplatz: Fertige Scraper für Amazon, Twitter, Google Maps und mehr – einfach konfigurieren und starten.

- Eigene Scripte: Eigene Actors in JavaScript oder Python für maximale Flexibilität entwickeln.

- Cloud-Skalierung: Mehrere Jobs parallel ausführen, Headless-Browser und Proxies nutzen.

- API-Integration: Export zu JSON, CSV, Google Sheets oder per API/Webhooks.

- Preise: Kostenloses Kontingent; Bezahlpläne ab 39 $/Monat.

Ideal für: Entwickler und technikaffine Teams – oder Nicht-Programmierer, die auf Marktplatz-Actors für Standardaufgaben setzen.

7. WebHarvy

ist eine Windows-Desktop-App für visuelles, einfaches Scraping:

- Intuitive Oberfläche: Elemente anklicken, Daten erfassen – WebHarvy erkennt Muster und Listen automatisch.

- Paginierung & Infinite Scroll: Mehrseitiges Scraping und „Mehr laden“-Buttons werden unterstützt.

- Formularausfüllung: Ergebnisse für verschiedene Suchbegriffe oder URLs scrapen.

- Einmalige Lizenz: Ca. 129 $ pro Nutzer (inkl. 1 Jahr Updates).

- Export: CSV, Excel, XML oder direkt in Datenbanken.

Ideal für: Kleine Unternehmen, Marketer und Forscher, die ein einfaches, günstiges Desktop-Tool suchen.

8. Dexi.io

ist eine cloudbasierte Plattform für Scraping und Workflow-Automatisierung, speziell für Operations-Teams:

- Visueller Robot-Designer: Scraping-Bots im Browser-Editor zusammenstellen.

- Cloud-Planung: Jobs auf Dexi-Servern ausführen, wiederkehrende Aufgaben planen und Fortschritt überwachen.

- Datenverarbeitung: Daten direkt beim Extrahieren bereinigen, anreichern und transformieren.

- Teamarbeit: Mehrbenutzerverwaltung und rollenbasierte Zugriffsrechte.

- Preise: Individuell, meist einige Hundert Dollar pro Monat für KMU.

Ideal für: Operations- und Analyse-Teams im Handel, E-Commerce oder Marketing, die skalierbares, automatisiertes Scraping brauchen.

9. Data Miner

ist eine Chrome/Edge-Erweiterung für schnelles, vorlagenbasiertes Scraping:

- 60.000+ Vorlagen: Ein-Klick-Scraping für Google, LinkedIn, Amazon und mehr.

- Eigene Rezepte: Eigene Vorlagen durch Anklicken erstellen – ohne Programmierung.

- Browser-basiert: Scrapen, was du siehst – auch hinter Logins.

- Export: CSV, Excel, Google Sheets.

- Preise: Kostenlos für 500 Seiten/Monat; Bezahlpläne ab 19 $/Monat.

Ideal für: Profis, die schnell und flexibel Daten brauchen – z. B. Vertriebler oder Marketer für Lead-Listen.

10. Mozenda

ist eine cloudbasierte, Enterprise-taugliche Scraping-Plattform:

- Visueller Agent-Builder: Windows-App für Point-and-Click-Einrichtung.

- Cloud-Ausführung: Agents in der Cloud ausführen, Jobs planen und Daten zentral verwalten.

- Teamarbeit: Mehrbenutzerverwaltung und rollenbasierte Rechte.

- Starker Support: Schulungen, Onboarding und Live-Hilfe für Unternehmenskunden.

- Preise: Ab ca. 99 $/Monat; Enterprise-Preise auf Anfrage.

Ideal für: Unternehmen und Organisationen, die skalierbare, wiederholbare Datenerfassung mit starkem Support benötigen.

11. OutWit Hub

ist eine Desktop-App (Windows, Mac, Linux) für visuelles, einsteigerfreundliches Scraping:

- Automatische Datenerkennung: Ein-Klick-Extraktion von Links, Bildern, E-Mails und mehr.

- Point-and-Click-Auswahl: Datenmuster markieren und strukturiert extrahieren.

- Verschiedene Datentypen: Text, Bilder, Dateien und mehr scrapen.

- Preise: Kostenlose Version mit Limits; Premium ca. 75 € einmalig.

Ideal für: Journalisten, Forscher oder kleine Unternehmen, die ein einfaches Desktop-Tool für verschiedene Scraping-Aufgaben suchen.

12. Visual Web Ripper

ist ein fortgeschrittener Windows-Desktop-Scraper für Power-User:

- Visueller Projekt-Designer: Vorlagen für komplexe Seiten, inklusive Paginierung und Unterseiten, erstellen.

- Zeitplanung & Automatisierung: Projekte zu festen Zeiten ausführen, Exporte automatisieren.

- Datenverarbeitung: Daten direkt beim Extrahieren bereinigen und transformieren.

- Einmalige Lizenz: Ca. 349 $ pro Nutzer.

Ideal für: Datenprofis und KMU, die leistungsstarkes Scraping auf Windows ohne laufende Kosten suchen.

13. Content Grabber

ist ein Enterprise-Desktop/Web-Scraper für Datenprofis und Agenturen:

- Erweiterte Studio-Umgebung: Visuelles Design plus C#-Scripting für individuelle Logik.

- Automatisierung & Zeitplanung: Hunderte Agents verwalten, parallel ausführen und mit anderen Systemen integrieren.

- Integration: Export zu Datenbanken, APIs oder sogar als eigenständige Scraper für Kunden.

- Preise: Professional/Enterprise-Lizenzen im vierstelligen Bereich (keine kostenlose Version).

Ideal für: Agenturen, große Unternehmen oder SaaS-Anbieter, für die Web-Scraping geschäftskritisch ist.

14. 80legs

ist ein cloudbasierter Web-Crawling-Service für Big Data:

- Enorme Skalierung: Bis zu 10 Millionen+ Seiten pro Job crawlen.

- Individuelle Extraktion: Mit Mustern oder Regex festlegen, welche Daten extrahiert werden.

- API-Zugriff: Crawls programmatisch konfigurieren und steuern.

- Preise: Kostenlos für bis zu 10.000 URLs pro Crawl; Bezahlpläne ab 29 $/Monat.

Ideal für: Data Scientists, Entwickler oder Unternehmen, die riesige Teile des Webs für Analysen oder Forschung crawlen müssen.

15. Diffbot

ist eine KI-basierte Plattform, die unstrukturierte Webinhalte in strukturierte Daten verwandelt:

- Automatische Seiteninterpretation: URL eingeben, strukturierte JSON-Daten (Artikel, Produkte, Diskussionen etc.) erhalten – ganz ohne Konfiguration.

- APIs für alle Content-Typen: Article API, Product API, Knowledge Graph und mehr.

- Crawlbot: Ganze Websites crawlen und Ergebnisse in Diffbots KI einspeisen.

- Preise: Pläne ab ca. 299 $/Monat; nutzungsbasiert für große Volumen.

Ideal für: Unternehmen und Entwickler, die hochwertige, strukturierte Daten aus verschiedensten Quellen ohne eigenen Scraper benötigen.

Vergleichstabelle der scraping lösungen

Hier ein schneller Überblick zum Vergleich:

| Tool | Hauptfunktionen | Benutzerfreundlichkeit | Anpassbarkeit | Leistung & Skalierung | Kompatibilität | Preis | Ideal für |

|---|---|---|---|---|---|---|---|

| Thunderbit | KI, 2-Klick, Unterseiten, Vorlagen | Sehr einfach | Mittel | Gut (Cloud/Lokal) | Alle Browser-Seiten | Kostenlos/ab 15 $ | Vertrieb, Marketing, No-Coder |

| Octoparse | Visuell, Cloud, Vorlagen | Einfach | Mittel | Hoch (Cloud) | Dynamisch, AJAX | Kostenlos/ab 89 $ | KMU, Analysten, Einsteiger |

| ParseHub | Visuell, Low-Code, API | Mittel | Hoch | Hoch (Cloud) | JS-lastig, komplex | Kostenlos/ab 189 $ | Technikaffine, Mac-Nutzer |

| Scrapy | Python, Code, skalierbar | Schwierig (nur Devs) | Sehr hoch | Exzellent | Jede Seite (mit Code) | Kostenlos | Entwickler, Big Data |

| Import.io | Managed, Cloud, API, Transformationen | Mittel | Mittel | Hoch (Enterprise) | Komplex, Login | ab 299 $/Monat | Unternehmen, Managed Service |

| Apify | Marktplatz, Scripting, Cloud | Einfach/Mittel | Sehr hoch | Hoch (Cloud) | Alle (JS, Headless) | Kostenlos/ab 39 $ | Devs, Fortgeschrittene |

| WebHarvy | Desktop, Point-and-Click | Sehr einfach | Niedrig/Mittel | Mittel | Meist statisch/dynamisch | 129 $ einmalig | KMU, Marketer, Windows |

| Dexi.io | Cloud, visuell, Automatisierung, Team | Mittel | Hoch | Enterprise | Meist inkl. Login | Individuell/ab 200$ | Ops, Handel, E-Commerce |

| Data Miner | Browser-Ext, Vorlagen, schneller Export | Sehr einfach | Niedrig | Mittel | Meist Browser-Seiten | Kostenlos/ab 19 $ | Schnell, Ad-hoc, No-Coder |

| Mozenda | Cloud, visuell, Team, Support | Einfach (nach Einarb) | Mittel | Hoch (Cloud) | Dynamisch, Login | ab 99 $/Monat | Unternehmen, Forschung |

| OutWit Hub | Desktop, Auto-Erkennung, Multi-Daten | Einfach | Niedrig/Mittel | Mittel | Meist statisch | Kostenlos/75 € | Journalisten, Forscher |

| Visual Web Ripper | Desktop, fortgeschritten visuell, Zeitplan | Mittel | Hoch | Hoch (Lokal) | Komplex, Formulare | 349 $ einmalig | Datenprofis, KMU, Windows |

| Content Grabber | Desktop/Web, Scripting, SDK | Schwierig (Dev/IT) | Sehr hoch | Sehr hoch | Alle (mit Code) | $$$ (Enterprise) | Agenturen, SaaS, Enterprise |

| 80legs | Cloud, massive Skalierung, API | Mittel (Tech nötig) | Mittel | Exzellent | Riesige Web-Skala | Kostenlos/ab 29 $ | Big Data, Forschung, Crawling |

| Diffbot | KI, APIs, Knowledge Graph | Einfach (für Devs) | Niedrig (User) | Hoch (Cloud) | Alle, JS-lastig, KI | ab 299 $/Monat | Enterprise, KI, strukturiert |

Wie du die richtige scraping lösung für dein Unternehmen findest

Hier meine Schnellübersicht zur Auswahl:

-

Technisches Know-how:

- Keine Programmierkenntnisse? Thunderbit, Octoparse, WebHarvy, Data Miner oder Mozenda.

- Grundkenntnisse? ParseHub, Apify oder Visual Web Ripper.

- Entwicklerteam? Scrapy, Content Grabber oder 80legs.

-

Datenmenge & Häufigkeit:

- Gelegentliche/kleine Jobs: Data Miner, WebHarvy, OutWit Hub.

- Regelmäßig/mittlere Jobs: Thunderbit, Octoparse, Dexi.io, Mozenda.

- Große Datenmengen: Scrapy, Apify, 80legs, Diffbot.

-

Website-Komplexität:

- Statisch/einfach: Jedes Tool.

- Dynamisch/JS-lastig: Octoparse, ParseHub, Apify, Diffbot, Content Grabber.

-

Integrationsbedarf:

- Export nach Excel/Sheets? Thunderbit, Octoparse, Data Miner.

- API/Datenbank-Integration? Import.io, Apify, Dexi.io, Content Grabber.

-

Budget:

- Kostenlos/günstig: Thunderbit (Free-Tier), Data Miner, Scrapy, WebHarvy (Einmalzahlung).

- Enterprise: Import.io, Mozenda, Dexi.io, Diffbot, Content Grabber.

-

Support & Wartung:

- Managed Service gewünscht? Import.io, Mozenda, Dexi.io.

- DIY mit Community-Support? Scrapy, Apify.

Teste immer zuerst die kostenlose Version oder Testphase – so findest du am besten heraus, welches Tool zu deinem Workflow und Datenbedarf passt.

Praxisbeispiele & typische Herausforderungen

E-Commerce-Preisüberwachung:

Ein mittelständischer Händler nutzte Dexi.io, um täglich Preise von 500 Konkurrenzprodukten zu scrapen. Automatisierung sparte 4 Stunden pro Tag und steigerte den Umsatz um .

Lead-Generierung im Vertrieb:

Ein B2B-Vertriebsteam nutzte Thunderbit, um Branchendatenbanken zu scrapen – zwei Tage Handarbeit wurden auf 10 Minuten reduziert. Im Quartal wurden 5.000 Leads generiert und der Vertriebspipeline ein starker Schub gegeben ().

Journalismus & Forschung:

Ein Journalist nutzte Diffbots Article API, um 1.200 Nachrichtenartikel in einer Woche zu extrahieren – eine Arbeit, die sonst einen Monat gedauert hätte ().

Typische Herausforderungen:

- Anti-Bot-Maßnahmen: Tools mit Proxy-Rotation (Dexi, Apify) oder browserbasiertem Scraping (Thunderbit) helfen, Blockaden zu vermeiden.

- Datenbereinigung: Feld-Prompts (Thunderbit) oder integrierte Transformationen (Import.io, Mozenda) sorgen für saubere Daten.

- Seitenänderungen: Tools mit KI oder Auto-Healing (Diffbot, Thunderbit) passen sich automatisch an Layout-Änderungen an.

Fazit: So findest du deine ideale scraping lösung

Webdaten sind 2025 der Schlüssel für klügere Geschäftsentscheidungen. Ob Vertriebspipeline, Preisüberwachung oder Analysen – mit der richtigen scraping lösung sparst du Zeit, steigerst die Genauigkeit und erschließt neue Chancen.

- No-Coder: Thunderbit, Octoparse, Data Miner, WebHarvy.

- Technikaffine Teams: ParseHub, Apify, Visual Web Ripper.

- Entwickler/Enterprise: Scrapy, Import.io, Dexi.io, Content Grabber, Diffbot, 80legs.

Die meisten Tools bieten kostenlose Testphasen – probiere aus, was zu dir passt, und kombiniere ruhig verschiedene Lösungen für unterschiedliche Projekte. Wenn du sehen willst, wie KI das Scraping revolutioniert, .

Viel Erfolg beim Scrapen – und mögen deine Daten immer sauber, strukturiert und einsatzbereit sein. Für weitere Praxistipps und Anleitungen schau auf dem vorbei.

FAQs

1. Was ist der Hauptvorteil von Web-Scraping-Lösungen für Unternehmen?

Web-Scraping-Lösungen automatisieren die Datenerfassung von Websites, sparen Zeit, reduzieren Fehler und ermöglichen Echtzeit-Insights für Vertrieb, Marketing und Operations.

2. Welche Scraping-Lösung eignet sich am besten für Nicht-Techniker?

Thunderbit, Octoparse, WebHarvy und Data Miner sind speziell für No-Coder konzipiert und bieten visuelle Oberflächen sowie KI-gestützte Einrichtung.

3. Wie gehe ich mit Websites um, die Scraping blockieren?

Nutze Tools mit integrierter Proxy-Rotation (Dexi.io, Apify) oder browserbasiertem Scraping (Thunderbit). Für große Projekte eignen sich Plattformen wie 80legs oder Diffbot.

4. Was tun, wenn sich das Layout der Zielseite ändert?

Setze auf scraping lösungen mit KI oder Auto-Healing (Thunderbit, Diffbot) – oder passe deine Vorlagen/Skripte bei Bedarf an.

5. Ist Web-Scraping für Unternehmen legal und ethisch?

Das Scrapen öffentlicher Daten ist meist legal, aber prüfe immer die Nutzungsbedingungen und Datenschutzrichtlinien der Website. Verzichte auf das Scrapen persönlicher oder sensibler Daten und respektiere nach Möglichkeit die robots.txt.