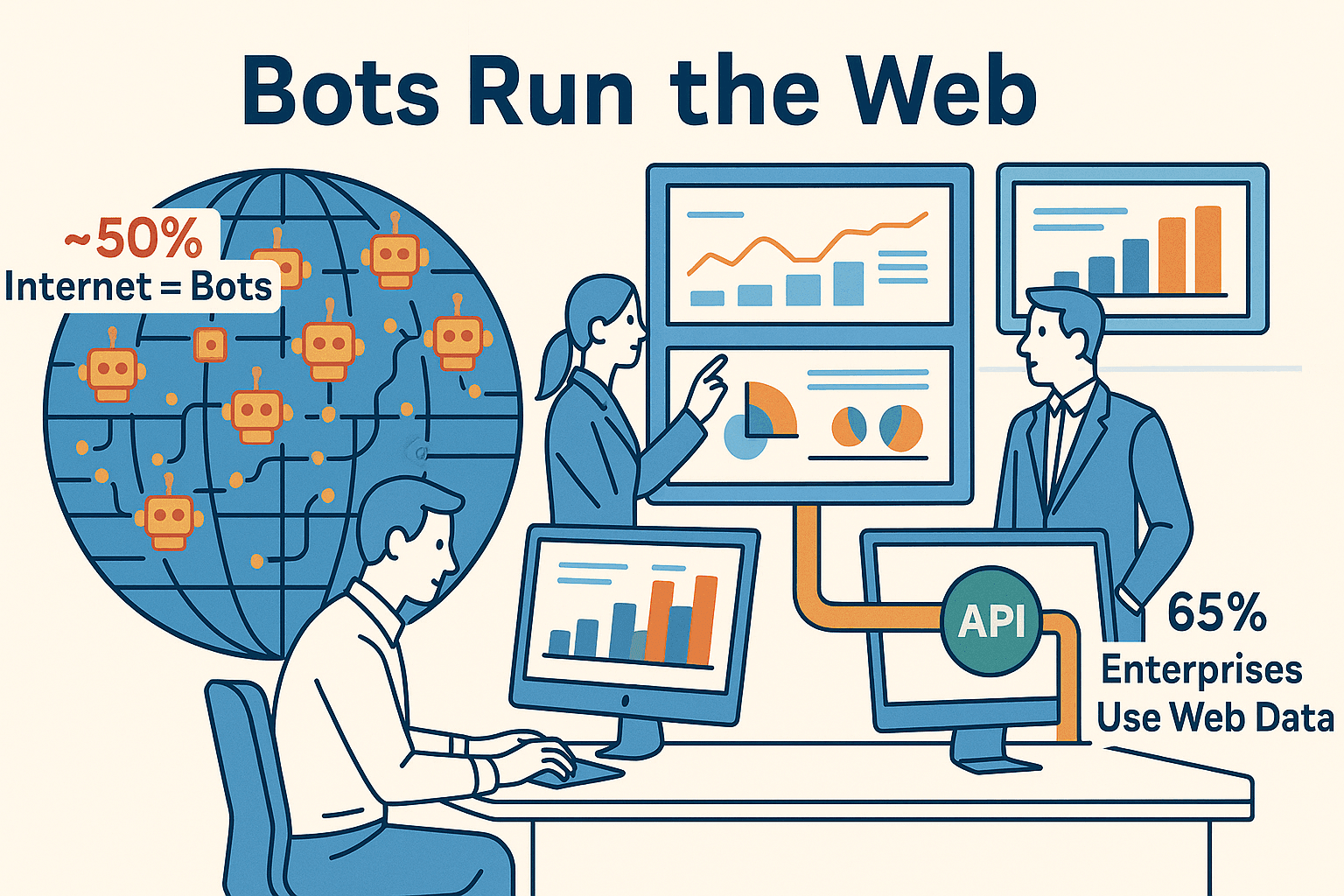

In der Datenwelt gibt’s einen Spruch, den fast jeder schon mal gehört hat: „Wer nicht scraped, kopiert wahrscheinlich immer noch alles per Hand.“ Aber mal ehrlich – Copy & Paste ist heute einfach nicht mehr zeitgemäß. Fast , und setzen auf Webdaten-Extraktion für ihre Analysen. KI-Web-Scraper und web scraping apis sind längst keine Spielerei mehr, sondern gehören zur Grundausstattung moderner Unternehmen. Egal ob Vertrieb, E-Commerce oder Operations – aus chaotischen Webseiten strukturierte Daten zu machen, ist heute Standard.

Aber Hand aufs Herz: Web Scraping ist oft alles andere als ein Spaziergang. Webseiten ändern ständig ihr Design, setzen CAPTCHAs ein oder verstecken Daten hinter kompliziertem JavaScript. Genau hier kommen web scraping apis ins Spiel – sie machen das Sammeln von Daten viel smarter, schneller und stressfreier. In diesem Beitrag zeige ich dir die acht besten web scraping apis für 2025, vergleiche ihre Stärken und helfe dir, das richtige Tool für dein Team zu finden – egal ob du im Marketing ohne Programmierkenntnisse unterwegs bist oder als Entwickler in Python denkst.

Warum web scraping apis für moderne Datensammler unverzichtbar sind

Kommen wir direkt zum Punkt: web scraping apis sind das Geheimrezept für datenhungrige Teams. Sie nehmen dir die lästige Arbeit ab, Infos von Webseiten zu holen, und sparen dir so Stunden oder sogar Tage, die du sonst mit Copy & Paste verbringen würdest. Tatsächlich sind als klassische Methoden.

Aber es geht nicht nur um Tempo. Die besten web scraping apis übernehmen auch die nervigen Aufgaben – sie passen sich an Webseitenänderungen an, führen JavaScript aus und umgehen Anti-Bot-Maßnahmen. Das Ergebnis: saubere, strukturierte Daten (z. B. als CSV, JSON oder direkt in Google Sheets), die du easy in Analysen, CRM oder BI-Dashboards einbauen kannst.

Hier punkten web scraping apis besonders für Unternehmen:

- Lead-Generierung: Kontaktdaten aus hunderten Verzeichnissen oder Social-Media-Profilen über Nacht einsammeln.

- Preisüberwachung: Wettbewerberpreise oder Lagerbestände täglich automatisch checken.

- Marktforschung: Bewertungen, News oder Social-Media-Stimmungen im großen Stil sammeln.

- Wettbewerbsanalyse: Neue Stellenanzeigen, Produkt-Launches oder Content-Updates automatisch im Blick behalten.

Das Beste: Viele dieser Tools sind extra für Nicht-Techniker gemacht und bieten No-Code-Oberflächen oder sogar natürliche Spracheingabe. Das heißt, du kannst auch ohne HTML-Kenntnisse deine Datensammlung professionell automatisieren.

So haben wir die besten web scraping apis bewertet

Nicht jede web scraping api ist gleich. Manche richten sich an Entwickler, andere an Business-User. Einige meistern komplexe Seiten, andere scheitern schon am ersten CAPTCHA. Nach diesen fünf Kriterien habe ich die Tools bewertet:

- Stabilität der Extraktion: Holt die API zuverlässig Daten – auch wenn sich Webseiten ändern?

- Umgang mit komplexen Seiten: Kommt sie mit JavaScript, Endlos-Scrollen oder Anti-Bot-Maßnahmen wie CAPTCHAs klar?

- Benutzerfreundlichkeit: Ist die Oberfläche auch für Nicht-Programmierer verständlich oder braucht man Regex-Kenntnisse?

- Dokumentation & Support: Gibt es verständliche Anleitungen, Tutorials und schnellen Support bei Problemen?

- Preis & Kosten-Nutzen: Ist das Tool für deinen Bedarf bezahlbar, mit transparenten Preisen und Testmöglichkeiten?

Mit diesen Kriterien im Hinterkopf stelle ich dir die acht besten web scraping apis für 2025 vor.

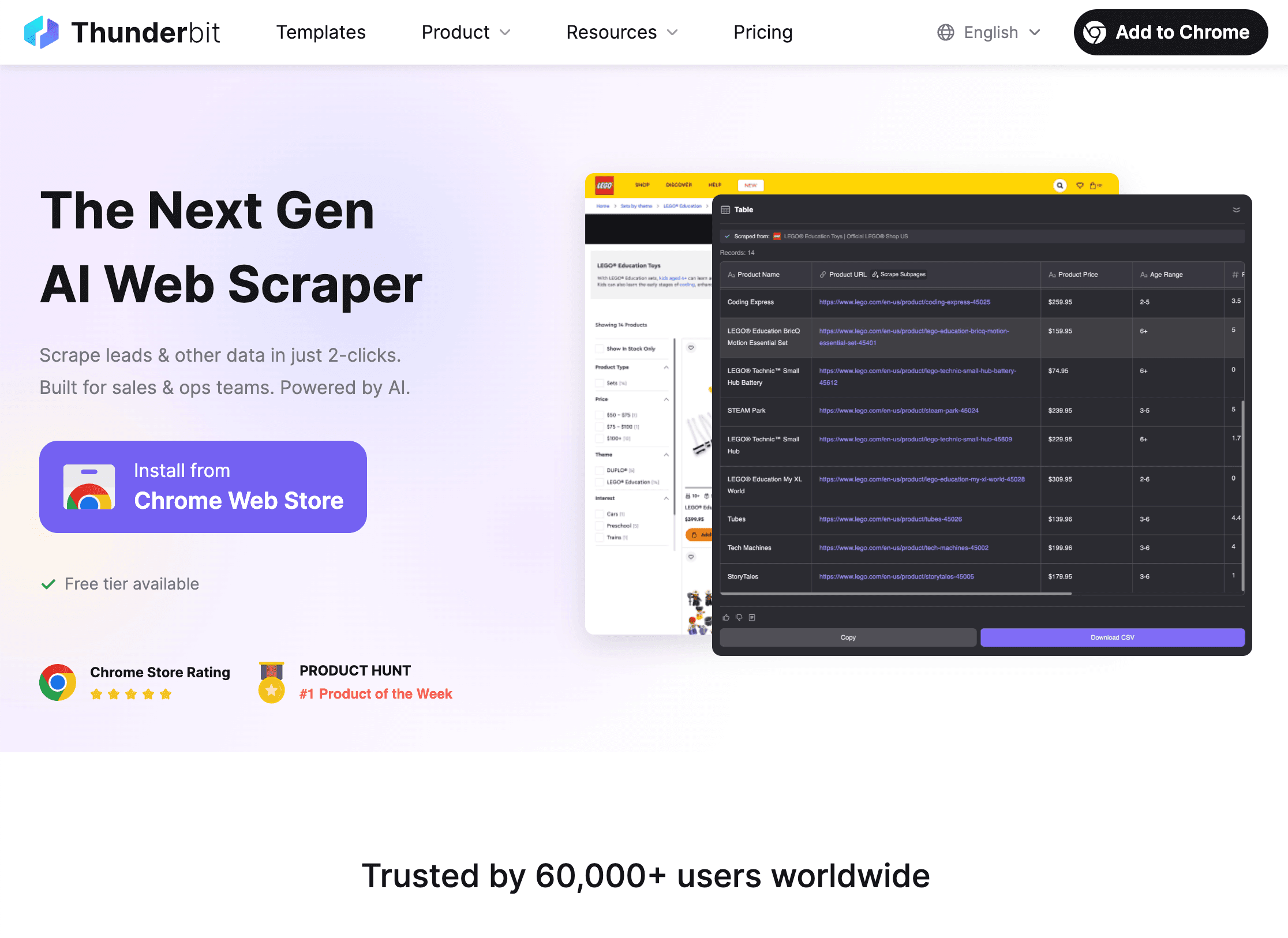

1. Thunderbit

ist meine absolute Empfehlung für Business-User, die KI-gestütztes Web Scraping ohne Technik-Stress wollen. Als Mitgründer bin ich natürlich etwas voreingenommen – aber ich habe selbst gesehen, wie viel Zeit Thunderbit Teams spart, die einfach nur Daten brauchen, ohne sich mit Technik herumzuschlagen.

Was macht Thunderbit besonders? Es ist die KI-gestützte Einfachheit. Du beschreibst einfach in Alltagssprache, was du brauchst („Alle Produktnamen und Preise von dieser Seite extrahieren“), und Thunderbits KI erledigt den Rest. Mit „AI Suggest Fields“ schlägt das Tool passende Spalten vor – du prüfst, klickst auf „Scrape“ und bist fertig. Kein Programmieren, kein Selektoren-Gefrickel, kein Frust.

Wichtige Funktionen:

- Aufgaben per natürlicher Sprache: Sag der KI einfach, was du willst – ganz ohne Fachchinesisch.

- KI-Feldvorschläge: Thunderbit analysiert die Seite und schlägt die besten Spalten vor, auch bei unstrukturierten Daten.

- Unterseiten & Paginierung: Details von Produktseiten oder mehrseitigen Listen? Thunderbit klickt automatisch weiter, folgt Links und ergänzt deine Tabelle.

- Strukturierte & unstrukturierte Daten: Scraping von Webseiten, PDFs oder Bildern – dank OCR liest Thunderbit Text überall aus.

- Automatische Anpassung: Die KI passt sich Layout-Änderungen an, sodass deine Scraper nicht bei jedem Redesign ausfallen.

- Exportoptionen: Daten direkt nach Excel, Google Sheets, Airtable oder Notion senden. Export ist immer kostenlos.

- Flexible Preise: Kostenlos für 6 Seiten, Testversion für 10 Seiten, und bezahlte Pläne ab ca. 16,50 $/Monat (jährlich).

Ideal für: Vertriebsteams beim Aufbau von Lead-Listen, E-Commerce-Teams für Preisüberwachung, Immobilienmakler für Objektdaten – oder alle, die ohne Programmierung leistungsstark scrapen wollen.

Mehr dazu findest du im oder auf der .

2. Scrapy

ist das Open-Source-Kraftpaket für Entwickler, die maximale Kontrolle wollen. In Python geschrieben, ist Scrapy das Schweizer Taschenmesser unter den web scraping tools – flexibel, schnell und fast grenzenlos anpassbar.

Wichtige Funktionen:

- Vollständige Anpassbarkeit: Eigene Spider in Python schreiben, um Daten nach Wunsch zu crawlen und zu verarbeiten.

- Hohe Performance: Asynchrone Engine lädt hunderte Seiten pro Minute.

- Skalierbar: Unterstützt Proxies, Headless-Browser und Cloud-Deployments für große Projekte.

- Großes Ökosystem: Viele Plugins, Middleware und Community-Support.

- Kostenlos & Open Source: Keine Lizenzgebühren – nur dein Know-how und deine Zeit.

Nachteile: Scrapy ist rein codebasiert – es gibt keine grafische Oberfläche oder No-Code-Option. Python-Kenntnisse und Wartungsaufwand sind Pflicht.

Ideal für: Entwickler, Data Engineers und Teams, die maßgeschneiderte, groß angelegte Scraping-Projekte mit Python-Integration umsetzen wollen.

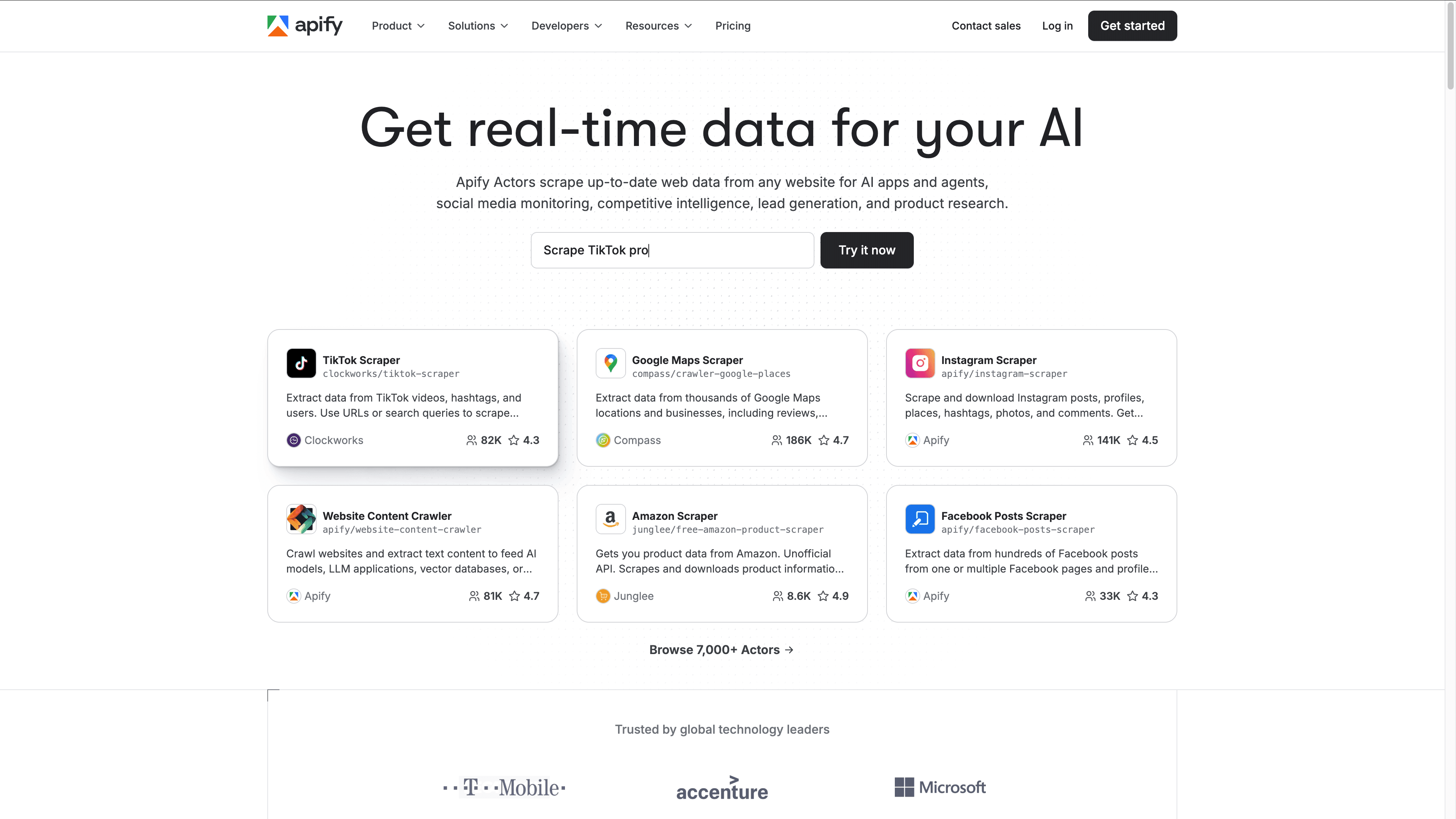

3. Apify

bietet eine Mischung aus sofort einsatzbereiten Lösungen und tiefer Anpassbarkeit. Die Cloud-Plattform ist ein Web-Scraping-Hub mit einem Marktplatz für vorgefertigte „Actors“ (Scraping-Bots) für beliebte Seiten – oder du programmierst eigene in JavaScript oder Python.

Wichtige Funktionen:

- Marktplatz mit 200+ Actors: Amazon, Twitter, Google Maps und mehr mit wenigen Klicks scrapen.

- Benutzerfreundliche Oberfläche: Scraper im Browser starten, Fortschritt überwachen und Ergebnisse in der Cloud ansehen.

- Eigene Scripte: Eigene Actors für individuelle Anforderungen erstellen und Apifys Infrastruktur nutzen.

- Automatisierung & Planung: Scrapes terminieren, Workflows verketten und mit Google Sheets, Slack oder Zapier integrieren.

- Flexible Preise: Kostenloses Kontingent, bezahlte Pläne ab 49 $/Monat, nutzungsbasiert für große Projekte.

Ideal für: Teams, die No-Code-Vorlagen und Entwickler-Flexibilität kombinieren wollen. Perfekt für Startups, Agenturen und Unternehmen mit wachsendem Datenbedarf.

4. Bright Data

(früher Luminati) ist der Enterprise-Gigant unter den web scraping apis. Wer die härtesten Webseiten in großem Stil scrapen muss, profitiert von Bright Datas riesigem Proxy-Netzwerk und Anti-Bot-Technologie.

Wichtige Funktionen:

- 150+ Millionen Proxy-IPs: Weltweite Abdeckung, Residential-, Datacenter-, ISP- und Mobile-Proxies.

- Web Unlocker API: Löst CAPTCHAs, umgeht Anti-Bot-Schutz und simuliert echte Browser.

- Spezialisierte APIs: SERP-Scraping, E-Commerce, individuelle Crawler und mehr.

- Enterprise-Qualität: Über 99 % Erfolgsquote, 24/7 Support, Compliance-Features.

- Datenexport: Export nach JSON, CSV, Excel oder direkt in die Cloud.

Nachteile: Preise ab ca. 500 $/Monat oder 1 $ pro 1.000 Anfragen. Die Oberfläche richtet sich an Entwickler – Nicht-Techniker brauchen Unterstützung.

Ideal für: Großunternehmen, Marktforschungsinstitute und alle, die große, geschützte Datenmengen zuverlässig extrahieren müssen.

5. ScrapingBee

ist eine API für Entwickler, die dynamische Webseiten und Anti-Bot-Hürden meistern will. Sie übernimmt Headless-Browser, Proxies und CAPTCHAs, damit du dich auf die Daten konzentrieren kannst.

Wichtige Funktionen:

- Headless-Browser-Rendering: Holt Inhalte von JavaScript-lastigen oder Single-Page-Apps.

- Automatische Proxy-Rotation: Verhindert IP-Sperren und ermöglicht Geo-Targeting.

- CAPTCHA-Lösung: Umgeht oder löst gängige CAPTCHAs automatisch.

- Einfache API: Leicht in Python, Node.js, PHP und mehr integrierbar.

- Günstige Preise: Pläne ab 49 $/Monat, nutzungsbasiert, mit kostenlosen Testkontingenten.

Nachteile: Keine grafische Oberfläche – API-Integration erforderlich. Bei sehr komplexen Anti-Bot-Systemen nicht ganz so robust wie Bright Data.

Ideal für: Entwickler und kleine bis mittlere Unternehmen, die dynamische Seiten oder moderaten Schutz scrapen wollen, ohne eigene Infrastruktur zu bauen.

6. Octoparse

ist eine No-Code-Web-Scraping-Plattform für Business-Anwender, die ohne Programmierung leistungsstark scrapen möchten. Die visuelle Drag-and-Drop-Oberfläche ist auch für Einsteiger geeignet und bietet dennoch viele Profi-Funktionen.

Wichtige Funktionen:

- Point-and-Click-Oberfläche: Scraper per Mausklick auf Seitenelemente erstellen – ganz ohne Code.

- Komplexe Seiten meistern: Unterstützt JavaScript, Endlos-Scrollen, Logins und mehrstufige Workflows.

- Vorlagen: Hunderte fertige Scraper für Amazon, Twitter, LinkedIn und mehr.

- Cloud-Scheduling: Jobs in der Cloud ausführen, wiederkehrende Aufgaben planen und Export nach Excel, CSV oder per API.

- Preise: Kostenloses Kontingent, Standard ab 119 $/Monat, Pro ab 249 $/Monat.

Nachteile: Desktop-App nur für Windows; Lernkurve bei komplexen Workflows; bei großem Umfang teuer.

Ideal für: Analysten, Marketer und Operations-Teams ohne Programmierkenntnisse, die trotzdem professionell scrapen wollen.

7. Import.io

ist ein Pionier im Web Scraping und heute auf End-to-End-Datenintegration für Unternehmen spezialisiert. Hier geht es darum, Webdaten direkt in Geschäftsprozesse zu bringen.

Wichtige Funktionen:

- Point-and-Click-Extraktion: Extraktoren per Beispiel trainieren – kein Code nötig.

- Logins & Workflows: Mehrstufige Interaktionen und Scraping hinter Logins automatisieren.

- Datenaufbereitung: Daten beim Extrahieren bereinigen, formatieren und anreichern.

- Integration: APIs und Webhooks für direkte Anbindung an BI-Tools, Datenbanken oder Google Sheets.

- Enterprise-Support: Persönliche Ansprechpartner, Compliance-Features, On-Premise-Optionen.

- Preise: Ab ca. 299 $/Monat, individuelle Enterprise-Verträge.

Nachteile: Premium-Preise, Jahresverträge, vor allem für große Unternehmen geeignet.

Ideal für: Unternehmen und datengetriebene Organisationen, die zuverlässige, integrierte Webdaten-Pipelines mit Support benötigen.

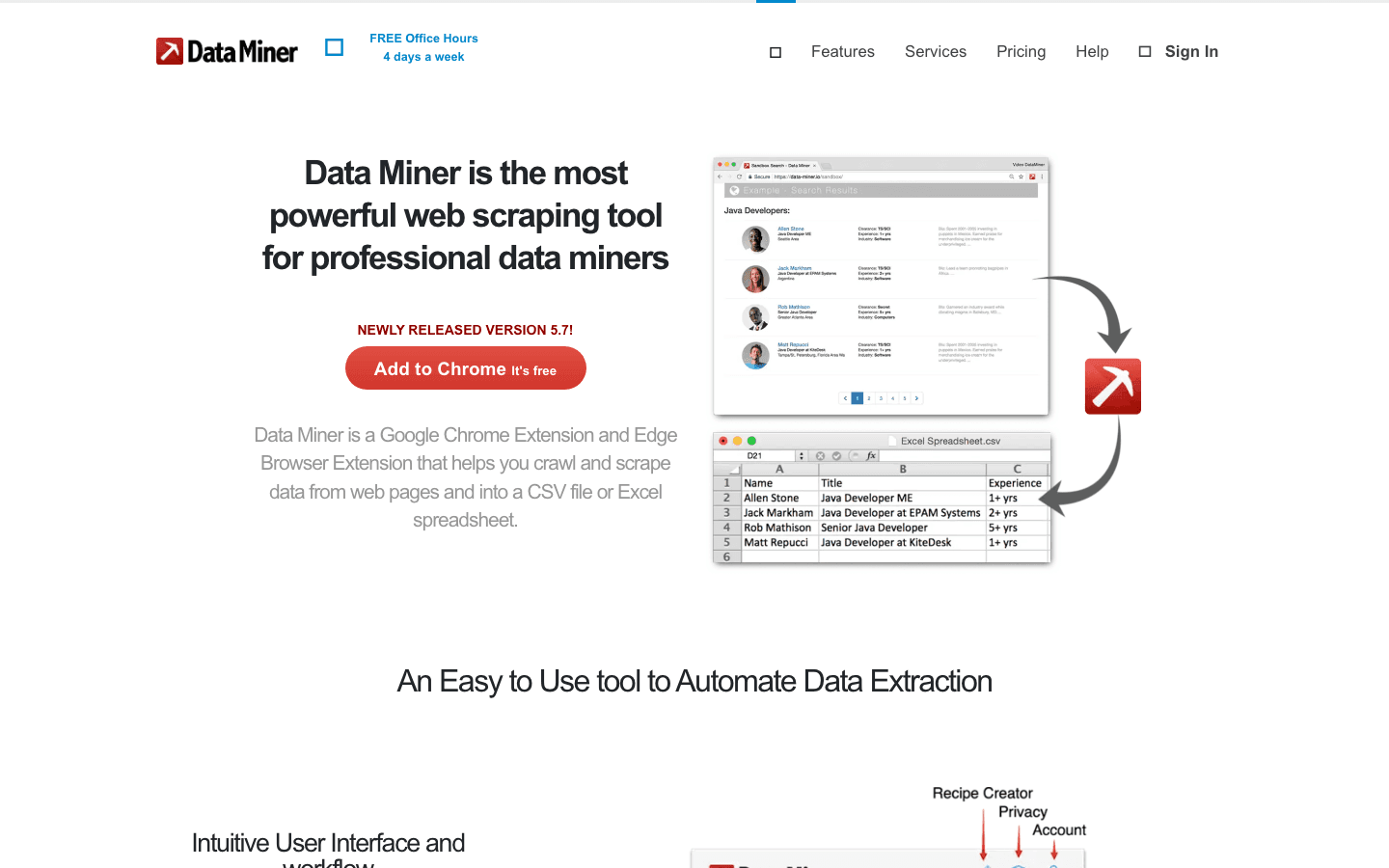

8. Data Miner

ist eine Browser-Erweiterung für Chrome und Edge, mit der du kleine Datenmengen blitzschnell extrahieren kannst. Perfekt für „Ich brauche diese Tabelle jetzt in Excel“-Momente.

Wichtige Funktionen:

- One-Click-Scraping: Über 50.000 öffentliche „Rezepte“ für beliebte Seiten oder eigene Vorlagen per Mausklick erstellen.

- Browser-basiert: Nutzt die aktuelle Sitzung – ideal für eingeloggte Seiten.

- Mehrseitiges Crawling: Automatisch „Nächste Seite“ klicken oder eine Liste von URLs abarbeiten.

- Export: Download als CSV, Excel oder direkt in Google Sheets.

- Preise: Kostenlos für 500 Seiten/Monat, bezahlte Pläne ab 20–99 $/Monat.

Nachteile: Nicht für große oder sehr dynamische Seiten gedacht; am besten für schnelle, spontane Aufgaben.

Ideal für: Einzelpersonen und kleine Teams, die schnell und unkompliziert Daten direkt im Browser extrahieren möchten – z. B. Marketer, Vertrieb oder Forscher.

Vergleichstabelle der web scraping apis

Hier ein schneller Überblick zum Vergleich:

| Tool | Stabilität der Extraktion | Komplexe Seiten | Benutzerfreundlichkeit | Dokumentation & Support | Preisgestaltung | Ideal für |

|---|---|---|---|---|---|---|

| Thunderbit | Sehr hoch (KI passt sich an) | Gut (KI, Browser/Cloud) | Exzellent (No-Code-UI) | Gute Doku, schneller Support | Kostenlos, ab ca. 16,5 $/Monat | Business-Anwender, KI-basiert, No-Code |

| Scrapy | Hoch (manuelle Wartung) | Variabel (eigener Code) | Gering (nur Code) | Große Community | Kostenlos, Infrastrukturkosten | Entwickler, individuelle, große Projekte |

| Apify | Hoch (Cloud, Actors) | Sehr gut (Proxies, Headless) | Gut (UI + Code) | Gute Doku, Support | Kostenlos, ab 49 $/Monat | Teams mit Vorlagen & individueller Entwicklung |

| Bright Data | Extrem hoch (Enterprise) | Exzellent (Proxies, Anti-Bot) | Gering (API, Entwickler) | 24/7 Enterprise | Ab 500 $/Monat, 1 $/1k Anfragen | Unternehmen, anspruchsvolles Scraping |

| ScrapingBee | Hoch (dynamische Seiten) | Sehr gut (JS, Proxies, CAPTCHA) | API (Entwickler) | Sehr gute Doku, Support | Ab 49 $/Monat, nutzungsbasiert | Entwickler, KMU, dynamische Seiten |

| Octoparse | Hoch (Cloud, Vorlagen) | Gut (JS, Logins, Scroll) | Exzellent (No-Code-UI) | Tutorials, 24/7 Support | Kostenlos, 119–249 $/Monat | Nicht-Techniker, Marktforschung, Preisüberwachung |

| Import.io | Sehr hoch (Managed) | Sehr gut (Logins, Workflows) | Gut (No-Code-UI) | Enterprise-Support | Ab 299 $/Monat | Unternehmen, integrierte Datenpipelines |

| Data Miner | Mittel (Browser-basiert) | Basis (Browsersitzung) | Exzellent (Erweiterung) | Doku, Sprechstunden | Kostenlos, 20–99 $/Monat | Schnelles, kleines, spontanes Scraping |

Wie finde ich die passende web scraping api für mein Unternehmen?

Die richtige web scraping api zu finden, heißt nicht, immer das Tool mit den meisten Features zu nehmen – sondern das, das zu deinen Anforderungen passt. Hier meine Schnellübersicht:

- Für Nicht-Programmierer oder Business-User: Thunderbit, Octoparse oder Data Miner – schnell und einfach.

- Für Entwickler oder individuelle Workflows: Scrapy, Apify oder ScrapingBee bieten maximale Flexibilität.

- Für Unternehmen oder kritische Projekte: Bright Data oder Import.io liefern Zuverlässigkeit, Compliance und Support auf Enterprise-Niveau.

- Für schnelle Einzelaufgaben: Data Miner ist ideal.

Fragen, die du dir vorab stellen solltest:

- Wie oft willst du scrapen? (Einmalig oder regelmäßig)

- Wie komplex sind die Zielseiten? (Statisch, dynamisch, Anti-Bot-Schutz)

- Wer nutzt das Tool? (Business-Anwender oder Entwickler)

- Welches Budget steht zur Verfügung? (Kostenlos, nutzungsbasiert, Enterprise)

- Brauchst du Integration mit BI-Tools oder CRM?

Nicht vergessen: Fast jedes Tool bietet eine kostenlose Testversion. Teste immer mit deinen echten Daten, bevor du dich entscheidest.

Fazit: Mit der richtigen web scraping api echten Mehrwert schaffen

KI-Web-Scraper und web scraping apis sind von Nischen-Tools für Entwickler zu unverzichtbarer Business-Infrastruktur geworden. Egal ob Lead-Listen, Preisüberwachung oder Analytics – die passende API verwandelt das wilde Web in strukturierte, nutzbare Daten – ganz ohne Stress.

Thunderbit überzeugt durch seinen KI-basierten, anwenderfreundlichen Ansatz, aber jedes Tool auf dieser Liste hat seine Stärken. Der eigentliche Gewinn? Die Automatisierung der Fleißarbeit, damit du und dein Team euch auf Analysen statt auf Datensuche konzentrieren könnt.

Neugierig, wie modernes Scraping aussieht? oder stöbere im für weitere Tipps. Viel Erfolg beim Scrapen – und möge deine Datenquelle immer aktuell und strukturiert sein.

Häufige Fragen (FAQ)

1. Was ist eine web scraping api und warum sollte ich sie nutzen?

Eine web scraping api automatisiert das Extrahieren von Daten aus Webseiten, übernimmt technische Details wie HTML-Parsing, JavaScript-Ausführung und Anti-Bot-Umgehung. Sie ist viel schneller und zuverlässiger als manuelles Kopieren und ermöglicht es dir, dich auf die Nutzung der Daten zu konzentrieren – nicht auf deren Beschaffung.

2. Welche web scraping api eignet sich am besten für Nicht-Techniker?

Thunderbit, Octoparse und Data Miner sind ideal für Anwender ohne Programmierkenntnisse. Thunderbit punktet mit KI-gestützter Spracheingabe, Octoparse mit einer visuellen Drag-and-Drop-Oberfläche und Data Miner ist perfekt für schnelle Aufgaben direkt im Browser.

3. Wie gehen web scraping apis mit dynamischen Seiten und CAPTCHAs um?

APIs wie Bright Data, ScrapingBee und Apify nutzen Headless-Browser, Proxy-Rotation und CAPTCHA-Lösungen, um JavaScript-lastige oder geschützte Seiten zu scrapen. Thunderbits KI passt sich Layout-Änderungen an und kann viele dynamische Szenarien, besonders im Browser-Modus, bewältigen.

4. Was sollte ich bei der Auswahl einer web scraping api beachten?

Überlege dir, wie technisch du bist, wie komplex die Zielseiten sind, welches Budget du hast und wie du die Daten nutzen willst (z. B. Export nach Excel, Integration mit BI-Tools). Teste immer mit einer kostenlosen Version, ob das Tool zu deinem Workflow passt.

5. Ist Web Scraping legal und sicher für Unternehmen?

Web Scraping ist legal, wenn es verantwortungsvoll geschieht – beachte immer die Nutzungsbedingungen der Webseiten, sammle keine persönlichen oder sensiblen Daten ohne Einwilligung und nutze APIs mit Compliance-Features (wie Bright Data oder Import.io für Unternehmen). Im Zweifel solltest du deine Rechtsabteilung fragen.

Mehr zu Web Scraping, Automatisierung und KI-gestützten Datentools findest du im oder auf unserem .

Mehr erfahren