Wenn ich an meine ersten Schritte im SaaS- und Automatisierungsbereich zurückdenke, erinnere ich mich an endlose Nächte, fehleranfällige Skripte und viel zu viel Kaffee – alles nur, um ein paar Webdaten zu extrahieren. Doch 2025 sieht alles ganz anders aus: data scraping api sind heute das Herzstück datengetriebener Unternehmen und sorgen für alles – von Preisüberwachung bis hin zum Training von KI-Modellen. Aber es gibt einen neuen Trend: Während APIs immer mächtiger werden, krempeln KI-basierte Automatisierungstools wie das Web-Scraping still und heimlich komplett um.

Egal, ob du Entwickler bist, Business Analyst oder einfach nur genug von Proxies und CAPTCHAs hast – dieser Guide ist für dich. Hier findest du die 10 besten Web-Scraping-APIs 2025: Was sie besonders macht, für wen sie geeignet sind und warum KI-Tools vielleicht dein neuer Geheimtipp werden.

Warum Thunderbit AI statt klassischer Web-Scraping-APIs?

Bevor wir zur eigentlichen Liste kommen, lass uns über das Offensichtliche sprechen: KI-gestützte Automatisierung. Nach Jahren, in denen ich Teams bei der Automatisierung von Routineaufgaben begleitet habe, sehe ich immer mehr Unternehmen, die sich den Umweg über komplexe APIs sparen und direkt auf KI-Agenten wie Thunderbit setzen.

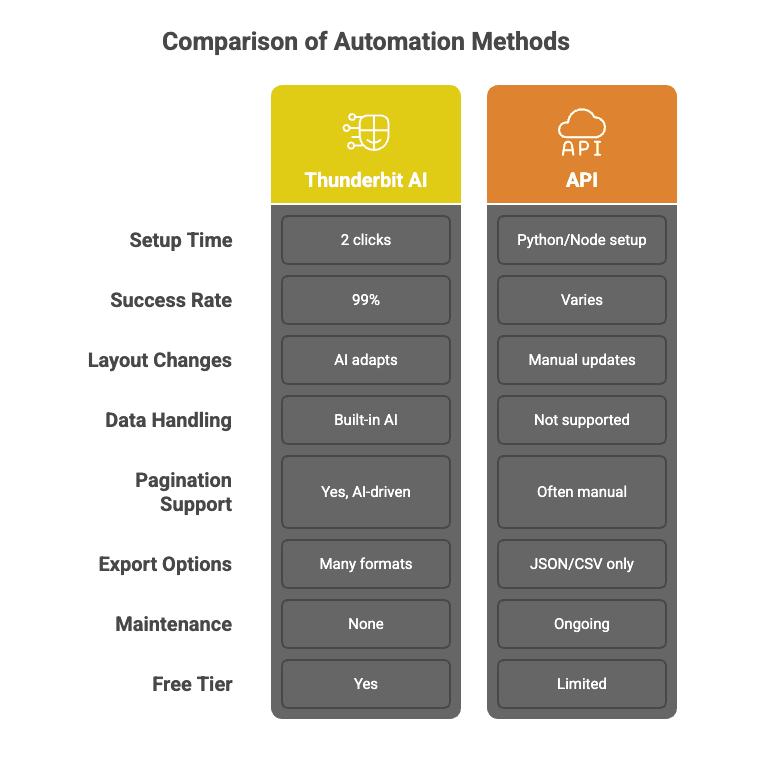

Was macht Thunderbit so anders als klassische Web-Scraping-APIs?

-

Waterfall-API-Aufrufe für 99% Erfolgsquote

Thunderbits KI verlässt sich nicht auf eine einzige Methode. Sie sucht sich automatisch die beste Scraping-Strategie für jede Aufgabe, wiederholt bei Bedarf und erreicht so eine Erfolgsrate von 99%. Du bekommst die Daten – ohne Kopfschmerzen.

-

No-Code, Zwei-Klick-Setup

Keine Python-Skripte, keine komplizierte API-Doku. Bei Thunderbit reicht ein Klick auf „AI Felder vorschlagen“ und dann auf „Scrapen“. Das war’s. Selbst meine Mutter würde es hinbekommen (und sie denkt immer noch, „die Cloud“ ist schlechtes Wetter).

-

Batch-Scraping: Schnell und präzise

Thunderbits KI verarbeitet tausende verschiedene Websites gleichzeitig und passt sich automatisch an jedes Layout an. Wie ein Team aus Praktikanten – nur ohne Kaffeepausen.

-

Wartungsfrei

Webseiten ändern sich ständig. Klassische APIs steigen dann oft aus. Thunderbit? Die KI liest jede Seite bei jedem Durchlauf neu – du musst also nie Code anpassen, wenn sich das Layout ändert.

-

Individuelle Datenaufbereitung & Nachbearbeitung

Du brauchst deine Daten bereinigt, beschriftet, übersetzt oder zusammengefasst? Thunderbit erledigt das direkt beim Extrahieren – als würdest du 10.000 Webseiten durch ChatGPT schicken und ein perfekt strukturiertes Datenset zurückbekommen.

-

Unterseiten & Paginierung scrapen

Thunderbits KI folgt Links, verarbeitet Paginierungen und reichert deine Tabelle mit Daten von Unterseiten an – ganz ohne eigenen Code.

-

Kostenloser Datenexport & Integrationen

Exportiere deine Daten nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON – ohne versteckte Kosten oder Einschränkungen.

Hier ein schneller Vergleich, damit du den Unterschied siehst:

Du willst Thunderbit live erleben? Probier die aus.

Was ist eine Data Scraping API?

Zurück zu den Basics: Eine data scraping api ist ein Tool, mit dem du automatisiert Daten von Webseiten extrahieren kannst – ganz ohne eigene 웹 스크래퍼 zu bauen. Stell dir vor, du schickst einen Roboter los, der aktuelle Preise, Bewertungen oder Angebote einsammelt und dir die Daten sauber strukturiert (meist als JSON oder CSV) zurückliefert.

Wie läuft das ab? Die meisten scraping-apis übernehmen die komplizierten Aufgaben – wie Proxy-Rotation, CAPTCHA-Lösungen oder das Rendern von JavaScript – damit du dich auf das Wesentliche konzentrieren kannst: die Daten. Du schickst eine Anfrage (meist mit URL und Parametern) und bekommst die gewünschten Inhalte, bereit für deine Geschäftsprozesse.

Die wichtigsten Vorteile:

- Geschwindigkeit: APIs können tausende Seiten pro Minute extrahieren.

- Skalierbarkeit: Du willst 10.000 Produkte überwachen? Kein Problem.

- Integration: Einfaches Andocken an dein CRM, BI-Tool oder Data Warehouse.

Aber: Nicht jede API hält, was sie verspricht – und nicht alle sind wirklich „einrichten und vergessen“.

So haben wir die besten Web-Scraping-APIs 2025 ausgewählt

Ich habe viele Stunden mit Testen, Debuggen und gelegentlichen DDoS-Attacken auf meine eigenen Server verbracht (bitte nicht meinem alten IT-Team verraten). Für diese Liste habe ich Wert gelegt auf:

- Zuverlässigkeit: Funktioniert die API auch bei schwierigen Seiten?

- Geschwindigkeit: Wie schnell liefert sie Ergebnisse – auch bei großen Datenmengen?

- Preisgestaltung: Ist sie für Startups bezahlbar und für Unternehmen skalierbar?

- Skalierbarkeit: Hält sie Millionen Anfragen aus oder bricht sie bei 100 zusammen?

- Entwicklerfreundlichkeit: Ist die Dokumentation verständlich? Gibt es SDKs und Codebeispiele?

- Support: Gibt es Hilfe, wenn mal etwas schiefgeht?

- Nutzerfeedback: Echte Erfahrungsberichte statt Marketingversprechen.

Zusätzlich habe ich auf eigene Tests, Review-Analysen und Rückmeldungen aus der Thunderbit-Community gesetzt (wir sind ziemlich anspruchsvoll).

Die Top 10 Data Scraping APIs 2025

Bereit für den Überblick? Hier kommt meine aktuelle Liste der besten web-scraping-tools und Plattformen für Unternehmen und Entwickler im Jahr 2025.

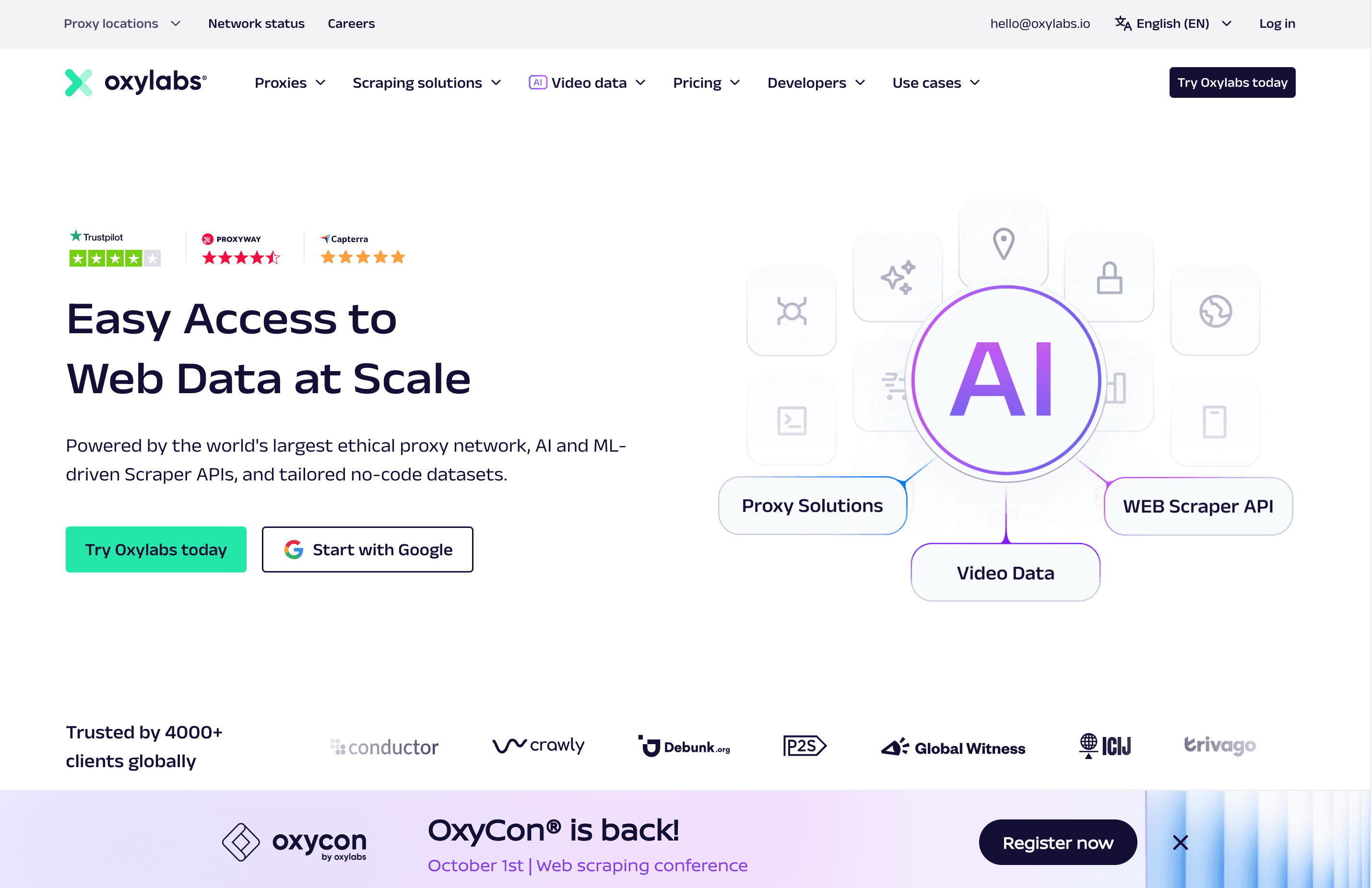

1. Oxylabs

Überblick:

Überblick:

Oxylabs ist der Big Player, wenn es um Webdaten-Extraktion im Enterprise-Bereich geht. Mit einem riesigen Proxy-Pool und spezialisierten APIs für alles von SERPs bis E-Commerce ist es die erste Wahl für große Unternehmen, die auf Zuverlässigkeit setzen.

Wichtige Funktionen:

- Riesiges Proxy-Netzwerk (Residential, Datacenter, Mobile, ISP) in über 195 Ländern

- Scraper-APIs mit Anti-Bot, CAPTCHA-Lösung und Headless-Browser-Rendering

- Geotargeting, Session-Persistenz und hohe Datenqualität (über 95% Erfolgsquote)

- OxyCopilot: KI-Assistent, der Parsing-Code und API-Queries automatisch generiert

Preise:

Ab ca. 49 $/Monat für eine API, 149 $/Monat für Komplettzugang. 7 Tage kostenlos testen mit bis zu 5.000 Anfragen.

Nutzerfeedback:

, besonders für Zuverlässigkeit und Support gelobt. Nachteil: Der Preis – aber Qualität kostet eben.

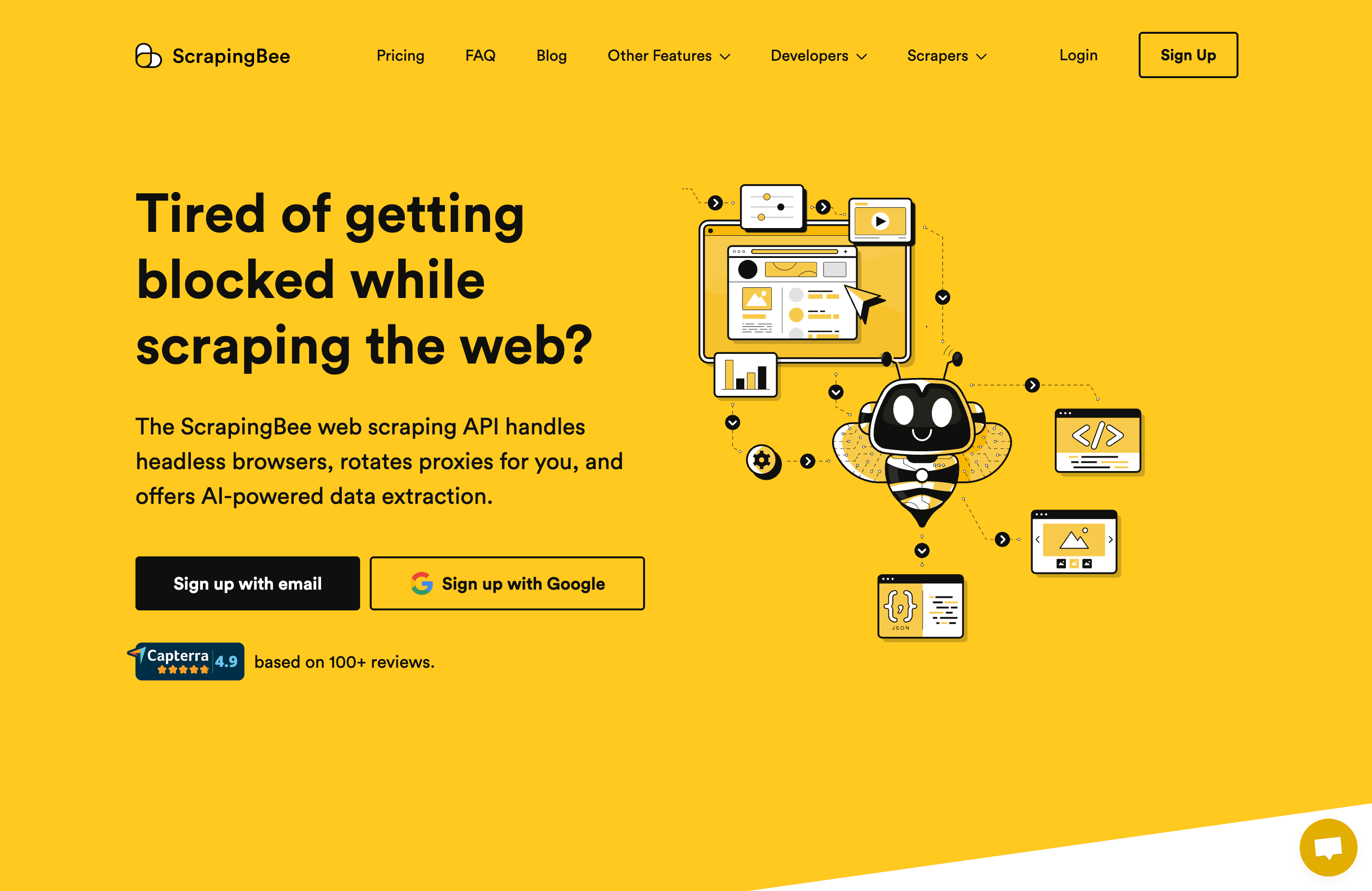

2. ScrapingBee

Überblick:

Überblick:

ScrapingBee ist der beste Freund von Entwicklern: Einfach, günstig und auf das Wesentliche fokussiert. Du schickst eine URL, ScrapingBee übernimmt Headless Chrome, Proxies und CAPTCHAs und liefert die gerenderte Seite oder gezielt die gewünschten Daten.

Wichtige Funktionen:

- Headless-Browser-Rendering (JavaScript-Unterstützung)

- Automatische IP-Rotation und CAPTCHA-Lösung

- Stealth-Proxy-Pool für schwierige Seiten

- Minimaler Aufwand – nur ein API-Call nötig

Preise:

Kostenlose Stufe mit ca. 1.000 Anfragen/Monat. Bezahlpläne ab ca. 29 $/Monat für 5.000 Anfragen.

Nutzerfeedback:

Stetig . Entwickler lieben die Einfachheit, für Nicht-Programmierer ist es manchmal zu minimalistisch.

3. Apify

Überblick:

Überblick:

Apify ist das Schweizer Taschenmesser unter den web-scraping-tools. Du kannst eigene Scraper („Actors“) in JavaScript oder Python bauen oder auf eine riesige Bibliothek vorgefertigter Actors für bekannte Seiten zurückgreifen. Maximale Flexibilität.

Wichtige Funktionen:

- Eigene und vorgefertigte Scraper (Actors) für fast jede Website

- Cloud-Infrastruktur, Terminplanung und Proxy-Management inklusive

- Datenexport zu JSON, CSV, Excel, Google Sheets und mehr

- Aktive Community und Discord-Support

Preise:

Kostenloser Plan mit 5 $/Monat Guthaben. Bezahlpläne ab 39 $/Monat.

Nutzerfeedback:

. Entwickler feiern die Flexibilität, Einsteiger müssen sich einarbeiten.

4. Decodo (ehemals Smartproxy)

Überblick:

Überblick:

Decodo (früher Smartproxy) punktet mit Preis-Leistung und einfacher Bedienung. Es vereint starke Proxy-Infrastruktur mit Scraping-APIs für allgemeines Web, SERPs, E-Commerce und Social Media – alles in einem Abo.

Wichtige Funktionen:

- Einheitliche Scraping-API für alle Endpunkte (keine separaten Add-ons)

- Spezielle Scraper für Google, Amazon, TikTok und mehr

- Benutzerfreundliches Dashboard mit Playground und Code-Generatoren

- 24/7 Live-Chat-Support

Preise:

Ab ca. 50 $/Monat für 25.000 Anfragen. 7 Tage kostenlos testen mit 1.000 Anfragen.

Nutzerfeedback:

Gelobt für Preis-Leistung und schnellen Support. .

5. Octoparse

Überblick:

Octoparse ist der No-Code-Champion. Wer keine Lust auf Programmierung, aber viel auf Daten hat, kann mit dieser Desktop-App (inklusive Cloud-Funktionen) Scraper per Mausklick bauen und lokal oder in der Cloud ausführen.

Wichtige Funktionen:

- Visueller Workflow-Builder – einfach Felder anklicken

- Cloud-Extraktion, Terminplanung und automatische IP-Rotation

- Vorlagen für bekannte Seiten und ein Marktplatz für individuelle Scraper

- Octoparse AI: RPA- und ChatGPT-Integration für Datenaufbereitung und Automatisierung

Preise:

Kostenlos für bis zu 10 lokale Aufgaben. Bezahlpläne ab 119 $/Monat (Cloud, unbegrenzte Aufgaben). 14 Tage Premium-Test.

Nutzerfeedback:

. Besonders beliebt bei Nicht-Programmierern, Profis stoßen an Grenzen.

6. Bright Data

Überblick:

Überblick:

Bright Data ist die All-in-One-Lösung für maximale Skalierung, Geschwindigkeit und Funktionsvielfalt. Mit dem weltweit größten Proxy-Netzwerk und einer leistungsstarken Scraper-IDE ist es auf Enterprise-Anforderungen ausgelegt.

Wichtige Funktionen:

- Über 150 Mio. IPs (Residential, Mobile, ISP, Datacenter)

- Web Scraper IDE, vorgefertigte Data-Collector und fertige Datensätze

- Fortschrittliche Anti-Bot-Technik, CAPTCHA-Lösung und Headless-Browser

- Fokus auf Compliance und Rechtssicherheit (Ethical Web Data Initiative)

Preise:

Pay-as-you-go: ca. 1,05 $ pro 1.000 Anfragen, Proxies ab 3–15 $/GB. Kostenlose Testphasen für die meisten Produkte.

Nutzerfeedback:

Gelobt für Performance und Funktionsumfang, aber Preis und Komplexität sind für kleine Teams eine Hürde.

7. WebAutomation

Überblick:

Überblick:

WebAutomation ist eine Cloud-Plattform für Nicht-Entwickler. Mit einem Marktplatz für vorgefertigte Extractors und einem No-Code-Builder ist sie ideal für Business-Anwender, die Daten – aber keinen Code – wollen.

Wichtige Funktionen:

- Vorgefertigte Extractors für bekannte Seiten (Amazon, Zillow etc.)

- No-Code-Builder mit Point-and-Click-Oberfläche

- Cloud-Terminierung, Datenlieferung und Wartung inklusive

- Zeilenbasierte Preisgestaltung (du zahlst nur für extrahierte Daten)

Preise:

Projektplan ab 74 $/Monat (~400.000 Zeilen/Jahr), Pay-as-you-go: 1 $ pro 1.000 Zeilen. 14 Tage kostenlos mit 10 Mio. Credits.

Nutzerfeedback:

Gelobt für Benutzerfreundlichkeit und transparente Preise. Support ist hilfsbereit, Wartung übernimmt das Team.

8. ScrapeHero

Überblick:

Überblick:

ScrapeHero startete als Beratungsdienst für individuelles Scraping und bietet jetzt eine Self-Service-Cloud-Plattform. Du kannst vorgefertigte Scraper für bekannte Seiten nutzen oder komplett gemanagte Projekte beauftragen.

Wichtige Funktionen:

- ScrapeHero Cloud: Vorgefertigte Scraper für Amazon, Google Maps, LinkedIn und mehr

- No-Code-Bedienung, Terminierung und Cloud-Lieferung

- Individuelle Lösungen für spezielle Anforderungen

- API-Zugang für programmatische Integration

Preise:

Cloud-Pläne ab 5 $/Monat. Individuelle Projekte ab 550 $ pro Seite (einmalig).

Nutzerfeedback:

Gelobt für Zuverlässigkeit, Datenqualität und Support. Ideal für den Wechsel von DIY zu Managed Services.

9. Sequentum

Überblick:

Überblick:

Sequentum ist das Schweizer Taschenmesser für Unternehmen – entwickelt für Compliance, Nachvollziehbarkeit und große Skalierung. Wer SOC-2-Zertifizierung, Audit-Trails und Teamarbeit braucht, ist hier richtig.

Wichtige Funktionen:

- Low-Code-Agent-Designer (Point-and-Click plus Scripting)

- Cloud-SaaS oder On-Premise-Deployment

- Integriertes Proxy-Management, CAPTCHA-Lösung und Headless-Browser

- Audit-Trails, rollenbasierter Zugriff und SOC-2-Compliance

Preise:

Pay-as-you-go (6 $/Stunde Laufzeit, 0,25 $/GB Export), Starter-Plan ab 199 $/Monat. 5 $ Startguthaben.

Nutzerfeedback:

Unternehmen schätzen Compliance und Skalierbarkeit. Es gibt eine Lernkurve, aber Support und Schulungen sind exzellent.

10. Grepsr

Überblick:

Überblick:

Grepsr ist ein Managed-Service für Datenextraktion – du sagst, was du brauchst, und das Team baut, betreibt und wartet die Scraper für dich. Perfekt für Unternehmen, die Daten wollen, aber keinen technischen Aufwand.

Wichtige Funktionen:

- Managed Extraction („Grepsr Concierge“) – Einrichtung und Wartung inklusive

- Cloud-Dashboard für Terminierung, Monitoring und Download

- Verschiedene Ausgabeformate und Integrationen (Dropbox, S3, Google Drive)

- Abrechnung pro Datensatz (nicht pro Anfrage)

Preise:

Starterpaket ab 350 $ (einmalige Extraktion), laufende Abos individuell kalkuliert.

Nutzerfeedback:

Kunden schätzen die Rundum-Betreuung und den schnellen Support. Ideal für nicht-technische Teams und alle, die Zeit sparen wollen.

Schneller Vergleich: Die besten Web-Scraping-APIs

Hier die Übersicht aller 10 Plattformen auf einen Blick:

| Plattform | Unterstützte Datentypen | Startpreis | Kostenlose Testphase | Benutzerfreundlichkeit | Support | Besondere Merkmale |

|---|---|---|---|---|---|---|

| Oxylabs | Web, SERP, E-Commerce, Immobilien | $49/Monat | 7 Tage/5k Anfragen | Entwicklerorientiert | 24/7, Enterprise | OxyCopilot KI, riesiger Proxy-Pool, Geotargeting |

| ScrapingBee | Allgemeines Web, JS, CAPTCHA | $29/Monat | 1k Anfragen/Monat | Einfache API | E-Mail, Foren | Headless Chrome, Stealth-Proxies |

| Apify | Beliebige Webdaten, vorgefertigt/individuell | Kostenlos/$39/Monat | Dauerhaft kostenlos | Flexibel, komplex | Community, Discord | Actor-Marktplatz, Cloud-Infrastruktur, Integrationen |

| Decodo | Web, SERP, E-Commerce, Social | $50/Monat | 7 Tage/1k Anfragen | Benutzerfreundlich | 24/7 Live-Chat | Einheitliche API, Code-Playground, Top Preis-Leistung |

| Octoparse | Beliebige Webdaten, No-Code | Kostenlos/$119/Monat | 14 Tage | Visuell, No-Code | E-Mail, Forum | Point-and-Click-UI, Cloud, Octoparse AI |

| Bright Data | Alle Webdaten, Datensätze | $1,05/1k Anfragen | Ja | Leistungsstark, komplex | 24/7, Enterprise | Größtes Proxy-Netz, IDE, fertige Datensätze |

| WebAutomation | Strukturierte Daten, E-Commerce, Immobilien | $74/Monat | 14 Tage/10 Mio. Zeilen | No-Code, Vorlagen | E-Mail, Chat | Vorgefertigte Extractors, zeilenbasierte Preise |

| ScrapeHero | E-Commerce, Karten, Jobs, individuell | $5/Monat | Ja | No-Code, Managed | E-Mail, Tickets | Cloud-Scraper, individuelle Projekte, Dropbox-Lieferung |

| Sequentum | Beliebige Webdaten, Enterprise | $0/$199/Monat | $5 Guthaben | Low-Code, visuell | High-Touch | Audit-Trails, SOC-2, On-Prem/Cloud |

| Grepsr | Strukturierte Daten, Managed | $350 einmalig | Testlauf | Komplett gemanagt | Persönlicher Ansprechpartner | Concierge-Setup, Abrechnung pro Datensatz, Integrationen |

Wie wähle ich das richtige Web-Scraping-Tool für mein Unternehmen?

Welches Tool passt zu dir? So berate ich Teams:

-

Du willst No-Code, sofortige Ergebnisse und KI-gestützte Datenaufbereitung:

Setz auf . Der schnellste Weg von „Ich brauche Daten“ zu „Ich habe Daten“ – ganz ohne Skripte oder API-Pflege.

-

Du bist Entwickler und willst maximale Kontrolle und Flexibilität:

Probier Apify, ScrapingBee oder Oxylabs. Hier hast du die meiste Power, musst aber auch mehr einrichten und pflegen.

-

Du bist Business-Anwender und bevorzugst visuelle Tools:

WebAutomation ist ideal für Point-and-Click-Scraping, besonders im E-Commerce und Lead-Gen.

-

Du brauchst Compliance, Nachvollziehbarkeit oder Enterprise-Features:

Sequentum ist für dich gemacht. Teurer, aber für regulierte Branchen unverzichtbar.

-

Du willst alles auslagern:

Grepsr oder ScrapeHero bieten Managed Services. Du zahlst etwas mehr, sparst aber Zeit und Nerven.

Und falls du noch unsicher bist: Die meisten Plattformen bieten kostenlose Testphasen – einfach ausprobieren!

Fazit: Data Scraping APIs 2025

- Web-Scraping-APIs sind ein Muss für datengetriebene Unternehmen – der Markt wird bis 2030 auf .

- Manuelles Scraping ist Geschichte – Anti-Bot-Technik, Proxies und ständige Webseiten-Änderungen machen APIs und KI-Tools zur einzigen skalierbaren Lösung.

- Jede API/Plattform hat ihre Stärken:

- Oxylabs und Bright Data für Skalierung und Zuverlässigkeit

- Apify für Flexibilität

- Decodo für Preis-Leistung

- WebAutomation für No-Code

- Sequentum für Compliance

- Grepsr für Managed Data

- KI-basierte Automatisierung (wie Thunderbit) verändert das Feld – mit höheren Erfolgsraten, null Wartungsaufwand und integrierter Datenverarbeitung, die klassische APIs nicht bieten können.

- Das beste Tool ist das, das zu deinem Workflow, Budget und Know-how passt. Probier ruhig verschiedene Lösungen aus!

Wenn du genug von fehlerhaften Skripten und endlosem Debugging hast, teste – oder stöbere im für weitere Guides zu Amazon, Google, PDFs und mehr.

Und denk dran: Im Webdaten-Universum ändert sich die Technik noch schneller als die Webseiten selbst. Bleib neugierig, automatisiert – und mögen deine Proxies nie blockiert werden.