Im Jahr 2025 gehören Webdaten zu den wichtigsten Ressourcen, um sich im Wettbewerb einen Vorsprung zu verschaffen – und sie sind längst nicht mehr nur ein Thema für Entwickler oder Data Engineers. Egal, ob du Lead-Listen aufbauen, die Preise der Konkurrenz im Blick behalten, Produktverfügbarkeiten überwachen oder Kundenbewertungen einsammeln willst: Teams aus Vertrieb, Marketing und Operations setzen heute Web-Scraper als festen Bestandteil ihrer Datenstrategie ein. Doch bei der riesigen Auswahl an Tools stellt sich die Frage: Welcher Scraper passt zu deinen Anforderungen und deinem technischen Level? Genau darauf gibt dieser Guide Antworten. Nach vielen Jahren in SaaS, Automatisierung und KI – und mittlerweile als Mitgründer von – stelle ich dir die 15 besten Web-Scraper für 2025 vor, mit ehrlichen Praxiserfahrungen und ein paar persönlichen Einblicken.

Warum Web-Scraper für moderne Unternehmen unverzichtbar sind

Klar ist: Das Internet ist die größte, chaotischste und gleichzeitig wertvollste Datenquelle überhaupt. Aber all diese Infos sind in Webseiten versteckt, verteilt auf zig Seiten und selten in einem Format, das man einfach runterladen und auswerten kann. Hier kommen Web-Scraper ins Spiel – sie sind wie ein digitales Praktikantenteam, das nie müde wird und keine Pause braucht.

Ein Web-Scraper ist ein Tool (oder Service), das automatisch Daten von Webseiten abgreift und unstrukturierte Inhalte in übersichtliche, strukturierte Datensätze verwandelt. Das ist längst kein „Nice-to-have“ mehr, sondern weltweit gelebte Praxis (). Unternehmen nutzen Web-Scraper für Lead-Generierung, Preisbeobachtung, Marktforschung oder Stimmungsanalysen. Einzelhändler steigern so ihre Umsätze durch automatisiertes Preis-Monitoring, Marketing-Teams analysieren Social Media und Bewertungsportale, um Trends frühzeitig zu erkennen.

Die Effizienzgewinne sind enorm: Statt stundenlang Daten zu kopieren, verarbeiten Scraper tausende Datensätze in wenigen Minuten. Eine Fallstudie zeigte, dass Web-Scraping-APIs die Kosten für Datenerhebung um bis zu 40 % senken können (). Dank KI-gestützter Scraper können heute auch Nicht-Techniker große Datenmengen mit minimalem Aufwand sammeln. Schluss mit fehleranfälligen Skripten, die bei jeder Layout-Änderung einer Website angepasst werden müssen – moderne Scraper erkennen Muster und passen sich automatisch an.

2025 setzen bereits rund 65 % aller Unternehmen weltweit Web-Extraktionstools für ihre Analysen ein (), und auch Mittelständler und Startups profitieren von benutzerfreundlichen, KI-basierten Lösungen. Web Scraping ist endgültig im Mainstream angekommen – nicht nur für Entwickler, sondern für ganze Teams aus Vertrieb, Marketing und Operations.

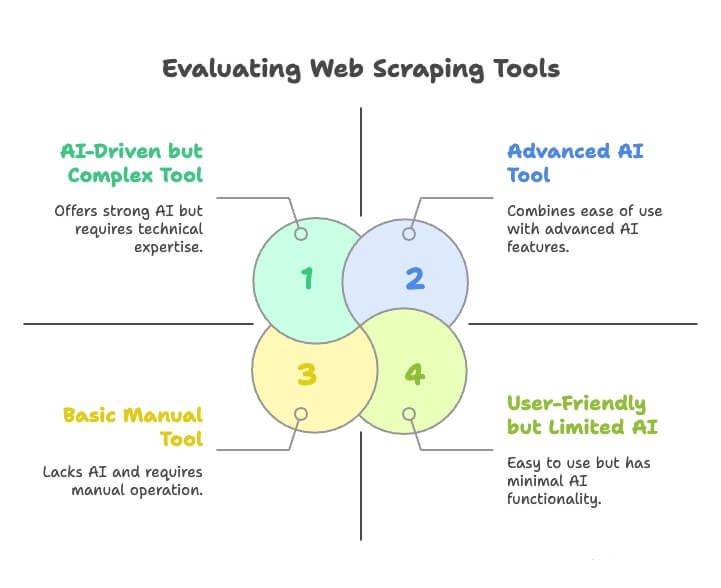

So haben wir die besten Web-Scraper ausgewählt

Bei der Masse an Web-Scraping-Tools fühlt sich die Auswahl schnell an wie die Suche nach der perfekten Netflix-Serie – unübersichtlich und voller Überraschungen. Nach diesen Kriterien habe ich bewertet:

- Benutzerfreundlichkeit: Kann man direkt loslegen, ohne ein 200-seitiges Handbuch zu wälzen? Intuitive Oberflächen oder natürliche Spracheingabe waren ein dickes Plus.

- KI-Funktionen: Nutzt das Tool KI, um das Scraping zu vereinfachen – etwa durch automatische Felderkennung, Anpassung an Webseitenänderungen oder die Möglichkeit, Anforderungen in Alltagssprache zu formulieren?

- Integration & Export: Lässt sich das Ergebnis nach Excel, Google Sheets, Airtable, Notion exportieren oder direkt in Workflows einbinden?

- Skalierbarkeit & Zuverlässigkeit: Kommt das Tool auch mit wachsenden Anforderungen klar – von wenigen Seiten bis zu Millionen? Werden Proxys, Anti-Blocking und Zeitpläne unterstützt?

- Preis-Leistungs-Verhältnis: Gibt es einen kostenlosen Plan oder eine Testphase? Sind die Preise fair? Gibt es versteckte Kosten?

- Zielgruppe: Ist das Tool für Business-Anwender ohne Technikkenntnisse, Entwickler oder große Unternehmen gedacht?

Jeder Scraper auf dieser Liste wurde nach diesen Kriterien sowie anhand von Nutzerfeedback und aktuellen Features bewertet. Egal, ob du Einsteiger oder Profi bist – hier findest du die passende Lösung.

Thunderbit: Der KI-Web-Scraper, der neue Maßstäbe setzt

Starten wir mit dem Spitzenreiter – und ja, ich bin da vielleicht etwas voreingenommen, aber Thunderbit krempelt das Web-Scraping 2025 wirklich um.

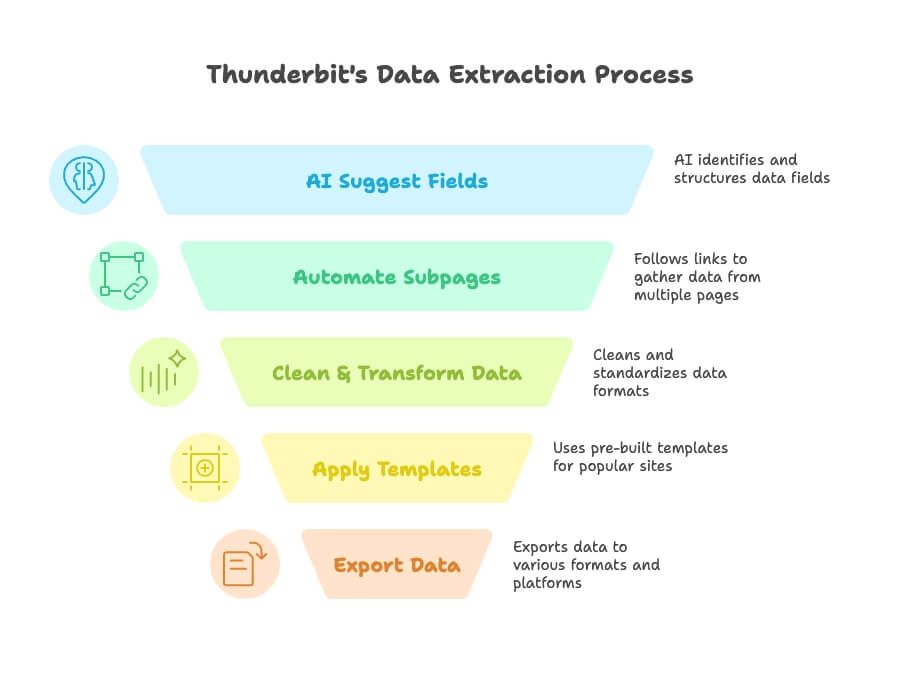

Thunderbit ist kein klassisches „Konfigurations-Tool“. Es ist ein KI-basierter Datenassistent, bei dem du einfach in natürlicher Sprache beschreibst, was du brauchst. Kein Gefummel mehr mit XPath, CSS-Selektoren oder regulären Ausdrücken. Sag Thunderbit einfach: „Ich möchte alle Produktnamen, Preise und Bewertungen von dieser Seite“, und die KI erledigt den Rest – erkennt die Seitenstruktur, klickt sich durch Unterseiten, verarbeitet Paginierung und liefert eine saubere, strukturierte Tabelle. Auch Detailseiten, mehrstufige Extraktion sowie automatische Datenbereinigung, Übersetzung, Kategorisierung und Berechnung sind mit einem Klick möglich.

Thunderbit kommt dem Versprechen, „jede Website in eine Datenbank zu verwandeln“, so nah wie kein anderes Tool – und das für alle, nicht nur für Entwickler. Die kostenlose Testversion ist großzügig, die Bedienung super einfach und gerade für Marketing-, Vertriebs- und Operationsteams ein echter Gewinn.

Thunderbits wichtigste Funktionen für Web Scraping

- KI-Felderkennung & Extraktion: Mit „AI Suggest Fields“ erkennt Thunderbits KI sofort die wichtigsten Datenfelder auf der Seite – etwa Namen, Preise, E-Mails, Bilder und mehr ().

- Automatisierte Unterseiten & Paginierung: Thunderbit folgt Links (z. B. „Nächste Seite“ oder Detailseiten), um Daten aus mehreren Ebenen zu sammeln – inklusive Endlos-Scroll und mehrseitigen Listen ().

- Datenbereinigung & Transformation: Während des Scrapings kannst du Daten bereinigen, Formate vereinheitlichen, übersetzen oder Inhalte direkt zusammenfassen ().

- Vorlagen für beliebte Seiten: Ein-Klick-Templates für Amazon, Google Maps, LinkedIn und viele weitere Plattformen ().

- Export & Integration: Exportiere Daten mit einem Klick nach Excel, CSV, JSON, Google Sheets, Airtable oder Notion ().

- KI-Autofill & Formularausfüllung: Thunderbit kann Online-Formulare automatisch ausfüllen und absenden – ideal für wiederkehrende Aufgaben oder Massenabfragen ().

- Intuitive Bedienung: Läuft als Chrome-Erweiterung mit benutzerfreundlicher Oberfläche. Kein Server-Setup, keine Proxy-Probleme, kein Technik-Kauderwelsch.

Thunderbit wird weltweit von über 30.000 Nutzern eingesetzt, darunter Teams von Accenture, Criteo, Grammarly, Verisk und Puma (). Es gibt einen kostenlosen Plan (bis zu 6 Seiten/Monat) und günstige Upgrades ab 9 $/Monat ().

ParseHub: Visuelles Web Scraping für Technikaffine

ParseHub ist ein alter Hase und bekannt für seine visuelle Workflow-Oberfläche. Die Desktop-App (Windows, Mac, Linux) ermöglicht es, Scraper durch Klicken auf Seitenelemente und das Definieren von Aktionen zu erstellen – quasi „Programmieren durch Vormachen“. ParseHub ist leistungsstark und bewältigt auch komplexe Seiten mit JavaScript, AJAX, Logins und Endlos-Scroll ().

Allerdings: ParseHub richtet sich eher an technisch versierte Nutzer. Man muss nicht programmieren können, sollte aber die Struktur von Webseiten verstehen und gelegentlich die Auswahl des Tools anpassen.

Web Scraper (Chrome): Web Scraping direkt im Browser

Web Scraper (von ) ist eine kostenlose Chrome-Erweiterung, die deinen Browser in einen Point-and-Click-Scraper verwandelt. Du erstellst „Sitemaps“, indem du auf die gewünschten Elemente klickst, und die Erweiterung navigiert durch die Seite und sammelt die Daten ().

Ideal für Einsteiger und kleine Projekte – etwa das Extrahieren von Tabellen, Listen oder Verzeichnissen. Für große oder komplexe Aufgaben ist das Tool jedoch weniger geeignet (keine Proxy-Unterstützung, kein Headless-Modus, und bei zu vielen Seiten kann der Browser abstürzen).

Kadoa: Automatisierte Datenerfassung mit KI

Kadoa setzt auf einen KI-zentrierten Ansatz. Du gibst eine URL ein, und die generative KI analysiert die Seite und erkennt automatisch strukturierte Daten – ganz ohne Selektoren oder HTML-Kenntnisse (). Besonders praktisch für Nicht-Programmierer, die große Datenmengen ohne eigenen Scraper extrahieren möchten.

Zyte API: Web Scraping API für Unternehmen

Zyte (früher Scrapinghub) ist ein Schwergewicht im Scraping-Bereich. Die Zyte API ist eine Komplettlösung, die Extraktion, Proxy-Management und Anti-Ban-Maßnahmen vereint (). Entwickelt für Entwickler und Unternehmen, die große Datenmengen zuverlässig und skalierbar extrahieren möchten – inklusive KI-gestützter Felderkennung und robuster Infrastruktur.

Oxylabs API: Hochvolumiges Web Scraping für Unternehmen

Oxylabs ist bekannt für riesige Proxy-Netzwerke und leistungsstarkes Scraping. Die Oxylabs Web Scraper API ist auf Performance und Skalierbarkeit ausgelegt – auch bei komplexen Seiten, mit über 100 Millionen IPs im Pool ().

Decodo: Flexibles Web Scraping für Entwickler

Decodo (von Smartproxy) ist eine Entwickler-zentrierte Web Scraping API mit Fokus auf Flexibilität und Anpassbarkeit. Sie übernimmt Proxys, Headless-Browser-Rendering, CAPTCHAs und bietet über 100 vorgefertigte Templates für gängige Seiten ().

Webscraper.io: Schnelle Extraktion von Tabellen und Listen

Die Browser-Erweiterung von Webscraper.io glänzt bei der schnellen, unkomplizierten Extraktion von Tabellen und Listen auf strukturierten Seiten. Du klickst auf ein paar Elemente, und das Tool erkennt das Muster und extrahiert alle ähnlichen Daten (). Perfekt für Analysten oder Marketer, die schnelle Ergebnisse brauchen – für komplexe Navigation oder große Datenmengen ist es jedoch nicht ausgelegt.

ScraperAPI: Web Scraping Infrastruktur ohne Aufwand

ScraperAPI ist der beste Freund von Entwicklern, die sich nicht mit Infrastruktur beschäftigen wollen. Du übergibst einfach die Ziel-URL an die API, und das Tool übernimmt Proxys, CAPTCHAs und Anti-Bot-Maßnahmen – und liefert das rohe HTML oder gerenderte Inhalte zurück ().

ScrapingBot: E-Commerce- und Produktdaten-Extraktion

ScrapingBot ist spezialisiert auf E-Commerce- und Retail-Daten. Die APIs sind darauf ausgelegt, Produktdetails, Preise, Bewertungen und mehr von bekannten Online-Shops zu extrahieren (). Die Ergebnisse kommen als strukturierte JSONs – ideal für Preisvergleiche, Produktanalysen oder Bestandsmanagement.

Firecrawl: Schnelles Web Scraping mit Cloud-Unterstützung

Firecrawl ist ein modernes, cloudbasiertes Open-Source-Tool, das „LLM-ready“ ist – also speziell dafür entwickelt, Daten für KI-Modelle und Anwendungen bereitzustellen (). Es kann Webseiten crawlen, durchsuchen und Daten als JSON oder Markdown ausgeben.

Octoparse: Visueller Web-Scraper mit Vorlagen

Octoparse ist ein Schwergewicht im No-Code-Web-Scraping mit visueller Oberfläche und einer riesigen Vorlagenbibliothek für beliebte Seiten (). Du richtest Scraping-Aufgaben per Klick im integrierten Browser ein, und die Auto-Detect-Funktion erkennt Listen oder Tabellen oft automatisch.

Diffbot: KI-gestützte Webdaten-Extraktion

Diffbot ist das „Gehirn“ unter den Web-Extraktoren. Es nutzt KI, Computer Vision und NLP, um automatisch strukturierte Daten aus beliebigen Webseiten zu extrahieren (). Du gibst eine URL ein, und Diffbot liefert ein JSON mit allen relevanten Feldern – ganz ohne Konfiguration.

ScrapingBee: Entwicklerfreundliche Web Scraping API

ScrapingBee ist eine einfache, auf Entwickler ausgerichtete API, die Headless-Browser, Proxys und Anti-Bot-Maßnahmen übernimmt (). Besonders geeignet für JavaScript-lastige Seiten – einfach render_js=true setzen und du bekommst das vollständig gerenderte HTML.

Dexi.io: Cloudbasiertes Web Scraping für Fortgeschrittene

Dexi.io (früher CloudScrape) ist eine cloudbasierte Plattform für komplexe Scraping-Workflows. Du entwirfst „Roboter“ per Drag-and-Drop, die in der Cloud laufen und Navigation, Extraktion sowie Integration mit anderen Systemen übernehmen ().

Vergleich auf einen Blick: Welcher Web-Scraper passt zu dir?

Hier eine schnelle Vergleichstabelle, um die passende Lösung zu finden:

| Tool | Ansatz & Hauptfunktionen | Ideal für | Startpreis (USD) |

|---|---|---|---|

| Thunderbit | KI-basiert, natürliche Sprache, automatische Felderkennung, Unterseiten-Navigation, Export zu Sheets/Airtable/Notion | Business-Anwender ohne Technikkenntnisse | Kostenlos (6 Seiten); $9/Monat+ |

| ParseHub | Visuelle Desktop-App, unterstützt JS/Formulare, ML-Mustererkennung | Technikaffine Nutzer, komplexe Seiten | Kostenlos; $189/Monat+ |

| Web Scraper (Ext.) | Browser-Erweiterung, Point-and-Click-Sitemaps, CSV/JSON-Export | Einsteiger, einfache Listen/Tabellen | Kostenlos; $50/Monat+ (Cloud) |

| Kadoa | KI-basiert, No-Code, generative KI erkennt Daten | Nicht-Programmierer, automatisierte Extraktion | Kostenlos; $39/Monat+ |

| Zyte API | Enterprise-API, Proxys, Headless-Browser, KI-Parsing | Entwickler/Unternehmen, skalierbares Crawling | $450/Monat+ |

| Oxylabs API | Hochvolumige API, 100M+ Proxys, KI-Code-Assistent | Große, technische Teams | $49/Monat+ |

| Decodo | API mit Zeitplanung, anpassbar, Anti-Block | Entwickler, flexible Code-Integration | $29/Monat+ |

| Webscraper.io | Erweiterung, einfache Listen-/Tabellenextraktion, Point-and-Click | Einfache, einmalige Datenabfragen | Kostenlos |

| ScraperAPI | API für HTML, Proxys, CAPTCHA-Handling | Entwickler, skalierbares Scraping ohne Infrastruktur | Kostenlos; $49/Monat+ |

| ScrapingBot | Daten-API für E-Commerce, strukturiertes JSON (Produktinfos etc.) | E-Commerce-Daten, Produktanalysen | Kostenlos; €39/Monat+ |

| Firecrawl | Open-Source/Cloud, schnelles Crawling, LLM-ready Daten (JSON/Markdown) | Entwickler von KI-Anwendungen, schnelles Site-Crawling | Kostenlos; $16/Monat+ |

| Octoparse | No-Code visuell, Vorlagenbibliothek, unterstützt Logins/AJAX | Analysten/Teams, Power ohne Programmierung | Kostenlos; $119/Monat+ |

| Diffbot | KI/ML-Extraktions-API, keine Selektoren, Knowledge Graph | Unternehmen/Forschung, automatisierte strukturierte Daten | $299/Monat+ |

| ScrapingBee | API, Headless Chrome, Proxys, CAPTCHA-Lösung | Entwickler für JS-lastige Seiten | Kostenlos; $49/Monat+ |

| Dexi.io | Cloud-Plattform, visueller Roboter-Builder, Scripting, Enterprise-Integration | Fortgeschrittene Nutzer, große/komplexe Workflows | $119/Monat+ |

Wie du den besten Web-Scraper für dein Unternehmen auswählst

- Nicht-Techniker: Setze auf KI-basierte, No-Code-Tools wie , Octoparse oder die Web Scraper-Erweiterung. Sie sind einfach, schnell und benötigen keine Programmierkenntnisse.

- Technische Nutzer/Entwickler: Du bevorzugst APIs und Scripting? Dann sind ScraperAPI, ScrapingBee, Oxylabs API oder Decodo die richtige Wahl.

- Unternehmen/große Projekte: Du brauchst Zuverlässigkeit, Compliance und Skalierbarkeit? Zyte API, Oxylabs, Dexi.io oder Diffbot sind für dich gemacht.

- Spezielle Datentypen: Für E-Commerce- oder Produktdaten sparen ScrapingBot oder Diffbot Zeit durch strukturierte Ausgaben.

- Integration: Thunderbit, Dexi.io und Octoparse bieten nahtlose Exporte zu Sheets, Airtable, Notion und mehr.

- Budget: Die Preisspanne reicht von kostenlosen Erweiterungen bis zu Enterprise-Lösungen. Starte klein, teste verschiedene Tools und skaliere bei Bedarf.

Tipp: Probier mehrere Plattformen mit kostenlosen Testphasen aus. Finde heraus, welches Tool am besten zu deinem Workflow passt und die gewünschten Daten liefert.

Thunderbits Alleinstellungsmerkmal: Die Zukunft des Web-Scrapings

Warum sticht Thunderbit besonders hervor? Aus meiner Erfahrung in SaaS und Automatisierung weiß ich, wie sehr KI das Web Scraping verändert. Thunderbit ist hier Vorreiter:

- Kein Setup, natürliche Sprache: Keine Konfiguration, keine Plugins, keine Lernkurve. Einfach beschreiben, was du brauchst, und Thunderbits KI erledigt den Rest ().

- KI-Anpassungsfähigkeit: Thunderbits KI passt sich an Webseitenänderungen an und erkennt neue Muster – das macht das Tool besonders wartungsarm ().

- Integrierte Datenverarbeitung: Daten werden direkt beim Extrahieren bereinigt, transformiert, übersetzt und zusammengefasst – ohne zusätzliche Schritte ().

- Businessfreundliche Integrationen: Ein-Klick-Export zu Notion, Airtable, Google Sheets und mehr ().

- Teamfähig & zugänglich: Jeder im Team kann Thunderbit nutzen, nicht nur die IT. Webdaten werden so für alle zugänglich.

Thunderbit ist das Tool, das ich mir früher gewünscht hätte. Es bringt Web Scraping wirklich „für alle“ – und wird mit jeder KI-Generation noch leistungsfähiger.

Fazit: Mit dem richtigen Web-Scraper zu besseren Geschäftseinblicken

Webdaten sind das neue Gold – und Web-Scraper die Werkzeuge, um es zu heben. Egal, ob du Wettbewerber beobachtest, Leads generierst oder dein nächstes KI-Projekt startest: Mit dem passenden Scraper erschließt du wertvolle Erkenntnisse. 2025 musst du dafür kein Entwickler mehr sein – KI-Tools wie Thunderbit und viele weitere machen Web Scraping für alle zugänglich.

Was jetzt? Teste verschiedene Tools, finde die beste Lösung für deinen Workflow und verwandle das Web in deine persönliche Business-Intelligence-Quelle. Und wenn du die Zukunft des Web Scrapings erleben willst, und erlebe, wie einfach Webdaten sein können.

Du willst tiefer einsteigen? Weitere Anleitungen findest du im , zum Beispiel oder .

Häufige Fragen

1. Muss ich programmieren können, um einen Web-Scraper zu nutzen?

Nein, das ist heute nicht mehr nötig. Tools wie Thunderbit, Octoparse und Kadoa sind für Nicht-Techniker gemacht. Du beschreibst einfach, was du brauchst, und das Tool extrahiert die Daten – ganz ohne XPath, Programmierung oder Setup.

2. Was unterscheidet KI-basierte von klassischen Web-Scrapern?

KI-Scraper (wie Thunderbit oder Diffbot) erkennen Felder automatisch, passen sich an Webseitenänderungen an und navigieren durch Unterseiten – mit minimalem Aufwand. Klassische Scraper erfordern meist manuelle Konfiguration, Selektoren und mehr Wartung.

3. Ist Web Scraping legal?

Das hängt davon ab, was du scrapen willst und wie du die Daten nutzt. Schau dir immer die Nutzungsbedingungen der Website an und vermeide das Sammeln persönlicher oder sensibler Daten. Viele Tools (wie Zyte oder Oxylabs) bieten Compliance-Features für Unternehmen.

4. Kann ich auch dynamische Seiten oder Login-Bereiche scrapen?

Ja – dafür brauchst du einen Scraper, der JavaScript-Rendering oder Headless-Browsing unterstützt. Tools wie Thunderbit, ParseHub, ScrapingBee und Zyte API kommen mit dynamischen Inhalten, Endlos-Scroll, AJAX und Logins (mit Einrichtung) klar.

5. Welcher Web-Scraper ist für kleine Unternehmen oder Startups am besten?

Wenn du Wert auf einfache Bedienung und schnelle Ergebnisse legst, ist Thunderbit eine Top-Wahl. Es gibt einen kostenlosen Plan, KI-gestützte Felderkennung und direkten Export zu Google Sheets und Notion. Auch ScraperAPI und Kadoa sind günstige Optionen für wachsende Teams.