Das Web ist eine wahre Daten-Goldmine – und 2026 ist der Wettlauf, aus diesem riesigen Durcheinander echten Mehrwert fürs Business zu ziehen, spannender als je zuvor. Ich habe hautnah miterlebt, wie Vertriebs-, E-Commerce- und Operationsteams ihre Abläufe komplett umgekrempelt haben, indem sie stundenlanges, eintöniges Copy-Paste durch clevere Automatisierung ersetzt haben. Wer heute noch keinen Web-Scraper nutzt, bleibt nicht nur auf der Strecke – der hängt wahrscheinlich immer noch in der Excel-Hölle fest, während die Konkurrenz schon entspannt beim zweiten Kaffee sitzt.

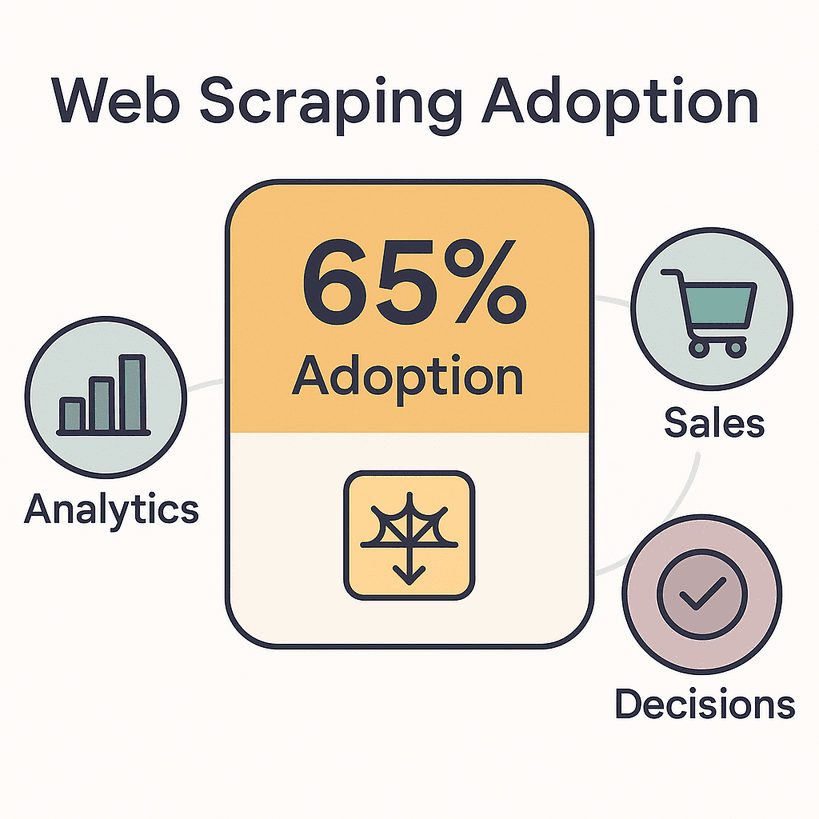

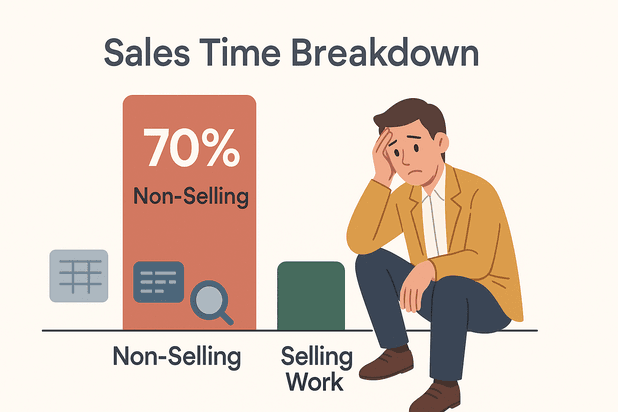

Die Zahlen sprechen für sich: , um Analysen, Vertrieb und Entscheidungen zu pushen. Der globale Markt für Webdaten-Extraktion ist schon – und wird sich bis 2030 vermutlich verdoppeln. Vertriebsleute verbringen bis zu mit Aufgaben wie Dateneingabe und Recherche – Zeit, die man viel besser fürs Abschließen von Deals oder wenigstens für eine entspannte Mittagspause nutzen könnte.

Welche Web-Scraping-Software ist also 2026 die beste Wahl? Ich habe die fünf Top-Tools getestet, die Teams jeder Größe und mit jedem technischen Background echte Vorteile bringen. Egal, ob du ohne Programmierkenntnisse direkt loslegen willst oder als Entwickler maximale Flexibilität suchst – hier findest du das passende Tool.

Was macht eine richtig gute Web-Scraping-Software aus?

Mal ehrlich: Nicht jeder Web-Scraper ist gleich. Die besten Tools 2026 überzeugen, weil sie das Extrahieren von Daten schnell, zuverlässig und für alle zugänglich machen – nicht nur für Python-Profis.

Das sind die wichtigsten Kriterien, auf die ich achte (und die auch für Unternehmen entscheidend sind):

- Benutzerfreundlichkeit: Können auch Nicht-Techniker in wenigen Minuten einen Scrape einrichten? No-Code und KI-gestützte Oberflächen sind heute Pflicht.

- Vielfalt der Datenquellen: Werden Webseiten, PDFs, Bilder und dynamische Inhalte (z. B. Infinite Scroll, AJAX) unterstützt? Je mehr Quellen, desto besser.

- Automatisierung & Zeitplanung: Lassen sich wiederkehrende Scrapes planen, Paginierung und Unterseiten automatisieren? Nur so wird aus „einmal einrichten und vergessen“ kein „ständig nachjustieren“.

- Integration & Export: Kann direkt nach Excel, Google Sheets, Notion, Airtable oder per API exportiert werden? Weniger manuelle Nacharbeit = mehr Zufriedenheit im Team.

- Technische Anforderungen: Ist das Tool wirklich No-Code oder braucht man doch Regex-Kenntnisse? Die besten Lösungen sprechen Einsteiger und Profis gleichermaßen an.

- Skalierbarkeit: Schafft das Tool hunderte oder tausende Seiten, ohne abzustürzen?

- Support & Community: Gibt es gute Dokumentation, schnellen Support und eine aktive Nutzerbasis?

Diese Punkte sind nicht nur „nice to have“ – sie entscheiden darüber, ob ein Tool dir Stunden spart oder Tage kostet. 2026, wenn , ist der richtige Web-Scraper ein echter Wettbewerbsvorteil.

Hier kommen die fünf besten Tools im Überblick.

Die 5 besten Web-Scraping-Tools 2026

- für No-Code, KI-gestütztes Multi-Source-Scraping

- für Enterprise-Integration und skalierbare Datenpipelines

- für Entwickler, die maximale Flexibilität suchen

- für visuelles, No-Code-Scraping mit Zeitplanung

- für einfache, klickbasierte Datenerfassung

1. Thunderbit: Die einfachste KI-gestützte Web-Scraping-Software

ist meine absolute Empfehlung für alle, die Webdaten extrahieren wollen, ohne auch nur eine Zeile Code zu schreiben. Zugegeben, ich bin etwas voreingenommen – ich habe an Thunderbit mitgearbeitet. Aber das Tool wurde speziell für Business-Anwender entwickelt, die Ergebnisse wollen, keine Kopfschmerzen.

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Einfach auf „KI-Felder vorschlagen“ klicken – Thunderbits KI liest die Seite, schlägt relevante Daten vor und richtet den Scraper automatisch ein. Keine Selektoren, keine Vorlagen, kein Stress.

- Multi-Source-Scraping: Nicht nur Webseiten, sondern auch PDFs und Bilder lassen sich extrahieren. Thunderbit holt Text, Links, E-Mails, Telefonnummern und Bilder – mit nur zwei Klicks.

- Automatisierung für Unterseiten & Paginierung: Du willst Details von jeder Produkt- oder Profilseite? Thunderbit folgt Links, sammelt Zusatzinfos und fügt sie direkt in deine Tabelle ein. Auch Infinite Scroll und Paginierung werden problemlos gemeistert.

- Batch- & Zeitplanung: Einfach eine Liste von URLs einfügen, regelmäßige Jobs planen und Thunderbit übernimmt den Rest – egal ob tägliches Preis-Monitoring oder wöchentliche Lead-Updates.

- Sofort-Export: Exportiere direkt nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON. Schluss mit Copy-Paste-Marathons.

- Individuelle KI-Prompts: Du möchtest Daten beim Scrapen kategorisieren, übersetzen oder labeln? Einfach eine Anweisung hinzufügen – Thunderbits KI erledigt den Rest.

- Cloud- oder Browser-Modus: Scrapes laufen entweder in der Cloud (bis zu 50 Seiten gleichzeitig) oder lokal – ideal für Seiten mit Login.

Thunderbit wird von über eingesetzt – vom Vertrieb über Immobilien bis zu kleinen E-Commerce-Shops. Im kostenlosen Tarif kannst du bis zu 6 Seiten (bzw. 10 mit Test-Boost) scrapen, bezahlt wird nur pro Ergebniszeile.

Warum ich es liebe: Thunderbit ist das einzige Tool, das ich kenne, bei dem auch Nicht-Techniker in unter fünf Minuten von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ kommen. Die Oberfläche ist wirklich intuitiv (wir haben sie mit viel Liebe entwickelt) und die KI passt sich Website-Änderungen an – du musst also nicht ständig kaputte Scraper reparieren.

Ideal für: Vertrieb, E-Commerce, Operations und alle, die No-Code, KI-gestütztes Scraping ohne Wartungsaufwand suchen.

Noch mehr Tipps findest du im .

2. Import.io: Enterprise-Grade Web-Scraping und Integration

ist die Top-Wahl für Unternehmen, die Webdaten in großem Stil brauchen – und diese direkt in ihre Systeme einbinden wollen.

Was macht Import.io besonders?

- Enterprise-taugliche Pipelines: Import.io ist mehr als ein Scraper – es ist eine komplette Webdaten-Integrationsplattform. „Data-as-a-Service“ mit kontinuierlichen, automatisierten Datenströmen.

- Selbstheilende KI: Ändert sich eine Website, versucht die KI von Import.io, Felder automatisch neu zuzuordnen – so bleiben deine Pipelines stabil.

- Leistungsstarke Automatisierung: Scrapes lassen sich stündlich, täglich oder nach individuellem Zeitplan ausführen. Bei Problemen oder ungewöhnlichen Daten gibt es automatische Benachrichtigungen.

- Interaktive Workflows: Auch Seiten mit Logins, Formularen oder mehrstufiger Navigation werden unterstützt. Import.io kann komplexe Abläufe aufzeichnen und wiederholen.

- Compliance & Governance: Automatische Erkennung und Maskierung von personenbezogenen Daten sowie Audit-Logs – wichtig für regulierte Branchen.

- API & Integration: Daten können direkt in Google Sheets, Excel, Tableau, Power BI, Datenbanken oder eigene Anwendungen gestreamt werden.

Import.io wird von Marken wie Unilever, Volvo und RedHat genutzt. Typische Anwendungsfälle sind Preisüberwachung auf tausenden E-Commerce-Seiten, Marktanalysen oder das Füttern von KI/ML-Modellen mit aktuellen Webdaten.

Preise: Import.io ist eine Premium-Lösung, die bei etwa 299 $/Monat für Self-Service-Tarife startet. Es gibt eine kostenlose Testphase, aber keinen dauerhaften Gratis-Tarif. Für Unternehmen mit hohem Datenbedarf lohnt sich die Investition.

Ideal für: Unternehmen und datengetriebene Organisationen, die Zuverlässigkeit, Skalierbarkeit, Compliance und tiefe Integration benötigen.

3. Scrapy: Open-Source-Web-Scraping-Framework für Entwickler

ist das Open-Source-Tool für Entwickler, die maximale Kontrolle und Flexibilität wollen. Wer Python beherrscht, bekommt mit Scrapy das Schweizer Taschenmesser fürs Web-Scraping.

Warum Entwickler Scrapy lieben:

- Vollständige Anpassbarkeit: Eigene „Spiders“ (Skripte) schreiben, um Daten exakt nach Wunsch zu crawlen, zu parsen und zu verarbeiten. Auch komplexe Abläufe und Datenbereinigung sind möglich.

- Asynchron & schnell: Die Architektur von Scrapy ist auf Geschwindigkeit und Skalierbarkeit ausgelegt – hunderte Seiten pro Minute oder Millionen mit verteilten Crawlern.

- Erweiterbar: Riesiges Ökosystem an Plugins und Middleware für Proxies, Headless-Browser (Splash/Playwright) und Integrationen.

- Kostenlos & Open Source: Keine Lizenzgebühren. Läuft auf eigener Hardware oder in der Cloud – skalierbar nach Bedarf.

- Starke Community: Über 55.000 GitHub-Sterne und eine große Nutzerbasis. Bei Problemen findet sich fast immer eine Lösung.

Zu beachten: Scrapy setzt Python-Kenntnisse und Erfahrung mit der Kommandozeile voraus. Es gibt keine Klick-Oberfläche – hier ist Coding gefragt. Für individuelle Projekte, KI-Trainingsdaten oder riesige Crawls ist Scrapy aber unschlagbar.

Ideal für: Unternehmen mit eigenen Entwicklern, individuelle Datenpipelines oder große, komplexe Scraping-Projekte.

4. Octoparse: Visuelles Web-Scraping einfach gemacht

ist besonders beliebt bei Anwendern ohne Programmierkenntnisse, die trotzdem leistungsstarkes Scraping mit einer visuellen Oberfläche wollen.

Warum Octoparse überzeugt:

- Visueller Workflow-Builder: Einfach Elemente im integrierten Browser anklicken – Octoparse erkennt Muster automatisch. Kein Code, nur klicken und extrahieren.

- Dynamische Inhalte: Auch AJAX, Infinite Scroll und passwortgeschützte Seiten werden unterstützt. Klicks, Scrolls und Formulare können simuliert werden.

- Cloud-Scraping & Zeitplanung: Aufgaben laufen in der Cloud (schneller, parallelisiert) und lassen sich regelmäßig planen – für stets aktuelle Daten.

- Vorlagen: Hunderte Templates für bekannte Seiten (Amazon, Twitter, Zillow etc.) ermöglichen den Sofortstart.

- Export & API: Ergebnisse als CSV, Excel, JSON herunterladen oder per API abrufen. Integration mit Google Sheets oder Datenbanken möglich.

Octoparse gilt als „super einfach, auch für Einsteiger“. Die Gratis-Version ist eingeschränkt, aber ab ca. 83 $/Monat gibt es Cloud-Runs, Zeitplanung und mehr Geschwindigkeit.

Ideal für: Nicht-Techniker, Marketer, Forscher und kleine Teams, die regelmäßig automatisiert Daten sammeln möchten – ganz ohne Programmieren.

5. ParseHub: Benutzerfreundliche Datenextraktion für den Alltag

ist ein weiteres No-Code-Tool, das besonders bei kleinen Unternehmen und Freelancern beliebt ist, die alltägliche Datenerfassung automatisieren möchten.

Was ParseHub auszeichnet:

- Klickbasierte Bedienung: Daten werden einfach per Mausklick im Browser ausgewählt. Workflows werden visuell erstellt – ganz ohne Code.

- Dynamische & JS-Seiten: Auch JavaScript-lastige Seiten, Infinite Scroll und mehrstufige Navigation sind kein Problem.

- Cloud- & lokale Ausführung: Scrapes laufen auf dem eigenen Rechner oder in der Cloud. Zeitplanung und API-Zugriff (bei höheren Tarifen) inklusive.

- Exportmöglichkeiten: Daten als CSV, Excel oder JSON herunterladen. API-Zugriff für Automatisierung.

- Plattformübergreifend: Verfügbar für Windows, Mac und Linux.

Der Gratis-Tarif von ParseHub ist auf 200 Seiten pro Lauf begrenzt, aber ab ca. 189 $/Monat gibt es mehr Leistung, Geschwindigkeit und API-Zugriff.

Ideal für: Kleine Unternehmen, Freelancer und Teams mit einfachen Scraping-Anforderungen, die ein zuverlässiges, visuelles Tool suchen.

Vergleichstabelle: Die besten Web-Scraping-Tools im Überblick

| Tool | Benutzerfreundlichkeit | Datenquellen | Automatisierung & Zeitplanung | Integration & Export | Technische Anforderungen | Preisgestaltung |

|---|---|---|---|---|---|---|

| Thunderbit | No-Code, KI-gestützt | Web, PDF, Bilder | Unterseiten, Paginierung, geplant, Batch | Excel, Sheets, Notion, Airtable, CSV, JSON | Keine | Freemium (pro Zeile) |

| Import.io | Point-and-Click UI | Web (statisch/dynamisch, Login) | Selbstheilend, geplant, Benachrichtigungen | API, BI-Tools, Sheets, Excel, DB | Gering–Mittel | ab $299/Monat |

| Scrapy | Code erforderlich | Web, APIs, (JS via Add-ons) | Vollautomatisierung per Code | Beliebig (per Code) | Python-Entwickler | Kostenlos (Open Source) |

| Octoparse | Visuell, No-Code | Web (dynamisch, Login) | Cloud-Planung, Vorlagen | CSV, Excel, JSON, API | Keine | ab $83/Monat |

| ParseHub | Visuell, No-Code | Web (JS, dynamisch) | Cloud/lokal, geplant | CSV, Excel, JSON, API | Keine | ab $189/Monat |

Wie finde ich das beste Web-Scraping-Tool für mein Unternehmen?

Du bist unsicher, welches Tool zu dir passt? Hier meine Schnellübersicht:

- Für Nicht-Techniker und schnelle Ergebnisse: oder . Thunderbit ist unschlagbar für sofortiges, KI-gestütztes Scraping aus verschiedenen Quellen (Web, PDF, Bilder). Octoparse punktet mit visuellen, geplanten Scrapes.

- Für Enterprise-Integration, Compliance und Skalierung: ist die beste Wahl. Es bietet kontinuierliche, zuverlässige Datenpipelines und tiefe Integration.

- Für Entwickler, individuelle Projekte oder große Crawls: ist das Tool der Wahl. Python-Kenntnisse sind nötig, dafür gibt es maximale Flexibilität.

- Für kleine Unternehmen, Freelancer oder Alltagsaufgaben: ist eine solide, benutzerfreundliche Lösung für klickbasiertes Scraping und moderate Automatisierung.

Tipps für die Auswahl:

- Wähle das Tool passend zu den technischen Fähigkeiten und Datenanforderungen deines Teams.

- Berücksichtige die Komplexität der zu scrapenden Seiten (dynamische Inhalte? Logins?).

- Überlege, wie du die Daten nutzen willst – brauchst du direkten Export zu Sheets oder tiefe API-Integration?

- Starte mit einer kostenlosen Testversion oder einem Freemium-Tarif für echte Praxistests.

- Unterschätze nicht den Wert von gutem Support und verständlicher Dokumentation.

Fazit: Mit den besten Web-Scraping-Tools das Maximum aus Daten holen

Webdaten sind 2026 der Treibstoff für klügere Geschäftsentscheidungen. Die richtige Web-Scraping-Software spart dir Zeit, reduziert Fehler und verschafft deinem Team einen echten Vorsprung – egal ob du Lead-Listen erstellst, Wettbewerber beobachtest oder deine Analysen fütterst.

Kurz gesagt:

- Thunderbit ist der einfachste, KI-gestützte No-Code-Scraper für Business-Anwender.

- Import.io ist die Enterprise-Lösung für kontinuierliche, integrierte Datenpipelines.

- Scrapy ist das Open-Source-Toolkit für Entwickler mit maximaler Kontrolle.

- Octoparse und ParseHub machen visuelles, No-Code-Scraping für alle zugänglich.

Die meisten Tools bieten kostenlose Testphasen oder Freemium-Tarife – probiere sie aus! Automatisiere die Routine, entdecke neue Insights und lass dein Team sich auf das Wesentliche konzentrieren.

Viel Erfolg beim Scrapen – und möge deine Datenquelle immer frisch, strukturiert und einsatzbereit sein.

Häufige Fragen (FAQ)

1. Wofür wird Web-Scraping-Software eingesetzt?

Web-Scraping-Software automatisiert das Extrahieren von Informationen aus Webseiten, PDFs und Bildern. Sie wird für Lead-Generierung, Preisüberwachung, Marktforschung, Content-Aggregation und vieles mehr genutzt.

2. Ist Web-Scraping legal?

Web-Scraping ist legal, solange nur öffentlich zugängliche Daten gesammelt und die Nutzungsbedingungen sowie Datenschutzgesetze eingehalten werden. Prüfe immer die Richtlinien der jeweiligen Website und nutze Daten verantwortungsvoll.

3. Muss ich programmieren können, um Web-Scraping-Software zu nutzen?

Nicht unbedingt! Tools wie Thunderbit, Octoparse und ParseHub sind für Nicht-Programmierer gemacht. Für komplexere oder individuelle Projekte sind Entwickler-Tools wie Scrapy sinnvoll.

4. Wie exportiere ich gescrapte Daten nach Excel oder Google Sheets?

Die meisten modernen Scraper (Thunderbit, Octoparse, ParseHub) bieten einen Klick-Export zu Excel, Google Sheets, CSV oder sogar direkte Integration mit Notion und Airtable.

5. Kommen Web-Scraping-Tools auch mit dynamischen Seiten oder Logins klar?

Ja – Top-Tools wie Import.io, Octoparse und ParseHub unterstützen dynamische Inhalte (AJAX, Infinite Scroll) und passwortgeschützte Seiten. Auch Thunderbit kann Daten von dynamischen Seiten und Unterseiten extrahieren.

Du willst sehen, wie modernes Web-Scraping funktioniert? oder stöbere im für weitere Tipps, Anleitungen und Einblicke in die Welt der KI-gestützten Datenextraktion.