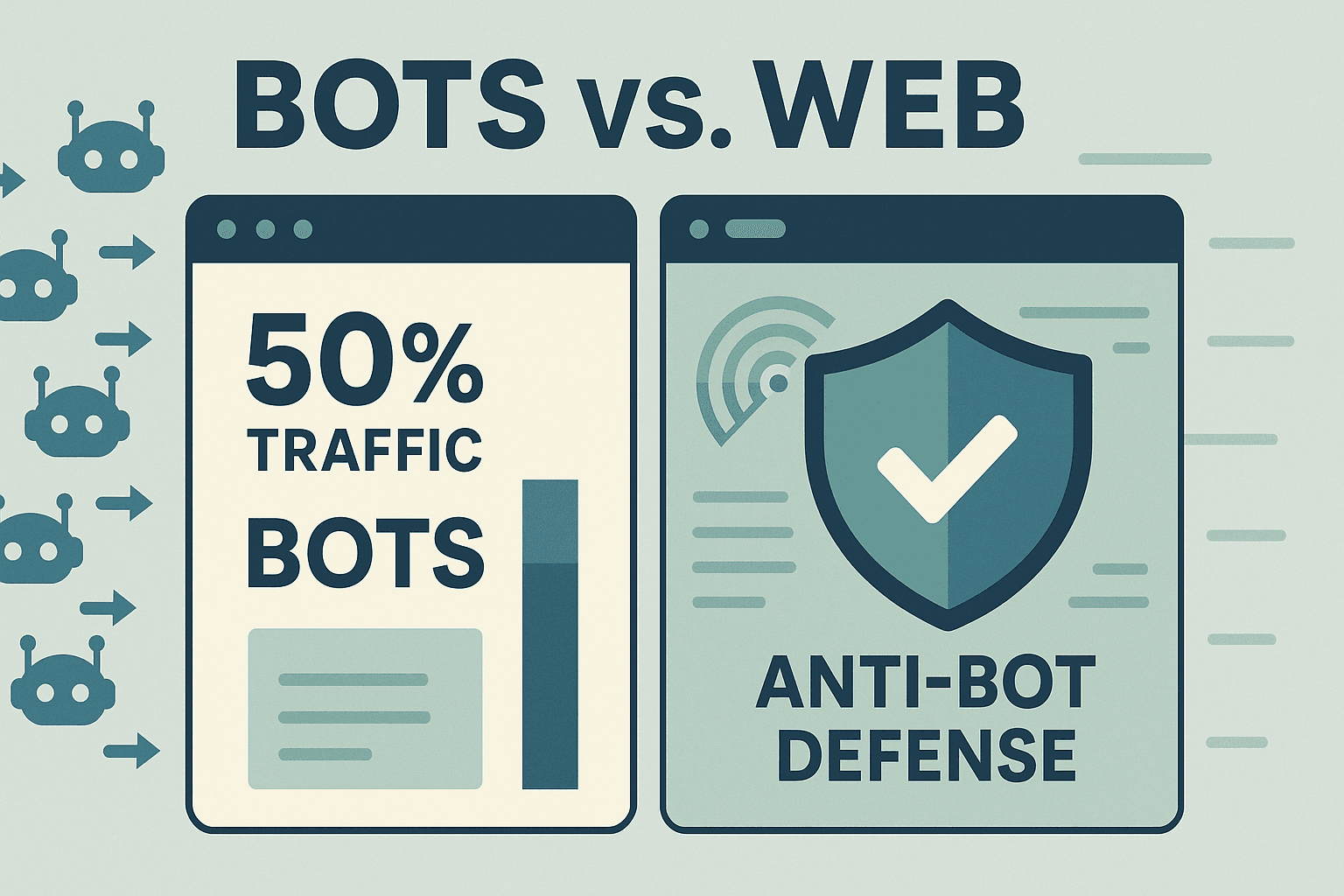

Das Internet im Jahr 2025 fühlt sich an wie der Wilde Westen – mittlerweile stammt fast die Hälfte des gesamten Traffics nicht mehr von echten Menschen. Richtig gelesen: Bots machen inzwischen fast aus, und die Anti-Bot-Systeme werden immer ausgefuchster. Aus meiner langjährigen Erfahrung mit Automatisierung und Web-Scraping weiß ich: Schon ein kleiner Fehler – wie der falsche User Agent – kann ein ganzes Datenprojekt zum Scheitern bringen. Für Teams aus Vertrieb, E-Commerce oder Operations ist eine Blockierung durch eine Website nicht nur nervig, sondern kann auch zu verpassten Leads, veralteten Preisen oder Umsatzeinbußen führen.

Die gute Nachricht: Du musst kein Technikprofi sein, um diese Hürden zu meistern. In diesem Guide zeige ich dir, warum die richtige User-Agent-Strategie beim Scraping heute so wichtig ist, wie du typische Fehler vermeidest und wie das User-Agent-Management so einfach macht, dass du es kaum noch bemerkst. Egal, ob du Leads sammelst, Produktdaten trackst oder deine Tabellen aktuell halten willst – hier erfährst du, wie du der Konkurrenz immer einen Schritt voraus bist.

Warum der beste User Agent beim Scraping so wichtig ist

Starten wir mit den Basics: Was ist ein User Agent? Stell dir den User Agent wie den „Ausweis“ deines Browsers vor. Jedes Mal, wenn du eine Website besuchst – egal ob als Mensch oder Bot – schickt dein Browser eine User-Agent-Zeichenkette im Request-Header mit. Das ist quasi die Vorstellung: „Hi, ich bin Chrome auf Windows“ oder „Ich bin Safari auf dem iPhone“ (). So sieht ein typischer Chrome-User-Agent aus:

1Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36Websites nutzen diese Info vor allem aus zwei Gründen:

- Um den passenden Inhalt auszuliefern (z. B. mobile oder Desktop-Ansicht).

- Um Bots und Scraper zu erkennen.

Wenn dein User Agent zum Beispiel „python-requests/2.28.1“ oder „Scrapy/2.9.0“ ist, ist das wie ein Namensschild mit „Hi, ich bin ein Bot!“. Viele Seiten haben Blocklisten für solche eindeutigen Kennungen und sperren dich schneller, als du „403 Forbidden“ sagen kannst. Mit einem aktuellen, gängigen Browser-User-Agent gehst du dagegen in der Masse unter.

Kurz gesagt: Dein User Agent ist deine Tarnung. Je besser die Tarnung, desto wahrscheinlicher bekommst du die Daten, die du willst.

Die Rolle des User Agents für deinen Scraping-Erfolg

Warum ist die Wahl des User Agents so entscheidend? Weil er für die meisten Anti-Bot-Systeme die erste Verteidigungslinie ist. Das kann passieren, wenn du den falschen auswählst:

- Sofortige Blockierung (403/429-Fehler): Nutzt du den Standard-User-Agent einer Scraping-Bibliothek, wirst du oft schon vor der Startseite ausgesperrt ().

- Leere oder gefälschte Daten: Manche Seiten liefern bei verdächtigen User Agents nur leere oder Dummy-Seiten aus.

- CAPTCHAs oder Weiterleitungen: Ein bot-typischer User Agent löst „Bist du ein Mensch?“-Abfragen oder endlose Login-Schleifen aus.

- Drosselung und Sperren: Wenn du mit demselben User Agent zu oft anfragst, wirst du gedrosselt oder die IP gesperrt.

So wirken sich verschiedene User Agents aus:

This paragraph contains content that cannot be parsed and has been skipped.

Die Lektion? Wähle deine Tarnung mit Bedacht. Und denk dran: Moderne Anti-Bot-Systeme prüfen nicht nur den User Agent. Sie vergleichen auch andere Header (wie Accept-Language oder Referer). Wenn du behauptest, Chrome zu sein, aber die Header nicht passen, fliegst du trotzdem auf ().

Hier kommt Thunderbit ins Spiel. Ich habe mit vielen Business-Anwendern gesprochen – Vertriebsmitarbeitern, E-Commerce-Managern, Maklern – die einfach nur Daten wollen, ohne sich mit HTTP-Headern beschäftigen zu müssen. Deshalb haben wir Thunderbit so entwickelt, dass das User-Agent-Management unsichtbar und automatisch abläuft.

Thunderbit: User-Agent-Management für alle ganz easy

Mit Thunderbits musst du keinen User Agent mehr auswählen. Unsere KI übernimmt das für dich und wählt für jede Seite die realistischste, aktuellste Browser-Signatur. Egal, ob du die nutzt (die tatsächlich den echten Chrome-UA verwendet) oder Cloud-Scraping (wo unsere KI aus einem Pool aktueller Browser-UAs rotiert) – du bewegst dich immer unauffällig im normalen Traffic.

Und es geht nicht nur um den User Agent. Thunderbit sendet einen vollständigen, konsistenten Header-Satz – Accept-Language, Accept-Encoding, Client Hints und mehr – damit deine Anfragen wie die eines echten Browsers aussehen. Keine widersprüchlichen Header mehr, keine Bot-Warnsignale.

Das Beste daran? Du musst nichts konfigurieren. Thunderbits KI übernimmt alle technischen Details im Hintergrund, sodass du dich auf das Wesentliche konzentrieren kannst: zuverlässige, hochwertige Daten zu bekommen.

Warum dynamische User-Agent-Rotation heute Pflicht ist

Du hast den perfekten User Agent gefunden? Einfach immer wieder verwenden? Lieber nicht! Im Jahr 2025 ist das ein klares Erkennungsmerkmal. Echte Nutzer verwenden verschiedene Browser, Versionen und Geräte. Wenn dein Scraper 500 Mal hintereinander mit demselben UA anfragt, ist das wie eine Parade identischer Zwillinge – das fällt auf.

Deshalb ist dynamische User-Agent-Rotation heute Standard. Die Idee: Für jede Anfrage oder Session wird aus einer Liste realistischer, aktueller User Agents rotiert. So wirkt dein Scraper wie eine Gruppe echter Besucher, nicht wie ein einzelnes Skript ().

Thunderbits KI-gestützte Rotation geht noch weiter. Bei mehrseitigen Crawls oder geplanten Jobs rotiert Thunderbit automatisch User Agents und kombiniert sie sogar mit unterschiedlichen Proxy-IPs. Wird eine Seite misstrauisch, passt Thunderbit sich in Echtzeit an – wechselt UA, passt Header an oder verlangsamt die Anfragen. All das läuft im Hintergrund, damit dein Scraping unentdeckt bleibt und die Daten zuverlässig fließen.

User Agent und Request-Header: Konsistenz ist alles

Ein Profi-Tipp: Der User Agent ist nur ein Teil des „Fingerabdrucks“ deiner Anfrage. Moderne Anti-Bot-Systeme prüfen, ob dein UA zu anderen Headern wie Accept-Language, Accept-Encoding und Referer passt. Wenn du Chrome auf Windows vorgibst, aber eine französische Accept-Language von einer New Yorker IP sendest, ist das verdächtig ().

Best Practice:

- Sende immer einen vollständigen Header-Satz, der zum User Agent passt.

- Halte Accept-Language und Accept-Encoding konsistent mit UA und (wenn möglich) der IP-Geolokation.

- Nutze die Entwicklertools deines Browsers, um echte Anfragen zu inspizieren und den vollständigen Header-Satz für deinen UA zu übernehmen.

Thunderbit übernimmt all das für dich. Unsere KI sorgt dafür, dass jede Anfrage perfekt abgestimmt ist – User Agent, Header und sogar der Browser-Fingerabdruck. Du bekommst ein menschlich wirkendes Anfrageprofil, ohne selbst Hand anlegen zu müssen.

Typische Fehler vermeiden: Was du bei User Agents NICHT tun solltest

Ich habe viele Scraping-Projekte an denselben Fehlern scheitern sehen. Die größten Stolperfallen:

- Standard-User-Agents von Scraping-Bibliotheken verwenden: Strings wie

python-requests/2.x,Scrapy/2.9.0oderJava/1.8führen fast immer zur Blockierung. - Veraltete Browser-Versionen: Wenn du 2025 als Chrome 85 auftrittst, wirkt das verdächtig. Nutze immer aktuelle Browser-Versionen.

- Unpassende Header: Sende keinen Chrome-UA mit fehlenden oder widersprüchlichen Accept-Language-, Accept-Encoding- oder Client-Hints-Headern.

- Bekannte Crawler-UAs: Alles mit „bot“, „crawler“, „spider“ oder Tool-Namen (wie AhrefsBot) ist ein Warnsignal.

- Leere oder unsinnige UAs: Manchmal erlaubt, aber meist verdächtig und unzuverlässig.

Schnell-Checkliste für sichere User Agents:

- Verwende echte, aktuelle Browser-UAs (Chrome, Firefox, Safari).

- Rotiere durch einen Pool von UAs.

- Halte die Header konsistent zum UA.

- Aktualisiere deine UA-Liste monatlich (Browser werden oft aktualisiert).

- Vermeide alles, was nach „Automatisierung“ aussieht.

Thunderbit in der Praxis: So profitieren Vertrieb und Operations

Kommen wir zur Praxis. So hilft Thunderbits User-Agent-Management echten Teams:

| Anwendungsfall | Früher: Manuelles Scraping | Mit Thunderbit | Ergebnis |

|---|---|---|---|

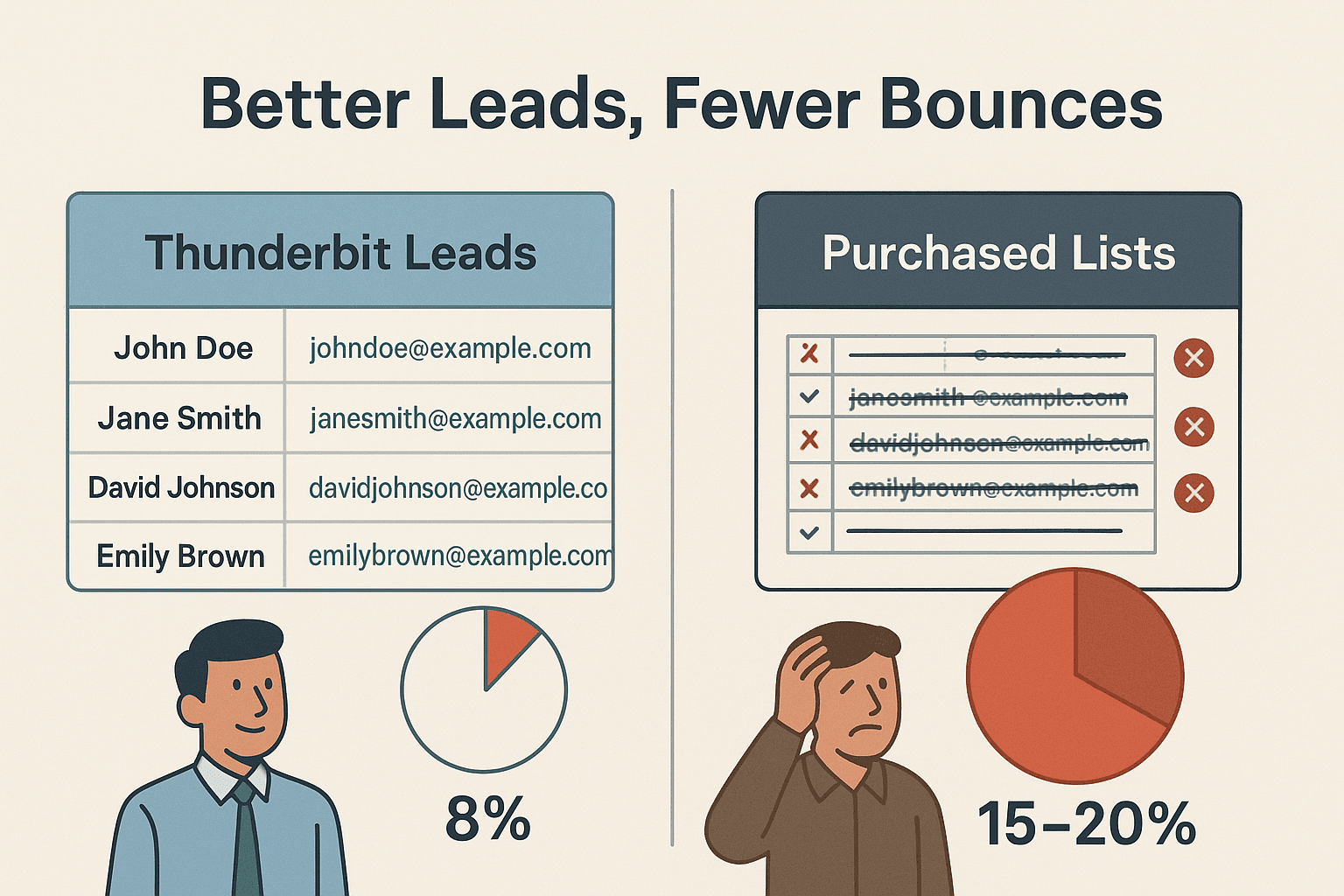

| Lead-Generierung | Häufige Blocks, fehlende Daten | KI wählt besten UA, rotiert, simuliert echtes Surfen | Mehr Leads, bessere Qualität, weniger Bounces |

| E-Commerce-Monitoring | Skriptfehler, IP-Sperren | Cloud-Scraping mit dynamischer UA- & Proxy-Rotation | Zuverlässige Preis-/Bestandsüberwachung |

| Immobilien-Listings | Aufwendige Anpassungen, Blocks | KI passt UA/Header an, steuert Unterseiten automatisch | Vollständige, aktuelle Objektlisten |

Ein Vertriebsteam, das Thunderbit nutzte, hat tausende Websites nach Leads durchsucht und erreichte nur eine ~8 % Bounce-Rate bei E-Mails – im Vergleich zu 15–20 % bei gekauften Listen (). Das ist der Vorteil von frischem, menschlich wirkendem Scraping.

Schritt für Schritt: So scrapest du mit dem besten User Agent via Thunderbit

So einfach startest du mit Thunderbit – ganz ohne Technikkenntnisse:

- Installiere die .

- Öffne die Zielseite. Logge dich ggf. ein – Thunderbit funktioniert auch auf eingeloggten Seiten.

- Klicke auf „KI schlägt Felder vor“. Die KI analysiert die Seite und schlägt passende Spalten zum Extrahieren vor.

- Passe die Felder bei Bedarf an. Benenne, ergänze oder entferne Spalten nach Wunsch.

- Klicke auf „Scrapen“. Thunderbit extrahiert die Daten und rotiert User Agents und Header automatisch im Hintergrund.

- Exportiere deine Daten. Direkt nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON herunterladen.

Du musst keine User Agents auswählen oder aktualisieren – Thunderbits KI übernimmt alles und passt sich jeder Seite optimal an.

Thunderbit vs. klassisches User-Agent-Management im Vergleich

So schneidet Thunderbit im Vergleich zum manuellen Vorgehen ab:

| Funktion/Aufgabe | Manuelles Scraping | Thunderbit-Ansatz |

|---|---|---|

| User-Agent-Einstellung | Recherche & Code-Anpassung | Automatisch, KI-gestützt pro Seite |

| UA aktuell halten | Manuell, wird oft vergessen | KI aktualisiert automatisch mit Browser-Trends |

| UA-Rotation | Eigene Logik programmieren | Integrierte, intelligente Rotation |

| Header-Konsistenz | Header manuell anpassen | KI sorgt für vollständigen, konsistenten Header-Satz |

| Blocks/CAPTCHAs umgehen | Manuell wechseln, hoher Aufwand | KI passt sich an, rotiert und wiederholt automatisch |

| Technisches Know-how nötig | Hoch (Coding, HTTP-Wissen) | Keins – für Business-Anwender entwickelt |

| Zeitaufwand für Fehlerbehebung | Häufig, frustrierend | Minimal – Fokus auf Daten, nicht auf Technik |

Thunderbit ist für alle gemacht, die zuverlässiges, skalierbares Scraping wollen – ohne Technikstress.

Fazit: So machst du deine User-Agent-Strategie zukunftssicher

Was ich (manchmal auf die harte Tour) über User-Agent-Management 2025 gelernt habe:

- Verwende niemals Standard- oder veraltete User Agents. Sie sind der Hauptgrund für Blockierungen.

- Rotier User Agents dynamisch. Vielfalt ist Trumpf – vermeide den „Bot-Parade“-Effekt.

- Halte Header konsistent und realistisch. Dein User Agent ist nur so glaubwürdig wie die übrigen Angaben.

- Bleib aktuell. Browser-Versionen ändern sich schnell – passe deine UA-Liste regelmäßig an.

- Lass KI die Arbeit machen. Tools wie Thunderbit setzen Best Practices automatisch um, damit du dich auf Ergebnisse statt Technik konzentrieren kannst.

Wenn du genug von Blockierungen und Skriptproblemen hast oder einfach professionell scrapen willst, ohne dich mit Details zu beschäftigen, . Unser KI-Web-Scraper wird weltweit von tausenden Nutzern eingesetzt und macht Webdaten für alle zugänglich – ganz ohne Technikstress.

Weitere Tipps, Anleitungen und Insights rund ums Web-Scraping findest du im .

Häufige Fragen (FAQ)

1. Was ist ein User Agent und warum ist er beim Web-Scraping wichtig?

Ein User Agent ist eine Zeichenkette, die bei jeder Webanfrage den Browser und das Betriebssystem identifiziert. Websites nutzen diese Info, um passende Inhalte auszuliefern und Bots zu erkennen. Mit dem richtigen User Agent bleibt dein Scraper unauffällig und wird seltener blockiert.

2. Warum sollte ich nicht den Standard-User-Agent meiner Scraping-Bibliothek verwenden?

Standard-User-Agents wie python-requests/2.x sind als Bot-Signaturen bekannt und werden oft sofort blockiert. Nutze immer realistische, aktuelle Browser-User-Agents.

3. Wie handhabt Thunderbit die User-Agent-Rotation?

Thunderbits KI rotiert automatisch durch einen Pool aktueller, realistischer Browser-User-Agents für jede Anfrage oder Session. So wirkt dein Scraping wie echter, vielfältiger Nutzer-Traffic.

4. Muss ich bei Thunderbit Header wie Accept-Language oder Referer manuell setzen?

Nein! Thunderbits KI sorgt dafür, dass alle Header konsistent sind und zum User Agent passen – deine Anfragen wirken wie die eines echten Browsers.

5. Was passiert, wenn eine Seite meine Anfragen trotzdem blockiert?

Thunderbit erkennt Blockierungen oder CAPTCHAs und passt sich in Echtzeit an – wechselt User Agents, passt Header an oder wiederholt Anfragen. Du bekommst zuverlässige Daten, ohne selbst eingreifen zu müssen.

Bereit für smarteres Scraping? und lass unsere KI das User-Agent-Katz-und-Maus-Spiel für dich übernehmen. Viel Erfolg beim Scrapen!

Mehr erfahren