Wer schon mal vor einem riesigen Haufen Webdaten saß und sich gefragt hat, wie man die bloß in eine Tabelle bekommt (ohne dabei den Kopf zu verlieren oder das Wochenende zu opfern), ist definitiv nicht allein. Ich kenn das nur zu gut – Kaffee in der Hand, zig Tabs offen und irgendwann die Erkenntnis: Copy & Paste reicht einfach nicht. Im Jahr 2025 ist Web-Scraping längst kein „Nice-to-have“ mehr für Business Intelligence, Vertrieb oder Operations – es ist die Basis für datengetriebene Entscheidungen. Aber bei der Masse an Web-Scraping-Tools (von KI-Web-Scrapern bis zu klassischen Python-Bibliotheken) fühlt sich die Auswahl schnell an wie die Suche nach der perfekten Eissorte in einer Eisdiele mit 100 Sorten.

Also, lass uns mal ein bisschen Klarheit schaffen. Ich bin Shuai Guan, Mitgründer & CEO von , und hab jahrelange Erfahrung mit SaaS, Automatisierung und KI – ich hab Tools gebaut, getestet und das Internet (im positiven Sinne) schon oft an seine Grenzen gebracht. Dieser Guide ist mein ehrlicher, praxisnaher Überblick über die 20 besten Web-Scraping-Tools für 2025. Egal, ob du als Business-Anwender Daten mit zwei Klicks willst, als Entwickler gerne tüftelst oder irgendwo dazwischen stehst – hier findest du das passende Tool. Dazu gibt’s Praxistipps, eine Prise Humor und eine Vergleichstabelle, die wirklich verständlich bleibt.

Schnellvergleich: Die besten Web-Scraping-Tools 2025

Bevor wir ins Detail gehen, hier ein Überblick über die 20 Top-Tools, sortiert nach Kategorie. Die Tabelle hilft dir, Funktionen, Preise, Einsatzbereiche und Nutzerbewertungen schnell zu vergleichen. (Kleiner Spoiler: Wer den einfachsten KI-Web-Scraper sucht, findet Thunderbit ganz oben.)

So nutzt du die Tabelle:

- KI-Web-Scraper sind perfekt für alle, die keine Technikfreaks sind und Wert auf Automatisierung und Flexibilität legen.

- No-/Low-Code-Tools bieten visuelle Oberflächen für Business-Anwender, die mehr Kontrolle wollen, aber nicht programmieren möchten.

- API-Tools sind für technisch versierte Teams, die Scraping in Workflows einbauen wollen.

- Python-Bibliotheken sind für Entwickler, die maximale Flexibilität und Kontrolle suchen.

| Tool Name | Kategorie | Hauptfunktionen | Preise (2025) | Ideal für | Vorteile | Nachteile | Nutzerbewertungen (G2, Capterra, Trustpilot, Chrome Store) | | ... | ... | ... | ... | ... | ... | ... | ... |

Hinweis: Nutzerbewertungen sind Richtwerte und können sich ändern. Für aktuelle Werte schau am besten direkt bei G2, Capterra, Trustpilot oder im Chrome Web Store vorbei.

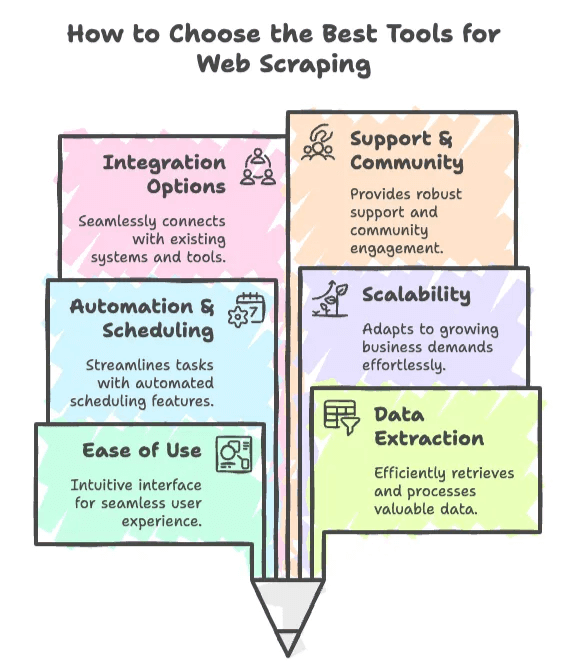

Wie findest du das beste Web-Scraping-Tool?

Mal ehrlich: Die Wahl eines Web-Scraping-Tools ist ein bisschen wie Online-Dating. Man sucht was Zuverlässiges, das einfach zu bedienen ist – und einen nicht im Stich lässt, wenn’s drauf ankommt. Hier die wichtigsten Kriterien, die ich (und die ich dir empfehle) bei der Auswahl für den Business-Einsatz nutze:

1. Benutzerfreundlichkeit

- KI-Web-Scraper (wie Thunderbit oder Browse AI) sind für alle gemacht, die keine Programmierer sind. Wer in weniger als fünf Minuten von „Ich brauch diese Daten“ zu „Hier ist meine Tabelle“ kommen will, startet hier.

- No-/Low-Code-Tools bieten mehr Kontrolle, brauchen aber ein bisschen Einarbeitung. Perfekt für Business-Anwender, die basteln wollen, aber nicht coden möchten.

2. Datenextraktions-Fähigkeiten

- Müssen dynamische, JavaScript-lastige Seiten extrahiert werden? Dann sind Tools mit Browser-Automatisierung (Selenium, Playwright, ScrapingBee) gefragt.

- Sollen Listen, Tabellen oder Unterseiten extrahiert werden? KI-Tools und visuelle Scraper sind hier oft stark.

3. Automatisierung & Zeitplanung

- Wer Daten regelmäßig aktualisieren will, braucht ein Tool mit Zeitplanungsfunktion (Thunderbit, Octoparse, Apify).

- Für einmalige Aufgaben reicht oft eine Browser-Erweiterung oder ein Skript.

4. Skalierbarkeit

- Hunderte Seiten scrapen? Das schaffen die meisten Tools.

- Millionen Seiten? Dann sind API-basierte Tools oder Python-Frameworks wie ScraperAPI, Bright Data oder Scrapy gefragt.

5. Integrationsmöglichkeiten

- Sollen Daten direkt nach Google Sheets, Airtable oder in eine Datenbank? Achte auf eingebaute Integrationen (Thunderbit, Simplescraper, Apify).

- Entwickler bevorzugen oft APIs oder Bibliotheken für individuelle Workflows.

6. Support & Community

- Neu beim Scraping? Tools mit starkem Support und aktiver Community (Octoparse, Apify, Thunderbit) sind Gold wert.

- Für fortgeschrittene Fehlerbehebung bieten Open-Source-Bibliotheken wie Scrapy und Selenium riesige Entwickler-Communities.

Tipp:

Wenn du als Business-Anwender auf Lead-Generierung, Preisüberwachung oder Wettbewerbsanalyse setzt, fang am besten mit einem KI- oder No-Code-Tool an. Entwickler oder technische Teams greifen zu API-Tools und Python-Bibliotheken für mehr Power und Flexibilität.

KI-Web-Scraper: Die Zukunft der Datenerfassung

Jetzt zu den neuen Stars: KI-Web-Scraper. Diese Tools machen Scraping für Business-Anwender super einfach – kein Stress mehr mit CSS-Selektoren oder der Angst, dass der Scraper bei Layout-Änderungen aussteigt. KI-Web-Scraper nutzen maschinelles Lernen und Computer Vision, um Webseiten wie ein Mensch zu „sehen“ und strukturierte Daten fast ohne Einrichtung zu extrahieren.

Warum ist das wichtig? Weil 2025 über 65 % der Unternehmen Web Scraping für KI/ML-Modelle und Business Intelligence nutzen (). KI-Scraper sind besonders für nicht-technische Teams wertvoll – sie sind schnell, flexibel und wartungsarm.

1. Thunderbit: Der einfachste KI-Web-Scraper für Unternehmen

Fangen wir mit meinem Favoriten an (ja, ich bin voreingenommen – aber aus gutem Grund): .

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Mit einem Klick liest Thunderbit die Website aus und schlägt passende Spalten und Datentypen vor.

- Subseiten-Scraping: Du brauchst mehr als die Listenansicht? Thunderbit besucht automatisch Unterseiten (z. B. Produktdetails) und ergänzt deine Tabelle.

- Sofort-Vorlagen: Für bekannte Seiten (Amazon, Zillow, Instagram, Shopify etc.) gibt’s fertige Vorlagen – kein manuelles Einrichten nötig.

- Kostenloser Datenexport: Exportiere nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON – ohne Bezahlschranke.

- Geplantes Scraping: Beschreib deinen Zeitplan in Alltagssprache, Thunderbits KI übernimmt den Rest. Ideal für Preisüberwachung oder Lagerbestände.

- Browser-/Cloud-Optionen: Scrape mit dem Browser (z. B. für eingeloggte Seiten) oder nutze Cloud-Scraping für Geschwindigkeit (bis zu 50 Seiten gleichzeitig).

- KI-Autofill: Formulare automatisch ausfüllen und Workflows automatisieren – komplett kostenlos.

- E-Mail-, Telefon- und Bild-Extraktoren: Kontaktinfos oder Bilder mit einem Klick extrahieren.

Für wen ist Thunderbit geeignet?

- Vertriebsteams für Lead-Listen (E-Mails, Telefonnummern, Namen)

- E-Commerce für Wettbewerber-Preise und SKUs

- Immobilienmakler für Angebots- und Preisüberwachung

- Alle, die Webdaten mit 2 Klicks statt 200 wollen

Preise

- Gratis: 6 Seiten scrapen (unbegrenzte Zeilen pro Seite)

- Starter: $15/Monat (500 Credits)

- Pro: $38–$249/Monat (3.000–20.000 Credits)

Nutzerfeedback

- Chrome Store: ★4.9 (steigend)

- Nutzer feiern das „2-Klick-Setup“ und „keine Programmierung nötig“.

- Im gibt’s Praxisbeispiele.

Warum ich es liebe

Ich hab Thunderbit für Leute wie mich gebaut – die mehr Zeit mit Datenanalyse als mit Tool-Bastelei verbringen wollen. Die KI passt sich Webseitenänderungen an, du musst deine Scraper nicht ständig babysitten. Und das Subseiten-Scraping? Mein Geheimtipp für strukturierte, reichhaltige Daten ohne Kopfschmerzen.

2. Browse AI

Browse AI ist ein weiterer KI-basierter, No-Code-Web-Scraper, der bei Business-Anwendern sehr beliebt ist. Mit dem visuellen „Roboter-Recorder“ trainierst du den Bot einfach per Klick auf die gewünschten Daten. Die KI erkennt ähnliche Elemente (z. B. alle Produktnamen oder Preise) und kann auch Paginierung sowie geplante Cloud-Läufe übernehmen.

Hauptfunktionen

- Visuelles Point-and-Click-Training

- Vorgefertigte Roboter für gängige Aufgaben

- KI-Mustererkennung für Listen und Tabellen

- Integrationen mit Google Sheets, Zapier, Slack u. v. m.

Preise

- Gratis-Tarif verfügbar

- Bezahlpläne ab $19/Monat

Ideal für

- Nicht-Techniker, die schnell Daten extrahieren wollen

- Marketing, Sales Ops, kleine Unternehmen

Vorteile

- Sehr benutzerfreundlich

- Keine Programmierung oder Einrichtung nötig

- Automatisierung und Integrationen inklusive

Nachteile

- Begrenzte Anpassung für komplexe Workflows

- Kann bei großen Jobs langsam sein

- Nicht ideal für Seiten mit starkem Bot-Schutz

Nutzerbewertungen

- G2: ★4.8

- Capterra: ★4.5

- Chrome Store: ★4.7

Browse AI ist ideal, wenn du in wenigen Minuten von „Ich brauch diese Daten“ zu „Hier ist meine Tabelle“ kommen willst.

3. Bardeen AI

Bardeen AI geht noch einen Schritt weiter und integriert Web Scraping in umfassende Workflow-Automatisierung. Die Browser-Erweiterung automatisiert wiederkehrende Webaufgaben, extrahiert Daten und schickt sie direkt in Business-Apps wie Google Sheets, Notion oder Airtable.

Hauptfunktionen

- Automatisierungs-Workflows für Scraping und mehr

- Integration mit zahlreichen Business-Apps

- Aktionen können durch extrahierte Daten ausgelöst werden

Preise

- Gratis-Tarif verfügbar

- Bezahlpläne ab $10/Monat

Ideal für

- Teams, die Webaufgaben und Datenerfassung automatisieren möchten

Vorteile

- Leistungsstark für mehrstufige Workflows

- Tiefe Integration mit Business-Tools

Nachteile

- Für sehr komplexes Scraping begrenzt

- Einarbeitung für Workflow-Setup nötig

Nutzerbewertungen

- G2: ★4.7

- Chrome Store: ★4.8

Wer Scraping als Teil einer größeren Automatisierung sieht, sollte Bardeen AI ausprobieren.

4. Diffbot

Diffbot ist der Enterprise-Profi unter den KI-Web-Scrapern. Mit Computer Vision und Machine Learning extrahiert es strukturierte Daten aus praktisch jeder Webseite und betreibt einen riesigen Knowledge Graph, der von Fortune-500-Unternehmen genutzt wird.

Hauptfunktionen

- Computer Vision (liest Seiten wie ein Mensch)

- APIs für Artikel, Produkte, Bilder u. v. m.

- Unterstützt dynamische und JS-lastige Seiten

- Knowledge Graph für Entity Linking

Preise

- Ab $299/Monat (250.000 Credits)

- Gratis-Test verfügbar

Ideal für

- Unternehmen, große Datenprojekte, ML-Teams

Vorteile

- No-Code, robust bei Layout-Änderungen

- Unterstützt dynamische Inhalte und JS

- Skalierbar und zuverlässig

Nachteile

- Hoher Preis (nicht für kleine Projekte)

- Black-Box-KI (wenig manuelle Anpassung)

Nutzerbewertungen

- G2: ★4.9

- Capterra: ★4.5

Für unternehmenskritische, großvolumige Datenpipelines ist Diffbot der Goldstandard.

5. Instant Data Scraper

Instant Data Scraper ist ein simples, browserbasiertes Tool von WebRobots.io, das speziell für Nicht-Programmierer entwickelt wurde. Perfekt für schnelle Aufgaben wie das Extrahieren von Tabellen, Listen oder Verzeichnissen.

Hauptfunktionen

- No-Code, erkennt Datentabellen automatisch

- Chrome-Erweiterung für Point-and-Click-Scraping

- Sofortiger Export als CSV/Excel

Preise

- Komplett kostenlos

Ideal für

- Nicht-Techniker, schnelle Listen, Tabellen

Vorteile

- Schneller Einstieg, sehr einfach

- Kein Login oder Registrierung nötig

- Ideal für strukturierte Seiten

Nachteile

- Keine Automatisierung, kein Cloud-Scraping

- Begrenzte Unterstützung für komplexe oder JS-lastige Seiten

Nutzerbewertungen

- Chrome Web Store: ★4.8 (10.000+ Bewertungen)

Ideal für schnelle, unkomplizierte Scraping-Aufgaben – besonders, wenn du einfach eine Tabelle kopieren willst.

No-/Low-Code-Web-Scraping-Tools: Datenextraktion ohne Programmierung

Nicht jeder will oder kann programmieren. No-/Low-Code-Tools sind ideal für Business-Anwender, die mehr Kontrolle als reine KI-Tools wollen, aber trotzdem auf Code verzichten möchten. Sie bieten visuelle Oberflächen, Zeitplanung und Cloud-Optionen.

6. Octoparse

Octoparse ist eines der bekanntesten visuellen Web-Scraping-Tools mit Point-and-Click-Oberfläche und der Fähigkeit, auch komplexe Seiten (Logins, Paginierung, Infinite Scroll) zu verarbeiten.

Hauptfunktionen

- Visueller Builder mit Assistent und Expertenmodus

- Cloud-Scraping und Zeitplanung

- Unterstützt Logins, Formulare, dynamische Inhalte

Preise

- Gratis-Tarif (10 Aufgaben)

- Bezahlpläne ab $119/Monat

Ideal für

- Nicht-Techniker, große Datenmengen, E-Commerce, Immobilien

Vorteile

- Sehr benutzerfreundlich

- Komplexe Szenarien möglich

- Gratis-Plan zum Einstieg

Nachteile

- Fortgeschrittene Funktionen erfordern Einarbeitung

- Trustpilot-Bewertung niedriger (Support-Probleme)

Nutzerbewertungen

- G2: ★4.8

- Capterra: ★4.7

- Trustpilot: ★2.7

Wer eine visuelle, geführte Erfahrung sucht, ist mit Octoparse gut beraten.

7. Parsehub

Parsehub ist ein flexibler Low-Code-Web-Scraper mit Desktop-App und Cloud-Ausführung. Besonders Analysten und Journalisten schätzen die Power und Flexibilität.

Hauptfunktionen

- Visueller Editor mit Skriptlogik

- Desktop- und Cloud-Optionen

- IP-Rotation, Paginierung, verschachtelte Navigation

Preise

- Gratis-Tarif (200 Seiten/Lauf)

- Bezahlpläne ab $189/Monat

Ideal für

- Analysten, Journalisten, technisch versierte Nutzer

Vorteile

- Leistungsstark und flexibel

- Plattformübergreifende Desktop-App

- Gratis-Tarif für kleine Projekte

Nachteile

- Desktop-Jobs laufen auf dem eigenen Rechner

- Support teils sehr vertriebsorientiert

Nutzerbewertungen

- G2: ★4.3

- Capterra: ★4.5

Ideal für alle, die mehr Kontrolle wollen, aber nicht komplett programmieren möchten.

8. Webscraper.io

Webscraper.io startete als kostenlose Chrome-Erweiterung und bietet inzwischen auch Cloud-Scraping. Besonders beliebt bei Einsteigern und Hobbyisten.

Hauptfunktionen

- Chrome-Erweiterung für lokales Scraping

- Cloud-Pläne für Zeitplanung und Skalierung

- Navigation per Sitemap

Preise

- Kostenlose Erweiterung

- Cloud ab $50/Monat

Ideal für

- Hobbyisten, Forscher, kleine Unternehmen

Vorteile

- Lokal kostenlos

- Günstige Cloud-Pläne

Nachteile

- Nur für Chrome

- Begrenzte Möglichkeiten für komplexe Aufgaben

Nutzerbewertungen

- G2: ★4.7

- Capterra: ★4.4

- Trustpilot: ★4.4

Perfekt für schnelle, einmalige Scrapes oder zum Lernen.

9. Data Miner

Data Miner ist eine Browser-Erweiterung mit Vorlagenansatz – ideal für kleine, schnelle Scraping-Jobs.

Hauptfunktionen

- Browser-Erweiterung (Chrome)

- Vorgefertigte Vorlagen für viele Seiten

- Einfacher Export nach CSV, Excel

Preise

- Gratis-Tarif

- Bezahlpläne ab $19/Monat

Ideal für

- Schnelle, kleine Scrapes, Nicht-Techniker

Vorteile

- Vorlagen ermöglichen schnellen Einstieg

- Einfache Exportoptionen

Nachteile

- Für komplexe oder große Aufgaben begrenzt

Nutzerbewertungen

- Chrome Store: ★4.4

Eine gute Wahl für kleine, vorlagenbasierte Scraping-Aufgaben.

API-basierte Web-Scraping-Tools: Für skalierbare, automatisierte Datenerfassung

API-Tools sind das Rückgrat für Teams mit technischen Ressourcen, die Datenerfassung automatisieren und skalieren wollen. Sie übernehmen Proxies, Browser-Rendering und Anti-Bot-Maßnahmen im Hintergrund.

10. Apify

Apify ist eine All-in-One-Automatisierungsplattform mit Marktplatz für fertige „Actors“ (Scraper) und APIs für eigene Skripte.

Hauptfunktionen

- Actor-Marktplatz (vorgefertigte Scraper)

- Eigene Skripte in Node.js/Python

- Zeitplanung, Speicherung, API-Zugriff

Preise

- Gratis-Tarif

- Bezahlpläne ab $49/Monat

Ideal für

- Entwickler und Nicht-Entwickler (über Actors), Automatisierungs-Workflows

Vorteile

- Sehr flexibel und skalierbar

- Community-Actors sparen Zeit

Nachteile

- Eigene Aufgaben erfordern Programmierung

- UI kann bei großen Projekten komplex sein

Nutzerbewertungen

- G2: ★4.5

- Capterra: ★4.7

Wer Flexibilität und Community-Lösungen sucht, ist mit Apify gut beraten.

11. ScrapingBee

ScrapingBee ist eine Entwickler-API, die sich auf das Scraping von JavaScript-lastigen Seiten mit Headless Chrome spezialisiert hat.

Hauptfunktionen

- Headless Browser API (Chromium)

- JS-Rendering, Proxy-Rotation

- Screenshot-API

Preise

- Gratis-Test

- Bezahlpläne ab $49/Monat

Ideal für

- Entwickler für dynamische, JS-lastige Seiten

Vorteile

- Einfache API, zuverlässiges Rendering

- Gute Dokumentation und Support

Nachteile

- Entwicklerfokus, nicht für Nicht-Techniker

- Teuer bei großem Volumen

Nutzerbewertungen

- G2: ★4.6

Ideal für Entwicklerteams, die moderne Web-Apps scrapen wollen.

12. ScraperAPI

ScraperAPI ist eine Komplettlösung, die Proxies, Browser-Rendering und Anti-Bot-Maßnahmen übernimmt.

Hauptfunktionen

- Proxy-Management, CAPTCHA-Lösung

- Async API für Massenjobs

- Strukturierte Datenendpunkte für gängige Seiten

Preise

- Kostenlos (5.000 Anfragen)

- Bezahlpläne ab $49/Monat

Ideal für

- Entwickler, große Scrapes, Anti-Block

Vorteile

- Hohe Erfolgsquote, günstig bei Skalierung

- Komplettlösung

Nachteile

- Entwicklerkenntnisse nötig

- Eigene Parser für individuelle Seiten nötig

Nutzerbewertungen

- G2: ★4.3

- Capterra: ★4.6

- Trustpilot: ★4.7

Die erste Wahl für Entwickler, die sich auf Daten statt Infrastruktur konzentrieren wollen.

13. Bright Data Web Scraper API

Bright Data ist Marktführer bei Proxies und bietet nun eine komplette Web-Scraping-Plattform mit IDE und fertigen APIs.

Hauptfunktionen

- Web-Scraper-IDE (visuell/Code)

- Größtes Proxy-Netzwerk (72M+ IPs)

- Vorgefertigte Data-Collector-APIs

Preise

- Gratis-Test

- Bezahlpläne ab ca. $500/Monat

Ideal für

- Unternehmen, hohes Volumen, Compliance-Projekte

Vorteile

- Leistungsstark, skalierbar, Compliance-Features

- Dedizierter Support

Nachteile

- Teuer, Einarbeitung in IDE nötig

Nutzerbewertungen

- G2: ★4.5

- Trustpilot: ★4.3

Für Fortune-500-Datenpipelines kaum zu schlagen.

14. Oxylabs

Oxylabs bietet Enterprise-Proxies und Scraping-APIs mit Fokus auf Zuverlässigkeit und Compliance.

Hauptfunktionen

- Proxy-Netzwerk, Datenlieferungs-APIs

- Geotargeting, Compliance-Support

Preise

- Ab $99/Monat

Ideal für

- Unternehmen, Compliance, Geo-Targeting

Vorteile

- Hohe Erfolgsquote, Support, Geo-Optionen

Nachteile

- Teuer, Entwickler-Setup nötig

Nutzerbewertungen

- G2: ★4.6

Top für große, compliance-getriebene Projekte.

15. Zyte (API Features)

Zyte bietet Scrapy Cloud, Smart Proxy Management und automatische Extraktion für gängige Inhalte.

Hauptfunktionen

- Scrapy Cloud für Spider-Ausführung

- Smart Proxy (Crawlera)

- Auto-Extract-APIs

Preise

- Gratis-Tarif

- Bezahlpläne ab $29/Monat

Ideal für

- Entwickler, individuelle Scraping-Projekte

Vorteile

- Bewährte Zuverlässigkeit, Scrapy-Integration

Nachteile

- Programmierung nötig, teuer bei Skalierung

Nutzerbewertungen

- G2: ★4.3

Ideal für Entwicklerteams, die eigene Crawler im großen Stil bauen ().

Python-Bibliotheken: Die besten Tools für Entwickler

Wer gerne selbst Hand anlegt, findet mit Python-Bibliotheken maximale Flexibilität und Kontrolle. Sie sind kostenlos, Open Source und haben große Communities.

16. Selenium

Selenium ist der Klassiker für Browser-Automatisierung. Damit lassen sich Chrome, Firefox & Co. steuern, um dynamische, JS-lastige Seiten zu scrapen.

Hauptfunktionen

- Komplette Browser-Automatisierung (Klicks, Scrollen, Formulare)

- Unterstützt JS, Logins, Infinite Scroll

- Screenshots, Multi-Browser-Support

Ideal für

- QA-Teams, dynamische Seiten, komplexe User-Flows

Vorteile

- Kann praktisch jede Seite verarbeiten

- Große Community, viele Tutorials

Nachteile

- Langsam, ressourcenintensiv

- Setup bei großen Jobs aufwendig

Nutzerbewertungen

- G2: ★4.5 (als Testing-Tool)

Wer echtes Nutzerverhalten nachbilden will, ist mit Selenium gut beraten.

17. BeautifulSoup4

BeautifulSoup4 ist die Standardbibliothek für das Parsen von HTML und XML in Python. Einfach, fehlertolerant und ideal für kleine bis mittlere Scraping-Aufgaben.

Hauptfunktionen

- Einfache API für HTML/XML-Parsing

- Verarbeitet auch fehlerhaften HTML-Code

- Kombinierbar mit requests, lxml

Ideal für

- Einsteiger, schnelle Auswertungen, Datenbereinigung

Vorteile

- Einfach, intuitiv, robust

- Flexibel mit anderen Bibliotheken

Nachteile

- Kein JS-Support, kein Crawler

Nutzerbewertungen

- G2: ★4.4

Ideal für schnelle Skripte und zum Lernen.

18. Scrapy

Scrapy ist ein leistungsstarkes Python-Framework für skalierbare Crawler und Scraper.

Hauptfunktionen

- Asynchrones Crawling (schnell und skalierbar)

- Erweiterbar mit Pipelines, Middlewares

- Große Community und viele Plugins

Ideal für

- Entwickler für eigene Crawler, große Projekte

Vorteile

- Hohe Performance, anpassbar

- Kostenlos und Open Source

Nachteile

- Hohe Lernkurve

- Kein nativer JS-Support (Selenium/Splash nötig)

Nutzerbewertungen

- GitHub: ★55k (meistgenutzter Scraper)

Wer robuste, skalierbare Scraping-Pipelines bauen will, ist mit Scrapy bestens beraten.

19. Puppeteer

Puppeteer ist eine Node.js-Bibliothek (mit Python-Wrappern) zur Steuerung von Headless Chrome. Ideal für dynamische Inhalte und Screenshots.

Hauptfunktionen

- Headless Chrome-Automatisierung

- Screenshots, PDF-Generierung

- Netzwerk-Interception

Ideal für

- Entwickler für dynamische, JS-lastige Seiten

Vorteile

- Modern, leistungsstark, flexibel

Nachteile

- Fokus auf Node.js, ressourcenintensiv

Nutzerbewertungen

- GitHub: ★85k

Perfekt für fortgeschrittenes Scraping und Browser-Automatisierung.

20. Playwright

Playwright ist eine moderne Browser-Automatisierungsbibliothek von Microsoft mit Multi-Browser- und Mehrsprachen-Support (inkl. Python).

Hauptfunktionen

- Multi-Browser-Support (Chromium, Firefox, WebKit)

- Auto-Wait, Async-API

- Screenshots, Netzwerk-Interception

Ideal für

- Entwickler für komplexe, JS-lastige Seiten

Vorteile

- Schnell, zuverlässig, cross-browser

- Moderne API, ideal für Parallelisierung

Nachteile

- Programmierung nötig, ressourcenintensiv

Nutzerbewertungen

- Dev Community: ★4.8

Wer das Neueste in Sachen Browser-Automatisierung sucht, ist mit Playwright bestens bedient.

Welches Web-Scraping-Tool passt zu deinem Unternehmen?

Hier mein Spickzettel für die Tool-Auswahl:

- Lead-Generierung, Kontaktdaten: Thunderbit, Browse AI, Bardeen AI, Data Miner

- Preisüberwachung, E-Commerce: Thunderbit, Octoparse, Parsehub, ScraperAPI, Bright Data

- Wettbewerbsbeobachtung, Marktforschung: Thunderbit, Diffbot, Apify, Scrapy

- Immobilienangebote: Thunderbit, Octoparse, Webscraper.io

- Workflow-Automatisierung: Bardeen AI, Apify, Thunderbit (KI-Autofill)

- Großprojekte, individuelle Lösungen: Scrapy, Selenium, Playwright, API-Tools (ScraperAPI, Zyte, Bright Data)

Tipp:

Teste die Gratis-Tarife oder Demos, bevor du dich festlegst. Die meisten Tools bieten genug, um den Workflow kennenzulernen und zu prüfen, ob sie zu deinen Anforderungen passen.

Fazit: Web-Scraping-Tools 2025

Web Scraping ist vom Nischenthema für Entwickler zum Must-have für Unternehmen geworden. 2025 sagen 96 % der Firmen, dass Daten zentral für Entscheidungen sind (), und Webdaten spielen dabei eine große Rolle. Der Markt für Web-Scraping-Tools wächst rasant – getrieben vom KI-Boom und dem Hunger nach Echtzeit-Insights ().

KI-Web-Scraper wie Thunderbit machen es auch Nicht-Technikern leicht, Daten mit wenigen Klicks zu extrahieren. Doch für jeden Bedarf gibt’s das passende Tool – von No-Code über API bis zu Python-Frameworks.

Die Landschaft entwickelt sich rasant. Mein Rat: Bleib neugierig auf neue Features, probier verschiedene Tools aus und hab keine Scheu, zu kombinieren. Das richtige Web-Scraping-Tool liefert nicht nur Daten – es macht dein Team schneller, smarter und entscheidungsstärker.

Mehr Deep Dives, Tutorials und ehrliche Reviews findest du im . Und wenn du bereit bist, intelligenter statt härter zu scrapen, probier aus. Dein zukünftiges Ich (und dein Kaffeebudget) werden es dir danken.

FAQs

1. Welche Web-Scraping-Tools sind 2025 am besten für Nicht-Techniker geeignet?

Für Nicht-Techniker sind KI-Web-Scraper wie Thunderbit, Browse AI und Bardeen AI die beste Wahl. Du brauchst keine Programmierkenntnisse, bekommst visuelle Oberflächen und kannst komplexe Aufgaben wie Paginierung, Subseiten-Navigation und Datenexport in Tabellen automatisieren.

2. Welche Tools eignen sich am besten für großvolumiges oder Enterprise-Scraping?

Für große Projekte sind Diffbot, Bright Data, Oxylabs und Scrapy führend. Sie stemmen riesige Datenmengen, bieten fortschrittliche Automatisierung und kommen auch mit JS-lastigen Seiten samt Anti-Bot-Schutz klar.

3. Wie unterscheiden sich No-Code- und Low-Code-Tools von KI-Scrapern?

No-/Low-Code-Tools wie Octoparse, Parsehub und Webscraper.io bieten mehr Anpassung als KI-Scraper, brauchen aber etwas Einarbeitung. KI-Scraper wie Thunderbit setzen auf Geschwindigkeit und Einfachheit und nutzen Machine Learning für Feldwahl und Subseiten-Scraping.

4. Was sind die besten Python-Bibliotheken für Entwickler, die volle Kontrolle wollen?

Entwickler, die gerne selbst programmieren, sollten Scrapy, Selenium, BeautifulSoup4, Puppeteer und Playwright in Betracht ziehen. Diese Tools bieten Flexibilität, Performance und Community-Support für individuelle Scraping-Lösungen.

5. Wie wählt man das richtige Web-Scraping-Tool für das eigene Unternehmen?

Die Wahl hängt von technischer Erfahrung, Datenvolumen und Projektkomplexität ab. Für Geschwindigkeit und Einfachheit eignen sich KI-Tools, für mittlere Komplexität No-Code-Plattformen und für Skalierbarkeit und Anpassung API- oder Python-Lösungen. Gratis-Tarife oder Demos sind sehr zu empfehlen.

Mehr erfahren: