Das Internet ist ein echter Schatz an Daten – und wer im Vertrieb, Marketing oder in der Unternehmensführung unterwegs ist, weiß: Die richtigen Infos zur richtigen Zeit zu haben, kann alles entscheiden. Aber mal ehrlich: Niemand hat Lust, stundenlang Daten per Hand von Webseiten in Excel-Tabellen zu kopieren. Ich habe schon Teams gesehen, die jeden Monat zig Stunden mit „Datenziehen“ verbringen – und am Ende trotzdem fehlerhafte oder veraltete Listen haben. Die gute Nachricht? Moderne Screen-Scraping-Tools haben das komplett verändert. Heute kann wirklich jeder – nicht nur Entwickler – Webdaten in wenigen Minuten sammeln, strukturieren und weiterverwenden.

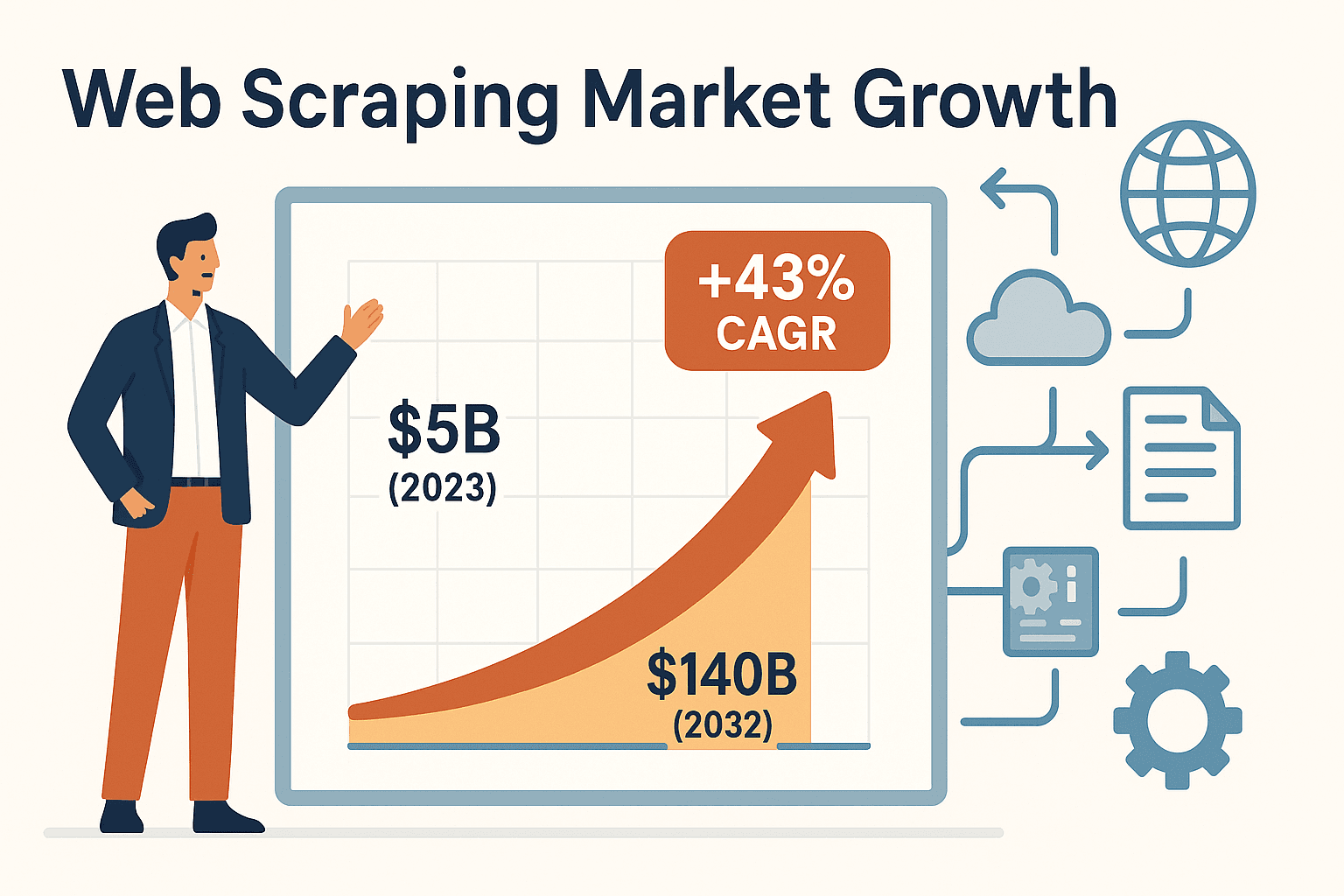

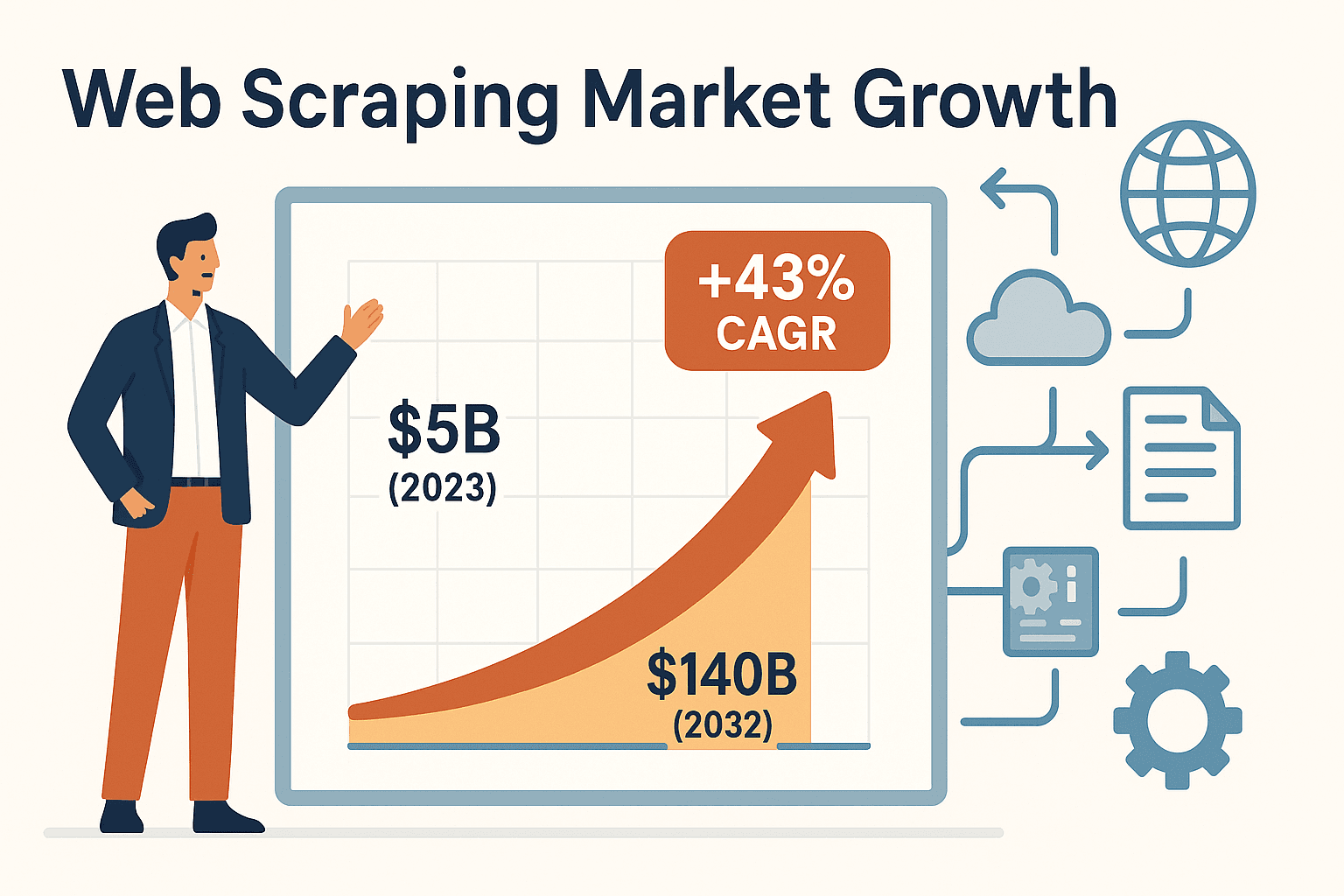

Die Nachfrage nach Screen-Scraping-Tools geht durch die Decke. Der globale Markt für Web-Scraper lag 2023 schon bei rund – mit einer jährlichen Wachstumsrate von satten 43 %. Warum? Weil Unternehmen gemerkt haben: Automatisierung ist kein Luxus mehr, sondern Pflicht, um vorne mitzumischen. Egal ob du Lead-Listen baust, die Konkurrenz im Blick behältst oder Immobilienangebote checkst: Mit dem richtigen Tool sparst du locker 30–40 % deiner Zeit bei Datentasks und senkst die Kosten für Datenerfassung um bis zu 40 % ().

Hier stelle ich dir die sechs besten Screen-Scraping-Tools für effiziente Datensammlung im Jahr 2025 vor. Du erfährst, was jedes Tool besonders macht, für wen es geeignet ist und wie du das passende für dein Team findest – egal ob du absoluter Anfänger oder erfahrener Entwickler bist.

Warum Screen-Scraping-Tools für Unternehmen unverzichtbar sind

Wer schon mal versucht hat, eine Lead-Liste aktuell zu halten oder Preise der Konkurrenz per Hand zu überwachen, kennt das Problem: Manuelle Datenerfassung ist langsam, nervig und fehleranfällig. Gerade für Nicht-Techniker – also Vertriebsleute, Marketer, Makler oder Analysten – sind Screen-Scraping-Tools echte Lebensretter. Sie automatisieren das monotone Copy-Paste und machen aus stundenlangem Aufwand einen einzigen Klick.

So verändern Screen-Scraping-Tools den Arbeitsalltag in Unternehmen:

- Lead-Generierung: In Sekunden Hunderte Kontakte aus Verzeichnissen oder Social Media ziehen – so bleibt dem Vertrieb mehr Zeit fürs Verkaufen statt fürs Kopieren.

- Wettbewerbsbeobachtung: Plane regelmäßige Scrapes von Wettbewerber-Websites, um aktuelle Preise oder neue Produkte automatisch zu erkennen. Einzelhändler wie John Lewis konnten allein durch Preisscraping einen erzielen.

- Immobiliendaten sammeln: Extrahiere Immobilienangebote von Seiten wie Zillow in Sekunden und halte dein Portfolio und deine Kundenlisten immer aktuell.

- Workflow-Automatisierung: Exportiere gesammelte Daten direkt nach Excel, Google Sheets, Airtable oder Notion – und automatisiere sogar Formularausfüllungen oder Software-Prozesse.

Das Fazit: Screen-Scraping-Tools geben Business-Anwendern die Möglichkeit, Webdaten eigenständig zu nutzen – ohne auf die IT zu warten. Das heißt: schnellere Entscheidungen, aktuellere Insights und ein echter Vorsprung gegenüber der Konkurrenz.

Wie wähle ich das richtige Screen-Scraping-Tool?

Die Auswahl ist riesig – das richtige Tool zu finden, fühlt sich manchmal an wie die Suche nach dem perfekten Auto: Soll es schnell und stylisch sein oder lieber zuverlässig und super easy? Mit dieser Checkliste findest du das passende Tool für deine Anforderungen:

- Benutzerfreundlichkeit: Suchst du ein No-Code-Tool mit Klick-Oberfläche oder willst du selbst programmieren?

- Anpassbarkeit: Musst du komplexe Seiten, Logins oder dynamische Inhalte (z. B. Endlos-Scrollen) abdecken?

- Unterstützte Datentypen: Willst du Text, Bilder, PDFs oder andere Formate extrahieren?

- Skalierbarkeit: Geht’s um ein paar Seiten oder musst du täglich Tausende abarbeiten?

- Exportmöglichkeiten: Kannst du die Daten easy nach Excel, Google Sheets oder ins CRM schieben?

- Preisgestaltung: Wie viel willst du ausgeben? Reicht ein kostenloses Tool oder brauchst du Profi-Automatisierung?

- Support & Wartung: Willst du einen Managed Service oder kümmerst du dich selbst um Wartung und Fehler?

Behalte diese Punkte im Hinterkopf, wenn wir gleich die sechs Top-Tools durchgehen. Und denk dran: Das beste Tool ist das, das dein Team wirklich nutzt.

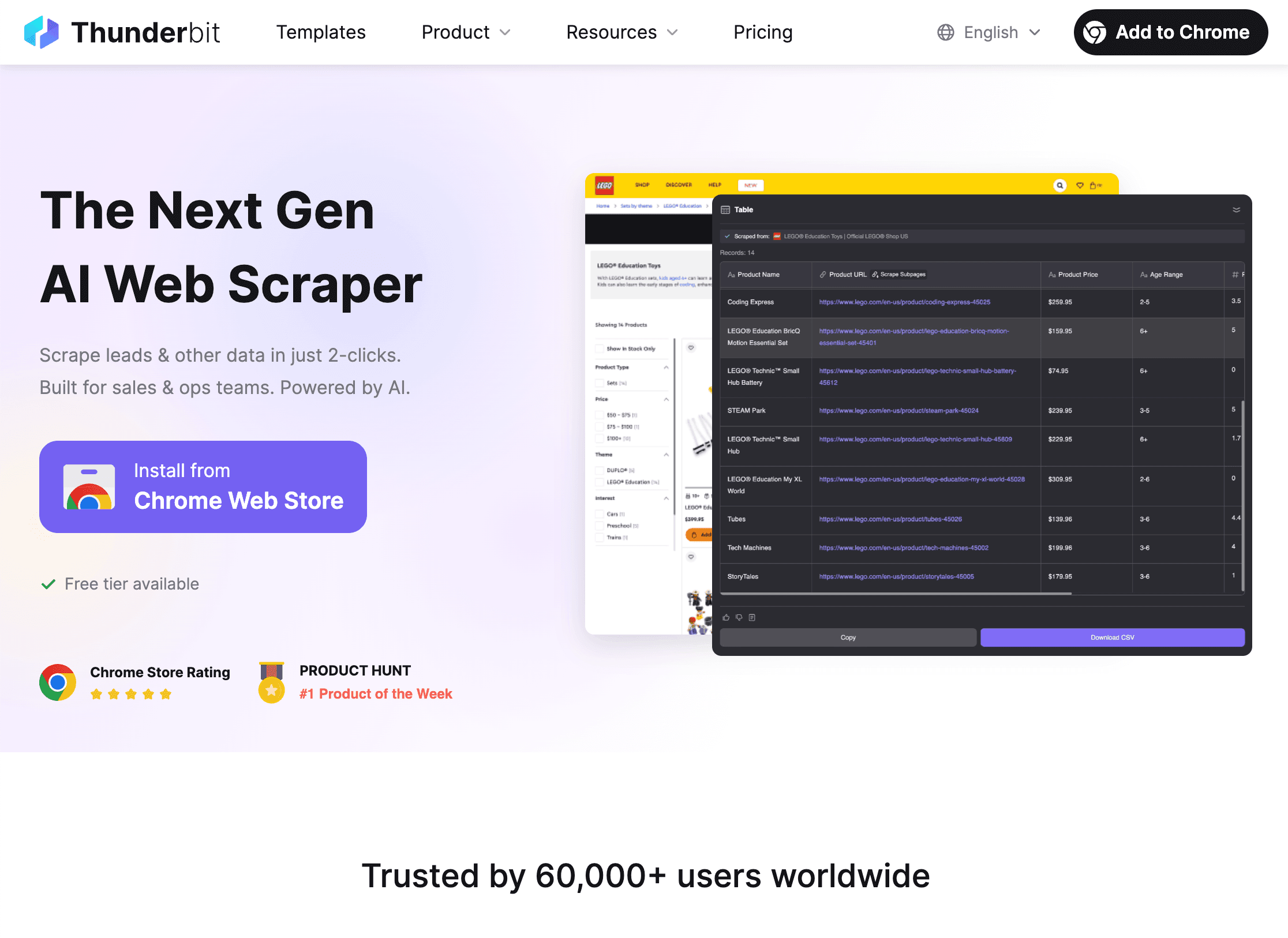

1. Thunderbit

ist meine absolute Empfehlung für Teams ohne Programmierkenntnisse, die Webdaten schnell und unkompliziert sammeln wollen – komplett ohne Code, Vorlagen oder komplizierte Einstellungen. Als Mitgründer und CEO bin ich vielleicht etwas voreingenommen, aber ich habe Thunderbit gebaut, weil ich gesehen habe, wie sehr sich Business-Anwender mit umständlichen Entwickler-Tools abmühen.

Was macht Thunderbit besonders? Hier stehen Einfachheit und Power im Fokus:

- KI-gestützte Feldvorschläge: Mit einem Klick auf „KI-Felder vorschlagen“ analysiert Thunderbits KI die Seite, schlägt passende Spalten (z. B. Namen, Preise, E-Mails) vor und legt sogar die Datentypen fest.

- Zwei-Klick-Scraping: Geh auf eine beliebige Website, klick auf „Scrapen“ – und Thunderbit macht den Rest. Kein Setup, keine Selektoren, null Aufwand.

- Subseiten- & Paginierungsscraping: Du willst Details von Unterseiten (z. B. Produktinfos oder LinkedIn-Profile) erfassen? Thunderbit besucht automatisch jede Unterseite und ergänzt deine Tabelle. Auch Paginierung und Endlos-Scrollen sind kein Problem.

- Sofort-Vorlagen: Für beliebte Seiten wie Amazon, Zillow oder Instagram gibt’s Ein-Klick-Vorlagen – einfach Suchbegriff eingeben und Daten exportieren.

- Kostenloser Datenexport: Exportiere deine Ergebnisse gratis nach Excel, Google Sheets, Airtable oder Notion.

- Erweiterte Funktionen: Extrahiere Daten aus PDFs, Bildern oder automatisiere Formulare mit KI-Autofill (auch kostenlos). Plane Scrapes mit natürlicher Sprache.

- Preise: Thunderbit läuft über ein Creditsystem – bis zu 6 Seiten kostenlos scrapen (oder 10 mit Test-Boost). Bezahlpläne starten ab nur 15 $/Monat (bzw. 9 $/Monat bei jährlicher Zahlung) für 500 Zeilen – perfekt für Teams jeder Größe.

Thunderbit wird von über genutzt – von Vertriebs- und Marketingteams bis zu Maklern und E-Commerce-Profis. Das häufigste Feedback? „Ich spare so viel Zeit – früher habe ich stundenlang Leads kopiert, jetzt dauert es nur Minuten.“ Probier’s einfach selbst: und teste Thunderbit.

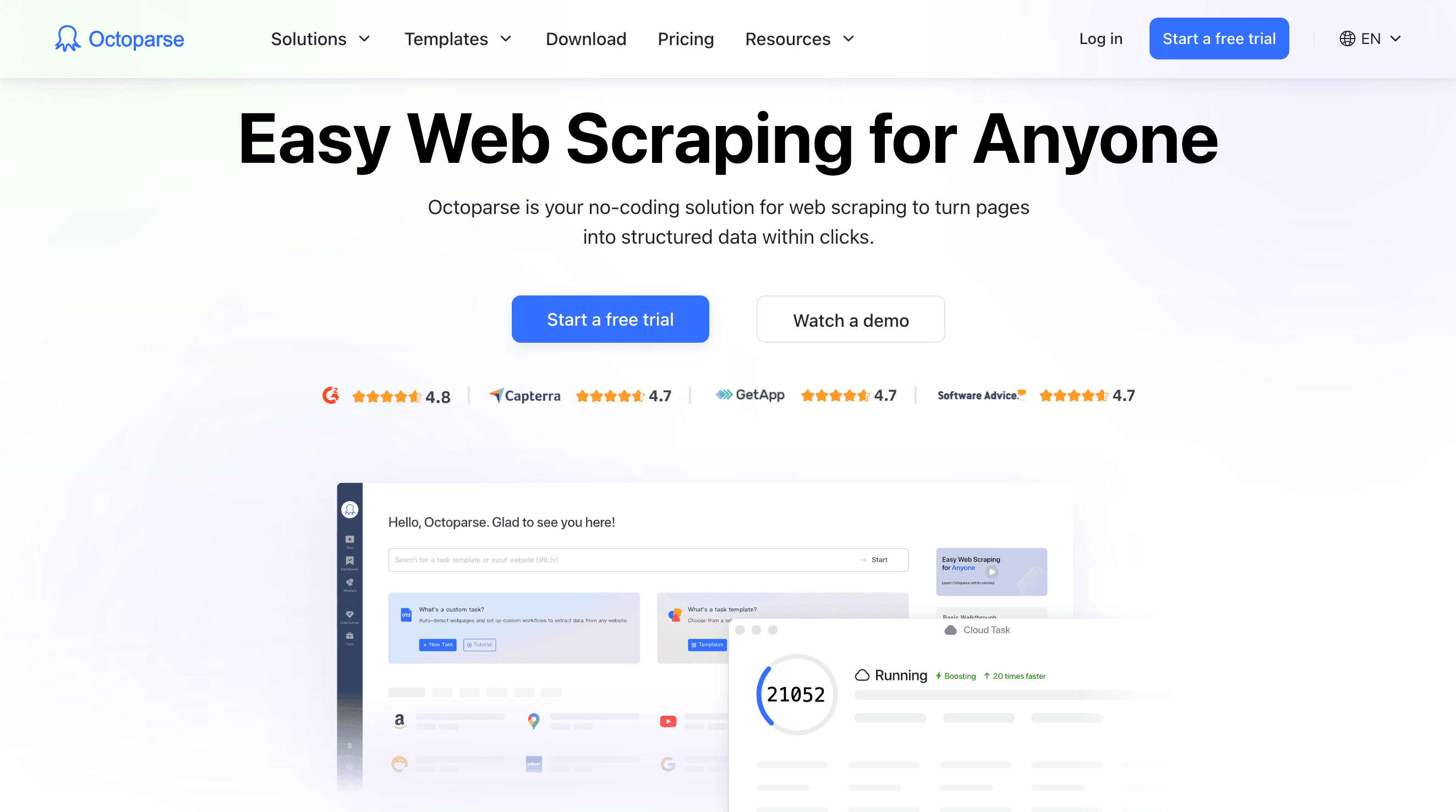

2. Octoparse

ist ein echtes Schwergewicht unter den No-Code-Scrapern und bietet eine visuelle Drag-and-Drop-Oberfläche für individuelle Workflows. Wer komplexe Seiten – etwa mit Logins, AJAX, Endlos-Scrollen oder mehrstufiger Navigation – ohne Programmierung scrapen will, ist hier richtig.

Wichtige Features:

- Visueller Workflow-Designer: Klick dich durch eine Beispielseite, Octoparse erkennt ähnliche Elemente und hilft beim Aufbau des Extraktions-Workflows.

- Dynamische Inhalte: Unterstützt JavaScript-lastige Seiten, Endlos-Scrollen und passwortgeschützte Bereiche.

- Cloud-Scraping: Jobs laufen in der Cloud (dein Rechner muss nicht an sein), Scrapes können geplant und große Datenmengen rund um die Uhr verarbeitet werden.

- Vorlagenbibliothek: Über 100 fertige Vorlagen für beliebte Seiten wie Amazon, LinkedIn oder Twitter.

- Exportoptionen: Ergebnisse als CSV, Excel oder JSON herunterladen oder direkt in die Datenbank übertragen.

- Preise: Kostenloser Einstieg mit eingeschränkten Funktionen; Bezahlpläne ab ca. 75 $/Monat für den Standard-Tarif, höhere Stufen für mehr Power und Features.

Octoparse ist besonders für Analysten, Forscher und kleine Unternehmen geeignet, die robuste, codefreie Scraping-Lösungen im mittleren Umfang suchen. Für komplexe Workflows gibt’s eine gewisse Lernkurve, aber die visuelle Oberfläche und gute Dokus machen den Einstieg leicht.

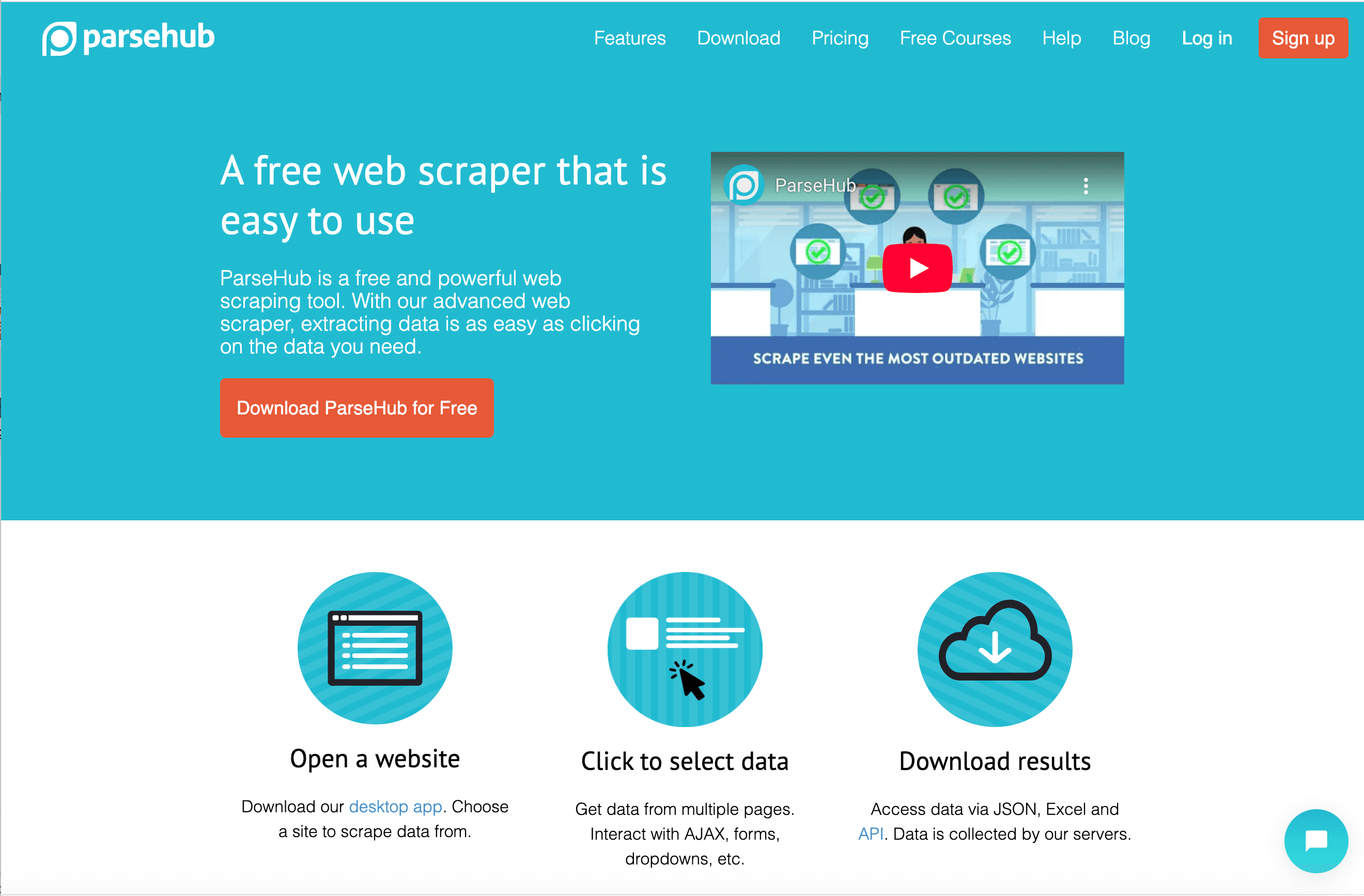

3. ParseHub

ist ein weiteres visuelles Scraping-Tool, das vor allem für seine Fähigkeit bekannt ist, komplexe, dynamische Seiten per Desktop-App zu verarbeiten. Wer Daten von Seiten mit viel JavaScript oder interaktiven Elementen extrahieren will, ist mit ParseHub gut beraten.

Das macht ParseHub aus:

- Desktop-Visual-Scraper: Projekte werden durch Klicken in der integrierten Browser-Ansicht erstellt. ParseHub erkennt Muster und lässt dich gezielt auswählen, was du brauchst.

- JavaScript & AJAX: Wartet auf das Laden von Inhalten, klickt Buttons, füllt Formulare aus und navigiert durch interaktive Seiten.

- API-Integration: Projekte können programmatisch gestartet und Ergebnisse abgerufen werden.

- Cloud-Planung: Jobs können in der Cloud geplant werden (bei höheren Tarifen).

- Exportoptionen: Daten als CSV, Excel oder JSON herunterladen.

- Preise: Kostenlos bis zu 200 Seiten pro Durchlauf; Bezahlpläne ab 189 $/Monat (Standard) bzw. 599 $/Monat (Professional).

ParseHub ist besonders beliebt bei Datenjournalisten, Forschern und kleinen Unternehmen, die dynamische Seiten scrapen und eine Desktop-Lösung bevorzugen. Die geführte Einführung hilft Einsteigern, aber für Vielnutzer ist das Tool recht teuer.

4. Scrapy

ist das Tool der Wahl für Entwickler und technische Teams, die maximale Kontrolle über ihre Scraping-Projekte wollen. Das Open-Source-Framework auf Python-Basis ermöglicht maßgeschneiderte Webcrawler – ideal für große, komplexe oder individuell angepasste Projekte.

Warum Entwickler Scrapy lieben:

- Maximale Flexibilität: Python-Code für Spider, Crawling-Regeln und Datenpipelines. Scrapy übernimmt Parallelisierung, Wiederholungen und Datenexport.

- Performance: Für Geschwindigkeit und Skalierbarkeit entwickelt – auch Tausende oder Millionen Seiten lassen sich effizient verarbeiten.

- Erweiterbarkeit: Integration von Proxys, Datenbanken, APIs und eigenen Middleware-Lösungen.

- Open Source: Kostenlos nutzbar; Kosten entstehen nur durch eigene Infrastruktur oder Cloud-Hosting (z. B. Scrapy Cloud von Zyte).

- Community: Große Nutzerbasis, ausgereifte Dokumentation und viele Tutorials.

Scrapy ist nichts für Einsteiger – die Lernkurve ist steil und du musst deinen Code selbst pflegen. Wer aber Entwickler im Team hat und eine skalierbare Datenpipeline braucht, findet hier ein mächtiges Werkzeug.

5. Diffbot

geht einen ganz anderen Weg: Mit KI und Machine Learning werden Webseiten automatisch analysiert und strukturierte Daten extrahiert. Statt eigene Scraper zu bauen, schickst du Diffbot eine URL (per API) und bekommst saubere, strukturierte JSON-Daten – ganz ohne Selektoren oder Setup.

Das macht Diffbot besonders:

- KI-basierte Extraktion: Vorgefertigte APIs für Artikel, Produkte, Diskussionen und mehr. Diffbot „liest“ die Seite wie ein Mensch und extrahiert die wichtigsten Felder.

- Crawlbot: Ganze Websites oder Sitemaps automatisch durchsuchen.

- Knowledge Graph: Zugriff auf Diffbots riesige Datenbank mit über 1,2 Milliarden Websites und 246 Millionen Organisationen.

- Skalierbarkeit: Für Datensammlungen im Unternehmensmaßstab entwickelt.

- Preise: Kostenloses Kontingent (10.000 Credits/Monat); Bezahlpläne ab 299 $/Monat für 250.000 Credits, höhere Stufen für mehr Volumen.

Diffbot ist vor allem für Unternehmen, Data Scientists und alle, die große Mengen strukturierter Webdaten ohne eigenen Scraper brauchen. Es ist weniger flexibel als Code-Lösungen, aber für KI-gestützte Extraktion im großen Stil unschlagbar.

6. DataMiner

ist eine Browser-Erweiterung (für Chrome und Edge), mit der du Daten schnell und unkompliziert extrahieren kannst. Wer als Growth Hacker, Journalist oder Business-Anwender einfach mal eine Tabelle oder Liste aus einer Webseite nach Excel holen will, wird DataMiner lieben.

Warum Nutzer DataMiner feiern:

- Einfache Bedienung: Klick Elemente auf der Seite an, um ein „Rezept“ zu erstellen, oder nutze eines der über 60.000 öffentlichen Rezepte für mehr als 15.000 Websites.

- Ein-Klick-Extraktion: Rezept anwenden und Daten sofort als CSV oder Excel exportieren.

- Paginierung & Massen-Scraping: Mehrseitige Listen und sogar Stapelverarbeitung mit eigenen URL-Listen möglich.

- Formularausfüllung: Automatisiere Formulare mit Daten aus einer CSV-Datei.

- Kostenloses Kontingent: Bis zu 500 Seiten pro Monat gratis; Bezahlpläne ab 19,99 $/Monat für 2.500 Seiten.

DataMiner ist ideal für spontane Aufgaben, schnelle Recherchen und alle, die direkt im Browser arbeiten wollen. Für große Projekte ist es nicht gedacht, aber für kleine bis mittlere Vorhaben super praktisch.

Schnellvergleich: Screen-Scraping-Tools im Überblick

| Tool | Benutzerfreundlichkeit | Hauptfunktionen | Ideal für | Preismodell | Besonderes Merkmal |

|---|---|---|---|---|---|

| Thunderbit | Sehr einfach (No-Code) | KI-Feldvorschläge, Subseiten/Paginierung, Vorlagen, kostenloser Export | Nicht-technische Anwender (Vertrieb, Ops, Immobilien) | Kostenlos/ab 9–15 $/Monat | Schnellste Einrichtung, KI-gestützt, ad-hoc Scraping |

| Octoparse | Mittel (No-Code) | Visueller Workflow, Cloud-Ausführung, dynamische Seiten, Vorlagen | Technikaffine Analysten, Forscher | Kostenlos/ab 75 $/Monat | Visueller Builder, Cloud-Planung, erweiterte Logik |

| ParseHub | Mittel (No-Code) | Desktop-App, JS/AJAX-Unterstützung, API, Cloud-Ausführung | Dynamische Seiten, technische Einsteiger | Kostenlos/ab 189 $/Monat | Für komplexe Seiten, Desktop-Steuerung |

| Scrapy | Anspruchsvoll (Python-Code) | Open Source, skalierbar, volle Kontrolle, Pipelines | Entwickler, Engineering-Teams | Kostenlos (Self-Hosting) | Maximale Flexibilität, große individuelle Projekte |

| Diffbot | Einfach (für Entwickler) | KI-Extraktion, APIs, Knowledge Graph, Crawlbot | Unternehmen, Data Scientists | Kostenlos/ab 299 $/Monat | Vollautomatisiert, Web-weite Daten, riesige Skalierung |

| DataMiner | Sehr einfach (Browser) | Browser-Erweiterung, 60k+ Rezepte, Ein-Klick, Formulare | Ad-hoc-Aufgaben, Journalisten, Growth Hacker | Kostenlos/ab 19,99 $/Monat | Schnellste Browser-Lösung, riesige Vorlagenbibliothek |

Welches Screen-Scraping-Tool passt zu dir?

- Du willst No-Code und sofortige Ergebnisse? Dann sind Thunderbit oder DataMiner top. Thunderbit ist besonders stark für strukturierte, mehrseitige oder Subseiten-Scrapes mit KI-Unterstützung; DataMiner ist perfekt für schnelle Aufgaben direkt im Browser.

- Du möchtest visuelle Workflows und Cloud-Power? Octoparse ist dein Tool, vor allem bei komplexen Seiten oder wiederkehrenden Scrapes.

- Du scrapest dynamische, JavaScript-lastige Seiten? ParseHub ist hier die beste Wahl, besonders für technische Einsteiger.

- Du hast Entwickler und brauchst volle Kontrolle? Scrapy ist der Goldstandard für individuelle, große Scraping-Projekte.

- Du brauchst KI-gestützte, unternehmensweite Daten? Diffbot liefert automatisierte, strukturierte Extraktion und einen riesigen Knowledge Graph.

Mein Tipp: Starte mit einer kostenlosen Testversion – die meisten Tools kannst du vorab ausprobieren. Überlege, wie fit du technisch bist, wie viel Daten du brauchst und wie deine Workflows aussehen – und probiere ruhig verschiedene Lösungen aus.

Fazit: Mit dem richtigen Screen-Scraping-Tool zur effizienten Datensammlung

Screen-Scraping-Tools sind längst keine Nischenlösungen für Entwickler mehr, sondern echte Produktivitäts-Booster für Unternehmen. Egal ob du Leads suchst, Preise checkst oder Immobilienangebote sammelst: Das richtige Tool macht das Web zu deiner persönlichen Datenbank. Wichtig ist, dass das Tool zu den Skills deines Teams und euren Zielen passt – denn das beste Screen-Scraping-Tool ist das, das ihr wirklich nutzt.

Bereit, Schluss mit Copy-Paste zu machen und Daten professionell zu sammeln? oder probiere eines der anderen Tools aus dieser Liste. Für mehr Tipps, Anleitungen und Insights schau auf dem vorbei.

Häufige Fragen (FAQ)

1. Was ist ein Screen-Scraping-Tool und wie funktioniert es?

Ein Screen-Scraping-Tool automatisiert das Extrahieren von Daten aus Webseiten. Statt Infos per Hand zu kopieren, wählst du einfach aus, was du brauchst, und exportierst es strukturiert – zum Beispiel nach Excel oder als CSV. Manche Tools nutzen KI oder visuelle Workflows, damit auch Nicht-Techniker sofort loslegen können.

2. Wer sollte Screen-Scraping-Tools nutzen?

Alle, die Webdaten effizient sammeln wollen – zum Beispiel Vertriebs- und Marketingteams, Makler, Forscher oder Analysten. Ob Lead-Listen, Wettbewerbsbeobachtung oder Angebotsübersichten: Diese Tools sparen Zeit und reduzieren Fehler.

3. Was ist der Unterschied zwischen No-Code- und Code-basierten Scraping-Tools?

No-Code-Tools (wie Thunderbit, Octoparse, ParseHub, DataMiner) bieten Klick-Oberflächen und sind für Nicht-Techniker gedacht. Code-basierte Tools (wie Scrapy) brauchen Programmierkenntnisse, bieten dafür aber mehr Flexibilität und Skalierbarkeit für komplexe Projekte.

4. Ist die Nutzung von Screen-Scraping-Tools legal?

Screen-Scraping ist für öffentlich zugängliche Daten legal, aber du solltest immer die Nutzungsbedingungen und Datenschutzgesetze der jeweiligen Website beachten. Vermeide das Scrapen persönlicher Daten ohne Einwilligung und überlaste keine Seiten mit zu vielen Anfragen.

5. Wie finde ich das beste Screen-Scraping-Tool für meine Anforderungen?

Überlege, wie fit du technisch bist, wie viel Daten du brauchst, wie komplex die Zielseiten sind, welche Exportmöglichkeiten du brauchst und wie viel Budget du hast. Teste verschiedene Tools mit einer kostenlosen Version und schau, welches am besten zu dir passt.

Bereit, das Potenzial von Webdaten zu nutzen? Probier eines dieser Tools aus und bring deine Produktivität aufs nächste Level.