Das Internet ist heutzutage wie ein riesiger Daten-Spielplatz – und mal ehrlich, jeder von uns will die coolste Sandburg bauen. Egal ob du im Vertrieb, E-Commerce, in der Forschung arbeitest oder einfach ein Datenfan bist: Web-Scraping ist das geheime Ass im Ärmel, wenn es um klügere Entscheidungen und effizientere Abläufe geht. Im Jahr 2025 sind es längst nicht mehr nur die großen Tech-Firmen, die Daten sammeln: , und sagen, dass datenbasierte Entscheidungen für sie unverzichtbar sind. Das Entscheidende dabei: Python ist der Motor hinter diesem Wandel – mit seinem riesigen Angebot an Web-Scraping-Bibliotheken und Tools.

Nach vielen Jahren in der SaaS- und Automatisierungswelt weiß ich: Mit dem richtigen Python Web-Scraper wird aus stundenlanger Fleißarbeit ein Zwei-Minuten-Job. Aber bei so vielen Möglichkeiten – von klassischen Bibliotheken über Browser-Automatisierung bis hin zu No-Code- und KI-Lösungen – wie findest du das passende Tool? In diesem Guide zeige ich dir die 12 besten Python Web-Scraping-Bibliotheken für Automatisierung – von bewährten Klassikern bis zu modernen KI-Tools wie . Egal ob du Entwickler, Operations-Manager oder Business-Anwender bist, der einfach nur Daten braucht (ohne Kopfschmerzen): Hier ist für jeden was dabei.

Warum das richtige Python Web-Scraping-Tool so wichtig ist

Eins steht fest: Kein Web-Scraping-Projekt gleicht dem anderen. Das richtige Tool entscheidet, ob du einen reibungslosen, automatisierten Prozess hast – oder tagelang an fehlerhaften Skripten verzweifelst. Ich habe erlebt, wie eine Recruiting-Agentur ihren Umsatz in drei Monaten verzehnfacht hat, weil sie die Lead-Generierung automatisiert hat – jede:r im Team sparte 8 Stunden pro Woche und es kamen tausende neue Leads rein (). Auf der anderen Seite habe ich Teams gesehen, die Tage verloren haben, weil ihre Bibliothek mit dynamischen Inhalten oder Anti-Bot-Schutz nicht klargekommen ist.

Deshalb ist die Wahl so entscheidend:

- Business-Mehrwert: Das richtige Tool automatisiert Lead-Generierung, Preisüberwachung, Wettbewerbsanalysen und Workflows – und verschafft dir so einen echten Vorsprung in Vertrieb, E-Commerce und Forschung ().

- Statische vs. dynamische Daten: Manche Seiten sind einfaches HTML, andere ein JavaScript-Dschungel. Kann dein Tool keine dynamischen Inhalte verarbeiten, verpasst du wichtige Daten.

- Skalierbarkeit & Zuverlässigkeit: Für ein paar Seiten reicht fast jedes Tool. Willst du aber tausende Seiten täglich crawlen, brauchst du ein Framework wie Scrapy oder eine Cloud-Lösung.

Tipp: – zum Beispiel Beautiful Soup für statische Seiten und Selenium für dynamische. Die richtige Kombi ist dein Geheimvorteil.

So haben wir die besten Python Web-Scraping-Bibliotheken bewertet

Bei der riesigen Auswahl an Bibliotheken und Plattformen habe ich mich auf die Kriterien konzentriert, die für Business- und Technik-User wirklich zählen:

- Benutzerfreundlichkeit: Kommen auch Nicht-Programmierer klar? Ist die API verständlich? Für visuelle/No-Code-Optionen gibt’s Extrapunkte.

- Automatisierung & Skalierbarkeit: Unterstützt das Tool Multi-Page-Crawling, Zeitplanung und große Datenmengen? Läuft es in der Cloud oder lokal?

- Dynamische Inhalte: Kommt das Tool mit JavaScript-Seiten, Infinite Scroll oder Login-Bereichen klar?

- Integration & Export: Wie einfach lassen sich Daten nach Excel, Google Sheets, Datenbanken oder in Workflows exportieren?

- Community & Wartung: Wird das Tool aktiv weiterentwickelt? Gibt es viele Tutorials und Support?

- Kosten: Ist es kostenlos, Open Source oder kostenpflichtig? Wie ist das Preis-Leistungs-Verhältnis für Teams?

Ich habe die Tools getestet, Nutzerbewertungen analysiert und echte Praxisbeispiele recherchiert. Hier sind die Top 12.

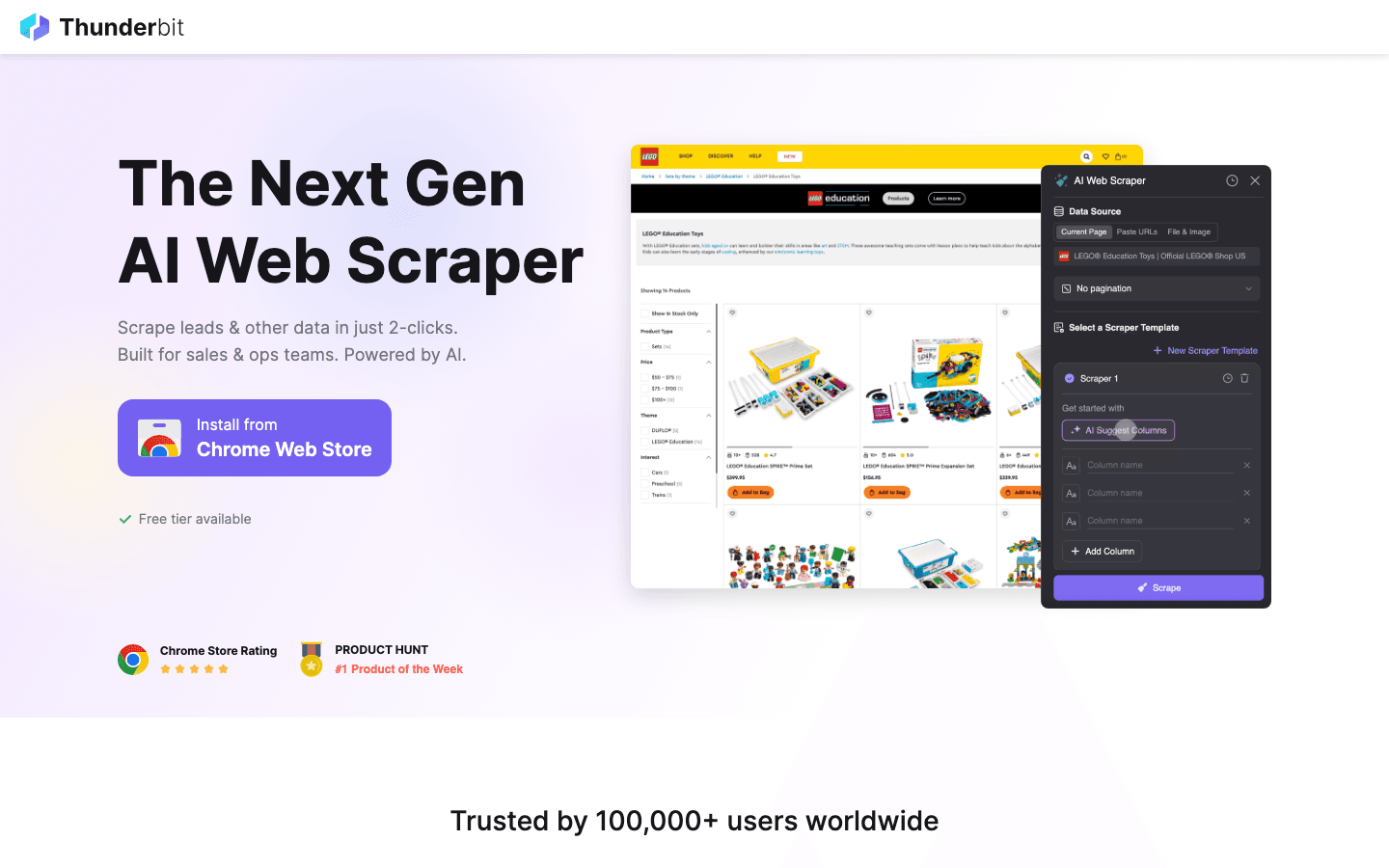

1. Thunderbit

ist meine Empfehlung für alle, die Web-Scraping ohne Stress wollen. Die macht es möglich, mit nur zwei Klicks Daten von jeder Website zu holen – ganz ohne Code, Vorlagen oder komplizierte Einstellungen.

ist meine Empfehlung für alle, die Web-Scraping ohne Stress wollen. Die macht es möglich, mit nur zwei Klicks Daten von jeder Website zu holen – ganz ohne Code, Vorlagen oder komplizierte Einstellungen.

Warum ich es feiere: Thunderbit ist für Business-Anwender:innen gemacht – Vertrieb, Operations, E-Commerce, Immobilien – die schnell an Daten kommen wollen, ohne sich mit Python-Skripten herumzuärgern. Einfach auf „KI-Felder vorschlagen“ klicken, die KI liest die Seite aus, dann auf „Scrapen“ klicken. Thunderbit übernimmt Unterseiten, Paginierung, dynamische Inhalte und füllt sogar Online-Formulare automatisch aus. Export nach Excel, Google Sheets, Airtable oder Notion ist kostenlos.

Besondere Features:

- KI-gestützte Feldvorschläge: Die KI erkennt automatisch relevante Daten wie Namen, Preise, E-Mails usw.

- Unterseiten-Scraping: Für mehr Details besucht Thunderbit automatisch Unterseiten (z. B. Produkt- oder Kontaktseiten) und ergänzt die Tabelle.

- Sofort-Vorlagen: Für Seiten wie Amazon, Zillow oder Instagram einfach eine Vorlage auswählen und loslegen.

- Cloud- oder Browser-Scraping: Bis zu 50 Seiten gleichzeitig in der Cloud scrapen oder den Browser für Login-Seiten nutzen.

- Kostenloser Datenexport: Exportieren ohne Bezahlschranke.

Ideal für: Nicht-technische Teams, Sales, E-Commerce und alle, die schnell Ergebnisse wollen – ohne Programmierung.

Einschränkungen: Kein klassisches Python-Modul. Wer direkt in Python integrieren will, muss die Daten exportieren und importieren. Für 99 % der Business-Anwendungen ist es aber ein echter Gamechanger.

Du willst Thunderbit in Aktion sehen? Schau auf dem oder unserem vorbei.

2. Beautiful Soup

ist der Klassiker unter den Python-Bibliotheken fürs Parsen von HTML und XML. Es war mein erstes Web-Scraping-Tool – und ist für Einsteiger:innen immer noch die beste Wahl.

ist der Klassiker unter den Python-Bibliotheken fürs Parsen von HTML und XML. Es war mein erstes Web-Scraping-Tool – und ist für Einsteiger:innen immer noch die beste Wahl.

Was es ausmacht: Einfach, fehlertolerant und ideal für schnelle Projekte. Seite mit Requests laden, HTML an Beautiful Soup übergeben und mit der intuitiven API gezielt Daten extrahieren. Auch bei „schmutzigem“ HTML sehr robust.

Ideal für: Kleine bis mittlere Projekte, Datenbereinigung und alle, die Web-Scraping lernen möchten.

Einschränkungen: Keine eingebaute Unterstützung für dynamische (JavaScript-)Inhalte. Dafür braucht man Selenium oder ein anderes Automatisierungstool.

3. Scrapy

ist das Schwergewicht unter den Python-Frameworks für groß angelegtes, automatisiertes Web-Crawling. Wer tausende oder Millionen Seiten scrapen, Datenpipelines bauen oder geplante Jobs ausführen will, ist hier richtig.

ist das Schwergewicht unter den Python-Frameworks für groß angelegtes, automatisiertes Web-Crawling. Wer tausende oder Millionen Seiten scrapen, Datenpipelines bauen oder geplante Jobs ausführen will, ist hier richtig.

Was es so stark macht: Scrapy ist asynchron, schnell und für Skalierung gebaut. Man definiert „Spiders“, die Seiten crawlen, Links folgen, Paginierung abbilden und Daten durch Pipelines verarbeiten. Viele Enterprise-Projekte setzen darauf.

Ideal für: Entwickler:innen, die robuste, skalierbare Crawler bauen; Multi-Page- oder Multi-Site-Scraping; produktive Datenpipelines.

Einschränkungen: Höhere Einstiegshürde als Beautiful Soup. Standardmäßig kein JavaScript-Support – aber mit Splash oder Selenium erweiterbar.

4. Selenium

ist das Tool für Browser-Automatisierung und steuert Chrome, Firefox & Co. direkt aus Python. Unverzichtbar für dynamische, JavaScript-lastige Seiten oder komplexe Web-Interaktionen.

ist das Tool für Browser-Automatisierung und steuert Chrome, Firefox & Co. direkt aus Python. Unverzichtbar für dynamische, JavaScript-lastige Seiten oder komplexe Web-Interaktionen.

Warum es wichtig ist: Selenium kann Nutzeraktionen simulieren – Klicks, Formulare, Scrollen – und alles scrapen, was im Browser angezeigt wird, wie ein Mensch.

Ideal für: Dynamische Seiten, Scraping nach Login, Infinite Scroll oder wenn Interaktion mit der Seite nötig ist.

Einschränkungen: Langsamer und ressourcenintensiver als reine HTTP-Bibliotheken. Für tausende Seiten nur mit starker Hardware geeignet.

5. Requests

ist die „HTTP for Humans“-Bibliothek. Sie bildet das Fundament der meisten Python-Scraping-Skripte – zum Laden von Webseiten, Absenden von Formularen und Verwalten von Cookies.

ist die „HTTP for Humans“-Bibliothek. Sie bildet das Fundament der meisten Python-Scraping-Skripte – zum Laden von Webseiten, Absenden von Formularen und Verwalten von Cookies.

Warum sie unverzichtbar ist: Einfache API, zuverlässig und perfekt kombinierbar mit Beautiful Soup oder lxml. Ideal für statische Seiten und APIs.

Ideal für: Statisches HTML, API-Aufrufe oder als Basis für eigene Web-Scraper.

Einschränkungen: Kann keine JavaScript-Inhalte verarbeiten. Für dynamische Seiten braucht man Selenium oder Ähnliches.

6. LXML

ist der Hochleistungs-Parser für HTML und XML in Python. Extrem schnell und unterstützt mächtige XPath- und CSS-Selektoren.

ist der Hochleistungs-Parser für HTML und XML in Python. Extrem schnell und unterstützt mächtige XPath- und CSS-Selektoren.

Warum es beliebt ist: Wer große Seiten scrapen oder komplexe Abfragen mit XPath machen will, ist hier richtig. Scrapy nutzt lxml übrigens intern.

Ideal für: Performance-kritische Projekte, große Datenmengen oder komplexe Extraktionen mit XPath.

Einschränkungen: Etwas höhere Einstiegshürde, Installation kann auf manchen Systemen knifflig sein.

7. PySpider

ist ein Python-Scraping-Framework mit Web-Oberfläche. Ähnlich wie Scrapy, aber mit Dashboard zur Verwaltung, Planung und Überwachung von Scraping-Jobs.

ist ein Python-Scraping-Framework mit Web-Oberfläche. Ähnlich wie Scrapy, aber mit Dashboard zur Verwaltung, Planung und Überwachung von Scraping-Jobs.

Was es besonders macht: Spiders in Python schreiben, planen und Ergebnisse direkt im Browser sehen. Ideal für Teams, die Überblick und Automatisierung wollen.

Ideal für: Teams mit mehreren Scraping-Projekten, geplante Crawls oder alle, die eine visuelle Oberfläche bevorzugen.

Einschränkungen: Wird nicht so aktiv gepflegt wie Scrapy, und moderner JavaScript-Support ist begrenzt.

8. MechanicalSoup

ist eine schlanke Python-Bibliothek für einfache Browser-Automatisierung – etwa zum Ausfüllen von Formularen und Folgen von Links, ohne den Overhead von Selenium.

ist eine schlanke Python-Bibliothek für einfache Browser-Automatisierung – etwa zum Ausfüllen von Formularen und Folgen von Links, ohne den Overhead von Selenium.

Warum es praktisch ist: Kombiniert Requests und Beautiful Soup, ideal für Logins, Formulare und das Scrapen der Folgeseiten.

Ideal für: Automatisierung von Logins, Formularübermittlungen oder einfache Web-Workflows ohne JavaScript.

Einschränkungen: Kommt mit JavaScript-lastigen Seiten oder komplexen Interaktionen nicht zurecht.

9. Octoparse

ist ein No-Code-Web-Scraping-Tool mit Drag-and-Drop-Oberfläche. Perfekt für Business-Anwender:innen, die ohne Programmierung Daten extrahieren möchten.

ist ein No-Code-Web-Scraping-Tool mit Drag-and-Drop-Oberfläche. Perfekt für Business-Anwender:innen, die ohne Programmierung Daten extrahieren möchten.

Warum es beliebt ist: Octoparse kann Paginierung, dynamische Inhalte und sogar Cloud-basierte Scrapes planen. Es gibt Vorlagen für viele bekannte Seiten und Export nach Excel, CSV oder Google Sheets.

Ideal für: Nicht-Programmierer:innen, Marktforschung, Lead-Generierung und Teams, die schnell Ergebnisse brauchen.

Einschränkungen: Die kostenlose Version ist eingeschränkt; erweiterte Funktionen gibt es ab ca. 75 $/Monat.

10. ParseHub

ist ein weiteres visuelles Scraping-Tool, mit dem sich komplexe Workflows per Klick zusammenstellen lassen. Ideal für dynamische Seiten, bedingte Logik und geplante Cloud-Jobs.

ist ein weiteres visuelles Scraping-Tool, mit dem sich komplexe Workflows per Klick zusammenstellen lassen. Ideal für dynamische Seiten, bedingte Logik und geplante Cloud-Jobs.

Was es auszeichnet: Mit bedingter Logik und mehrstufigen Workflows eignet sich ParseHub besonders für anspruchsvolle Seiten mit Pop-ups, Tabs oder versteckten Daten.

Ideal für: Nicht-Programmierer:innen, die komplexe, dynamische Websites scrapen; geplante Datenerfassung.

Einschränkungen: Die Gratis-Version ist limitiert; für große Datenmengen werden die kostenpflichtigen Pläne schnell teuer.

11. Colly

ist ein extrem schnelles Web-Scraping-Framework – geschrieben in Go, aber wegen seiner Performance auch für Python-Teams interessant. Manche nutzen Colly als Microservice für große Crawls und verarbeiten die Daten dann in Python weiter.

ist ein extrem schnelles Web-Scraping-Framework – geschrieben in Go, aber wegen seiner Performance auch für Python-Teams interessant. Manche nutzen Colly als Microservice für große Crawls und verarbeiten die Daten dann in Python weiter.

Warum es spannend ist: Colly kann tausende Seiten pro Sekunde mit minimalem Speicherbedarf abarbeiten. Wer im großen Stil scrapen will, findet hier eine starke Cross-Plattform-Lösung.

Ideal für: Entwicklerteams, die Geschwindigkeit und Parallelität brauchen; Integration von Go-basierten Crawlern in Python-Workflows.

Einschränkungen: Go-Kenntnisse erforderlich; kein direktes Python-Modul.

12. Portia

ist ein Open-Source-Visual-Scraper von Scrapinghub (heute Zyte). Damit lassen sich Scrapy-Spiders per Mausklick im Browser zusammenstellen – ganz ohne Code.

ist ein Open-Source-Visual-Scraper von Scrapinghub (heute Zyte). Damit lassen sich Scrapy-Spiders per Mausklick im Browser zusammenstellen – ganz ohne Code.

Was daran cool ist: Portia schlägt die Brücke zwischen No-Code und der Power von Scrapy. Extraktionsregeln werden visuell definiert, der Spider läuft dann in Scrapy oder in der Zyte-Cloud.

Ideal für: Nicht-Programmierer:innen in Datenteams oder alle, die Scrapy-Spiders visuell prototypen wollen.

Einschränkungen: Wird nicht mehr so aktiv gepflegt und kommt mit sehr dynamischen oder interaktiven Seiten an seine Grenzen.

Vergleichstabelle: Die besten Python Web-Scraping-Bibliotheken im Überblick

| Tool/Library | Benutzerfreundlichkeit | Dynamische Inhalte | Automatisierung & Skalierung | Ideal für | Preisgestaltung |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | ★★★★☆ | ★★★★☆ | No-Coder, Business-User, schnelle Ergebnisse | Kostenlos + Credits |

| Beautiful Soup | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | Einsteiger, statische Seiten, Datenbereinigung | Kostenlos |

| Scrapy | ★★★☆☆ | ★★★☆☆ | ★★★★★ | Entwickler, große Crawls | Kostenlos |

| Selenium | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | Dynamische Seiten, Browser-Automatisierung | Kostenlos |

| Requests | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | Statisches HTML, APIs, schnelle Skripte | Kostenlos |

| LXML | ★★★☆☆ | ★☆☆☆☆ | ★★★★☆ | Performance, große Datenmengen, XPath | Kostenlos |

| PySpider | ★★★★☆ | ★★★☆☆ | ★★★★★ | Teams, geplante Crawls, Web-Oberfläche | Kostenlos |

| MechanicalSoup | ★★★★☆ | ★☆☆☆☆ | ★★☆☆☆ | Formular-Automatisierung, Logins, einfache Workflows | Kostenlos |

| Octoparse | ★★★★★ | ★★★★☆ | ★★★★☆ | No-Code, Business-User, geplante Scrapes | Kostenlos + bezahlt |

| ParseHub | ★★★★★ | ★★★★☆ | ★★★★☆ | No-Code, komplexe/dynamische Seiten | Kostenlos + bezahlt |

| Colly | ★★☆☆☆ | ★☆☆☆☆ | ★★★★★ | High-Speed, Cross-Plattform, Go-Integration | Kostenlos |

| Portia | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | Visuelle Scrapy-Spiders, No-Coder | Kostenlos |

Das richtige Python Web-Scraping-Tool für dein Business auswählen

Welches Tool passt zu dir? Hier meine Schnellübersicht:

- No-Coder oder Business-User: Starte mit , oder . Schnell, visuell, keine Programmierung nötig.

- Entwickler, große Projekte: oder sind ideal für robuste, wiederholbare Crawler.

- Dynamische/JavaScript-Seiten: oder ein visuelles Tool mit Browser-Automatisierung nutzen.

- Schnelles Scraping statischer Seiten: + ist der einfachste Einstieg.

- Performance oder Cross-Plattform: als Go-Microservice oder in Kombination mit Python nutzen.

- Visuelles Prototyping für Scrapy: ist die Brücke zwischen No-Code und Devs.

Mein Tipp: Starte mit dem einfachsten Tool, das zu deinem Bedarf passt. Wer unsicher ist, probiert für einen schnellen Erfolg – oder setzt auf Scrapy für große Projekte.

Und denk dran: Das beste Tool ist das, das dir zuverlässig und effizient die Daten liefert – ohne dass du dabei verzweifelst.

Häufige Fragen (FAQ)

1. Warum ist Python so beliebt fürs Web-Scraping?

Python ist beim Web-Scraping so beliebt, weil die Sprache super einfach zu lernen ist, es eine riesige Auswahl an Bibliotheken gibt und die Community sehr aktiv ist. ), egal ob Anfänger oder Profi.

2. Welche Python-Bibliothek eignet sich am besten für dynamische (JavaScript-)Websites?

Für dynamische Seiten ist der Klassiker, weil es einen echten Browser steuert. No-Code-Lösungen wie , und kommen aber auch mit JavaScript-lastigen Seiten klar.

3. Wann sollte ich Scrapy und wann Beautiful Soup nutzen?

ist perfekt für schnelle, einfache Projekte oder zum Lernen. ist die richtige Wahl für große, automatisierte Crawls, Multi-Page-Projekte oder wenn du robuste Pipelines und Zeitplanung brauchst.

4. Kann ich Thunderbit in meinen Python-Workflow integrieren?

Klar! exportiert Daten als CSV, Excel oder Google Sheets – die kannst du dann easy in Python weiterverarbeiten oder analysieren.

5. Wie steige ich als Nicht-Entwickler:in am einfachsten ins Web-Scraping ein?

Probier , oder aus. Diese Tools ermöglichen visuelles Scraping – ganz ohne Code. Mehr Tipps und Anleitungen findest du im .

Viel Erfolg beim Scrapen – und möge deine Datenquelle immer sauber, strukturiert und nur einen Klick entfernt sein.

Mehr erfahren