Die Web-Scraping-Welt im Jahr 2026 fühlt sich an wie ein quirliger Markt in Seoul am frühen Morgen – alle sind auf der Jagd nach den frischesten Daten, und wer die besten Tools nutzt, ist der Konkurrenz immer einen Schritt voraus. Unternehmen setzen heute auf gescrapte Daten für alles Mögliche – von der Lead-Generierung bis zur Wettbewerbsanalyse. Die Wahl der richtigen Python-Bibliothek für Web-Scraping ist deshalb nicht nur eine technische, sondern eine strategische Entscheidung. Und mal ehrlich: Bei der riesigen Auswahl (und den unzähligen „ultimativen Guides“) kann man sich schnell so fühlen, als bräuchte man einen Doktortitel, um das passende Tool zu finden.

Nach Jahren in der SaaS- und Automatisierungsbranche weiß ich: Mit den richtigen Python-Web-Scraping-Tools wird aus einer wochenlangen Fleißarbeit ein Projekt, das du locker an einem Vormittag erledigst. Egal, ob du als Entwickler stabile Datenpipelines aufbaust oder als Business-Anwender einfach saubere Daten in deiner Tabelle brauchst – hier findest du die 12 besten Python-Bibliotheken für Web-Scraping im Jahr 2026. Und dazu: eine KI-basierte Lösung, die das Spiel für Einsteiger und Profis gleichermaßen verändert.

Warum die Wahl der richtigen Python-Web-Scraping-Bibliothek so wichtig ist

Web-Scraping bedeutet nicht einfach nur, Daten zu sammeln – es geht darum, die richtigen Daten schnell und effizient zu bekommen, ohne dabei den Überblick zu verlieren. 2026 nutzen über in den USA automatisiertes Web-Scraping für Vertrieb, Marktforschung und operative Aufgaben. Täglich werden gecrawlt. Die Anforderungen sind hoch: Das falsche Tool kann zu verpassten Chancen, fehlerhaften Skripten oder stundenlangem Debugging führen.

Worauf solltest du bei der Auswahl deiner Python-Web-Scraping-Tools achten?

- Performance: Kann das Tool auch mit großen Datenmengen umgehen?

- Benutzerfreundlichkeit: Verbringst du mehr Zeit mit Coden oder mit Ergebnissen?

- Browser- & JavaScript-Unterstützung: Funktioniert es auch mit modernen, dynamischen Webseiten?

- Skalierbarkeit: Wächst das Tool mit deinen Anforderungen mit?

- Integration: Lässt es sich einfach in deine Datenpipeline oder Geschäftsprozesse einbinden?

Typische Business-Anwendungsfälle? Lead-Generierung, Preisüberwachung, Wettbewerbsbeobachtung und die Automatisierung lästiger Dateneingaben. Die richtige Bibliothek entscheidet, ob dein Vertriebsteam immer einen Schritt voraus ist – oder in endlosen Tabellen festhängt.

So haben wir die besten Python-Bibliotheken für Web-Scraping bewertet

Für diese Liste habe ich jede Bibliothek nach folgenden Kriterien bewertet:

- Performance & Skalierbarkeit: Wie gut kommt sie mit großen Datenmengen und komplexen Seiten klar?

- Benutzerfreundlichkeit: Ist sie auch für Einsteiger geeignet oder braucht man Expertenwissen?

- Browser- & JavaScript-Unterstützung: Kommt sie mit dynamischen Inhalten und modernen Web-Apps klar?

- Sicherheit & Wartung: Wird sie aktiv gepflegt und ist sie sicher?

- Community & Support: Gibt es Dokumentation, Tutorials und eine aktive Community?

- Integrationsmöglichkeiten: Lässt sie sich mit anderen Tools (oder KI-Lösungen wie Thunderbit) kombinieren?

Außerdem habe ich auf echte Business-Anforderungen geachtet – denn am Ende zählt, wie gut die gelieferten Daten sind.

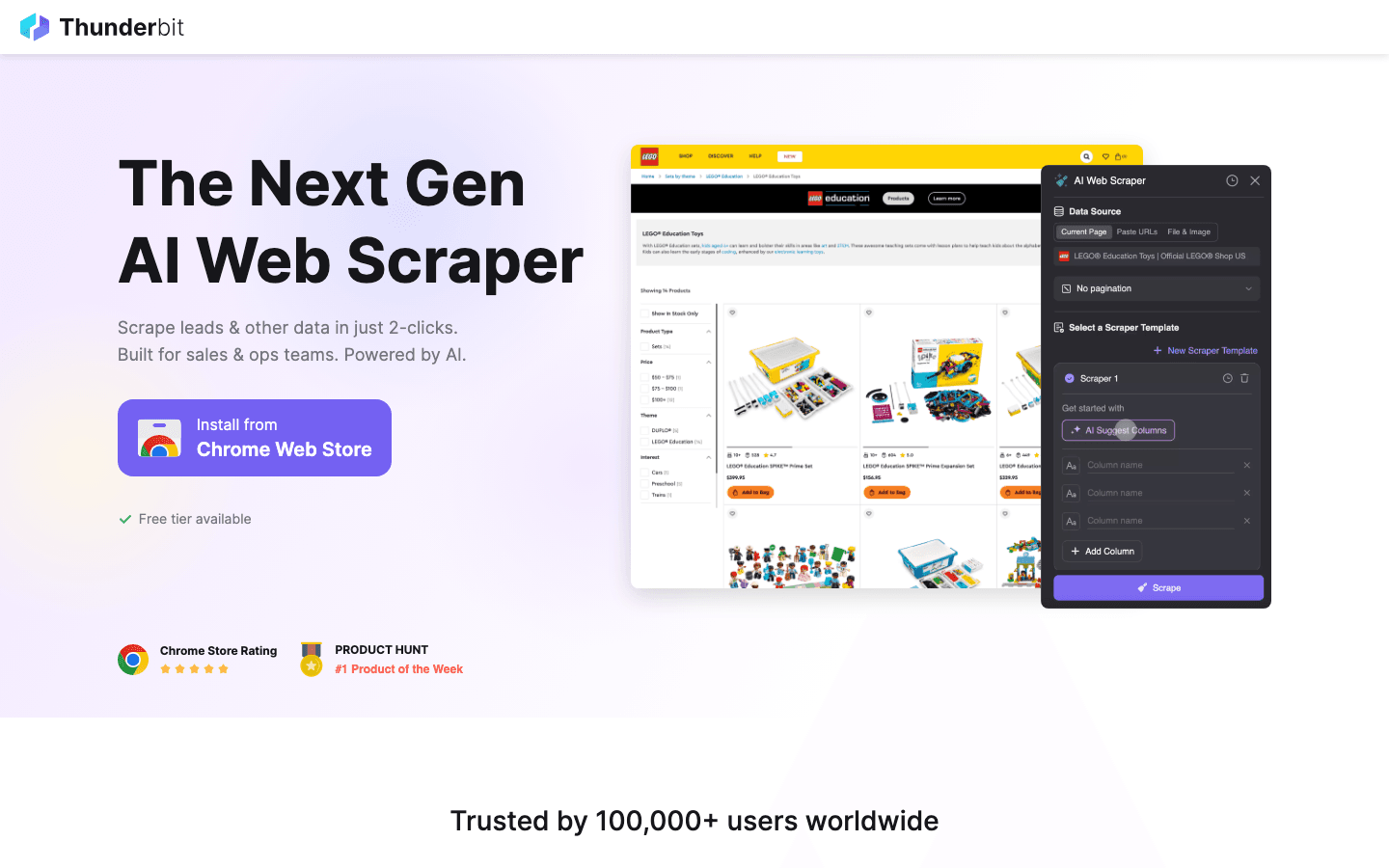

1. Thunderbit

ist keine klassische Python-Bibliothek, sondern eine , die 2026 das Web-Scraping für Business-Anwender und Entwickler komplett aufmischt. Deshalb gehört sie auf diese Liste.

ist keine klassische Python-Bibliothek, sondern eine , die 2026 das Web-Scraping für Business-Anwender und Entwickler komplett aufmischt. Deshalb gehört sie auf diese Liste.

Hauptfunktionen:

- KI-Feldvorschläge: Einfach beschreiben, was du brauchst – Thunderbits KI erkennt automatisch die passenden Spalten und Datentypen.

- Subseiten-Scraping: Besucht und extrahiert automatisch Daten von Unterseiten (z. B. Produktdetails oder LinkedIn-Profile).

- Sofort-Vorlagen: Ein-Klick-Scraping für bekannte Seiten (Amazon, Zillow, Shopify usw.).

- Kostenloser Datenexport: Exportiere nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON – ohne Zusatzkosten.

- No-Code-Workflow: Perfekt für Nicht-Techniker, lässt sich aber auch mit Python-Tools für fortgeschrittene Workflows kombinieren.

Beste Anwendungsfälle: Lead-Generierung, Preisüberwachung im E-Commerce, Immobilienanzeigen, operative Prozesse – überall, wo strukturierte Daten schnell benötigt werden.

Vorteile:

- Kein Programmieren nötig – einfach klicken und beschreiben

- KI passt sich an wechselnde Webseitenstrukturen an

- Kommt auch mit unübersichtlichen, langen Webseiten klar

- Lässt sich mit Python-Bibliotheken (wie Scrapy oder Beautiful Soup) für hybride Workflows kombinieren

Nachteile:

- Keine reine Python-Bibliothek (aber gut in Python-Pipelines integrierbar)

- Am besten für Business-Anwender oder als Ergänzung zu Code-basiertem Scraping

Tipp: Nutze Thunderbit, um Scraper schnell zu prototypisieren oder unübersichtliche Einzelaufgaben zu erledigen. Für große Automatisierungen exportiere die strukturierten Daten und verarbeite sie weiter mit Python-Skripten.

2. Beautiful Soup

ist die Standardbibliothek in Python, wenn es ums Parsen und Navigieren von HTML oder XML geht. Wer schon mal eine chaotische Webseite aufräumen musste, weiß, warum dieses Tool bei Einsteigern und Profis gleichermaßen beliebt ist.

ist die Standardbibliothek in Python, wenn es ums Parsen und Navigieren von HTML oder XML geht. Wer schon mal eine chaotische Webseite aufräumen musste, weiß, warum dieses Tool bei Einsteigern und Profis gleichermaßen beliebt ist.

Hauptfunktionen:

- Intuitive Syntax zum Suchen, Navigieren und Bearbeiten von HTML/XML

- Kommt auch mit fehlerhaftem oder unvollständigem Markup zurecht

- Lässt sich nahtlos mit zum Laden von Seiten kombinieren

Beste Anwendungsfälle: Schnelles Scraping, Datenbereinigung, Parsen kleiner bis mittelgroßer Seiten.

Vorteile:

- Sehr leicht zu erlernen

- Ideal zum Aufräumen von „hässlichem“ HTML

- Flexibel und fehlertolerant

Nachteile:

- Langsamer als bei großen Dokumenten

- Keine eingebaute JavaScript-Unterstützung

Tipp: Für mehr Geschwindigkeit Beautiful Soup mit dem lxml-Parser nutzen. Für komplexe, dynamische Seiten empfiehlt sich die Kombination mit Selenium oder Pyppeteer.

3. Selenium

ist der Klassiker, wenn es um die Automatisierung von Browsern geht. Es steuert Chrome, Firefox, Edge und mehr – ideal für das Scrapen dynamischer, JavaScript-lastiger Webseiten.

ist der Klassiker, wenn es um die Automatisierung von Browsern geht. Es steuert Chrome, Firefox, Edge und mehr – ideal für das Scrapen dynamischer, JavaScript-lastiger Webseiten.

Hauptfunktionen:

- Steuert echte Browser (Chrome, Firefox usw.)

- Unterstützt Headless-Modus für schnellere, GUI-freie Abläufe

- Kann Formulare ausfüllen, Buttons klicken und Nutzeraktionen simulieren

Beste Anwendungsfälle: Scraping von Seiten mit Login, Klicks oder starker JavaScript-Nutzung.

Vorteile:

- Kommt mit fast jeder Website klar, egal wie dynamisch

- Unterstützt verschiedene Browser und Plattformen

- Ideal für Tests und Scraping in einem Tool

Nachteile:

- Langsamer als reine Headless-Lösungen

- Benötigt mehr Ressourcen

- Skripte können bei Layout-Änderungen schnell brechen

Tipp: Selenium ist die Lösung, wenn sonst nichts funktioniert. Für Geschwindigkeit und Skalierung lieber Scrapy oder Pyppeteer nutzen.

4. Requests

ist die Standardbibliothek für HTTP-Anfragen in Python. Sie bildet das Rückgrat vieler Scraping-Workflows und macht das Senden von GET/POST-Anfragen und das Verarbeiten von Antworten super einfach.

ist die Standardbibliothek für HTTP-Anfragen in Python. Sie bildet das Rückgrat vieler Scraping-Workflows und macht das Senden von GET/POST-Anfragen und das Verarbeiten von Antworten super einfach.

Hauptfunktionen:

- Saubere, Python-typische API für HTTP-Anfragen

- Unterstützt Cookies, Sessions und Authentifizierung

- Lässt sich gut mit Parsern wie Beautiful Soup und LXML kombinieren

Beste Anwendungsfälle: Abrufen statischer Seiten, APIs oder als Basis für eigene Scraper.

Vorteile:

- Extrem einfach zu nutzen

- Zuverlässig und gut gepflegt

- Perfekt für schnelle Skripte und Prototypen

Nachteile:

- Kein eingebautes HTML-Parsen

- Kann keine JavaScript-Inhalte verarbeiten

Tipp: Kombiniere Requests mit Beautiful Soup oder LXML für einen klassischen, schlanken Scraping-Stack.

5. LXML

ist der Turbo unter den Python-Parsern für HTML/XML. Wer riesige Dokumente oder komplexe XPath-Abfragen verarbeiten muss, ist hier richtig.

ist der Turbo unter den Python-Parsern für HTML/XML. Wer riesige Dokumente oder komplexe XPath-Abfragen verarbeiten muss, ist hier richtig.

Hauptfunktionen:

- Blitzschnelles Parsen dank C-basierter Engine

- Volle Unterstützung für XPath und CSS-Selektoren

- Verarbeitet HTML und XML

Beste Anwendungsfälle: Großflächiges Parsen, komplexe Dokumentstrukturen, Projekte mit hohen Performance-Anforderungen.

Vorteile:

- Viel schneller als Beautiful Soup bei großen Datenmengen

- Mächtige Selektor-Unterstützung

- Robuste Fehlerbehandlung

Nachteile:

- Weniger fehlertolerant bei kaputtem HTML

- Etwas höhere Einstiegshürde

Tipp: Nutze LXML als Parser für Beautiful Soup – so kombinierst du Benutzerfreundlichkeit und Performance.

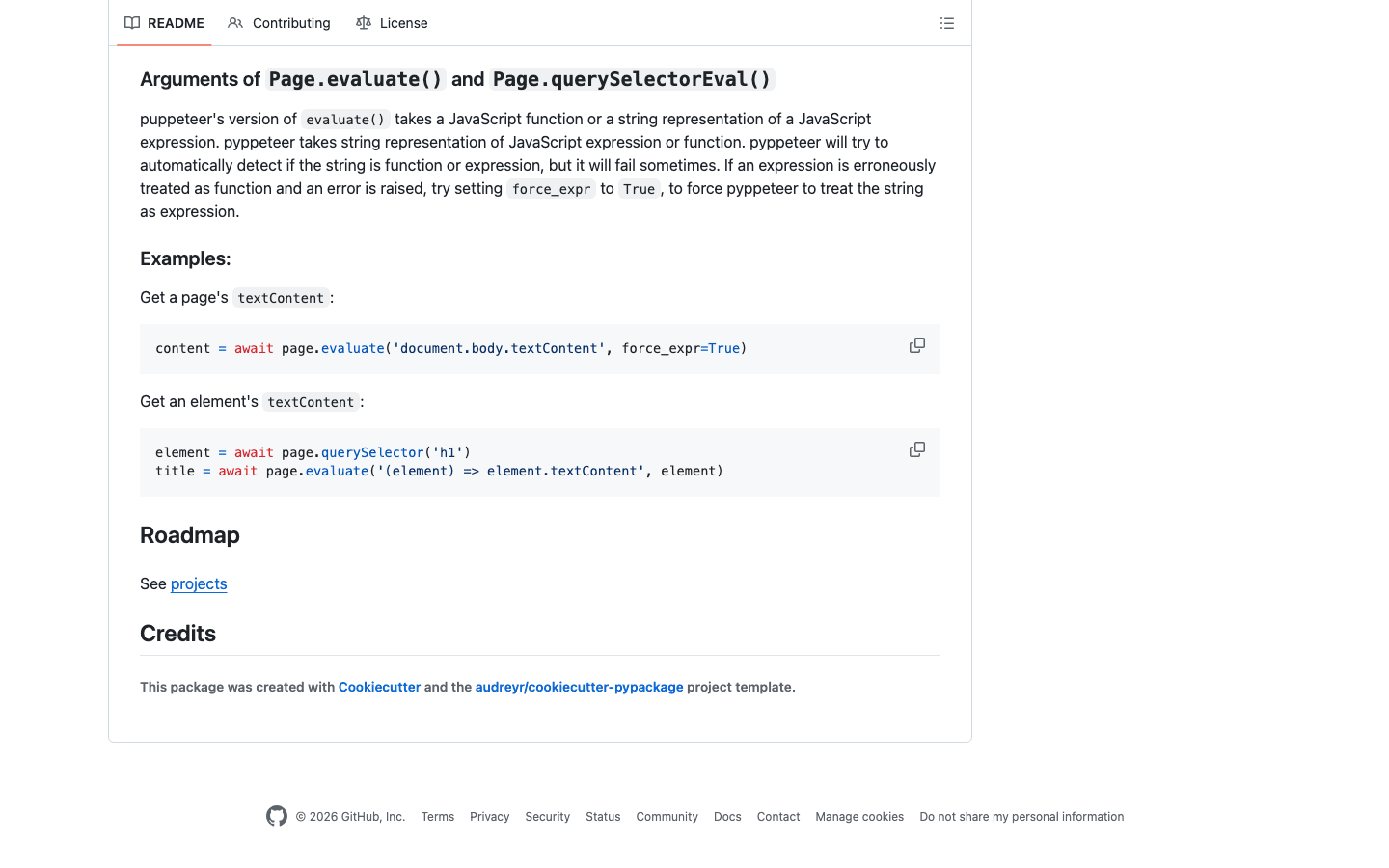

6. Pyppeteer

ist das Python-Pendant zu Puppeteer und steuert Headless Chrome für anspruchsvolle Scraping-Aufgaben. Perfekt für moderne Web-Apps mit viel JavaScript.

ist das Python-Pendant zu Puppeteer und steuert Headless Chrome für anspruchsvolle Scraping-Aufgaben. Perfekt für moderne Web-Apps mit viel JavaScript.

Hauptfunktionen:

- Volle Kontrolle über Headless Chrome (oder Chromium)

- Hervorragende JavaScript-Ausführung und Nutzerinteraktion

- Kann komplexe Navigation, Screenshots und PDF-Generierung übernehmen

Beste Anwendungsfälle: Scraping moderner, JavaScript-lastiger Seiten, Automatisierung von Nutzerabläufen, Umgehen von Anti-Bot-Maßnahmen.

Vorteile:

- Erstklassige JavaScript-Unterstützung

- Simuliert menschliches Verhalten für schwierige Seiten

- Ideal für SPAs (Single Page Apps)

Nachteile:

- Schwerer und langsamer als Requests oder Scrapy

- Wartungsstatus kann schwanken – auf Updates achten

- Etwas mehr Einrichtung nötig

Tipp: Wenn Selenium nicht weiterhilft, schafft Pyppeteer oft Abhilfe. Für Business-Workflows: Mit Thunderbits KI die Datenfelder vorab definieren und dann Pyppeteer für die Navigation nutzen.

7. Splash

ist eine schlanke Browser-Engine, die JavaScript in großem Stil rendert. Häufig in Kombination mit Scrapy für dynamische Seiten im Einsatz.

ist eine schlanke Browser-Engine, die JavaScript in großem Stil rendert. Häufig in Kombination mit Scrapy für dynamische Seiten im Einsatz.

Hauptfunktionen:

- Headless-Browser mit HTTP-API

- Rendert JavaScript und liefert HTML, Screenshots oder HAR-Dateien zurück

- Lässt sich über Middleware in Scrapy integrieren

Beste Anwendungsfälle: Stapelverarbeitung von JavaScript-Seiten, skalierbare Scraping-Pipelines, serverseitiges Rendering.

Vorteile:

- Schnell und effizient für große Mengen

- API-basiert – einfach zu integrieren

- Geringerer Ressourcenverbrauch als vollständige Browser-Automatisierung

Nachteile:

- Weniger interaktiv als Selenium oder Pyppeteer

- Etwas Einarbeitung für Einrichtung und Scripting nötig

Tipp: Für großflächiges Scraping dynamischer Seiten ist Scrapy + Splash ein echtes Power-Duo.

8. MechanicalSoup

ist eine schlanke Python-Bibliothek zur Automatisierung von Webformularen und einfacher Navigation. Sie baut auf Requests und Beautiful Soup auf.

ist eine schlanke Python-Bibliothek zur Automatisierung von Webformularen und einfacher Navigation. Sie baut auf Requests und Beautiful Soup auf.

Hauptfunktionen:

- Automatisiert Formularausfüllung und Navigation

- Hält Sitzungsstatus und Cookies automatisch

- Einfache, einsteigerfreundliche API

Beste Anwendungsfälle: Einloggen auf Webseiten, Formulare ausfüllen, Scraping statischer oder leicht dynamischer Seiten.

Vorteile:

- Minimaler Aufwand – ideal für schnelle Automatisierung

- Cookies und Sessions werden automatisch verwaltet

- Perfekt für Seiten mit einfachen Login- oder Suchformularen

Nachteile:

- Keine JavaScript-Unterstützung

- Nicht für große oder hochdynamische Scraping-Projekte gedacht

Tipp: Nutze MechanicalSoup für Login-Prozesse und übergib dann an Requests + Beautiful Soup für die weitere Verarbeitung.

9. Twisted

ist eine ereignisgesteuerte Netzwerk-Engine für Python. Kein klassischer Web-Scraper, aber das Rückgrat für maßgeschneiderte, hochperformante Scraping-Pipelines.

ist eine ereignisgesteuerte Netzwerk-Engine für Python. Kein klassischer Web-Scraper, aber das Rückgrat für maßgeschneiderte, hochperformante Scraping-Pipelines.

Hauptfunktionen:

- Asynchrones Networking für HTTP, TCP und mehr

- Skaliert auf Tausende gleichzeitige Verbindungen

- Wird in individuellen, verteilten Scraping-Systemen eingesetzt

Beste Anwendungsfälle: Entwicklung eigener, hochvolumiger Scraper; Integration mit anderen Async-Frameworks.

Vorteile:

- Extrem skalierbar und leistungsstark

- Unterstützt viele Protokolle

- Für fortgeschrittene Nutzer geeignet

Nachteile:

- Hohe Lernkurve

- Für Standard-Scraping meist überdimensioniert

Tipp: Wer Millionen von Seiten scrapen will, sollte sich Twisted genauer ansehen.

10. Scrapy

ist das Schweizer Taschenmesser unter den Python-Web-Scraping-Frameworks. Für große, produktionsreife Projekte entwickelt, basiert es auf einer asynchronen Architektur und crawlt Tausende Seiten mühelos.

ist das Schweizer Taschenmesser unter den Python-Web-Scraping-Frameworks. Für große, produktionsreife Projekte entwickelt, basiert es auf einer asynchronen Architektur und crawlt Tausende Seiten mühelos.

Hauptfunktionen:

- Asynchrone, ereignisgesteuerte Engine für hohe Durchsatzraten

- Integrierte Unterstützung für Pipelines, Middleware und Datenexport (JSON, CSV, XML)

- Übernimmt Crawling, Parsen und Datenbereinigung in einem Tool

- Erweiterbar mit Plugins für Proxies, User Agents und mehr

Beste Anwendungsfälle: Scraping im Unternehmensmaßstab, strukturierte Datenerfassung, Projekte mit hohen Anforderungen an Geschwindigkeit und Zuverlässigkeit.

Vorteile:

- Extrem schnell bei großen Aufgaben

- Hochgradig anpassbar und erweiterbar

- Starke Community und Dokumentation

Nachteile:

- Für Einsteiger steile Lernkurve

- Nicht ideal für dynamische, JavaScript-lastige Seiten (außer mit Splash)

Tipp: Scrapy funktioniert hervorragend mit für JavaScript-Rendering oder mit für KI-gestützte Felderkennung und Datenstrukturierung.

11. PyQuery

bringt jQuery-ähnliche Selektoren nach Python. Wer jQuery mag, fühlt sich hier sofort zuhause.

bringt jQuery-ähnliche Selektoren nach Python. Wer jQuery mag, fühlt sich hier sofort zuhause.

Hauptfunktionen:

- jQuery-ähnliche API zum Auswählen und Bearbeiten von HTML

- Baut auf lxml für Geschwindigkeit auf

- Unterstützt CSS-Selektoren und DOM-Manipulation

Beste Anwendungsfälle: Entwickler mit jQuery-Erfahrung, schnelles Prototyping, Projekte mit flexiblen Selektoren.

Vorteile:

- Schnell und effizient

- Intuitiv für jQuery-Fans

- Gut zum Parsen und Bearbeiten von HTML

Nachteile:

- Kleinere Community als Beautiful Soup oder LXML

- Weniger tolerant bei fehlerhaftem HTML

Tipp: PyQuery ist ideal, wenn du die Power von lxml willst, aber CSS-Selektoren bevorzugst.

12. Parsel

ist eine leistungsstarke Bibliothek zum Extrahieren von Daten aus HTML und XML mit XPath- und CSS-Selektoren. Sie ist das Herzstück der Parsing-Engine von Scrapy.

ist eine leistungsstarke Bibliothek zum Extrahieren von Daten aus HTML und XML mit XPath- und CSS-Selektoren. Sie ist das Herzstück der Parsing-Engine von Scrapy.

Hauptfunktionen:

- Erweiterte Unterstützung für XPath- und CSS-Selektoren

- Saubere API zum Extrahieren und Bereinigen von Daten

- Kann eigenständig oder innerhalb von Scrapy genutzt werden

Beste Anwendungsfälle: Komplexe Datenextraktion, Projekte mit anspruchsvoller Selektorlogik, Integration mit Scrapy.

Vorteile:

- Extrem flexibel und leistungsstark

- Ideal für schwierige Seitenlayouts

- Gut dokumentiert und aktiv gepflegt

Nachteile:

- Erfordert etwas Erfahrung mit Selektoren

- Kein vollständiges Scraping-Framework – am besten als Parsing-Komponente

Tipp: Nutze Parsel für die anspruchsvolle Extraktion in eigenen Scrapy-Spidern oder Parsing-Skripten.

Vergleichstabelle: Python-Web-Scraping-Tools im Überblick

| Bibliothek | Hauptfunktionen | Performance | Benutzerfreundlichkeit | JavaScript-Unterstützung | Ideal für | Integrationsmöglichkeiten |

|---|---|---|---|---|---|---|

| Thunderbit | KI-basiert, No-Code, Subseiten | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Ja (browserbasiert) | Business-Anwender, hybride Workflows | Excel, Sheets, Notion, Python |

| Beautiful Soup | HTML/XML-Parsing, fehlertolerant | ⭐⭐ | ⭐⭐⭐⭐⭐ | Nein | Datenbereinigung, kleine Aufgaben | Requests, LXML, Thunderbit |

| Selenium | Browser-Automatisierung, dynamische Inhalte | ⭐⭐ | ⭐⭐ | Ja | Dynamische Seiten, Nutzerinteraktion | Beautiful Soup, PyQuery |

| Requests | HTTP-Anfragen, Sessions | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Nein | Statische Seiten, APIs | Beautiful Soup, LXML |

| LXML | Schnelles Parsen, XPath, CSS-Selektoren | ⭐⭐⭐⭐ | ⭐⭐⭐ | Nein | Große Dokumente, komplexes Parsen | Beautiful Soup, PyQuery |

| Pyppeteer | Headless Chrome, JS-Rendering | ⭐⭐ | ⭐⭐ | Ja | Moderne JS-Seiten, SPAs | Thunderbit, Pandas |

| Splash | JS-Rendering, API-basiert | ⭐⭐⭐ | ⭐⭐ | Ja | Batch-JS-Scraping, Pipelines | Scrapy, Thunderbit |

| MechanicalSoup | Formularhandling, Navigation | ⭐⭐ | ⭐⭐⭐⭐ | Nein | Einfache Formulare, Logins | Requests, Beautiful Soup |

| Twisted | Async Networking, eigene Pipelines | ⭐⭐⭐⭐⭐ | ⭐ | Nein | Hochvolumige, individuelle Scraper | Scrapy, eigene Frameworks |

| Scrapy | High-Performance, Async, Pipelines | ⭐⭐⭐⭐⭐ | ⭐⭐ | Eingeschränkt (mit Splash) | Unternehmens-Scraping, strukturierte Daten | Splash, Parsel, Thunderbit |

| PyQuery | jQuery-Selektoren, schnell | ⭐⭐⭐ | ⭐⭐⭐⭐ | Nein | jQuery-Fans, schnelles Prototyping | LXML, Requests |

| Parsel | XPath/CSS-Selektoren, flexibles Parsen | ⭐⭐⭐⭐ | ⭐⭐⭐ | Nein | Komplexe Extraktion, Scrapy-Nutzer | Scrapy, eigenständig |

Wie du die beste Python-Web-Scraping-Bibliothek für dich findest

Hier eine schnelle Entscheidungshilfe:

-

Statische Seiten oder APIs?

Nutze Requests + Beautiful Soup oder LXML. -

Große Datenmengen, hohe Geschwindigkeit?

Scrapy ist ideal. Für asynchrones Networking Twisted in Betracht ziehen. -

Dynamische, JavaScript-lastige Seiten scrapen?

Selenium, Pyppeteer oder Splash (mit Scrapy) ausprobieren. -

jQuery-ähnliche Selektoren gewünscht?

PyQuery ist eine gute Wahl. -

Formulare oder Logins automatisieren?

MechanicalSoup ist einfach und effektiv. -

Kein Programmierer oder wenig Zeit für Setup?

Mit Thunderbit kannst du per natürlicher Sprache definieren, was du brauchst, und strukturierte Daten direkt exportieren. -

Hybrider Ansatz?

Mit Thunderbit schnell Daten strukturieren und dann in Python-Skripte zur Weiterverarbeitung einspeisen.

Checkliste für die Tool-Auswahl:

- Wie komplex ist die Seite (statisch vs. dynamisch)?

- Wie viel Daten willst du extrahieren?

- Müssen Formulare oder Logins automatisiert werden?

- Wie fit bist du in Python und Selektoren?

- Willst du Daten in Business-Tools (Excel, Sheets, Notion) exportieren?

- Ist Wartung ein Thema?

Fazit: So nutzt du die Power von Python-Web-Scraping 2026

Python-Web-Scraping war noch nie so stark – und so einfach zugänglich – wie heute. Egal, ob du mit Scrapy skalierst, Daten mit Beautiful Soup bereinigst, JavaScript mit Selenium oder Pyppeteer meisterst oder einfach ohne eine Zeile Code Daten in deine Tabelle bringen willst: Es gibt für jeden das passende Tool.

Das eigentliche Geheimnis? Kombiniere verschiedene Tools! Jede Python-Web-Scraping-Bibliothek hat ihre Stärken. Durch die Kombination (oder die Ergänzung mit KI-Lösungen wie ) sparst du Zeit, reduzierst Fehler und gewinnst neue Business-Insights.

2026 gewinnen nicht die schnellsten Coder, sondern die, die das richtige Tool für die Aufgabe wählen, Routinearbeiten automatisieren und sich auf das Wesentliche konzentrieren: Webdaten in echten Geschäftswert verwandeln.

FAQs

1. Welche Python-Bibliothek eignet sich am besten für Einsteiger?

Beautiful Soup ist wegen ihrer einfachen Syntax und Fehlertoleranz sehr beliebt. Für Nicht-Programmierer bietet Thunderbit eine KI-basierte, No-Code-Alternative.

2. Welches Python-Tool ist am besten für dynamische oder JavaScript-lastige Webseiten?

Selenium, Pyppeteer und Splash sind die Top-Optionen für dynamische Inhalte. Pyppeteer ist besonders stark bei modernen JavaScript-Anwendungen.

3. Kann ich Thunderbit mit Python-Bibliotheken wie Scrapy oder Beautiful Soup kombinieren?

Absolut! Thunderbit kann Daten schnell strukturieren und exportieren, die du dann mit deinen bevorzugten Python-Bibliotheken weiterverarbeiten kannst.

4. Welche Python-Bibliothek ist am schnellsten beim Parsen großer HTML-Dokumente?

LXML ist in der Regel am schnellsten, besonders bei der Nutzung von XPath- oder CSS-Selektoren.

5. Wie entscheide ich zwischen Scrapy und Selenium?

Scrapy eignet sich für großflächiges, strukturiertes Scraping von meist statischen Seiten. Selenium ist die bessere Wahl, wenn du mit dynamischen Elementen, Logins oder JavaScript-lastigen Seiten arbeiten musst.

Neugierig, wie Thunderbit dein Web-Scraping aufs nächste Level bringt? und entdecke weitere Anleitungen im . Viel Erfolg beim Scrapen!

Mehr erfahren