Web-Scraping ist in den letzten Jahren zum unsichtbaren Antrieb vieler smarter Geschäftsentscheidungen geworden. Egal ob Vertrieb, Operations oder Marktforschung – wahrscheinlich hast du schon von gesammelten Webdaten profitiert, ohne es zu merken.

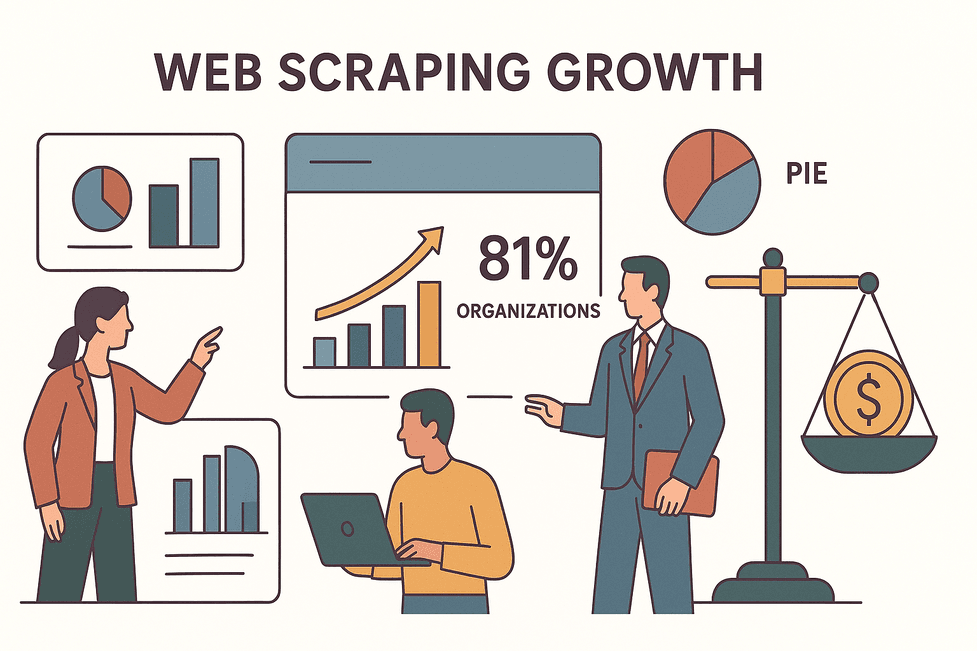

Da der Markt für Web-Scraping-Software bis 2025 auf wachsen soll und bereits Scraping nutzen, sind Effizienz und Rechtssicherheit wichtiger denn je. Sie entscheiden darüber, ob du eine nachhaltige Datenstrategie aufbaust – oder dir rechtlichen Ärger einhandelst.

In diesem Guide teile ich die wichtigsten Best Practices für Web-Scraping, die ich als Thunderbit-Mitgründer (und Automatisierungsfan) gesammelt habe. Du erfährst, warum Compliance unverzichtbar ist, wie du das passende Tool auswählst (Tipp: KI ist dein bester Freund), wie du schneller und smarter scrapen kannst und wie du deine Daten und deinen Ruf schützt. Los geht’s!

Was ist Web-Scraping? Das sollten Business-Anwender wissen

Im Kern bedeutet Web-Scraping, dass Software automatisch Infos von Webseiten sammelt – wie ein Copy-Paste-Roboter, der nie müde wird. Statt Preise, E-Mails oder News händisch zu kopieren, zieht ein Web-Scraper die Daten in wenigen Minuten in eine Tabelle oder Datenbank.

Der eigentliche Mehrwert für Unternehmen liegt nicht im Code, sondern darin, was du mit den Daten machen kannst: Vertriebsteams bauen Lead-Listen, E-Commerce-Manager beobachten Preise der Konkurrenz, Analysten verfolgen Markttrends – alles dank Scraping. – ein Muss, um wettbewerbsfähig zu bleiben.

Der eigentliche Mehrwert für Unternehmen liegt nicht im Code, sondern darin, was du mit den Daten machen kannst: Vertriebsteams bauen Lead-Listen, E-Commerce-Manager beobachten Preise der Konkurrenz, Analysten verfolgen Markttrends – alles dank Scraping. – ein Muss, um wettbewerbsfähig zu bleiben.

Moderne Tools wie machen Scraping für alle zugänglich – nicht nur für Entwickler. Du kannst per Mausklick oder sogar mit einer einfachen Beschreibung starten, und die KI übernimmt den Rest.

Web-Scraping und Compliance: Warum Rechtssicherheit zählt und wie du sie sicherstellst

Jetzt zum weniger spaßigen Teil: Mit großer Datenmacht kommt große Verantwortung. Compliance beim Web-Scraping heißt, Gesetze einzuhalten, Website-Regeln zu respektieren und persönliche Daten korrekt zu behandeln. Die Risiken sind real – Unternehmen mussten bereits für unsauberes Scraping zahlen.

Wer Compliance ignoriert, riskiert nicht nur rechtliche Konsequenzen, sondern auch einen massiven Reputationsschaden. Deshalb mein Tipp: Setze von Anfang an auf einen „Compliance-First“-Ansatz und baue Schutzmaßnahmen in jedes Scraping-Projekt ein.

Die wichtigsten Compliance-Bereiche beim Web-Scraping

Hier die zentralen Risiken im Überblick:

- Nutzungsbedingungen (ToS): Viele Websites verbieten Scraping ausdrücklich in ihren ToS. Wer dagegen verstößt, riskiert IP-Sperren oder sogar Klagen. Prüfe die Regeln immer vorab.

- robots.txt und Crawler-Etikette: Diese Datei zeigt Bots, was tabu ist. Rechtlich nicht bindend, aber wer sie ignoriert, gilt schnell als „Bad Actor“.

- Datenschutzgesetze (DSGVO, CCPA): Wer personenbezogene Daten (Namen, E-Mails, Social-Profile) sammelt, muss Datenschutzgesetze beachten – auch wenn die Daten öffentlich sind. Die Strafen können enorm sein.

- Urheber- und Datenbankrechte: Fakten sind meist frei, aber große Mengen an Texten, Bildern oder kreativen Inhalten können urheberrechtlich geschützt sein. In Europa ist sogar die Datenbankstruktur geschützt.

- Computerstrafrecht (CFAA): Öffentlich zugängliche Daten zu scrapen ist meist erlaubt, aber das Umgehen von Logins, CAPTCHAs oder technischen Sperren kann illegal sein.

Mehr dazu findest du im .

So baust du einen Compliance-orientierten Scraping-Prozess auf

Meine Schritt-für-Schritt-Checkliste:

- Planen und dokumentieren: Prüfe vorab die ToS, robots.txt und ob du personenbezogene Daten sammelst. Dokumentiere deine Compliance-Schritte – das ist deine Absicherung.

- Zugriffsregeln respektieren: Beachte robots.txt, setze Crawl-Delays und vermeide zu viele Anfragen. Bei Fehlern wie HTTP 429 (zu viele Anfragen) drossle das Tempo.

- Keine geschützten Bereiche scrapen: Scrape nicht hinter Logins oder Bezahlschranken ohne Erlaubnis. Bleib bei öffentlich sichtbaren Inhalten.

- Personenbezogene Daten minimieren: Sammle nur, was nötig ist. Anonymisiere oder aggregiere persönliche Infos, wo möglich.

- Legale Proxies nutzen: Verwende nur seriöse Proxy-Anbieter. Illegale Netzwerke können rechtliche Probleme verursachen.

- Regelmäßig prüfen und anpassen: Wenn sich eine Website ändert oder du eine Abmahnung erhältst, stoppe und prüfe dein Vorgehen.

- Team schulen: Alle Beteiligten sollten die Best Practices kennen. Ein uninformierter Praktikant kann großen Schaden anrichten.

Eine ausführliche Checkliste gibt es .

Das richtige Web-Scraping-Tool für dein Unternehmen auswählen

Nicht jeder Scraper ist gleich. Die Wahl hängt von deinen technischen Kenntnissen, der Komplexität der Zielseiten, Automatisierungsbedarf und Budget ab. Worauf ich achte:

- Benutzerfreundlichkeit: Ist das Tool auch für Nicht-Programmierer geeignet? Tools wie und Browse AI bieten 2-Klick-Setups und KI-gestützte Feldvorschläge.

- Automatisierung & KI: Unterstützt das Tool Paginierung, Unterseiten und Zeitplanung? Kann es sich an Layout-Änderungen anpassen? Thunderbit schlägt Felder vor und formatiert Daten automatisch.

- Komplexe Websites: Müssen dynamische oder JavaScript-lastige Seiten gescrapt werden? Dann sollte das Tool browserbasiertes oder Cloud-Scraping unterstützen.

- Integrationen: Kannst du direkt nach Google Sheets, Airtable, Notion oder ins CRM exportieren? Thunderbit bietet 1-Klick-Exporte.

- Kosten & Skalierbarkeit: Für kleine Aufgaben reicht oft die Gratis-Version. Bei größeren Projekten sind Cloud-Lösungen mit paralleler Verarbeitung (Thunderbit kann 50 Seiten gleichzeitig scrapen) sinnvoll.

Web-Scraping-Tools im Vergleich: Worauf kommt es an?

| Tool | Benutzerfreundlichkeit | Automatisierung & KI | Komplexe Seiten | Integrationen | Kosten |

|---|---|---|---|---|---|

| Thunderbit | Sehr hoch | KI-gestützt, 2-Klick, Zeitplanung | Hoch (Cloud & Browser) | Sheets, Airtable, Notion, Excel | Gratis, kostenpflichtige Pläne |

| Browse AI | Hoch | KI-Roboter, Zeitplanung | Hoch (Cloud) | Sheets, Airtable, API | Gratis, kostenpflichtige Pläne |

| Octoparse | Mittel | Visuell, Vorlagen | Hoch (Cloud) | CSV, Excel, API | Gratis, kostenpflichtige Pläne |

| Web-Scraper | Mittel | Manuelle Einrichtung | Mittel | CSV, JSON | Gratis, kostenpflichtige Cloud |

| Bardeen | Mittel-Hoch | Automatisierungsfokus | Hoch | Sheets, CRMs | Gratis, kostenpflichtige Pläne |

Eine ausführliche Übersicht findest du in .

Effizienter scrapen: Strategien für schnellere und intelligentere Datenerfassung

Effizienz macht aus Web-Scraping ein echtes Business-Asset. So holst du das Maximum raus:

- Anfragen parallelisieren: Moderne Tools wie Thunderbit Cloud scrapen Dutzende Seiten gleichzeitig – das spart enorm Zeit. Aber Vorsicht: Zu viele Anfragen können zu Sperren führen.

- Cleveres Scheduling: Automatisiere Scrapes zu Randzeiten oder in festen Intervallen. Thunderbit versteht sogar natürliche Sprache („jeden Montag um 9 Uhr“).

- Schrittweises Extrahieren: Teile große Aufgaben in Etappen – erst URLs sammeln, dann Details scrapen. Thunderbits Subpage-Scraping macht das einfach.

- Vorlagen nutzen: Für bekannte Seiten gibt es fertige Templates – z.B. für Amazon oder LinkedIn. Thunderbit und Octoparse bieten diese an.

- Datenverarbeitung automatisieren: Bereinige und formatiere Daten direkt beim Scraping. Thunderbits KI kann Telefonnummern formatieren, Texte übersetzen und Daten kategorisieren.

Schrittweises und automatisiertes Web-Scraping

Beispiel: Du möchtest alle Produkte eines Online-Shops scrapen:

- Listen-Seiten scrapen – Produktnamen und URLs sammeln (inkl. Paginierung).

- Diese URLs an einen Detail-Scraper übergeben (Thunderbits Subpage-Feature erledigt das mit einem Klick).

- Ergebnisse zusammenführen – alles in einer strukturierten Tabelle, bereit zur Analyse.

Diese Methode ist schneller, robuster und leichter zu warten. Und wenn mal etwas nicht klappt, musst du nur einen Schritt anpassen.

Daten speichern und exportieren: So bleibt alles übersichtlich

Vermeide Datenchaos – so behältst du den Überblick:

- Das richtige Format wählen: Exportiere nach CSV, Excel, Google Sheets oder Airtable – je nach Bedarf. Thunderbit bietet 1-Klick-Exporte.

- Daten strukturieren: Verwende klare, einheitliche Spaltennamen („Preis“ statt „col3“).

- Metadaten ergänzen: Füge Quell-URLs und Zeitstempel hinzu.

- Größenlimits beachten: Google Sheets hat z. B. ein Limit von 10 Mio. Zellen – teile große Datensätze ggf. auf.

- Exporte automatisieren: Nutze Integrationen, um Daten direkt in deine Workflows zu schicken – ganz ohne manuelle Downloads.

Weitere Tipps findest du in .

Datenbereinigung und -management: Aus Rohdaten werden Geschäftseinblicke

Rohdaten aus dem Web sind oft unstrukturiert – Duplikate, unterschiedliche Formate, fehlende Werte. Hier beginnt die eigentliche Arbeit:

- Duplikate entfernen: Nutze eindeutige IDs oder URLs, um doppelte Einträge zu löschen.

- Formate vereinheitlichen: Daten, Preise, Telefonnummern – alles sollte einheitlich sein. Thunderbits KI kann das automatisch übernehmen.

- Fehlende Werte behandeln: Entscheide, wie du Lücken füllst oder markierst.

- Ausreißer prüfen: Kontrolliere stichprobenartig auf Fehler oder ungewöhnliche Werte.

- Daten anreichern: Füge Kategorien, Tags oder Übersetzungen direkt beim Scraping hinzu.

Mit Thunderbits Field AI Prompts kannst du für jedes Feld festlegen, wie es formatiert oder benannt werden soll – so ist dein Output direkt analysierbar, ohne Nachbearbeitung in Excel.

Praktische Schritte zur Datenbereinigung beim Web-Scraping

- Duplikate entfernen.

- Formate vereinheitlichen (Datum, Zahlen, Text).

- Fehlende Werte füllen oder markieren.

- Daten auf Richtigkeit prüfen.

- Bei Bedarf mit internen Daten abgleichen.

- Wo möglich, Bereinigung automatisieren.

Mehr dazu in .

Sicherheit und Schutz deiner gesammelten Daten

Sobald du deine Daten hast, ist deren Schutz Pflicht – besonders bei personenbezogenen oder sensiblen Informationen.

- Daten sicher speichern: Nutze verschlüsselte Datenbanken oder sichere Cloud-Speicher. Bei Google Sheets: Zugriffsrechte restriktiv vergeben.

- Personenbezogene Daten verschlüsseln: E-Mails und Telefonnummern nur im Klartext speichern, wenn unbedingt nötig.

- Zugriff beschränken: Nur berechtigte Personen erhalten Zugriff.

- Wo möglich anonymisieren: Persönliche Merkmale entfernen, wenn sie nicht gebraucht werden.

- Aufbewahrungsfristen einhalten: Daten nicht länger speichern als nötig.

- Scraping-Prozess absichern: Setze auf seriöse Cloud-Dienste (Thunderbits Cloud-Scraping läuft auf sicheren US/EU/Asien-Servern).

- Datenschutzgesetze beachten: Sei bereit, Daten auf Anfrage zu löschen (DSGVO/CCPA).

Mehr zum Thema Datensicherheit findest du in .

Datenschutz im Web-Scraping-Projekt sicherstellen

- Nur sammeln, was wirklich nötig ist.

- Für Analysen aggregieren und anonymisieren.

- Keine Login- oder privaten Inhalte scrapen.

- Über aktuelle Datenschutzgesetze informiert bleiben.

- Beim Teilen von Daten: anonymisieren oder Vereinbarungen einholen.

Behandle gescrapte Daten mit der gleichen Sorgfalt wie deine internen Datenbanken – dein Ruf (und deine Rechtssicherheit) hängen davon ab.

Typische Fehler beim Web-Scraping – und wie du sie vermeidest

Auch Profis machen Fehler. Hier die häufigsten Stolperfallen – und wie du sie umgehst:

- Zu aggressives Scraping: Wird man blockiert oder legt eine Website lahm. Lösung: Anfragen drosseln, Crawl-Delays beachten, Proxies verantwortungsvoll nutzen.

- Compliance ignorieren: ToS oder Datenschutz übergehen. Lösung: Compliance immer vorab prüfen.

- Schlechtes Datenmanagement: Am Ende unbrauchbare, chaotische Daten. Lösung: Daten direkt beim Scraping strukturieren und bereinigen.

- Nur ein Tool nutzen: Für jede Aufgabe das gleiche Tool erzwingen. Lösung: Flexibel bleiben – manchmal ist eine API oder ein anderes Tool besser.

- Monitoring vernachlässigen: Nicht prüfen, ob der Scraper noch funktioniert. Lösung: Alerts einrichten und Ergebnisse regelmäßig kontrollieren.

- Fehlendes Fehler-Handling: Ein Fehler stoppt den gesamten Prozess. Lösung: Wiederholungen und Fehlerprotokolle einbauen.

- Ethische Fehler: Sensible oder persönliche Daten ohne Nachdenken scrapen. Lösung: Immer fragen: „Wäre ich mit dieser Datennutzung einverstanden?“

Mehr echte Beispiele (und wie du sie vermeidest) findest du in .

Fazit: Nachhaltiges und rechtssicheres Web-Scraping aufbauen

Web-Scraping ist ein echter Gamechanger für Business Intelligence – aber nur, wenn du es richtig angehst. Die besten Ergebnisse erzielst du, wenn du Effizienz, Compliance und Ethik in Einklang bringst. Hier die wichtigsten Punkte:

- Vor dem Scraping planen: Ziele klären, Compliance prüfen, das passende Tool wählen.

- Compliance in jeden Schritt integrieren: Recht und Ethik sind Pflicht.

- Automatisierung und KI nutzen: Tools wie machen Scraping schneller, intelligenter und zugänglicher.

- Daten bereinigen und strukturieren: Nur saubere Daten führen zu guten Entscheidungen.

- Daten schützen: Privatsphäre und Geschäftsgeheimnisse wahren.

- Monitoring und Anpassung: Das Web verändert sich – deine Scraping-Strategie sollte es auch.

Wenn du sehen möchtest, wie modernes und verantwortungsvolles Web-Scraping aussieht, und probiere sie aus. Für weitere Tipps und Anleitungen besuche den .

Viel Erfolg beim (verantwortungsvollen) Scrapen!

FAQs

1. Ist Web-Scraping für Unternehmen legal?

Web-Scraping ist legal, wenn du öffentliche Daten sammelst, die Website-Regeln beachtest und Datenschutzgesetze wie DSGVO und CCPA einhältst. Prüfe immer die ToS und vermeide das Scrapen personenbezogener Daten ohne rechtliche Grundlage.

2. Wie kann ich verhindern, beim Scraping blockiert zu werden?

Drossle deine Anfragen, beachte Crawl-Delays in robots.txt und nutze bei Bedarf Proxies. Scrape nicht zu aggressiv und achte auf Fehler wie HTTP 429 (zu viele Anfragen).

3. Welches Tool eignet sich für Einsteiger ohne Programmierkenntnisse?

ist ideal für Nicht-Programmierer: KI-gestützte Feldvorschläge, 2-Klick-Setup und Sofort-Exporte nach Google Sheets, Airtable und Notion.

4. Wie halte ich gescrapte Daten sauber und übersichtlich?

Nutze strukturierte Exporte (CSV, Excel, Sheets), klare Spaltennamen und automatisiere Bereinigungsschritte wie Duplikat-Entfernung und Formatierung. Thunderbits KI hilft beim Formatieren und Beschriften der Daten.

5. Was sind die größten Compliance-Risiken beim Web-Scraping?

Die wichtigsten Risiken sind Verstöße gegen ToS, unsachgemäßer Umgang mit personenbezogenen Daten (DSGVO/CCPA) und das Scrapen urheberrechtlich geschützter Inhalte. Prüfe Compliance immer vorab und dokumentiere dein Vorgehen.

Mehr dazu in diesen Ressourcen:

Mehr erfahren