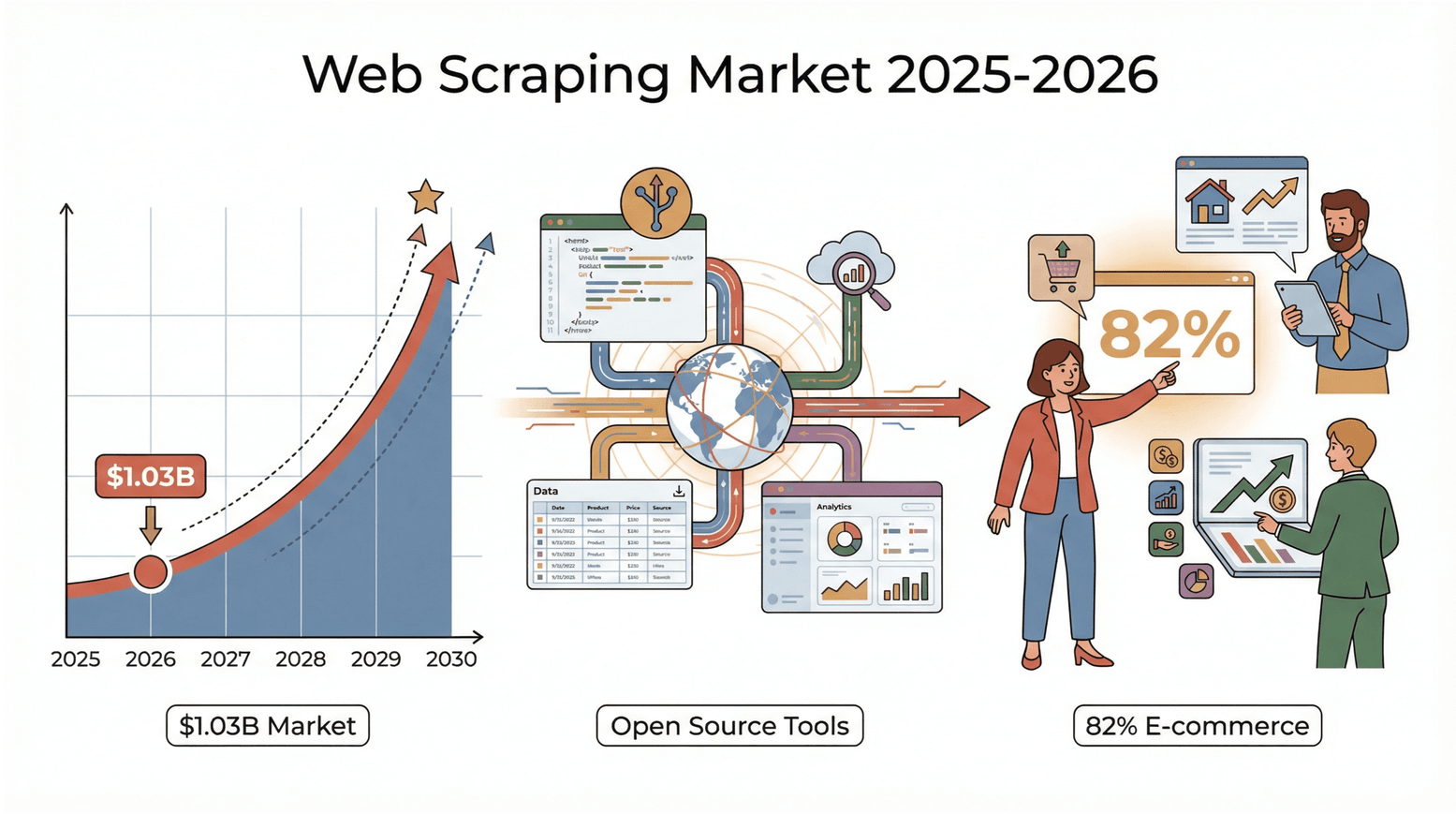

Das Internet ist eine wahre Datenmine – und 2026 ist der Wettlauf, aus diesem riesigen Pool an Infos echte Erkenntnisse zu gewinnen, spannender denn je. Egal, ob du im Vertrieb, E-Commerce, Immobilienbereich unterwegs bist oder einfach ein Daten-Nerd bist: Die Zeiten, in denen man noch mühsam Copy-Paste gemacht hat, sind endgültig vorbei. Ein spannender Fakt: Der globale Markt für Web-Scraping lag und wird sich bis 2030 voraussichtlich verdoppeln. Und es sind längst nicht nur die Tech-Riesen – 82 % der E-Commerce-Unternehmen und mehr als ein Drittel der Investmentfirmen setzen Web-Scraping für Leads, Preisanalysen und Marktforschung ein (). Die Message ist klar: Wer kein Web-Scraping-Tool nutzt, lässt bares Geld und wertvolle Insights liegen.

Die gute Nachricht: Open-Source-Web-Scraping-Tools sind heute so stark, zugänglich und von einer aktiven Community getragen wie nie zuvor. Egal, ob du Python-Profi, JavaScript-Fan oder Business-User bist, der einfach nur Daten braucht – es gibt für jeden das richtige Tool. Nach vielen Jahren in der SaaS- und Automatisierungswelt habe ich das Wachstum dieser Szene hautnah miterlebt. Hier kommen die 5 besten Open-Source-Web-Scraping-Tools, die du 2026 unbedingt ausprobieren solltest – inklusive Tipps, wie du das passende Tool für deine Anforderungen findest.

Warum Open-Source-Web-Scraping-Tools?

Open-Source-Web-Scraping-Tools sind echte Allrounder in der Datenwelt. Sie sind günstig (keine Lizenzkosten), flexibel (du kannst sie anpassen) und transparent (der Code ist offen einsehbar). Das Beste daran ist aber die Community: Tausende Entwickler und User teilen Plugins, Anleitungen und Lösungen – du bist also nie allein ().

Im Vergleich zu kommerziellen Tools hast du mit Open Source die volle Kontrolle: Keine Abhängigkeit von Anbietern, keine versteckten Kosten, und du kannst deine Scraper jederzeit an neue Webseiten anpassen. Viele kommerzielle Scraping-Dienste nutzen übrigens selbst Open-Source-Engines – warum also nicht gleich das Original nehmen?

So haben wir die besten Open-Source-Web-Scraping-Tools ausgewählt

Bei der riesigen Auswahl an Tools habe ich auf folgende Punkte geachtet:

- Benutzerfreundlichkeit: Kommen auch Nicht-Programmierer schnell rein? Gibt’s visuelle oder KI-gestützte Optionen?

- Skalierbarkeit: Ist das Tool für große Projekte geeignet oder eher für Einzelaufgaben?

- Unterstützte Sprachen und Plattformen: Python, JavaScript, browserbasiert, Desktop – für jeden Tech-Stack was dabei.

- Community und Wartung: Wird das Tool aktiv weiterentwickelt? Gibt’s Foren, Dokus und Plugins?

- Besondere Features: KI-Felderkennung, Subpage-Scraping, Zeitplanung, Cloud-Support und mehr.

Außerdem habe ich auf echte Praxiserfahrungen und reale Use Cases geachtet – denn das beste Tool ist das, das dein Problem wirklich löst.

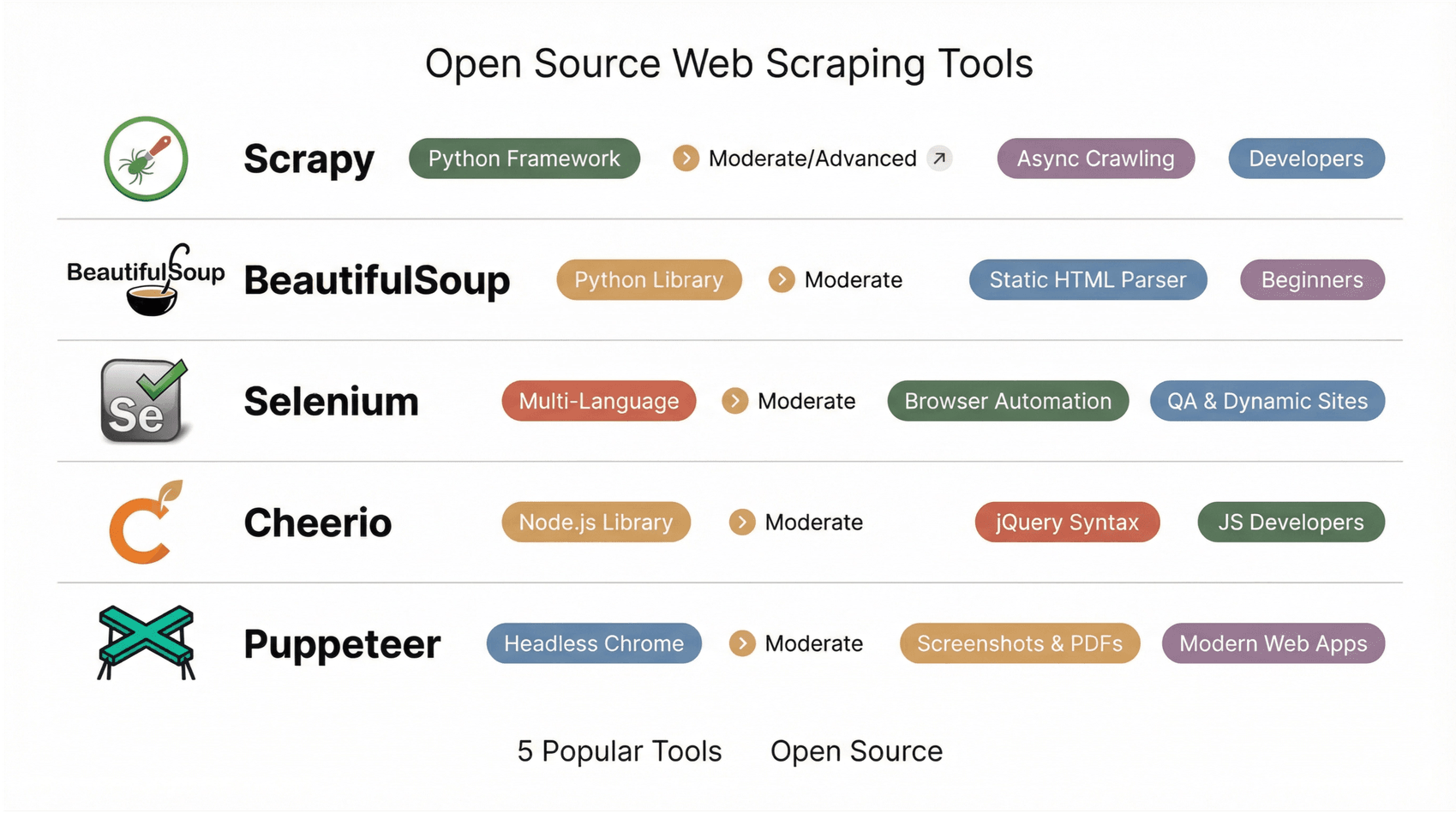

Die Top 5 Open-Source-Web-Scraping-Tools im Überblick

Hier kommt meine Auswahl – von KI-gestützter Einfachheit bis zu Entwickler-Frameworks.

1. Scrapy

ist das Traum-Framework für alle Python-Fans. Es eignet sich perfekt, um skalierbare, anpassbare Crawler und Datenpipelines zu bauen. Dank asynchroner Architektur kann Scrapy tausende oder sogar Millionen Seiten effizient abarbeiten. Du definierst sogenannte „Spiders“ in Python, Scrapy übernimmt das Queue-Management, Drosselung und den Export in JSON, CSV oder XML.

Das Plugin-Ökosystem ist riesig: Es gibt Middleware für Proxies, Cookies und sogar Headless-Browser-Integration für dynamische Seiten. Scrapy ist ideal für große Projekte wie das Crawlen kompletter E-Commerce-Kataloge oder das Sammeln von News. Für Einsteiger ist die Lernkurve steil, aber wer maximale Flexibilität sucht, ist hier goldrichtig ().

2. Beautiful Soup

ist die klassische Python-Bibliothek für schnelles und unkompliziertes HTML-Parsing. Sie ist bei Einsteigern und Profis gleichermaßen beliebt, weil sie auch mit fehlerhaftem HTML super klarkommt. Du lädst eine Seite (meist mit requests), gibst sie an Beautiful Soup weiter und holst dir die gewünschten Elemente mit einfachen Methoden.

Ideal für kleine Projekte, Prototypen und zum Lernen. Der Nachteil: Beautiful Soup kann kein JavaScript ausführen und ist daher nur für statische HTML-Seiten geeignet. Für dynamische Inhalte brauchst du Tools wie Selenium oder requests_html ().

3. Selenium

ist der Klassiker, wenn es um Browser-Automatisierung geht. Ursprünglich für Tests entwickelt, ist es heute ein Favorit für das Scraping dynamischer, JavaScript-lastiger Webseiten. Selenium startet einen echten Browser (z. B. Chrome, Firefox) und simuliert Nutzeraktionen – Klicks, Scrollen, Logins und mehr. Was ein Mensch sieht, kann Selenium extrahieren.

Es unterstützt mehrere Programmiersprachen (Python, Java, JS, C#) und ist besonders praktisch für das Scraping hinter Logins oder bei interaktiven Abläufen. Nachteile: Es ist langsamer und braucht mehr Ressourcen als reine HTTP-Scraper, und das Management der Browser-Treiber kann aufwendig sein. Für komplexe Seiten ist Selenium aber oft die beste Wahl ().

4. Cheerio

ist das jQuery für Node.js. Es ermöglicht das Parsen von HTML auf dem Server mit einer vertrauten jQuery-ähnlichen Syntax. Cheerio ist extrem schnell und ideal für statische Seiten – einfach HTML mit Axios oder Fetch laden, in Cheerio übergeben und mit Selektoren die gewünschten Daten rausziehen.

Cheerio führt kein JavaScript aus und ist daher nur für statische Inhalte geeignet. Es lässt sich aber super mit anderen Node.js-Tools kombinieren und ist bei Entwicklern beliebt, die komplett in JavaScript arbeiten wollen ().

5. Puppeteer

ist eine Node.js-Bibliothek, mit der du Chrome oder Chromium im Headless-Modus steuern kannst. Man kann es sich als den modernen, JavaScript-nativen Cousin von Selenium vorstellen. Puppeteer ist perfekt für das Scraping moderner Web-Apps, Single-Page-Anwendungen und alles, was echtes Browser-Rendering braucht. Du kannst Screenshots machen, PDFs generieren und Netzwerk-Anfragen abfangen – alles mit einer eleganten async/await-API.

Puppeteer richtet sich eher an Entwickler, ist aber für das Scraping von JavaScript-intensiven Seiten unverzichtbar ().

Schnellvergleich: Die besten Open-Source-Web-Scraping-Tools

| Tool | Benutzerfreundlichkeit | Plattform/Sprache | Dynamische Inhalte | Ideal für | Besondere Stärken |

|---|---|---|---|---|---|

| Scrapy | Mittel/Fortgeschrittene (Code) | Python-Framework | Teilweise | Entwickler, Data Scientists | Asynchrones Crawling, Plugins, große Community |

| BeautifulSoup | Mittel (einfacher Code) | Python-Bibliothek | Nein | Einsteiger, schnelles Parsen | Fehlertoleranter Parser, ideal für statisches HTML |

| Selenium | Mittel (Skripting) | Mehrsprachig | Ja | QA, Scraping dynamischer Seiten | Echte Browser-Automatisierung, Logins, Nutzerinteraktionen |

| Cheerio | Mittel (JS-Code) | Node.js-Bibliothek | Nein | JS-Entwickler, statische Seiten | jQuery-Syntax, schnelles HTML-Parsing |

| Puppeteer | Mittel (JS-Code) | Node.js (Headless Chrome) | Ja | Entwickler, moderne Web-Apps | Screenshots, PDFs, SPA-Scraping, async/await-API |

So findest du das passende Open-Source-Web-Scraping-Tool

Hier meine Entscheidungshilfe:

- Technisches Know-how: Keine Programmierkenntnisse? Probier Thunderbit, Octoparse, ParseHub oder WebHarvy. Entwickler? Scrapy, Cheerio, Puppeteer oder Apify.

- Projektumfang: Einzelne oder kleine Aufgaben? Beautiful Soup, Cheerio, WebHarvy. Große oder wiederkehrende Projekte? Scrapy, Apify, Thunderbit (mit Zeitplanung).

- Datentyp: Statisches HTML? Cheerio, Beautiful Soup oder WebHarvy. Dynamische/JS-lastige Seiten? Puppeteer, Selenium, Thunderbit, Octoparse.

- Integration: Export zu Sheets, Notion oder Datenbanken? Thunderbit und Octoparse machen’s easy. APIs oder eigene Pipelines? Scrapy und Apify sind top.

- Community & Support: Schau auf aktive Foren, regelmäßige Updates und viele Anleitungen. Scrapy, Cheerio und Selenium haben große Communities; Thunderbit und Octoparse wachsen rasant und bieten viele Guides.

Teste ein oder zwei Tools an einem kleinen Projekt – so findest du raus, was am besten zu deinem Workflow passt. Und keine Angst vor Kombinationen: Oft ist die schnellste Lösung ein visuelles Tool für den schnellen Einstieg und ein Framework für tiefere Analysen.

Die Bedeutung von Community und Support bei Open-Source-Scraping

Einer der größten Vorteile von Open Source ist die Community. Aktive Foren, GitHub-Repos und Stack Overflow sorgen dafür, dass du nie allein bist. Wenn du auf ein Problem stößt, hat es wahrscheinlich schon jemand gelöst – oder hilft dir weiter. Community-getriebene Tools werden regelmäßig aktualisiert, bekommen neue Features und bieten eine Fülle an Tutorials, Plugins und Best Practices ().

Gerade bei visuellen Tools wie Thunderbit und Octoparse sind Nutzerforen und Template-Sharing wahre Goldgruben. Bei Entwickler-Tools sind GitHub-Issues und Discord/Slack-Gruppen die besten Anlaufstellen. Mit einem Open-Source-Tool wirst du Teil eines globalen Netzwerks von Problemlösern – und das ist unbezahlbar.

Thunderbit: Die einfache No-Code-Web-Scraping-Lösung für alle

Open Source ist super – aber manchmal will man einfach nur schnell und ohne Aufwand an die Daten kommen, ohne selbst einen Scraper zu bauen und zu pflegen. Nicht jedes Scraping-Problem lässt sich mit Open-Source-Code lösen – und genau hier kommt Thunderbit ins Spiel. Wenn du denkst: „Die Tools sind mächtig, aber ich will einfach nur die Daten, ohne mich um Technik zu kümmern“, ist Thunderbit die perfekte Ergänzung.

ist eine KI-gestützte Chrome-Erweiterung, die speziell für Business-User entwickelt wurde, die Ergebnisse statt Infrastruktur wollen. Anstatt Selektoren oder Skripte zu schreiben, klickst du einfach auf KI-Felder vorschlagen. Die KI erkennt die Seitenstruktur, schlägt passende Spalten vor und mit einem weiteren Klick startest du das Scraping. Paginierung, Unterseiten und List-Detail-Workflows werden automatisch erledigt.

Ein großer Vorteil von Thunderbit ist die Brücke zwischen menschlicher Absicht und strukturierten Daten. Du beschreibst einfach, was du brauchst (z. B. „Produktnamen, Preise und Bewertungen sammeln“), und Thunderbit erstellt daraus eine saubere Tabelle. Subpage-Scraping ermöglicht es, automatisch Detailseiten zu besuchen und umfangreichere Daten zu extrahieren. Der Export zu Excel, Google Sheets, Notion und Airtable ist integriert – deine Daten sind sofort einsatzbereit.

Thunderbit ist besonders beliebt bei Vertriebs-, Marketing-, E-Commerce- und Immobilienteams, die zuverlässige Daten brauchen, aber keine Open-Source-Pipelines pflegen möchten. Es unterstützt viele Sprachen, funktioniert auch auf dynamischen Seiten und bietet eine großzügige kostenlose Einstiegsversion. Zwar ist es nicht Open Source, ergänzt aber Open-Source-Tools ideal – perfekt, um Ideen schnell zu testen oder wiederkehrende Aufgaben ohne Entwicklungsaufwand zu erledigen.

Fazit: Mit den besten Open-Source-Tools Webdaten erschließen

Web-Scraping ist längst nicht mehr nur was für Entwickler oder große Unternehmen. Mit den heutigen Open-Source-Tools kann jeder das Web in strukturierte, nutzbare Daten verwandeln – egal, ob du eine Lead-Liste erstellen, Preise überwachen oder dein nächstes KI-Projekt mit Daten füttern willst. Entscheidend ist, das passende Tool für deine Anforderungen zu wählen: KI-gestützte und visuelle Tools für Schnelligkeit und Einfachheit, Code-Frameworks für maximale Power und Skalierbarkeit.

Was jetzt? Such dir ein Tool aus dieser Liste, probier es an einer echten Aufgabe aus und erlebe, wie viel Zeit und Aufwand du sparst. Und wenn du schnellen Erfolg willst, und sieh selbst, wie einfach Web-Scraping sein kann. Das Web ist voller Daten – schnapp dir deine Schätze!

Mehr Anleitungen und Tipps findest du im . Viel Spaß beim Scrapen!

Häufige Fragen (FAQ)

1. Was ist der Hauptvorteil von Open-Source-Web-Scraping-Tools gegenüber kommerziellen Lösungen?

Open-Source-Tools sind günstig, flexibel und profitieren von aktiven Communities. Du kannst sie individuell anpassen, bist unabhängig und profitierst von gemeinsamem Wissen und regelmäßigen Updates.

2. Welches Open-Source-Tool eignet sich am besten für nicht-technische Business-Anwender?

Thunderbit, Octoparse, ParseHub und WebHarvy sind alle super für Nicht-Programmierer. Thunderbit punktet besonders mit dem KI-gestützten Zwei-Klick-Workflow und direktem Export.

3. Können Open-Source-Tools auch dynamische, JavaScript-lastige Webseiten scrapen?

Klar! Tools wie Thunderbit, Selenium, Puppeteer, Octoparse und ParseHub können dynamische Inhalte extrahieren, indem sie Seiten in einem echten oder Headless-Browser rendern.

4. Woran erkenne ich, ob ein Tool aktiv gepflegt und unterstützt wird?

Schau auf GitHub nach aktuellen Commits, offenen Issues und Beiträgen. Achte auf aktive Foren, aktuelle Blogposts und viele von Nutzern beigesteuerte Plugins oder Vorlagen.

5. Wie starte ich am besten mit Web-Scraping, wenn ich Einsteiger bin?

Starte mit einem visuellen oder KI-gestützten Tool wie Thunderbit oder Octoparse. Scrape einen kleinen Datensatz, exportiere ihn nach Excel oder Sheets und probier dich aus. Mit mehr Erfahrung kannst du auch Code-basierte Tools für komplexere Projekte nutzen.

Willst du Thunderbit in Aktion sehen? und werde Teil von über 30.000 Nutzern, die das Web ohne Programmieraufwand in Daten verwandeln.

Mehr erfahren