Stell dir vor: Es ist 2025. Das Netz ist riesiger, unübersichtlicher und voller Möglichkeiten als je zuvor. Aber es gibt einen Haken – mittlerweile stammt fast die Hälfte des gesamten Traffics von Bots, nicht von echten Menschen. Viele davon sind Unternehmen, die Daten sammeln, um sich einen Vorsprung zu sichern. Nach Jahren in der SaaS- und Automatisierungswelt kann ich sagen: Die Zeiten, in denen man Links noch mühsam per Hand kopiert hat, sind endgültig vorbei. Wer heute keinen Link Extractor oder URL extractor nutzt, arbeitet mit stumpfen Werkzeugen.

Wie findet man also das richtige Tool, um Links, URLs und Daten effizient und in großem Stil zu extrahieren – ohne dabei den Verstand oder das Wochenende zu verlieren? Ich habe die 12 besten Link Extractor für 2025 getestet – von KI-basierten No-Code-Lösungen bis hin zu Entwickler-Favoriten. Egal ob Vertrieb, Marketing oder Datenanalyse: Hier ist für jeden was dabei. Und ich zeige, warum (das Tool, das mein Team und ich entwickelt haben) für Unternehmen, die clever statt hart scrapen wollen, ganz vorne mitspielt.

Warum braucht man 2025 einen Link Extractor oder URL Extractor?

Fakt ist: Das Web platzt vor Daten, und Unternehmen versuchen, aus diesem Chaos brauchbare Erkenntnisse zu ziehen. und sind heute unverzichtbar für Teams, die:

- Leads generieren: Vertriebsteams können in wenigen Minuten Firmenprofile aus Verzeichnissen oder LinkedIn extrahieren und diese URLs direkt für die Kontaktsuche nutzen. Schluss mit endlosem Geklicke.

- Content sammeln & SEO pushen: Marketer erfassen alle Artikel-URLs eines Blogs, überwachen Backlinks der Konkurrenz oder checken Websites auf fehlerhafte Links.

- Wettbewerber beobachten & Marktforschung betreiben: Operations-Teams sammeln automatisch Links zu neuen Produkten, Preislisten oder Pressemitteilungen – und behalten so die Konkurrenz locker im Blick.

- Abläufe automatisieren & Zeit sparen: Moderne Link-Scraper verarbeiten riesige Mengen an URLs, durchsuchen Unterseiten und exportieren die Daten direkt in strukturierte Formate (CSV, Excel, Google Sheets, Notion usw.). Manuelles Kopieren und das Aufräumen chaotischer Textdateien war gestern.

Angesichts der Tatsache, dass , ist Handarbeit keine Option mehr. Der richtige Link Extractor ist wie ein digitaler Assistent, der nie müde wird, keinen Link übersieht und nie eine Pause braucht.

So haben wir die besten Link Extractor ausgewählt

Bei der Masse an Tools fühlt sich die Auswahl schnell wie Speed-Dating auf einer Tech-Messe an – alle versprechen das Blaue vom Himmel, aber nur wenige halten es. Nach diesen Kriterien habe ich die Top 12 ausgewählt:

- Benutzerfreundlichkeit: Können auch Nicht-Programmierer das Tool ohne Spezialwissen nutzen? No-Code- und Low-Code-Lösungen haben Pluspunkte bekommen.

- Massen- & Mehrstufiges Scraping: Kann das Tool hunderte URLs auf einmal verarbeiten? Werden Unterseiten automatisch durchsucht?

- Export & Integration: Lassen sich die Daten direkt nach CSV, Excel, Google Sheets, Notion, Airtable oder per API exportieren? Je weniger Handarbeit, desto besser.

- Zielgruppe & Flexibilität: Ist das Tool für Business-Anwender, Analysten oder Entwickler gedacht? Manche sind universell, andere eher spezialisiert.

- Erweiterte Funktionen: KI-gestützte Erkennung, Zeitplanung, Cloud-Skalierung, Datenbereinigung und Vorlagen für gängige Websites.

- Preis & Skalierbarkeit: Gibt es kostenlose Stufen, Pay-as-you-go oder Enterprise-Angebote? Ich habe geprüft, was man fürs Geld bekommt.

Von Browser-Erweiterungen bis zu Enterprise-Plattformen ist alles dabei – egal ob Einzelunternehmer oder Daten-Team im Großkonzern, hier findet jeder das passende Tool.

Thunderbit: Der cleverste Link Extractor für Unternehmen

Starten wir mit dem Spitzenreiter. ist meine klare Empfehlung für Link-Extraktion im Jahr 2025 – und das nicht nur, weil ich an der Entwicklung beteiligt war. Thunderbit ist eine , die speziell für Business-Anwender entwickelt wurde, die schnell Ergebnisse wollen.

Was macht Thunderbit besonders? Es ist wie ein KI-Praktikant, der wirklich versteht, was du willst. Du beschreibst einfach in Alltagssprache, was extrahiert werden soll („Alle Produktlinks und Preise von dieser Seite holen“), und Thunderbit erledigt den Rest. Kein Herumprobieren mit Selektoren oder Scripten.

Aber das ist noch nicht alles:

- Massen-URL-Unterstützung: Egal ob eine einzelne URL oder eine Liste mit hunderten – Thunderbit verarbeitet alles in einem Rutsch.

- Navigation auf Unterseiten: Du willst Links von einer Übersichtsseite extrahieren und dann auf jede Detailseite gehen, um weitere URLs zu sammeln? Thunderbits mehrstufige Scraping-Logik macht’s möglich.

- Strukturierter Export: Nach der Extraktion kannst du Felder umbenennen, kategorisieren und die Daten direkt nach Google Sheets, Notion, Airtable, Excel oder CSV exportieren. Nachbearbeitung entfällt.

Thunderbit wird weltweit von über 30.000 Nutzern eingesetzt – von Vertriebsteams über Immobilienmakler bis zu kleinen Online-Shops. Und ja, es gibt eine (bis zu 6 Seiten, mit Test-Boost bis zu 10), sodass du risikofrei starten kannst.

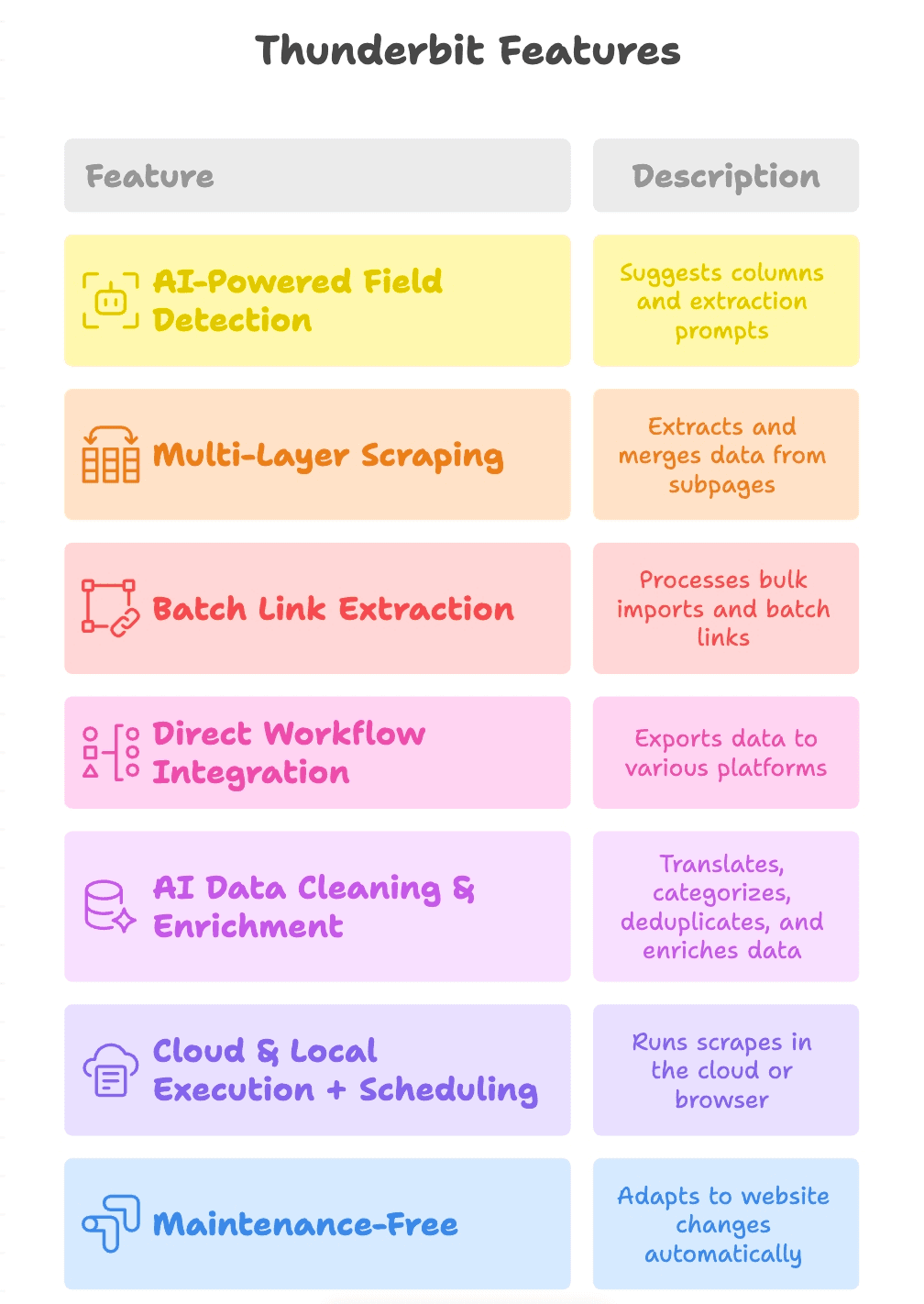

Thunderbits besondere Funktionen

Was hebt Thunderbit wirklich ab?

- KI-gestützte Felderkennung: Mit „AI Suggest Fields“ liest Thunderbit die Seite, schlägt passende Spalten vor (z. B. „Produktlink“, „PDF-URL“, „Kontakt-E-Mail“) und erstellt Extraktions-Prompts für jedes Feld.

- Mehrstufiges Scraping: Thunderbit folgt Links von der Hauptseite zu Unterseiten (z. B. Produktdetails oder PDF-Downloads), extrahiert weitere Links und führt alles in einer Tabelle zusammen.

- Batch-Link-Extraktion: Egal ob eine oder tausend Seiten – Thunderbit verarbeitet Massenimporte und Batch-Extraktion mühelos.

- Direkte Workflow-Integration: Ergebnisse können direkt nach Google Sheets, Notion, Airtable exportiert oder als CSV/Excel heruntergeladen werden. Die Daten landen dort, wo dein Team sie braucht.

- KI-Datenbereinigung & Anreicherung: Thunderbit kann Daten beim Scraping übersetzen, kategorisieren, deduplizieren und sogar anreichern – so sind die Ergebnisse sofort einsatzbereit.

- Cloud- & lokale Ausführung + Zeitplanung: Scrapes laufen entweder in der Cloud (schnell) oder im Browser (z. B. für Login-Seiten). Wiederkehrende Aufgaben lassen sich planen.

- Wartungsfrei: Thunderbits KI passt sich Website-Änderungen an, sodass du weniger Zeit mit Reparaturen und mehr mit Ergebnissen verbringst.

Octoparse: No-Code Link Scraper für alle

ist ein Klassiker unter den No-Code-Scrapern. Die Desktop-App (Windows/Mac) bietet eine visuelle Point-and-Click-Oberfläche. Einfach Webseite laden, gewünschte Links anklicken – Octoparse erledigt den Rest.

- Ideal für Einsteiger: Keine Programmierkenntnisse nötig. Klicken, extrahieren, fertig.

- Verarbeitet Paginierung & dynamische Inhalte: Octoparse kann „Weiter“-Buttons klicken, scrollen und sich sogar einloggen.

- Cloud-Scraping & Zeitplanung: Mit kostenpflichtigen Plänen lassen sich Aufgaben in der Cloud ausführen und planen.

- Exportoptionen: Daten als CSV, Excel, JSON herunterladen oder in Datenbanken übertragen.

Das kostenlose Paket reicht für kleine Projekte (bis zu 10 Aufgaben und 50.000 Zeilen/Monat). Für größere Anforderungen startet der Preis bei ca. 75 $/Monat.

Apify: Flexibler URL Extractor für individuelle Workflows

ist das Schweizer Taschenmesser fürs Web Scraping. Es gibt einen Marktplatz mit vorgefertigten „Actors“ (Scraping-Tools) und die Möglichkeit, eigene Skripte in JavaScript oder Python zu schreiben.

- Vorgefertigt & anpassbar: Community-Actors für Standardaufgaben oder eigene Workflows programmieren.

- Massen- & geplantes Scraping: URLs in Warteschlangen abarbeiten, Jobs parallel ausführen und regelmäßig scrapen.

- API-First: Export nach JSON, CSV, Excel oder Google Sheets und Integration in Datenpipelines.

- Pay-as-you-go: Monatliche Gratis-Credits, danach nutzungsbasierte Abrechnung.

Ideal für technisch versierte Teams und Entwickler, die Flexibilität und Skalierbarkeit brauchen.

Bright Data URL Scraper: Link Scraping in Enterprise-Dimensionen

richtet sich an Unternehmen, die in großem Stil scrapen. Der Data Collector bietet einen vorkonfigurierten URL Scraper für große Datenmengen.

- Extrem skalierbar: Tausende oder Millionen Seiten scrapen, mit robusten Proxys gegen Blockaden.

- Vorgefertigte Templates: Scraper für E-Commerce, Social Media, Immobilien und mehr.

- Enterprise-Features: Compliance-Tools, Experten-Support und fortschrittliche Anti-Blocking-Technologien.

- Preis: Ab ca. 350 $ für 100.000 Seiten – klar auf große Unternehmen ausgerichtet.

Für Startups meist zu umfangreich, aber für kritische, großvolumige Scraping-Projekte eine Top-Lösung.

WebHarvy: Visueller Link Extractor mit Klick-Komfort

ist eine Desktop-App (Windows), mit der du Links einfach per Klick im integrierten Browser extrahieren kannst.

- Extrem einfach: Link anklicken, WebHarvy markiert alle ähnlichen Elemente zur Extraktion.

- Reguläre Ausdrücke: Vorlagen für gängige Aufgaben, keine Programmierung nötig.

- Export nach Excel, CSV, JSON, XML, SQL: Perfekt für Business-Anwender, die Daten in bekannten Formaten brauchen.

- Einmalige Lizenz: Einmal zahlen, dauerhaft nutzen.

Ideal für kleine Unternehmen, Forscher oder alle, die ohne Programmierung schnell Links extrahieren möchten.

Web Scraper (Chrome Extension): Schnelles Link Scraping im Browser

Die ist ein kostenloses Open-Source-Tool, das deinen Browser in einen Scraper verwandelt.

- Sitemaps definieren: Vorgeben, wie navigiert und was extrahiert werden soll.

- Paginierung & mehrstufiges Crawling: Kategorien, Unterkategorien und Detailseiten durchsuchen.

- Export nach CSV/XLSX: Daten direkt aus dem Browser herunterladen.

- Community-Vorlagen: Viele geteilte Sitemaps für bekannte Websites.

Ideal für schnelle Einzelaufgaben oder für Studierende und kleine Teams mit begrenztem Budget.

ScraperAPI: Skalierbarer Link Scraper für Entwickler

richtet sich an Entwickler, die Webseiten in großem Stil abrufen wollen, ohne sich um Proxys, Blockaden oder CAPTCHAs zu kümmern.

- API-basiert: URL senden, HTML oder extrahierte Daten zurückbekommen.

- Skalierbar & Anti-Bot: Proxy-Rotation, JS-Rendering und CAPTCHA-Lösung inklusive.

- Integration in eigenen Code: Mit Python, Node.js oder jeder anderen Sprache nutzbar.

- Preis: Kostenloses Kontingent (~1000 API-Calls), danach Bezahlung pro Anfrage.

Ideal für individuelle Crawler oder wenn Zuverlässigkeit und Geschwindigkeit gefragt sind.

ParseHub: Visueller Link Scraper mit fortschrittlicher Auswahl

ist eine Desktop-App (Windows, Mac, Linux), mit der du Scraping-Projekte visuell zusammenstellen kannst.

- Erweiterte Auswahl & Navigation: Klicken, Schleifen, bedingte Extraktion – auch bei dynamischen oder versteckten Elementen.

- Verschachtelte Seiten: Kategorien crawlen, dann Detailseiten, dann weitere Links extrahieren.

- Export nach CSV, Excel, JSON: Cloud-Ausführung und API-Zugang in kostenpflichtigen Plänen.

- Kostenlos: 5 Projekte, bis zu 200 Seiten pro Durchlauf.

ParseHub ist besonders bei Marketern und Forschern beliebt, die ohne Code viel erreichen wollen.

Scrapy: Python Link Extractor für Entwickler

ist der Goldstandard für Python-Entwickler, die maximale Kontrolle wollen.

- Code-basiert: Eigene Spider für beliebig große Crawls und Link-Extraktion programmieren.

- Verteiltes Crawling: Effizient, asynchron und hochgradig anpassbar.

- Export nach CSV, JSON, XML oder Datenbank: Du bestimmst das Ausgabeformat.

- Open-Source & kostenlos: Die Umgebung muss man allerdings selbst verwalten.

Wer sich mit Python auskennt, bekommt mit Scrapy maximale Power.

Diffbot: KI-basierter Link Scraper für strukturierte Daten

ist das „KI-Gehirn“ unter den Web-Scrapern. Es analysiert Seiten und liefert strukturierte Daten – inklusive Links – ganz ohne manuelle Einrichtung.

- Automatische Inhaltserkennung: URL eingeben, strukturierte Daten (Artikel, Produkte, Links etc.) erhalten.

- Crawlbot & Knowledge Graph: Ganze Websites crawlen oder die riesige Web-Datenbank abfragen.

- API-basiert: Integration in BI-Tools oder Datenpipelines.

- Enterprise-Preise: Ab ca. 299 $/Monat, aber dafür gibt’s Top-Qualität.

Ideal für Unternehmen, die saubere, strukturierte Daten ohne eigenen Scraper wollen.

Cheerio: Leichter Link Scraper für Node.js

ist ein schneller, jQuery-ähnlicher HTML-Parser für Node.js.

- Extrem schnell: Parst HTML in Millisekunden.

- Vertraute Syntax: Wer jQuery kennt, kommt sofort zurecht.

- Ideal für statische Seiten: Kein JS-Rendering, aber perfekt für serverseitige Inhalte.

- Open-Source & kostenlos: Mit axios oder fetch für Requests kombinierbar.

Optimal für Entwickler, die eigene Skripte mit Fokus auf Geschwindigkeit und Einfachheit bauen.

Puppeteer: Browser-Automatisierung für anspruchsvolles Link Scraping

ist eine Node.js-Bibliothek zur Steuerung von Chrome im Headless-Modus.

- Vollständige Browser-Automatisierung: Seiten laden, klicken, scrollen, wie ein echter Nutzer interagieren.

- Dynamische Inhalte & Logins: Perfekt für JS-lastige Seiten oder komplexe Abläufe.

- Feinsteuerung: Auf Elemente warten, Screenshots machen, Netzwerk-Anfragen abfangen.

- Open-Source & kostenlos: Allerdings ressourcenintensiv und langsamer als leichte Tools.

Puppeteer ist ideal, wenn einfache Scraper an ihre Grenzen stoßen.

Vergleich auf einen Blick: Welcher Link Extractor passt zu dir?

Hier ein schneller Überblick über alle 12 Tools:

| Tool | Ideal für | Massen- & Unterseiten-Support | Datenexport | Preis |

|---|---|---|---|---|

| Thunderbit | No-Coder, Business | Ja (KI, mehrstufig) | Excel, CSV, Sheets, Notion, Airtable | Gratis-Test, ab ca. 9 €/Monat |

| Octoparse | No-Code, Analysten | Ja | CSV, Excel, JSON, Cloud | Gratis, ca. 75 €/Monat |

| Apify | Semi-Tech, Devs | Ja | CSV, JSON, Sheets via API | Gratis-Credits, nutzungsbasiert |

| Bright Data | Enterprise | Ja (hohes Volumen) | CSV, JSON, NDJSON via API | ca. 350 $/100k Seiten |

| WebHarvy | No-Coder, Desktop | Ja | Excel, CSV, JSON, XML, SQL | Einmalige Lizenz |

| Web Scraper Extension | Jeder, schnell/kostenlos | Ja | CSV, XLSX | Kostenlos, Open-Source |

| ScraperAPI | Entwickler, API | Ja | JSON (HTML via API) | 1k gratis, dann bezahlt |

| ParseHub | No-Coder, Fortgeschrittene | Ja | CSV, Excel, JSON, API | 5 Projekte gratis, bezahlt |

| Scrapy | Devs, Python | Ja | CSV, JSON, XML, DB | Kostenlos, Open-Source |

| Diffbot | Enterprise, KI | Ja (KI-Crawl) | JSON (strukturierte Daten via API) | ab ca. 299 $/Monat |

| Cheerio | Devs, Node.js | Ja (eigener Code) | Custom (JSON etc.) | Kostenlos, Open-Source |

| Puppeteer | Devs, komplexe Seiten | Ja (vollautomatisch) | Custom (Skriptausgabe) | Kostenlos, Open-Source |

Welcher Link Scraper passt zu deinem Unternehmen?

Wie entscheiden? Hier meine Kurzempfehlung:

- Keine Programmierkenntnisse? Starte mit Thunderbit, Octoparse, ParseHub, WebHarvy oder der Web Scraper Extension.

- Individuelle Workflows nötig? Apify, ScraperAPI oder Cheerio sind ideal für Entwickler.

- Enterprise-Anspruch? Bright Data oder Diffbot sind für große Datenmengen gemacht.

- Python- oder Node.js-Entwickler? Scrapy (Python) oder Cheerio/Puppeteer (Node.js) bieten volle Kontrolle.

- Direkter Export zu Sheets/Notion? Thunderbit ist hier unschlagbar.

Wähle das Tool passend zu deinen technischen Fähigkeiten, dem Datenvolumen und den Integrationswünschen. Die meisten bieten kostenlose Tests – probiere ruhig mehrere aus.

Thunderbits Mehrwert für Link-Extraktion 2025

Was macht Thunderbit wirklich einzigartig?

- KI-gestützte Einfachheit: Beschreibe dein Ziel in Alltagssprache – Thunderbits KI übernimmt den Rest.

- Mehrstufiges Scraping: Links von Hauptseiten extrahieren, Unterseiten folgen und weitere URLs sammeln – alles in einem Durchlauf.

- Massenimport & Batch-Verarbeitung: Hunderte URLs einfügen, Links in großen Mengen extrahieren und strukturierte Daten sofort exportieren.

- Workflow-Integration: Export direkt nach Google Sheets, Notion, Airtable oder als CSV/Excel.

- Wartungsfrei: Thunderbits KI passt sich Website-Änderungen an – du musst keine kaputten Scraper mehr reparieren.

Thunderbit schließt die Lücke zwischen „nur Daten sammeln“ und „Daten, die du wirklich nutzen kannst“. Genau so ein Tool hätte ich mir früher gewünscht, als ich noch stundenlang manuell Daten extrahieren musste.

Fazit: Links clever extrahieren und Workflows beschleunigen

2025 sind Webdaten der Treibstoff für Unternehmenserfolg – und der richtige Link Extractor ist dein Motor. Egal ob du Leadlisten aufbaust, Wettbewerber beobachtest oder Recherchen automatisierst: Hier findest du das passende Tool für deine Anforderungen und dein Know-how.

Wenn du sehen möchtest, wie moderne Link-Extraktion funktioniert, . Du wirst überrascht sein, wie viel du mit wenigen Klicks erreichen kannst. Und falls Thunderbit nicht perfekt passt, probiere ruhig weitere Tools aus – es war nie einfacher, langweilige Aufgaben zu automatisieren und sich auf das Wesentliche zu konzentrieren.

Viel Erfolg beim Scrapen – und mögen deine Links immer sauber, strukturiert und einsatzbereit sein. Für mehr Tipps und Anleitungen rund ums Web Scraping schau im vorbei.

Häufige Fragen

1. Warum sind Link Extractor 2025 unverzichtbar?

Da fast die Hälfte des Internet-Traffics von Bots stammt und Unternehmen gezielt Daten scrapen, sind Link Extractor entscheidend, um aus dem Datenchaos brauchbare Erkenntnisse zu gewinnen. Sie automatisieren Aufgaben wie Lead-Generierung, Content-Sammlung, SEO-Audits und Wettbewerbsbeobachtung – und sparen enorm viel Zeit und Aufwand.

2. Was macht Thunderbit unter den Link Extractor besonders?

Thunderbit setzt auf KI, um das Scraping zu vereinfachen: Ziel einfach in Alltagssprache beschreiben, den Rest übernimmt das Tool. Es unterstützt Massen-URLs, mehrstufiges Scraping, intelligente Felderkennung und den nahtlosen Export zu Plattformen wie Google Sheets und Notion. Ideal für Business-Anwender ohne Programmierkenntnisse, die starke Ergebnisse wollen.

3. Gibt es Link Extractor für Entwickler und individuelle Workflows?

Ja. Tools wie Apify, ScraperAPI, Cheerio, Puppeteer und Scrapy richten sich an Entwickler. Sie bieten Scripting, API-Integration und maximale Flexibilität für komplexe Scraping-Aufgaben, große Datenmengen und fortgeschrittene Automatisierung.

4. Welche Tools eignen sich für Nutzer ohne Programmierkenntnisse?

Thunderbit, Octoparse, ParseHub, WebHarvy und die Web Scraper Chrome Extension sind Top-Empfehlungen für Nicht-Techniker. Sie bieten visuelle Oberflächen, Vorlagen und KI-Features, die Link-Extraktion für jeden zugänglich machen.

5. Wie finde ich den passenden Link Extractor für meine Anforderungen?

Überlege, wie technisch du bist, wie viele Daten du brauchst und wohin du exportieren möchtest. Für Nicht-Programmierer sind Thunderbit oder Octoparse ideal, Entwickler greifen zu Scrapy oder Puppeteer. Für große Unternehmen sind Bright Data oder Diffbot die richtige Wahl. Teste am besten mehrere Tools kostenlos, um das optimale Setup zu finden.