Eins steht fest: Web-Scraping ist 2025 spannender als je zuvor. Nach etlichen Jahren in der SaaS- und Automatisierungsbranche bin ich immer wieder überrascht, wie viele Daten im Netz nur darauf warten, genutzt zu werden. Egal ob du im E-Commerce, Vertrieb, Immobilienbereich unterwegs bist oder einfach Daten liebst – Web-Scraping ist längst vom Geheimtipp zum Must-have-Skill geworden. Der Markt für Web-Scraping-Software lag . Das heißt: Daten ohne Ende und jede Menge Möglichkeiten.

Aber Achtung: Die beste Programmiersprache für Web-Scraping entscheidet oft darüber, ob du schnell ans Ziel kommst oder im Frust landest. Mit der richtigen Sprache läuft alles reibungslos, wartungsarm und entspannt. Die falsche Wahl? Ich habe schon einige Entwickler erlebt, die nach stundenlangem Kampf mit einem widerspenstigen Scraper entnervt aufgegeben haben. In diesem Guide zeige ich dir die sieben besten Programmiersprachen für Web-Scraping 2025 – mit Codebeispielen, Praxistipps und ehrlichen Erfahrungswerten. Und falls dir das Programmieren zu viel ist: Am Ende erfährst du, wie (unser No-Code KI-Web-Scraper) dir die Arbeit komplett abnimmt.

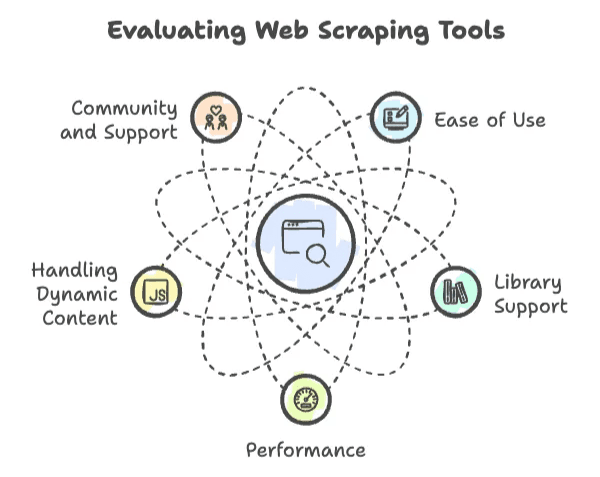

So haben wir die beste Sprache für Web-Scraping ausgewählt

Nicht jede Sprache eignet sich gleich gut fürs Web-Scraping. Ich habe Projekte an Kleinigkeiten scheitern oder durchstarten sehen – entscheidend sind vor allem diese Punkte:

- Benutzerfreundlichkeit: Wie schnell kannst du loslegen? Ist die Syntax verständlich oder brauchst du ein Informatikstudium, um „Hello, World“ zu schreiben?

- Bibliotheken: Gibt es ausgereifte Libraries für HTTP-Requests, HTML-Parsing und dynamische Inhalte? Oder musst du alles selbst bauen?

- Performance: Schafft die Sprache Millionen von Seiten oder geht ihr nach ein paar Hundert die Luft aus?

- Umgang mit dynamischen Inhalten: Moderne Webseiten setzen auf JavaScript. Kommt deine Sprache damit klar?

- Community & Support: Gibt es Hilfe, wenn du mal nicht weiterkommst?

Nach diesen Kriterien – und etlichen Nachtschichten – stelle ich dir diese sieben Sprachen vor:

- Python: Der Alleskönner für Einsteiger und Profis.

- JavaScript & Node.js: Die Top-Wahl für dynamische Inhalte.

- Ruby: Klare Syntax, schnelle Skripte.

- PHP: Einfach auf dem Server einsetzbar.

- C++: Wenn es auf maximale Geschwindigkeit ankommt.

- Java: Für große, skalierbare Projekte.

- Go (Golang): Schnell und parallelisiert.

Und falls du denkst: „Ich will gar nicht programmieren!“, dann bleib bis zum Thunderbit-Tipp am Ende dran.

Python Web-Scraping: Der Einsteigerfreundliche Alleskönner

Starten wir mit dem Favoriten: Python. Frag eine Gruppe von Datenfans nach der besten Sprache fürs Web-Scraping – du hörst garantiert „Python“ im Chor.

Warum Python?

- Einfache Syntax: Python liest sich fast wie Englisch.

- Unschlagbare Bibliotheken: Von fürs HTML-Parsing über für große Crawls, für HTTP bis für Browser-Automatisierung – alles ist da.

- Riesige Community: Über nur zum Thema Web-Scraping.

Beispiel: Python-Code zum Auslesen des Seitentitels

1import requests

2from bs4 import BeautifulSoup

3response = requests.get("<https://example.com>")

4soup = BeautifulSoup(response.text, 'html.parser')

5title = soup.title.string

6print(f"Page title: {title}")Stärken:

- Schnelle Entwicklung und Prototyping.

- Unzählige Tutorials und Hilfestellungen.

- Perfekt für Datenanalyse – Scraping mit Python, Auswertung mit pandas, Visualisierung mit matplotlib.

Schwächen:

- Für riesige Datenmengen langsamer als kompilierte Sprachen.

- Sehr dynamische Seiten können knifflig sein (Selenium und Playwright helfen aber).

- Nicht optimal für Millionen von Seiten in Höchstgeschwindigkeit.

Fazit:

Wer neu einsteigt oder schnell Ergebnisse will, ist mit Python beim Web-Scraping bestens beraten. .

JavaScript & Node.js: Dynamische Webseiten mühelos scrapen

Wenn Python das Schweizer Taschenmesser ist, dann ist JavaScript (und Node.js) der Akkuschrauber – vor allem für moderne, JavaScript-lastige Seiten.

Warum JavaScript/Node.js?

- Ideal für dynamische Inhalte: Läuft direkt im Browser und sieht, was der Nutzer sieht – auch bei React, Angular oder Vue.

- Standardmäßig asynchron: Node.js kann hunderte Anfragen gleichzeitig abarbeiten.

- Webentwickler kennen es bereits: Wer Webseiten baut, kennt JavaScript.

Wichtige Libraries:

- : Headless Chrome Automatisierung.

- : Multi-Browser-Automatisierung.

- : jQuery-ähnliches HTML-Parsing für Node.

Beispiel: Node.js-Code für den Seitentitel mit Puppeteer

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch();

4 const page = await browser.newPage();

5 await page.goto('<https://example.com>', { waitUntil: 'networkidle2' });

6 const title = await page.title();

7 console.log(`Page title: ${title}`);

8 await browser.close();

9})();Stärken:

- Kann JavaScript-gerenderte Inhalte nativ verarbeiten.

- Perfekt für Infinite Scroll, Pop-ups und interaktive Seiten.

- Effizient für große, parallele Scraping-Projekte.

Schwächen:

- Asynchrone Programmierung ist für Einsteiger gewöhnungsbedürftig.

- Headless-Browser brauchen viel RAM, wenn viele parallel laufen.

- Weniger Tools für Datenanalyse als Python.

Wann ist JavaScript/Node.js die beste Wahl fürs Web-Scraping?

Wenn du dynamische Seiten scrapen oder Browseraktionen automatisieren willst. .

Ruby: Klare Syntax für schnelle Web-Scraping-Skripte

Ruby ist nicht nur für Rails-Apps und eleganten Code bekannt. Auch fürs Web-Scraping ist es eine gute Wahl – vor allem, wenn du Wert auf lesbaren Code legst.

Warum Ruby?

- Lesbare, ausdrucksstarke Syntax: Ein Ruby-Scraper liest sich fast wie eine Einkaufsliste.

- Ideal für Prototypen: Schnell geschrieben, leicht anpassbar.

- Wichtige Libraries: fürs Parsing, für Navigation.

Beispiel: Ruby-Code für den Seitentitel

1require 'open-uri'

2require 'nokogiri'

3html = URI.open("<https://example.com>")

4doc = Nokogiri::HTML(html)

5title = doc.at('title').text

6puts "Page title: #{title}"Stärken:

- Sehr lesbar und kompakt.

- Perfekt für kleine Projekte, Einmalskripte oder wenn du Ruby ohnehin nutzt.

Schwächen:

- Für große Projekte langsamer als Python oder Node.js.

- Weniger Scraping-Bibliotheken und kleinere Community.

- Nicht ideal für JavaScript-lastige Seiten (Watir oder Selenium helfen).

Wann passt Ruby?

Wenn du Ruby magst oder schnell ein Skript brauchst, macht Ruby Spaß. Für große, dynamische Projekte gibt es bessere Alternativen.

PHP: Serverseitige Einfachheit für Web-Datenextraktion

PHP wirkt manchmal wie ein Relikt aus den Anfangstagen des Webs, ist aber immer noch weit verbreitet – besonders, wenn du direkt auf dem Server scrapen willst.

Warum PHP?

- Läuft überall: Die meisten Webserver unterstützen PHP von Haus aus.

- Leicht in Web-Apps integrierbar: Scraping und Anzeige auf der eigenen Seite in einem Schritt.

- Wichtige Libraries: für HTTP, für Requests, für Headless-Browser.

Beispiel: PHP-Code für den Seitentitel

1<?php

2$ch = curl_init("<https://example.com>");

3curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

4$html = curl_exec($ch);

5curl_close($ch);

6$dom = new DOMDocument();

7@$dom->loadHTML($html);

8$title = $dom->getElementsByTagName("title")->item(0)->nodeValue;

9echo "Page title: $title\n";

10?>Stärken:

- Einfach auf Webservern einsetzbar.

- Gut für Scraping als Teil eines Web-Workflows.

- Schnell für einfache, serverseitige Aufgaben.

Schwächen:

- Begrenzte Bibliotheken für komplexes Scraping.

- Nicht für hohe Parallelität oder große Datenmengen ausgelegt.

- JavaScript-lastige Seiten sind schwierig (Panther hilft).

Wann passt PHP?

Wenn du ohnehin mit PHP arbeitest oder Daten direkt auf deiner Website anzeigen willst, ist PHP praktisch. .

C++: High-Performance Web-Scraping für große Projekte

C++ ist der Sportwagen unter den Programmiersprachen. Wenn du maximale Geschwindigkeit und Kontrolle brauchst und vor Handarbeit nicht zurückschreckst, bist du hier richtig.

Warum C++?

- Extrem schnell: Für CPU-intensive Aufgaben kaum zu schlagen.

- Feinste Kontrolle: Speicher, Threads und Performance lassen sich exakt steuern.

- Wichtige Libraries: für HTTP, fürs Parsing.

Beispiel: C++-Code für den Seitentitel

1#include <curl/curl.h>

2#include <iostream>

3#include <string>

4size_t WriteCallback(void* contents, size_t size, size_t nmemb, void* userp) {

5 std::string* html = static_cast<std::string*>(userp);

6 size_t totalSize = size * nmemb;

7 html->append(static_cast<char*>(contents), totalSize);

8 return totalSize;

9}

10int main() {

11 CURL* curl = curl_easy_init();

12 std::string html;

13 if(curl) {

14 curl_easy_setopt(curl, CURLOPT_URL, "<https://example.com>");

15 curl_easy_setopt(curl, CURLOPT_WRITEFUNCTION, WriteCallback);

16 curl_easy_setopt(curl, CURLOPT_WRITEDATA, &html);

17 CURLcode res = curl_easy_perform(curl);

18 curl_easy_cleanup(curl);

19 }

20 std::size_t startPos = html.find("<title>");

21 std::size_t endPos = html.find("</title>");

22 if(startPos != std::string::npos && endPos != std::string::npos) {

23 startPos += 7;

24 std::string title = html.substr(startPos, endPos - startPos);

25 std::cout << "Page title: " << title << std::endl;

26 } else {

27 std::cout << "Title tag not found" << std::endl;

28 }

29 return 0;

30}Stärken:

- Unübertroffene Geschwindigkeit für riesige Scraping-Jobs.

- Ideal, wenn Scraping in Hochleistungssysteme integriert werden soll.

Schwächen:

- Hohe Einstiegshürde (Kaffee bereithalten).

- Speicherverwaltung von Hand.

- Wenige High-Level-Bibliotheken; nicht für dynamische Inhalte gemacht.

Wann passt C++?

Wenn du Millionen von Seiten scrapen musst oder Performance absolut entscheidend ist. Sonst verbringst du mehr Zeit mit Debugging als mit Scraping.

Java: Enterprise-taugliche Web-Scraping-Lösungen

Java ist der Dauerbrenner in der Unternehmenswelt. Wenn dein Projekt dauerhaft laufen, riesige Datenmengen verarbeiten und ausfallsicher sein soll, ist Java die richtige Wahl.

Warum Java?

- Robust und skalierbar: Perfekt für große, langlebige Scraping-Projekte.

- Starke Typisierung und Fehlerbehandlung: Weniger Überraschungen im Produktivbetrieb.

- Wichtige Libraries: fürs Parsing, für Browser-Automatisierung, für HTTP.

Beispiel: Java-Code für den Seitentitel

1import org.jsoup.Jsoup;

2import org.jsoup.nodes.Document;

3public class ScrapeTitle {

4 public static void main(String[] args) throws Exception {

5 Document doc = Jsoup.connect("<https://example.com>").get();

6 String title = doc.title();

7 System.out.println("Page title: " + title);

8 }

9}Stärken:

- Hohe Performance und Parallelität.

- Sehr gut für große, wartbare Codebasen.

- Gute Unterstützung für dynamische Inhalte (über Selenium oder HtmlUnit).

Schwächen:

- Ausführliche Syntax; mehr Setup als bei Skriptsprachen.

- Für kleine Einmalskripte meist zu aufwendig.

Wann passt Java?

Für große Unternehmensprojekte oder wenn Zuverlässigkeit und Skalierbarkeit im Vordergrund stehen.

Go (Golang): Schnelles und paralleles Web-Scraping

Go ist zwar noch relativ neu, sorgt aber schon für Furore – vor allem, wenn es um schnelles, paralleles Scraping geht.

Warum Go?

- Kompiliert und schnell: Fast so flott wie C++.

- Eingebaute Parallelität: Mit Goroutines wird paralleles Scraping zum Kinderspiel.

- Wichtige Libraries: fürs Scraping, fürs Parsing.

Beispiel: Go-Code für den Seitentitel

1package main

2import (

3 "fmt"

4 "github.com/gocolly/colly"

5)

6func main() {

7 c := colly.NewCollector()

8 c.OnHTML("title", func(e *colly.HTMLElement) {

9 fmt.Println("Page title:", e.Text)

10 })

11 err := c.Visit("<https://example.com>")

12 if err != nil {

13 fmt.Println("Error:", err)

14 }

15}Stärken:

- Extrem schnell und effizient für große Scraping-Projekte.

- Einfach zu deployen (einzelne Binärdatei).

- Hervorragend für paralleles Crawling.

Schwächen:

- Kleinere Community als Python oder Node.js.

- Weniger High-Level-Bibliotheken.

- Für JavaScript-lastige Seiten ist zusätzlicher Aufwand nötig (Chromedp oder Selenium).

Wann passt Go?

Wenn du große Datenmengen scrapen musst oder Python zu langsam ist. .

Vergleich der besten Programmiersprachen für Web-Scraping

Hier findest du einen direkten Vergleich, um die passende Sprache für dein Web-Scraping-Projekt 2025 zu finden:

| Sprache/Tool | Benutzerfreundlichkeit | Performance | Bibliotheken | Dynamische Inhalte | Bestes Einsatzgebiet |

|---|---|---|---|---|---|

| Python | Sehr hoch | Mittel | Exzellent | Gut (Selenium/Playwright) | Allrounder, Einsteiger, Datenanalyse |

| JavaScript/Node.js | Mittel | Hoch | Stark | Exzellent (nativ) | Dynamische Seiten, asynchrones Scraping, Webentwicklung |

| Ruby | Hoch | Mittel | Gut | Eingeschränkt (Watir) | Schnelle Skripte, Prototyping |

| PHP | Mittel | Mittel | Ausreichend | Eingeschränkt (Panther) | Serverseitig, Web-Integration |

| C++ | Niedrig | Sehr hoch | Eingeschränkt | Sehr eingeschränkt | Performance-kritisch, große Datenmengen |

| Java | Mittel | Hoch | Gut | Gut (Selenium/HtmlUnit) | Unternehmen, langlebige Services |

| Go (Golang) | Mittel | Sehr hoch | Wächst | Mittel (Chromedp) | Schnelles, paralleles Scraping |

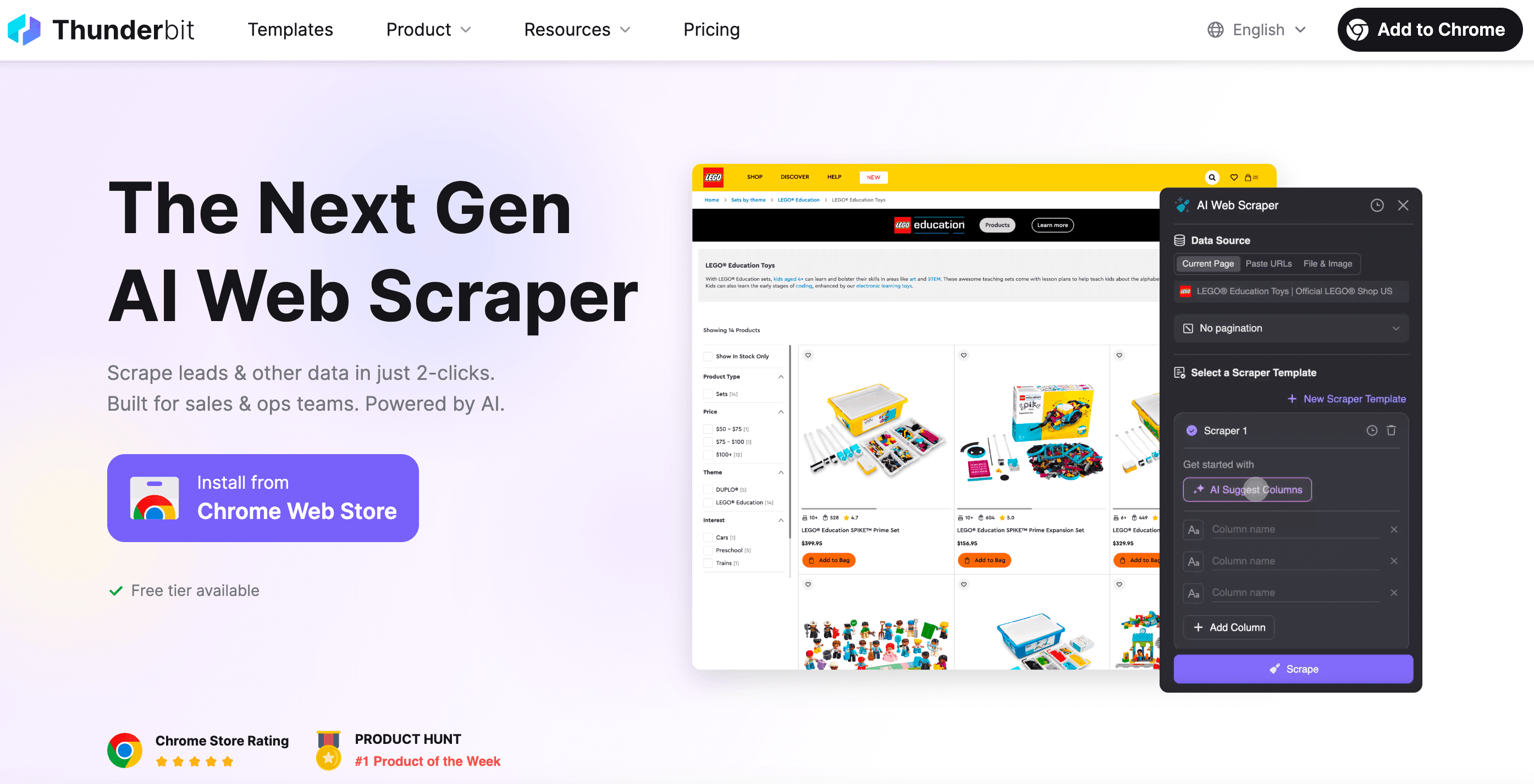

Wenn du nicht coden willst: Thunderbit als No-Code Web-Scraping-Lösung

Mal ehrlich: Manchmal willst du einfach nur die Daten – ohne Code, Debugging oder nervige Selektoren. Genau dafür gibt es .

Als Mitgründer von Thunderbit war mein Ziel, Web-Scraping so einfach zu machen wie Essen bestellen. Das macht Thunderbit besonders:

- 2-Klick-Setup: Einfach „KI-Felder vorschlagen“ und „Scrapen“ klicken. Kein Stress mit HTTP-Requests, Proxies oder Anti-Bot-Maßnahmen.

- Intelligente Vorlagen: Ein Scraper-Template passt sich verschiedenen Seitenlayouts an. Kein ständiges Umschreiben mehr.

- Browser- & Cloud-Scraping: Wähle zwischen Scraping im Browser (ideal für eingeloggte Seiten) oder in der Cloud (blitzschnell für öffentliche Daten).

- Dynamische Inhalte? Kein Problem: Thunderbits KI steuert einen echten Browser – Infinite Scroll, Pop-ups, Logins und mehr sind kein Hindernis.

- Export überallhin: Excel, Google Sheets, Airtable, Notion oder einfach in die Zwischenablage.

- Keine Wartung: Ändert sich eine Seite, reicht ein Klick auf die KI-Vorschläge. Nachtschichten zum Debuggen entfallen.

- Automatisierung & Zeitplanung: Scraper lassen sich zeitgesteuert ausführen – ohne Cronjobs oder Server-Setup.

- Spezialisierte Extraktoren: E-Mails, Telefonnummern oder Bilder? Thunderbit extrahiert sie mit einem Klick.

Das Beste: Du brauchst keine einzige Zeile Code. Thunderbit ist für Business-User, Marketer, Vertrieb, Immobilienprofis – für alle, die schnell an Daten kommen wollen.

Du willst Thunderbit in Aktion sehen? oder schau auf unserem vorbei.

Fazit: Die beste Sprache für Web-Scraping 2025 wählen

Web-Scraping ist 2025 zugänglicher und leistungsfähiger als je zuvor. Was ich nach Jahren in der Automatisierung gelernt habe:

- Python bleibt die beste Sprache für schnellen Einstieg und riesige Ressourcen.

- JavaScript/Node.js ist unschlagbar für dynamische, JavaScript-lastige Seiten.

- Ruby und PHP sind super für schnelle Skripte und Web-Integration, besonders wenn du sie ohnehin nutzt.

- C++ und Go sind deine Wahl, wenn es auf Geschwindigkeit und Skalierbarkeit ankommt.

- Java ist ideal für große, langfristige Unternehmensprojekte.

- Und wenn du gar nicht coden willst? ist dein Geheimtipp.

Stell dir vor dem Start diese Fragen:

- Wie groß ist mein Projekt?

- Muss ich dynamische Inhalte verarbeiten?

- Wie fit bin ich technisch?

- Will ich selbst bauen oder einfach nur die Daten?

Teste einen der Codes oben oder probiere Thunderbit für dein nächstes Projekt aus. Mehr Tipps, Anleitungen und echte Scraping-Storys findest du im .

Viel Erfolg beim Scrapen – und möge deine Datenquelle immer sauber, strukturiert und nur einen Klick entfernt sein.

P.S.: Falls du nachts um 2 Uhr im Web-Scraping-Dschungel feststeckst: Es gibt immer Thunderbit. Oder Kaffee. Oder beides.

Häufige Fragen (FAQ)

1. Was ist die beste Programmiersprache für Web-Scraping 2025?

Python bleibt die erste Wahl – dank lesbarer Syntax, starker Bibliotheken (wie BeautifulSoup, Scrapy und Selenium) und einer riesigen Community. Ideal für Einsteiger und Profis, besonders wenn du Scraping und Datenanalyse kombinieren willst.

2. Welche Sprache eignet sich am besten für JavaScript-lastige Webseiten?

JavaScript (Node.js) ist hier unschlagbar. Tools wie Puppeteer und Playwright bieten volle Browserkontrolle und ermöglichen das Scrapen von Inhalten, die mit React, Vue oder Angular geladen werden.

3. Gibt es eine No-Code-Lösung für Web-Scraping?

Ja – ist ein No-Code KI-Web-Scraper, der alles von dynamischen Inhalten bis zur Zeitplanung übernimmt. Einfach „KI-Felder vorschlagen“ klicken und loslegen. Perfekt für Vertrieb, Marketing oder Teams, die schnell strukturierte Daten brauchen.

Mehr erfahren: