Eine Website zu managen, fühlt sich 2025 manchmal wie ein nie endender Parcours an. Heute jagst du fehlerhafte Links, morgen steht eine Content-Migration an – und zwischendurch wunderst du dich, warum Google plötzlich deine „Test“-Seite von 2019 indexiert hat. Glaub mir, ich kenne das nur zu gut. Und wenn es dir ähnlich geht, hast du bestimmt auch schon mal mitten in der Nacht nach dem „besten kostenlosen website crawler“ gesucht – in der Hoffnung auf ein Tool, das einfach läuft (und kein Informatikstudium voraussetzt).

Aber Vorsicht: Nicht jeder website crawler ist gleich – und viele werfen „web crawling“ und „web scraping“ durcheinander, als wäre es das Gleiche. Ist es aber nicht. In diesem Guide erkläre ich dir den Unterschied, zeige, warum Online-Crawler wichtiger denn je sind, und stelle dir die 10 besten kostenlosen website crawler für 2025 vor. Und weil ich Mitgründer von bin, erfährst du auch, wann es sich lohnt, auf eine KI-basierte Lösung zu setzen, die dir wirklich die Daten liefert, die du brauchst. Bereit? Dann lass uns loslegen.

Was ist ein Website Crawler? Die Basics verständlich gemacht

Erstmal Klartext: Ein website crawler ist nicht das Gleiche wie ein Web-Scraper. Die Begriffe werden oft verwechselt, aber sie haben unterschiedliche Aufgaben. Stell dir einen Crawler wie einen Kartografen deiner Website vor: Er durchforstet jede Ecke, folgt allen Links und erstellt eine Übersicht aller Seiten. Sein Job ist die Entdeckung: URLs finden, die Seitenstruktur abbilden und Inhalte indexieren. Genau das machen Suchmaschinen wie Google mit ihren Bots – und SEO-Tools nutzen Crawler, um die Gesundheit deiner Website zu checken ().

Ein Web-Scraper dagegen ist der Datensammler. Ihn interessiert nicht die ganze Karte – er sucht gezielt nach Gold: Produktpreise, Firmennamen, Bewertungen, E-Mails und mehr. Scraper holen gezielt Felder von den Seiten, die Crawler gefunden haben ().

Vergleich zur Veranschaulichung:

- Crawler: Jemand, der durch jeden Gang im Supermarkt läuft und eine Liste aller Produkte erstellt.

- Scraper: Jemand, der direkt zum Kaffeeregal geht und nur die Preise der Bio-Sorten notiert.

Warum ist das wichtig? Wenn du alle Seiten deiner Website finden willst (z. B. für ein SEO-Audit), brauchst du einen Crawler. Willst du alle Produktpreise von der Konkurrenz extrahieren, brauchst du einen Scraper – oder am besten ein web crawler tool, das beides kann.

Warum einen Online-Web-Crawler nutzen? Die wichtigsten Vorteile für Unternehmen

Warum solltest du 2025 auf einen Online-web crawler tool setzen? Das Internet wächst weiter rasant. Über , um ihre Websites zu optimieren, und manche SEO-Tools crawlen täglich .

Was bringen dir Crawler konkret?

- SEO-Audits: Finde fehlerhafte Links, fehlende Titel, doppelte Inhalte, verwaiste Seiten und mehr ().

- Link-Checks & Qualitätssicherung: Entdecke 404-Fehler und Weiterleitungsschleifen, bevor es deine Nutzer tun ().

- Sitemap-Erstellung: Generiere automatisch XML-Sitemaps für Suchmaschinen und die Planung ().

- Content-Inventar: Erstelle eine Übersicht aller Seiten, ihrer Hierarchie und Metadaten.

- Compliance & Barrierefreiheit: Prüfe jede Seite auf WCAG, SEO und rechtliche Vorgaben ().

- Performance & Sicherheit: Finde langsame Seiten, zu große Bilder oder Sicherheitsprobleme ().

- Daten für KI & Analyse: Nutze gecrawlte Daten für Analysen oder KI-Tools ().

Hier eine Übersicht, welche Use Cases für welche Rollen besonders relevant sind:

| Anwendungsfall | Ideal für | Nutzen / Ergebnis |

|---|---|---|

| SEO & Website-Audit | Marketing, SEO, KMU | Technische Probleme finden, Struktur optimieren, Rankings verbessern |

| Content-Inventar & QA | Content-Manager, Webmaster | Inhalte prüfen/migrieren, kaputte Links/Bilder finden |

| Lead-Generierung (Scraping) | Vertrieb, Business Development | Automatisierte Akquise, CRM mit frischen Leads füllen |

| Wettbewerbsanalyse | E-Commerce, Produktmanager | Preise, neue Produkte, Lagerbestände der Konkurrenz überwachen |

| Sitemap & Struktur-Klonen | Entwickler, DevOps, Berater | Seitenstruktur für Redesigns oder Backups klonen |

| Content-Aggregation | Forschung, Medien, Analysten | Daten aus mehreren Quellen für Analysen oder Trends sammeln |

| Marktforschung | Analysten, KI-Teams | Große Datensätze für Analysen oder KI-Training erfassen |

()

So haben wir die besten kostenlosen Website-Crawler ausgewählt

Ich habe viele Nächte (und zu viel Kaffee) damit verbracht, web crawler tool zu testen, Dokus zu lesen und Probe-Crawls zu machen. Worauf habe ich geachtet?

- Technische Möglichkeiten: Kommt das Tool mit modernen Websites klar (JavaScript, Logins, dynamische Inhalte)?

- Benutzerfreundlichkeit: Ist es auch für Nicht-Techniker geeignet oder braucht man Kommandozeilen-Kenntnisse?

- Kostenlose Nutzung: Ist das Angebot wirklich kostenlos oder nur ein Lockangebot?

- Online-Zugänglichkeit: Cloud-Tool, Desktop-App oder Code-Bibliothek?

- Besondere Features: Gibt es Extras wie KI-Extraktion, visuelle Sitemaps oder eventgesteuertes Crawling?

Ich habe jedes Tool ausprobiert, Nutzerbewertungen gecheckt und die Funktionen verglichen. Alles, was mich zur Verzweiflung gebracht hat, ist rausgeflogen.

Schnellvergleich: Die 10 besten kostenlosen Website-Crawler im Überblick

| Tool & Typ | Kernfunktionen | Bester Anwendungsfall | Technische Anforderungen | Details zum Gratis-Angebot |

|---|---|---|---|---|

| BrightData (Cloud/API) | Enterprise-Crawling, Proxies, JS-Rendering, CAPTCHA-Lösung | Großflächige Datensammlung | Technisches Know-how hilfreich | Testversion: 3 Scraper, je 100 Datensätze (insgesamt ca. 300) |

| Crawlbase (Cloud/API) | API-Crawling, Anti-Bot, Proxies, JS-Rendering | Entwickler, Backend-Crawling | API-Integration | Gratis: ca. 5.000 API-Calls für 7 Tage, danach 1.000/Monat |

| ScraperAPI (Cloud/API) | Proxy-Rotation, JS-Rendering, asynchrones Crawling, fertige Endpunkte | Entwickler, Preisüberwachung, SEO-Daten | Minimaler Aufwand | Gratis: 5.000 API-Calls für 7 Tage, danach 1.000/Monat |

| Diffbot Crawlbot (Cloud) | KI-Crawling & Extraktion, Knowledge Graph, JS-Rendering | Strukturierte Daten, KI/ML | API-Integration | Gratis: 10.000 Credits/Monat (ca. 10.000 Seiten) |

| Screaming Frog (Desktop) | SEO-Audit, Link-/Meta-Analyse, Sitemap, Custom Extraction | SEO-Audits, Site-Manager | Desktop-App, GUI | Gratis: 500 URLs pro Crawl, Basisfunktionen |

| SiteOne Crawler (Desktop) | SEO, Performance, Barrierefreiheit, Sicherheit, Export, Markdown | Entwickler, QA, Migration, Doku | Desktop/CLI, GUI | Open Source, 1.000 URLs im GUI-Report (anpassbar) |

| Crawljax (Java, OpenSrc) | Eventgesteuertes Crawling für JS-Seiten, statischer Export | Entwickler, QA für dynamische Web-Apps | Java, CLI/Config | Open Source, keine Limits |

| Apache Nutch (Java, OpenSrc) | Verteiltes Crawling, Plugins, Hadoop, Custom Search | Eigene Suchmaschinen, große Crawls | Java, Kommandozeile | Open Source, nur Infrastrukturkosten |

| YaCy (Java, OpenSrc) | Peer-to-Peer-Crawling & Suche, Datenschutz, Web/Intranet | Private Suche, Dezentralisierung | Java, Browser-UI | Open Source, keine Limits |

| PowerMapper (Desktop/SaaS) | Visuelle Sitemaps, Barrierefreiheit, QA, Browser-Kompatibilität | Agenturen, QA, visuelle Planung | GUI, einfach | Testversion: 30 Tage, 100 Seiten (Desktop) oder 10 Seiten (Online) pro Scan |

BrightData: Cloud-Crawler für Unternehmen

BrightData ist das Schwergewicht unter den web crawling Tools. Die Cloud-Plattform bietet ein riesiges Proxy-Netzwerk, JavaScript-Rendering, CAPTCHA-Lösungen und eine eigene Entwicklungsumgebung für individuelle Crawls. Wer große Datenmengen aus dem Web ziehen will – etwa für Preisüberwachung im E-Commerce – ist hier richtig ().

Vorteile:

- Meistern auch schwierige Seiten mit Anti-Bot-Schutz

- Skalierbar für große Unternehmen

- Vorlagen für viele Standardseiten

Nachteile:

- Kein dauerhaft kostenloser Tarif (nur Test: 3 Scraper, je 100 Datensätze)

- Für einfache Audits meist zu umfangreich

- Einarbeitung für Nicht-Techniker nötig

Wer im großen Stil crawlen will, bekommt mit BrightData ein echtes Profi-Tool – aber nach der Testphase ist Schluss mit kostenlos ().

Crawlbase: API-basierter Gratis-Crawler für Entwickler

Crawlbase (früher ProxyCrawl) setzt voll auf API-Crawling. Du schickst eine URL an die API, bekommst das HTML zurück – Proxies, Geotargeting und CAPTCHAs werden automatisch gehandhabt ().

Vorteile:

- Sehr hohe Erfolgsquote (99 %+)

- Kommt mit JavaScript-lastigen Seiten klar

- Ideal für die Integration in eigene Anwendungen

Nachteile:

- API- oder SDK-Integration erforderlich

- Gratis: ca. 5.000 API-Calls für 7 Tage, danach 1.000/Monat

Für Entwickler, die skalierbar web crawling (und ggf. scraping) wollen, ohne sich um Proxies zu kümmern, ist Crawlbase eine gute Wahl ().

ScraperAPI: Dynamisches Web Crawling leicht gemacht

ScraperAPI ist die „hol mir einfach die Daten“-API. Du gibst eine URL, das Tool kümmert sich um Proxies, Headless-Browser und Anti-Bot-Maßnahmen und liefert dir das HTML (oder strukturierte Daten für manche Seiten). Besonders für dynamische Seiten und mit großzügigem Gratis-Tarif ().

Vorteile:

- Extrem einfach für Entwickler (nur ein API-Call)

- Umgeht CAPTCHAs, IP-Sperren, JavaScript

- Gratis: 5.000 API-Calls für 7 Tage, danach 1.000/Monat

Nachteile:

- Keine visuellen Crawl-Reports

- Crawl-Logik (z. B. Link-Following) muss selbst gescriptet werden

Wer web crawling schnell in den eigenen Code integrieren will, ist mit ScraperAPI bestens bedient.

Diffbot Crawlbot: Automatisierte Website-Strukturerkennung

Diffbot Crawlbot hebt das Ganze auf ein neues Level: Hier wird nicht nur gecrawlt, sondern mit KI die Seiten klassifiziert und strukturierte Daten (Artikel, Produkte, Events etc.) als JSON extrahiert. Fast wie ein digitaler Praktikant, der versteht, was er liest ().

Vorteile:

- KI-gestützte Extraktion, nicht nur Crawling

- Kommt mit JavaScript und dynamischen Inhalten klar

- Gratis: 10.000 Credits/Monat (ca. 10.000 Seiten)

Nachteile:

- Eher für Entwickler (API-Integration)

- Kein visuelles SEO-Tool, sondern für Datenprojekte

Wer strukturierte Daten in großem Stil braucht, etwa für KI oder Analysen, ist mit Diffbot bestens beraten.

Screaming Frog: Kostenloser Desktop-SEO-Crawler

Screaming Frog ist der Klassiker für SEO-Audits am Desktop. Bis zu 500 URLs pro Scan (in der Gratis-Version) und alles dabei: fehlerhafte Links, Meta-Tags, doppelte Inhalte, Sitemaps und mehr ().

Vorteile:

- Schnell, gründlich und in der SEO-Welt etabliert

- Keine Programmierkenntnisse nötig – einfach URL eingeben und los

- Gratis bis 500 URLs pro Crawl

Nachteile:

- Nur als Desktop-Tool (keine Cloud-Version)

- Erweiterte Features (z. B. JS-Rendering, Zeitplanung) kostenpflichtig

Wer SEO ernst nimmt, kommt an Screaming Frog kaum vorbei – für sehr große Seiten reicht die Gratis-Version aber nicht.

SiteOne Crawler: Statischer Export & Dokumentation

SiteOne Crawler ist das Schweizer Taschenmesser für technische Audits. Open Source, plattformübergreifend, kann crawlen, prüfen und sogar die Website als Markdown für Doku oder Offline-Nutzung exportieren ().

Vorteile:

- Prüft SEO, Performance, Barrierefreiheit, Sicherheit

- Export für Archivierung oder Migration

- Kostenlos & Open Source, keine Nutzungsbeschränkungen

Nachteile:

- Technischer als manche GUI-Tools

- Standardmäßig 1.000 URLs im GUI-Report (anpassbar)

Für Entwickler, QA oder Berater, die tief eintauchen wollen (und Open Source lieben), ist SiteOne ein echter Geheimtipp.

Crawljax: Open-Source-Java-Crawler für dynamische Seiten

Crawljax ist spezialisiert auf moderne, JavaScript-lastige Web-Apps. Er simuliert Nutzerinteraktionen (Klicks, Formulare etc.), ist eventgesteuert und kann sogar eine statische Version einer dynamischen Seite erzeugen ().

Vorteile:

- Unschlagbar für SPAs und AJAX-Seiten

- Open Source und erweiterbar

- Keine Nutzungsbeschränkungen

Nachteile:

- Java und etwas Programmierkenntnisse nötig

- Nicht für Einsteiger geeignet

Wer eine React- oder Angular-App wie ein echter Nutzer crawlen will, ist mit Crawljax gut beraten.

Apache Nutch: Skalierbarer, verteilter Website-Crawler

Apache Nutch ist der Urvater der Open-Source-Crawler. Entwickelt für riesige, verteilte Crawls – etwa zum Aufbau einer eigenen Suchmaschine oder zum Indexieren von Millionen Seiten ().

Vorteile:

- Skaliert auf Milliarden Seiten mit Hadoop

- Sehr anpassbar und erweiterbar

- Kostenlos & Open Source

Nachteile:

- Hohe Einstiegshürde (Java, Kommandozeile, Konfiguration)

- Nicht für kleine Seiten oder Gelegenheitsnutzer

Wer das Web im großen Stil crawlen will und keine Angst vor der Kommandozeile hat, ist mit Nutch bestens bedient.

YaCy: Peer-to-Peer-Crawler & Suchmaschine

YaCy ist ein dezentraler Crawler und eine Suchmaschine. Jede Instanz crawlt und indexiert Seiten, und im Peer-to-Peer-Netzwerk werden die Indizes geteilt ().

Vorteile:

- Datenschutzfreundlich, kein zentraler Server

- Ideal für private oder Intranet-Suche

- Kostenlos & Open Source

Nachteile:

- Ergebnisse hängen von der Netzabdeckung ab

- Einrichtung (Java, Browser-UI) nötig

Wer auf Dezentralisierung steht oder eine eigene Suchmaschine will, sollte sich YaCy anschauen.

PowerMapper: Visueller Sitemap-Generator für UX & QA

PowerMapper visualisiert die Struktur deiner Website. Es crawlt die Seite, erstellt interaktive Sitemaps und prüft auf Barrierefreiheit, Browser-Kompatibilität und SEO-Basics ().

Vorteile:

- Visuelle Sitemaps ideal für Agenturen und Designer

- Prüft Barrierefreiheit und Compliance

- Einfache Bedienung, keine Technikkenntnisse nötig

Nachteile:

- Nur Testversion (30 Tage, 100 Seiten Desktop/10 Seiten Online pro Scan)

- Vollversion kostenpflichtig

Wer Sitemaps für Kunden präsentieren oder Compliance prüfen will, findet in PowerMapper ein praktisches Tool.

Welcher kostenlose Web-Crawler passt zu dir?

Bei so vielen Möglichkeiten: Wie entscheidest du dich? Hier ein schneller Überblick:

- Für SEO-Audits: Screaming Frog (kleine Seiten), PowerMapper (visuell), SiteOne (tiefgehende Audits)

- Für dynamische Web-Apps: Crawljax

- Für große Crawls oder eigene Suche: Apache Nutch, YaCy

- Für Entwickler mit API-Bedarf: Crawlbase, ScraperAPI, Diffbot

- Für Doku oder Archivierung: SiteOne Crawler

- Für Enterprise-Scale mit Testphase: BrightData, Diffbot

Wichtige Auswahlkriterien:

- Skalierbarkeit: Wie groß ist dein Crawl-Projekt?

- Benutzerfreundlichkeit: Bist du technikaffin oder willst du einfach klicken?

- Datenexport: Brauchst du CSV, JSON oder Schnittstellen zu anderen Tools?

- Support: Gibt es Community oder Hilfedokumente?

Wenn Web Crawling auf Web Scraping trifft: Warum Thunderbit die clevere Wahl ist

Die Realität: Die meisten wollen Websites nicht nur kartieren, sondern strukturierte Daten gewinnen – etwa Produktlisten, Kontaktdaten oder Inhaltsübersichten. Genau hier setzt an.

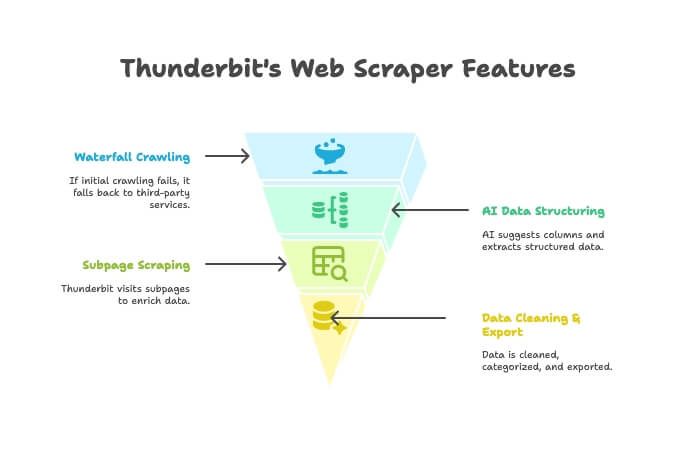

Thunderbit ist mehr als ein Crawler oder Scraper – es ist eine KI-gestützte Chrome-Erweiterung, die beides vereint. So funktioniert’s:

- KI-Crawler: Thunderbit erkundet die Website wie ein klassischer Crawler.

- Waterfall Crawling: Kommt Thunderbit nicht weiter (z. B. wegen Anti-Bot-Schutz), greift es automatisch auf Drittanbieter-Crawler zurück – ganz ohne manuelle Einrichtung.

- KI-Datenstrukturierung: Nach dem Crawling schlägt Thunderbits KI automatisch passende Spalten vor und extrahiert strukturierte Daten (Namen, Preise, E-Mails etc.) – ganz ohne Selektoren.

- Unterseiten-Scraping: Du brauchst Details von allen Produktseiten? Thunderbit besucht automatisch jede Unterseite und ergänzt die Tabelle.

- Datenaufbereitung & Export: Zusammenfassen, kategorisieren, übersetzen und Export nach Excel, Google Sheets, Airtable oder Notion – alles mit einem Klick.

- No-Code-Bedienung: Wer einen Browser bedienen kann, kann auch Thunderbit nutzen. Kein Coding, keine Proxies, kein Stress.

Wann ist Thunderbit besser als ein klassischer Crawler?

- Wenn du am Ende eine saubere, nutzbare Tabelle willst – nicht nur eine Linkliste.

- Wenn du den gesamten Prozess (Crawlen, Extrahieren, Aufbereiten, Exportieren) automatisieren möchtest.

- Wenn dir deine Zeit und Nerven wichtig sind.

und selbst erleben, warum immer mehr Unternehmen umsteigen.

Fazit: Das Potenzial kostenloser Website-Crawler 2025 nutzen

Website crawler haben sich enorm weiterentwickelt. Egal ob Marketing, Entwicklung oder einfach für die Website-Pflege – es gibt für jeden ein kostenloses (oder zumindest kostenlos testbares) web crawler tool. Von Enterprise-Lösungen wie BrightData und Diffbot über Open-Source-Perlen wie SiteOne und Crawljax bis hin zu visuellen Tools wie PowerMapper – die Auswahl war nie größer.

Wer aber eine smarte, integrierte Lösung sucht, um von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ zu kommen, sollte Thunderbit ausprobieren. Es ist für Business-Anwender gemacht, die Ergebnisse wollen – keine endlosen Reports.

Bereit zum Crawlen? Lade ein Tool herunter, starte einen Scan und entdecke, was dir bisher entgangen ist. Und wenn du in zwei Klicks von Crawling zu verwertbaren Daten willst, .

Mehr Praxistipps und Deep Dives findest du im .

FAQ

Was ist der Unterschied zwischen einem Website Crawler und einem Web-Scraper?

Ein Crawler entdeckt und kartiert alle Seiten einer Website (quasi das Inhaltsverzeichnis). Ein Scraper extrahiert gezielt Datenfelder (wie Preise, E-Mails oder Bewertungen) von diesen Seiten. Crawler finden, Scraper graben tiefer ().

Welcher kostenlose Web-Crawler ist für Einsteiger am besten geeignet?

Für kleine Seiten und SEO-Audits ist Screaming Frog sehr nutzerfreundlich. Für visuelle Sitemaps eignet sich PowerMapper (während der Testphase). Thunderbit ist die einfachste Lösung, wenn du strukturierte Daten ohne Programmierung direkt im Browser willst.

Gibt es Websites, die Web-Crawler blockieren?

Ja – manche Seiten nutzen robots.txt oder Anti-Bot-Maßnahmen (wie CAPTCHAs oder IP-Sperren), um Crawler auszuschließen. Tools wie ScraperAPI, Crawlbase und Thunderbit (mit Waterfall Crawling) können das oft umgehen. Aber: Immer verantwortungsvoll crawlen und die Regeln der Website beachten ().

Haben kostenlose Website-Crawler Seiten- oder Funktionslimits?

Meistens ja. Zum Beispiel ist Screaming Frog gratis auf 500 URLs pro Crawl begrenzt, PowerMapper auf 100 Seiten im Test. API-Tools haben oft monatliche Limits. Open-Source-Tools wie SiteOne oder Crawljax haben meist keine festen Grenzen – hier limitiert nur die eigene Hardware.

Ist der Einsatz eines Web-Crawlers legal und datenschutzkonform?

Das Crawlen öffentlicher Webseiten ist in der Regel legal, aber prüfe immer die Nutzungsbedingungen und robots.txt der Seite. Niemals private oder passwortgeschützte Daten ohne Erlaubnis crawlen und bei personenbezogenen Daten die Datenschutzgesetze beachten ().