Im Jahr 2025 sind Webdaten längst kein Luxus mehr – sie gehören zum Alltag in Vertrieb, Marketing und im operativen Geschäft.

Egal, ob du neue Leads suchst, die Konkurrenz im Blick behalten willst, Preise überwachen oder Produktinfos sammeln möchtest: Früher oder später stehst du vor der gleichen Frage: Wie komme ich an diese Daten, ohne stundenlang alles per Hand zu kopieren oder selbst einen Web-Scraper zu bauen?

Die Auswahl an Tools ist riesig: Unzählige Plattformen versprechen kostenloses Web Scraping – ganz ohne Programmierkenntnisse. Doch oft entpuppen sich die Angebote als zeitlich begrenzte Testversionen, sind umständlich zu bedienen oder verstecken wichtige Funktionen hinter einer Paywall. Was taugt wirklich? Welche Tools sind für Business-User gemacht, welche für Entwickler? Und wie weit kommst du tatsächlich mit den Gratis-Versionen?

In diesem Guide findest du die 12 besten kostenlosen Data Scraper Tools 2025 – mit Thunderbit als klarer Nummer eins. Wir vergleichen Bedienung, Funktionsumfang, Einschränkungen der Gratis-Tarife und für wen welches Tool am besten passt. Egal, ob du hunderte Google Maps-Einträge extrahieren, dynamische Seiten hinter einem Login scrapen oder strukturierte Daten aus PDFs ziehen willst – hier findest du das richtige Werkzeug.

Warum du 2025 einen Data Scraper brauchst: Business-Anwendungen & Trends

Klar ist: Web Scraping ist 2025 kein Nischenthema mehr. Es ist fester Bestandteil moderner Unternehmen – und die Zahlen sprechen für sich. Der Markt für Web Scraping Software lag und wird sich bis 2032 mehr als verdoppeln. Warum? Weil vom Vertrieb bis zur Immobilienbranche alle auf Webdaten setzen, um sich Vorteile zu verschaffen.

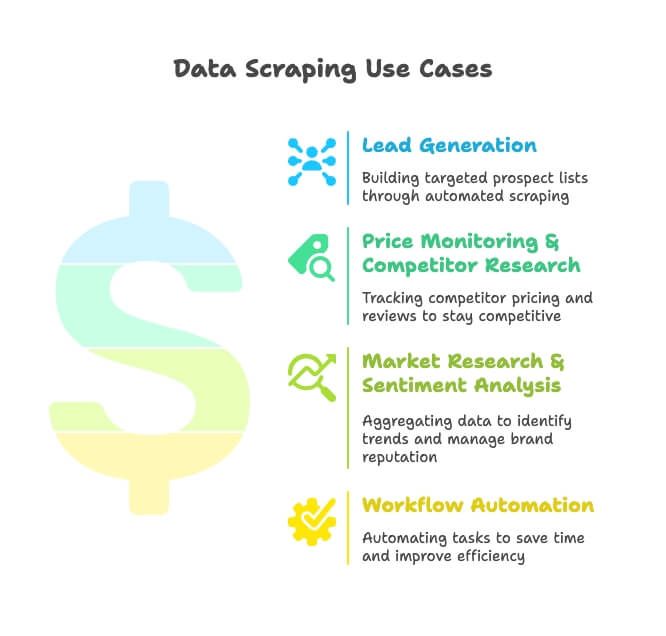

- Lead-Generierung: Vertriebsteams scrapen Verzeichnisse, Google Maps und Social Media, um gezielte Kontaktlisten zu erstellen – Schluss mit mühsamer Handarbeit.

- Preisüberwachung & Wettbewerbsanalyse: E-Commerce- und Retail-Teams behalten Konkurrenzprodukte, Preise und Bewertungen im Blick (übrigens: 82% aller Onlinehändler nutzen Scraping genau dafür).

- Marktforschung & Stimmungsanalyse: Marketing-Teams sammeln Bewertungen, News und Social-Media-Beiträge, um Trends zu erkennen und den Ruf der Marke zu steuern.

- Workflow-Automatisierung: Operations-Teams automatisieren Aufgaben wie Bestandsprüfungen oder regelmäßige Reports und sparen so jede Woche viele Stunden.

Noch ein spannender Wert: Unternehmen, die KI-gestützte Web-Scraper einsetzen, sparen im Vergleich zu manuellen Methoden. Das ist nicht nur ein bisschen – das entscheidet, ob du um 18 oder um 21 Uhr Feierabend machst.

So haben wir die besten kostenlosen Data Scraper Tools ausgewählt

Viele „Best of“-Listen wiederholen nur Werbeversprechen. Hier nicht. Für diese Auswahl habe ich auf Folgendes geachtet:

- Echte Nutzbarkeit der Gratis-Version: Kann man damit wirklich arbeiten oder ist es nur ein Lockangebot?

- Benutzerfreundlichkeit: Kommt man als Nicht-Programmierer in Minuten ans Ziel oder braucht man ein Informatikstudium?

- Unterstützte Website-Typen: Statische, dynamische, paginierte Seiten, Login-Bereiche, PDFs, Social Media – wie vielseitig ist das Tool?

- Exportmöglichkeiten: Lässt sich das Ergebnis einfach nach Excel, Google Sheets, Notion oder Airtable übertragen?

- Zusatzfunktionen: KI-gestützte Extraktion, Zeitplanung, Vorlagen, Nachbearbeitung, Integrationen.

- Zielgruppe: Für Business-Anwender, Analysten oder Entwickler?

Ich habe außerdem die Dokumentation geprüft, den Einstieg getestet und die Limits der Gratis-Tarife verglichen – denn „kostenlos“ ist oft nicht so frei, wie es klingt.

Schnellvergleich: Die 12 besten kostenlosen Data Scraper Tools

Hier ein Überblick, damit du das passende Tool für deinen Bedarf findest.

| Tool | Plattform | Gratis-Limitierungen | Ideal für | Exportformate | Besondere Features |

|---|---|---|---|---|---|

| Thunderbit | Chrome-Erweiterung | 6 Seiten/Monat | Nicht-Programmierer, Business | Excel, CSV | KI-Prompts, PDF/Bild-Scraping, Subseiten-Crawl |

| Browse AI | Cloud | 50 Credits/Monat | No-Code-User | CSV, Sheets | Point-and-Click-Roboter, Zeitplanung |

| Octoparse | Desktop | 10 Tasks, 50k Zeilen/Monat | No-Code, Semi-Tech | CSV, Excel, JSON | Visueller Workflow, dynamische Seiten |

| ParseHub | Desktop | 5 Projekte, 200 Seiten/Lauf | No-Code, Semi-Tech | CSV, Excel, JSON | Visuell, dynamische Seiten |

| Webscraper.io | Chrome-Erweiterung | Unbegrenzt lokal | No-Code, einfache Aufgaben | CSV, XLSX | Sitemap-basiert, Community-Vorlagen |

| Apify | Cloud | $5 Credits/Monat | Teams, Semi-Tech, Devs | CSV, JSON, Sheets | Actor-Marktplatz, Zeitplanung, API |

| Scrapy | Python-Bibliothek | Unbegrenzt (Open Source) | Entwickler | CSV, JSON, DB | Vollständige Code-Kontrolle, skalierbar |

| Puppeteer | Node.js-Bibliothek | Unbegrenzt (Open Source) | Entwickler | Custom (Code) | Headless-Browser, dynamisches JS |

| Selenium | Multi-Sprache | Unbegrenzt (Open Source) | Entwickler | Custom (Code) | Browser-Automatisierung, Multi-Browser |

| Zyte | Cloud | 1 Spider, 1 Std./Job, 7 Tage Speicherung | Devs, Ops-Teams | CSV, JSON | Gehostetes Scrapy, Proxy-Management |

| SerpAPI | API | 100 Suchen/Monat | Devs, Analysten | JSON | Suchmaschinen-APIs, Anti-Blocking |

| Diffbot | API | 10.000 Credits/Monat | Devs, KI-Projekte | JSON | KI-Extraktion, Knowledge Graph |

Thunderbit: Die Nr. 1 für KI-gestütztes, benutzerfreundliches Data Scraping

Warum steht ganz oben? Nicht nur, weil ich das Team kenne – Thunderbit ist wirklich wie ein KI-Praktikant, der zuhört (und keine Kaffeepausen braucht).

Thunderbit ist kein klassisches „erst lernen, dann scrapen“-Tool. Es funktioniert wie ein smarter Assistent: Du beschreibst einfach, was du brauchst („Alle Produktnamen, Preise und Links von dieser Seite“), und die KI erledigt den Rest. Kein XPath, keine CSS-Selektoren, kein Regex-Chaos. Und wenn du Unterseiten scrapen willst (z.B. Produktdetails oder Kontaktseiten), klickt Thunderbit automatisch durch und ergänzt deine Tabelle – mit nur einem Klick.

Das Besondere: Nach dem Scraping geht’s weiter. Du willst Daten zusammenfassen, übersetzen, kategorisieren oder bereinigen? Thunderbits integrierte KI-Nachbearbeitung macht’s möglich. Du bekommst nicht nur Rohdaten, sondern direkt strukturierte Infos – bereit für CRM, Tabellen oder dein nächstes Projekt.

Gratis-Tarif: Mit Thunderbit kannst du bis zu 6 Seiten (bzw. 10 mit Test-Boost) kostenlos scrapen – inklusive PDFs, Bildern und Social-Media-Vorlagen. Export nach Excel oder CSV ist gratis, ebenso wie Features wie E-Mail-/Telefon-/Bild-Extraktion. Für größere Projekte gibt’s kostenpflichtige Pläne mit mehr Seiten, direktem Export zu Google Sheets/Notion/Airtable, geplanten Scrapes und Sofort-Vorlagen für Amazon, Google Maps, Instagram & Co.

Du willst Thunderbit live sehen? Schau dir die an oder besuche unseren für Schnellstart-Videos.

Thunderbits Highlights

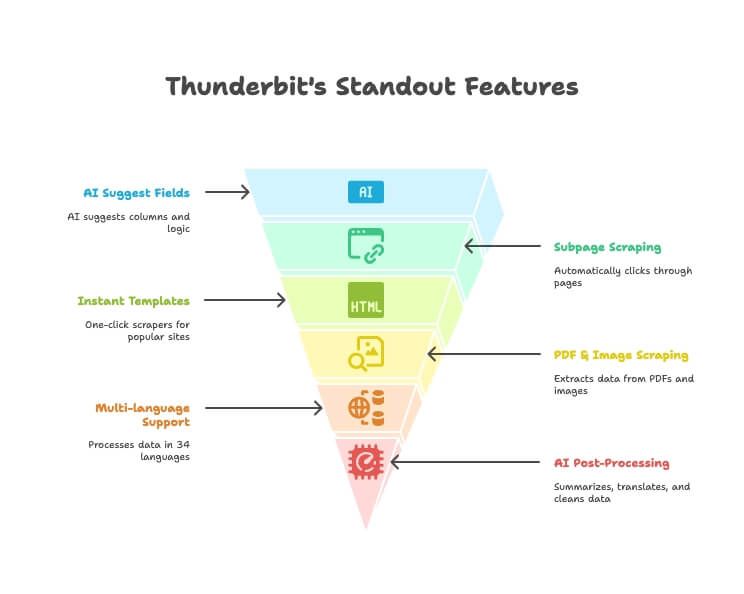

- KI-Feldvorschläge: Einfach beschreiben, was du brauchst – Thunderbit schlägt passende Spalten und Extraktionslogik vor.

- Subseiten-Scraping: Automatisches Durchklicken von Detailseiten und Anreicherung der Haupttabelle – ohne manuelle Einrichtung.

- Sofort-Vorlagen: Ein-Klick-Scraper für Amazon, Google Maps, Instagram und mehr.

- PDF- & Bild-Scraping: Tabellen und Daten aus PDFs und Bildern per KI extrahieren – ohne Zusatztools.

- Mehrsprachigkeit: Daten in 34 Sprachen scrapen und verarbeiten.

- Direkter Export: Daten direkt nach Excel, Google Sheets, Notion oder Airtable senden (in den kostenpflichtigen Plänen).

- KI-Nachbearbeitung: Daten beim Scrapen zusammenfassen, übersetzen, kategorisieren und bereinigen.

- Kostenlose E-Mail-/Telefon-/Bild-Extraktion: Kontaktdaten oder Bilder mit einem Klick von jeder Website holen.

Thunderbit schließt die Lücke zwischen „nur Daten scrapen“ und „Daten, die du wirklich nutzen kannst“. Es ist das bisher beste Beispiel für einen echten KI-Datenassistenten für Business-Anwender.

Die weiteren Top 12: Kostenlose Data Scraper Tools im Überblick

Hier die restlichen Tools, sortiert nach Zielgruppe.

Für No-Code- & Business-Anwender

Thunderbit

Bereits oben beschrieben. Der einfachste Einstieg für Nicht-Programmierer – mit KI und Sofort-Vorlagen.

Webscraper.io

- Plattform: Chrome-Erweiterung

- Ideal für: Einfache, statische Seiten; Nutzer ohne Programmierkenntnisse, die etwas ausprobieren möchten.

- Features: Sitemap-basiertes Scraping, unterstützt Paginierung, Export als CSV/XLSX.

- Gratis-Tarif: Unbegrenzt lokal nutzbar, aber keine Cloud-Läufe oder Zeitplanung. Nur manuell.

- Einschränkungen: Kein Login-, PDF- oder komplexes dynamisches Scraping. Nur Community-Support.

ParseHub

- Plattform: Desktop-App (Windows, Mac, Linux)

- Ideal für: Nicht-Programmierer und technisch Versierte, die Zeit zum Einarbeiten mitbringen.

- Features: Visueller Workflow-Builder, unterstützt dynamische Seiten, AJAX, Logins, Paginierung.

- Gratis-Tarif: 5 öffentliche Projekte, 200 Seiten pro Lauf, nur manuelle Ausführung.

- Einschränkungen: Projekte sind öffentlich (Achtung bei sensiblen Daten), keine Zeitplanung, langsame Extraktion.

Octoparse

- Plattform: Desktop-App (Windows/Mac), Cloud (kostenpflichtig)

- Ideal für: Nicht-Programmierer und Analysten, die Flexibilität und Power suchen.

- Features: Visuelles Point-and-Click, dynamische Inhalte, Vorlagen für bekannte Seiten.

- Gratis-Tarif: 10 Tasks, bis zu 50.000 Zeilen/Monat, nur Desktop (keine Cloud/Planung).

- Einschränkungen: Keine API, kein IP-Wechsel, keine Zeitplanung im Gratis-Tarif. Für komplexe Seiten steile Lernkurve.

Browse AI

- Plattform: Cloud

- Ideal für: No-Code-User, die einfache Scrapes und Überwachungen automatisieren wollen.

- Features: Point-and-Click-Roboter, Zeitplanung, Integrationen (Sheets, Zapier).

- Gratis-Tarif: 50 Credits/Monat, 1 Website, bis zu 5 Roboter.

- Einschränkungen: Begrenztes Volumen, für komplexe Seiten anfangs etwas Einarbeitung nötig.

Für Entwickler & Technik-Profis

Scrapy

- Plattform: Python-Bibliothek (Open Source)

- Ideal für: Entwickler, die volle Kontrolle und Skalierbarkeit wollen.

- Features: Hochgradig anpassbar, große Crawls, Middleware, Pipelines.

- Gratis-Tarif: Unbegrenzt (Open Source).

- Einschränkungen: Keine grafische Oberfläche, Python-Kenntnisse erforderlich. Nicht für Nicht-Programmierer.

Puppeteer

- Plattform: Node.js-Bibliothek (Open Source)

- Ideal für: Entwickler, die dynamische, JavaScript-lastige Seiten scrapen.

- Features: Headless-Browser-Automatisierung, volle Kontrolle über Navigation und Extraktion.

- Gratis-Tarif: Unbegrenzt (Open Source).

- Einschränkungen: JavaScript-Kenntnisse nötig, keine GUI.

Selenium

- Plattform: Multi-Sprache (Python, Java, etc.), Open Source

- Ideal für: Entwickler, die Browser für Scraping oder Tests automatisieren.

- Features: Multi-Browser-Support, automatisiert Klicks, Scrolls, Logins.

- Gratis-Tarif: Unbegrenzt (Open Source).

- Einschränkungen: Langsamer als Headless-Lösungen, Scripting erforderlich.

Zyte (Scrapy Cloud)

- Plattform: Cloud

- Ideal für: Entwickler und Ops-Teams, die Scrapy-Spider skalieren wollen.

- Features: Gehostetes Scrapy, Proxy-Management, Job-Planung.

- Gratis-Tarif: 1 gleichzeitiger Spider, 1 Std./Job, 7 Tage Datenspeicherung.

- Einschränkungen: Keine erweiterte Planung im Gratis-Tarif, Scrapy-Kenntnisse nötig.

Für Teams & Unternehmen

Apify

- Plattform: Cloud

- Ideal für: Teams, technisch Versierte und Entwickler, die fertige oder eigene Scraper suchen.

- Features: Actor-Marktplatz (vorgefertigte Bots), Zeitplanung, API, Integrationen.

- Gratis-Tarif: $5 Credits/Monat (reicht für kleine Jobs), 7 Tage Datenspeicherung.

- Einschränkungen: Etwas Einarbeitung nötig, Nutzung durch Credits begrenzt.

SerpAPI

- Plattform: API

- Ideal für: Entwickler und Analysten, die Suchmaschinendaten (Google, Bing, YouTube) brauchen.

- Features: Such-APIs, Anti-Blocking, strukturierte JSON-Ausgabe.

- Gratis-Tarif: 100 Suchen/Monat.

- Einschränkungen: Nicht für beliebige Websites, nur API-Nutzung.

Diffbot

- Plattform: API

- Ideal für: Entwickler, KI/ML-Teams und Unternehmen, die große Mengen strukturierter Webdaten brauchen.

- Features: KI-gestützte Extraktion, Knowledge Graph, Artikel-/Produkt-APIs.

- Gratis-Tarif: 10.000 Credits/Monat.

- Einschränkungen: Nur API, technisches Know-how nötig, Durchsatz limitiert.

Gratis-Limits: Was bedeutet „kostenlos“ bei Data Scraper Tools wirklich?

Mal ehrlich – „kostenlos“ reicht von „unbegrenzt für Hobbyprojekte“ bis „gerade genug, um dich anzufixen“. Hier die echten Limits:

| Tool | Seiten/Zeilen pro Monat | Exportformate | Zeitplanung | API-Zugang | Wichtige Gratis-Limits |

|---|---|---|---|---|---|

| Thunderbit | 6 Seiten | Excel, CSV | Nein | Nein | KI-Feldvorschläge limitiert, kein direkter Sheets/Notion-Export gratis |

| Browse AI | 50 Credits | CSV, Sheets | Ja | Ja | 1 Website, 5 Roboter, 15 Tage Speicherung |

| Octoparse | 50.000 Zeilen | CSV, Excel, JSON | Nein | Nein | Nur Desktop, keine Cloud/Planung |

| ParseHub | 200 Seiten/Lauf | CSV, Excel, JSON | Nein | Nein | 5 öffentliche Projekte, langsam |

| Webscraper.io | Unbegrenzt lokal | CSV, XLSX | Nein | Nein | Manuelle Läufe, keine Cloud |

| Apify | $5 Credits (~klein) | CSV, JSON, Sheets | Ja | Ja | 7 Tage Speicherung, Credit-Limit |

| Scrapy | Unbegrenzt | CSV, JSON, DB | Nein | N/A | Programmierung nötig |

| Puppeteer | Unbegrenzt | Custom (Code) | Nein | N/A | Programmierung nötig |

| Selenium | Unbegrenzt | Custom (Code) | Nein | N/A | Programmierung nötig |

| Zyte | 1 Spider, 1 Std./Job | CSV, JSON | Eingeschränkt | Ja | 7 Tage Speicherung, 1 Job gleichzeitig |

| SerpAPI | 100 Suchen | JSON | Nein | Ja | Nur Such-APIs |

| Diffbot | 10.000 Credits | JSON | Nein | Ja | Nur API, Durchsatz limitiert |

Fazit: Für echte Projekte bieten Thunderbit, Browse AI und Apify die nutzbarsten Gratis-Tarife für Business-Anwender. Für größere oder dauerhafte Scrapes stößt du schnell an Grenzen und brauchst ein Upgrade oder Open-Source-Lösungen.

Welches Data Scraper Tool passt zu dir? (Nutzer-Typen-Guide)

Hier eine Übersicht, welches Tool für welchen Nutzertyp am besten geeignet ist:

| Nutzertyp | Beste Tools (Gratis) | Warum |

|---|---|---|

| Nicht-Programmierer (Vertrieb/Marketing) | Thunderbit, Browse AI, Webscraper.io | Schnell zu lernen, Point-and-Click, KI-Unterstützung |

| Semi-Technisch (Ops/Analyst) | Octoparse, ParseHub, Apify, Zyte | Mehr Power, komplexe Seiten möglich, teils Scripting |

| Entwickler/Engineer | Scrapy, Puppeteer, Selenium, Diffbot, SerpAPI | Volle Kontrolle, unbegrenzt, API-first |

| Team/Unternehmen | Apify, Zyte | Zusammenarbeit, Zeitplanung, Integrationen |

Praxis-Check: Wie flexibel sind die Tools in typischen Scraping-Szenarien?

So schlagen sich die Tools in fünf gängigen Anwendungsfällen:

| Szenario | Thunderbit | Browse AI | Octoparse | ParseHub | Webscraper.io | Apify | Scrapy | Puppeteer | Selenium | Zyte | SerpAPI | Diffbot |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Paginierte Listen | Einfach | Einfach | Mittel | Mittel | Mittel | Einfach | Einfach | Einfach | Einfach | Einfach | N/A | Mittel |

| Google Maps-Einträge | Einfach* | Schwierig | Mittel | Mittel | Schwierig | Einfach | Schwierig | Schwierig | Schwierig | Schwierig | Einfach | N/A |

| Login-Seiten | Einfach | Mittel | Mittel | Mittel | Manuell | Mittel | Einfach | Einfach | Einfach | Einfach | N/A | N/A |

| PDF-Datenextraktion | Einfach | Nein | Nein | Nein | Nein | Mittel | Schwierig | Schwierig | Schwierig | Schwierig | Nein | Eingeschränkt |

| Social Media-Inhalte | Einfach* | Teilweise | Schwierig | Schwierig | Schwierig | Einfach | Schwierig | Schwierig | Schwierig | Schwierig | YouTube | Eingeschränkt |

- Thunderbit und Apify bieten Vorlagen/Actors für Google Maps und Social Media Scraping – ideal für Nicht-Programmierer.

Plugin vs. Desktop vs. Cloud: Was ist das beste Web Scraper Erlebnis?

- Chrome-Erweiterungen (Thunderbit, Webscraper.io):

- Vorteile: Schnell startklar, läuft im Browser, kaum Einrichtung nötig.

- Nachteile: Manuelle Bedienung, anfällig für Website-Änderungen, begrenzte Automatisierung.

- Thunderbits Vorteil: KI erkennt Strukturänderungen, navigiert Subseiten und extrahiert sogar PDFs/Bilder – viel robuster als klassische Extensions.

- Desktop-Apps (Octoparse, ParseHub):

- Vorteile: Leistungsstark, visuelle Workflows, unterstützt dynamische Seiten und Logins.

- Nachteile: Höhere Lernkurve, keine Cloud-Automatisierung im Gratis-Tarif, abhängig vom Betriebssystem.

- Cloud-Plattformen (Browse AI, Apify, Zyte):

- Vorteile: Zeitplanung, Teamarbeit, skalierbar, Integrationen.

- Nachteile: Gratis-Tarife oft durch Credits limitiert, teils API-Kenntnisse nötig.

- Open-Source-Bibliotheken (Scrapy, Puppeteer, Selenium):

- Vorteile: Unbegrenzt, anpassbar, ideal für Entwickler.

- Nachteile: Programmierkenntnisse nötig, nicht für Business-Anwender.

Web Scraping 2025: Was moderne Tools auszeichnet

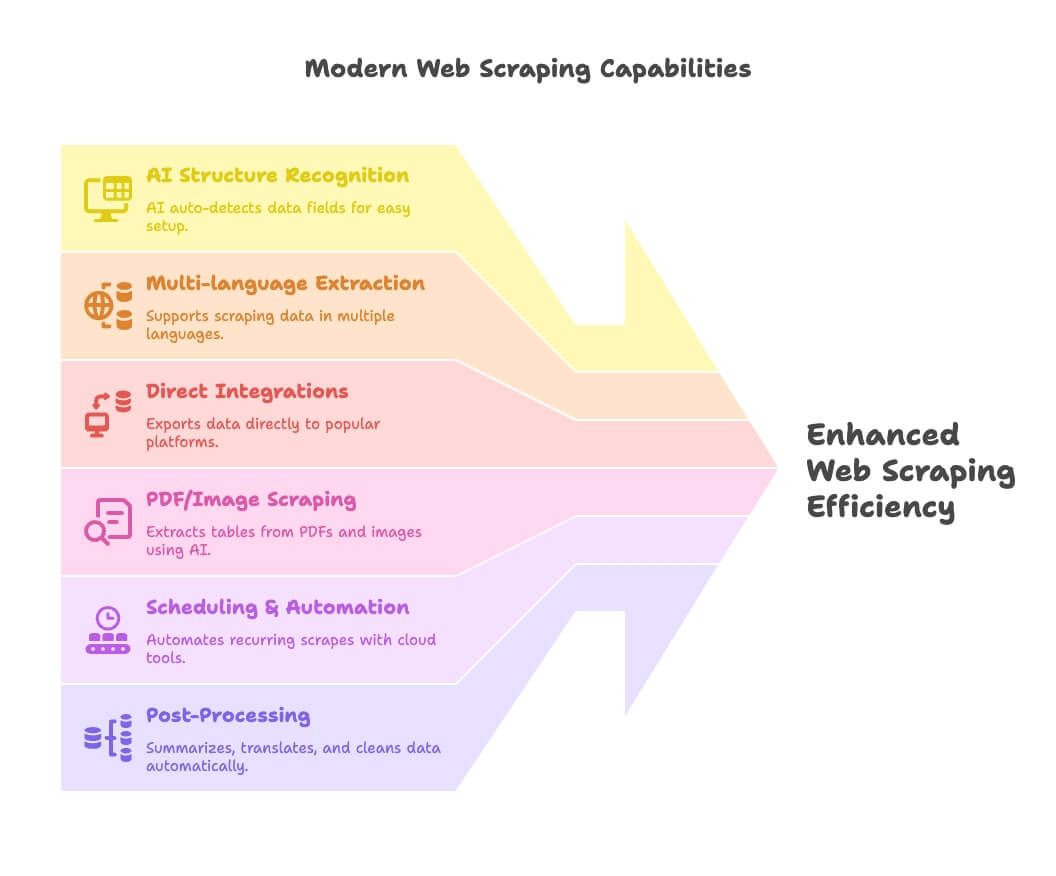

Web Scraping 2025 steht für KI, Automatisierung und Integration. Das ist neu:

- KI-Strukturerkennung: Tools wie Thunderbit erkennen Datenfelder automatisch – ideal für Nicht-Programmierer.

- Mehrsprachige Extraktion: Thunderbit & Co. unterstützen Scraping und Verarbeitung in vielen Sprachen.

- Direkte Integrationen: Export direkt nach Google Sheets, Notion oder Airtable – kein CSV-Gefrickel mehr.

- PDF/Bild-Scraping: Thunderbit ist hier führend und extrahiert Tabellen aus PDFs und Bildern per KI.

- Zeitplanung & Automatisierung: Cloud-Tools (Apify, Browse AI) ermöglichen wiederkehrende Scrapes auf Knopfdruck.

- Nachbearbeitung: Daten beim Scrapen zusammenfassen, übersetzen, kategorisieren und bereinigen – Schluss mit chaotischen Tabellen.

Thunderbit, Apify und SerpAPI sind hier Vorreiter – Thunderbit macht KI-Scraping aber besonders für Nicht-Entwickler zugänglich.

Mehr als Scraping: Datenverarbeitung & Zusatznutzen

Es geht nicht nur ums Sammeln, sondern ums Nutzen der Daten. So schneiden die Top-Tools bei der Nachbearbeitung ab:

| Tool | Bereinigung | Übersetzung | Kategorisierung | Zusammenfassung | Hinweise |

|---|---|---|---|---|---|

| Thunderbit | Ja | Ja | Ja | Ja | Integrierte KI-Nachbearbeitung |

| Apify | Teilweise | Teilweise | Teilweise | Teilweise | Abhängig vom Actor |

| Browse AI | Nein | Nein | Nein | Nein | Nur Rohdaten |

| Octoparse | Teilweise | Nein | Teilweise | Nein | Teilweise Feldverarbeitung |

| ParseHub | Teilweise | Nein | Teilweise | Nein | Teilweise Feldverarbeitung |

| Webscraper.io | Nein | Nein | Nein | Nein | Nur Rohdaten |

| Scrapy | Ja* | Ja* | Ja* | Ja* | Wenn vom Entwickler programmiert |

| Puppeteer | Ja* | Ja* | Ja* | Ja* | Wenn vom Entwickler programmiert |

| Selenium | Ja* | Ja* | Ja* | Ja* | Wenn vom Entwickler programmiert |

| Zyte | Teilweise | Nein | Teilweise | Nein | Teilweise automatische Extraktion |

| SerpAPI | Nein | Nein | Nein | Nein | Nur strukturierte Suchdaten |

| Diffbot | Ja | Ja | Ja | Ja | KI-gestützt, aber nur API |

- Entwickler müssen die Logik ggf. selbst programmieren.

Thunderbit ist das einzige Tool, mit dem auch Nicht-Programmierer direkt von Rohdaten zu verwertbaren Insights kommen – alles in einem Workflow.

Community, Support & Lernressourcen: So gelingt der Einstieg

Gute Dokumentation und Onboarding sind Gold wert. So schneiden die Tools ab:

| Tool | Doku & Tutorials | Community | Vorlagen | Lernkurve |

|---|---|---|---|---|

| Thunderbit | Exzellent | Wächst | Ja | Sehr niedrig |

| Browse AI | Gut | Gut | Ja | Niedrig |

| Octoparse | Exzellent | Groß | Ja | Mittel |

| ParseHub | Exzellent | Groß | Ja | Mittel |

| Webscraper.io | Gut | Forum | Ja | Mittel |

| Apify | Exzellent | Groß | Ja | Mittel-Hoch |

| Scrapy | Exzellent | Riesig | N/A | Hoch |

| Puppeteer | Gut | Groß | N/A | Hoch |

| Selenium | Gut | Riesig | N/A | Hoch |

| Zyte | Gut | Groß | Ja | Mittel-Hoch |

| SerpAPI | Gut | Mittel | N/A | Hoch |

| Diffbot | Gut | Mittel | N/A | Hoch |

Thunderbit und Browse AI sind am einsteigerfreundlichsten. Octoparse und ParseHub bieten viele Ressourcen, brauchen aber mehr Geduld. Apify und Entwickler-Tools sind gut dokumentiert, aber komplexer.

Fazit: Das richtige kostenlose Data Scraper Tool für 2025 finden

Das Wichtigste: Nicht jedes „kostenlose“ Data Scraper Tool ist wirklich praxistauglich. Deine Wahl sollte sich nach deinem Job, deinem Technik-Level und deinem konkreten Bedarf richten.

- Für Business-Anwender und Nicht-Programmierer, die schnell an Daten kommen wollen – auch von schwierigen Seiten, PDFs oder Bildern – ist Thunderbit die beste Wahl. Dank KI, natürlicher Spracheingabe und Nachbearbeitung ist es der wohl fortschrittlichste Datenassistent. Probiere die kostenlos aus und erlebe, wie schnell du von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ kommst.

- Für Entwickler oder alle, die unbegrenztes, anpassbares Scraping brauchen, sind Open-Source-Tools wie Scrapy, Puppeteer und Selenium ideal.

- Für Teams und technisch versierte Nutzer bieten Apify und Zyte skalierbare, kollaborative Lösungen mit großzügigen Gratis-Tarifen für kleine Projekte.

Egal, wie dein Workflow aussieht: Starte mit dem Tool, das zu deinen Fähigkeiten und Anforderungen passt. Und denk daran: 2025 musst du kein Programmierer mehr sein, um Webdaten zu nutzen – du brauchst nur den richtigen Assistenten (und vielleicht ein bisschen Humor, wenn die Roboter schneller sind als du).

Du willst tiefer einsteigen? Mehr Guides und Vergleiche findest du im , zum Beispiel: