Das Internet wächst mit einer Geschwindigkeit, die einem schwindelig machen kann – bis 2025 werden wir es mit an digitalen Inhalten zu tun haben, die durchs Netz schwirren. Das ist so viel, dass selbst die stärkste Excel-Tabelle irgendwann kapituliert. Das Entscheidende dabei: Immer mehr dieser Daten werden nicht mehr von Menschen, sondern von KI-gestützten 웹 스크래퍼 eingesammelt. Allein Ende 2024 haben automatisierte Crawler und Scraper für einen gesorgt.

Wer im Vertrieb, Marketing oder in der Unternehmenssteuerung arbeitet – oder einfach keine Lust mehr auf Copy-Paste-Marathons hat – kennt das Problem: Manuelle Datenerfassung ist langsam, fehleranfällig und ungefähr so spannend wie das Zuschauen beim Trocknen von Wandfarbe. Genau deshalb sind kostenlose KI 웹 스크래퍼 zum Geheimtipp für Teams geworden, die das Datenchaos des Internets in saubere, strukturierte Infos verwandeln wollen – und das ganz ohne Programmierkenntnisse.

Ich habe jahrelang im SaaS- und Automatisierungsbereich gearbeitet und weiß aus eigener Erfahrung, wie viel Zeit und Nerven die richtigen KI-basierten 웹 스크래퍼 Teams sparen können – und welche Insights sie liefern, die manuell nie erreichbar wären. In diesem Guide stelle ich dir die 12 besten kostenlosen KI 웹 스크래퍼 2026 vor – mit Fokus darauf, was jedes Tool besonders macht, wie sie sich für Unternehmen eignen und wie du das passende Werkzeug für deinen Workflow findest.

Warum kostenlose KI 웹 스크래퍼 für Unternehmen ein Muss sind

Die Zeiten, in denen man einfach einen Praktikanten zum Copy-Pasten abgestellt hat, sind vorbei. Moderne Teams müssen schnell reagieren, Routineaufgaben automatisieren und sich auf das Wesentliche konzentrieren. Genau hier kommen kostenlose KI 웹 스크래퍼 ins Spiel – sie machen es jedem (nicht nur Entwicklern) möglich:

- Leads generieren – zum Beispiel aus Verzeichnissen, LinkedIn oder Nischenseiten, und das in wenigen Minuten.

- Wettbewerber beobachten – Preise, Produktneuheiten oder Bewertungen im Blick behalten, ohne ständiges Klicken.

- Abläufe automatisieren – wie das Aktualisieren von CRM-Daten, das Überwachen von Lagerbeständen oder das Sammeln von Marktdaten.

Und der Effekt ist enorm: Laut aktuellen Branchenberichten liefern KI-Scraper Daten als klassische Methoden, senken Kosten und verkürzen die Einrichtungszeit. Teams, die auf diese Tools setzen, berichten oft von tausenden eingesparten Arbeitsstunden und deutlich weniger Fehlern ().

So haben wir die besten kostenlosen KI 웹 스크래퍼 ausgewählt

Nicht jeder Scraper ist gleich. Das waren meine wichtigsten Kriterien für die Top 12:

- Benutzerfreundlichkeit: No-Code- oder Low-Code-Oberflächen sind Pflicht. Wer dafür ein Informatikstudium braucht, fliegt raus.

- KI-Unterstützung: Tools, die Felder automatisch erkennen, Spalten vorschlagen oder sich an Webseitenänderungen anpassen, bekommen Extrapunkte.

- Kostenlose Nutzung: Wie viel kann man wirklich gratis machen? Ich habe Seiten-/Datensatzlimits, Exportmöglichkeiten und die Nutzung der Kernfunktionen verglichen.

- Funktionsumfang: Unterstützung für Paginierung, Unterseiten, Bild-/E-Mail-/Telefon-Extraktion und Vorlagenbibliotheken.

- Skalierbarkeit & Integration: Export nach Excel, Google Sheets, Notion oder API-Anbindung? Eignung für große Datenmengen oder nur für kleine Aufgaben?

- Einsatzszenarien: Manche Tools sind ideal für Einsteiger, andere für Entwickler oder große Projekte.

Am Ende findest du eine Vergleichstabelle, die dir hilft, das passende Tool für deinen Bedarf zu finden.

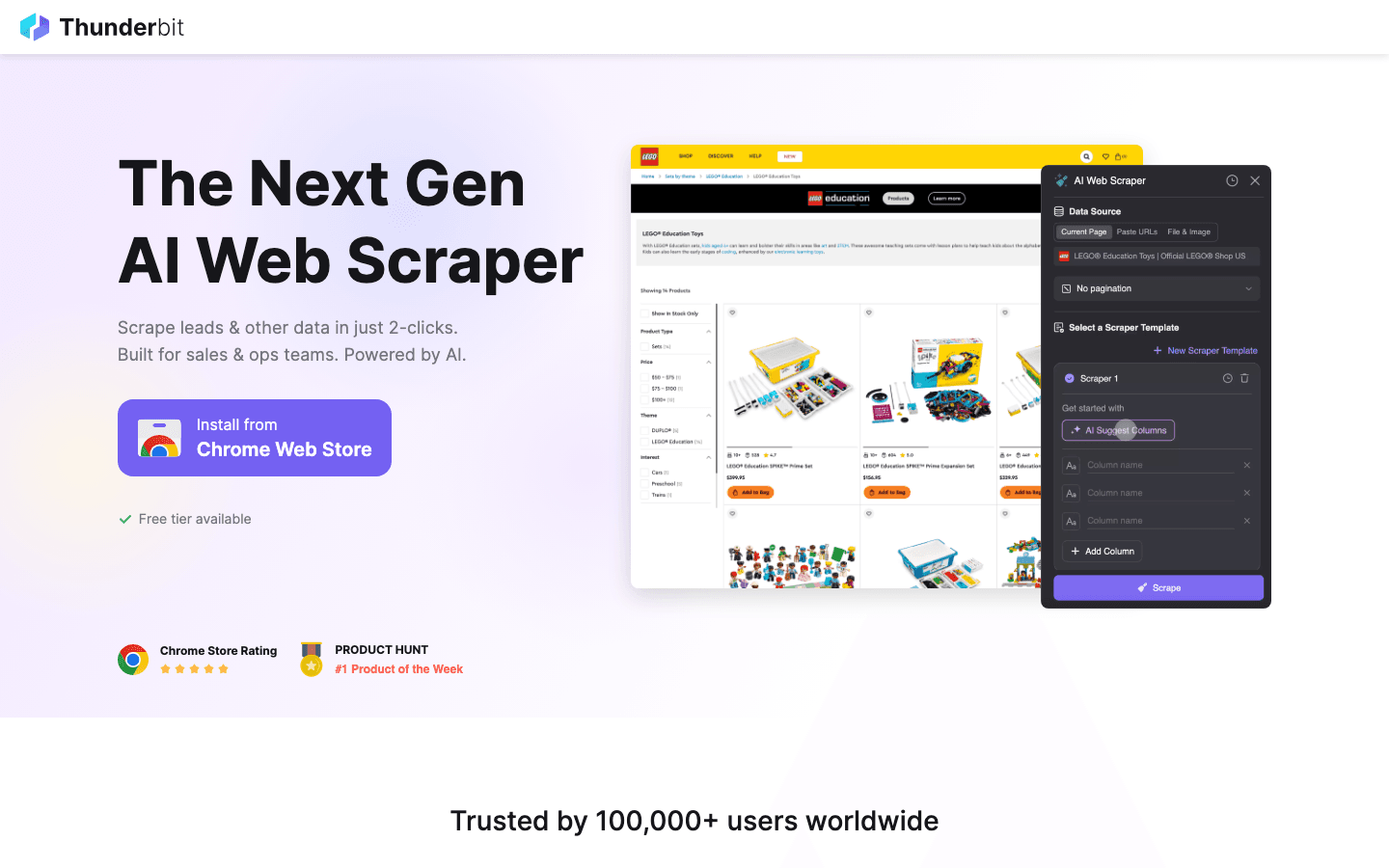

1. Thunderbit

ist meine absolute Empfehlung für Unternehmen, die einen wirklich kostenlosen KI 웹 스크래퍼 suchen, der super einfach zu bedienen ist. Als Chrome-Erweiterung richtet sich Thunderbit an nicht-technische Teams – wie Vertrieb, Operations, E-Commerce oder Immobilien – die mit nur zwei Klicks Daten von jeder Website extrahieren wollen.

ist meine absolute Empfehlung für Unternehmen, die einen wirklich kostenlosen KI 웹 스크래퍼 suchen, der super einfach zu bedienen ist. Als Chrome-Erweiterung richtet sich Thunderbit an nicht-technische Teams – wie Vertrieb, Operations, E-Commerce oder Immobilien – die mit nur zwei Klicks Daten von jeder Website extrahieren wollen.

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Mit „KI-Felder vorschlagen“ liest Thunderbits KI die Seite, schlägt passende Spalten (z. B. Name, E-Mail, Preis) vor und erstellt sogar individuelle Extraktions-Prompts für jedes Feld.

- Unterseiten- & Paginierungs-Scraping: Du willst Detailseiten oder endloses Scrollen abdecken? Thunderbits KI folgt Links, erkennt Paginierung und fasst alle Daten in einer Tabelle zusammen.

- Sofort-Vorlagen: Für beliebte Seiten (Amazon, Zillow, Instagram, Shopify u. v. m.) gibt es fertige Vorlagen für 1-Klick-Scraping – ganz ohne Einrichtung.

- Kostenloser Datenexport: Exportiere deine Daten gratis nach Excel, Google Sheets, Airtable oder Notion. Auch als CSV oder JSON möglich.

- Bild-/E-Mail-/Telefon-Extraktion: Mit nur einem Klick Bilder, E-Mails und Telefonnummern von jeder Website extrahieren.

- No-Code, kein Aufwand: Kein Programmieren, keine Vorlagen, keine Wartung. Thunderbits KI passt sich automatisch an Webseitenänderungen an.

Kostenloser Tarif: Bis zu 6 Seiten pro Monat (oder 10 mit Gratis-Test). Wer mehr braucht, startet ab 15 $/Monat für 500 Credits.

Nutzerfeedback: Teams loben Thunderbit für die einfache Bedienung und hohe Genauigkeit – besonders bei unübersichtlichen Websites, an denen andere Scraper scheitern. Ideal für schnelle Lead-Listen, Produktüberwachung und Marktrecherche ().

Du willst es ausprobieren? und starte in weniger als einer Minute mit deinem ersten Scraping-Projekt.

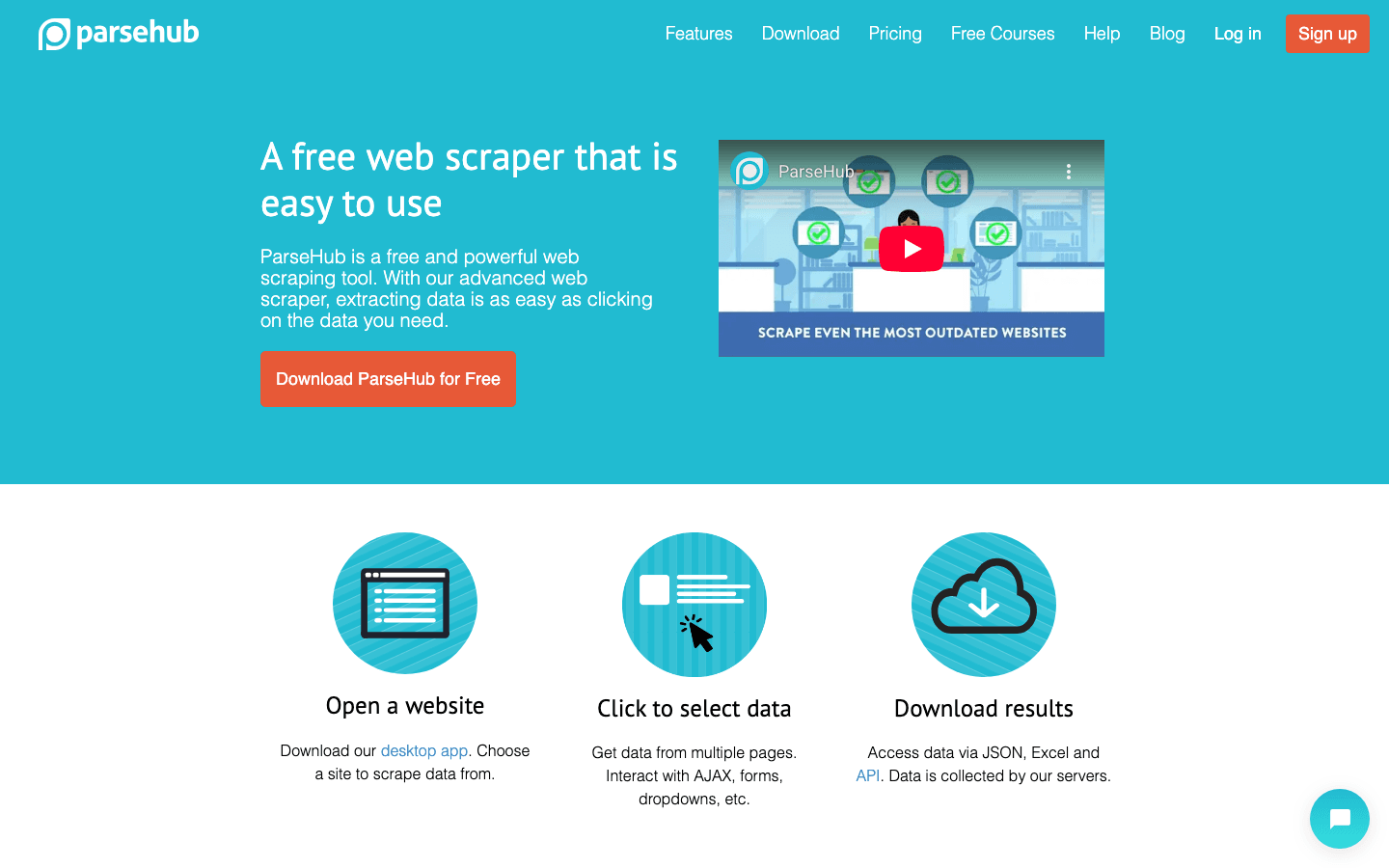

2. ParseHub

ist ein visuelles, No-Code-Web-Scraping-Tool, das besonders für Einsteiger und kleine Teams geeignet ist. Mit Machine Learning werden Elemente gruppiert, auch komplexe Seiten mit AJAX, Formularen und Bildern sind kein Problem.

ist ein visuelles, No-Code-Web-Scraping-Tool, das besonders für Einsteiger und kleine Teams geeignet ist. Mit Machine Learning werden Elemente gruppiert, auch komplexe Seiten mit AJAX, Formularen und Bildern sind kein Problem.

- Visuelles Point-and-Click: Einfach gewünschte Elemente anklicken, ParseHub erledigt den Rest.

- Bilderkennung & API: Bilder extrahieren, dynamische Inhalte verarbeiten und Daten per API abrufen.

- Cloud oder Desktop: Läuft in der Cloud oder lokal auf dem Rechner.

- Kostenloser Tarif: Bis zu 200 Seiten pro Durchlauf, 5 Projekte. Export als CSV oder JSON.

Ideal für: Kleine, visuelle Projekte wie Produktlisten oder Nachrichtenartikel. Der Einstieg ist einfach, für größere Projekte ist ein kostenpflichtiger Tarif nötig ().

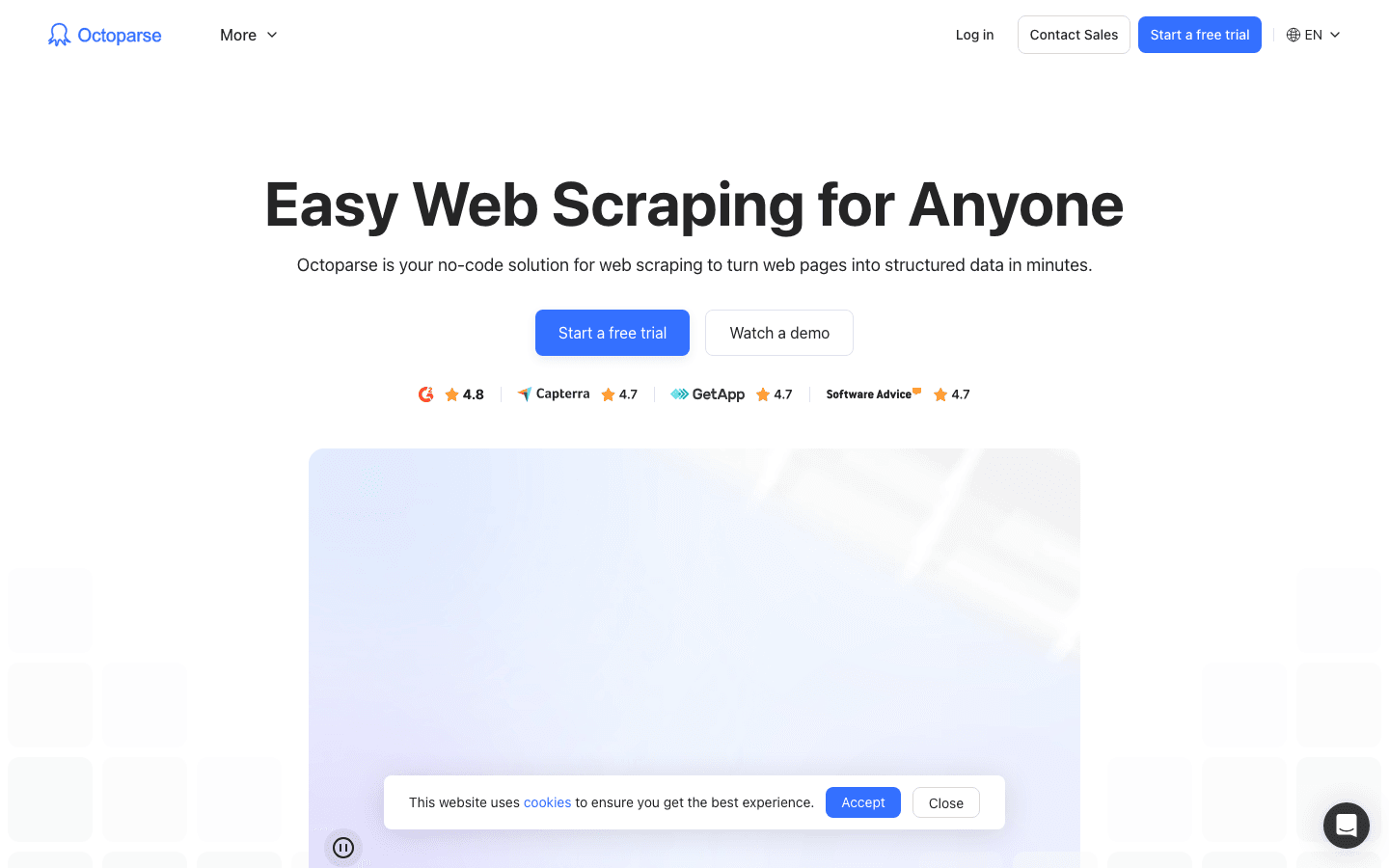

3. Octoparse

ist ein No-Code-Scraper für Desktop oder Cloud mit umfangreicher Vorlagenbibliothek und starken KI-Funktionen.

ist ein No-Code-Scraper für Desktop oder Cloud mit umfangreicher Vorlagenbibliothek und starken KI-Funktionen.

- KI-Auto-Erkennung: Octoparse erstellt Workflows automatisch, auch für JavaScript-lastige oder durch CAPTCHAs geschützte Seiten.

- Batch-Verarbeitung: Tausende Datensätze auf einmal extrahieren, Jobs planen, Logins und endloses Scrollen meistern.

- Kostenloser Tarif: 10.000 Datensätze pro Monat, Zugriff auf die meisten Kernfunktionen.

- Exportoptionen: CSV, Excel, Google Sheets und direkte API-Anbindung.

Ideal für: Teams, die dynamische Seiten oder wiederkehrende, große Projekte automatisieren wollen. Die Einarbeitung braucht etwas Zeit, aber die Dokumentation ist sehr hilfreich ().

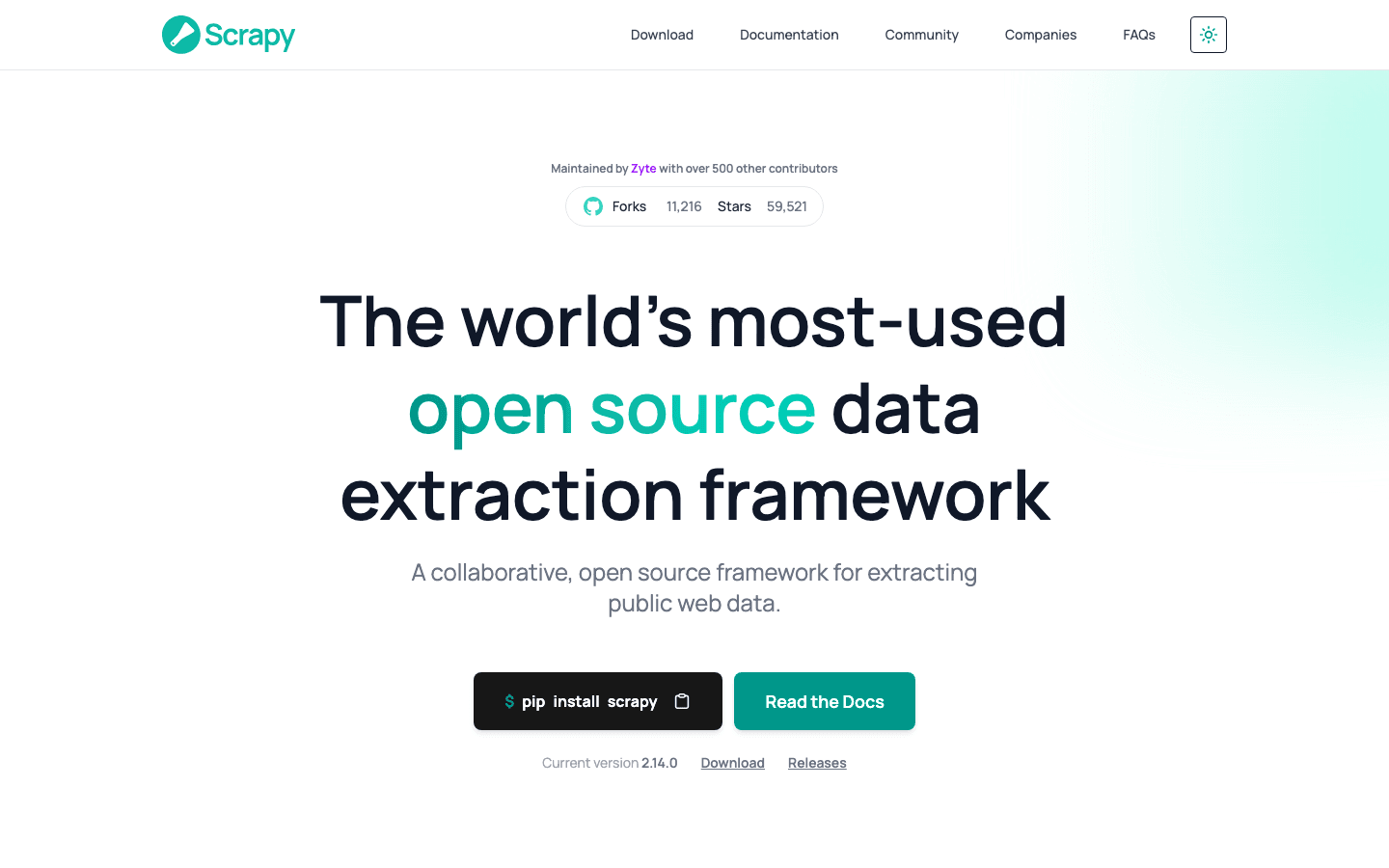

4. Scrapy

ist das weltweit beliebteste Open-Source-Framework für Web-Scraping mit Python. Hier ist Programmierkenntnis gefragt, dafür gibt es maximale Flexibilität für individuelle, große Projekte.

ist das weltweit beliebteste Open-Source-Framework für Web-Scraping mit Python. Hier ist Programmierkenntnis gefragt, dafür gibt es maximale Flexibilität für individuelle, große Projekte.

- Volle Flexibilität: Eigene Spider bauen, jede Seitenstruktur abdecken, KI-Module integrieren.

- Keine Nutzungsbeschränkung: Als Open Source kannst du so viel scrapen, wie deine Hardware hergibt.

- Erweiterbar: Viele Plugins und große Community.

Ideal für: Entwickler und technische Teams, die volle Kontrolle und Skalierbarkeit brauchen. Für Nicht-Programmierer nicht zu empfehlen ().

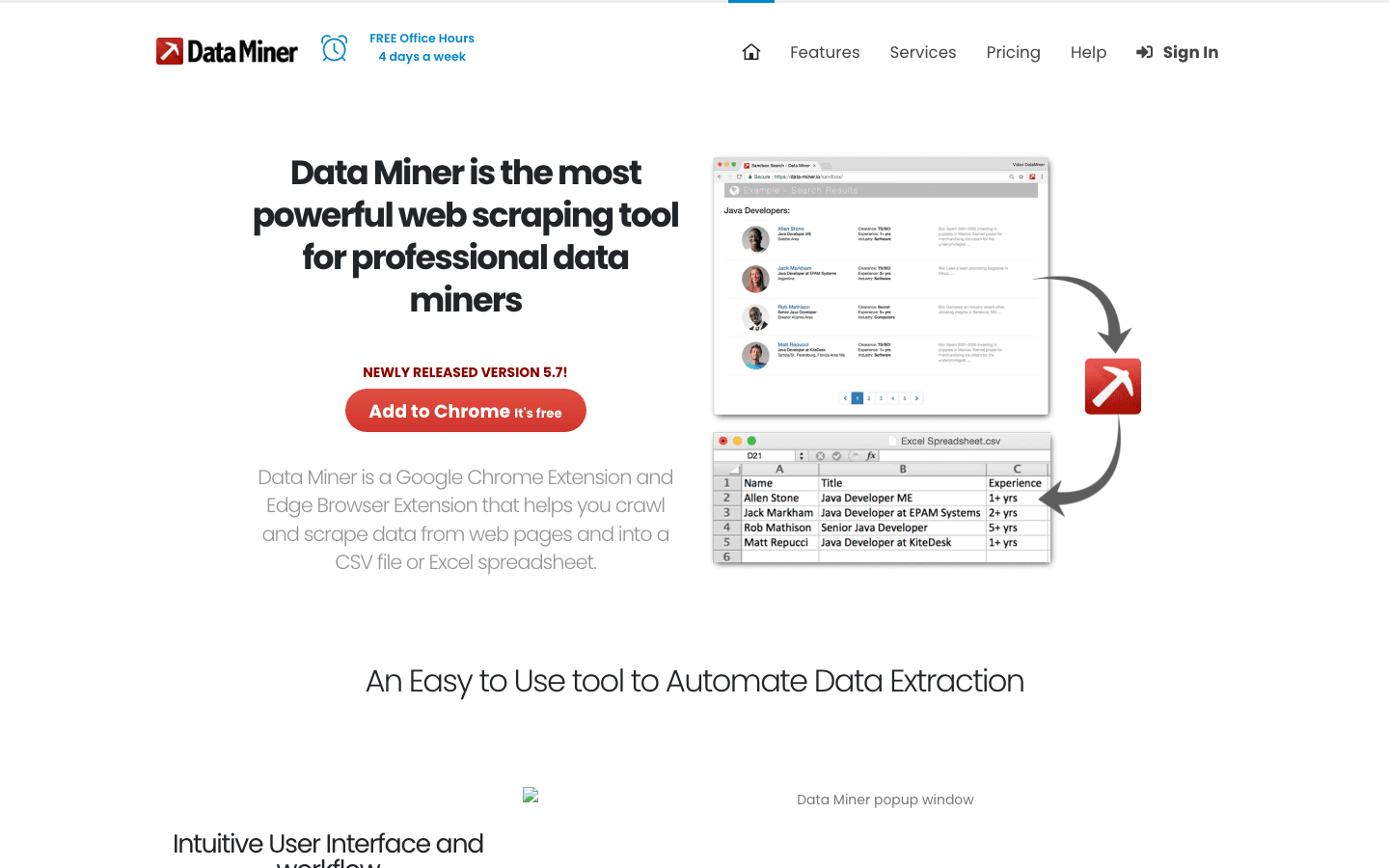

5. Data Miner

ist eine Chrome-/Edge-Erweiterung mit über 50.000 vorgefertigten „Rezepten“ zum Extrahieren von Tabellen, Listen und Kontaktdaten aus mehr als 15.000 bekannten Websites.

ist eine Chrome-/Edge-Erweiterung mit über 50.000 vorgefertigten „Rezepten“ zum Extrahieren von Tabellen, Listen und Kontaktdaten aus mehr als 15.000 bekannten Websites.

- 1-Klick-Scraping: Rezept auswählen, klicken, Daten erhalten.

- Paginierung & Autofill: Mehrseitige Listen und Formularausfüllung werden unterstützt.

- Kostenloser Tarif: Bis zu 500 Seiten pro Monat. Export als CSV, Excel oder Google Sheets.

Ideal für: Schnelle, tabellarische Datenerfassung – etwa für Lead-Listen oder Produktkataloge – ohne Einrichtung ().

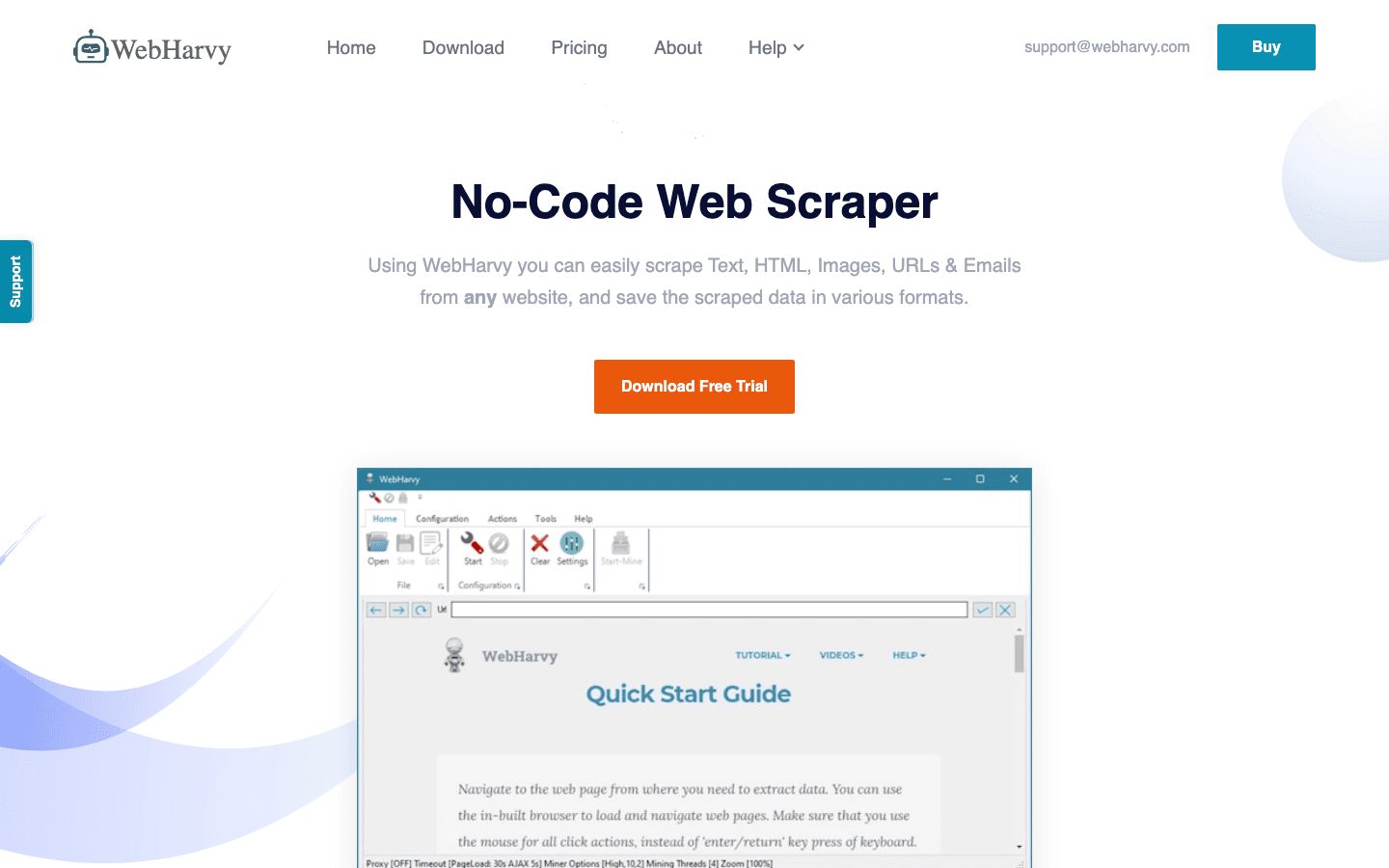

6. WebHarvy

ist ein Windows-Desktop-Scraper mit visueller Point-and-Click-Oberfläche und intelligenter Mustererkennung.

ist ein Windows-Desktop-Scraper mit visueller Point-and-Click-Oberfläche und intelligenter Mustererkennung.

- Mustererkennung: Ein Produkt anklicken, WebHarvy erkennt automatisch alle ähnlichen Elemente.

- Bild-Scraping: Bilder, E-Mails und URLs einfach herunterladen.

- Kostenlose Testversion: Kein dauerhaft kostenloser Tarif, aber eine Testversion ist verfügbar. Für die dauerhafte Nutzung ist eine Lizenz nötig.

Ideal für: E-Commerce-Teams oder alle, die viele Bilder oder Produktdaten extrahieren möchten ().

7. Dexi.io

ist eine cloudbasierte Plattform für fortgeschrittenes, skalierbares Web-Scraping und Workflow-Automatisierung.

ist eine cloudbasierte Plattform für fortgeschrittenes, skalierbares Web-Scraping und Workflow-Automatisierung.

- Visueller Workflow-Builder: Komplexe Scraping-Prozesse per Drag-and-Drop gestalten.

- API-Integrationen: Anbindung an Data Warehouse, CRM oder Analytics-Stack.

- Kostenlose Testversion: Begrenzte Testphase, kostenpflichtige Tarife ab 119 $/Monat.

Ideal für: Unternehmen oder Operations-Profis, die komplexe, wiederkehrende Datenaufgaben automatisieren wollen ().

8. Apify

ist eine Entwickler-freundliche Cloud-Plattform mit einem riesigen Marktplatz von über 6.000 fertigen „Actors“ (Scraping-Skripte) und voller API-Anbindung.

ist eine Entwickler-freundliche Cloud-Plattform mit einem riesigen Marktplatz von über 6.000 fertigen „Actors“ (Scraping-Skripte) und voller API-Anbindung.

- Marktplatz & Anpassung: Vorgefertigte Actors nutzen oder eigene in JavaScript/Python programmieren.

- Cloud-Ausführung & Planung: Jobs in der Cloud ausführen, wiederkehrende Scrapes planen, KI-Workflows integrieren.

- Kostenloser Tarif: 30 Compute-Einheiten pro Monat.

Ideal für: Technische Teams, die individuelle Workflows automatisieren oder Scraping-Pipelines skalieren wollen ().

9. Import.io

ist eine Enterprise-Plattform für KI-gestützte Datenerfassung mit Fokus auf strukturierte Daten und Compliance.

ist eine Enterprise-Plattform für KI-gestützte Datenerfassung mit Fokus auf strukturierte Daten und Compliance.

- KI-Selektoren: Passt sich automatisch an veränderte Webseitenlayouts an.

- Datenaufbereitung: Daten vor dem Export bereinigen, anreichern und transformieren.

- Kostenlose Testversion: 14 Tage gratis, danach kostenpflichtig ab 249 $/Monat.

Ideal für: Unternehmen, die große, konforme Datenfeeds für BI oder Analytics benötigen ().

10. Diffbot

ist eine KI-basierte Plattform, die mit NLP und Computer Vision strukturierte Daten aus jeder Webseite extrahiert – ganz ohne Einrichtung.

ist eine KI-basierte Plattform, die mit NLP und Computer Vision strukturierte Daten aus jeder Webseite extrahiert – ganz ohne Einrichtung.

- Knowledge Graph: Erkennt automatisch Personen, Produkte, Artikel und mehr.

- API-Zugriff: Strukturierte Daten per API für Newsfeeds, Analysen oder Forschung abrufen.

- Kostenloser Tarif: 10.000 Credits pro Monat für Extract-, NLP- und Knowledge-Graph-APIs.

Ideal für: Teams, die hochwertige, strukturierte Daten aus News-, Produkt- oder Diskussionsseiten benötigen ().

11. VisualScraper

ist ein einfaches, visuelles Web-Scraping-Tool für Einsteiger.

ist ein einfaches, visuelles Web-Scraping-Tool für Einsteiger.

- Kein Programmieren nötig: Felder auswählen und loslegen.

- Mehrseitige Unterstützung: Mehrere Seiten in Echtzeit scrapen.

- Kostenloser Tarif: Unbegrenzte Nutzung der Basisfunktionen. Export als CSV, JSON, XML oder SQL.

Ideal für: Schnelle, einmalige Extraktionen öffentlicher Daten – etwa News, Foren oder kleine Verzeichnisse ().

12. Portia by Scrapinghub

ist ein Open-Source-Web-Scraper mit visueller Oberfläche, bei dem du Seiten im Browser annotierst, um einen Spider zu trainieren – ganz ohne Code.

ist ein Open-Source-Web-Scraper mit visueller Oberfläche, bei dem du Seiten im Browser annotierst, um einen Spider zu trainieren – ganz ohne Code.

- Drag-and-Drop-Oberfläche: Elemente anklicken, Portia erkennt die Extraktionsregeln.

- Open Source: Kostenlos nutzbar, aber seit 2018 ohne offiziellen Support.

- Scrapy-Integration: Export über Scrapy-Pipelines.

Ideal für: Technikaffine Teams, die eine kostenlose, visuelle Alternative zu Code-basierten Scrapern suchen ().

Schnellvergleich: Die besten kostenlosen KI 웹 스크래퍼 im Überblick

| Tool | Benutzerfreundlichkeit | KI-/Smart-Features | Kostenlose Nutzung | Exportoptionen | Ideal für |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ (2-Klick) | KI-Feldvorschlag, Unterseiten/Paginierung | 6 Seiten/Monat (10 Test) | Excel, Sheets, Airtable, Notion, CSV | Nicht-technische Teams, schnelle Webdaten |

| ParseHub | ★★★★☆ (visuelle UI) | ML-Elementgruppierung, API | 200 Seiten/Lauf, 5 Projekte | CSV, JSON, API | Kleine Projekte, AJAX/JS-Seiten |

| Octoparse | ★★★★☆ (visuelle UI) | KI-Auto-Erkennung, JS/CAPTCHA-Support | 10.000 Datensätze/Monat | CSV, Excel, Sheets, API | Dynamische Seiten, Planung, Cloud-Jobs |

| Scrapy | ★★☆☆☆ (Code nötig) | Erweiterbar, Open Source | Unbegrenzt (Open Source) | Beliebig (programmatisch) | Entwickler, individuelle/große Projekte |

| Data Miner | ★★★★☆ (Browser-Ext.) | 50k+ Rezepte, Selektor-Finder | 500 Seiten/Monat | CSV, Excel, Sheets | Schnelle tabellarische/Kontaktdaten |

| WebHarvy | ★★★★☆ (visuelle UI) | Mustererkennung, Bild-Scraping | Testversion (Lizenz nötig) | CSV, SQL, Excel | E-Commerce, Produktbilder |

| Dexi.io | ★★★☆☆ (Cloud-App) | Workflow-Automatisierung, APIs | Testversion | JSON, CSV, Integrationen | Unternehmen, komplexe Workflows |

| Apify | ★★★☆☆ (Entwickler) | Actor-Marktplatz, API | 30 Compute-Einheiten/Monat | JSON, API, Webhooks | Individuelle Automatisierung, Dev-Teams |

| Import.io | ★★★☆☆ (Enterprise) | KI-Selektoren, Compliance-Features | 14 Tage Test | CSV, Excel, Datenbanken | Große, regulierte Datenmengen |

| Diffbot | ★★★☆☆ (API/UI) | NLP, Vision, Knowledge Graph | 10.000 Credits/Monat | JSON, API | Hochwertige Entitäten-/News-/Produktdaten |

| VisualScraper | ★★★☆☆ (Web-UI) | Point-and-Click-Auswahl | Unbegrenzt (Basis) | CSV, JSON, XML, SQL | Einfache, geplante, mehrseitige Scrapes |

| Portia | ★★★☆☆ (Browser-UI) | Visueller Scrapy-Wrapper | Unbegrenzt (Open Source) | JSON, XML (über Scrapy) | Kostenlose visuelle Scraper für Tech-Teams |

So findest du das passende kostenlose KI-Web-Scraping-Tool

Hier meine Schnellübersicht zur Auswahl:

- Einsteiger/No-Code: Thunderbit, ParseHub, Data Miner oder VisualScraper liefern am schnellsten Ergebnisse.

- Komplexe/dynamische Seiten: Octoparse, Dexi.io oder ParseHub meistern JavaScript-lastige oder schwierige Layouts.

- Große/individuelle Projekte: Scrapy, Apify oder Import.io sind ideal für Entwickler oder Unternehmen.

- Bilder/Produktdaten: WebHarvy und Thunderbit sind stark bei der Extraktion von Bildern und strukturierten Produktinfos.

- Strukturierte Wissensdaten/Entitäten: Diffbot ist die erste Wahl für hochwertige, KI-angereicherte Daten.

- Open Source/Community: Scrapy und Portia sind dauerhaft kostenlos, wenn du etwas Technikaffinität mitbringst.

Tipp: Schau dir immer die Limits und Exportmöglichkeiten des kostenlosen Tarifs an, bevor du ein großes Projekt startest. Und denk dran: „Kostenlos“ heißt nicht automatisch „am besten für deinen Workflow“. Wähle das Tool, das zu deinem Anwendungsfall (Lead-Generierung, Wettbewerbsbeobachtung, Recherche etc.) passt.

Fazit: Mit den besten kostenlosen KI 웹 스크래퍼 echten Mehrwert schaffen

KI-gestütztes Web-Scraping ist längst nicht mehr nur etwas für Entwickler oder Datenexperten. Mit dem richtigen kostenlosen Tool kann jeder die Datenerfassung automatisieren, Workflows optimieren und wertvolle Einblicke gewinnen. Egal ob du eine Lead-Liste aufbaust, Preise überwachst oder einfach keine Lust mehr auf Copy-Paste hast – in dieser Liste findest du garantiert das passende Tool, das dir Zeit und Nerven spart.

Wenn du besonders einfach starten willst – vor allem bei unübersichtlichen, schwer zu scrapenden Seiten – überzeugt mit KI-Feldvorschlägen, Unterseiten-Scraping und direktem Export in deine Lieblings-Apps. Probier aber ruhig mehrere Tools aus, um das beste für dich zu finden.

Bereit, manuelle Dateneingabe hinter dir zu lassen? Lade einen kostenlosen KI 웹 스크래퍼 herunter, probiere ihn aus und erlebe, wie deine Produktivität (und Datenqualität) durch die Decke geht.

Weitere Tipps, Deep Dives und Tutorials rund ums Web-Scraping findest du im .

Häufige Fragen (FAQ)

1. Was ist ein KI-basierter 웹 스크래퍼 und wie unterscheidet er sich von klassischen Scrapern?

Ein KI 웹 스크래퍼 nutzt künstliche Intelligenz, um Daten automatisch auf Webseiten zu erkennen, zu extrahieren und zu strukturieren – meist ganz ohne Programmierung. Im Gegensatz zu klassischen Scrapern, die auf feste Vorlagen oder manuelle Einrichtung setzen, passen sich KI-Scraper flexibel an Webseitenänderungen an und kommen auch mit unstrukturierten Daten zurecht.

2. Gibt es wirklich kostenlose KI 웹 스크래퍼 für Unternehmen?

Ja! Tools wie , ParseHub, Octoparse und Data Miner bieten alle kostenlose Tarife mit großzügigen Funktionen. Prüfe aber immer die jeweiligen Limits (Seiten pro Monat, Exportoptionen), um sicherzugehen, dass sie zu deinem Bedarf passen.

3. Welcher kostenlose KI 웹 스크래퍼 ist am besten für Nicht-Techniker geeignet?

Thunderbit, ParseHub, Data Miner und VisualScraper sind alle für Anwender ohne Programmierkenntnisse konzipiert. Thunderbit sticht durch den 2-Klick-Workflow und die KI-Feldvorschläge besonders hervor – ideal für Vertrieb, Operations und Marketing.

4. Kann ich mit diesen Tools auch Bilder, E-Mails oder Telefonnummern extrahieren?

Ja! Thunderbit, WebHarvy und Data Miner unterstützen die Extraktion von Bildern, E-Mails und Telefonnummern. Bitte beachte immer die geltenden Datenschutzgesetze und nutze die gewonnenen Kontaktdaten verantwortungsvoll.

5. Wie entscheide ich zwischen No-Code- und Code-basierten Scrapern?

Wenn du Wert auf Schnelligkeit und Einfachheit legst, starte mit einem No-Code-Tool wie Thunderbit oder ParseHub. Für maximale Anpassbarkeit, große Automatisierung oder Systemintegration sind Code-basierte Tools wie Scrapy oder Apify die bessere Wahl.

Viel Erfolg beim Scrapen – und möge deine Daten stets sauber, strukturiert und einsatzbereit sein.

Mehr erfahren