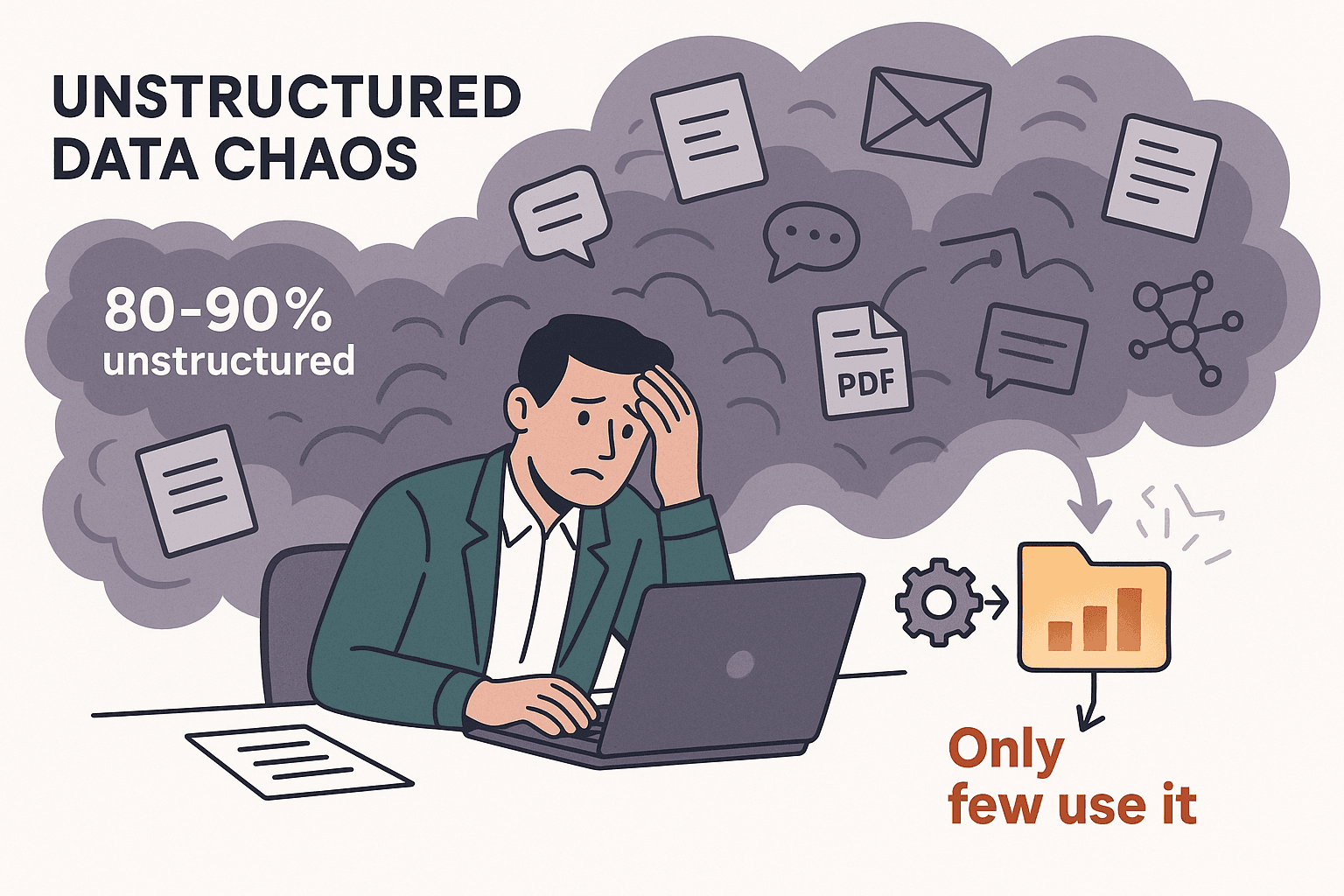

Hast du dich schon mal dabei ertappt, wie du stundenlang Webseiten, Tabellen oder PDFs durchforstest und dir denkst: „Da muss es doch einen smarteren Weg geben, an diese Daten zu kommen“? Damit bist du echt nicht allein. Ich habe selbst jahrelang Automatisierungstools gebaut und mit Teams gesprochen, die das ewige Copy-Paste einfach nicht mehr sehen können. Fakt ist: 2025 wird die Datenflut immer größer – 80–90 % aller neuen Unternehmensdaten sind unstrukturiert, und nur ein kleiner Teil der Firmen nutzt sie wirklich clever (). Manuelle Datenerfassung? Die ist nicht nur nervig, sondern kostet auch richtig Geld, ist fehleranfällig und bremst die Produktivität total aus.

Genau hier kommen Data Extractors ins Spiel. Egal ob Vertrieb, Operations, E-Commerce oder Forschung – das richtige Tool spart dir locker Stunden (oder sogar Tage), macht die Daten genauer und gibt deinem Team endlich Zeit für die wirklich wichtigen Sachen. Aber bei so vielen Tools – von KI-basierten Chrome-Add-ons über No-Code-Plattformen bis hin zu Entwickler-Frameworks – wie findest du das passende? Ich habe die 12 besten Data Extractors für 2025 genau unter die Lupe genommen, ihre Stärken, Schwächen und Einsatzbereiche verglichen. Los geht’s!

Warum Unternehmen Data Extractors für maximale Effizienz brauchen

Mal ehrlich: 94 % der Unternehmen schlagen sich mit zeitraubenden, immer gleichen Aufgaben herum wie manueller Dateneingabe (). Und das kostet nicht nur Nerven – manuelle Datenerfassung kann pro Mitarbeiter bis zu 1.500 $ im Monat verschlingen (). Data Extractors nehmen dir diese Fleißarbeit ab und bringen dir:

- Bis zu 77 % Zeitersparnis bei der Datenerfassung ().

- 40 % mehr Effizienz in den Abläufen ().

- Verarbeitungszeiten halbieren oder mehr ().

- Bis zu 99,9 % Genauigkeit bei der Dokumentenerfassung ().

Das Ergebnis? Schnellere Entscheidungen, bessere Datenqualität und ein zufriedeneres Team. Egal ob du Leads sammelst, Preise der Konkurrenz checkst oder Daten in deine BI-Tools schiebst – ein guter Extractor ist wie ein digitaler Assistent, der nie müde wird (und nie nach einer Gehaltserhöhung fragt).

Worauf du bei der Auswahl eines Data Extractors achten solltest

Nicht jeder Data Extractor ist gleich. Hier die wichtigsten Punkte, auf die ich immer schaue:

- Benutzerfreundlichkeit: Kommen auch Nicht-Techies direkt klar? Gibt’s KI-Features oder Point-and-Click?

- Anpassbarkeit & Flexibilität: Kommt das Tool mit komplexen Seiten, Logins oder dynamischen Inhalten klar? Gibt’s Scripting für Profis?

- Unterstützte Datentypen: Werden Text, Zahlen, Bilder, E-Mails, Telefonnummern, PDFs usw. extrahiert?

- Skalierbarkeit & Performance: Schafft das Tool tausende Seiten? Gibt’s Cloud- oder Multi-Threading?

- Integration & Automatisierung: Kannst du direkt nach Excel, Google Sheets, Airtable, Notion exportieren oder per API anbinden?

- Preis-Leistung: Gibt’s eine Gratis-Version? Sind die Bezahlmodelle fair für deinen Use Case?

- Support & Community: Gibt’s gute Dokus, Tutorials und schnellen Support?

Je nach Team sind diese Punkte unterschiedlich wichtig. Im Vertrieb zählt oft die einfache Bedienung und der schnelle Export, Entwickler wollen maximale Anpassbarkeit und API-Zugriff.

Data Extractors für E-Commerce und Marktforschung

Gerade im E-Commerce und in der Marktforschung sind aktuelle Daten Gold wert – zum Beispiel für Preisvergleiche, Produktbewertungen oder Wettbewerbsanalysen. Hier brauchst du Tools, die große Datenmengen, Anti-Bot-Maßnahmen und Zeitpläne meistern.

- : Bekannt für seine No-Code-Oberfläche und hunderte Vorlagen für Amazon, eBay & Co. Ideal für Preisüberwachung und Review-Analysen.

- : Starke Integration von Webdaten in BI-Tools, mit Zeitplanung und Änderungsbenachrichtigungen. Perfekt für Marktforscher, die kontinuierliche Datenströme brauchen.

- : Enterprise-Lösung mit Workflow-Automatisierung und Datenaufbereitung. Wird von großen Händlern für Wettbewerbsanalysen und Preisbeobachtung genutzt.

Diese Tools sind auf Skalierbarkeit ausgelegt und kommen mit den Anti-Scraping-Mechanismen großer E-Commerce-Seiten klar.

Data Extractors für Entwickler und individuelle Workflows

Wenn du Entwickler im Team hast (oder selbst gerne coden willst), sind diese Tools besonders flexibel:

- : Der Python-Standard für Web-Scraping. Open Source, extrem anpassbar und für große Projekte gemacht. Ideal für eigene Crawler oder die Integration in eigene Anwendungen.

- : Visueller Workflow-Builder, der auch mit JavaScript-lastigen Seiten klarkommt. Unterstützt bedingte Logik, eigenes JS und API-Zugriff.

- : Cloud-Plattform für eigene Scraping-Skripte („Actors“) in JavaScript oder Python. Perfekt für automatisierte Workflows, Headless-Browser und Skalierung in der Cloud.

Diese Tools sind top, wenn du komplexe Seiten scrapen, mehrstufige Abläufe automatisieren oder etwas bauen willst, das mit einfachen Point-and-Click-Tools nicht geht.

Data Extractors für Datenintegration und Workflow-Automatisierung

Manche Teams brauchen mehr als Rohdaten – sie wollen den kompletten Prozess von der Extraktion bis zur Analyse automatisieren:

- : Wie erwähnt, glänzt es bei der Integration von Webdaten in BI-Dashboards, mit Zeitplanung und API.

- : Entwickelt für End-to-End-Automatisierung, inklusive Datenbereinigung, Transformation und Anbindung an CRMs, Datenbanken usw.

- : Enterprise-Plattform mit Scripting, Fehlerbehandlung und tiefen Integrationsmöglichkeiten. Wird von großen Unternehmen für kritische Datenaggregation genutzt.

Wenn dein Workflow mehrere Schritte umfasst oder Daten direkt in bestehende Systeme fließen sollen, sind das die passenden Extractors.

Vergleichstabelle: Die 12 besten Data Extractors im Überblick

Hier ein schneller Vergleich, damit du direkt siehst, welches Tool zu dir passt:

| Tool Name | Benutzerfreundlichkeit | Bester Anwendungsfall | Preisgestaltung | Anpassbarkeit | Unterstützte Datentypen |

|---|---|---|---|---|---|

| Thunderbit | ⭐ Sehr einfach | Alle Branchen, Nicht-Techniker | Kostenlos & Bezahlt | Low-Code KI-Prompts | Text, Zahlen, Daten, URLs, E-Mails, Telefonnummern, Bilder, PDFs |

| Octoparse | 🙂 Mittel | E-Commerce, Marktforschung | Kostenlos & Bezahlt | Hoch (visuell, Regex) | Text, Zahlen, URLs, Bilder |

| ParseHub | 🙂 Mittel | Dynamische Seiten, Tech-User | Bezahlt | Hoch (JS, Logik) | Text, Zahlen, URLs, Bilder |

| Import.io | 😀 Einfach | Datenintegration, BI | Bezahlt (Enterprise) | Mittel | Text, Tabellen, Listen |

| Scrapy | 😐 Anspruchsvoll | Individuelle Entwicklung, groß | Kostenlos (Open Source) | Sehr hoch (Code) | Beliebig (entwicklerdefiniert) |

| Apify | 😐 Anspruchsvoll | Workflow-Automatisierung, Devs | Kostenlos & Bezahlt | Sehr hoch (Code) | Jeglicher Web-Content |

| Dexi.io | 🙂 Mittel | Enterprise, Workflows | Bezahlt (Enterprise) | Hoch (visuell, Script) | Text, Bilder, Dateien |

| WebHarvy | 😀 Einfach | Kleine Unternehmen, statische Seiten | Einmalige Lizenz | Niedrig-Mittel | Text, Zahlen, URLs, Bilder |

| Data Miner | 😀 Einfach | Schneller Web-zu-Tabelle-Export, Vertrieb | Kostenlos & Bezahlt | Mittel (Rezepte) | Text, Tabellen, Listen |

| Visual Web Ripper | 🙂 Mittel | Große statische Seiten, komplexe Logik | Einmalige Lizenz | Hoch (Vorlagen, API) | Text, Bilder, Dateien |

| Helium Scraper | 🙂 Mittel | Individuelle Logik, relationale Daten | Einmalige Lizenz | Hoch (JS, SQL) | Text, URLs, Bilder, Dateien |

| Content Grabber | 🙂 Mittel | Enterprise, Automatisierung | Bezahlt (Enterprise) | Sehr hoch (Scripting) | Jeglicher Content, strukturierter Export |

Legende: 😀 Einfach (für Nicht-Techniker), 🙂 Mittel (gewisse Einarbeitung), 😐 Anspruchsvoll (Programmierung nötig)

1. Thunderbit

ist meine absolute Empfehlung für alle, die ohne Technik-Know-how schnell und easy Daten extrahieren wollen. Als richtet sich Thunderbit an Business-User – Vertrieb, Operations, Immobilien, E-Commerce – die einfach nur die Daten brauchen, ohne sich mit Technik zu stressen.

ist meine absolute Empfehlung für alle, die ohne Technik-Know-how schnell und easy Daten extrahieren wollen. Als richtet sich Thunderbit an Business-User – Vertrieb, Operations, Immobilien, E-Commerce – die einfach nur die Daten brauchen, ohne sich mit Technik zu stressen.

Hauptfunktionen:

- KI-Spaltenvorschläge: Ein Klick, und Thunderbits KI erkennt die wichtigsten Felder auf der Seite – ganz ohne manuelles Setup.

- 2-Klick-Scraping: Felder bestätigen, auf „Scrapen“ klicken, fertig. So einfach, dass sogar meine Mutter es könnte (und die ruft mich sonst bei jedem WLAN-Problem an).

- Subseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch Unterseiten (z. B. Produkt- oder Profilseiten) und ergänzt deine Tabelle.

- Kostenloser Datenexport: Ergebnisse direkt nach Excel, Google Sheets, Airtable oder Notion schicken – ohne Zusatzkosten.

- E-Mail-, Telefon- und Bilderkennung mit einem Klick: Perfekt für Lead-Generierung oder Kontaktdaten-Extraktion.

- Cloud- oder Browser-Scraping: Wähle zwischen schnellem Cloud-Scraping für öffentliche Seiten oder Browser-Modus für eingeloggte Bereiche.

- Unterstützt 34 Sprachen: Super für internationale Teams.

Vorteile: Extrem einfach, kein Coding, erkennt unstrukturierte Daten und passt sich automatisch an Webseitenänderungen an. Für kleine Aufgaben kostenlos, günstige Tarife für größere Projekte.

Nachteile: Nicht so flexibel wie Entwickler-Tools bei sehr komplexen Seiten. Credit-basiertes Preismodell für Vielnutzer.

Ideal für: Vertriebsteams, E-Commerce, Makler und alle, die in unter fünf Minuten von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ kommen wollen. .

2. Octoparse

ist ein echtes Power-Tool für E-Commerce- und Marktforschungsteams. Die No-Code-Desktop-App (Windows) bietet einen visuellen Workflow-Builder und hunderte Vorlagen für Seiten wie Amazon, eBay und Zillow.

ist ein echtes Power-Tool für E-Commerce- und Marktforschungsteams. Die No-Code-Desktop-App (Windows) bietet einen visuellen Workflow-Builder und hunderte Vorlagen für Seiten wie Amazon, eBay und Zillow.

Hauptfunktionen:

- Point-and-Click-Oberfläche: Scraping-Aufgaben durch einfaches Anklicken der Seitenelemente erstellen.

- Cloud-Scraping & Zeitplanung: Mit Bezahlplänen lassen sich Jobs in der Cloud ausführen und regelmäßig automatisieren.

- IP-Rotation & Anti-Bot: Integrierte Proxy- und Captcha-Lösungen für Seiten mit Scraper-Schutz.

- Vorlagenbibliothek: Über 500 fertige Templates für gängige Websites.

- Mehrstufiges & paginiertes Scraping: Komplexe Navigation und Detailseiten werden unterstützt.

Vorteile: Ideal für großflächiges Preis-Tracking, Review-Analysen und E-Commerce-Monitoring. Meist kein Coding nötig.

Nachteile: Nur für Windows, kann bei intensiver Nutzung teuer werden, und für komplexe Workflows ist Einarbeitung nötig.

Ideal für: E-Commerce-Analysten, Marktforscher und alle, die viele Produkte oder Wettbewerber im Blick behalten müssen.

3. ParseHub

ist ein flexibler visueller Scraper, der besonders bei dynamischen, JavaScript-lastigen Seiten punktet. Die Desktop-App (Windows, Mac, Linux) bietet einen Workflow-Builder mit bedingter Logik, eigenem JS und API-Zugriff.

ist ein flexibler visueller Scraper, der besonders bei dynamischen, JavaScript-lastigen Seiten punktet. Die Desktop-App (Windows, Mac, Linux) bietet einen Workflow-Builder mit bedingter Logik, eigenem JS und API-Zugriff.

Hauptfunktionen:

- Dynamische Inhalte: Funktioniert mit Single-Page-Apps, AJAX und interaktiven Seiten.

- Workflows & Scripting: Mehrstufige Abläufe, eigenes JS und Regex für Feintuning.

- Cloud- & lokale Ausführung: Jobs lokal oder in der Cloud (bezahlt) ausführen.

- API-Zugriff: Scraping in eigene Apps integrieren oder per Webhook automatisieren.

Vorteile: Sehr anpassbar für Technikaffine, meistert komplexe Seiten und unterstützt ausgefeilte Logik.

Nachteile: Bei großen Jobs langsamer, gewisse Lernkurve, Cloud-Ausführung kostet extra.

Ideal für: Technische Analysten, Entwickler oder alle, die interaktive Seiten scrapen müssen.

4. Import.io

ist auf die Integration von Webdaten in Business-Intelligence-Workflows spezialisiert. Die webbasierte Plattform bietet eine Point-and-Click-Oberfläche sowie starke Zeitplan- und API-Funktionen.

ist auf die Integration von Webdaten in Business-Intelligence-Workflows spezialisiert. Die webbasierte Plattform bietet eine Point-and-Click-Oberfläche sowie starke Zeitplan- und API-Funktionen.

Hauptfunktionen:

- Automatische Tabellenerkennung: URL einfügen, Import.io erkennt strukturierte Daten automatisch.

- Zeitplanung & Änderungsbenachrichtigung: Jobs regelmäßig ausführen und bei Datenänderungen benachrichtigt werden.

- API-Integration: Daten programmatisch abrufen oder in BI-Tools einspeisen.

- Datenaufbereitung: Daten direkt in der Plattform bereinigen und formatieren.

Vorteile: Benutzerfreundlich, ideal für Business-Analysten, starke Integration mit Analyse-Tools.

Nachteile: Enterprise-Preise, eingeschränkt bei sehr interaktiven Seiten, weniger Kontrolle für Profis.

Ideal für: Marktforschung, Business-Analysten und Operations-Teams, die kontinuierliche Datenströme benötigen.

5. Scrapy

ist das Open-Source-Framework für Python, das Entwickler lieben. Wer volle Kontrolle, Skalierbarkeit und eigene Crawler bauen will, ist hier richtig.

ist das Open-Source-Framework für Python, das Entwickler lieben. Wer volle Kontrolle, Skalierbarkeit und eigene Crawler bauen will, ist hier richtig.

Hauptfunktionen:

- Asynchrones Crawling: Schnell, effizient und für große Projekte gemacht.

- Vollständige Code-Kontrolle: Spiders in Python schreiben, jeden Schritt anpassen und mit beliebigen Systemen integrieren.

- Middleware & Plugins: Proxies rotieren, Logins verwalten, Community-Plugins nutzen.

- Strukturierte Ausgabe: Export nach JSON, CSV, Datenbanken oder eigene Formate.

Vorteile: Kostenlos, extrem flexibel, große Community.

Nachteile: Python-Kenntnisse nötig, keine grafische Oberfläche, Wartung liegt beim Nutzer.

Ideal für: Entwickler, Data Engineers und alle, die Scraping in eigene Apps oder Datenpipelines integrieren wollen.

6. Apify

ist eine Cloud-Plattform zum Ausführen und Teilen von Scraping-Skripten („Actors“) in JavaScript oder Python. Perfekt für Automatisierung, Workflow-Verkettung und Skalierung in der Cloud.

ist eine Cloud-Plattform zum Ausführen und Teilen von Scraping-Skripten („Actors“) in JavaScript oder Python. Perfekt für Automatisierung, Workflow-Verkettung und Skalierung in der Cloud.

Hauptfunktionen:

- Actors & SDK: Eigene Skripte schreiben oder vorgefertigte Actors aus dem Apify Store nutzen.

- Headless-Browser-Automatisierung: Dynamische Seiten scrapen, Logins verwalten, Webaufgaben automatisieren.

- Workflow-Verkettung: Einen Actor nach dem anderen auslösen, mehrstufige Abläufe automatisieren.

- API & Integrationen: Anbindung an Zapier, Make, Google Drive, AWS und mehr.

Vorteile: Leistungsstark für Entwickler, skalierbar, ideal für komplexe Automatisierungen.

Nachteile: Coding für individuelle Aufgaben nötig, nutzungsbasierte Preise können sich summieren, gewisse Lernkurve.

Ideal für: Startups, Entwicklerteams und alle, die cloudbasiertes, automatisiertes Scraping im großen Stil brauchen.

7. Dexi.io

(früher CloudScrape) ist eine Enterprise-Plattform für automatisierte Datenerfassung und -integration. Hier geht es um End-to-End-Workflows von der Extraktion bis zur Datenaufbereitung und -auslieferung.

(früher CloudScrape) ist eine Enterprise-Plattform für automatisierte Datenerfassung und -integration. Hier geht es um End-to-End-Workflows von der Extraktion bis zur Datenaufbereitung und -auslieferung.

Hauptfunktionen:

- Visueller Robot-Designer: Mehrstufige Workflows mit Point-and-Click-Logik erstellen.

- Cloud-Ausführung & Zeitplanung: Roboter in der Cloud ausführen, regelmäßige Jobs planen, große Datenmengen verarbeiten.

- Datenverarbeitung & Integration: Daten bereinigen, transformieren und an CRMs, Datenbanken oder APIs exportieren.

- Enterprise-Features: Benutzerverwaltung, Compliance, On-Premise-Optionen.

Vorteile: Skalierbar, leistungsstark für komplexe Workflows, starke Integrationsmöglichkeiten.

Nachteile: Enterprise-Preise, nicht für Einsteiger, für fortgeschrittene Nutzung ist Training nötig.

Ideal für: Große Unternehmen, Retail-Intelligence-Teams und alle, die mehrstufige Datenpipelines automatisieren wollen.

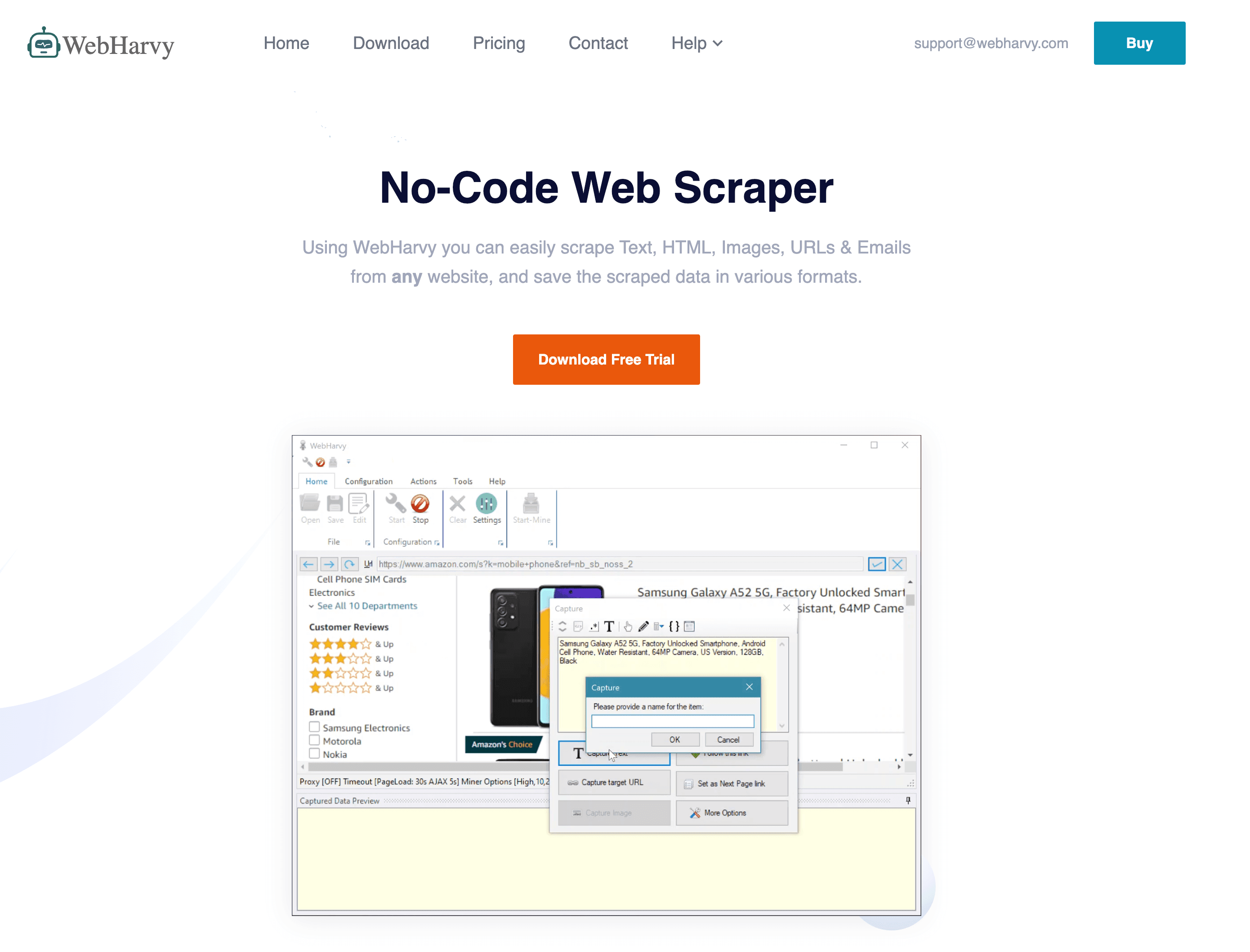

8. WebHarvy

ist ein Windows-Desktop-Scraper, der für seine einfache Point-and-Click-Bedienung und das Einmal-Lizenzmodell bekannt ist.

ist ein Windows-Desktop-Scraper, der für seine einfache Point-and-Click-Bedienung und das Einmal-Lizenzmodell bekannt ist.

Hauptfunktionen:

- Visuelle Auswahl: Elemente im integrierten Browser anklicken, um Felder zu definieren.

- Automatische Mustererkennung: Listen und Tabellen werden automatisch erkannt.

- Bilder- & Dateidownload: Extrahiert Bilder und Dokumente ebenso wie Text.

- Zeitplanung: Automatisierte Ausführung über den Windows Task Scheduler.

Vorteile: Günstige Einmalzahlung, einfach für einfache Seiten, funktioniert offline.

Nachteile: Schwächen bei JavaScript-lastigen oder Anti-Bot-Seiten, nur für Windows, eingeschränkte Anpassbarkeit.

Ideal für: Kleine Unternehmen, Forscher und alle, die ein günstiges, unkompliziertes Tool für statische Seiten suchen.

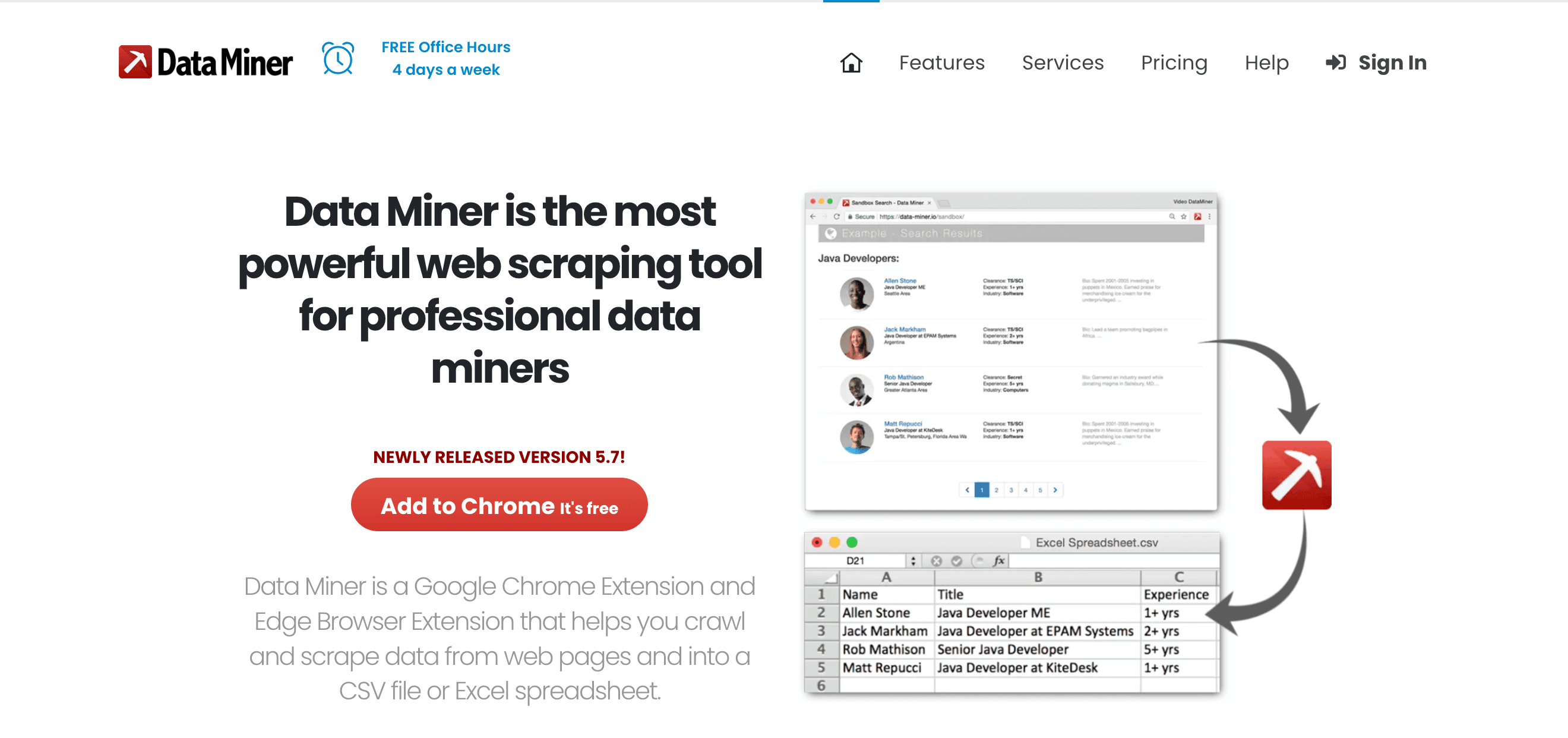

9. Data Miner

ist eine Chrome/Edge-Erweiterung, die sich perfekt für schnelle, vorlagenbasierte Web-Extraktion eignet – besonders für Vertrieb und Operations.

ist eine Chrome/Edge-Erweiterung, die sich perfekt für schnelle, vorlagenbasierte Web-Extraktion eignet – besonders für Vertrieb und Operations.

Hauptfunktionen:

- Über 60.000 öffentliche Rezepte: Ein-Klick-Scraping für viele bekannte Seiten.

- Point-and-Click-Rezept-Builder: Eigene Extraktionsregeln erstellen.

- Sofortiges Tabellenscraping: HTML-Tabellen oder Listen in Sekunden erfassen.

- Direkter Export: Daten nach Google Sheets, Excel oder CSV senden.

Vorteile: Schnell, browserbasiert, kein Coding, ideal für eingeloggte Seiten.

Nachteile: Begrenzung durch Browsergeschwindigkeit, Seitenlimits bei kostenlosen/Bezahlplänen, nicht für große Projekte geeignet.

Ideal für: Lead-Generierung, schnelle Recherche und alle, die einen „Export nach Excel“-Button fürs Web wollen.

10. Visual Web Ripper

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

ist eine umfassende Desktop-Lösung für großflächige Webdaten-Extraktion, mit Fokus auf vorlagenbasierte Projekte und Automatisierung.

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

ist eine umfassende Desktop-Lösung für großflächige Webdaten-Extraktion, mit Fokus auf vorlagenbasierte Projekte und Automatisierung.

Hauptfunktionen:

- Vorlagen- & Projektsystem: Mehrstufige Crawls mit Templates gestalten.

- Erweiterte Optionen: Regex, XPath und Debugging für komplexe Seiten.

- Export zu Datenbanken: Direkter Export nach SQL, Excel, XML und mehr.

- Automatisierung: Jobs planen und mehrfädige Extraktion ausführen.

Vorteile: Leistungsstark für komplexe, statische Seiten; Einmal-Lizenz; unterstützt fortgeschrittene Logik.

Nachteile: Veraltete Oberfläche, nur für Windows, weniger geeignet für moderne dynamische Seiten.

Ideal für: Berater, Agenturen und Power-User, die große, strukturierte Scraping-Projekte managen.

11. Helium Scraper

ist eine Windows-App, die Drag-and-Drop-Bedienung mit tiefer Anpassbarkeit verbindet.

ist eine Windows-App, die Drag-and-Drop-Bedienung mit tiefer Anpassbarkeit verbindet.

Hauptfunktionen:

- Kinds & Actions-Modell: Datenmuster visuell definieren, dann Aktionen für die Extraktion festlegen.

- Mehrstufige & relationale Daten: Parent-Child-Beziehungen ausgeben, SQL-Abfragen auf extrahierte Daten ausführen.

- Custom Scripting: JavaScript oder SQL für fortgeschrittene Logik einbinden.

- Multi-Threading: Mehrere Seiten parallel scrapen für mehr Geschwindigkeit.

Vorteile: Flexibel, unterstützt komplexe Datenstrukturen, günstige Einmalzahlung.

Nachteile: Einarbeitung in das „Kinds“-Konzept nötig, nur für Windows, weniger verbreitet.

Ideal für: Analysten und Technikbegeisterte, die mehr Power als bei einfachen Tools wollen, aber nicht komplett coden möchten.

12. Content Grabber

ist eine Enterprise-Plattform für großflächige, automatisierte Datenextraktion und -integration.

ist eine Enterprise-Plattform für großflächige, automatisierte Datenextraktion und -integration.

Hauptfunktionen:

- Visueller Agent-Editor: Scraping-Agents per Point-and-Click bauen, dann in C# oder VB.NET für individuelle Logik erweitern.

- Enterprise-Zeitplanung & Monitoring: Zentrale Steuerung, Fehlerbehandlung und Benachrichtigungen.

- On-Premise-Betrieb: Daten bleiben für Compliance im eigenen Haus.

- API & Integration: Export zu Datenbanken, APIs und Message Queues.

Vorteile: Extrem leistungsstark, skalierbar, für kritische Workflows gebaut.

Nachteile: Teuer, komplex, am besten für Unternehmen mit eigener IT-Abteilung.

Ideal für: Großunternehmen, Datenanbieter und alle, die Webdatenextraktion als Kerngeschäft betreiben.

Welcher Data Extractor passt zu dir? Anwendungsfälle und Empfehlungen

- Lead-Generierung im Vertrieb: (KI, einfacher Export), (browserbasiert, schnelle Rezepte).

- E-Commerce-Monitoring: (Vorlagen, Zeitplanung), (Enterprise, Integration).

- Technische Anpassung: (Python, Open Source), (Cloud, Workflow-Automatisierung), (visuell, dynamische Seiten).

- Datenintegration & Automatisierung: (BI-Workflows), (Enterprise, On-Premise).

- Schnelle, kleine Aufgaben: (Point-and-Click, Einmalzahlung), (Drag-and-Drop, individuelle Logik).

Tipp: Die meisten Tools bieten kostenlose Testversionen – probier ein paar direkt an deinem Datenproblem aus, bevor du dich festlegst.

Fazit: Mit dem richtigen Data Extractor maximale Effizienz erreichen

Manuelle Datenbeschaffung? Die Zeiten sind vorbei. Mit dem passenden Data Extractor automatisierst du stundenlange Fleißarbeit, steigerst die Genauigkeit und triffst bessere Entscheidungen – egal ob du Solo-Selbstständiger, Vertriebsteam oder Operations-Manager in einem Großkonzern bist. Wichtig ist, dass das Tool zu deinem Anwendungsfall, deinem Technik-Level und deinem Budget passt.

Wenn du den schnellsten Weg von „Ich brauche diese Daten“ zu „Sie sind in meiner Tabelle“ suchst, ist ein super Startpunkt. Aber egal, was du brauchst – in dieser Liste findest du garantiert das passende Tool, um smarter statt härter zu arbeiten.

Bereit, dein Datenmanagement aufs nächste Level zu bringen? Teste ein paar dieser Extractors und erlebe, wie viel Zeit (und Nerven) du sparen kannst.

FAQs

1. Was ist ein Data Extractor und warum brauche ich ihn?

Ein Data Extractor ist ein Tool, das die Sammlung strukturierter Infos von Webseiten, Dokumenten oder Datenbanken automatisiert. Es spart Zeit, reduziert Fehler und gibt dir die Möglichkeit, dich auf die Analyse statt auf Copy-Paste zu konzentrieren.

2. Welcher Data Extractor ist am besten für Nicht-Techniker geeignet?

überzeugt mit KI-gestützter, 2-Klick-Bedienung und natürlicher Spracheingabe. Es ist für Business-User gemacht, die Ergebnisse ohne Programmierung oder komplizierte Einrichtung wollen.

3. Kommen Data Extractors auch mit dynamischen oder JavaScript-lastigen Webseiten klar?

Ja – Tools wie , und (mit Headless-Browser-Support) sind auf dynamische Inhalte und interaktive Seiten spezialisiert.

4. Wie entscheide ich zwischen einem kostenlosen und einem kostenpflichtigen Data Extractor?

Kostenlose Tools sind super für kleine, gelegentliche Aufgaben. Für regelmäßige, große oder geschäftskritische Projekte bieten Bezahlmodelle mehr Features, höhere Limits und besseren Support. Teste immer erst mit einer Gratis-Version.

5. Ist die Nutzung von Data Extractors legal?

Grundsätzlich ist das Extrahieren öffentlich zugänglicher Daten erlaubt, aber check immer die Nutzungsbedingungen der Website und beachte Datenschutzgesetze. Bei sensiblen oder personenbezogenen Daten ist die Einhaltung von Vorschriften wie der DSGVO Pflicht.

Mehr Tipps zu Web Scraping, Automatisierung und Produktivität findest du im – mit Praxisbeispielen, Tutorials und den neuesten Entwicklungen rund um KI-gestützte Datenextraktion.

Mehr erfahren