Das Internet ist heute viel mehr als nur ein digitaler Tummelplatz – es ist das größte Datenlager, das wir kennen. Egal ob Vertrieb, Marketing oder Marktforschung: Alle sind auf der Jagd nach wertvollen Infos. Aber mal ehrlich – Webdaten händisch zu sammeln, fühlt sich an wie IKEA-Möbel ohne Anleitung zusammenzuschrauben: Am Ende hast du doppelt so viele Schrauben übrig und fragst dich, wo die Zeit geblieben ist. Da Unternehmen immer mehr auf aktuelle Marktdaten, Wettbewerbsanalysen und Lead-Generierung setzen, war der Bedarf an effizienten, zuverlässigen Web-Scraping-Tools noch nie so hoch. Fast , und der globale Markt für Web-Scraping wird sich laut Prognosen bis .

Wenn du genug vom Copy-Paste-Wahnsinn hast, keine neuen Leads mehr verpassen willst oder einfach neugierig bist, was mit Automatisierung alles möglich ist, bist du hier goldrichtig. Nach Jahren in der Entwicklung und im Testen von Web-Scraping-Tools (und als Teamleiter bei ) weiß ich aus erster Hand, wie das richtige Tool stundenlange Fleißarbeit auf ein paar Klicks schrumpfen lässt. Egal, ob du ohne Programmierkenntnisse sofort Ergebnisse willst oder als Entwickler die volle Kontrolle suchst – diese Top 10 der besten Web-Scraping-Tools hilft dir, das passende Werkzeug zu finden.

Warum die Wahl des richtigen Web-Scraping-Tools so wichtig ist

Ganz ehrlich: Der Unterschied zwischen einem guten und einem mittelmäßigen Web-Scraping-Tool ist nicht nur Bequemlichkeit – es kann ein echter Gamechanger fürs Business sein. Automatisierte Web-Extraktion spart nicht nur Zeit (ein G2-User berichtet von ), sondern reduziert Fehler, eröffnet neue Chancen und sorgt dafür, dass dein Team immer mit den aktuellsten und präzisesten Daten arbeitet. Manuelle Recherche ist langsam, fehleranfällig und oft schon veraltet, bevor du fertig bist. Mit dem richtigen Tool kannst du Wettbewerber beobachten, Preise tracken oder Lead-Listen in Minuten – nicht Tagen – bauen.

Ein Beispiel: Ein Beauty-Händler nutzte Web Scraping, um Lagerbestände und Preise der Konkurrenz zu überwachen – . Solche Ergebnisse sind mit Excel und Handarbeit kaum zu schaffen.

So haben wir die besten Web-Scraping-Tools bewertet

Bei der riesigen Auswahl fühlt sich die Suche nach dem richtigen Tool schnell an wie Speed-Dating auf einer Tech-Konferenz. Nach diesen Kriterien habe ich die Spreu vom Weizen getrennt:

- Benutzerfreundlichkeit: Kann man ohne Programmierkenntnisse loslegen? Gibt’s eine visuelle Oberfläche oder KI-Unterstützung?

- Automatisierung: Werden Paginierung, Unterseiten, dynamische Inhalte und Zeitpläne unterstützt? Läuft das Tool auch in der Cloud für große Projekte?

- Preis & Skalierbarkeit: Gibt’s einen kostenlosen Einstieg oder günstige Pläne? Wie entwickelt sich der Preis bei wachsendem Datenbedarf?

- Funktionsumfang & Integration: Kann man nach Excel, Google Sheets oder per API exportieren? Gibt’s Vorlagen, Zeitpläne oder integrierte Datenbereinigung?

- Zielgruppe: Für wen ist das Tool gemacht – Business-Anwender, Entwickler oder große Teams?

Am Ende findest du eine Vergleichstabelle, die alle Tools gegenüberstellt.

Jetzt geht’s los mit den 10 besten Web-Scraping-Tools für effiziente Datenerfassung im Jahr 2025.

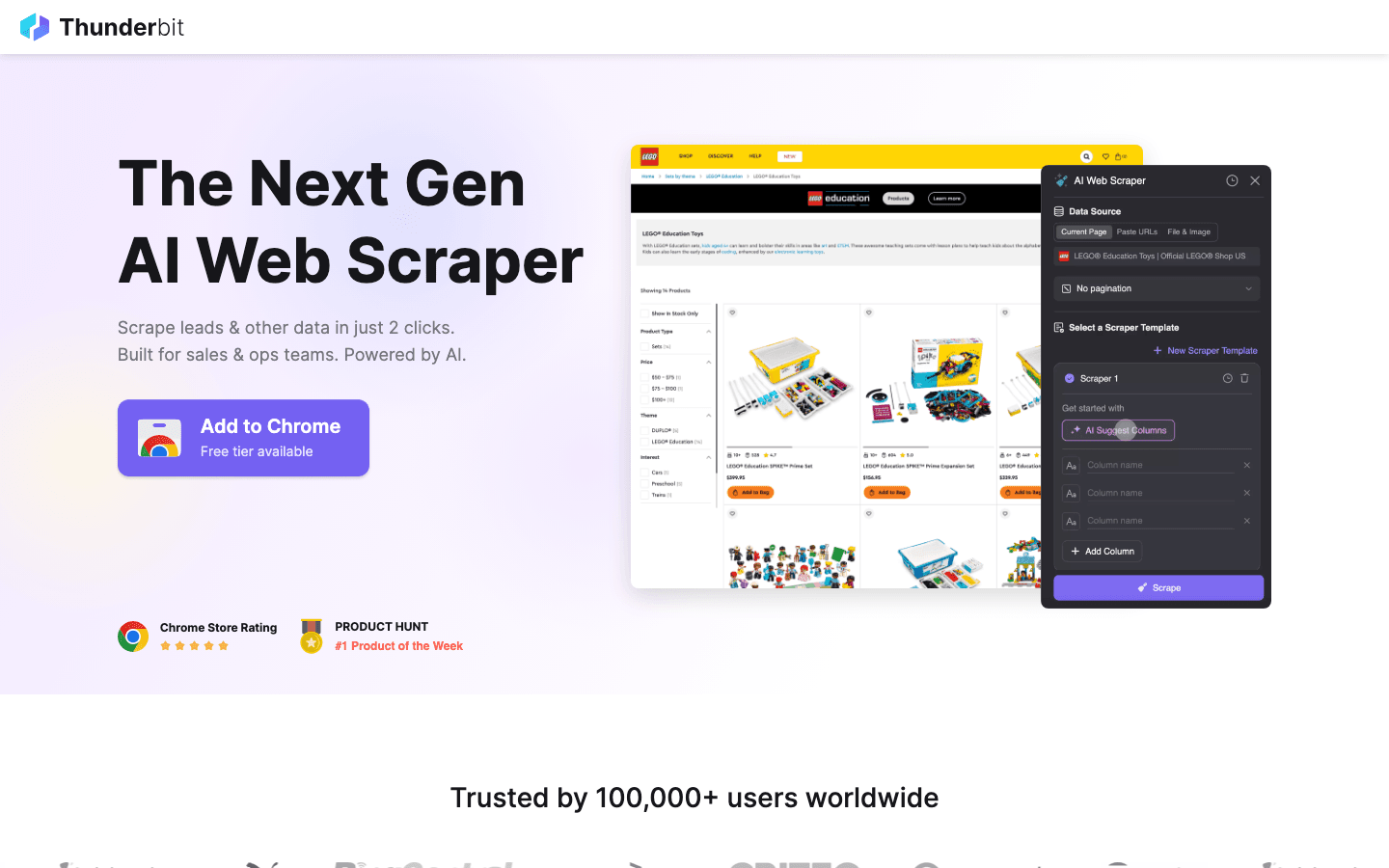

1. Thunderbit

ist meine absolute Empfehlung für alle, die Web Scraping so einfach wie Essen bestellen wollen. Als KI-basierte Chrome-Erweiterung setzt Thunderbit auf 2-Klick-Scraping: „AI Suggest Fields“ erkennt automatisch die wichtigsten Daten auf der Seite, dann einfach auf „Scrape“ klicken – fertig. Kein Code, kein Gefummel mit Selektoren – sofort Ergebnisse.

ist meine absolute Empfehlung für alle, die Web Scraping so einfach wie Essen bestellen wollen. Als KI-basierte Chrome-Erweiterung setzt Thunderbit auf 2-Klick-Scraping: „AI Suggest Fields“ erkennt automatisch die wichtigsten Daten auf der Seite, dann einfach auf „Scrape“ klicken – fertig. Kein Code, kein Gefummel mit Selektoren – sofort Ergebnisse.

Warum ist Thunderbit bei Vertriebs-, Marketing- und E-Commerce-Teams so beliebt? Es ist auf echte Business-Workflows zugeschnitten:

- AI Suggest Fields: Die KI liest die Seite und schlägt die besten Spalten vor – Namen, Preise, E-Mails und mehr.

- Unterseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch Unterseiten (z. B. Produktdetails oder LinkedIn-Profile) und ergänzt deine Tabelle.

- Sofort-Export: Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable oder Notion – kostenlos.

- Vorlagen mit einem Klick: Für beliebte Seiten (Amazon, Zillow, Instagram) gibt’s fertige Templates für noch schnellere Ergebnisse.

- Kostenloser Datenexport: Es gibt keine Bezahlschranke für den Export deiner Daten.

- Geplanter Scraper: Wiederkehrende Aufgaben lassen sich in Klartext planen („jeden Montag um 9 Uhr“) – ideal für Preisüberwachung oder wöchentliche Lead-Updates.

Thunderbit arbeitet mit einem Creditsystem (1 Credit = 1 Zeile), mit für bis zu 6 Seiten (oder 10 mit Test-Boost). Bezahlpläne starten ab 15 $/Monat für 500 Credits – damit ist es für Teams jeder Größe erschwinglich.

Wer Thunderbit in Aktion sehen möchte, findet auf unserem oder im viele Beispiele. Es ist das Tool, das ich mir früher bei stundenlanger Dateneingabe gewünscht hätte.

2. Octoparse

ist ein echtes Schwergewicht unter den Web-Scraping-Tools, besonders für Unternehmen mit großem Datenhunger. Die visuelle Desktop-Oberfläche (Windows und Mac) macht es möglich, Extraktions-Workflows per Mausklick zu bauen – ganz ohne Programmierung. Doch hinter der benutzerfreundlichen Oberfläche steckt viel Power: Octoparse meistert Logins, Endlos-Scrollen, Proxy-Rotation und sogar CAPTCHAs.

ist ein echtes Schwergewicht unter den Web-Scraping-Tools, besonders für Unternehmen mit großem Datenhunger. Die visuelle Desktop-Oberfläche (Windows und Mac) macht es möglich, Extraktions-Workflows per Mausklick zu bauen – ganz ohne Programmierung. Doch hinter der benutzerfreundlichen Oberfläche steckt viel Power: Octoparse meistert Logins, Endlos-Scrollen, Proxy-Rotation und sogar CAPTCHAs.

- 500+ Vorlagen: Starte direkt mit Templates für Amazon, Twitter, LinkedIn und viele mehr.

- Cloud-Scraping: Aufgaben laufen auf Octoparse-Servern, können geplant und für große Projekte skaliert werden.

- API-Zugang: Integriere extrahierte Daten direkt in deine Business-Apps oder Datenbanken.

- Fortgeschrittene Automatisierung: Unterstützt dynamische Inhalte, Paginierung und mehrstufige Workflows.

Es gibt einen für bis zu 10 Aufgaben, die meisten Unternehmen greifen aber zum Standard-Tarif (~83 $/Monat) oder Professional (~299 $/Monat). Die Lernkurve ist etwas steiler als bei Thunderbit, aber für große, komplexe Projekte ist Octoparse eine Top-Wahl.

3. Scrapy

ist der Goldstandard für Entwickler, die maximale Kontrolle über ihre Web-Scraping-Projekte wollen. Das Open-Source-Framework für Python ermöglicht es, eigene Crawler (Spiders) für jede beliebige Website zu programmieren. Was du dir vorstellen kannst, lässt sich mit Scrapy umsetzen.

ist der Goldstandard für Entwickler, die maximale Kontrolle über ihre Web-Scraping-Projekte wollen. Das Open-Source-Framework für Python ermöglicht es, eigene Crawler (Spiders) für jede beliebige Website zu programmieren. Was du dir vorstellen kannst, lässt sich mit Scrapy umsetzen.

- Voll programmierbar: Schreibe Python-Code, um das Crawling und Parsen individuell zu steuern.

- Asynchron & schnell: Verarbeitet tausende Seiten parallel – ideal für große Projekte.

- Erweiterbar: Middleware für Proxys, Headless-Browser oder eigene Logik einfach integrierbar.

- Starke Community: Viele Tutorials, Plugins und Support für knifflige Fälle.

Scrapy ist kostenlos und Open Source, erfordert aber Programmierkenntnisse. Für technische Teams oder individuelle Pipelines ist Scrapy kaum zu schlagen – für Nicht-Programmierer ist es jedoch eine Herausforderung.

4. ParseHub

ist ein visuelles, No-Code-Web-Scraping-Tool, das sich besonders für komplexe Websites eignet. Mit der Point-and-Click-Oberfläche wählst du Elemente aus, definierst Aktionen und baust Workflows – auch für dynamische Seiten oder schwierige Navigation.

ist ein visuelles, No-Code-Web-Scraping-Tool, das sich besonders für komplexe Websites eignet. Mit der Point-and-Click-Oberfläche wählst du Elemente aus, definierst Aktionen und baust Workflows – auch für dynamische Seiten oder schwierige Navigation.

- Visueller Workflow-Builder: Daten auswählen, Paginierung einrichten, Pop-ups oder Dropdowns handhaben – alles per Klick.

- Dynamische Inhalte: Funktioniert auch mit JavaScript-lastigen und interaktiven Seiten.

- Cloud-Ausführung & Zeitplanung: Scrapes laufen in der Cloud und können regelmäßig geplant werden.

- Export zu CSV, Excel oder per API: Einfache Integration in deine Tools.

ParseHub bietet einen kostenlosen Plan (5 Projekte), kostenpflichtige Tarife starten ab . Es ist etwas teurer als manche Alternativen, aber die visuelle Bedienung macht es für Analysten, Marketer und Forscher attraktiv, die mehr als eine einfache Chrome-Erweiterung brauchen.

5. Apify

ist Plattform und Marktplatz in einem. Es gibt eine riesige Bibliothek an vorgefertigten „Actors“ (fertige Scraper) für beliebte Seiten und die Möglichkeit, eigene Crawler in der Cloud zu bauen und auszuführen.

ist Plattform und Marktplatz in einem. Es gibt eine riesige Bibliothek an vorgefertigten „Actors“ (fertige Scraper) für beliebte Seiten und die Möglichkeit, eigene Crawler in der Cloud zu bauen und auszuführen.

- 5.000+ fertige Actors: Sofort Google Maps, Amazon, Twitter und mehr scrapen.

- Eigene Scripte: Entwickler können mit JavaScript oder Python eigene Crawler erstellen.

- Cloud-Skalierung: Aufgaben parallel ausführen, Zeitpläne festlegen und Daten in der Cloud verwalten.

- API & Integration: Ergebnisse direkt in Apps, Workflows oder Datenpipelines einbinden.

Apify bietet einen flexiblen , bezahlte Pläne starten ab 29 $/Monat (Pay-as-you-go für Rechenzeit). Die Einarbeitung dauert etwas, aber wer Plug-and-Play und volle Anpassbarkeit sucht, ist hier richtig.

6. Data Miner

ist eine Chrome-Erweiterung für schnelles, vorlagenbasiertes Web Scraping. Ideal für Business-Anwender, die Daten aus Tabellen oder Listen ohne großen Aufwand extrahieren möchten.

ist eine Chrome-Erweiterung für schnelles, vorlagenbasiertes Web Scraping. Ideal für Business-Anwender, die Daten aus Tabellen oder Listen ohne großen Aufwand extrahieren möchten.

- Große Vorlagenbibliothek: Über tausend Rezepte für gängige Seiten (LinkedIn, Yelp usw.).

- Point-and-Click-Extraktion: Vorlage auswählen, Datenvorschau anzeigen, sofort exportieren.

- Browserbasiert: Funktioniert direkt im aktuellen Browser – auch hinter Logins.

- Export zu CSV oder Excel: Daten in Sekunden ins Spreadsheet bringen.

Der umfasst 500 Seiten/Monat, bezahlte Tarife starten ab 20 $/Monat. Perfekt für kleine, einmalige Aufgaben oder wenn Daten sofort gebraucht werden – für große Projekte oder komplexe Automatisierung ist es weniger geeignet.

7. Import.io

ist eine Enterprise-Plattform für Unternehmen, die kontinuierlich und zuverlässig Webdaten integrieren müssen. Es ist mehr als ein Crawler – ein Managed Service, der saubere, strukturierte Daten direkt in deine Systeme liefert.

ist eine Enterprise-Plattform für Unternehmen, die kontinuierlich und zuverlässig Webdaten integrieren müssen. Es ist mehr als ein Crawler – ein Managed Service, der saubere, strukturierte Daten direkt in deine Systeme liefert.

- No-Code-Extraktion: Visuelle Einrichtung, um gewünschte Daten zu definieren.

- Echtzeit-Datenfeeds: Daten direkt in Dashboards, Analyse-Tools oder Datenbanken streamen.

- Compliance & Zuverlässigkeit: IP-Rotation, Anti-Bot-Maßnahmen und rechtliche Konformität inklusive.

- Managed Services: Das Import.io-Team übernimmt Einrichtung und Wartung deiner Scraper.

Die Preise sind , mit 14 Tagen kostenlosem Test für die SaaS-Plattform. Wer auf stets aktuelle Webdaten angewiesen ist (z. B. Handel, Finanzen, Marktforschung), sollte Import.io in Betracht ziehen.

8. WebHarvy

ist ein Desktop-Scraper für Windows-Nutzer, die eine Point-and-Click-Lösung ohne Abo suchen. Besonders beliebt bei kleinen Unternehmen und Einzelanwendern, die eine Einmalzahlung bevorzugen.

ist ein Desktop-Scraper für Windows-Nutzer, die eine Point-and-Click-Lösung ohne Abo suchen. Besonders beliebt bei kleinen Unternehmen und Einzelanwendern, die eine Einmalzahlung bevorzugen.

- Visuelle Mustererkennung: Einfach auf Daten klicken, WebHarvy erkennt automatisch wiederkehrende Strukturen.

- Text, Bilder & mehr: Extrahiert alle gängigen Datentypen, inklusive E-Mails und URLs.

- Paginierung & Zeitplanung: Mehrseitige Websites durchforsten und geplante Scrapes einrichten.

- Export zu Excel, CSV, XML, JSON oder SQL: Flexible Ausgabe für jeden Workflow.

Eine Einzelplatzlizenz kostet – damit ist es eine günstige Lösung für regelmäßige Nutzung. Hinweis: Nur für Windows.

9. Mozenda

ist eine cloudbasierte Web-Scraping-Plattform für Unternehmen mit laufendem Datenbedarf. Sie kombiniert einen Desktop-Designer (Windows) mit leistungsstarker Cloud-Ausführung und Automatisierung.

ist eine cloudbasierte Web-Scraping-Plattform für Unternehmen mit laufendem Datenbedarf. Sie kombiniert einen Desktop-Designer (Windows) mit leistungsstarker Cloud-Ausführung und Automatisierung.

- Visueller Agenten-Builder: Extraktionsroutinen per Mausklick gestalten.

- Cloud-Skalierung: Mehrere Agenten parallel ausführen, Aufgaben planen und Daten zentral verwalten.

- Datenmanagement-Konsole: Datensätze nach der Extraktion kombinieren, filtern und bereinigen.

- Enterprise-Support: Persönliche Ansprechpartner und Managed Services für große Teams.

Die Tarife starten ab , höhere Stufen bieten mehr Nutzer und Rechenleistung. Mozenda eignet sich besonders für Unternehmen, die Webdaten fest in ihre Abläufe integrieren möchten.

10. BeautifulSoup

ist die klassische Python-Bibliothek zum Parsen von HTML und XML. Kein vollständiger Crawler, aber bei Entwicklern beliebt für kleine, individuelle Scraping-Projekte.

ist die klassische Python-Bibliothek zum Parsen von HTML und XML. Kein vollständiger Crawler, aber bei Entwicklern beliebt für kleine, individuelle Scraping-Projekte.

- Einfache HTML-Analyse: Daten aus statischen Webseiten unkompliziert extrahieren.

- Kombinierbar mit Python Requests: Zusammen mit anderen Bibliotheken für das Crawling nutzbar.

- Flexibel & schlank: Ideal für schnelle Skripte oder Lernprojekte.

- Große Community: Viele Tutorials und Antworten auf Stack Overflow.

BeautifulSoup ist , aber du musst selbst programmieren und das Crawling steuern. Am besten geeignet für Entwickler oder Lernende, die Web Scraping von Grund auf verstehen möchten.

Vergleichstabelle: Web-Scraping-Tools im Überblick

| Tool | Benutzerfreundlichkeit | Automatisierungsgrad | Preisgestaltung | Exportoptionen | Ideal für |

|---|---|---|---|---|---|

| Thunderbit | Sehr einfach, No-Code | Hoch (KI, Unterseiten) | Kostenlos testen, ab 15 $/Monat | Excel, Sheets, Airtable, Notion, CSV | Vertrieb, Marketing, E-Commerce, Nicht-Programmierer |

| Octoparse | Mittel, visuelle UI | Sehr hoch, Cloud | Kostenlos, 83–299 $/Monat | CSV, Excel, JSON, API | Unternehmen, Datenteams, dynamische Seiten |

| Scrapy | Gering (Python nötig) | Hoch (anpassbar) | Kostenlos, Open Source | Beliebig (per Code) | Entwickler, große individuelle Projekte |

| ParseHub | Hoch, visuell | Hoch (dynamische Seiten) | Kostenlos, ab 189 $/Monat | CSV, Excel, JSON, API | Nicht-Programmierer, komplexe Webstrukturen |

| Apify | Mittel, flexibel | Sehr hoch, Cloud | Kostenlos, 29–999 $/Monat | CSV, JSON, API, Cloud-Speicher | Entwickler, Unternehmen, fertige oder eigene Actors |

| Data Miner | Sehr einfach, Browser | Gering (manuell) | Kostenlos, 20–99 $/Monat | CSV, Excel | Schnelle, einmalige Extraktionen, kleine Datensätze |

| Import.io | Mittel, Managed Service | Sehr hoch, Enterprise | Individuell, volumenbasiert | CSV, JSON, API, direkte Integration | Unternehmen, kontinuierliche Datenintegration |

| WebHarvy | Hoch, Desktop | Mittel (Zeitplanung) | 129 $ einmalig | Excel, CSV, XML, JSON, SQL | KMU, Windows-Nutzer, regelmäßiges Scraping |

| Mozenda | Mittel, visuell | Sehr hoch, Cloud | 250–450+ $/Monat | CSV, Excel, JSON, Cloud, DB | Laufende, großvolumige Geschäftsprozesse |

| BeautifulSoup | Gering (Python nötig) | Gering (manuelles Coding) | Kostenlos, Open Source | Beliebig (per Code) | Entwickler, Lernende, kleine individuelle Skripte |

So findest du das passende Web-Scraping-Tool für dein Team

Das beste Web-Scraping-Tool ist nicht das „mächtigste“, sondern das, das zu den Fähigkeiten, Anforderungen und dem Budget deines Teams passt. Mein Tipp:

- Nicht-Programmierer oder Business-Anwender: Thunderbit, ParseHub oder Data Miner liefern schnelle Ergebnisse und sind super einfach einzurichten.

- Unternehmen oder große Projekte: Octoparse, Mozenda oder Import.io punkten mit Automatisierung, Zeitplanung und Support.

- Entwickler oder individuelle Projekte: Scrapy, Apify oder BeautifulSoup bieten volle Kontrolle und Flexibilität.

- Preisbewusste oder Einzelaufgaben: WebHarvy (Windows) oder Data Miner (Browser) sind günstig und unkompliziert.

Teste deine Favoriten immer mit einer kostenlosen Probe auf den echten Zielseiten – was auf einer Seite klappt, funktioniert nicht immer überall. Und denk an die Integration: Wenn du Daten in Sheets, Notion oder eine Datenbank brauchst, prüfe, ob dein Tool das direkt unterstützt.

Fazit: Mit den besten Web-Scraping-Tools echten Mehrwert schaffen

Webdaten sind das neue Öl – aber nur, wenn du die richtigen Werkzeuge zum Extrahieren und Veredeln hast. Moderne Web-Scraping-Tools verwandeln stundenlange Recherche in wenige Minuten automatisierter Erkenntnisse – für mehr Vertriebserfolg, gezielteres Marketing und agilere Abläufe. Egal, ob du Lead-Listen baust, Wettbewerber beobachtest oder einfach keine Lust mehr auf Copy-Paste hast: In dieser Liste findest du das passende Tool, das deinen Arbeitsalltag spürbar erleichtert.

Schau dir die Anforderungen deines Teams an, probiere ein paar Tools aus und erlebe, wie viel mehr du mit Automatisierung erreichen kannst. Und wenn du sehen willst, wie KI-gestütztes 2-Klick-Scraping aussieht, . Viel Erfolg beim Scrapen – und mögen deine Daten immer frisch, strukturiert und einsatzbereit sein.

Häufige Fragen (FAQ)

1. Was ist ein Web-Scraping-Tool und warum brauche ich eines?

Ein Web-Scraping-Tool automatisiert das Extrahieren von Infos aus Webseiten. Es spart Zeit, reduziert Fehler und hilft Teams, aktuelle Daten für Vertrieb, Marketing, Forschung und operative Aufgaben viel effizienter zu sammeln als per Hand.

2. Welches Web-Scraping-Tool eignet sich für Nicht-Programmierer?

Thunderbit, ParseHub und Data Miner sind Top-Empfehlungen für alle ohne Programmierkenntnisse. Thunderbit überzeugt mit seinem 2-Klick-KI-Workflow, ParseHub bietet eine visuelle Lösung für komplexere Seiten.

3. Wie unterscheiden sich die Preismodelle der Web-Scraping-Tools?

Die Preise variieren stark: Einige Tools (wie Thunderbit und Data Miner) bieten kostenlose Einstiege und günstige Monatspläne, während Enterprise-Plattformen (wie Import.io und Mozenda) individuelle oder volumenbasierte Preise haben. Schau immer, ob die Kosten zu deinem Datenbedarf passen.

4. Kann ich diese Tools für regelmäßige, geplante Datenerfassung nutzen?

Ja – Tools wie Thunderbit, Octoparse, Apify, Mozenda und Import.io unterstützen geplante oder wiederkehrende Scrapes. Perfekt für Preisüberwachung, Lead-Generierung oder Marktforschung.

5. Was sollte ich vor der Auswahl eines Web-Scraping-Tools beachten?

Berücksichtige die technischen Fähigkeiten deines Teams, die Komplexität der Zielseiten, das Datenvolumen, Integrationsmöglichkeiten und dein Budget. Teste mehrere Tools mit deinen echten Aufgaben, bevor du dich für einen kostenpflichtigen Plan entscheidest.

Weitere Tipps und Praxis-Guides findest du im .

Mehr erfahren