Web-Scraping-Tools werden 2025 zu einem der unterschätzten Produktivitäts-Turbos überhaupt. Egal ob du Leads generierst, den Markt beobachtest, Wettbewerber analysierst oder Stimmungsbilder sammelst – mit diesen Tools können mittlerweile auch Leute ohne Technik-Background Aufgaben erledigen, für die früher ein ganzes Entwicklerteam nötig war. Automatisierte Web-Scraping-Tools sind längst nicht mehr nur was für Programmierer oder Daten-Nerds. Heute können Vertriebler, Marketer und sogar komplette Technik-Laien in wenigen Minuten eigene Datenpipelines aufsetzen – oft reicht ein paar Klicks und eine kurze Beschreibung in Alltagssprache.

Wenn du das hier liest, weißt du wahrscheinlich schon: Web-Scraping ist das Geheimrezept für gezieltes Prospecting, aktuelle Marktdaten und effiziente Prozesse. Aber bei der Masse an Web-Scraper-Tools, die alle versprechen, dir Zeit und Nerven zu sparen – wie findest du das richtige? Nach Jahren in der Entwicklung von SaaS- und Automatisierungslösungen (und als Mitgründer von ) weiß ich: Das passende Tool macht aus stundenlangem Copy-Paste einen Zwei-Minuten-Job. Hier kommen die 10 besten automatisierten Web-Scraping-Tools für 2025 – mit ihren Stärken im Vergleich, damit du direkt loslegen kannst.

Warum automatisierte Web-Scraping-Tools für Unternehmen heute Pflicht sind

Mal ehrlich: Die Zeiten, in denen man Daten mühsam von Webseiten abtippt, sind vorbei (außer du stehst auf monotone Klickerei und Frust). Automatisierte Web-Scraping-Tools sind heute für Unternehmen jeder Größe ein Muss. Tatsächlich investieren , wobei Web-Scraping ein zentrales Element ist.

Warum sind diese Tools so wertvoll?

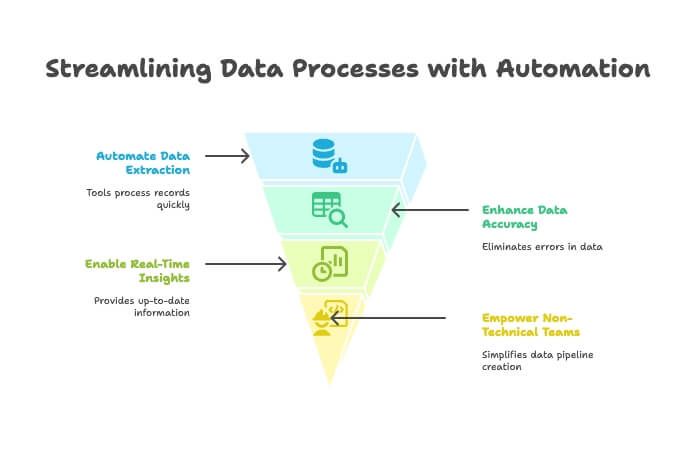

- Zeitersparnis & weniger Handarbeit: Automatisierte Scraper verarbeiten tausende Datensätze in Minuten und entlasten dein Team für wichtigere Aufgaben. Ein Nutzer hat berichtet, durch automatisierte Datenerfassung „hunderte Stunden“ eingespart zu haben ().

- Bessere Datenqualität: Keine Tippfehler oder vergessene Einträge mehr. Automatisierte Extraktion sorgt für saubere, zuverlässige Daten.

- Schnellere Entscheidungen: Mit Echtzeit-Daten kannst du Wettbewerber beobachten, Preise tracken oder Lead-Listen erstellen – ohne auf den Monatsbericht zu warten.

- Auch für Nicht-Techniker: Dank No-Code- und KI-Tools können selbst absolute Laien Web-Datenpipelines bauen ().

Kein Wunder, dass – und fast 80 % sagen, ihr Unternehmen könnte ohne diese Daten nicht effektiv arbeiten. Wer 2025 seine Datenerfassung nicht automatisiert, lässt bares Geld und wertvolle Erkenntnisse liegen.

So haben wir die besten automatisierten Web-Scraping-Tools ausgewählt

Der Markt für Web-Scraping-Software wird . Die Auswahl fühlt sich an wie Schuhkauf in einem Laden mit 10.000 Modellen. Nach diesen Kriterien habe ich die Tools bewertet:

- Benutzerfreundlichkeit: Kommen auch Nicht-Entwickler schnell zurecht? Gibt es eine steile Lernkurve?

- KI-Funktionen: Nutzt das Tool KI, um Datenfelder automatisch zu erkennen, dynamische Seiten zu verarbeiten oder Anforderungen in Alltagssprache zu verstehen?

- Datenexport & Integration: Wie einfach lassen sich Daten nach Excel, Google Sheets, Airtable, Notion oder ins CRM übertragen?

- Preisgestaltung: Gibt es eine kostenlose Testphase? Sind die Tarife auch für Einzelpersonen und kleine Teams erschwinglich?

- Skalierbarkeit: Eignet sich das Tool für kleine Einzelaufgaben und große, geplante Extraktionen?

- Zielgruppe: Ist es für Business-Anwender, Entwickler oder beide gedacht?

- Besondere Stärken: Was hebt das Tool von der Masse ab?

Die Liste enthält Tools für jedes Level – vom „Ich will nur eine Tabelle“ bis zum „Ich will das ganze Web crawlen“. Los geht’s!

1. Thunderbit: Der KI-Web-Scraper für alle

Ich starte mit dem Tool, das ich am besten kenne – denn mein Team und ich haben es genau für die Probleme gebaut, die ich bei Business-Anwendern immer wieder gesehen habe. ist kein klassischer „Drag-and-Drop“- oder „Selector-bauen“-Scraper. Es ist ein KI-basierter Datenassistent: Du beschreibst, was du brauchst, und die KI erledigt den Rest – ohne Code, ohne XPath, ohne Frust.

Warum Thunderbit ganz oben steht

Thunderbit ist das Beste, was ich bisher gesehen habe, um „jede Website in eine Datenbank zu verwandeln“. So funktioniert’s:

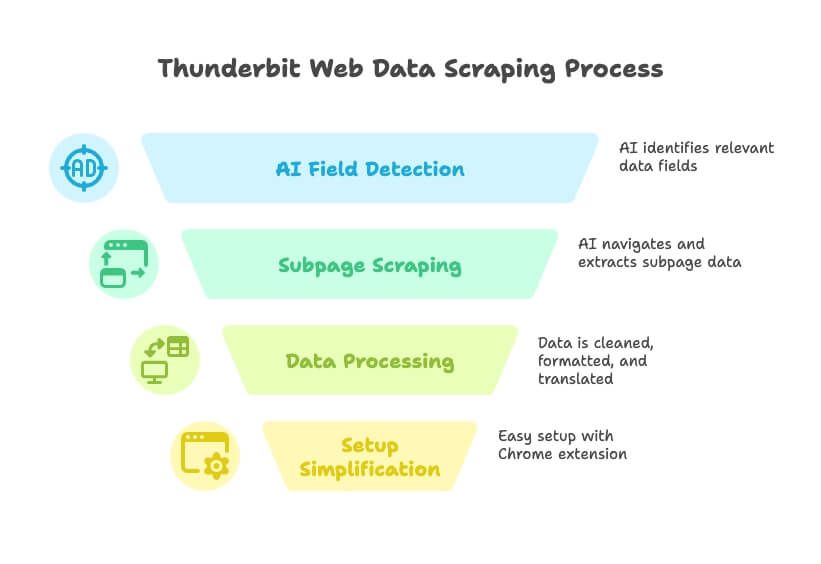

- Alltagssprache genügt: Sag Thunderbit einfach, welche Daten du willst („Ich brauche alle Firmennamen, E-Mails und Telefonnummern aus diesem Verzeichnis“), und die KI erkennt die passenden Felder automatisch.

- KI-Feldvorschläge: Mit einem Klick liest Thunderbit die Seite aus und schlägt die optimalen Spalten vor – kein Rätselraten mehr.

- Subpages & mehrstufiges Scraping: Du brauchst Details von Unterseiten? Thunderbit klickt sich durch, sammelt Zusatzinfos und ergänzt sie direkt in deiner Tabelle.

- Datenbereinigung, Übersetzung & Klassifizierung: Thunderbit holt nicht nur Rohdaten, sondern kann sie direkt bereinigen, formatieren, übersetzen und kategorisieren.

- Schneller Einstieg: Einfach die installieren, „KI-Felder vorschlagen“ klicken – und in unter einer Minute loslegen.

- Kostenlos testen & günstige Tarife: Großzügige Gratis-Version (bis zu 6 Seiten kostenlos scrapen), bezahlte Pläne ab nur 9 $/Monat – günstiger als mein wöchentlicher Kaffeekonsum.

Thunderbit richtet sich an Vertriebs-, Marketing- und Operationsteams, die schnell Daten brauchen. Kein Programmieren, keine Plugins, keine Schulung. Es ist wie ein Datenpraktikant, der immer zuhört und nie meckert.

Thunderbits besondere Funktionen

- KI-gesteuertes Scraping: Die KI versteht Seitenstrukturen, passt sich Layout-Änderungen an und übernimmt Paginierung sowie Subpages automatisch ().

- Sofortiger Datenexport: Ergebnisse direkt nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON exportieren.

- Cloud- oder lokaler Betrieb: Scrapes laufen in der Cloud für Tempo und Skalierung oder im Browser, falls du Login/Sitzung brauchst.

- Geplantes Scraping: Wiederkehrende Jobs einrichten, um Daten aktuell zu halten – ideal für Preisüberwachung oder Lead-Updates.

- Wartungsfrei: Thunderbits KI passt sich Webseitenänderungen an, sodass du weniger Zeit mit Reparaturen verbringst ().

Für wen? Für alle, die in Minuten von „Ich brauche diese Daten“ zu „Hier ist deine Tabelle“ kommen wollen – besonders für Nicht-Techniker. Mit und 4,9★-Bewertung wird Thunderbit schnell zum Favoriten für Business-Teams, die Ergebnisse statt Probleme wollen.

Du willst es in Aktion sehen? Schau auf dem vorbei oder stöbere in den .

2. Clay: Automatisierte Datenanreicherung trifft Web-Scraping

Clay ist das Schweizer Taschenmesser für Wachstumsteams. Es ist mehr als ein Web-Scraper – eine Automatisierungs-Tabelle, die über 50 Live-Datenquellen (z. B. Apollo, LinkedIn, Crunchbase) verbindet und mit integrierter KI Leads anreichert, E-Mails schreibt und Kontakte bewertet.

- Workflow-Automatisierung: Jede Zeile ist ein Lead, jede Spalte kann Daten ziehen oder Aktionen auslösen. Firmenliste scrapen, mit LinkedIn-Profilen anreichern und personalisierte E-Mails versenden? Clay macht’s möglich.

- KI-Integration: Nutzt GPT-4 für Icebreaker-Texte, Bio-Zusammenfassungen und mehr.

- Integrationen: Verbindet sich mit HubSpot, Salesforce, Gmail, Slack und vielen weiteren Tools.

- Preise: Ab ca. 99 $/Monat für den Professional-Plan, kostenlose Testphase für kleine Nutzung.

Ideal für: Outbound-Sales, Growth-Hacker und Marketer, die individuelle Lead-Pipelines bauen wollen – Scraping, Anreicherung und Outreach in einem. Leistungsstark, aber mit Lernkurve für Automatisierungs-Neulinge ().

3. Bardeen: Browserbasierter Web-Scraper für Workflow-Automatisierung

Bardeen ist wie ein Browser-Roboter, der Daten extrahiert und wiederkehrende Webaufgaben automatisiert – alles über eine Chrome-Erweiterung.

- No-Code-Automatisierung: Über 500 „Playbooks“ für Scraping, Formulare ausfüllen, Daten zwischen Apps verschieben und mehr.

- KI-Workflow-Builder: Beschreibe deine Aufgabe in Alltagssprache, Bardeen baut den Ablauf.

- Integrationen: Funktioniert mit Notion, Trello, Slack, Salesforce und über 100 weiteren Apps.

- Preise: Für kleine Nutzung kostenlos (100 Automatisierungspunkte/Monat), Team-Tarife ab 99 $/Monat.

Ideal für: Power-User und Go-to-Market-Teams, die Scraping und Folgeaktionen über mehrere Apps automatisieren wollen. Viel Flexibilität, aber für Einsteiger etwas komplex ().

4. Bright Data: Automatisierte Web-Scraping-Tools für Unternehmen

Bright Data (früher Luminati) ist das Schwergewicht im Web-Scraping – mit globalen Proxy-Netzwerken, fortschrittlichen APIs und der Fähigkeit, tausende Seiten pro Tag zu crawlen.

- Enterprise-Scale: Über 100 Millionen IPs, Web-Scraper-IDE, Web Unlocker zum Umgehen von Bot-Schutz.

- Individuell anpassbar: Komplexe, großvolumige Extraktionen mit hoher Zuverlässigkeit.

- Preise: Ab 499 $/Monat für die Web-Scraper-IDE, kleinere Pakete verfügbar.

Ideal für: Große Unternehmen, Datenaggregatoren und Profis, die robuste, skalierbare Lösungen brauchen. Wer täglich tausende Seiten crawlt und IP-Sperren umgehen muss, ist hier richtig ().

5. Octoparse: Visueller Web-Scraper für Fortgeschrittene

Octoparse ist ein beliebtes No-Code-Tool mit visueller Point-and-Click-Oberfläche – ideal für Nutzer, die Power ohne Programmierung wollen.

- Drag-and-Drop-UI: Elemente anklicken, um Extraktion zu definieren, Logins, Paginierung und mehr handhaben.

- Vorlagen: Über 500 Templates für gängige Seiten (Amazon, Twitter etc.).

- Cloud-Scraping: Jobs auf Octoparse-Servern ausführen, Extraktionen planen, IP-Rotation nutzen.

- Preise: Gratis-Plan mit Limits, Bezahlpläne ab 119 $/Monat.

Ideal für: Nicht-Programmierer und Datenanalysten, die einen leistungsfähigen Scraper ohne Code suchen. Perfekt für Preisüberwachung, Produktlisten und Recherche ().

6. : Datenextraktionsplattform für Unternehmen

ist einer der Pioniere im Web-Scraping und heute eine umfassende Datenplattform.

- Point-and-Click-Extraktion: Unterstützt Logins, Dropdowns und interaktive Elemente.

- Cloud-basiert: Tausende URLs parallel verarbeiten, Extraktionen planen, API-Zugriff.

- Enterprise-Fokus: Für Preisüberwachung, Marktforschung und Machine-Learning-Datensätze.

- Preise: Starter ab 199 $/Monat, Standard 599 $/Monat, Advanced 1.099 $/Monat.

Ideal für: Mittelgroße bis große Unternehmen und Datenteams, die zuverlässige, gewartete Lösungen für große Projekte brauchen. Für Hobbyprojekte überdimensioniert, aber ein Kraftpaket für Business-Anforderungen ().

7. Parsehub: Flexibler Web-Scraper mit visuellem Editor

Parsehub ist eine Desktop-App (Windows, Mac, Linux), mit der du Scraper per Klick durch die Website-Oberfläche baust.

- Visueller Workflow: Elemente auswählen, Extraktionsregeln festlegen, Logins, Dropdowns und Endlos-Scrolls handhaben.

- Cloud-Features: Scrapes in der Cloud ausführen, Jobs planen, API-Zugang nutzen.

- Preise: Gratis für kleine Aufgaben, Bezahlpläne ab 149 $/Monat.

Ideal für: Forscher, kleine Unternehmen oder Einzelpersonen, die mehr Kontrolle als mit einer Browser-Erweiterung wollen, aber nicht selbst programmieren möchten ().

8. Common Crawl: Offene Webdaten für KI und Forschung

Common Crawl ist kein Tool im klassischen Sinn – sondern ein riesiger, offener Datensatz aus monatlichen Web-Crawls.

- Größe: Rund 400 TB Webdaten, Milliarden Webseiten.

- Kostenlos & offen: Kein eigener Crawler nötig.

- Technisches Know-how erforderlich: Für Filterung und Analyse sind Big-Data-Tools und Entwicklerkenntnisse nötig.

Ideal für: Datenwissenschaftler und Entwickler, die KI-Modelle trainieren oder groß angelegte Forschung betreiben. Wer allgemeine Webtexte oder Langzeit-Archive braucht, findet hier eine Goldgrube ().

9. Crawly: Leichtgewichtiges automatisiertes Web-Scraping für Startups

Crawly (von Diffbot) ist ein cloudbasierter, KI-gestützter Crawler, der Daten von Millionen Websites strukturiert zurückliefert – ganz ohne Parsing-Regeln.

- KI-Extraktion: Nutzt Computer Vision und NLP, um Inhalte zu erkennen und zu extrahieren.

- API-Zugang: Abfrage der gesammelten Daten und Integration in Analysen oder Datenbanken.

- Preise: Enterprise-Level, Preis auf Anfrage.

Ideal für: Startups und Teams mit technischem Know-how, die große, intelligente Webdaten brauchen, ohne eigene Scraper zu bauen ().

10. Apify: Entwicklerfreundlicher Web-Scraper mit Marktplatz

Apify ist eine Cloud-Plattform, auf der du eigene Scraper („Actors“) bauen oder aus einer Bibliothek von Community-Scrapern wählen kannst.

- Flexibilität für Entwickler: Unterstützt JavaScript/Python-Scraping, Headless Chrome, Proxy-Management und Zeitplanung.

- Marktplatz: Große Auswahl an fertigen Scrapern für gängige Seiten.

- Preise: Gratis-Tarif mit 5 $/Monat Guthaben, Bezahlpläne ab 49 $/Monat.

Ideal für: Entwickler und technisch versierte Analysten, die volle Kontrolle und Skalierbarkeit wollen. Auch Nicht-Programmierer können vorgefertigte Actors für Standardaufgaben nutzen ().

Vergleichstabelle automatisierter Web-Scraping-Tools

| Tool | Benutzerfreundlichkeit | KI-Funktionen | Preis (ab) | Zielgruppe | Besondere Stärken |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | Alltagssprache, KI-Feldvorschläge, Subpage-Scraping | $9/Monat | Nicht-technische Business-User | 2-Klick-Setup, kein Code, Sofort-Export, Gratis-Test |

| Clay | ★★★★☆ | KI-Anreicherung, GPT-4 | $99/Monat | Growth/Sales Ops | Automatisierungstabelle, Anreicherung, Outreach |

| Bardeen | ★★★★☆ | KI-Workflow-Builder | $99/Monat | Power-User, GTM-Teams | Browser-RPA, 500+ Playbooks, tiefe Integrationen |

| Bright Data | ★★☆☆☆ | Proxy-Rotation, Anti-Bot-KI | $499/Monat | Unternehmen, Entwickler | Skalierung, Zuverlässigkeit, globale Proxys |

| Octoparse | ★★★★☆ | Visuelle KI-Erkennung | $119/Monat | Analysten, Nicht-Programmierer | Drag-and-Drop, Vorlagen, Cloud-Scraping |

| Import.io | ★★★☆☆ | Interaktive Extraktoren | $199/Monat | Unternehmen, Datenteams | Parallelität, Zeitplanung, API, Support |

| Parsehub | ★★★★☆ | Visuelle Workflows | $149/Monat | Forscher, KMU | Desktop-App, dynamische Seiten |

| Common Crawl | ★☆☆☆☆ | N/A (nur Datensatz) | Kostenlos | Datenwissenschaftler, Entwickler | Offener Massendatensatz, Web-Archive |

| Crawly | ★★☆☆☆ | KI-Extraktion | Individuell/Enterprise | Startups, Tech-Teams | KI-basiert, keine Parsing-Regeln, API-Zugang |

| Apify | ★★★★☆ | Actor-Marktplatz | $49/Monat | Entwickler, Tech-Analysten | Baukasten/Marktplatz, Cloud-Automatisierung, Flexibilität |

Wie du das richtige Web-Scraper-Tool auswählst

Welches automatisierte Web-Scraping-Tool am besten passt, hängt von Teamgröße, Technikkenntnissen und Zielen ab. Hier ein schneller Überblick:

- Für Nicht-Techniker (Vertrieb, Marketing, Operations): ist für euch gemacht – kein Code, keine Einrichtung, einfach Ergebnisse. Ideal für Lead-Generierung, Preisüberwachung und schnelle Datenprojekte.

- Für Automatisierungs-Fans: Clay und Bardeen sind top, wenn du Scraping mit Anreicherung, Outreach oder Workflows kombinieren willst.

- Für Unternehmen & Entwickler: Bright Data, und Apify sind die beste Wahl für große, individuell anpassbare Projekte.

- Für Forscher & Analysten: Octoparse und Parsehub bieten visuelle Oberflächen und starke Features ohne Programmieraufwand.

- Für KI- & Data-Science-Projekte: Common Crawl und Crawly liefern riesige Datensätze und KI-gestützte Extraktion für Modelltraining und Forschung.

Frag dich: Willst du in Minuten loslegen oder brauchst du eine maßgeschneiderte Enterprise-Lösung? Wenn du unsicher bist, probier erstmal eine kostenlose Testversion – die meisten Tools bieten das an.

Thunderbits Alleinstellungsmerkmal: KI-Assistent für Geschäftsdaten

Unter all diesen Tools ist Thunderbit das einzige, das wirklich als „KI-Assistent“ für Web-Scraping und Datenaufbereitung agiert. Es geht nicht nur um Datensammlung – sondern darum, aus unübersichtlichen Webseiten strukturierte, nutzbare Erkenntnisse zu machen, ganz ohne technische Hürden.

- Alltagssprachliche Bedienung: Einfach beschreiben, was du brauchst – Thunderbit erledigt den Rest.

- Vollständige Workflow-Automatisierung: Von der Extraktion über Bereinigung und Übersetzung bis zum Export – alles in einem Tool.

- Ideal für schnelles Testen: Egal ob Marktvalidierung, Lead-Liste oder Wettbewerbsbeobachtung – Thunderbit ist der schnellste und günstigste Einstieg.

Es ist wie ein Datenanalyst im Browser – einer, der nie Urlaub will und keine Gehaltserhöhung verlangt.

Fazit: Mit dem richtigen automatisierten Web-Scraping-Tool durchstarten

Die Web-Scraping-Welt 2025 ist größer, schlauer und zugänglicher als je zuvor. Egal ob Solo-Gründer, agiles Vertriebsteam oder Enterprise-Data-Scientist – in dieser Liste findest du das passende Tool. Entscheidend ist, dass du Workflow und Know-how mit der richtigen Plattform kombinierst – so sparst du dir Programmierfrust und gewinnst wertvolle Einblicke.

Bereit, Copy-Paste hinter dir zu lassen? und erlebe, wie einfach Web-Scraping sein kann. Oder entdecke die anderen Optionen je nach Bedarf. So oder so: Die Zukunft datengetriebener Unternehmen gehört denen, die automatisieren.

Mehr erfahren? Im findest du Deep Dives, Tutorials und Tipps für den optimalen Einsatz deiner Webdaten. Viel Erfolg beim Scrapen – und denk dran: Mögen deine Daten immer sauber sein und deine Scraper nie ausfallen (und falls doch, lass die KI ran).

Häufige Fragen (FAQ)

1. Warum sind automatisierte Web-Scraping-Tools 2025 für Unternehmen so wichtig?

Automatisierte Web-Scraping-Tools beschleunigen die Datenerfassung, sparen Zeit und reduzieren manuelle Arbeit. Sie sorgen für bessere Datenqualität, ermöglichen schnelle Entscheidungen und machen es auch Nicht-Technikern leicht, Webdaten zu extrahieren und zu nutzen – ohne Programmierkenntnisse. Für Vertrieb, Marketing und Operations sind sie heute unverzichtbar.

2. Was unterscheidet Thunderbit von anderen Web-Scraping-Tools?

Thunderbit nutzt KI, damit Nutzer einfach in Alltagssprache beschreiben können, welche Daten sie brauchen. Das Tool erkennt Felder automatisch, verarbeitet Subpages und Paginierung und exportiert Ergebnisse direkt nach Excel oder Airtable. Es ist speziell für Nicht-Techniker konzipiert und bietet starke Features wie Datenbereinigung und geplantes Scraping zu einem günstigen Preis.

3. Welches Tool eignet sich am besten für große Enterprise-Scraping-Projekte?

Bright Data und sind ideal für Unternehmen. Sie bieten Proxy-Rotation, Anti-Bot-Mechanismen, hohe Parallelität und API-Zugriff – perfekt für Organisationen, die tausende Webseiten zuverlässig und skalierbar verarbeiten müssen.

4. Gibt es Tools, die Scraping mit Automatisierung und Outreach kombinieren?

Ja, Tools wie Clay und Bardeen verbinden Web-Scraping mit Workflows. Clay reichert Leads an und automatisiert Outreach, während Bardeen browserbasierte Aufgaben und Workflows mit KI-Playbooks automatisiert.

5. Was ist die beste Option für Nutzer ohne Technikkenntnisse?

Thunderbit ist für Nicht-Techniker besonders geeignet: Dank alltagssprachlicher Bedienung, KI-gestütztem Setup und einfacher Nutzung braucht es weder Code noch Einrichtung. Ideal für Business-Anwender, die schnell und zuverlässig Daten wollen – ohne technischen Aufwand.