Wer schon mal an einem trüben Montagmorgen stundenlang Datenzeilen von einer Webseite in eine Tabelle kopiert hat, weiß, wie zäh das sein kann. Solche Aufgaben bringen einen schnell dazu, die eigene Jobwahl und den Kaffeekonsum zu hinterfragen. Die gute Nachricht: Im Jahr 2026 sind automatisierte Data-Extraction-Software und Tools zur Automatisierung der Datenauslese längst nicht mehr nur ein Thema für große Tech-Firmen. Sie sind zum Must-have für Vertrieb, Operations und alle geworden, die aus Datenchaos wertvolle Infos machen wollen. Mit den richtigen Automatisierungstools spart dein Team jede Woche viele Stunden, arbeitet genauer – und kann den Kaffee vielleicht sogar noch warm genießen.

Der Markt für automatisierte Datenauslese boomt. Schon 2025 war die Branche für Web-Scraping und Automatisierung , und praktisch jedes Unternehmen – egal ob groß oder klein – sucht nach Wegen, manuelle Routinearbeiten zu automatisieren. Die manuelle Dateneingabe ist immer noch das : Sie ist nicht nur langsam, sondern auch teuer, fehleranfällig und skaliert so schlecht wie ein Papierflieger im Sturm. Wie findet man also das richtige Tool? Nach vielen Jahren in SaaS und Automatisierung habe ich die 18 besten automatisierten Data-Extraction-Lösungen für 2026 zusammengestellt – jede mit eigenen Stärken, Besonderheiten und idealen Einsatzbereichen.

Lass uns gemeinsam eintauchen und das Tool finden, mit dem du Copy-Paste-Marathons endgültig hinter dir lassen kannst.

Warum automatisierte Data-Extraction-Software 2026 ein Muss ist

Fakt ist: Geschäftsdaten wachsen schneller als mein E-Mail-Postfach. Teams aus Vertrieb, Marketing und Operations stehen vor einer Datenflut – Produktlisten, Leads, Preise, Bewertungen, Compliance-Dokumente und vieles mehr. Doch . Selbst die besten Excel-Profis machen irgendwann Fehler oder sind einfach ausgebrannt.

Automatisierte Data-Extraction-Software dreht das Spiel komplett um, indem sie:

- Wiederholungsarbeiten abschafft: Kein mühsames Kopieren einzelner Felder mehr. Automatisierungstools holen tausende Zeilen in wenigen Minuten.

- Die Genauigkeit erhöht: KI und regelbasierte Extraktion minimieren Tippfehler, fehlende Felder und Dubletten ().

- Mit deinem Unternehmen wächst: Egal ob 100 oder 100.000 Datensätze – Automatisierung hält locker mit, ganz ohne Überstunden.

- Sich nahtlos in Workflows integriert: Moderne Tools exportieren direkt nach Google Sheets, ins CRM oder Data Warehouse – so kann dein Team sofort mit aktuellen Daten arbeiten.

Das Fazit: . Dank No-Code- und KI-Lösungen profitieren inzwischen auch Teams ohne IT-Know-how.

So haben wir die besten Tools zur Automatisierung der Datenauslese ausgewählt

Bei der riesigen Auswahl fühlt sich die Suche nach dem passenden Tool schnell wie Speed-Dating auf einer Tech-Messe an. Ich habe dutzende Lösungen getestet und nach diesen Kriterien bewertet:

- Benutzerfreundlichkeit: Kommen auch Nicht-Programmierer schnell klar? Gibt es eine steile Lernkurve?

- Unterstützung für strukturierte & unstrukturierte Daten: Kann das Tool mit Webseiten, PDFs, Bildern und mehr umgehen?

- Automatisierungsfunktionen: Gibt es Features wie Paginierung, Subpages, Zeitplanung und Echtzeit-Updates?

- Integrationsmöglichkeiten: Lässt sich nach Excel, Google Sheets, CRM oder ins Data Warehouse exportieren?

- Skalierbarkeit & Flexibilität: Ist das Tool für Einzelaufgaben oder auch für große Unternehmensprojekte geeignet?

- Preis & Mehrwert: Gibt es kostenlose Tarife? Ist die Preisgestaltung transparent und fair für die gebotenen Funktionen?

Außerdem habe ich Nutzerbewertungen, Supportqualität und die Eignung für verschiedene Business-Szenarien – besonders für Vertrieb, E-Commerce und Operations – berücksichtigt.

Hier kommen die 18 besten Tools zur Automatisierung der Datenauslese für 2026.

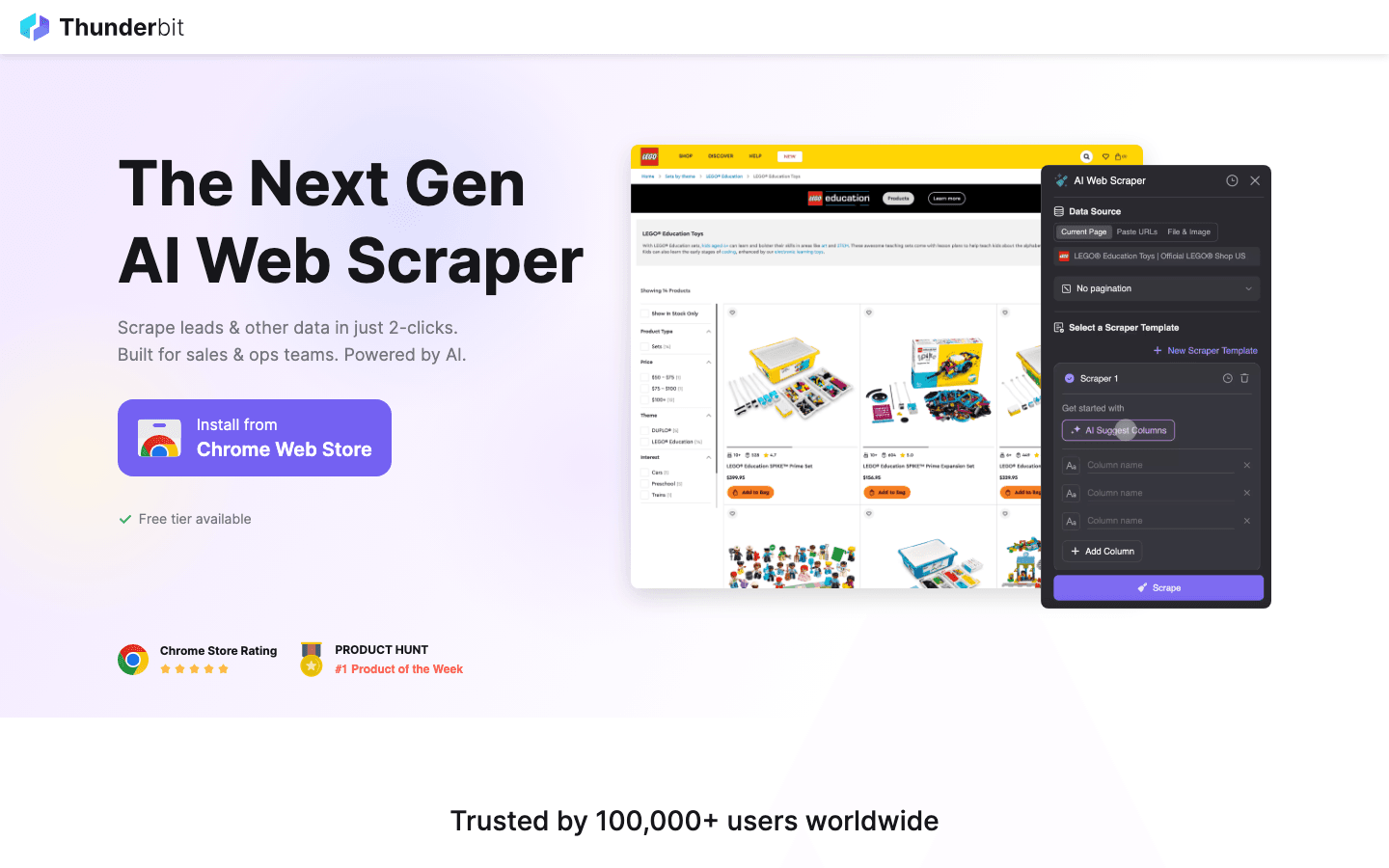

1. Thunderbit

ist meine Top-Empfehlung für Business-User, die KI-gestützte Datenauslese ohne Technikstress wollen. Als Mitgründer bin ich natürlich voreingenommen – aber unser Ziel war immer, Web-Datenerfassung so einfach wie Essensbestellung zu machen. Thunderbit ist eine , mit der du einfach in Alltagssprache beschreibst, was du brauchst („Alle Produktnamen und Preise von dieser Seite holen“) – den Rest erledigt die KI.

Was Thunderbit besonders macht:

- KI-Feldvorschläge: Ein Klick, und Thunderbit liest die Seite, schlägt Spaltennamen vor und erstellt Extraktions-Prompts für jedes Feld.

- 2-Klick-Setup: Keine Vorlagen, kein Code. Einfach „KI-Felder vorschlagen“ und „Scrapen“.

- Subpage- & Paginierungs-Scraping: Thunderbit folgt Links zu Unterseiten (z. B. Produktdetails, Profile) und kommt mit endlosem Scrollen oder Klick-Paginierung klar – so entgeht dir kein Datensatz.

- Sofort-Export: Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable oder Notion. Download als CSV oder JSON – kostenlos, ohne Haken.

- Geplantes Scraping: Lege wiederkehrende Jobs an, damit dein CRM oder deine Tabelle immer aktuell bleibt.

- Kostenloser Datenexport: Kein Export-Paywall für deine gesammelten Daten.

- Unterstützt 34 Sprachen: Perfekt für internationale Teams.

Thunderbit ist besonders beliebt bei Vertriebs-, E-Commerce- und Operations-Teams, die Leads scrapen, Preise überwachen oder Listen aggregieren wollen – ohne auf die IT zu warten. Mit einem kostenlosen Einstieg (bis zu 6 Seiten scrapen) kannst du risikolos testen. Bezahlpläne starten ab 15 $/Monat für 500 Credits, mit höheren Stufen für Power-User.

Mehr dazu im oder auf unserem .

2. Octoparse

ist ein visuelles Web-Scraping-Tool mit Drag-and-Drop-Workflow, das besonders bei langen, scrollenden Seiten glänzt – etwa bei E-Commerce-Katalogen oder Jobbörsen mit Endlos-Scroll.

Warum Octoparse so beliebt ist:

- Visueller Workflow: Scraping-Aufgaben per Klick zusammenstellen – ganz ohne Programmierung.

- Paginierung & Endlos-Scroll: Auch sehr lange Seiten sind kein Problem.

- Vorlagen-Bibliothek: Vorgefertigte Templates für bekannte Seiten wie Amazon, Google Maps und mehr.

- Cloud- & Lokale Ausführung: Jobs lokal oder in der Cloud laufen lassen – für mehr Geschwindigkeit und größere Datenmengen.

- Zeitplanung: Aufgaben automatisch ausführen und Daten aktuell halten.

Octoparse ist ideal für nicht-technische Nutzer, die Flexibilität und Power wollen. Für Vielnutzer kann es allerdings teuer werden (ab ca. 75 $/Monat). Für kleine Aufgaben ist die Gratis-Version großzügig.

3. ParseHub

steht für maximale Flexibilität. Mit dem visuellen Parser lassen sich auch komplexe Webseiten mit verschachtelter Navigation, dynamischen Inhalten und anspruchsvollen Layouts auslesen.

Stärken von ParseHub:

- Individuelle Workflows: Felder per Klick auswählen, Schleifen und Bedingungen einrichten.

- Komplexe Seiten meistern: Ideal für Karten, Kalender oder Seiten mit viel JavaScript.

- Exportoptionen: Download als CSV, Excel oder JSON; API-Integration möglich.

- Cloud-basiert: Große Jobs laufen, ohne den eigenen Rechner zu blockieren.

ParseHub eignet sich für Teams, die maßgeschneiderte Scraper brauchen, hat aber eine steilere Lernkurve als Thunderbit oder Octoparse. Die Preisgestaltung ist nutzungsbasiert, mit kostenlosem Einstieg für kleine Projekte.

4. Import.io

ist eine Enterprise-Plattform für Datenauslese im großen Stil. Sie wird von Fortune-500-Unternehmen und datengetriebenen Firmen genutzt, die Wert auf Automatisierung, Compliance und Integration legen.

Import.io im Überblick:

- API-First: Daten per API extrahieren, mit BI-Tools integrieren oder Workflows automatisieren.

- Echtzeit-Datenfeeds: Dashboards und Analysen mit Live-Daten versorgen.

- Compliance & Sicherheit: Enterprise-Standards für regulierte Branchen.

- Skalierbarkeit: Millionen Datensätze und komplexe Seiten problemlos verarbeiten.

Import.io ist ideal für große Unternehmen mit hohen Datenanforderungen. Die Preise sind individuell, Enterprise-Features starten ab ca. 299 $/Monat.

5. Scrapy

ist der Goldstandard für Entwickler, die maximale Kontrolle wollen. Das Open-Source-Python-Framework wird für Preisvergleichsportale, Forschung und vieles mehr eingesetzt.

Warum Entwickler Scrapy lieben:

- Höchste Anpassbarkeit: Eigene Spider schreiben, jede Webseite auslesen und Daten beliebig verarbeiten.

- Schnell & skalierbar: Für große Crawling-Projekte optimiert.

- Aktive Community: Viele Plugins, Tutorials und Support.

Scrapy ist nichts für Einsteiger – man braucht Python-Kenntnisse und Zeit zum Einarbeiten. Für technische Teams ist es jedoch kaum zu schlagen.

6. Apify

ist eine Automatisierungsplattform, die weit über klassisches Scraping hinausgeht. Im Marketplace gibt es vorgefertigte „Actors“ (Mini-Apps) für Web-Crawling, PDF-Extraktion und vieles mehr.

Besonderheiten von Apify:

- Actor-Marktplatz: Fertige Lösungen für Standardaufgaben oder eigene Actors bauen.

- Cloud-Ausführung: Jobs in der Cloud skalieren, ohne Server zu verwalten.

- API-Integration: Anbindung an Datenpipelines oder Workflow-Tools.

- Vielseitige Automatisierung: Scraping, Crawling, Datenumwandlung und mehr.

Apify ist ideal für Teams, die Flexibilität und Automatisierungstiefe suchen. Die Abrechnung erfolgt nach Nutzung, mit kostenlosem Einstieg für kleine Aufgaben.

7. Content Grabber

richtet sich an Unternehmen, die maßgeschneiderte, großvolumige Datenauslese benötigen. Es bietet eine Point-and-Click-Oberfläche und Scripting für Fortgeschrittene.

Stärken von Content Grabber:

- Individuelle Scripte: Mit VB.NET komplexe Workflows umsetzen.

- Enterprise-Integration: Anbindung an Datenbanken, CRM und Business-Systeme.

- Flexible Bereitstellung: Lokal oder in der Cloud nutzbar.

- Datenschutz & Sicherheit: Erfüllt hohe Compliance-Anforderungen.

Content Grabber ist ideal für Unternehmen mit speziellen Anforderungen und eigenen IT-Ressourcen.

8. Kofax Kapow

kombiniert Robotic Process Automation (RPA) mit Datenauslese. Es ist für die End-to-End-Automatisierung von Geschäftsprozessen konzipiert, nicht nur fürs Scraping.

Was Kapow besonders macht:

- RPA + Datenauslese: Workflows über Web, Desktop und Unternehmensanwendungen automatisieren.

- No-Code-Bots: Automatisierung ohne Programmierkenntnisse.

- Strukturierte & unstrukturierte Daten: Extraktion aus Webseiten, PDFs, E-Mails und mehr.

- Enterprise-Integration: Anbindung an ERP, CRM und andere Systeme.

Kapow ist ideal für große Unternehmen, die komplexe, mehrstufige Prozesse automatisieren wollen.

9. Helium Scraper

ist ein Desktop-Tool mit Drag-and-Drop-Oberfläche. Es richtet sich an nicht-technische Nutzer, die Extraktions-Workflows visuell erstellen möchten.

Highlights von Helium Scraper:

- Visueller Workflow-Builder: Kein Programmieren nötig.

- Dynamische Webseiten: Kommt mit JavaScript und AJAX klar.

- Datenaggregation: Daten aus mehreren Quellen zusammenführen.

- Günstige Preise: Einmalige Lizenz oder Abo.

Helium Scraper eignet sich für kleine Unternehmen oder Forscher, die Einfachheit und Leistung suchen.

10. Data Miner

ist eine Chrome-Erweiterung für schnelle, vorlagenbasierte Datenauslese. Perfekt, um Daten aus Tabellen, Listen und einfachen Webseiten zu extrahieren.

Warum Data Miner praktisch ist:

- Vorlagen-Bibliothek: Tausende fertige Templates für bekannte Seiten.

- Point-and-Click-Extraktion: Felder visuell auswählen.

- Export zu Sheets: Daten direkt nach Google Sheets oder Excel senden.

- Team-Sharing: Vorlagen gemeinsam nutzen.

Data Miner ist ideal für kleine, spontane Aufgaben. Es gibt eine kostenlose Version, Power-User können upgraden.

11. Mozenda

ist eine Cloud-Plattform für Business-Teams. Sie bietet Point-and-Click-Setup, Zeitplanung und viele Integrationsmöglichkeiten.

Mozendas Business-Fokus:

- Cloud-Automatisierung: Jobs laufen ohne lokale Software.

- Zeitplanung: Daten werden automatisch aktuell gehalten.

- Integration: Export zu Datenbanken, CRM oder Analyse-Tools.

- Team-Kollaboration: Projekte und Ergebnisse teilen.

Mozenda ist beliebt bei Research-, Marketing- und Operations-Teams. Preise starten ab ca. 99 $/Monat.

12. Automation Anywhere

ist eine führende RPA-Plattform, mit der Unternehmen Bots für wiederkehrende Aufgaben – inklusive Datenauslese – bauen können.

Stärken von Automation Anywhere:

- RPA-Bots: Automatisieren Dateneingabe, -auslese und Workflows.

- Integration: Anbindung an Unternehmensanwendungen, Webseiten und Altsysteme.

- KI & IDP: Intelligente Dokumentenverarbeitung für PDFs, Rechnungen und mehr.

- Skalierbarkeit: Für große Unternehmen konzipiert.

Ideal für Unternehmen, die komplette Geschäftsprozesse automatisieren wollen, nicht nur Web-Scraping.

13. UiPath

ist ein weiterer RPA-Riese, bekannt für Benutzerfreundlichkeit und umfassende Automatisierungsfunktionen.

UiPath-Features:

- Drag-and-Drop-Automatisierung: Bots visuell erstellen.

- Datenauslese: Scraping aus Web, Desktop-Apps, PDFs und mehr.

- Enterprise-Ready: Governance, Sicherheit und Skalierbarkeit.

- Marketplace: Zugriff auf vorgefertigte Automatisierungskomponenten.

UiPath wird häufig in Finanzen, Gesundheitswesen und Operations für die Automatisierung repetitiver Datenaufgaben eingesetzt.

14. Blue Prism

ist eine Enterprise-RPA-Plattform mit Fokus auf skalierbare, sichere Automatisierung.

Highlights von Blue Prism:

- Skalierbare RPA: Datensammlung über Systeme und Apps hinweg automatisieren.

- Governance & Compliance: Starke Kontrollen für regulierte Branchen.

- Integration: Anbindung an APIs, Datenbanken und Cloud-Services.

- KI & Analytics: Bots mit KI-gestützten Insights erweitern.

Blue Prism ist ideal für große Unternehmen mit komplexen Automatisierungsanforderungen.

15. Datahut

bietet Managed Data Extraction Services. Wer fertige Daten braucht, ohne eigene Scraper zu bauen, ist hier richtig.

Warum Datahut wählen:

- Managed Service: Du sagst, was du brauchst – Datahut liefert saubere, strukturierte Daten.

- Individuelle Projekte: Auch komplexe, großvolumige Extraktion möglich.

- Kein Setup nötig: Ideal für Teams ohne eigene IT-Ressourcen.

Datahut ist beliebt bei Unternehmen, die individuelle Datensätze benötigen, aber den Prozess nicht selbst steuern wollen.

16. Fivetran

automatisiert Datenpipelines. Es extrahiert und synchronisiert Daten aus hunderten Quellen – Web, SaaS, Datenbanken – ins Data Warehouse.

Fivetrans Automatisierungsvorteile:

- Connector-Ökosystem: Hunderte vorgefertigte Schnittstellen.

- Echtzeit-Sync: Analytics immer aktuell halten.

- No-Code-Setup: In wenigen Minuten startklar.

- Sicher & zuverlässig: Enterprise-Standards für Verfügbarkeit und Compliance.

Fivetran ist ideal für Analytics-Teams, die Datenintegration automatisieren wollen, nicht nur Scraping.

17. Talend

ist eine umfassende Plattform für Data Extraction, Transformation und Integration (ETL).

Talends Enterprise-Fokus:

- Batch- & Echtzeitverarbeitung: Große Datenmengen und Streaming-Quellen verarbeiten.

- Data Governance: Qualität, Herkunft und Compliance sicherstellen.

- Integration: Anbindung an Cloud, On-Premises und hybride Systeme.

- Open Source & kommerziell: Flexible Bereitstellung.

Talend eignet sich für große Unternehmen mit komplexen Datenworkflows.

18. Skyvia

ist eine No-Code-Cloud-Plattform für automatisierte Datenauslese, Integration und Synchronisation.

Stärken von Skyvia:

- No-Code-Oberfläche: Pipelines ohne IT-Unterstützung einrichten.

- Große Connector-Bibliothek: Integration mit Datenbanken, SaaS und Cloud-Apps.

- Zeitplanung & Automatisierung: Datenflüsse automatisch aktuell halten.

- Günstige Preise: Gratis-Tarif und Pay-as-you-go.

Skyvia ist ideal für kleine Unternehmen und Teams, die einfache, cloudbasierte Datenautomatisierung suchen.

Vergleichstabelle: Automatisierte Data-Extraction-Software

Hier ein schneller Überblick über alle 18 Tools:

| Tool | Benutzerfreundlichkeit | Unterstützte Datenquellen | Zeitplanung | Integrationen | Ideal für | Preise (2026) |

|---|---|---|---|---|---|---|

| Thunderbit | ⭐⭐⭐⭐⭐ | Web, PDF, Bild | Ja | Excel, Sheets, CRM | Vertrieb, E-Commerce, Ops | Kostenlos, ab 15 $/Monat |

| Octoparse | ⭐⭐⭐⭐ | Web | Ja | Excel, Sheets | E-Commerce, Research | Kostenlos, ab 75 $/Monat |

| ParseHub | ⭐⭐⭐⭐ | Web | Ja | Excel, JSON, API | Individuelle Projekte | Kostenlos, nutzungsbasiert |

| Import.io | ⭐⭐⭐ | Web, API | Ja | API, BI-Tools | Enterprise, Analytics | Individuell, ab 299 $/Monat |

| Scrapy | ⭐⭐ | Web | Nein | Individuell (Python) | Entwickler | Kostenlos, Open Source |

| Apify | ⭐⭐⭐⭐ | Web, PDF, mehr | Ja | API, Workflow-Tools | Automatisierung, Dev-Teams | Kostenlos, Pay-as-you-go |

| Content Grabber | ⭐⭐⭐ | Web | Ja | DB, CRM, individuell | Enterprise, individuell | Individuell, ab 189 $/Monat |

| Kofax Kapow | ⭐⭐⭐ | Web, PDF, Apps | Ja | ERP, CRM, RPA | Enterprise, RPA | Individuell |

| Helium Scraper | ⭐⭐⭐⭐ | Web | Nein | CSV, Excel | KMU, Forschung | Einmalig/Lizenz |

| Data Miner | ⭐⭐⭐⭐ | Web | Nein | Sheets, Excel | Schnelle Aufgaben | Kostenlos, kostenpflichtig |

| Mozenda | ⭐⭐⭐⭐ | Web | Ja | DB, CRM, Analytics | Business-Teams | Ab 99 $/Monat |

| Automation Anywhere | ⭐⭐⭐ | Web, PDF, Apps | Ja | RPA, Enterprise | RPA, Ops | Individuell |

| UiPath | ⭐⭐⭐⭐ | Web, PDF, Apps | Ja | RPA, Marketplace | RPA, Ops | Individuell |

| Blue Prism | ⭐⭐⭐ | Web, Apps, API | Ja | RPA, Enterprise | Enterprise, Ops | Individuell |

| Datahut | ⭐⭐⭐⭐⭐ | Web, individuell | Ja | Fertige Daten | Managed Services | Individuell |

| Fivetran | ⭐⭐⭐⭐⭐ | Web, SaaS, DB | Ja | Data Warehouses | Analytics, Integration | Kostenlos, kostenpflichtig |

| Talend | ⭐⭐⭐ | Web, DB, Cloud | Ja | ETL, Data Gov | Enterprise, Integration | Kostenlos, kostenpflichtig |

| Skyvia | ⭐⭐⭐⭐⭐ | Web, DB, SaaS | Ja | Cloud, DB, SaaS | KMU, No-Code-Teams | Kostenlos, Pay-as-you-go |

So findest du das passende Tool zur Datenauslese für dein Unternehmen

Welches Tool zur Automatisierung der Datenauslese passt zu dir? Hier meine Schnellübersicht:

- Für nicht-technische Teams (Vertrieb, Ops, E-Commerce): oder für den einfachsten Einstieg und schnelle Ergebnisse.

- Für individuelle, komplexe Projekte: , oder bieten maximale Anpassung.

- Für Automatisierung im großen Stil: , , , und sind für große Unternehmen gemacht.

- Für Managed Services: liefert fertige Daten – ohne eigenen Aufwand.

- Für Analytics und Integration: , und automatisieren Datenpipelines und Synchronisation.

Empfehlungen nach Szenario:

- Produktlisten scrapen und Preise überwachen? Thunderbit oder Octoparse.

- Individuelle Lead-Generierung aufbauen? ParseHub oder Apify.

- Rechnungs- und Dokumentenverarbeitung automatisieren? UiPath oder Automation Anywhere.

- Mehrere SaaS-Apps und Datenbanken integrieren? Fivetran oder Skyvia.

Die meisten Tools bieten kostenlose Testphasen – probiere aus, was am besten zu deinem Workflow passt.

Fazit: Mehr Effizienz durch automatisierte Data-Extraction

Manuelle Dateneingabe ist bald Geschichte – und das ist auch gut so. 2026 sind automatisierte Data-Extraction-Software und Tools zur Automatisierung der Datenauslese das Geheimnis für Teams, die schneller arbeiten, bessere Entscheidungen treffen und Routineaufgaben den Bots überlassen wollen. Egal ob du im Vertrieb Leads sammelst, im E-Commerce Preise beobachtest oder als Operations-Manager Berichte zusammenstellst: In dieser Liste findest du ein Tool, das dir jede Woche Stunden (und Nerven) spart.

Mein Tipp: Schau dir deinen aktuellen Workflow an, wähle ein passendes Tool und starte mit einem kleinen Pilotprojekt. Der ROI ist echt – . Und wer weiß – vielleicht genießt du deinen Kaffee bald wieder warm.

Du willst sehen, wie einfach Automatisierung sein kann? und probiere es aus – oder stöbere im für weitere Tipps und Insights.

Häufige Fragen (FAQ)

1. Was ist automatisierte Data-Extraction-Software?

Automatisierte Data-Extraction-Software ist ein Tool, das strukturierte oder unstrukturierte Daten aus Webseiten, Dokumenten oder Apps extrahiert – ganz ohne manuelles Kopieren. Sie nutzt KI, Regeln oder Skripte, um Daten zu sammeln, zu bereinigen und für das Unternehmen nutzbar zu machen.

2. Wie helfen Tools zur Automatisierung der Datenauslese Vertriebs- und Operationsteams?

Sie sparen Zeit, indem sie wiederkehrende Aufgaben wie Lead-Scraping, Preisüberwachung und Berichtserstellung automatisieren. Das steigert die Produktivität, reduziert Fehler und gibt Teams mehr Freiraum für wertschöpfende Arbeit.

3. Können auch Nicht-Techniker diese Tools nutzen?

Auf jeden Fall. Tools wie Thunderbit, Octoparse und Data Miner sind für Nicht-Programmierer gemacht – mit visuellen Oberflächen und KI-gestütztem Setup. Technischere Tools (wie Scrapy) erfordern Programmierkenntnisse.

4. Worauf sollte ich bei automatisierter Data-Extraction-Software achten?

Wichtige Kriterien sind Benutzerfreundlichkeit, Unterstützung für Paginierung und Subpages, Zeitplanung, Integration mit deinen Lieblings-Apps und die Fähigkeit, sowohl strukturierte als auch unstrukturierte Daten zu verarbeiten.

5. Ist die Nutzung automatisierter Data-Extraction-Tools legal?

In der Regel ja – solange du öffentlich zugängliche Daten scrapest und die Nutzungsbedingungen der Webseiten beachtest. Prüfe immer die rechtlichen Vorgaben für deine Region und deinen Anwendungsfall und vermeide das Scrapen von persönlichen oder sensiblen Daten ohne Erlaubnis.

Bereit für automatisierte Datenauslese? Starte mit einer kostenlosen Testphase und lass die Bots die Arbeit übernehmen. Dein zukünftiges Ich (und dein Kaffee) werden es dir danken.

Mehr erfahren