Das Internet wächst so rasant, dass selbst die aufmerksamsten Analysten kaum noch hinterherkommen. Bis 2026 wird erwartet, dass der – angetrieben von Unternehmen, die ständig nach frischen, verwertbaren Daten suchen. Doch klassisches Scraping ist oft eine echte Geduldsprobe: Skripte gehen ständig kaputt, Anti-Bot-Systeme werden immer schlauer und wer nicht programmieren kann, bleibt beim Copy-Paste wie im Jahr 1999 hängen. Genau hier kommen KI-Web-Scraper ins Spiel und machen aus einer technischen Hürde ein echtes Produktivitäts-Upgrade – für Vertrieb, Operations und alle, die Webdaten für bessere Entscheidungen brauchen.

Nach vielen Jahren in SaaS und Automatisierung weiß ich, wie sehr KI-gestütztes Scraping die Spielregeln verändert. Egal ob Lead-Listen, Wettbewerbsbeobachtung oder einfach aktuelle Excel-Tabellen – mit dem richtigen Tool sparst du nicht nur Zeit, sondern auch Nerven. Hier sind die 10 besten KI-Web-Scraping-Tools für 2026: Von No-Code-Lösungen bis hin zu Entwickler-Favoriten – damit du das passende Werkzeug für deinen Workflow findest.

Warum KI-Web-Scraping-Tools für moderne Unternehmen unverzichtbar sind

Webdaten sind das neue Öl – aber das Extrahieren sollte kein Informatikstudium voraussetzen. Die Zeiten von selbstgebauten Skripten, ständiger Wartung und dem ewigen Kampf gegen Anti-Bot-Maßnahmen sind vorbei. haben das Spiel verändert: Jetzt können auch Business-Anwender ohne Programmierkenntnisse Daten sammeln, strukturieren und exportieren – ganz ohne Stress.

Was hat sich geändert?

- Keine fragilen Skripte mehr: KI passt sich automatisch an Website-Änderungen an, sodass du nicht ständig kaputten Code reparieren musst ().

- No-Code- und Low-Code-Optionen: Vertrieb, Operations und Marketing können jetzt selbst Daten extrahieren – ohne auf die IT warten zu müssen.

- Intelligentere Extraktion: KI erkennt Muster, ergänzt fehlende Felder und kann Daten sogar direkt zusammenfassen oder kategorisieren.

- Skalierbarkeit: Moderne Tools meistern alles – von einmaligen Abfragen bis zu geplanten, großvolumigen Scraping-Jobs.

Das Ergebnis: Unternehmen, die auf KI-Web-Scraper setzen, berichten von und deutlich schnelleren Ergebnissen bei geschäftskritischen Projekten.

Typische Anwendungsfälle:

- Leadgenerierung: Zielgerichtete Listen aus Verzeichnissen, LinkedIn oder Eventseiten erstellen.

- Marktforschung: Preise, Bewertungen und Trends bei Wettbewerbern überwachen.

- Operations: Dateneingabe, Bestandsüberwachung und Compliance automatisieren.

So haben wir die besten KI-Web-Scraping-Tools ausgewählt

Bei der riesigen Auswahl fühlt sich die Suche nach dem richtigen Tool schnell wie Speed-Dating auf einer Tech-Konferenz an. Nach diesen Kriterien habe ich die Top 10 zusammengestellt:

- Benutzerfreundlichkeit: Können auch Nicht-Programmierer schnell loslegen? Wie steil ist die Lernkurve?

- KI-Anpassungsfähigkeit: Kommt das Tool mit wechselnden Websites, dynamischen Inhalten und unstrukturierten Daten klar?

- Automatisierung: Unterstützung für Zeitpläne, Cloud-Scraping und Workflow-Integration.

- Preisgestaltung: Gibt es eine kostenlose Version? Transparente Preise für Unternehmen?

- Support & Community: Gute Dokumentation, aktive Nutzerbasis und schneller Support.

- Bestes Einsatzszenario: Für Business-Anwender, Entwickler oder Enterprise-Teams?

Die Liste enthält No-Code-, Code-basierte, Browser-Erweiterungen und Cloud-Plattformen – egal ob Einzelunternehmer oder großes Datenteam, hier ist für jeden was dabei.

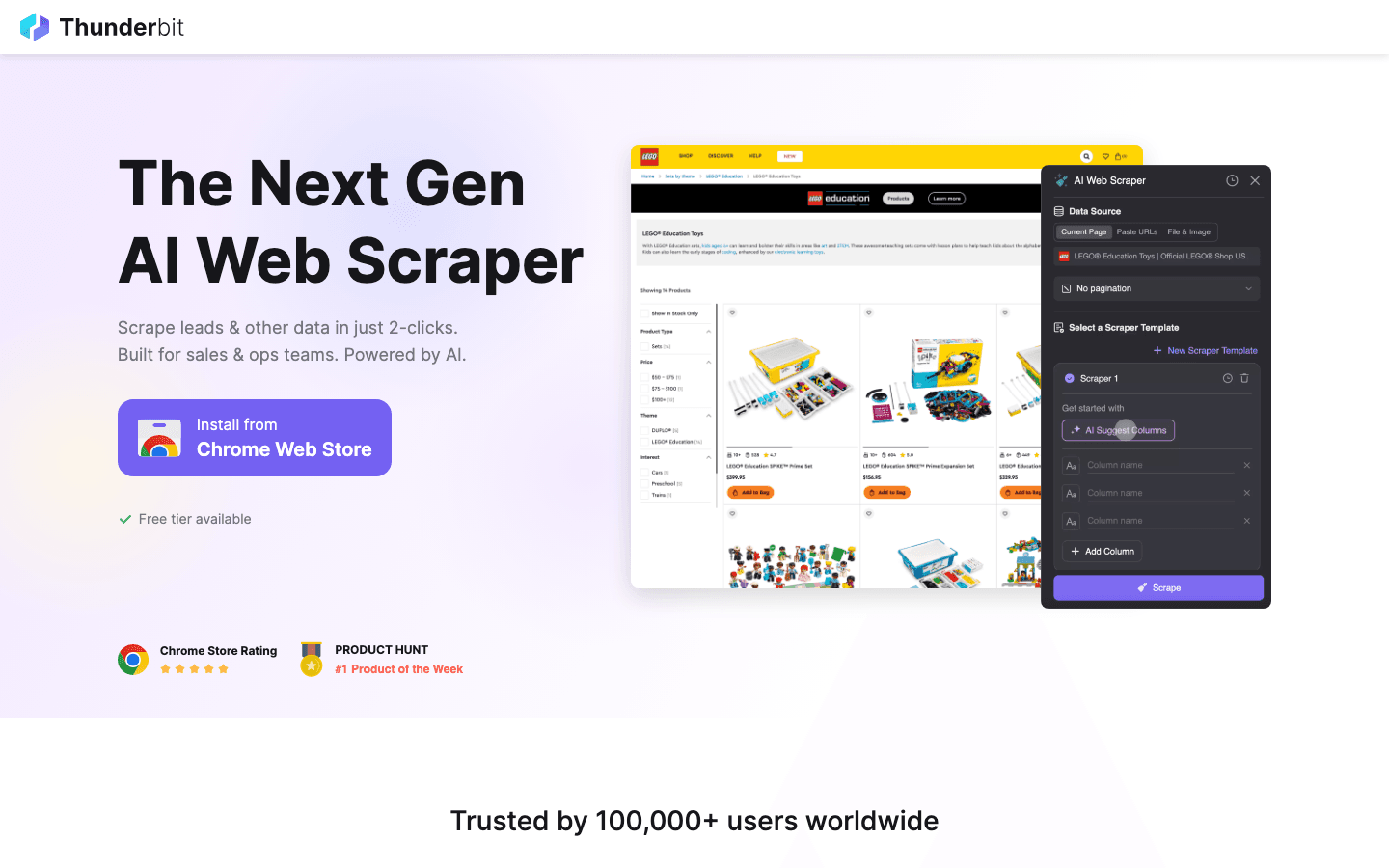

1. Thunderbit

ist meine absolute Empfehlung für alle, die ohne Programmieraufwand mit KI-Web-Scraping starten wollen. Als Mitgründer bin ich natürlich voreingenommen – aber Thunderbit wurde für Menschen entwickelt, die keine Lust auf Code, Vorlagen oder komplizierte Einrichtung haben. Einfach in Alltagssprache beschreiben, was du brauchst, auf „KI-Felder vorschlagen“ klicken – und die KI erledigt den Rest.

Highlights:

- Scraping in 2 Klicks: Natürliche Sprache + KI-Feldvorschläge = sofortige Ergebnisse.

- Unterseiten & Paginierung: Detailseiten, Bewertungen oder Listen ohne Aufwand extrahieren.

- Sofort-Vorlagen: Ein-Klick-Scraper für Amazon, Zillow, Shopify und viele mehr.

- Kostenloser Datenexport: Ergebnisse direkt nach Excel, Google Sheets, Notion oder Airtable senden.

- KI-Autofill: Nicht nur Daten extrahieren, sondern auch Formulare und Workflows automatisieren.

- Stufenweise Lernkurve: Einfach starten, bei Bedarf erweiterte Funktionen freischalten.

Warum Thunderbit überzeugt:

Es ist der einfachste Weg, auch ohne Technikkenntnisse strukturierte Daten zu extrahieren – selbst von komplexen, geschützten oder dynamischen Seiten. Besonders beliebt bei Vertriebs- und Operationsteams für Leadgenerierung, Preisüberwachung und Immobiliendaten. Es gibt eine großzügige Gratis-Version (bis zu 6 Seiten, mit Test-Boost bis zu 10) und kostenpflichtige Pläne ab nur 15 $/Monat.

Du willst Thunderbit in Aktion sehen? oder schau dir unseren für Tutorials an.

2. Octoparse

ist ein visuelles, No-Code-KI-Web-Scraping-Tool mit moderner Oberfläche und riesiger Vorlagenbibliothek. Ideal für alle, die flexibel bleiben wollen, aber keinen Code schreiben möchten.

Highlights:

- Visueller Workflow-Builder: Per Mausklick festlegen, was extrahiert werden soll.

- KI-gestützte Felderkennung: Erkennt Datenfelder auf den meisten Websites automatisch.

- Vorlagenbibliothek: Über 60.000 fertige Vorlagen für beliebte Seiten.

- Cloud- & lokales Scraping: Jobs am Desktop oder in der Cloud ausführen.

- Zeitplanung & Automatisierung: Wiederkehrende Scrapes für stets aktuelle Daten.

Preise:

Kostenlose Version für kleine Aufgaben (bis zu 10 Tasks, 50.000 Zeilen/Monat). Bezahlpläne ab 75 $/Monat für mehr Volumen und Funktionen.

Ideal für:

Teams, die regelmäßig verschiedene Seiten visuell und vorlagenbasiert scrapen möchten.

3. Scrapy

ist der Goldstandard für Entwickler, die maßgeschneiderte, skalierbare und Open-Source-Scraping-Lösungen suchen. In Python geschrieben, extrem flexibel und bestens mit KI-Modulen kombinierbar.

Highlights:

- Vollständige Code-Kontrolle: Eigene Spider für jede Website und jeden Workflow.

- Skalierbare Pipelines: Millionen Seiten verarbeiten, Datenbanken und ML-Modelle integrieren.

- Aktive Community: Viele Plugins, Dokumentation und Support.

- KI-Integration: Mit NLP oder Computer Vision für fortgeschrittene Datenstrukturierung kombinierbar.

Preise:

Kostenlos und Open Source – nur Zeit und Infrastruktur erforderlich.

Ideal für:

Technische Nutzer, Data Engineers und alle, die große, individuelle Scraping-Projekte umsetzen.

4. ParseHub

bietet eine klickbasierte, visuelle Oberfläche, um auch komplexe, JavaScript-lastige Seiten zu scrapen. Kein Code nötig, aber mit viel Logik-Potenzial.

Highlights:

- Point-and-Click-Einrichtung: Elemente visuell auswählen, auch auf dynamischen Seiten.

- KI-gestützte Erkennung: Meistern auch verschachtelte Daten und schwierige Layouts.

- Cloud-Scraping & Zeitplanung: Wiederkehrende Jobs automatisieren, Export nach Excel/JSON.

- API-Zugang: In eigene Workflows integrierbar.

Preise:

Kostenlose Basisversion. Bezahlpläne ab 149 $/Monat für mehr Volumen und Funktionen.

Ideal für:

Business-Anwender, die komplexe Seiten visuell und logisch scrapen möchten.

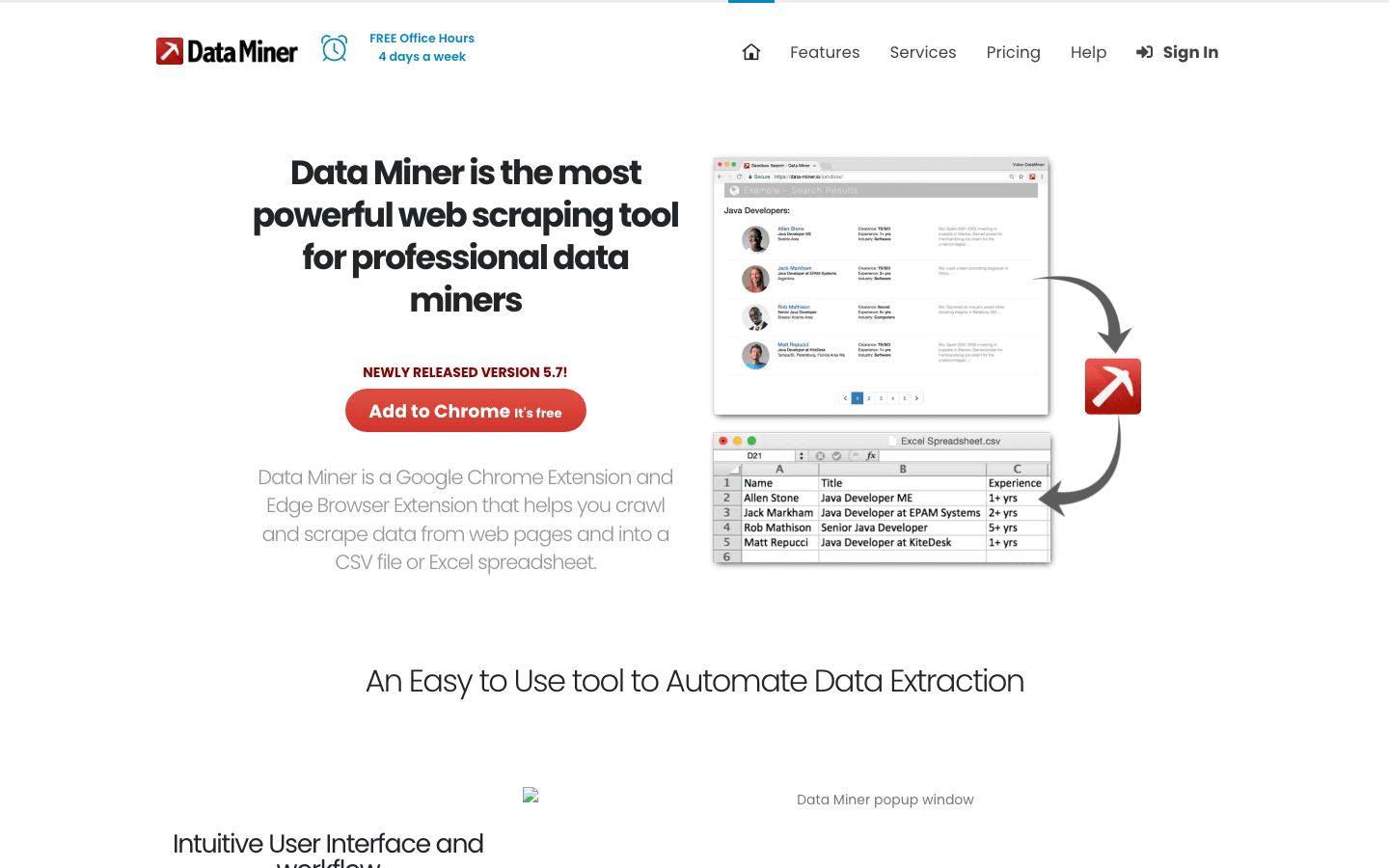

5. DataMiner

ist eine Chrome/Edge-Erweiterung für schnelles, vorlagenbasiertes Scraping. Perfekt für kleine Aufgaben, Listen oder wenn es schnell gehen muss.

Highlights:

- Browserbasiert: Keine Installation – einfach Erweiterung hinzufügen.

- 60.000+ öffentliche Vorlagen: Google-Suche, LinkedIn, Verzeichnisse und mehr scrapen.

- Ein-Klick-Export: Direkt als CSV, Excel oder Google Sheets herunterladen.

- Eigene Rezepte: Eigene Vorlagen für wiederkehrende Aufgaben erstellen.

Preise:

Kostenlos bis 500 Seiten/Monat. Bezahlpläne ab 19 $/Monat für mehr Volumen und Funktionen.

Ideal für:

Vertrieb, Recherche oder alle, die schnell Daten direkt im Browser extrahieren möchten.

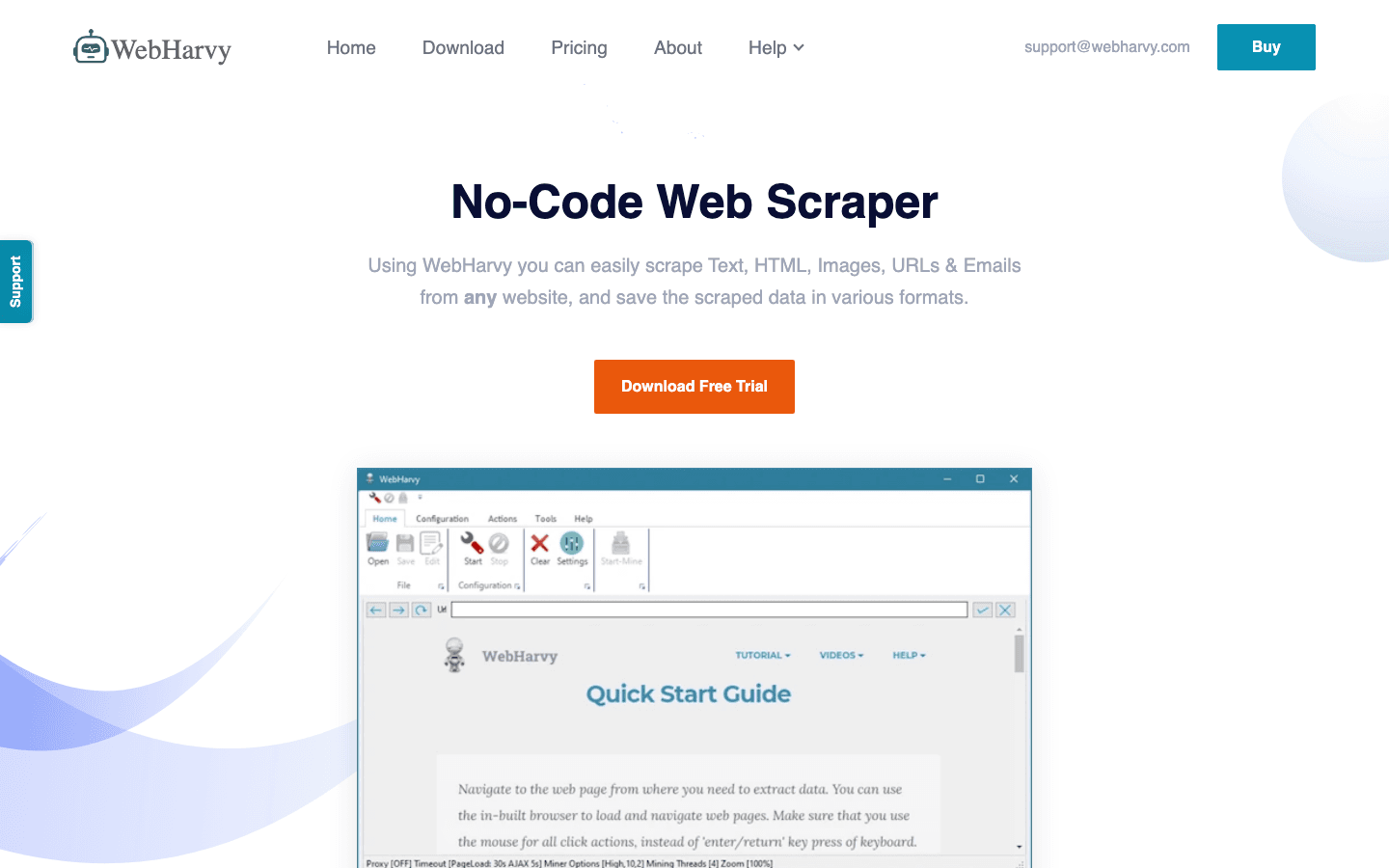

6. WebHarvy

ist eine Desktop-App (Windows) mit Point-and-Click-Oberfläche und automatischer Mustererkennung. Besonders stark beim Scraping von Bildern und gemischten Inhalten.

Highlights:

- Visuelle Auswahl: Elemente anklicken, um Text, Bilder oder Links zu extrahieren.

- Mustererkennung: Wiederholende Daten für Massenscraping automatisch erkennen.

- Paginierung: Mehrseitige Listen problemlos extrahieren.

- Exportoptionen: Excel, CSV, XML oder direkt in Datenbanken.

Preise:

Einmalige Lizenz (ca. 139 $), inkl. Updates und Support für ein Jahr.

Ideal für:

Nicht-technische Nutzer, die ein Desktop-Tool für bildlastige oder komplexe Seiten suchen.

7. Import.io

ist eine Cloud-Plattform für großvolumiges, automatisiertes KI-Web-Scraping. Besonders für Unternehmen geeignet, mit umfangreichen Funktionen für Zeitplanung, Workflows und Compliance.

Highlights:

- Cloud-Automatisierung: Wiederkehrende Scrapes planen, große Datenmengen verarbeiten.

- KI-gestützte Extraktion: Kommt mit Logins, CAPTCHAs und dynamischen Inhalten zurecht.

- Workflow-Integration: Anbindung an BI-Tools, CRMs und mehr.

- Datenbereinigung: Integrierte Tools für Dublettenprüfung und Validierung.

Preise:

Individuelle Angebote, meist ab ca. 299 $/Monat. Keine kostenlose Version.

Ideal für:

Unternehmen und Datenteams, die skalierbare, verwaltete und konforme Webdaten-Pipelines benötigen.

8. Content Grabber

ist ein Enterprise-Desktop/Web-Scraper mit fortschrittlicher Automatisierung und Integrationsmöglichkeiten. Entwickelt für Operations-Teams, die große Datenmengen extrahieren und Berichte erstellen müssen.

Highlights:

- Automatisierung: Mehrere Scraping-Agenten planen, überwachen und verwalten.

- Integration: Export zu Datenbanken, APIs oder eigenen Workflows.

- Fehlerbehandlung: Umfassendes Logging und Wiederherstellung für kritische Jobs.

- Eigene Skripte: Mit C# oder .NET tiefgreifend anpassbar.

Preise:

Keine kostenlose Version; Lizenzen ab ca. 2.995 $ (einmalig).

Ideal für:

Große Unternehmen, Agenturen oder alle, die industrielle Scraping- und Reporting-Lösungen brauchen.

9. BeautifulSoup

ist eine schlanke Python-Bibliothek zum Parsen von HTML und XML. Besonders beliebt bei Entwicklern, die individuelle Scraping-Lösungen mit KI kombinieren möchten.

Highlights:

- Flexibles Parsen: Daten aus unstrukturiertem HTML extrahieren und bereinigen.

- KI-Integration: Mit NLP- oder ML-Modellen für intelligente Extraktion kombinierbar.

- Open Source: Kostenlos, mit großer Entwickler-Community.

Preise:

Kostenlos und Open Source.

Ideal für:

Entwickler, die maximale Kontrolle und Python-Kenntnisse mitbringen.

10. Apify

ist eine Cloud-Plattform mit tausenden fertigen „Actors“ (vorgefertigte Scraper) und einem KI-SDK für individuelle Workflows. Fokus: Skalierung, Automatisierung und gemanagte Infrastruktur.

Highlights:

- Actor-Marktplatz: Über 10.000 sofort einsetzbare Scraper für beliebte Seiten.

- KI-SDK: Eigene KI-Workflows erstellen, bereitstellen und planen.

- Cloud-Skalierung: Jobs parallel ausführen, riesige Datenmengen verarbeiten.

- Integration: Export zu Sheets, Datenbanken oder per API.

Preise:

Kostenlose Version (begrenzte Ausführungen), Bezahlpläne ab 39 $/Monat.

Ideal für:

Teams, die automatisiertes Scraping in großem Stil brauchen oder eigene KI-Workflows ohne Serververwaltung bauen möchten.

Vergleichstabelle: KI-Web-Scraping-Tools

Hier ein schneller Überblick, damit du das passende Tool für deine Anforderungen findest:

| Tool | Nutzererlebnis | Technisches Know-how | Automatisierung | Preis | Ideal für |

|---|---|---|---|---|---|

| Thunderbit | No-Code, 2 Klicks, KI | Keins | Ja | Kostenlos/ab 15 $ | Nicht-Techniker, Vertrieb, Ops |

| Octoparse | Visuell, Vorlagen | Gering | Ja | Kostenlos/ab 75 $ | Business, wiederkehrende Jobs |

| Scrapy | Code-basiert, flexibel | Hoch | Ja | Kostenlos | Entwickler, individuelle Projekte |

| ParseHub | Visuell, logisch | Gering | Ja | Kostenlos/ab 149 $ | Komplexe, dynamische Seiten |

| DataMiner | Browser-Erweiterung | Keins | Eingeschränkt | Kostenlos/ab 19 $ | Schnelle, kleine Aufgaben |

| WebHarvy | Desktop, Point-Click | Keins | Ja | 139 $ (einmalig) | Bilder, Nicht-Techniker |

| Import.io | Cloud, Enterprise | Gering/Mittel | Ja | ab 299 $/Monat | Unternehmen, großes Volumen |

| Content Grabber | Desktop, Enterprise | Mittel/Hoch | Ja | ab 2.995 $ | Ops, großflächiges Reporting |

| BeautifulSoup | Python-Bibliothek | Hoch | Nein | Kostenlos | Entwickler, individuelles Parsing |

| Apify | Cloud, Actors, SDK | Gering/Mittel | Ja | Kostenlos/ab 39 $ | Skalierung, gemanagte Automatisierung |

Wie du das richtige KI-Web-Scraping-Tool für dein Unternehmen findest

Die Wahl des passenden Tools hängt davon ab, wie fit dein Team ist, wie viel Daten ihr braucht und wie viel Budget zur Verfügung steht. Hier eine schnelle Entscheidungshilfe:

- Nicht-technische Nutzer: oder Octoparse – einfache Einrichtung, kein Code, schnelle Ergebnisse.

- Entwickler: Scrapy oder BeautifulSoup – volle Kontrolle, individuelle Workflows, Open Source.

- Komplexe/dynamische Seiten: ParseHub oder WebHarvy – visuelle Logik, meistert schwierige Layouts.

- Schnelle, kleine Aufgaben: DataMiner – browserbasiert, sofortiger Export.

- Enterprise/Skalierung: Import.io, Content Grabber oder Apify – Automatisierung, Zeitplanung, Integrationen.

Überlege dir:

- Wie oft scrapest du? (Einmalig oder regelmäßig)

- Wie groß ist dein Datenvolumen? (Kleine Listen oder Millionen Zeilen)

- Brauchst du Workflow-Integration? (Export zu Sheets, CRMs, APIs)

- Welches Budget steht zur Verfügung? (Kostenlos, Pay-as-you-go, Enterprise)

Falls du unsicher bist: Starte mit einer kostenlosen Testversion – die meisten Tools bieten das an. Und denk dran: Das beste Tool ist das, das dein Team wirklich nutzt.

Fazit: Mit KI-Web-Scraping deine Datenstrategie zukunftssicher machen

Webdaten werden immer wertvoller – und das Extrahieren immer komplexer. KI-Web-Scraping-Tools sorgen dafür, dass sowohl Business-Anwender als auch Entwickler auf die wichtigsten Datenquellen zugreifen können – ohne technische Hürden. Egal ob Lead-Listen, Marktbeobachtung oder CRM-Pflege: Mit dem richtigen Tool sparst du Zeit, Geld und viele Nerven.

Bereit, das Potenzial von KI-Web-Scraping für dein Team zu entdecken? oder probiere die anderen Tools aus dieser Liste. Für weitere Tipps, Anleitungen und Deep Dives schau auf dem vorbei.

Viel Erfolg beim Scrapen – und mögen deine Daten immer sauber, strukturiert und einsatzbereit sein.

Häufige Fragen (FAQ)

1. Was ist KI-Web-Scraping und wie unterscheidet es sich vom klassischen Scraping?

KI-Web-Scraping nutzt maschinelles Lernen, um Daten auf Websites zu erkennen, zu extrahieren und zu strukturieren – selbst wenn sich Layouts ändern oder Inhalte unstrukturiert sind. Im Gegensatz zu klassischen, fehleranfälligen Skripten passen sich KI-Scraper automatisch an und brauchen viel weniger Wartung.

2. Welches KI-Web-Scraping-Tool eignet sich am besten für Nicht-Techniker?

und Octoparse sind die Top-Empfehlungen für alle ohne Programmierkenntnisse. Beide bieten visuelle Oberflächen, KI-Feldvorschläge und einfachen Export nach Excel oder Google Sheets.

3. Können diese Tools auch dynamische oder geschützte Websites scrapen?

Ja – Tools wie Thunderbit, ParseHub und Import.io unterstützen das Scraping dynamischer Inhalte und können auch mit Login-geschützten Seiten umgehen (die Einrichtung kann variieren).

4. Was kostet KI-Web-Scraping?

Die Preise reichen von kostenlos (Scrapy, BeautifulSoup) über günstige SaaS-Angebote (Thunderbit ab 15 $/Monat, Octoparse ab 75 $/Monat) bis hin zu Enterprise-Lösungen (Import.io, Content Grabber). Die meisten bieten kostenlose Testphasen oder Tarife für kleine Aufgaben.

5. Ist Web-Scraping legal und sicher für Unternehmen?

Web-Scraping ist legal, wenn es verantwortungsvoll gemacht wird – beachte immer die Nutzungsbedingungen der Websites, vermeide Missbrauch personenbezogener Daten und halte Datenschutzgesetze ein. Die meisten KI-Tools helfen dir dabei, compliant zu bleiben und Scraping-Geschwindigkeiten zu steuern.

Mehr erfahren?

Hier findest du weiterführende Ressourcen: