Stell dir vor, du sitzt vor einer Webseite mit tausenden Produkten – und dein Chef (oder dein innerer Daten-Nerd) will am liebsten schon gestern alle Preise, Namen und Bewertungen fein säuberlich in einer Tabelle sehen. Du könntest jetzt stundenlang Copy & Paste machen – oder du lässt Python für dich schuften. Genau hier kommt Web Scraping ins Spiel. Und nein, das ist längst nicht mehr nur was für Hacker mit Kapuze oder Silicon-Valley-Profis. Web Scraping ist heute eine gefragte Fähigkeit – vom Vertrieb über Makler bis zur Marktforschung. Der globale Markt für Web-Scraping-Software ist schon über schwer und wird sich bis 2032 voraussichtlich mehr als verdoppeln. Heißt: riesige Datenmengen – und jede Menge Chancen.

Als Mitgründer von habe ich schon viele Unternehmen dabei unterstützt, die lästige Datensammelei zu automatisieren. Bevor KI-Tools wie das Extrahieren von Webdaten zum Zwei-Klick-Erlebnis gemacht haben, habe ich selbst mit dem klassischen Python-Stack angefangen: beautifulsoup, requests und viel Herumprobieren. In diesem Leitfaden zeige ich dir, was beautifulsoup ist, wie du es installierst und nutzt – und warum es für viele immer noch das Tool der Wahl ist. Außerdem erfährst du, wie KI-gestützte Tools wie Thunderbit das Web Scraping für alle revolutionieren (und dabei viele Nerven sparen). Egal, ob du Python-Einsteiger, Business-User oder einfach neugierig bist: Los geht’s!

Was ist BeautifulSoup? Ein Überblick über Pythons Web-Scraping-Tool

Starten wir mit den Basics. (oft als BS4 abgekürzt) ist eine Python-Bibliothek, mit der du Daten aus HTML- und XML-Dateien herausziehen kannst. Stell dir beautifulsoup wie deinen persönlichen HTML-Detektiv vor: Du gibst ihm einen Haufen chaotischen Web-Code, und er macht daraus eine übersichtliche, durchsuchbare Baumstruktur. Plötzlich ist es ganz easy, Produktnamen, Preise oder Bewertungen gezielt per Tag oder Klassenname herauszufiltern.

beautifulsoup lädt Webseiten nicht selbst herunter (dafür brauchst du z.B. requests), aber sobald du das HTML hast, kannst du gezielt suchen, filtern und genau die Infos rausziehen, die du brauchst. Kein Wunder, dass in einer aktuellen Umfrage beautifulsoup als ihr bevorzugtes Web-Scraping-Tool gewählt haben – mehr als jede andere Bibliothek.

beautifulsoup-Skripte sind überall im Einsatz: von wissenschaftlichen Studien über E-Commerce-Analysen bis zur Lead-Generierung. Marketing-Teams bauen damit Influencer-Listen, Recruiter durchforsten Jobbörsen und sogar Journalisten automatisieren ihre Recherche. Das Tool ist flexibel, fehlertolerant und – mit ein bisschen Python-Know-how – ziemlich zugänglich.

Warum beautifulsoup? Geschäftliche Vorteile und Praxisbeispiele

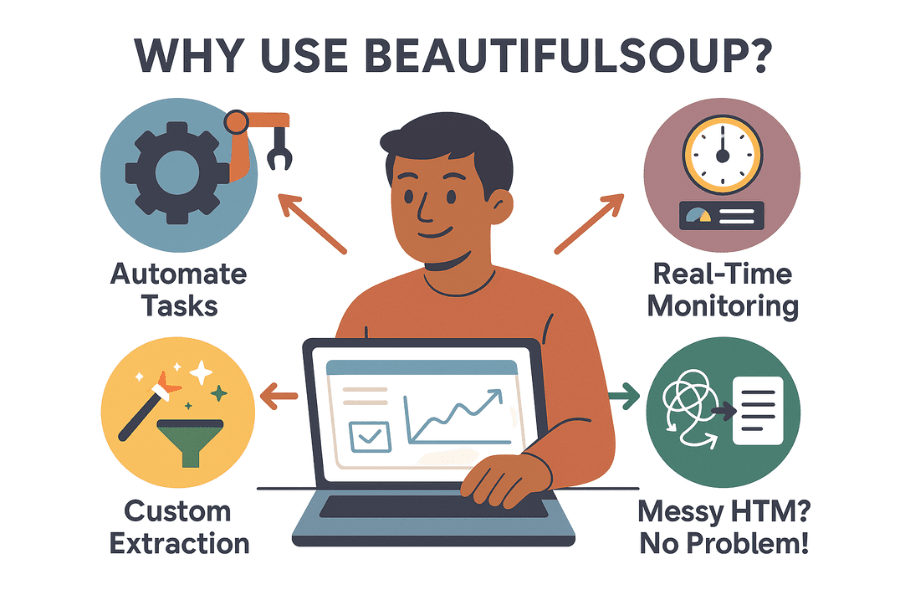

Warum greifen so viele Unternehmen und Datenfans zu beautifulsoup? Das macht das Tool so beliebt:

- Automatisiert nervige Aufgaben: Warum alles per Hand kopieren, wenn ein Skript die Arbeit in Minuten erledigt? beautifulsoup kann tausende Datenpunkte in kürzester Zeit sammeln und dein Team entlasten.

- Echtzeit-Überwachung: Mit automatisierten Skripten kannst du Wettbewerberpreise, Lagerbestände oder News regelmäßig checken. So verpasst du keine Preisänderung mehr.

- Individuelle Datenauswahl: Du brauchst die Top 10 Trendprodukte samt Bewertungen? beautifulsoup gibt dir volle Kontrolle, was und wie du Daten extrahierst.

- Kommt mit chaotischem HTML klar: Selbst wenn der Quellcode einer Seite wild aussieht, kann beautifulsoup meist trotzdem alles sauber auslesen.

Hier ein paar typische Anwendungsfälle:

| Anwendungsfall | Beschreibung | Beispiel-Ergebnis |

|---|---|---|

| Lead-Generierung | Geschäftsdaten oder LinkedIn-Kontakte samt E-Mail und Telefonnummer extrahieren | Zielgerichtete Vertriebsliste für die Akquise erstellen |

| Preisüberwachung | Preise von Wettbewerbern auf E-Commerce-Seiten verfolgen | Eigene Preise in Echtzeit anpassen |

| Marktforschung | Bewertungen, Ratings oder Produktdetails aus Online-Shops sammeln | Trends erkennen und Produktentwicklung steuern |

| Immobiliendaten | Immobilienangebote von Seiten wie Zillow oder Realtor.com aggregieren | Preistrends oder Investitionschancen analysieren |

| Content-Aggregation | Nachrichten, Blogposts oder Social-Media-Erwähnungen sammeln | Newsletter oder Stimmungsanalysen automatisieren |

Und der Mehrwert? Ein britischer Händler steigerte mit Web Scraping die Umsätze um . ASOS verdoppelte die internationalen Verkäufe, indem sie ihr Marketing an lokal gescrapte Preise anpassten. Kurz gesagt: Daten aus Web Scraping bringen echten Geschäftserfolg.

Loslegen: beautifulsoup in Python installieren

Bereit? So bringst du beautifulsoup zum Laufen:

Schritt 1: beautifulsoup installieren (so geht’s richtig)

Installiere die aktuelle Version – beautifulsoup4 (bs4). Lass dich nicht vom alten Paketnamen verwirren!

1pip install beautifulsoup4Auf macOS oder Linux eventuell mit pip3 oder sudo:

1sudo pip3 install beautifulsoup4Tipp: Wer versehentlich pip install beautifulsoup (ohne „4“) eingibt, bekommt die alte, inkompatible Version. Schon oft erlebt!

Schritt 2: Einen Parser installieren (optional, aber empfohlen)

beautifulsoup kann den eingebauten HTML-Parser von Python nutzen, aber für mehr Speed und Zuverlässigkeit empfiehlt sich lxml und html5lib:

1pip install lxml html5libSchritt 3: requests installieren (um Webseiten zu laden)

beautifulsoup analysiert HTML, aber du musst es erst herunterladen. Die -Bibliothek ist hier Standard:

1pip install requestsSchritt 4: Python-Umgebung prüfen

Nutzt du Python 3? In IDEs wie PyCharm oder VS Code den Interpreter checken. Bei Import-Fehlern installierst du Pakete womöglich im falschen Environment. Unter Windows hilft oft: py -m pip install beautifulsoup4.

Schritt 5: Teste deine Installation

Ein schneller Check:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)Wenn du den <title>-Tag siehst, ist alles bereit.

beautifulsoup-Grundlagen: Wichtige Konzepte und Syntax

Hier die wichtigsten Objekte und Begriffe bei beautifulsoup:

- BeautifulSoup-Objekt: Der Wurzelknoten deines geparsten HTML-Baums. Erstellt mit

BeautifulSoup(html, parser). - Tag: Repräsentiert ein HTML- oder XML-Tag (wie

<div>,<p>,<span>). Du kannst Attribute, Kinder und Text auslesen. - NavigableString: Der Text innerhalb eines Tags.

Den Parse-Tree verstehen

Stell dir dein HTML wie einen Stammbaum vor: Das <html>-Tag ist der Vorfahre, <head> und <body> sind die Kinder usw. beautifulsoup macht es einfach, diesen Baum mit Python zu durchlaufen.

Beispiel:

1html = """

2<html>

3 <head><title>My Test Page</title></head>

4 <body>

5 <p class="story">Once upon a time <b>there were three little sisters</b>...</p>

6 </body>

7</html>

8"""

9soup = BeautifulSoup(html, "html.parser")

10# Zugriff auf das title-Tag

11print(soup.title) # <title>My Test Page</title>

12print(soup.title.string) # My Test Page

13# Erstes <p>-Tag und dessen class-Attribut

14p_tag = soup.find('p', class_='story')

15print(p_tag['class']) # ['story']

16# Gesamten Text im <p>-Tag auslesen

17print(p_tag.get_text()) # Once upon a time there were three little sisters...Navigieren und Suchen

- Elementzugriff:

soup.head,soup.body,tag.parent,tag.children - find() / find_all(): Tags nach Name oder Attributen suchen.

- select(): Komplexe Abfragen mit CSS-Selektoren.

Beispiel:

1# Alle Links finden

2for link in soup.find_all('a'):

3 print(link.get('href'))

4# CSS-Selektor-Beispiel

5for item in soup.select('div.product > span.price'):

6 print(item.get_text())Praxis: Deinen ersten Web-Scraper mit beautifulsoup bauen

Jetzt wird’s praktisch. Du willst z. B. Produktnamen und Preise von einer E-Commerce-Suchergebnisseite (z. B. Etsy) extrahieren? So geht’s:

Schritt 1: Webseite abrufen

1import requests

2from bs4 import BeautifulSoup

3url = "https://www.etsy.com/search?q=clothes"

4headers = {"User-Agent": "Mozilla/5.0"} # Manche Seiten verlangen einen User-Agent

5resp = requests.get(url, headers=headers)

6soup = BeautifulSoup(resp.text, 'html.parser')Schritt 2: Daten parsen und extrahieren

Angenommen, jedes Produkt steckt in einem <li class="wt-list-unstyled">-Block, der Titel in <h3 class="v2-listing-card__title"> und der Preis in <span class="currency-value">.

1items = []

2for item in soup.find_all('li', class_='wt-list-unstyled'):

3 title_tag = item.find('h3', class_='v2-listing-card__title')

4 price_tag = item.find('span', class_='currency-value')

5 if title_tag and price_tag:

6 title = title_tag.get_text(strip=True)

7 price = price_tag.get_text(strip=True)

8 items.append((title, price))Schritt 3: In CSV oder Excel speichern

Mit dem eingebauten csv-Modul:

1import csv

2with open("etsy_products.csv", "w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Product Title", "Price"])

5 writer.writerows(items)Oder mit :

1import pandas as pd

2df = pd.DataFrame(items, columns=["Product Title", "Price"])

3df.to_csv("etsy_products.csv", index=False)Jetzt hast du eine Tabelle, die du weiter analysieren oder präsentieren kannst.

Herausforderungen mit beautifulsoup: Wartung, Anti-Scraping & Grenzen

Jetzt mal ehrlich: So sehr ich beautifulsoup mag, es gibt auch ein paar Stolpersteine – vor allem, wenn du regelmäßig oder in großem Stil scrapen willst.

1. Anfällig für Website-Änderungen

Webseiten ändern gerne mal ihr Layout, Klassennamen oder die Reihenfolge der Elemente. Dein beautifulsoup-Skript funktioniert nur so lange, wie die Selektoren passen. Schon kleine Änderungen im HTML können das Skript aus dem Tritt bringen – manchmal sogar unbemerkt. Wer viele Seiten scraped, muss ständig nachbessern – das ist selten spaßig.

2. Anti-Scraping-Maßnahmen

Viele moderne Seiten setzen auf Schutzmechanismen: CAPTCHAs, IP-Sperren, Rate-Limits, dynamische Inhalte per JavaScript und mehr. beautifulsoup kommt damit allein nicht klar. Du brauchst dann Proxies, Headless-Browser oder externe CAPTCHA-Lösungen. Es ist ein ständiges Katz-und-Maus-Spiel.

3. Skalierung und Performance

Für kleine oder einmalige Projekte ist beautifulsoup super. Wer aber Millionen Seiten oder parallele Jobs abarbeiten will, muss viel Zusatzcode für Fehlerbehandlung, Parallelisierung und Infrastruktur schreiben. Möglich – aber aufwendig.

4. Technische Einstiegshürde

Ganz ehrlich: Wer mit Python, HTML und Debugging nicht vertraut ist, findet beautifulsoup anfangs herausfordernd. Selbst erfahrene Entwickler müssen oft viel ausprobieren, anpassen und testen.

5. Rechtliche und ethische Aspekte

Web Scraping bewegt sich rechtlich oft in einer Grauzone – vor allem, wenn man robots.txt oder Nutzungsbedingungen ignoriert. Du bist selbst dafür verantwortlich, fair zu agieren: also Limits einhalten, Regeln respektieren und Daten verantwortungsvoll nutzen.

Mehr als beautifulsoup: Wie KI-Tools wie Thunderbit Web Scraping vereinfachen

Jetzt wird’s spannend: Dank KI machen Tools wie Web Scraping für alle zugänglich – nicht nur für Entwickler.

Thunderbit ist eine KI-gestützte Chrome-Erweiterung, mit der du jede Website in wenigen Klicks auslesen kannst. Kein Python, keine Selektoren, kein Wartungsaufwand. Einfach Seite öffnen, auf „AI Felder vorschlagen“ klicken – Thunderbits KI erkennt automatisch relevante Daten (Produktnamen, Preise, Bewertungen, E-Mails, Telefonnummern usw.). Dann auf „Scrapen“ klicken – fertig.

Thunderbit vs. beautifulsoup: Der direkte Vergleich

| Funktion | BeautifulSoup (mit Code) | Thunderbit (No-Code KI) |

|---|---|---|

| Einrichtung | Python-Kenntnisse, HTML-Verständnis und Debugging nötig | Kein Code – KI erkennt Felder automatisch, intuitive Oberfläche |

| Geschwindigkeit | Stunden (Code schreiben und testen) | Minuten (2–3 Klicks) |

| Anpassung an Änderungen | Bricht bei HTML-Änderungen, manuelle Updates nötig | KI passt sich oft automatisch an, Vorlagen für viele Seiten werden gepflegt |

| Paginierung/Unterseiten | Manuelle Schleifen und Requests für jede Seite | Paginierung und Unterseiten integriert – einfach aktivieren |

| Anti-Bot-Schutz | Proxies, CAPTCHAs, Browser-Simulation selbst einbauen | Viele Anti-Bot-Probleme werden automatisch gelöst, Browser-Kontext hilft |

| Datenverarbeitung | Volle Kontrolle im Code, aber alles selbst programmieren | KI-gestützte Zusammenfassung, Kategorisierung, Übersetzung und Datenbereinigung integriert |

| Exportmöglichkeiten | Individueller Code für CSV, Excel, Datenbanken usw. | Ein-Klick-Export zu CSV, Excel, Google Sheets, Airtable, Notion |

| Skalierbarkeit | Unbegrenzt, aber Fehler, Wiederholungen und Skalierung selbst managen | Hoch – Cloud/Erweiterung übernimmt Parallelisierung, Planung und große Jobs (je nach Tarif/Kontingent) |

| Kosten | Kostenlos (Open Source), aber Zeit- und Wartungsaufwand | Freemium (kleine Jobs gratis, größere kostenpflichtig), spart aber viel Zeit und Wartung |

| Flexibilität | Maximal – im Code ist (fast) alles möglich | Deckt die meisten Standardfälle ab, Spezialfälle erfordern ggf. Code |

Mehr dazu findest du im und in den .

Schritt-für-Schritt: Daten mit Thunderbit vs. beautifulsoup scrapen

Vergleichen wir die Abläufe am Beispiel von Produktdaten aus einem Online-Shop.

Mit beautifulsoup

- HTML-Struktur der Website mit den Entwicklertools im Browser analysieren.

- Python-Code schreiben, um die Seite zu laden (

requests), zu parsen (beautifulsoup) und die gewünschten Felder zu extrahieren. - Selektoren (Klassennamen, Tag-Pfade) so lange anpassen, bis die richtigen Daten gefunden werden.

- Paginierung durch Schleifen und Link-Verfolgung selbst programmieren.

- Daten mit Zusatzcode in CSV oder Excel exportieren.

- Bei Änderungen an der Seite alles wiederholen.

Zeitaufwand: 1–2 Stunden pro neuer Seite (mehr, falls Anti-Bot-Schutz greift).

Mit Thunderbit

- Zielseite in Chrome öffnen.

- Thunderbit-Erweiterung anklicken.

- „AI Felder vorschlagen“ wählen – die KI schlägt Spalten wie Produktname, Preis usw. vor.

- Spalten ggf. anpassen, dann auf „Scrapen“ klicken.

- Paginierung oder Unterseiten per Schalter aktivieren, falls nötig.

- Daten in der Tabelle prüfen und im gewünschten Format exportieren.

Zeitaufwand: 2–5 Minuten. Kein Code, kein Debugging, keine Wartung.

Extra: Thunderbit kann auch E-Mails, Telefonnummern, Bilder extrahieren und sogar Formulare automatisch ausfüllen. Wie ein extrem schneller Assistent, der nie über Routinearbeit klagt.

Fazit & wichtigste Erkenntnisse

Web Scraping ist längst kein Nischenthema mehr, sondern ein zentrales Werkzeug für Lead-Generierung, Marktforschung und vieles mehr. bleibt ein super Einstieg für alle mit etwas Python-Erfahrung und bietet maximale Flexibilität für individuelle Projekte. Doch je komplexer Webseiten werden – und je mehr Business-Anwender schnelle, einfache Datenzugriffe fordern – desto mehr verändern KI-Tools wie das Spielfeld.

Wer gerne programmiert und maßgeschneiderte Lösungen bauen will, ist mit beautifulsoup bestens bedient. Wer aber ohne Code, ohne Wartungsaufwand und in Minuten Ergebnisse will, fährt mit Thunderbit deutlich entspannter. Warum stundenlang coden, wenn KI das Problem in Minuten löst?

Neugierig geworden? Lade dir die herunter oder stöbere in weiteren Anleitungen im . Und falls du weiter mit Python experimentieren willst: Viel Spaß mit beautifulsoup – aber vergiss nicht, zwischendurch die Handgelenke zu lockern!

Viel Erfolg beim Scrapen!

Weiterführende Links:

Du hast Fragen, Erfahrungen oder willst dich über Scraping austauschen? Schreib gern einen Kommentar – ich habe vermutlich schon mehr Scraper geschrottet als die meisten je gebaut haben.