Das Internet ist eine echte Goldmine für Daten – aber wer hat schon Lust, stundenlang per Copy & Paste Infos zusammenzutragen? Im Jahr 2025 ist man mit manueller Lead-Recherche oder Preisbeobachtung so oldschool wie jemand, der noch zu Fuß unterwegs ist, während alle anderen längst mit E-Bikes cruisen. Die gute Nachricht: KI-Web-Scraper sind vom Geheimtipp zum absoluten Must-have geworden. Sie verwandeln chaotische Webseiten in strukturierte, auswertbare Daten – und das ganz ohne Programmierkenntnisse.

Ich habe selbst viele Jahre im SaaS- und Automatisierungsbereich gearbeitet und kann aus Erfahrung sagen: Mit dem richtigen KI-Web-Scraper spart dein Team hunderte Arbeitsstunden, hebt die Datenqualität auf ein neues Level und gewinnt wertvolle Insights fürs Business. Egal, ob du neue Leads suchst, Markttrends im Blick behalten willst oder einfach deine Nerven schonen möchtest – diese Übersicht der 10 besten KI-Web-Scraper-Tools für 2025 hilft dir, das passende Tool zu finden und vielleicht sogar dein Wochenende zurückzuerobern.

Warum KI-Web-Scraper für die Produktivität ein Gamechanger sind

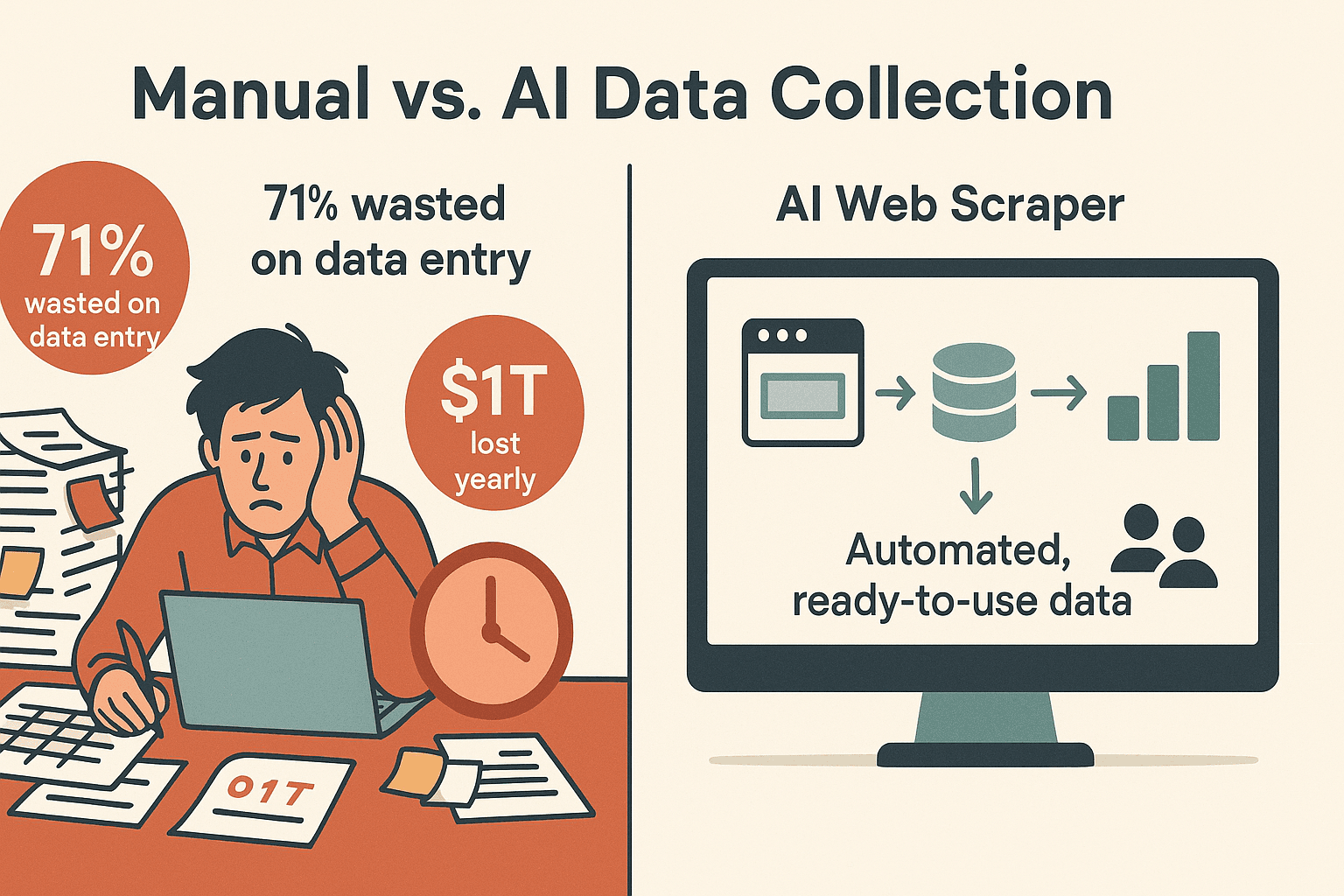

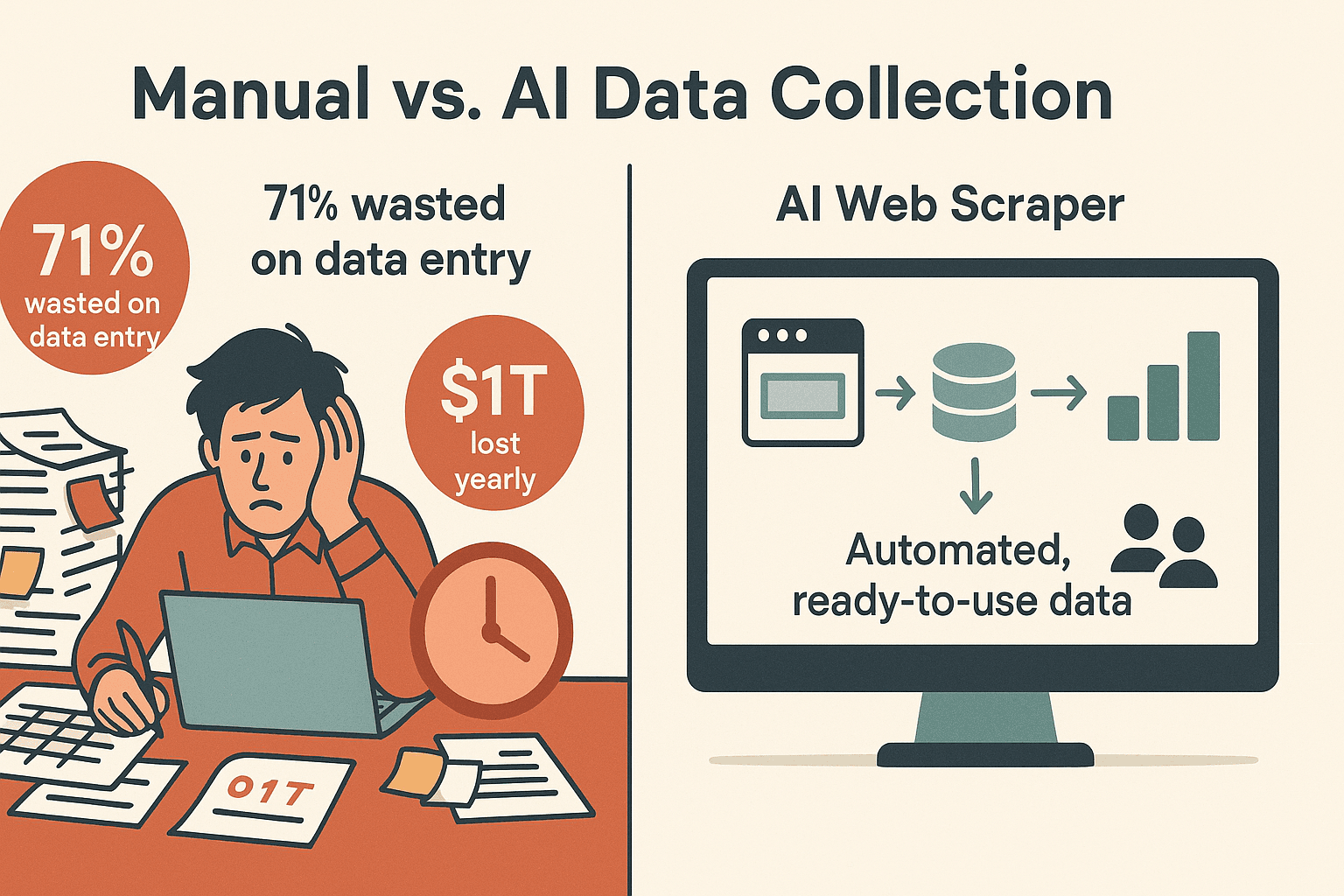

Mal ehrlich: Manuelle Datenerfassung ist der absolute Produktivitätskiller. sagen, dass sie viel zu viel Zeit mit Dateneingabe statt mit Verkaufen verbringen. Schlechte Lead-Verwaltung und Zeitverschwendung kosten Unternehmen jedes Jahr bis zu . KI-Web-Scraper drehen den Spieß um: Sie automatisieren wiederkehrende Webaufgaben und liefern dir strukturierte Datensätze – bereit für Analyse, Akquise oder Reporting.

Warum KI-Web-Scraper heute für Unternehmen unverzichtbar sind:

- Zeitersparnis: KI-Scraper reduzieren den Aufwand für Datensammlung um 30–40 % im Vergleich zu Handarbeit. So bleibt mehr Zeit für die wirklich wichtigen Dinge ().

- Hohe Genauigkeit: KI-gestützte Extraktion erreicht ), selbst bei dynamischen oder unübersichtlichen Seiten – weniger Nacharbeit nötig.

- Komplexe Seiten? Kein Problem: Moderne KI-Scraper meistern JavaScript, Endlos-Scroll, Logins und Unterseiten – kein Stress mehr mit „Mehr laden“-Buttons.

- Kein Programmieren nötig: Die meisten Tools bieten heute intuitive Oberflächen oder sogar natürliche Spracheingabe – perfekt für alle, die noch nie ein Skript geschrieben haben.

Typische Business-Anwendungsfälle:

- Lead-Generierung: Verzeichnisse, LinkedIn oder Eventseiten nach Kontakten durchsuchen.

- Wettbewerbsbeobachtung: Preise, Artikelnummern oder Bewertungen auf E-Commerce-Seiten verfolgen.

- Marktforschung: Artikel, Inserate oder Forenbeiträge für Analysen sammeln.

- Betrieb & Einkauf: Produktdaten, Compliance-Infos oder Lieferantendaten extrahieren – ohne Umweg über die IT.

Mit einem werden diese Tools zum Geheimtipp für datenhungrige Teams.

So haben wir die besten KI-Web-Scraper ausgewählt

Nicht jeder Web-Scraper ist gleich – vor allem, wenn es um KI-Funktionen und Bedienkomfort geht. Das waren unsere wichtigsten Kriterien für die Top 10:

- Einfache Bedienung: Können auch Nicht-Techniker in wenigen Minuten Ergebnisse erzielen? Gibt es eine No-Code-Oberfläche oder einen KI-Assistenten?

- Automatisierung: Unterstützt das Tool Paginierung, Unterseiten, Logins und dynamische Inhalte? Sind wiederkehrende Scrapes planbar?

- Datenexport & Integration: Lassen sich Daten nach Excel, Google Sheets, Airtable, Notion oder per API exportieren?

- Skalierbarkeit: Gibt es Cloud-Scraping, parallele Verarbeitung oder Unterstützung für große Datenmengen?

- Preisgestaltung: Gibt es einen kostenlosen Einstieg oder Test? Sind die Tarife für Unternehmen fair?

- Support & Community: Gibt es gute Dokus, Tutorials oder schnellen Support?

Jedes Tool auf dieser Liste hat seine eigenen Stärken – los geht’s!

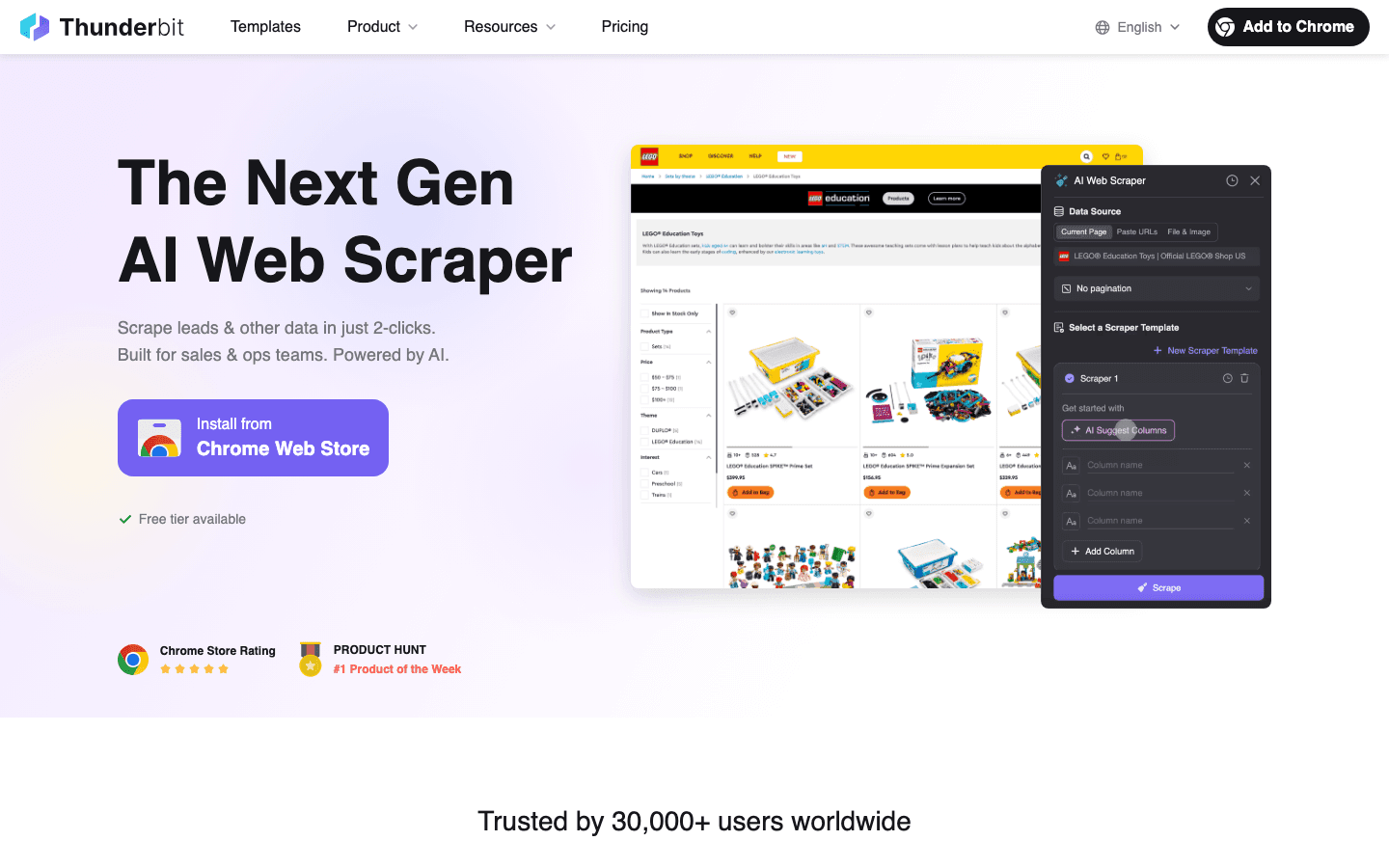

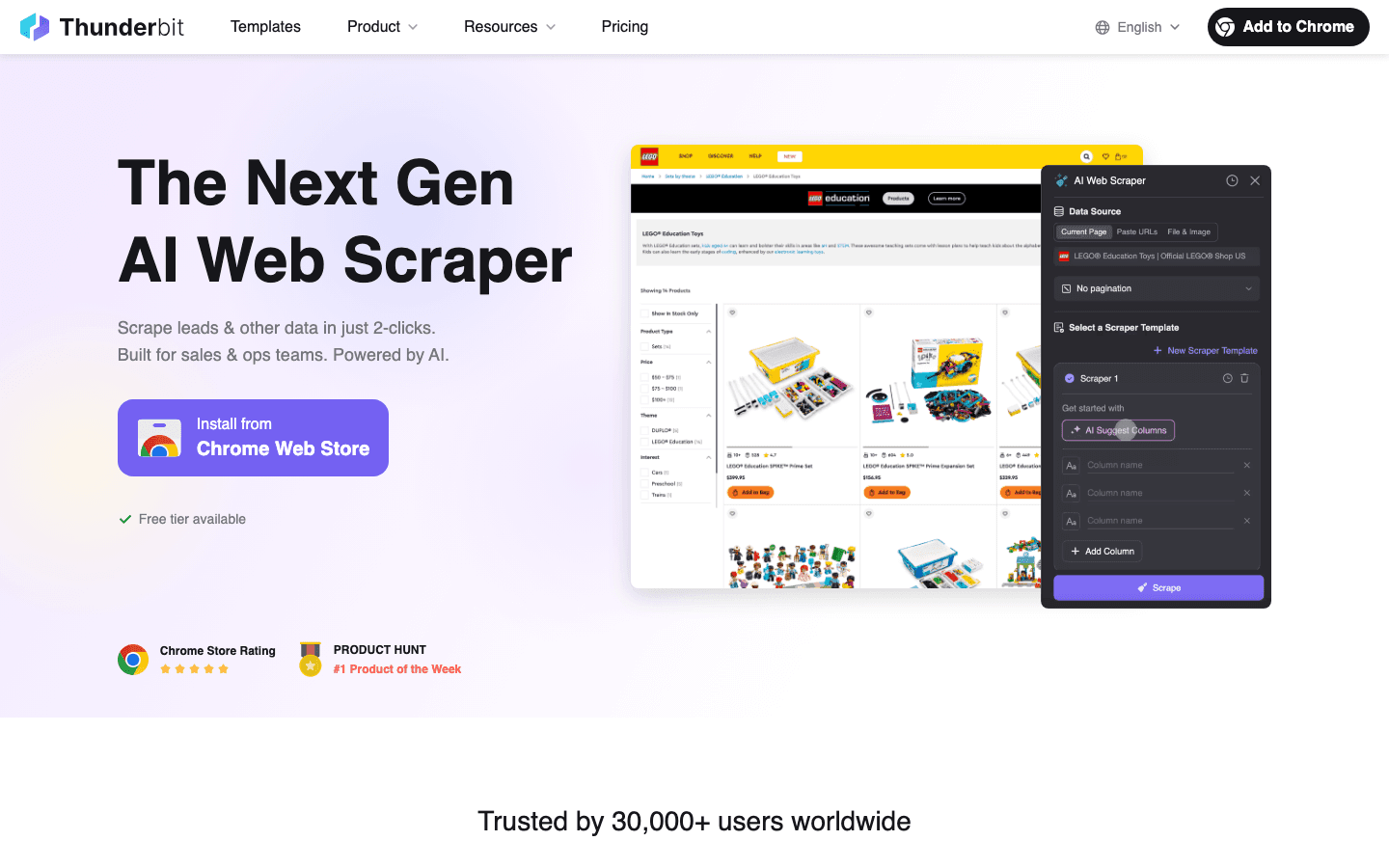

1. Thunderbit: KI-Web-Scraper für stressfreie Datenerfassung

ist meine Top-Empfehlung für alle, die in unter fünf Minuten von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ kommen wollen. Als Chrome-Erweiterung macht Thunderbit das Scraping zum Zwei-Klick-Erlebnis: „KI-Felder vorschlagen“ anklicken, dann „Scrapen“ – die KI erkennt automatisch, was extrahiert werden soll.

Wichtige Funktionen:

- KI-gestütztes 2-Klick-Scraping: Keine Vorlagen, kein Code – die KI übernimmt alles.

- Unterseiten & Paginierung: Listen scrapen und automatisch Details von Unterseiten holen.

- Sofort-Vorlagen: Ein-Klick-Scrapes für Amazon, Zillow, Google Maps und mehr.

- Kostenloser Datenexport: Export nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten.

- KI-Autofill: Die KI füllt Webformulare für dich aus (ideal für wiederkehrende Aufgaben).

- Geplanter Cloud-Scraper: Wiederkehrende Jobs mit natürlicher Sprache planen („jeden Montag um 9 Uhr“).

- Mehrsprachig: Unterstützt 34 Sprachen.

- Kostenlose E-Mail-, Telefon- und Bild-Extraktoren: Kontaktdaten oder Bilder mit einem Klick extrahieren.

Vorteile:

- Super einfache Einrichtung – perfekt für Nicht-Techniker.

- Kommt mit dynamischen, unübersichtlichen Seiten und Unterseiten besser klar als viele andere.

- Alle Export- und Profi-Funktionen in den Bezahlplänen enthalten.

- Großzügiger Gratis-Tarif (6 Seiten/Monat; 10 mit Testphase).

Nachteile:

- Kreditbasiertes Modell – Vielnutzer brauchen einen Bezahlplan.

- Sehr komplexe Seiten erfordern manchmal Anpassung der KI-Prompts.

- Keine direkten CRM-Integrationen (aber API verfügbar).

Preise:

- Kostenlos bis zu 6 Seiten/Monat (unbegrenzte Zeilen pro Seite).

- Bezahlpläne ab 15 $/Monat für 500 Credits (1 Credit = 1 Zeile), bis zu 249 $/Monat für 20.000 Credits.

Ideal für:

Vertriebs-, Marketing- und Operationsteams, die schnell und ohne Programmieraufwand an saubere Daten kommen wollen. Perfekt für Lead-Generierung, Wettbewerbsbeobachtung und Preisanalysen im E-Commerce.

Du willst Thunderbit direkt ausprobieren? und teste kostenlos.

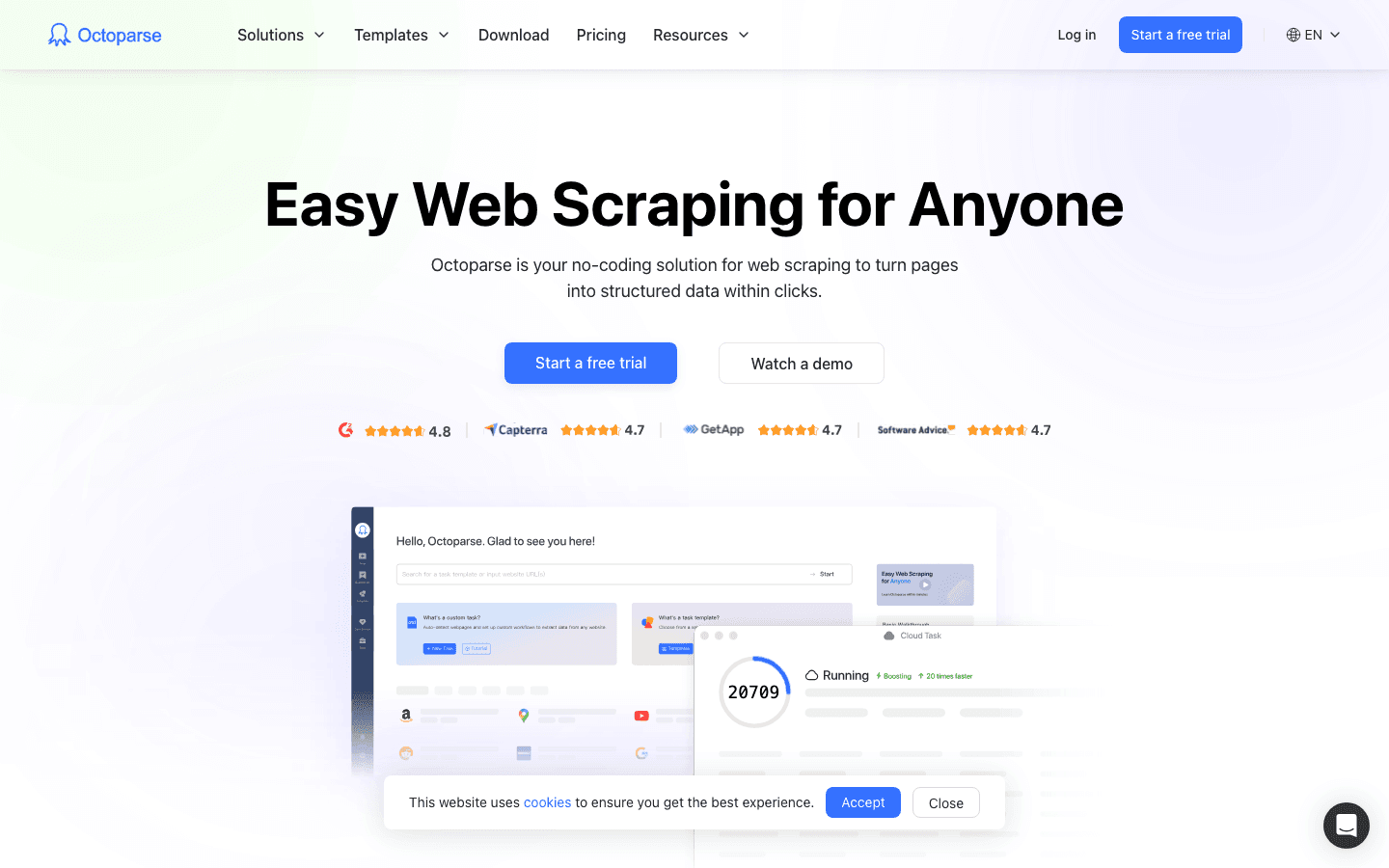

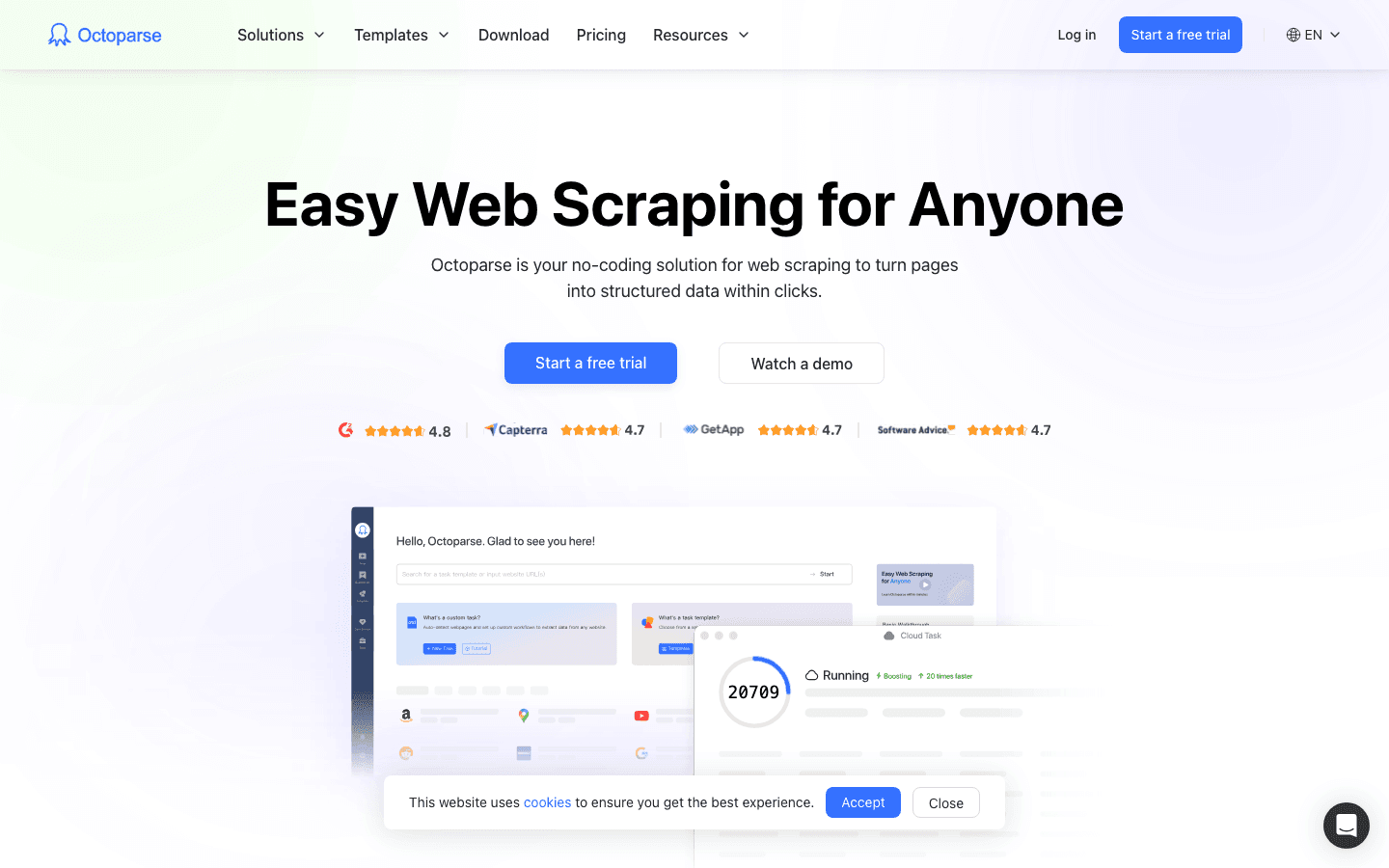

2. Octoparse: Stapelverarbeitung mit visueller Oberfläche

ist ein echter Klassiker unter den No-Code-Scrapern und bekannt für seine Drag-and-Drop-Oberfläche sowie die Möglichkeit, große Datenmengen auf einen Schlag zu extrahieren. Die Desktop-App (Windows/Mac) bietet einen visuellen Workflow-Builder – einfach durch die Seite klicken, Octoparse nimmt alles auf.

Wichtige Funktionen:

- Visueller Workflow-Designer: Scraper per Mausklick zusammenstellen, kein Code nötig.

- Cloud- & Lokale Ausführung: Jobs auf dem eigenen Rechner oder in der Cloud laufen lassen.

- 100+ Vorlagen: Vorgefertigte Templates für Amazon, eBay, Twitter, Google Maps u.v.m.

- Smart Mode: KI erkennt Datenlisten automatisch für einen schnellen Start.

- Komplexe Seiten: Unterstützt Logins, AJAX, Endlos-Scroll.

- Export nach CSV, Excel, JSON, HTML oder per API.

Vorteile:

- Einsteigerfreundlich, aber auch für Profis geeignet.

- Riesige Vorlagenbibliothek für gängige Seiten.

- Cloud-Planung für wiederkehrende Aufgaben.

- Mehrsprachige Oberfläche.

Nachteile:

- Nur für Windows/Mac (kein Linux, keine Web-App).

- Für fortgeschrittene Features (XPath, Logik) ist Einarbeitung nötig.

- Gratis-Tarif eingeschränkt; höhere Pläne für Vielnutzer teuer.

Preise:

- Kostenlos (10 Aufgaben).

- Standard: ca. 75 $/Monat (jährliche Abrechnung).

- Professional: ca. 209 $/Monat (jährliche Abrechnung).

Ideal für:

Analysten, kleine Teams oder KMU, die regelmäßig große Datenmengen – vor allem von bekannten Seiten – extrahieren möchten.

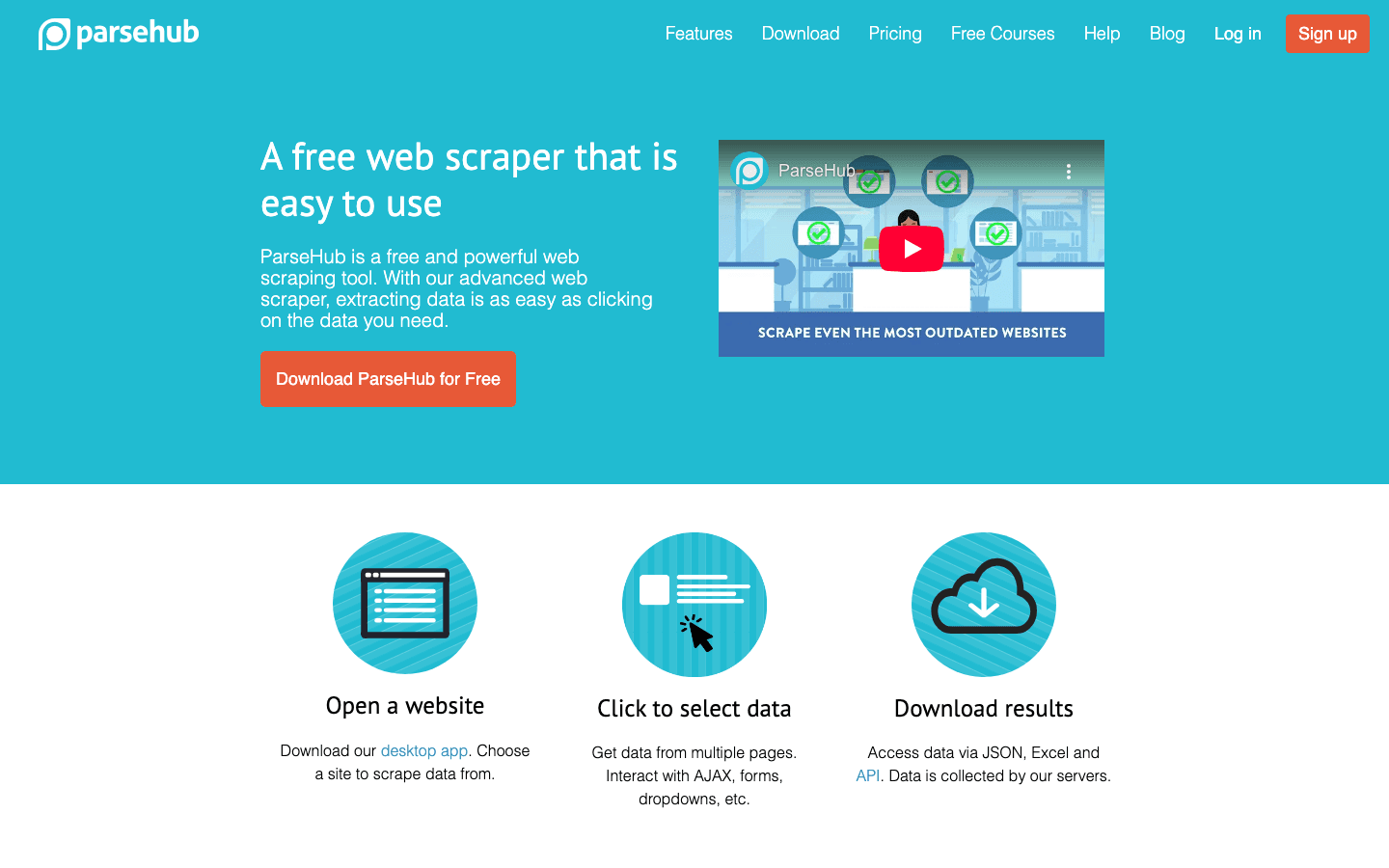

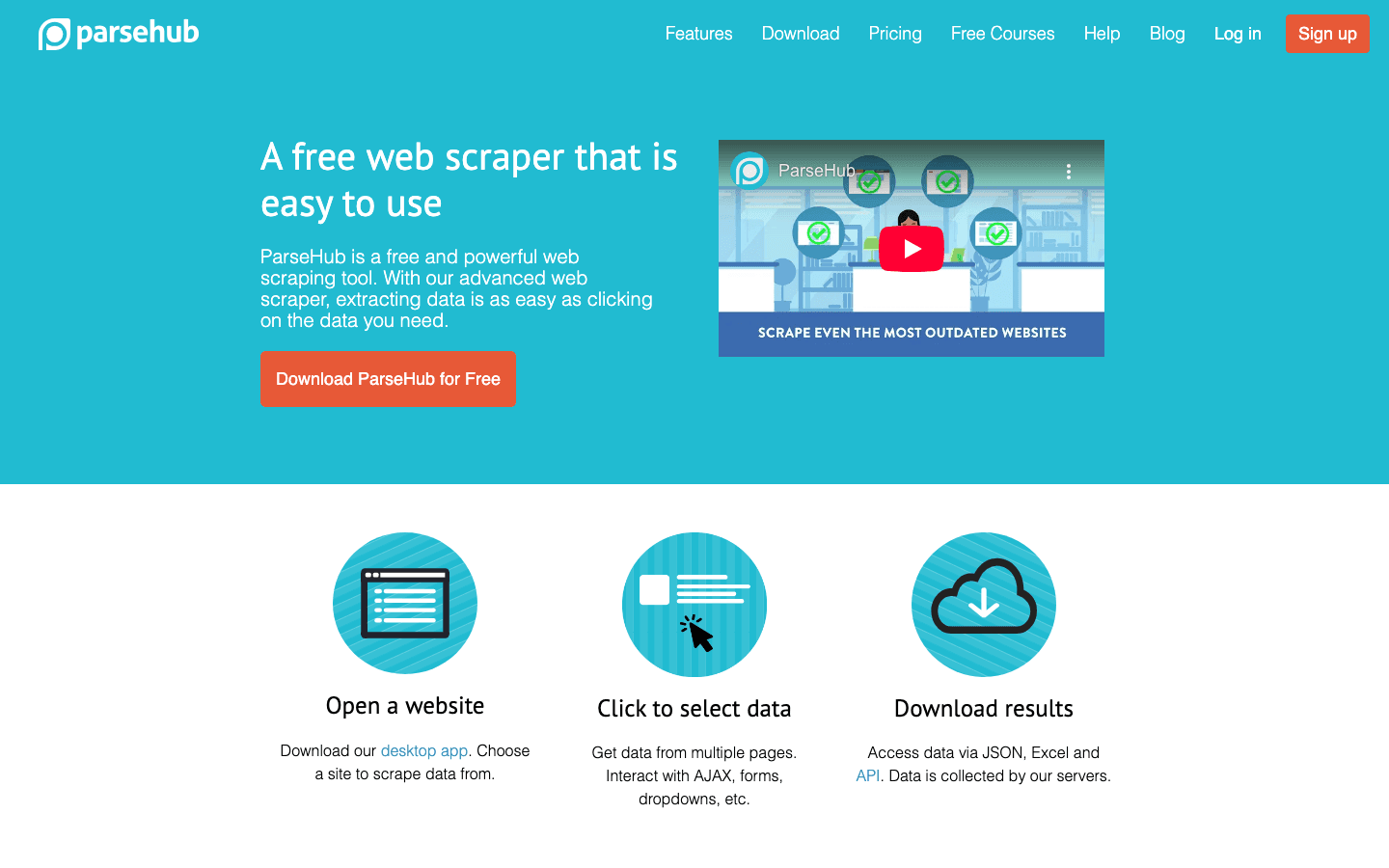

3. ParseHub: Leistungsstarkes visuelles Scraping für komplexe Websites

ist eine Desktop-App (Windows, Mac, Linux), die speziell für komplexe, dynamische Webseiten entwickelt wurde – etwa Seiten mit viel JavaScript, Endlos-Scroll oder mehrstufiger Navigation.

Wichtige Funktionen:

- Visueller Workflow-Builder: Elemente per Klick auswählen, Schleifen und Aktionen definieren.

- Komplexe Seiten: Unterstützt AJAX, Karten, Logins.

- Geplantes Scraping: Jobs zeitgesteuert ausführen (in Bezahlplänen).

- Plattformübergreifend: Für Windows, Mac und Linux.

- Export nach JSON, CSV, Excel.

Vorteile:

- Hervorragend für dynamische oder interaktive Seiten.

- Großzügiger Gratis-Tarif (200 Seiten/Lauf, 5 Projekte).

- Plattformübergreifend nutzbar.

Nachteile:

- Läuft meist lokal (Rechner muss an sein).

- Fortgeschrittene Workflows erfordern Einarbeitung.

- Bezahlpläne für Gelegenheitsnutzer teuer.

Preise:

- Kostenlos: 5 Projekte, 200 Seiten/Lauf.

- Standard: 189 $/Monat (10.000 Seiten/Lauf).

- Professional: 599 $/Monat (unbegrenzte Seiten/Lauf).

Ideal für:

Technikaffine Nutzer, Datenjournalisten oder Teams, die komplexe, dynamische Seiten scrapen möchten.

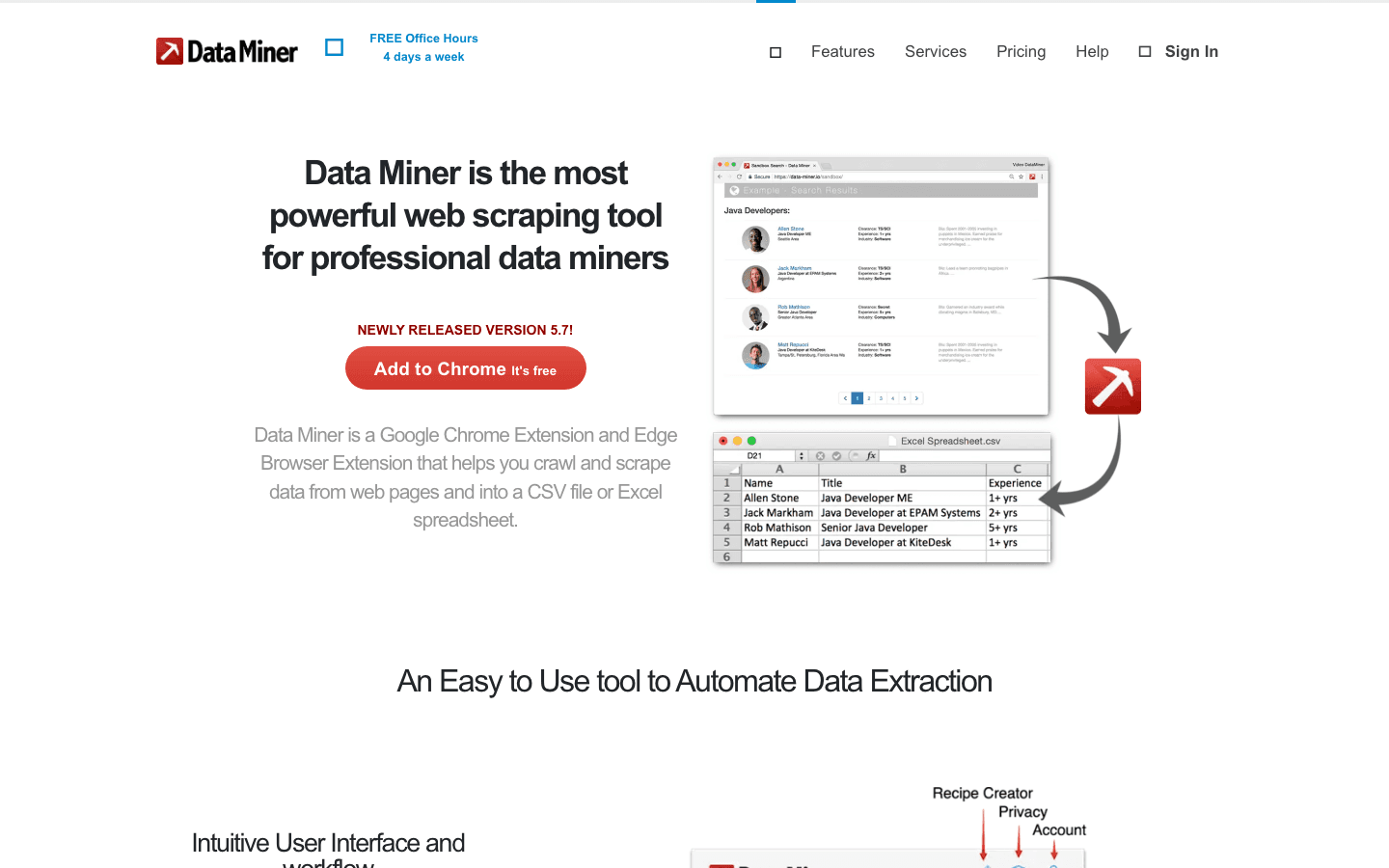

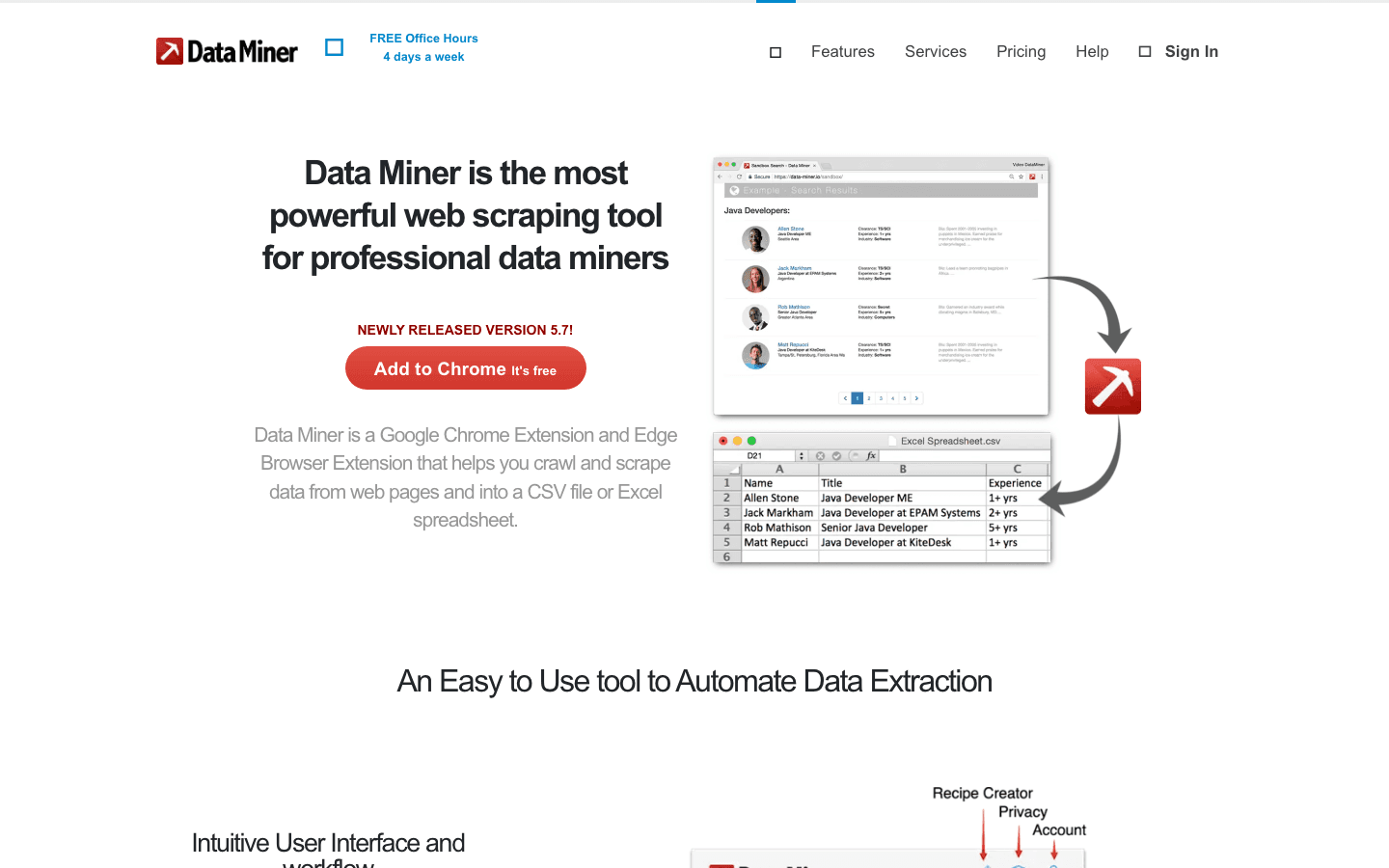

4. DataMiner: Chrome-Erweiterung für einfaches Scraping per Klick

ist eine Browser-Erweiterung (Chrome/Edge), mit der du Tabellen und Listen mit wenigen Klicks extrahieren kannst – ganz ohne Programmierung. Das Highlight: Über 60.000 vorgefertigte „Rezepte“ für bekannte Websites.

Wichtige Funktionen:

- Daten per Klick auswählen: Tabellen oder Listen direkt im Browser markieren.

- Rezept-Bibliothek: Ein-Klick-Scraping für Google, Amazon, LinkedIn u.v.m.

- Paginierung: Automatisches Weiterklicken und Zusammenführen der Ergebnisse.

- Google Sheets-Integration: Daten direkt ins Spreadsheet übertragen.

- Cloud-Scraping (Bezahlpläne): Jobs auf deren Servern ausführen.

Vorteile:

- Sehr einfach für schnelle Datenerfassung im Browser.

- Riesige Rezept-Bibliothek für gängige Seiten.

- Kostenlose Schulungen und schneller Support.

Nachteile:

- Gratis-Tarif auf 500 Seiten/Monat begrenzt.

- Fortgeschrittene Features (mehrstufiges Crawling, Automatisierung) erfordern Einarbeitung und Bezahlpläne.

- Kein integriertes IP-Routing – am besten für moderates Scraping.

Preise:

- Kostenlos: 500 Seiten/Monat.

- Solo: 19,99 $/Monat (500 Seiten, alle Features).

- Small Business: 49 $/Monat (1.000 Seiten).

- Business: 99 $/Monat (4.000 Seiten).

Ideal für:

Vertriebs-, Marketing- und Research-Profis, die schnell tabellenfertige Daten direkt im Browser brauchen.

5. Scrapy: Open-Source-Flexibilität für Profis

ist das Profi-Tool für Entwickler: Ein Python-basiertes Open-Source-Framework für maßgeschneiderte Webcrawler und große Scraping-Projekte.

Wichtige Funktionen:

- Code-basiert: Eigene Spider in Python schreiben.

- Schnelles, asynchrones Crawling: Tausende Seiten pro Stunde scrapen.

- Erweiterbar: Proxies, CAPTCHAs, eigene Parser u.v.m. integrierbar.

- Export nach CSV, JSON, Datenbanken oder beliebigem Format.

- Große Community & Ökosystem.

Vorteile:

- Maximale Flexibilität und Skalierbarkeit.

- Komplett kostenlos (Open Source).

- Lässt sich in jede Datenpipeline integrieren.

Nachteile:

- Python-Kenntnisse erforderlich – steile Lernkurve für Nicht-Entwickler.

- JavaScript-lastige Seiten nur mit Headless-Browser-Integration.

- Infrastruktur und Wartung in Eigenregie.

Preise:

- Kostenlos (Self-Hosting, Open Source).

Ideal für:

Entwicklerteams oder Data Engineers, die individuelle, groß angelegte Scraping-Lösungen bauen.

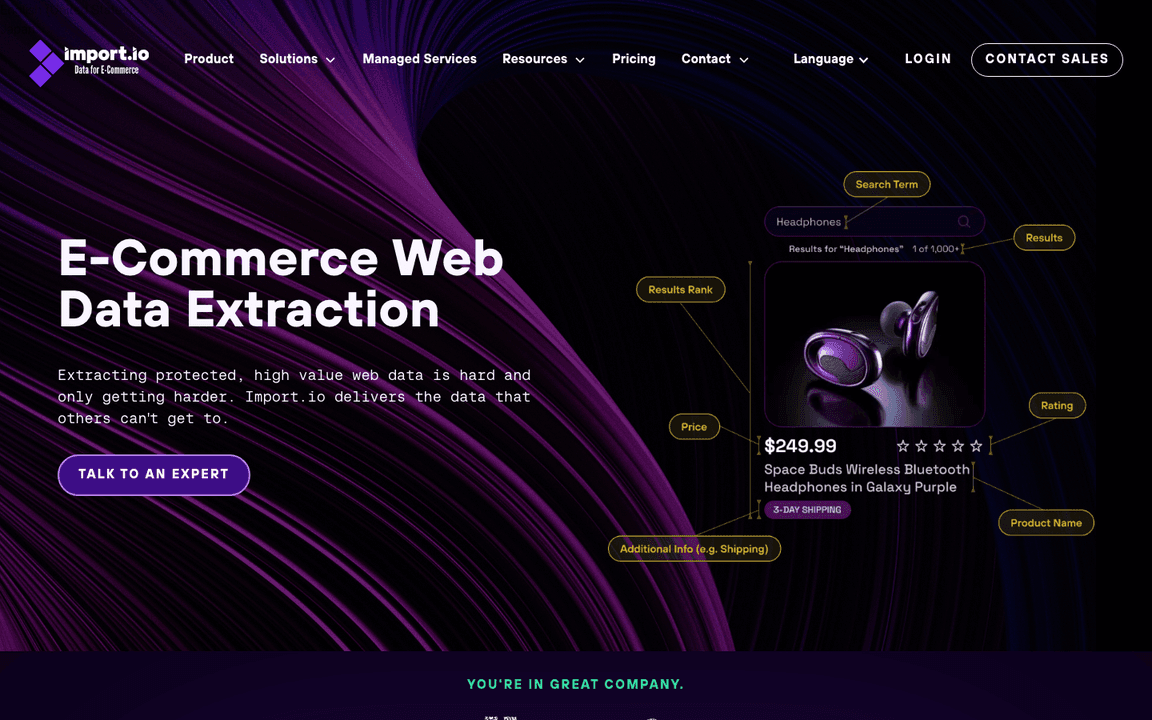

6. Import.io: KI-Web-Scraper für Unternehmen mit großem Datenbedarf

richtet sich an Unternehmen und kombiniert einen visuellen Extraktor mit Machine Learning und leistungsstarken Tools zur Datenaufbereitung.

Wichtige Funktionen:

- Visuelle Extraktion per Klick: Extraktoren ohne Code erstellen.

- Verkettete Extraktoren: Listen scrapen und automatisch Unterseiten durchsuchen.

- Datenbereinigung & Transformation: Integrierte Tools für saubere, einheitliche Daten.

- Planung & API-Integration: Wiederkehrende Jobs automatisieren und an BI-Tools anbinden.

- Enterprise-Features: Nutzerverwaltung, Audit-Logs, SLAs.

Vorteile:

- Bewältigt große, komplexe Projekte mit hoher Zuverlässigkeit.

- Fokus auf Datenqualität und Transformation.

- Dedizierter Support und SLAs für Unternehmen.

Nachteile:

- Einstiegspreis hoch (ab mehreren Hundert bis über 1.000 $/Monat).

- Für Einzelprojekte oder kleine Aufgaben weniger geeignet.

- Onboarding und Einrichtung aufwendiger.

Preise:

- Individuelle Enterprise-Preise (ab ca. 499 $/Monat).

- Kostenlose Testphase verfügbar.

Ideal für:

Große Unternehmen oder datengetriebene Firmen, die zuverlässige, großvolumige Webdaten benötigen.

7. WebHarvy: Visuelles Scraping mit automatischer Mustererkennung

ist eine Windows-Desktop-App, die Scraping so einfach macht wie das Anklicken der gewünschten Daten. Die automatische Mustererkennung wählt ähnliche Elemente aus – ideal für Listen und Tabellen.

Wichtige Funktionen:

- Point-and-Click-Oberfläche: Daten anklicken, WebHarvy extrahiert die ganze Liste.

- Automatische Mustererkennung: Keine Selektoren nötig.

- Mehrseitiges & Bild-Scraping: Paginierung und Bilder-Download inklusive.

- Formularausfüllung & Keyword-Scraping: Suchen automatisieren und Ergebnisse extrahieren.

- Einmalige Lizenz: Einmal kaufen, dauerhaft nutzen.

Vorteile:

- Sehr einsteigerfreundlich.

- Einmalige Kosten – langfristig günstig.

- Funktioniert offline – Daten bleiben auf dem eigenen Rechner.

Nachteile:

- Nur für Windows (kein Mac/Linux).

- Kein Cloud-Modul – PC muss für geplante Jobs laufen.

- Für sehr dynamische Seiten ggf. Scripting nötig.

Preise:

- 129 $ einmalig (Einzelplatzlizenz, inkl. 1 Jahr Updates).

- 15 Tage kostenlos testen.

Ideal für:

EinDas Internet ist wie ein riesiger Schatz an Daten – aber wer hat schon Lust, stundenlang per Copy & Paste Infos zusammenzutragen? Im Jahr 2025 ist man mit manueller Lead-Recherche oder Preisbeobachtung echt nicht mehr up to date – während andere schon mit dem E-Bike unterwegs sind, läuft man selbst noch zu Fuß. Die gute Nachricht: KI-Web-Scraper sind vom Geheimtipp zum echten Must-have geworden. Sie machen aus chaotischen Webseiten strukturierte, auswertbare Daten – und das ganz ohne Programmierkenntnisse.

Ich habe selbst viele Jahre im SaaS- und Automatisierungsbereich gearbeitet und kann aus Erfahrung sagen: Mit dem richtigen KI-Web-Scraper spart dein Team hunderte Arbeitsstunden, hebt die Datenqualität und gewinnt wertvolle Insights fürs Business. Egal, ob du neue Leads suchst, Markttrends im Blick behalten willst oder einfach deine Nerven schonen möchtest – diese Übersicht der 10 besten KI-Web-Scraper-Tools für 2025 hilft dir, das passende Tool zu finden und vielleicht sogar dein Wochenende zurückzuerobern.

Warum KI-Web-Scraper für die Produktivität ein Gamechanger sind

Mal ehrlich: Manuelle Datenerfassung ist ein echter Produktivitätskiller. sagen, sie verbringen zu viel Zeit mit Dateneingabe statt mit Verkaufen. Schlechte Lead-Verwaltung und Zeitverschwendung kosten Unternehmen jedes Jahr bis zu . KI-Web-Scraper drehen den Spieß um: Sie automatisieren wiederkehrende Webaufgaben und liefern dir strukturierte Datensätze – bereit für Analyse, Akquise oder Reporting.

Warum KI-Web-Scraper heute für Unternehmen unverzichtbar sind:

- Zeitersparnis: KI-Scraper verkürzen die Zeit für Datensammlung um 30–40 % im Vergleich zu Handarbeit. So bleibt mehr Zeit für Analyse und Umsetzung ().

- Hohe Genauigkeit: KI-gestützte Extraktion erreicht ), selbst bei dynamischen oder unübersichtlichen Seiten – weniger Nacharbeit nötig.

- Komplexe Seiten? Kein Problem: Moderne KI-Scraper meistern JavaScript, Endlos-Scroll, Logins und Unterseiten – kein Hängenbleiben mehr an „Mehr laden“-Buttons.

- Kein Programmieren nötig: Die meisten Tools bieten heute intuitive Oberflächen oder sogar natürliche Spracheingabe – perfekt für alle, die noch nie ein Skript geschrieben haben.

Typische Business-Anwendungsfälle:

- Lead-Generierung: Verzeichnisse, LinkedIn oder Eventseiten nach Kontakten durchsuchen.

- Wettbewerbsbeobachtung: Preise, Artikelnummern oder Bewertungen auf E-Commerce-Seiten verfolgen.

- Marktforschung: Artikel, Inserate oder Forenbeiträge für Analysen sammeln.

- Betrieb & Einkauf: Produktdaten, Compliance-Infos oder Lieferantendaten extrahieren – ohne Umweg über die IT.

Mit einem werden diese Tools zum Geheimtipp für datengetriebene Teams.

So haben wir die besten KI-Web-Scraper ausgewählt

Nicht jeder Web-Scraper ist gleich – vor allem, wenn es um KI-Funktionen und Bedienkomfort geht. Das waren unsere wichtigsten Kriterien für die Top 10:

- Einfache Bedienung: Können auch Nicht-Techniker in wenigen Minuten Ergebnisse erzielen? Gibt es eine No-Code-Oberfläche oder einen KI-Assistenten?

- Automatisierung: Unterstützt das Tool Paginierung, Unterseiten, Logins und dynamische Inhalte? Sind wiederkehrende Scrapes planbar?

- Datenexport & Integration: Lassen sich Daten nach Excel, Google Sheets, Airtable, Notion oder per API exportieren?

- Skalierbarkeit: Gibt es Cloud-Scraping, parallele Verarbeitung oder Unterstützung für große Datenmengen?

- Preisgestaltung: Gibt es einen kostenlosen Einstieg oder Test? Sind die Tarife für Unternehmen fair?

- Support & Community: Gibt es gute Dokus, Tutorials oder schnellen Support?

Jedes Tool auf dieser Liste hat seine eigenen Stärken – los geht’s!

1. Thunderbit: KI-Web-Scraper für mühelose Datenerfassung

ist meine Top-Empfehlung für alle, die in unter fünf Minuten von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ kommen wollen. Als Chrome-Erweiterung macht Thunderbit das Scraping zum Zwei-Klick-Erlebnis: „KI-Felder vorschlagen“ anklicken, dann „Scrapen“ – die KI erkennt automatisch, was extrahiert werden soll.

Wichtige Funktionen:

- KI-gestütztes 2-Klick-Scraping: Keine Vorlagen, kein Code – die KI übernimmt die Arbeit.

- Unterseiten & Paginierung: Listen scrapen und automatisch Details von Unterseiten holen.

- Sofort-Vorlagen: Ein-Klick-Scrapes für Amazon, Zillow, Google Maps und mehr.

- Kostenloser Datenexport: Export nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten.

- KI-Autofill: Die KI füllt Webformulare für dich aus (ideal für wiederkehrende Aufgaben).

- Geplanter Cloud-Scraper: Wiederkehrende Jobs mit natürlicher Sprache planen („jeden Montag um 9 Uhr“).

- Mehrsprachig: Unterstützt 34 Sprachen.

- Kostenlose E-Mail-, Telefon- und Bild-Extraktoren: Kontaktdaten oder Bilder mit einem Klick extrahieren.

Vorteile:

- Extrem einfache Einrichtung – perfekt für Nicht-Techniker.

- Kommt mit dynamischen, unübersichtlichen Seiten und Unterseiten besser klar als viele andere.

- Alle Export- und Profi-Funktionen in den Bezahlplänen enthalten.

- Großzügiger Gratis-Tarif (6 Seiten/Monat; 10 mit Testphase).

Nachteile:

- Kreditbasiertes Modell – Vielnutzer brauchen einen Bezahlplan.

- Sehr komplexe Seiten erfordern manchmal Anpassung der KI-Prompts.

- Keine direkten CRM-Integrationen (aber API verfügbar).

Preise:

- Kostenlos bis zu 6 Seiten/Monat (unbegrenzte Zeilen pro Seite).

- Bezahlpläne ab 15 $/Monat für 500 Credits (1 Credit = 1 Zeile), bis zu 249 $/Monat für 20.000 Credits.

Ideal für:

Vertriebs-, Marketing- und Operationsteams, die schnell und ohne Programmieraufwand an saubere Daten kommen wollen. Perfekt für Lead-Generierung, Wettbewerbsbeobachtung und Preisanalysen im E-Commerce.

Du willst Thunderbit direkt ausprobieren? und teste kostenlos.

2. Octoparse: Stapelverarbeitung mit visueller Oberfläche

ist ein echter Klassiker unter den No-Code-Scrapern und bekannt für seine Drag-and-Drop-Oberfläche und die Möglichkeit, große Datenmengen in einem Rutsch zu extrahieren. Die Desktop-App (Windows/Mac) bietet einen visuellen Workflow-Builder – einfach durch die Seite klicken, Octoparse zeichnet alles auf.

Wichtige Funktionen:

- Visueller Workflow-Designer: Scraper per Mausklick zusammenstellen, kein Code nötig.

- Cloud- & Lokale Ausführung: Jobs auf dem eigenen Rechner oder in der Cloud laufen lassen.

- 100+ Vorlagen: Vorgefertigte Templates für Amazon, eBay, Twitter, Google Maps u.v.m.

- Smart Mode: KI erkennt Datenlisten automatisch für schnelleren Start.

- Komplexe Seiten: Unterstützt Logins, AJAX, Endlos-Scroll.

- Export nach CSV, Excel, JSON, HTML oder per API.

Vorteile:

- Einsteigerfreundlich, aber auch für Profis geeignet.

- Riesige Vorlagenbibliothek für gängige Seiten.

- Cloud-Planung für wiederkehrende Aufgaben.

- Mehrsprachige Oberfläche.

Nachteile:

- Nur für Windows/Mac (kein Linux, keine Web-App).

- Für fortgeschrittene Features (XPath, Logik) ist Einarbeitung nötig.

- Gratis-Tarif eingeschränkt; höhere Pläne für Vielnutzer teuer.

Preise:

- Kostenlos (10 Aufgaben).

- Standard: ca. 75 $/Monat (jährliche Abrechnung).

- Professional: ca. 209 $/Monat (jährliche Abrechnung).

Ideal für:

Analysten, kleine Teams oder KMU, die regelmäßig große Datenmengen – vor allem von bekannten Seiten – extrahieren möchten.

3. ParseHub: Leistungsstarkes visuelles Scraping für komplexe Websites

ist eine Desktop-App (Windows, Mac, Linux), die speziell für komplexe, dynamische Webseiten entwickelt wurde – etwa Seiten mit viel JavaScript, Endlos-Scroll oder mehrstufiger Navigation.

Wichtige Funktionen:

- Visueller Workflow-Builder: Elemente per Klick auswählen, Schleifen und Aktionen definieren.

- Komplexe Seiten: Unterstützt AJAX, Karten, Logins.

- Geplantes Scraping: Jobs zeitgesteuert ausführen (in Bezahlplänen).

- Plattformübergreifend: Für Windows, Mac und Linux.

- Export nach JSON, CSV, Excel.

Vorteile:

- Hervorragend für dynamische oder interaktive Seiten.

- Großzügiger Gratis-Tarif (200 Seiten/Lauf, 5 Projekte).

- Plattformübergreifend nutzbar.

Nachteile:

- Läuft meist lokal (Rechner muss an sein).

- Fortgeschrittene Workflows erfordern Einarbeitung.

- Bezahlpläne für Gelegenheitsnutzer teuer.

Preise:

- Kostenlos: 5 Projekte, 200 Seiten/Lauf.

- Standard: 189 $/Monat (10.000 Seiten/Lauf).

- Professional: 599 $/Monat (unbegrenzte Seiten/Lauf).

Ideal für:

Technikaffine Nutzer, Datenjournalisten oder Teams, die komplexe, dynamische Seiten scrapen möchten.

4. DataMiner: Chrome-Erweiterung für einfaches Scraping per Klick

ist eine Browser-Erweiterung (Chrome/Edge), mit der du Tabellen und Listen mit wenigen Klicks extrahieren kannst – ganz ohne Programmierung. Das Highlight: Über 60.000 vorgefertigte „Rezepte“ für bekannte Websites.

Wichtige Funktionen:

- Daten per Klick auswählen: Tabellen oder Listen direkt im Browser markieren.

- Rezept-Bibliothek: Ein-Klick-Scraping für Google, Amazon, LinkedIn u.v.m.

- Paginierung: Automatisches Weiterklicken und Zusammenführen der Ergebnisse.

- Google Sheets-Integration: Daten direkt ins Spreadsheet übertragen.

- Cloud-Scraping (Bezahlpläne): Jobs auf deren Servern ausführen.

Vorteile:

- Sehr einfach für schnelle Datenerfassung im Browser.

- Riesige Rezept-Bibliothek für gängige Seiten.

- Kostenlose Schulungen und schneller Support.

Nachteile:

- Gratis-Tarif auf 500 Seiten/Monat begrenzt.

- Fortgeschrittene Features (mehrstufiges Crawling, Automatisierung) erfordern Einarbeitung und Bezahlpläne.

- Kein integriertes IP-Routing – am besten für moderates Scraping.

Preise:

- Kostenlos: 500 Seiten/Monat.

- Solo: 19,99 $/Monat (500 Seiten, alle Features).

- Small Business: 49 $/Monat (1.000 Seiten).

- Business: 99 $/Monat (4.000 Seiten).

Ideal für:

Vertriebs-, Marketing- und Research-Profis, die schnell tabellenfertige Daten direkt im Browser brauchen.

5. Scrapy: Open-Source-Flexibilität für Profis

ist das Profi-Tool für Entwickler: Ein Python-basiertes Open-Source-Framework für maßgeschneiderte Webcrawler und große Scraping-Projekte.

Wichtige Funktionen:

- Code-basiert: Eigene Spider in Python schreiben.

- Schnelles, asynchrones Crawling: Tausende Seiten pro Stunde scrapen.

- Erweiterbar: Proxies, CAPTCHAs, eigene Parser u.v.m. integrierbar.

- Export nach CSV, JSON, Datenbanken oder beliebigem Format.

- Große Community & Ökosystem.

Vorteile:

- Maximale Flexibilität und Skalierbarkeit.

- Komplett kostenlos (Open Source).

- Lässt sich in jede Datenpipeline integrieren.

Nachteile:

- Python-Kenntnisse erforderlich – steile Lernkurve für Nicht-Entwickler.

- JavaScript-lastige Seiten nur mit Headless-Browser-Integration.

- Infrastruktur und Wartung in Eigenregie.

Preise:

- Kostenlos (Self-Hosting, Open Source).

Ideal für:

Entwicklerteams oder Data Engineers, die individuelle, groß angelegte Scraping-Lösungen bauen.

6. Import.io: KI-Web-Scraper für Unternehmen mit großem Datenbedarf

richtet sich an Unternehmen und kombiniert einen visuellen Extraktor mit Machine Learning und leistungsstarken Tools zur Datenaufbereitung.

Wichtige Funktionen:

- Visuelle Extraktion per Klick: Extraktoren ohne Code erstellen.

- Verkettete Extraktoren: Listen scrapen und automatisch Unterseiten durchsuchen.

- Datenbereinigung & Transformation: Integrierte Tools für saubere, einheitliche Daten.

- Planung & API-Integration: Wiederkehrende Jobs automatisieren und an BI-Tools anbinden.

- Enterprise-Features: Nutzerverwaltung, Audit-Logs, SLAs.

Vorteile:

- Bewältigt große, komplexe Projekte mit hoher Zuverlässigkeit.

- Fokus auf Datenqualität und Transformation.

- Dedizierter Support und SLAs für Unternehmen.

Nachteile:

- Einstiegspreis hoch (ab mehreren Hundert bis über 1.000 $/Monat).

- Für Einzelprojekte oder kleine Aufgaben weniger geeignet.

- Onboarding und Einrichtung aufwendiger.

Preise:

- Individuelle Enterprise-Preise (ab ca. 499 $/Monat).

- Kostenlose Testphase verfügbar.

Ideal für:

Große Unternehmen oder datengetriebene Firmen, die zuverlässige, großvolumige Webdaten benötigen.

7. WebHarvy: Visuelles Scraping mit automatischer Mustererkennung

ist eine Windows-Desktop-App, die Scraping so einfach macht wie das Anklicken der gewünschten Daten. Die automatische Mustererkennung wählt ähnliche Elemente aus – ideal für Listen und Tabellen.

Wichtige Funktionen:

- Point-and-Click-Oberfläche: Daten anklicken, WebHarvy extrahiert die ganze Liste.

- Automatische Mustererkennung: Keine Selektoren nötig.

- Mehrseitiges & Bild-Scraping: Paginierung und Bilder-Download inklusive.

- Formularausfüllung & Keyword-Scraping: Suchen automatisieren und Ergebnisse extrahieren.

- Einmalige Lizenz: Einmal kaufen, dauerhaft nutzen.

Vorteile:

- Sehr einsteigerfreundlich.

- Einmalige Kosten – langfristig günstig.

- Funktioniert offline – Daten bleiben auf dem eigenen Rechner.

Nachteile:

- Nur für Windows (kein Mac/Linux).

- Kein Cloud-Modul – PC muss für geplante Jobs laufen.

- Für sehr dynamische Seiten ggf. Scripting nötig.

Preise:

- 129 $ einmalig (Einzelplatzlizenz, inkl. 1 Jahr Updates).

- 15 Tage kostenlos testen.

Ideal für:

Einzelanwender, kleine Unternehmen oder Forscher auf Windows, die eine günstige, einfache Lösung für gelegentliches Scraping suchen.

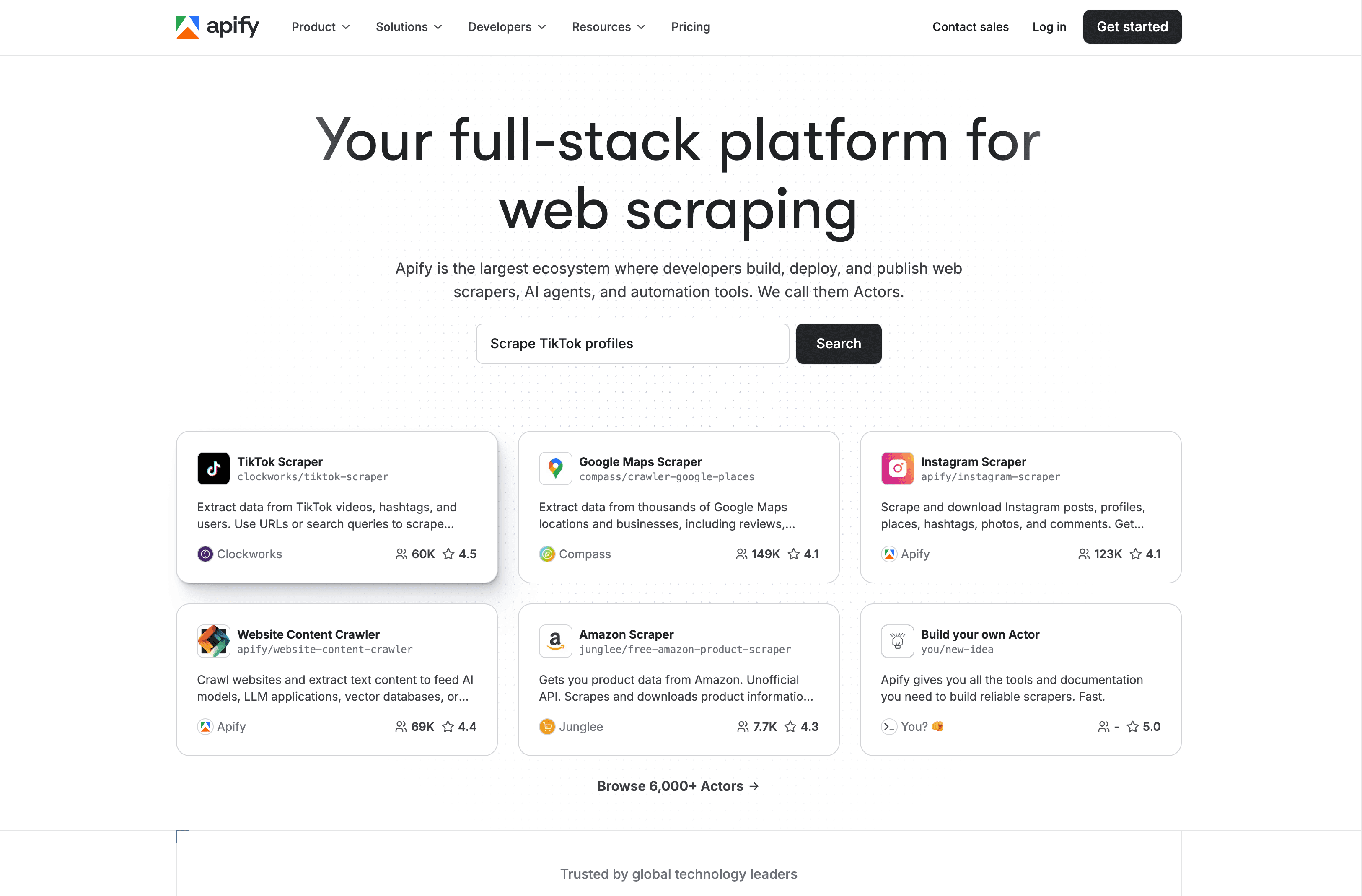

8. Apify: Cloud-Automatisierung und Marktplatz für KI-Web-Scraping

ist eine cloudbasierte Plattform mit einem riesigen Marktplatz für vorgefertigte „Actors“ (Scraping-Bots) und der Möglichkeit, eigene Skripte in JavaScript oder Python zu erstellen.

Wichtige Funktionen:

- Marktplatz mit 5.000+ Actors: Ein-Klick-Scraper für Google Maps, Amazon, Facebook u.v.m.

- Eigene Skripte: Eigene Bots mit Node.js oder Python programmieren.

- Cloud-Infrastruktur: Skalierung, Planung, Proxies und Speicher inklusive.

- API & Integration: Anbindung an Zapier, Make, Google Sheets, AWS u.v.m.

- Anti-Blocking: IP-Rotation und Wiederholungen.

Vorteile:

- Kombiniert fertige Scraper mit individueller Programmierung.

- Hoch skalierbar für große Projekte.

- Aktive Community und viele Integrationsmöglichkeiten.

Nachteile:

- Oberfläche für absolute Einsteiger etwas komplex.

- Kreditbasiertes Preismodell kann verwirrend sein.

- Community-Actors werden nicht immer regelmäßig gepflegt.

Preise:

- Gratis-Tarif (begrenzte Credits).

- Personal: 49 $/Monat.

- Scale: 499 $/Monat.

- Enterprise: ab 999 $/Monat.

Ideal für:

Entwickler, technikaffine Teams oder alle, die skalierbares, anpassbares Scraping mit vorgefertigten Bots kombinieren möchten.

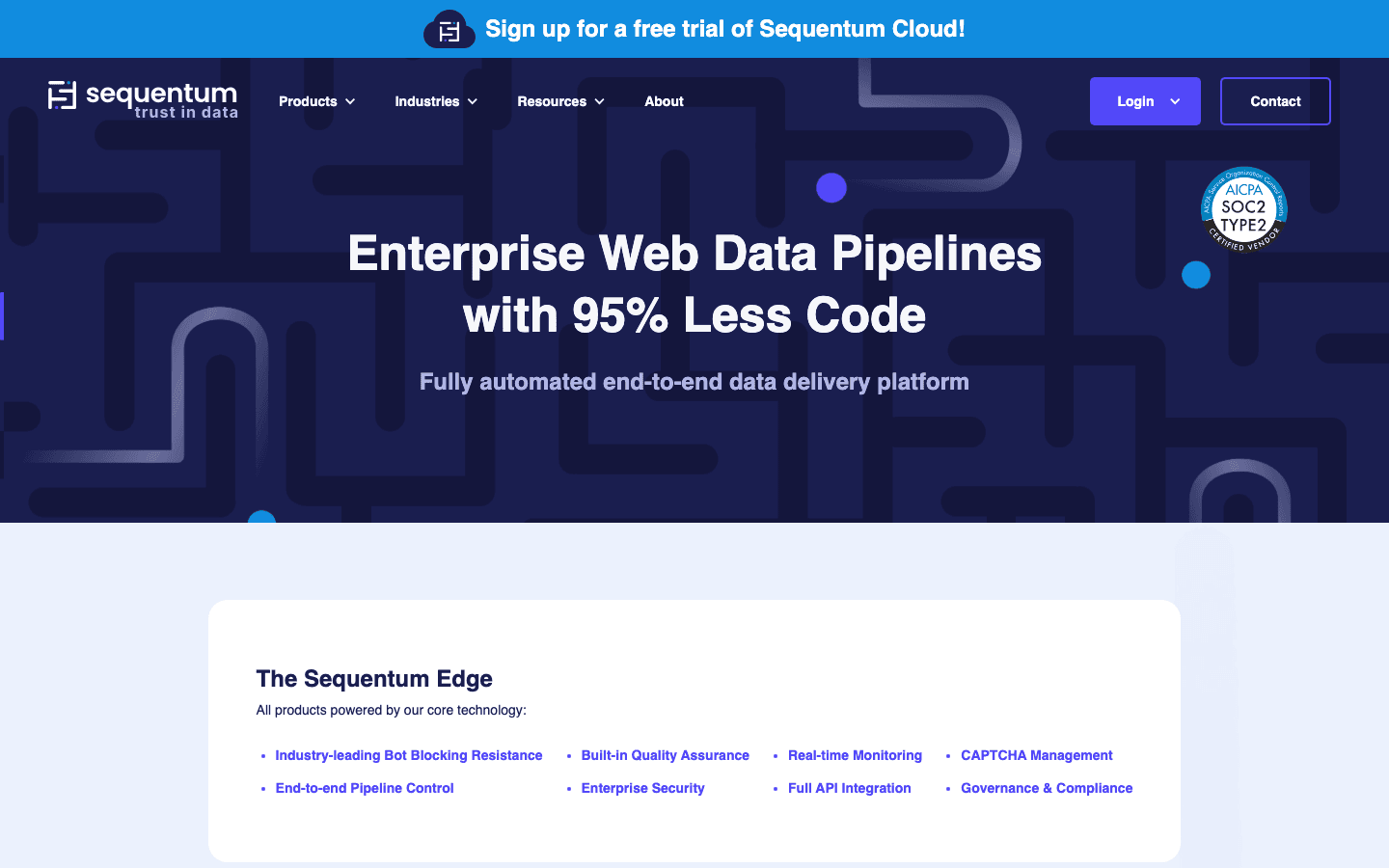

9. Dexi.io: Cloudbasierter KI-Web-Scraper für Workflow-Automatisierung

(früher CloudScrape) ist eine Enterprise-Cloud-Plattform für den Aufbau und die Automatisierung komplexer Webdaten-Workflows – quasi RPA für Web-Scraping.

Wichtige Funktionen:

- Visueller Robot-Builder: Workflows mit Logik, Schleifen und Bedingungen gestalten.

- Cloud-Ausführung: Roboter laufen auf Dexis Servern – keine eigene Infrastruktur nötig.

- Datenaufbereitung & Integration: Daten bereinigen und in Datenbanken, APIs oder Analyse-Tools exportieren.

- Teamarbeit: Mehrbenutzer-Support, Versionskontrolle, rollenbasierte Zugriffe.

- Planung & Monitoring: Wiederkehrende Jobs automatisieren und überwachen.

Vorteile:

- Ideal für die Automatisierung mehrstufiger, kollaborativer Workflows.

- Starke Integrations- und Nachbearbeitungsfunktionen.

- Zuverlässig für Projekte im Unternehmensmaßstab.

Nachteile:

- Für fortgeschrittene Workflows steile Lernkurve.

- Einstiegspreis ab 119 $/Monat.

- Kleinere Community – Support hauptsächlich über Dexi.

Preise:

- Ab ca. 119 $/Monat.

- Kostenlose Testphase verfügbar.

Ideal für:

Mittlere bis große Unternehmen oder Agenturen, die umfangreiche Webdaten-Workflows mit Teamarbeit automatisieren möchten.

10. Content Grabber: Automatisierung und Integration für Power-User

ist eine Windows-basierte, professionelle Scraping-Plattform für Power-User und IT-Teams, die tiefe Automatisierung und Integration benötigen.

Wichtige Funktionen:

- Vollständige IDE: Visueller Editor plus Scripting in C# oder VB.NET.

- Integrierte Planung & Protokollierung: Scraping-Jobs automatisieren, überwachen und benachrichtigen.

- Datenbank- & API-Integration: Export direkt nach SQL, XML, JSON oder Excel.

- Eigenständige EXE-Dateien: Scraper als ausführbare Programme verteilen.

- Enterprise Management Console: Zentrale Steuerung für große Rollouts.

Vorteile:

- Extrem leistungsfähig und erweiterbar.

- On-Premises-Kontrolle für sensible Daten.

- Einmalige Lizenz oder Abo möglich.

Nachteile:

- Steile Lernkurve – am besten für Technikprofis.

- Nur für Windows.

- Hohe Einstiegskosten für kleine Projekte.

Preise:

- Professional: ca. 995 $ einmalig oder 149 $/Monat.

- Premium: ca. 2.495 $ einmalig oder 299 $/Monat.

- Server-Edition: 449 $/Jahr.

Ideal für:

Großunternehmen, IT-Abteilungen oder Datenanbieter, die großvolumiges, individuell anpassbares Scraping mit tiefer Integration benötigen.

Schnellvergleich: KI-Web-Scraper-Tools im Überblick

| Tool | Kernfunktionen | Preis (ab) | Ideal für | Besondere Stärken |

|---|---|---|---|---|

| Thunderbit | Chrome-Erweiterung, KI-2-Klick-Scraping, Unterseiten | Kostenlos/ 15 $/Monat | Nicht-technische Business-User | Einfachste Einrichtung, KI-Felderkennung, Gratis-Export |

| Octoparse | Visuelle Desktop-App, 100+ Vorlagen, Cloud/Lokal | Kostenlos/ 75 $/Monat | Analysten, KMU, Vorlagen-Scraping | Riesige Vorlagenbibliothek, Hybrid Cloud/Desktop |

| ParseHub | Visueller Workflow, dynamische Seiten, plattformübergreifend | Kostenlos/ 189 $/Monat | Technikaffine Nutzer, komplexe Seiten | Stark bei JS-lastigen Seiten, großzügiger Gratis-Tarif |

| DataMiner | Chrome-Erweiterung, 60k+ Rezepte, Sheets-Integration | Kostenlos/ 19,99 $/Monat | Vertrieb, Marketing, schnelle Datenerfassung | Riesige Rezept-Bibliothek, einfacher Sheets-Export |

| Scrapy | Python-Framework, Code-basiert, skalierbar | Kostenlos (Open Source) | Entwicklerteams, individuelle Großprojekte | Maximale Flexibilität, keine Lizenzkosten |

| Import.io | Enterprise-Cloud, ML-Extraktion, Datenaufbereitung | ca. 499 $/Monat (individuell) | Großunternehmen, zuverlässige Datenfeeds | Komplettlösung, starker Support/SLAs |

| WebHarvy | Windows-App, Mustererkennung, Einmallizenz | 129 $ einmalig | Einzelanwender, kleine Unternehmen auf Windows | Einsteigerfreundlich, Einmalzahlung, Offline-Nutzung |

| Apify | Cloud, 5k+ Actors, eigene Skripte, API | Kostenlos/ 49 $/Monat | Entwickler, skalierbares/individuelles Scraping | Marktplatz + eigene Programmierung, hoch skalierbar |

| Dexi.io | Cloud-Builder, Workflow-Automatisierung | ca. 119 $/Monat | Unternehmen, Team-Automatisierung | Fokus auf ETL-Workflows, Kollaborationsfunktionen |

| Content Grabber | Windows-IDE, Scripting, Planung, Integration | 995 $ einmalig/ 149 $/Monat | Unternehmen, IT mit Integrationsbedarf | Funktionsreich, On-Premises, eigenständige Bots |

Welcher KI-Web-Scraper passt zu deinem Unternehmen?

Welches KI-Web-Scraper-Tool ist das richtige? Hier meine Einschätzung:

- Für Einsteiger, Vertrieb/Marketing oder alle, die keine Einrichtung mögen: ist die beste Wahl – schnell, präzise, ohne Lernaufwand.

- Für Vorlagen-Fans oder Stapelverarbeitung: und sind ideal für bekannte Seiten und wiederkehrende Aufgaben.

- Für komplexe, dynamische Seiten oder Technik-Teams: , oder bieten maximale Flexibilität.

- Für Enterprise, Workflow-Automatisierung oder tiefe Integration: , und sind dafür gemacht.

Tipp: Starte mit einer kostenlosen Testphase. Die meisten Tools kannst du vorab ausprobieren – teste sie an einer echten Aufgabe und finde heraus, welches am besten zu deinem Workflow und Know-how passt.

Die Zukunft der KI-Web-Scraper: Trends im Blick

KI-Web-Scraper werden immer smarter. Das erwartet uns in den nächsten Jahren:

- Besserer Umgang mit dynamischen Inhalten: KI-Scraper „verstehen“ Seiten immer mehr wie Menschen und sind robuster gegenüber Layout- und JavaScript-Änderungen ().

- Intelligentere Datenaufbereitung: Immer mehr Tools bieten integrierte Bereinigung, Kategorisierung und Anreicherung – so werden Rohdaten zu direkt nutzbaren Insights ().

- Abfragen in natürlicher Sprache: Tools wie Thunderbit machen es vor – einfach beschreiben, was du brauchst, und die KI erledigt den Rest ().

- Tiefere Workflow-Automatisierung: Scraper werden immer häufiger direkt Aktionen auslösen – etwa CRM-Updates oder E-Mail-Kampagnen – ganz ohne manuelles Zutun.

- Multimodales Scraping: Künftig werden nicht nur Texte, sondern auch Bilder, Videos und Audios automatisch extrahiert.

Fazit: Die nächste Generation von KI-Web-Scrapern macht Datenerfassung fast zum Selbstläufer – so bleibt dir mehr Zeit, die gewonnenen Daten für dein Business zu nutzen.

Häufige Fragen (FAQ)

1. Was ist ein KI-Web-Scraper und wie unterscheidet er sich von klassischen Scraper-Tools?

Ein KI-Web-Scraper nutzt künstliche Intelligenz, um Daten automatisch auf Webseiten zu erkennen, zu extrahieren und zu strukturieren. Im Gegensatz zu klassischen Scraper-Tools, die meist Programmierung oder manuelle Konfiguration erfordern, passen sich KI-Scraper an wechselnde Layouts an, verarbeiten dynamische Inhalte und funktionieren oft mit einfachen Anweisungen in Alltagssprache – ideal für Nicht-Techniker.

2. Welcher KI-Web-Scraper eignet sich am besten für Nicht-Techniker?

ist besonders beliebt wegen der Zwei-Klick-Bedienung und der KI-gestützten Felderkennung – perfekt für Business-Anwender ohne Programmierkenntnisse. Auch und sind gute Optionen für Einsteiger.

3. Können KI-Web-Scraper auch dynamische oder JavaScript-lastige Seiten verarbeiten?

Ja – Tools wie , und sind speziell für dynamische Inhalte, Endlos-Scroll und Logins ausgelegt. Für besonders komplexe Seiten bieten Entwickler-Frameworks wie (mit Headless-Browser-Integration) volle Kontrolle.

4. Wie finde ich den passenden KI-Web-Scraper für mein Unternehmen?

Überlege, wie technisch versiert dein Team ist, wie komplex die Zielseiten sind, welche Exportformate du brauchst und welches Budget zur Verfügung steht. Teste Tools mit einer kostenlosen Testphase. Für schnelle, No-Code-Aufgaben sind Thunderbit oder Octoparse ideal; für große oder individuelle Projekte eignen sich Apify oder Scrapy besser.

5. Gibt es rechtliche oder ethische Aspekte beim Web-Scraping?

Prüfe immer die Nutzungsbedingungen der Zielseite und beachte Datenschutzgesetze. Die meisten KI-Web-Scraper bieten Funktionen, um Anfragen zu drosseln und Webseiten nicht zu überlasten. Nutze Scraping verantwortungsvoll – konzentriere dich auf öffentlich zugängliche Daten und vermeide das Sammeln sensibler Informationen ohne Einwilligung.

Bereit, deine Produktivität zu boosten? Teste oder hol dir noch mehr Tipps im . Viel Erfolg beim Scrapen – und mögen deine Daten immer sauber, präzise und einsatzbereit sein.

Mehr erfahren: