老實說,社群媒體根本就是一座寶庫,裡面塞滿了各種觀點、流行趨勢、迷因,還有那些讓人一滑就停不下來的貓咪影片。但在這些爆紅舞蹈和熱門話題背後,其實藏著一大堆數據等著被挖掘。現在每天都有數十億則貼文、留言和個人檔案誕生,社群媒體早就成為即時消費者和市場洞察的超級資料來源。

我自己長期在 SaaS 和自動化領域打滾,真的看過太多企業為了解讀這些數位聲量絞盡腦汁(真的就是腦袋快打結那種)。不管你是行銷人、業務高手,還是像我一樣的數據狂熱者,你一定都想過:企業到底怎麼收集、分析這些社群數據?這時候,社群媒體爬蟲工具就超級重要啦。這篇文章會用最簡單的方式,帶你搞懂什麼是社群媒體爬蟲、它們怎麼運作(保證不會講一堆技術黑話),還有不管你是 Python 達人還是完全不會寫程式,都能怎麼開始擷取洞察。

社群媒體爬蟲:基礎說明

先來個基本認識。社群媒體爬蟲,就是自動化收集社群平台(像 Facebook、Twitter(或 X)、Instagram、LinkedIn、TikTok 等)資料的過程。與其自己一條一條複製貼上貼文或留言(說真的,這比看油漆乾還無聊),不如交給社群媒體爬蟲工具幫你搞定這些瑣事。

那到底什麼是社群媒體爬蟲工具?簡單說,它就是一種軟體或服務,會自動瀏覽社群頁面,讀取公開資訊,把你要的內容(像貼文、留言、標籤、用戶資料、粉絲數等等)都抓下來。有些人也會叫這類工具社群媒體爬行器(crawler),因為它們會「爬」遍各個頁面找資料,但爬行器和爬蟲還是有點不一樣。爬行器像是偵查兵,負責探索地形;爬蟲則是那個真的把寶藏帶回來的夥伴。

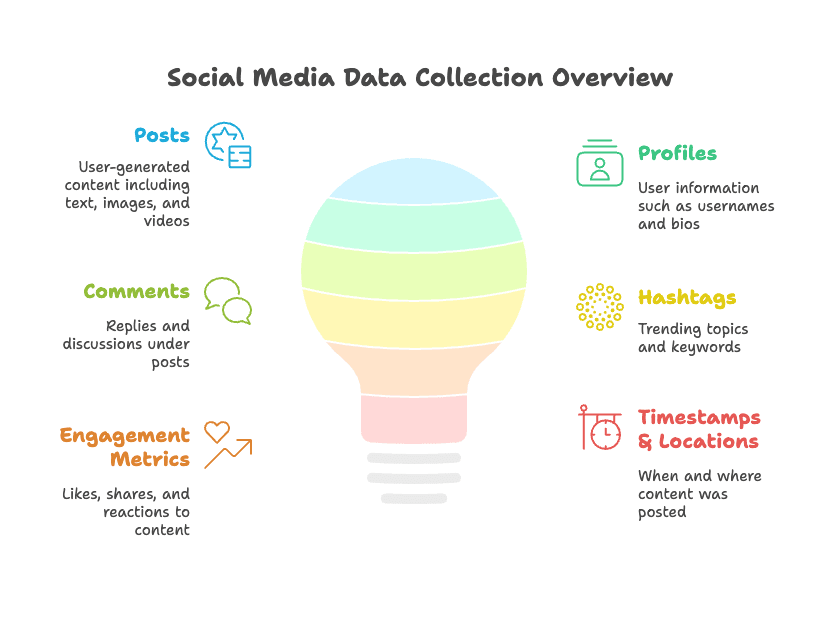

你可以用社群媒體爬蟲抓到哪些常見資料?舉幾個例子:

- 貼文:用戶分享的內容,像文字、圖片、影片、連結等。

- 個人檔案:用戶名稱、簡介、大頭貼、粉絲/追蹤數等。

- 留言:貼文下的回覆和討論。

- 標籤:熱門話題、活動標籤或關鍵字。

- 按讚、分享、互動:哪些內容最受歡迎的互動指標。

- 時間戳記與地點:內容發布的時間和地點。

如果你腦中浮現一個拿著放大鏡的機器人,其實也沒錯——只是這些機器人不用喝咖啡。

為什麼企業重視社群媒體數據擷取?

那企業為什麼這麼愛抓社群媒體數據?其實不只是怕錯過流行,更是為了挖掘真正有價值的洞察。來看看企業常用社群媒體爬蟲的幾個理由:

| 應用場景 | 好處 | 實際成效 |

|---|---|---|

| 市場調查 | 掌握趨勢與消費者情緒 | 發現爆紅標籤、熱門話題 |

| 消費者洞察 | 了解顧客喜好與反饋 | 情緒分析、產品回饋 |

| 潛在客戶開發 | 尋找潛在客戶與合作夥伴 | 從 LinkedIn 建立名單 |

| 競爭對手分析 | 追蹤對手活動與策略 | 監控競品貼文與粉絲動態 |

| 品牌監控 | 維護品牌聲譽、預防公關危機 | 即時警示負面提及 |

| 銷售情報 | 辨識購買意圖與潛在客戶 | 追蹤職務異動、新進員工 |

舉個例子,假設你要推出新零食品牌。透過抓 Instagram 和 TikTok,你可以知道哪些口味最夯、網紅怎麼評論,甚至競爭對手的討論熱度。如果你是 B2B 業務,抓 LinkedIn 資料能幫你快速建立精準名單,找出剛換工作的決策者。

這些可不是空談——很多企業早就大規模運用。像 。。

社群媒體爬蟲工具怎麼運作?(簡單易懂版)

接下來,直接用最白話的方式拆解這些工具的運作原理——完全不用電腦科學學位。

基本流程

- 存取公開資料:工具會瀏覽社群頁面(像公開的 Instagram 個人檔案或 Twitter 標籤搜尋)。

- 擷取結構化資訊:讀取頁面內容,抓你要的資料(貼文、留言、按讚等),整理成表格或試算表。

- 匯出結果:把資料輸出成你能用的格式——CSV、Excel、Google Sheets,甚至直接串接分析工具。

爬蟲 vs. 爬行器 vs. API

- 社群媒體爬蟲:專門從網頁抓特定欄位(像貼文內容、作者、時間等)。

- 社群媒體爬行器:會自動瀏覽多個頁面(個人檔案、貼文、留言)找新資料,像探險家一樣。

- 官方 API:由平台提供(像 Facebook Graph API、Twitter API),是合法存取資料的方式,但通常有嚴格限制、流量上限,還要開發者設定。

反爬蟲機制

社群平台其實不太歡迎爬蟲。它們會設置像 CAPTCHA、流量限制、登入驗證等反機器人措施。有些工具能靠代理伺服器、切換用戶代理、解決驗證碼等方式突破,但有些就可能被封鎖或資料不完整。所以,不同工具的穩定性差很多。

想深入技術細節,很值得參考。

社群媒體數據擷取方案比較:從 Python 到無程式碼

抓一則推文(或 TikTok 舞蹈)的方法其實超多。這邊簡單比較幾種主流方式:

| 方法 | 技術門檻 | 設定時間 | 彈性 | 適合對象 |

|---|---|---|---|---|

| Python 函式庫(如 BeautifulSoup、snscrape) | 高 | 長 | 最高 | 開發者、自訂專案 |

| 官方 API(如 Facebook Graph API、Twitter API) | 中 | 中 | 高 | 應用整合、合規需求 |

| 無程式碼工具(如 Thunderbit) | 無 | 短 | 中高 | 商務用戶、快速需求 |

| 現成資料集 | 無 | 即時 | 低 | 一次性研究、非技術用戶 |

- Python 函式庫:適合技術人員,彈性高,可自訂流程,但要自己處理代理、資料清理等。

- 官方 API:合法又穩定,但資料存取有限制,申請流程也比較繁瑣。

- 無程式碼工具:適合不會寫程式的用戶,操作簡單,快速取得資料。

- 現成資料集:適合臨時研究,但資料可能不夠新或不符需求。

用 Python 擷取社群媒體數據:快速入門

來點技術內容。如果你熟 Python,可以用 、、 等函式庫自己打造社群媒體爬蟲。

基本步驟

-

安裝函式庫:打開終端機安裝需要的套件:

1pip install beautifulsoup4 requests snscrape -

寫程式碼:用 Requests 取得網頁、BeautifulSoup 解析 HTML,或用 snscrape 抓 Twitter 等平台資料。

-

擷取資料:找出包含目標資料的 HTML 元素(像

<div>、<span>等)。 -

輸出結果:把資料存成 CSV、Excel 或資料庫。

-

處理挑戰:注意流量限制、登入驗證、CAPTCHA 和資料清理等問題。

範例:用 snscrape 擷取推文

1import snscrape.modules.twitter as sntwitter

2import pandas as pd

3tweets = []

4for tweet in sntwitter.TwitterSearchScraper('from:elonmusk').get_items():

5 tweets.append([tweet.date, tweet.content, tweet.user.username])

6 if len(tweets) > 100:

7 break

8df = pd.DataFrame(tweets, columns=['Date', 'Content', 'Username'])

9df.to_csv('elon_tweets.csv', index=False)常見挑戰:

- API 和網站常常變動,程式可能隔天就壞掉。

- 如果要抓私人資料,還要處理認證。

- 大量抓取時,得用代理和反爬蟲技巧。

想看更多細節,可以參考 。

不用寫程式也能抓社群數據:Thunderbit 社群媒體爬蟲

如果你跟大多數人一樣,看到 Python 程式碼就想落跑,那你一定要認識 。(沒錯,我有點偏心,但真的有原因!)

Thunderbit 專為不懂技術的用戶設計,只要幾個步驟就能抓到社群數據。操作方式超簡單:

- 選擇範本:針對 Instagram、LinkedIn、Twitter/X 等平台,直接選現成範本。

- 貼上網址:輸入你想抓的個人檔案、貼文或標籤連結。

- AI 智能欄位建議:Thunderbit 的 AI 會自動分析頁面,推薦可擷取的資料欄位(像貼文內容、作者、按讚數等)。

- 一鍵擷取與匯出:點「擷取」就能把資料匯出到 Excel、Google Sheets、Airtable 或 Notion,完全免費。

特色亮點

- 子頁面擷取:不只主頁,連帶抓所有相關子頁(像個人檔案下所有貼文)。

- 即時範本:熱門平台一鍵擷取,完全不用煩設定。

- 免費資料匯出:多種格式下載,完全免費。

- 零程式碼門檻:只要會用滑鼠就能上手。

想看實際操作,歡迎到我們的 看教學影片。

可以抓什麼?社群媒體資料類型與範例

來點具體的。以下是各大平台(僅限公開資料)常見可抓的內容:

| 平台 | 資料類型 |

|---|---|

| 個人名稱、個人網址、大頭貼、粉絲/追蹤數、貼文(文字、日期、按讚等) | |

| Twitter/X | 推文、標籤、作者、時間、按讚、轉推、回覆、個人資訊 |

| 貼文、說明文字、標籤、作者、發文日期、按讚、留言、個人資訊 | |

| 姓名、職稱、公司、地點、貼文、連結、技能 | |

| TikTok | 影片、說明、標籤、作者、按讚、留言、分享、個人資訊 |

| YouTube | 影片標題、描述、觀看數、按讚、留言、頻道資訊 |

公開 vs. 私人資料:

- 公開資料:不需登入就能看到的內容——公開貼文、公開個人檔案、標籤等,通常合法可抓。

- 私人資料:需要登入、設為隱私或未公開的內容,抓這類資料在法律和道德上都不行。

想了解更多細節,可以參考 。

社群媒體爬蟲:法律與道德須知

嚴肅一點說,能抓資料不代表就能亂抓——一定要先搞清楚規則。

重要原則

- 公開 vs. 私人:只抓公開資料,私人或受限內容千萬別碰。

- 平台規範:每個平台都有自己的使用條款,違規可能被封鎖甚至更慘。

- 資料隱私法:像歐盟 這種法規保護個資,沒經同意請勿收集或分享個人識別資訊(PII)。

- 負責任使用:不要把抓到的資料用來發垃圾訊息、騷擾或其他不當用途。

最佳實踐:

- 一定要檢查平台的 robots.txt 和服務條款。

- 避免高頻率抓取,別影響網站正常運作。

- 如果不小心抓到個資,請馬上刪除。

- 有疑慮時,記得問法律專業。

更多資訊可以參考 。

入門建議:有效且合規地抓取社群媒體數據

準備開始了嗎?這裡整理幾個社群媒體數據擷取的實用建議,讓你高效又安心:

- 從小規模測試:先在幾個公開頁面試跑,確認流程沒問題再擴大。

- 善用範本:用現成範本(像 Thunderbit 內建)省時又減少出錯。

- 隨時監控變動:社群平台常常改版,有 AI 的工具(像 Thunderbit)能更快適應。

- 結合分析工具:抓資料只是第一步,搭配分析工具才能挖出趨勢和洞察。

- 遵守法規與道德:隨時注意最新規範,有疑慮就保守處理。

記住,重點不是單純收集資料,而是把數據變成有價值的洞察,幫你做出更聰明的決策。

結論:用社群媒體爬蟲工具解鎖數據洞察

社群媒體爬蟲早就不是駭客或數據科學家的專利。不管你是行銷人員、業務主管,還是單純想了解網路趨勢的人,這類工具都能幫你開啟新世界——從市場調查、消費者洞察,到名單開發和銷售情報。

重點就是選對工具。如果你愛寫程式,Python 函式庫和 API 給你最大彈性(但也最容易頭痛);如果你追求速度、簡單、零設定, 就是你的好夥伴——選範本、點擊、搞定。

不管你選哪種方式,記得一定要合規、尊重隱私,專注把原始數據轉成真正的商業價值。如果你準備好開始,歡迎參考 ,或到 找更多實用技巧。

最後,請容我先去補看幾支貓咪影片——純粹是為了研究啦。

延伸閱讀:

常見問題

1. 什麼是社群媒體爬蟲工具?它能做什麼?

社群媒體爬蟲工具是一種軟體或服務,能自動從 Facebook、Twitter、Instagram、LinkedIn、TikTok 等平台收集公開資料。它會抓像貼文、留言、標籤、用戶資料、互動數據等資訊,並自動整理,讓你不用手動複製貼上。

2. 為什麼企業要用社群媒體爬蟲工具?

企業用社群媒體爬蟲工具,能即時掌握市場趨勢、消費者情緒、競爭對手動態和品牌聲譽。這些工具有助於市場調查、名單開發、銷售情報和品牌監控,提供可行動的數據,幫助決策和策略規劃。

3. 社群媒體爬蟲工具是如何運作的?

這類工具通常會存取公開社群頁面,抓結構化資訊(像貼文、留言、按讚等),並把資料匯出成 CSV、Excel 或 Google Sheets 等格式。有些工具會用爬行器自動瀏覽多個頁面,有些則透過官方 API 或無程式碼方案,讓存取更簡單又合規。

4. 擷取社群媒體數據時有哪些法律與道德考量?

抓社群媒體數據時,一定只收集公開資訊並遵守各平台的使用條款。不能抓私人或受限資料。此外,必須遵守像 GDPR 這類資料隱私法規,沒經同意不能收集或分享個人識別資訊。負責任地用數據,才能避免法律和道德風險。

5. 有哪些社群媒體數據擷取方案?一定要會寫程式嗎?

市面上有很多方案,從進階的 Python 函式庫(適合會寫程式的人)、官方 API,到像 Thunderbit 這種無程式碼工具,完全不需要技術背景。無程式碼工具適合商務用戶快速取得結果,開發者則可選自訂腳本。如果只是一次性研究,也可以考慮現成資料集。