網路上有滿滿的寶藏資料,不管你是做銷售、電商還是市場調查,網頁爬蟲都是你開發潛在客戶、監控價格、分析競爭對手的秘密武器。但現實很骨感:隨著越來越多人投入爬蟲,網站的防禦也越來越硬。其實,, 幾乎變成標配。如果你有過 Python 腳本跑得好好的,突然 403 被擋的經驗,那種無力感一定懂。

我在 SaaS 跟自動化領域混了好幾年,深知爬蟲專案常常從「這有什麼難?」瞬間變成「怎麼到處都被擋?」這篇文章就要帶你實戰:怎麼用 Python 寫出不容易被封鎖的網頁爬蟲,分享最實用的技巧和程式碼,還有什麼時候該考慮像 這種 AI 驅動的替代方案。不管你是 Python 老鳥還是剛入門,都能學到一套穩定又低風險的資料擷取方法。

什麼是「Python 無阻擋網頁爬蟲」?

所謂「無阻擋網頁爬蟲」,就是用一種不會被網站反爬蟲機制抓包的方式來抓資料。對 Python 來說,這可不是單純寫個 requests.get() 迴圈就好——你得學會怎麼偽裝成一般用戶,避開網站的監控。

為什麼選 Python?,因為語法簡單、套件超多(像 requests、BeautifulSoup、Scrapy、Selenium),從小型腳本到分散式爬蟲都能搞定。但也因為太熱門,很多反爬蟲系統都專門針對 Python 的行為來設計。

所以想要穩定抓資料,你得超越基本功,深入了解網站怎麼抓機器人,以及怎麼合法、合規地繞過這些防線。

為什麼「不被封鎖」對 Python 網頁爬蟲這麼重要?

被封鎖不只是技術問題,還可能讓整個商業流程卡住。來看看常見情境:

| 應用場景 | 被封鎖的影響 |

|---|---|

| 潛在客戶開發 | 名單不完整或過時,錯失商機 |

| 價格監控 | 漏掉競爭對手價格變動,定價失誤 |

| 內容彙整 | 新聞、評論或研究資料出現缺口 |

| 市場情報 | 產業或競爭對手動態無法掌握 |

| 房地產資訊 | 物件資料不準確或過期,錯過機會 |

爬蟲被擋,不只是資料抓不到,還可能浪費資源、增加合規風險,甚至因為資訊不全而做出錯誤決策。現在 ,穩定性真的超級重要。

網站怎麼偵測並封鎖 Python 網頁爬蟲?

網站的反爬蟲技術越來越聰明,常見的防禦手法有(參考 、):

- IP 黑名單: 同一 IP 太多請求就直接封鎖。

- User-Agent 跟標頭檢查: 預設的 Python 標頭(像

python-requests/2.25.1)一看就知道是機器人。 - 請求速率限制: 請求太密集就被限流或封鎖。

- 驗證碼(CAPTCHA): 逼你證明自己是人類,機器人很難過關。

- 行為分析: 監控有沒有機械式、重複的點擊或操作。

- 蜜罐陷阱: 藏一些只有機器人才會點的連結或欄位。

- 瀏覽器指紋辨識: 收集瀏覽器和裝置資訊,辨識自動化工具。

- Cookie 跟 Session 追蹤: 不處理 Cookie 或 Session 的爬蟲很容易被抓包。

就像機場安檢一樣:你行為自然就能過,太奇怪就會被特別關注。

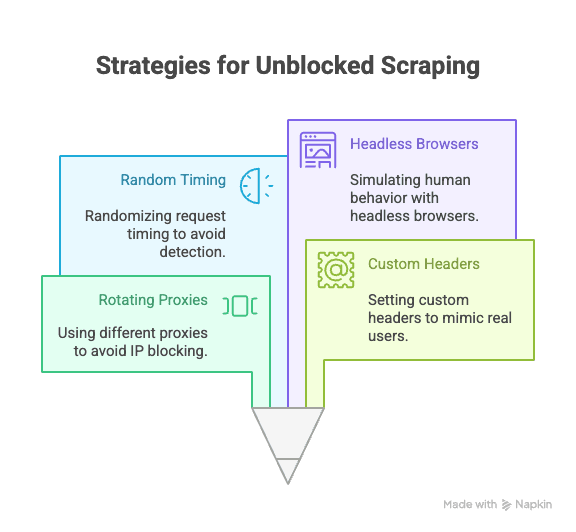

Python 網頁爬蟲不被封鎖的核心技巧

重點來了:怎麼用 Python 避開封鎖?以下是每個爬蟲必備的實戰招式:

代理伺服器與 IP 輪換

為什麼重要: 所有請求都從同一 IP 出去,最容易被封。代理伺服器可以幫你分散來源,大幅降低被封鎖的機率。

Python 實作範例:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...更多代理

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # 處理回應建議用付費的住宅代理或輪換代理,穩定性高很多(參考 )。

設定 User-Agent 跟自訂標頭

為什麼重要: 預設的 Python 標頭超容易被識破。模仿真實瀏覽器的 User-Agent 跟標頭能有效降低風險。

範例程式碼:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)建議定期更換 User-Agent,效果更好(參考 )。

請求間隔與行為隨機化

為什麼重要: 機器人請求速度又快又規律,人類則慢又隨機。加上隨機延遲、變換操作路徑能有效降低被偵測的機率。

Python 實作:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # 隨機等待 2–7 秒如果用 Selenium,也可以隨機點擊、滾動等行為。

管理 Cookie 跟 Session

為什麼重要: 很多網站需要 Cookie 或 Session 才能正常瀏覽,忽略這些細節很容易被擋。

Python 實作:

1import requests

2session = requests.Session()

3response = session.get(url)

4# session 會自動處理 cookie遇到更複雜的流程,可以用 Selenium 抓取並重用 Cookie。

用無頭瀏覽器模擬人類行為

為什麼重要: 有些網站會偵測 JavaScript、滑鼠移動、滾動等互動。用 Selenium 或 Playwright 這類無頭瀏覽器能模擬真實用戶行為。

Selenium 範例:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))這樣能避開行為分析和動態內容的限制(參考 )。

進階技巧:Python 如何破解 CAPTCHA 跟蜜罐陷阱

CAPTCHA 就是專門擋機器人的。雖然有些 Python 套件能解簡單驗證碼,但大多數專業爬蟲會用第三方服務(像 2Captcha、Anti-Captcha)付費解決(參考 )。

範例整合:

1# 使用 2Captcha API 的偽代碼

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# 等待解答,再帶入請求蜜罐陷阱 是網站設計的隱藏欄位或連結,只有機器人會誤觸。建議只操作真實瀏覽器上看得到的元素(參考 )。

用 Python 套件設計更擬真的請求標頭

除了 User-Agent,還可以隨機化 Referer、Accept、Origin 等標頭,讓請求更像真人。

Scrapy 範例:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # 更多標頭

7 }

8 }Selenium 用法: 可以透過瀏覽器設定檔或擴充套件設置標頭,或用 JavaScript 注入。

建議多參考瀏覽器 DevTools 的真實請求,定期更新標頭清單。

當傳統 Python 爬蟲遇到瓶頸:反爬蟲技術的進化

現實就是:隨著爬蟲越來越普及,網站的反制手段也不斷升級。。AI 偵測、動態請求門檻、瀏覽器指紋辨識,讓再厲害的 Python 腳本也很難長期隱身(參考 )。

有時候,不管你多會寫程式,還是會卡關。這時候就該考慮換個做法。

Thunderbit:AI 網頁爬蟲,Python 之外的新選擇

當 Python 技巧到極限時, 就是專為商業用戶設計的無程式碼、AI 驅動網頁爬蟲。你不用再煩惱代理、標頭、驗證碼,Thunderbit 的 AI 會自動讀取網頁、推薦最佳欄位、處理子頁面和資料匯出。

Thunderbit 有哪些獨家優勢?

- AI 欄位推薦: 一鍵「AI 建議欄位」,自動掃描頁面、推薦欄位、產生擷取指令。

- 子頁面爬取: 能自動進入每個子頁(像商品詳情、LinkedIn 個人頁),自動補齊資料。

- 雲端/瀏覽器雙模式: 公開頁面用雲端,登入頁面用瀏覽器,速度和穩定性兼顧。

- 排程爬蟲: 設定好自動執行,資料永遠保持最新。

- 即用範本: 針對熱門網站(Amazon、Zillow、Shopify 等)提供一鍵範本,免設定。

- 免費資料匯出: 可直接匯出到 Excel、Google Sheets、Airtable、Notion,完全不用加錢。

Thunderbit 已經有 ,而且完全不用寫程式。

Thunderbit 怎麼幫用戶避開封鎖、自動化資料擷取?

Thunderbit 的 AI 不只是模仿人類行為,更能即時適應每個網站,大幅降低被封鎖的風險:

- AI 自動適應版面變動: 網站改版也不怕,腳本不會輕易失效。

- 自動處理子頁和分頁: 能像真人一樣自動點擊連結、翻頁。

- 雲端高速批次爬取: 一次可抓 50 頁,效率超高。

- 免寫程式、免維護: 你只要專心分析資料,不用再 debug。

想更深入了解,推薦你看 。

Python 爬蟲 vs. Thunderbit:該怎麼選?

直接比較兩者差異:

| 功能 | Python 爬蟲 | Thunderbit |

|---|---|---|

| 建置時間 | 中高(需寫腳本、設代理等) | 極低(2 步驟,AI 全自動) |

| 技術門檻 | 需會寫程式 | 完全免寫程式 |

| 穩定性 | 易受網站變動影響 | 高(AI 自動調整) |

| 被封鎖風險 | 中高 | 低(AI 擬真人類行為) |

| 擴展性 | 需自建雲端/批次處理 | 內建雲端批次爬取 |

| 維護成本 | 頻繁(網站變動、被封) | 極低(AI 自動修正) |

| 匯出選項 | 手動(CSV、資料庫) | 直接匯出 Sheets、Notion、Airtable、CSV |

| 成本 | 免費(但耗時) | 免費方案,進階付費 |

適合用 Python 的情境:

- 需要高度自訂、複雜邏輯或要跟其他 Python 流程整合。

- 目標網站防爬措施比較弱。

適合用 Thunderbit 的情境:

- 追求速度、穩定、免設定。

- 目標網站複雜或常常改版。

- 不想處理代理、驗證碼或寫程式。

實戰教學:Python 無阻擋網頁爬蟲步驟

以下用抓商品資料為例,示範怎麼用最佳實踐避開封鎖。

1. 安裝必要套件

1pip install requests beautifulsoup4 fake-useragent2. 撰寫爬蟲腳本

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # 請換成你的網址

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # 擷取資料

16 print(soup.title.text)

17 else:

18 print(f"{url} 被封鎖或出錯:{response.status_code}")

19 time.sleep(random.uniform(2, 6)) # 隨機延遲3. 加入代理輪換(選用)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # 更多代理

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...其餘程式碼4. 處理 Cookie 跟 Session

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...其餘程式碼5. 常見問題排解

- 如果出現大量 403/429,請降低請求速度或更換代理。

- 遇到驗證碼,可以考慮用 Selenium 或第三方解碼服務。

- 請務必檢查網站的

robots.txt和服務條款。

結論與重點整理

用 Python 寫網頁爬蟲很強大,但隨著反爬技術進化,被封鎖的風險也越來越高。最有效的避開方式,就是結合技術最佳實踐(代理輪換、擬真標頭、隨機延遲、Session 管理、無頭瀏覽器)和對網站規則的尊重。

但有時候,再厲害的 Python 技巧也沒轍。這時候,像 這種 AI 工具就能派上用場——不用寫程式、抗封鎖、商業級穩定,讓你輕鬆取得想要的資料。

想體驗爬蟲有多簡單? 親自試試,或到我們的 看更多教學和技巧。

常見問答

1. 為什麼網站會封鎖 Python 網頁爬蟲?

網站封鎖爬蟲是為了保護資料、避免伺服器過載,也防止自動化濫用。如果 Python 腳本用預設標頭、不處理 Cookie、請求太頻繁,很容易被抓包。

2. Python 爬蟲怎麼有效避開封鎖?

建議用代理輪換、擬真 User-Agent 和標頭、隨機化請求間隔、管理 Cookie/Session,還有用 Selenium 或 Playwright 模擬人類行為。

3. Thunderbit 怎麼比 Python 腳本更能避開封鎖?

Thunderbit 透過 AI 自動適應網站版面、模擬真人瀏覽、處理子頁和分頁,能即時調整策略,大幅降低被封鎖風險,而且完全不用寫程式、也不用自己搞代理。

4. 什麼時候該用 Python,什麼時候該用 Thunderbit?

需要自訂邏輯、跟 Python 流程整合、或目標網站防爬弱時適合用 Python。如果追求快速、穩定、可擴展,或網站複雜、常變動、封鎖嚴格,建議用 Thunderbit。

5. 網頁爬蟲是否合法?

只要抓取公開資料,通常是合法的,但一定要遵守網站的服務條款、隱私政策和相關法規。千萬不要抓敏感或私人資料,務必以合乎道德、負責任的方式使用爬蟲。

想更聰明地抓資料?不妨試試 Thunderbit,讓封鎖成為過去式。

延伸閱讀:

- 用 Python 抓取 Google News:完整教學

- 打造 Best Buy 價格追蹤器(Python 範例)

- 14 種避開網頁爬蟲封鎖的方法

- 10 個不被封鎖的網頁爬蟲技巧