網頁爬蟲早就成為現代商業團隊的秘密武器,不管你是做銷售、營運,還是想隨時掌握競爭對手的動態,能自動從網站抓資料,已經是基本功。這幾年最大的變化,就是網頁越來越動態——像互動式儀表板、無限滾動、點了才會出現的內容,這些背後的推手就是 JavaScript,讓網頁前後台互動變得超靈活。

我自己長期在 SaaS 和自動化領域打滾,親眼看到 JavaScript 和 Node.js 從「加分技能」變成商業數據擷取的主力。數據會說話:,而全球網頁爬蟲市場預計到 2030 年都還會持續雙位數成長()。這篇指南會帶你了解用 JavaScript 和 Node.js 做網頁爬蟲的意義、優勢,還有——最重要的——就算你完全不會寫程式,也能靠 這類工具輕鬆上手。無論你有沒有技術底子,現在都是把網路雜亂資訊變成商業價值的黃金時機。

什麼是 JavaScript 網頁爬蟲?基礎概念解析

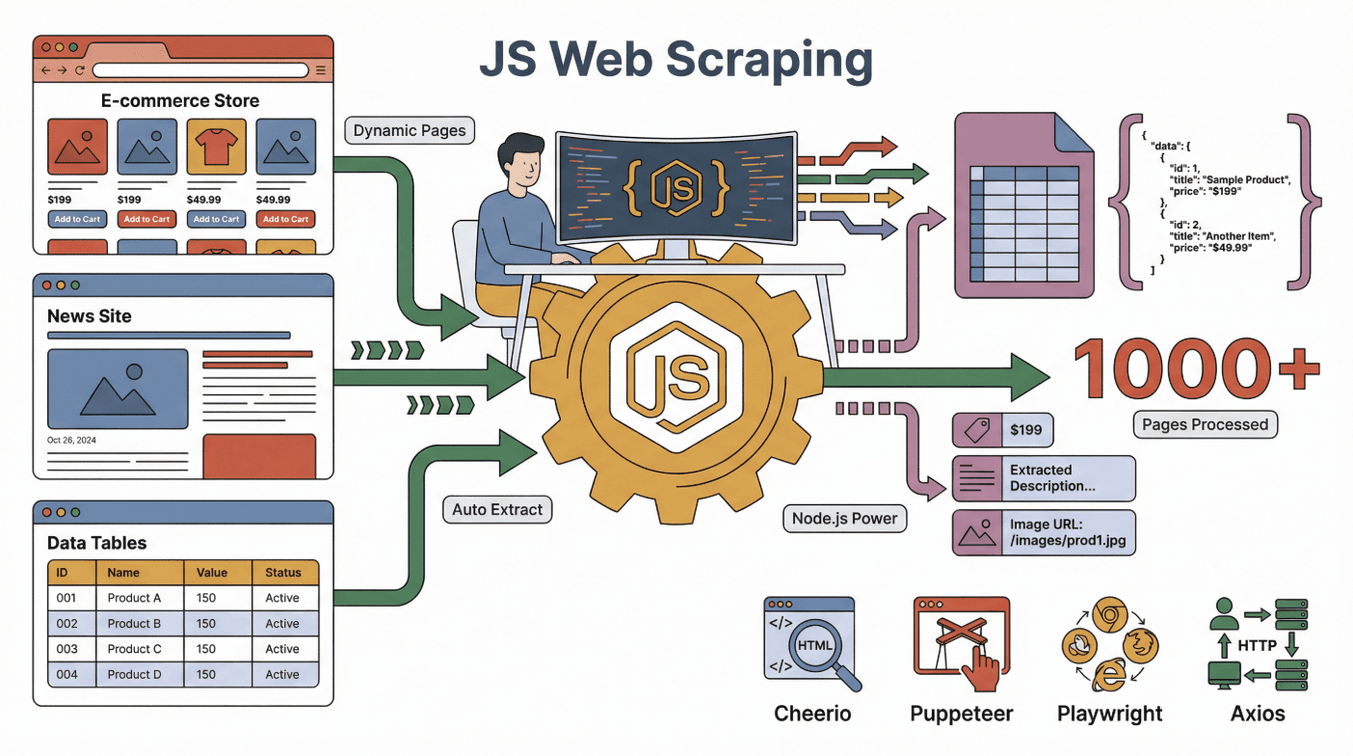

先從最基本的說明開始。用 JavaScript 做網頁爬蟲,就是利用 JavaScript(通常配合 Node.js)自動從網站抓資料。你可以想像有個數位小幫手,會自動幫你逛網站、讀頁面,把你要的資訊整理到表格裡——而且這個小幫手可以同時處理上千個頁面,永遠不喊累,還能自動點按鈕、填表單。

先從最基本的說明開始。用 JavaScript 做網頁爬蟲,就是利用 JavaScript(通常配合 Node.js)自動從網站抓資料。你可以想像有個數位小幫手,會自動幫你逛網站、讀頁面,把你要的資訊整理到表格裡——而且這個小幫手可以同時處理上千個頁面,永遠不喊累,還能自動點按鈕、填表單。

JavaScript 的厲害就在於它是瀏覽器建構和更新網頁的語言。Node.js 則讓你能在瀏覽器外面跑 JavaScript,進而自動化這些任務:

- 載入網頁(不管是動態還是互動式頁面)

- 自動點擊、滾動,或等內容載入

- 抓取頁面上的文字、圖片、價格、Email 等各種資料

常見的 JavaScript 網頁爬蟲工具有:

- : 適合解析靜態 HTML 頁面(有點像伺服器版的 jQuery)。

- : 自動化真實 Chrome 瀏覽器,專門對付需要互動的動態網站。

- : 跟 Puppeteer 類似,但支援更多瀏覽器自動化功能。

- : 發送 HTTP 請求,直接抓網頁或 API。

這些工具搭配起來最強大:Axios 或 Puppeteer 負責抓頁面,Cheerio 解析 HTML,Node.js 則統籌全局。

靜態 vs. 動態頁面:為什麼 JavaScript 這麼重要?

- 靜態頁面:內容固定,載入就看得到。用簡單工具就能抓。

- 動態頁面:內容要等 JavaScript 執行後才會顯示。這時就得靠 Puppeteer 這類瀏覽器自動化工具才能正確抓資料()。

現在大多數網站(像 Amazon、LinkedIn、Zillow)都用動態內容,JavaScript 型爬蟲已經是抓關鍵資料的標配。

為什麼選 JavaScript 來做網頁爬蟲?跟其他語言比有什麼優勢

在開發者圈常常會看到「JavaScript vs. Python vs. Ruby vs. Go」的爬蟲大亂鬥。根據我的實戰經驗,JavaScript 有幾個超明顯的優勢:

JavaScript 的超能力

- 原生支援動態內容:JavaScript 就是瀏覽器的語言,天生能搞定現代網頁的動態互動()。

- 瀏覽器自動化:Puppeteer、Playwright 能像真人一樣點、滾、填表單。

- 前端經驗直接轉用:如果團隊本來就會 JavaScript,學習門檻超低,技能直接複用()。

- 高併發與速度:Node.js 能同時處理大量任務,超適合大規模抓取()。

- 生態系超大:有一堆函式庫、教學和社群支援。

JavaScript 跟 Python、Ruby、Go 的比較

| 語言 | 動態內容支援 | 瀏覽器自動化 | 社群規模 | 速度 | 最適用情境 |

|---|---|---|---|---|---|

| JavaScript | 極佳 | 極佳 | 超大 | 快速 | 互動式網站、前端團隊 |

| Python | 良好(需搭配 Selenium/Playwright) | 良好 | 超大 | 快速 | API、靜態網站、數據分析 |

| Ruby | 普通 | 有限 | 小眾 | 中等 | 簡單靜態抓取 |

| Go | 有限 | 有限 | 成長中 | 非常快 | 大規模後端爬蟲 |

針對現代互動式網站,JavaScript(配 Node.js)通常是最強選擇()。Python 也很強,但遇到大量 JavaScript 動態內容時,還是 JavaScript 本身最順手()。

JavaScript 與 Node.js 網頁爬蟲的主力工具

來看看 JavaScript 爬蟲工具箱的主角:

- Node.js:讓 JavaScript 能在瀏覽器外執行,像指揮中心一樣。

- Cheerio:解析 HTML,像「幫我找出所有商品名稱」。

- Puppeteer/Playwright:自動化瀏覽器,搞定動態內容、登入、複雜互動。

- Axios/Fetch:直接抓網頁或 API。

- 其他輔助工具:像資料匯出(CSV、Excel)、代理伺服器、排程等。

它們怎麼分工? 可以把 Puppeteer 想成機器人瀏覽器,Cheerio 是資料偵探,Node.js 則是專案經理,確保每個環節都順利。

JavaScript 網頁爬蟲的運作流程:步驟解析

來拆解一下典型的 JavaScript 網頁爬蟲流程:

- 發送請求:用 Axios 或 Puppeteer 載入網頁。

- 等待內容載入:如果是動態頁面,要等 JavaScript 執行完(Puppeteer 能「看到」最終頁面)。

- 擷取資料:用 Cheerio 或瀏覽器 API 選取並複製需要的資料。

- 處理分頁/子頁面:自動點「下一頁」或跟連結抓更多資料。

- 匯出資料:把結果存成 CSV、Excel、Google Sheets 或資料庫。

比喻一下: 就像派一個超強實習生跑遍每個頁面,做筆記,最後整理成表格。

靜態 vs. 動態內容:差在哪?

- 靜態網站例子:部落格文章都直接寫在 HTML 裡。Cheerio + Axios 就能搞定。

- 動態網站例子:電商網站價格要滾動後才會顯示。這時就要用 Puppeteer 或 Playwright 來「看到」最終價格()。

小提醒: 如果爬蟲抓到空白頁,通常就是遇到動態內容——該換 Puppeteer 上場了。

Thunderbit:結合 JavaScript 強大功能的無程式碼網頁爬蟲

這裡是重點,尤其對非工程師來說。Thunderbit 的目標,就是讓每個人都能用上 JavaScript 級的網頁爬蟲威力,不再只屬於技術人。

我們的理念: 你的網頁爬蟲應該像實習生一樣「聽得懂任務」——你只要描述需求,AI 就會自動搞定技術細節。

Thunderbit 怎麼讓每個人都能用 JavaScript 爬蟲?

- AI 智能欄位建議:只要點一下,Thunderbit 的 AI 就會自動掃描頁面、推薦可抓的資料,還幫你設定好爬蟲。

- 子頁面自動抓取:需要更細的資料?Thunderbit 能自動進入每個子頁(像商品或個人頁),自動補齊表格。

- 即用範本:熱門網站(Amazon、Zillow、Shopify)直接選範本就能開抓,完全不用設定。

- 免費資料匯出:資料可直接匯出到 Excel、Google Sheets、Airtable 或 Notion,完全免費。

真實案例: 很多銷售團隊用 Thunderbit,幾個點擊就能從動態名錄抓下數百筆潛在客戶,連 Email、電話都一併帶走——完全不用寫程式,效率超高。就像團隊裡多了一位 JavaScript 工程師,還不用面試。

熱門應用場景:JavaScript 網頁爬蟲在銷售與營運的實戰

JavaScript 網頁爬蟲不只是技術人的專利。以下是各類團隊的日常應用:

| 團隊 | 應用場景 | 成效 |

|---|---|---|

| 銷售 | 從名錄自動擷取潛在客戶 | 潛在名單數量提升 10 倍,直接匯入 CRM |

| 電商 | 競品價格監控 | 動態調價,市場反應更快 |

| 營運 | 庫存整合 | 跨供應商 SKU 一覽無遺 |

| 房地產 | 物件資訊彙整 | 最新市場數據一表掌握 |

| 行銷 | 評論與情感分析 | 快速洞察,精準投放行銷 |

案例分享: 有電商團隊表示,利用 Thunderbit 抓競品價格,每週省下 20 小時以上,能即時調整自家價格()。

JavaScript 網頁爬蟲的法律與道德考量

來聊聊大家最在意的問題:網頁爬蟲到底合不合法? 簡單說,只要抓的是公開資料、遵守網站規範,通常沒問題()。但還是有幾個重點:

- 遵守 robots.txt:網站如果明確禁止爬蟲,千萬別硬抓。

- 遵守服務條款:有些網站明文禁止自動抓取。

- 重視隱私:不要收集或濫用個人資料。

- 避免過度請求:抓取速度要適當,別讓伺服器吃不消。

近年法院多傾向支持公開資料的爬取,但著作權和隱私法還是要遵守()。有疑慮時,建議找法律專家問問。

最佳做法: 只抓你願意公開分享的資料,並標註資料來源。

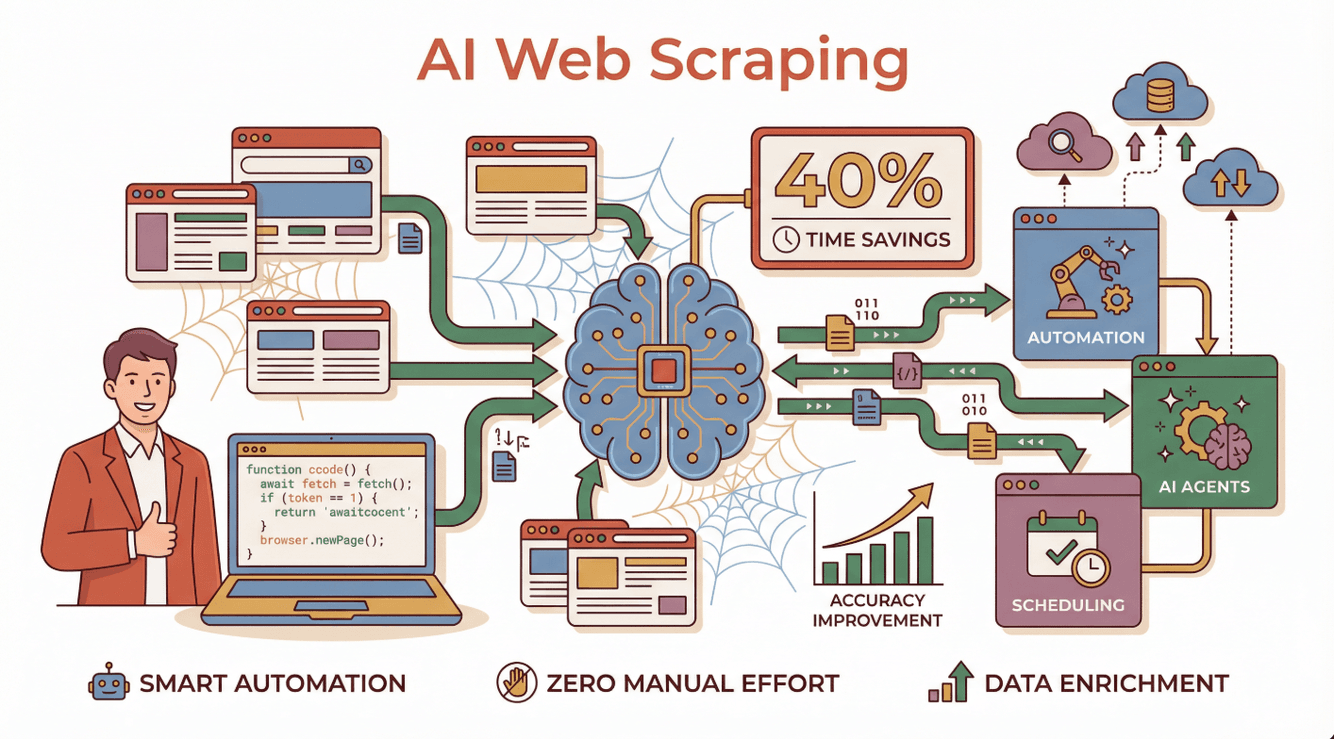

JavaScript 網頁爬蟲的未來:AI 與自動化新時代

未來已經來臨。AI 正在把網頁爬蟲從繁瑣、重程式碼的工作,變成智慧自動化流程。導入 AI 的企業回報 ,準確率更高,連最複雜的動態網站也能輕鬆搞定()。

未來已經來臨。AI 正在把網頁爬蟲從繁瑣、重程式碼的工作,變成智慧自動化流程。導入 AI 的企業回報 ,準確率更高,連最複雜的動態網站也能輕鬆搞定()。

實際應用會長什麼樣?

- AI 智能代理:能用自然語言理解指令,遇到網站變動自動調整,還能自我修正錯誤()。

- 自動排程:每天自動更新資料,完全不用手動。

- 資料增強:AI 可即時分類、摘要、甚至翻譯抓到的資料。

Thunderbit 正站在這波浪潮最前線,讓任何人都能打造並運行 AI 驅動的網頁爬蟲——不用寫程式、不用維護。

想更了解 AI 網頁爬蟲的未來? 歡迎參考我們的詳細指南:。

新手入門:商業用戶實用建議

想試試用 JavaScript(或 Thunderbit 的無程式碼方式)做網頁爬蟲?這裡有幾個入門步驟:

- 明確目標:你到底要什麼資料?要拿來幹嘛?

- 選擇工具:有技術底就用 Node.js + Puppeteer 或 Cheerio;沒經驗就,讓 AI 幫你搞定。

- 從小規模開始:先測幾個頁面,確認流程順不順。

- 匯出與分析:把資料匯進 Google Sheets、Excel 或 Notion 分析。

- 遵守道德規範:重視隱私、服務條款和抓取頻率。

想學更多? 可以參考 的新手教學,或加入 Stack Overflow、Reddit r/webscraping 等社群找幫手。

結語:用 JavaScript 網頁爬蟲釋放商業價值

總結一下,JavaScript 和 Node.js 已經是現代網頁爬蟲的主力,特別適合動態、互動性高的網站。不管你是開發者還是商業用戶,結合瀏覽器自動化、龐大生態系和 AI 工具,都能更快、更精準地拿到你要的資料。

有了像 這種無程式碼解決方案,你甚至不用寫一行程式碼,就能享受 JavaScript 級的爬蟲威力。只要描述需求、點幾下,資料就自動整理好,無論是分析、開發名單還是其他商業應用都能馬上啟動。

如果你準備好把網路雜訊變成有價值的洞察,現在就是最佳時機。祝你爬蟲順利,資料乾淨合規,永遠領先對手!

常見問答

1. 什麼是 JavaScript 與 Node.js 網頁爬蟲?

就是用 JavaScript 程式碼(通常跑在 Node.js 環境)自動從網站抓資料。這種方式特別適合需要 JavaScript 動態載入內容的網站。

2. 為什麼 JavaScript 比 Python 或 Ruby 更適合抓動態網站?

JavaScript 是瀏覽器渲染和更新網頁的語言,能更自然地跟動態內容互動。Puppeteer、Playwright 這些工具可以自動操作真實瀏覽器,讓抓取依賴 JavaScript 的網站變得超簡單。

3. 非技術人員可以用 JavaScript 做網頁爬蟲嗎?

當然可以。像 這種無程式碼工具,讓每個人都能用自然語言描述需求,AI 自動處理技術細節。

4. 網頁爬蟲是否合法?

一般來說,抓公開資料是合法的,但一定要遵守網站服務條款、robots.txt 和隱私法規。不要未經授權抓個人或受版權保護的資料。

5. AI 如何改變 JavaScript 網頁爬蟲?

AI 讓網頁爬蟲更聰明、更好用。它能自動適應網站變動、處理錯誤,甚至即時處理和增強資料——大幅省時又提升準確率。Thunderbit 就是這波 AI 驅動爬蟲的領頭羊。

想獲得更多教學和技巧,歡迎逛逛 或訂閱我們的 。

延伸閱讀