如果你有在終端機裡摸索過,肯定對 cURL 這個工具不陌生。它就像網路世界的瑞士刀——默默地安裝在全球數十億台裝置上,隨時待命幫你抓資料、發送請求或除錯任何帶有 URL 的資源。根據 cURL 創辦人的估算,。沒看錯,真的是兩百億次。

那為什麼到了 2025 年,開發者甚至不少商業人士還是愛用 cURL?現在不是有一堆新穎又 AI 加持的爬蟲工具嗎?其實,有時候我們只想快速搞定事情——簡單、可自動化、沒負擔。這篇指南會帶你了解 cURL 網頁爬蟲為什麼還是很重要、什麼情境下最適合用 cURL、怎麼高效運用它,以及如何結合 ,讓你的資料擷取流程直接升級到新世代。

為什麼 2025 年還是要用 cURL 網頁爬蟲?

老實說:我真的很愛 cURL。只要打一行指令,資料就像流水一樣湧進來,超有成就感。而且我不是唯一的粉絲。根據 ,去年受訪人數暴增 28%,Stack Overflow 上也有超過 標註「curl」。開發者們都說它「經典耐用」、「超強」、「網路請求的共同語言」。即使新工具層出不窮,cURL 也不斷進化——現在甚至支援 HTTP/3。

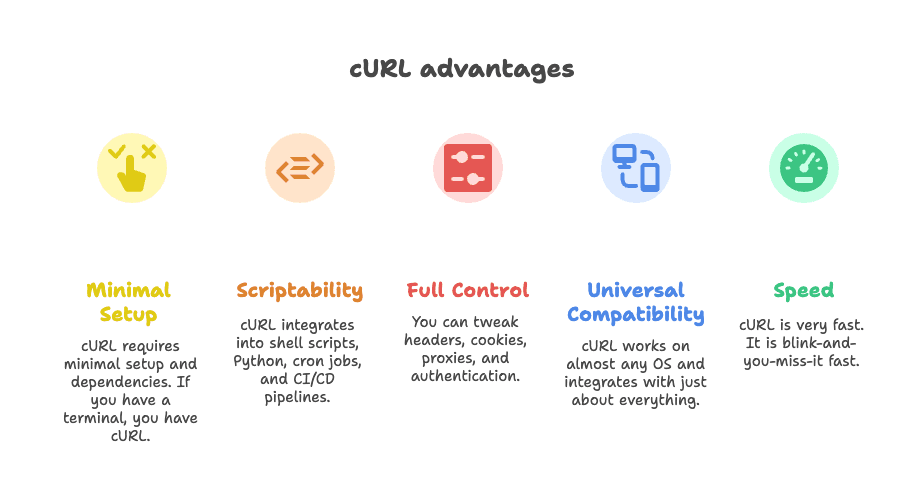

那 cURL 為什麼能在網頁爬蟲領域屹立不搖?

- 極簡安裝: 幾乎所有終端機都內建 cURL,完全不用再裝一堆套件。

- 高度自動化: 輕鬆嵌入 shell script、Python、排程任務或 CI/CD 流程。

- 完全掌控: 標頭、Cookie、代理、認證……你想怎麼調整都行。

- 跨平台相容: 幾乎所有作業系統都支援,整合性超高。

- 速度快: 執行效率極高,幾乎一瞬間就完成。

有開發者這樣說:「你想做的事,cURL 幾乎都能辦到。」()

cURL 網頁爬蟲的最佳應用場景:什麼時候該選 cURL?

說實話,cURL 並不是所有爬蟲需求的萬靈丹。但在某些情境下,它真的無可取代。以下是 cURL 最擅長的幾種情境:

1. 抓取 REST API 的 JSON 資料

現在很多網站內容都是透過背景 API 載入的。只要找到正確的 API 端點(小撇步:用瀏覽器的 Network 面板觀察),cURL 一行指令就能把 JSON 抓下來。超適合快速取數、API 測試或自動化腳本整合。

2. 擷取靜態或結構明確的網頁資料

如果你要的資料直接寫在 HTML 裡(像新聞、目錄、商品分類頁),cURL 可以瞬間下載。再搭配 grep、sed 或 jq 做簡單解析。

3. 除錯與重現複雜的 HTTP 請求

需要模擬登入、測試 webhook、或除錯 API?cURL 讓你直接操作所有標頭、Cookie、Payload。想看底層發生什麼,cURL 絕對是開發者的首選。

4. 快速嵌入腳本自動化

cURL 很適合嵌入 shell、Python,甚至 Zapier webhook。很多自動化流程的背後,其實就是靠 cURL 串接。

這張表快速總結 cURL 的適用與限制:

| 應用情境 | cURL 優勢 | 限制 | 替代方案 |

|---|---|---|---|

| 抓取 JSON API | 快速、可自動化、支援標頭/Token | 無內建 JSON 解析,複雜認證需手動處理 | Python Requests、Postman、Thunderbit |

| 靜態 HTML 頁面 | 輕量、易與 CLI 工具整合 | 無 HTML 解析、無法處理 JavaScript | Scrapy、BeautifulSoup、Thunderbit |

| 需 Session 認證的爬蟲 | 可處理 Cookie、標頭、基本認證 | 多步驟登入繁瑣、不支援 JS | Requests sessions、Selenium、Thunderbit |

| Shell/Python 整合 | 通用、可嵌入任何腳本 | 解析與錯誤處理需手動 | 原生 HTTP 函式庫、Thunderbit |

想深入了解各種情境,推薦參考。

2025 年必學的 cURL 網頁爬蟲技巧

接下來進入實戰,分享幾個 2025 年最實用的 cURL 技巧。

設定標頭與 User-Agent

很多網站會封鎖預設的 cURL 請求。要偽裝成一般瀏覽器,記得加上真實的 User-Agent 和必要標頭:

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/data或一次加多個標頭:

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/data標頭偽裝常常是能否成功抓取的關鍵。更多細節可參考 。

處理 Cookie 與 Session

需要登入或維持會話?用 cURL 的 cookie jar:

1# 登入並儲存 Cookie

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# 之後請求帶上 Cookie

4curl -b cookies.txt https://example.com/dashboard也可以直接傳遞 Cookie:

1curl -b "SESSIONID=abcd1234" https://example.com/page如果遇到重導(像登入後跳轉),加上 -L 保持 Cookie 有效。

使用代理避免封鎖

遇到 IP 被封?讓請求走代理:

1curl --proxy 198.199.86.11:8080 https://target.com要輪換代理,可以寫腳本讓 cURL 輪流用不同代理。不過免費代理常常不穩,連不上別怪 cURL。

儲存與解析回應內容

cURL 只給你原始資料。要進一步處理,可搭配 CLI 工具:

-

JSON 處理: 用

jq美化或擷取欄位。1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

HTML 處理: 用

grep或sed抓簡單內容。1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

複雜解析: 可用

htmlq(支援 CSS 選擇器),或直接用 Python + BeautifulSoup。

想看 cURL 搭配 jq 的實戰,推薦 。

cURL 認證與流量控制技巧

認證方式:

-

基本認證:

1curl -u username:password https://api.example.com/data -

Bearer Token:

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

Session Cookie: 用上面

-c、-b參數即可。

遇到更複雜的認證(像 OAuth),就得自己寫流程,cURL 雖然能做,但難度比較高。

流量控制與重試:

-

加延遲:

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # 隨機延遲 2-4 秒 4done -

自動重試:

1curl --retry 3 --retry-delay 5 https://example.com/data

記得要有禮貌,不要狂轟伺服器,也要注意 429 Too Many Requests 回應。

cURL 網頁爬蟲的限制:你必須知道的事

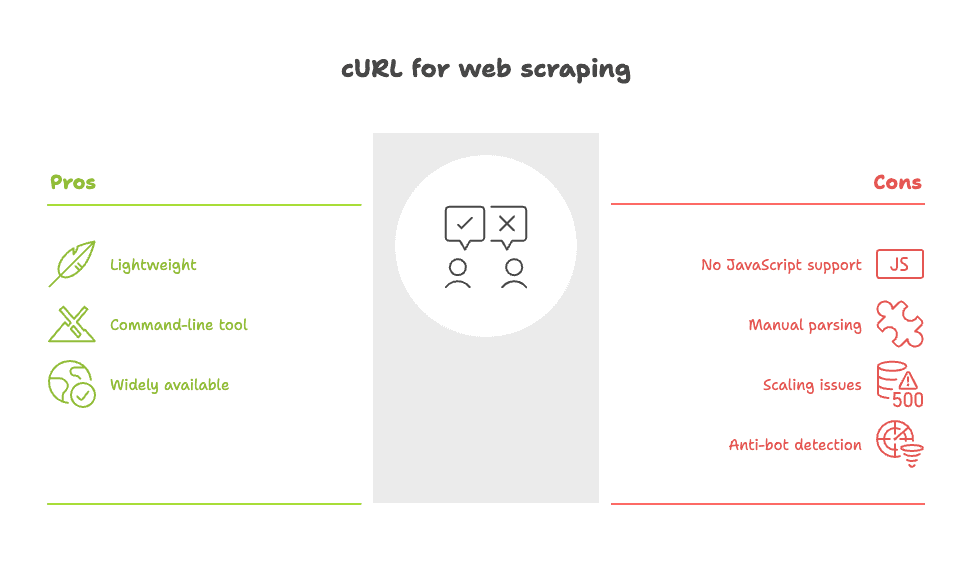

該來點真心話了。雖然我很愛 cURL,但它並非萬能。以下是它的幾個明顯短板:

- 無法處理 JavaScript: cURL 只抓原始 HTML,動態載入的資料它看不到。這時只能找 API 或改用瀏覽器型工具。

- 解析全靠自己: 拿到的是原始 HTML/JSON,結構化資料得靠你自己寫腳本處理。

- 大規模爬蟲難度高: 要抓數百、數千頁時,錯誤處理、重試、資料清洗都很麻煩。

- 容易被反爬蟲偵測: 很多網站能輕易識別 cURL 的網路特徵,即使偽裝標頭也常被擋下。

有 Reddit 用戶說得很直白:「簡單爬蟲用 curl 或 wget 就夠,但遇到複雜網站會很痛苦。」()

想看完整的痛點分析,推薦 。

讓 Thunderbit 為你的 cURL 網頁爬蟲加速

如果你想要 cURL 的速度與彈性,但又不想手動處理資料,那就該試試 。

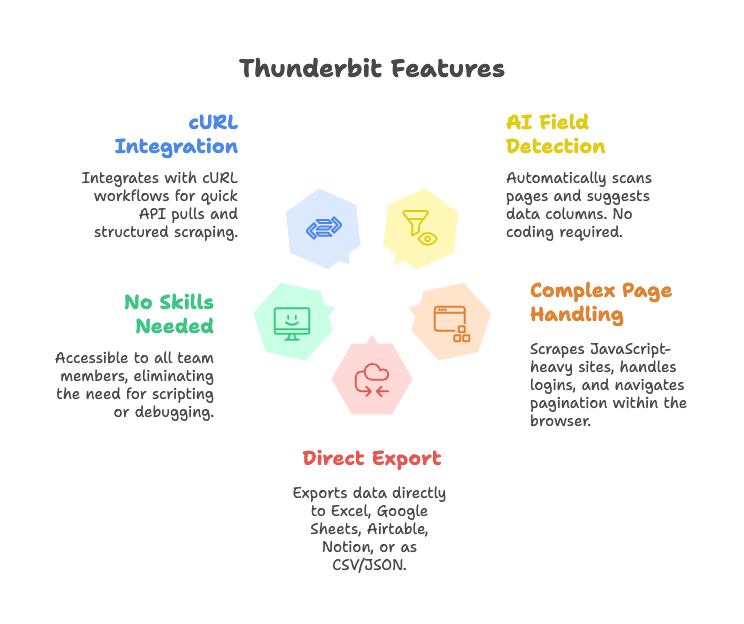

Thunderbit 是一款 AI 驅動的網頁爬蟲 Chrome 擴充功能,讓資料擷取變得超簡單。它怎麼補足 cURL 的不足?

- AI 欄位自動偵測: 一鍵「AI 建議欄位」,Thunderbit 會自動掃描頁面、建議欄位並結構化資料,完全不用寫選擇器或程式碼。

- 支援複雜網頁: Thunderbit 在瀏覽器內運作,能抓取 JavaScript 動態頁面、處理登入、甚至自動點擊分頁。

- 直接匯出: 資料可一鍵匯出到 Excel、Google Sheets、Airtable、Notion,或下載成 CSV/JSON。

- 零技術門檻: 團隊任何人都能用,完全不需寫程式或調整 HTTP 標頭。

- 可與 cURL 流程整合: 開發者可用 cURL 快速測試 API,正式抓取時再用 Thunderbit 結構化資料。

想看 Thunderbit 實際運作,歡迎安裝我們的 ,或瀏覽 了解更多應用案例。

Thunderbit + cURL:企業團隊的實戰組合

來點實際案例,看看團隊怎麼結合 cURL 與 Thunderbit,創造商業價值:

1. 快速市場調查

- 先用 cURL 測試競爭對手網站是否有公開 API 或靜態 HTML。

- 有的話,寫個腳本快速抓快照。

- 要深入分析(像多頁商品列表),就交給 Thunderbit——AI 自動偵測欄位、處理分頁、匯出到 Sheets 立即分析。

2. 潛在客戶名單收集

- 用 cURL 從簡單目錄 API 抓聯絡資訊。

- 複雜網站(像 LinkedIn 型錄、房仲網)則用 Thunderbit 抓姓名、Email、電話、圖片等,完全不用手動解析。

3. 監控商品列表或價格

- 用 cURL 定時抓 REST API 查價。

- 沒有 API 的網站,交給 Thunderbit 自動爬取、結構化資料,並推送到 Airtable 或 Notion 給營運團隊。

流程圖大致如下(腦中想像小人與箭頭):

1[瀏覽器/終端機] --(cURL 測試)--> [快速取數]

2 |

3 v

4[Thunderbit Chrome 擴充] --(AI 擷取)--> [結構化資料] --> [Sheets/Airtable/Notion]Thunderbit 與手寫 cURL 腳本的優勢對比

直接比較給你看:

| 功能 | Thunderbit(人工智慧網頁爬蟲) | cURL(命令列工具) |

|---|---|---|

| 上手時間 | 點選操作,AI 自動偵測欄位 | 需手動寫腳本,懂 HTML 結構 |

| 易用性 | 任何人都能用,視覺化回饋 | 只限命令列,學習曲線高 |

| 結構化輸出 | 有——表格、欄位、可匯出到 Sheets/CRM | 原始 HTML/JSON,需手動解析 |

| 支援動態頁面 | 有——瀏覽器內運作,支援 JS、分頁 | 無——僅抓靜態 HTML |

| 維護成本 | 低——AI 自動適應網站變動,易更新 | 高——網站變動腳本易壞 |

| 整合性 | 內建匯出到商業工具 | 需自寫整合程式 |

| 多語言/翻譯 | 有——AI 可自動翻譯與欄位標準化 | 無——全靠手動 |

| 擴展性 | 適合中小型任務 | 大型任務可寫腳本批次處理 |

| 成本 | 免費方案,付費約 $9/月起 | 免費,但需投入開發時間 |

想看更詳細比較,歡迎參考我們的。

Thunderbit 的 AI 智能設計,讓你少寫腳本、多拿成果。不論你是開發者還是商業用戶,這都是最快將網頁資料轉化為商業價值的方式。

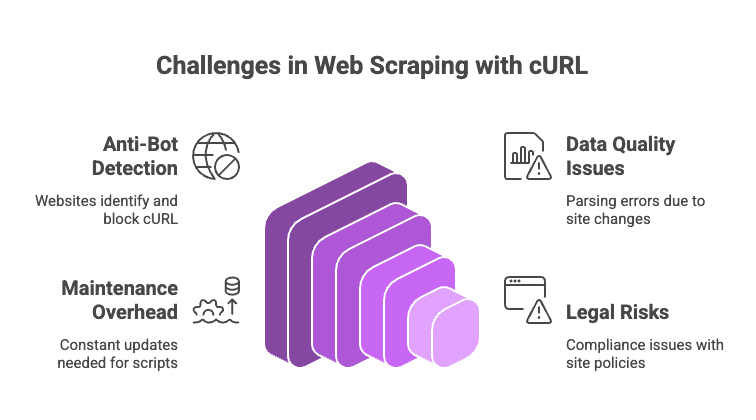

cURL 網頁爬蟲的挑戰與陷阱

2025 年的網頁爬蟲並非一帆風順,以下是常見風險與避雷建議:

- 反爬蟲機制: Cloudflare、Akamai、DataDome 等服務能輕易識別 cURL,即使偽裝標頭也常被擋。遇到 CAPTCHA,cURL 完全沒轍。

- 資料品質與一致性: 用 regex 或 grep 解析 HTML 很脆弱,網站結構一變腳本就壞。

- 維護負擔: 網站每次改版,你都得重寫選擇器或解析邏輯。

- 法律與合規風險: 務必檢查網站的服務條款與隱私政策。能抓不代表該抓。

實用建議:

- 遇到封鎖時,輪換 User-Agent 與 IP。

- 請求間加隨機延遲。

- JSON 用

jq,HTML 用htmlq處理。 - 動態或受保護網站,建議改用 Thunderbit 或爬蟲 API。

想看完整避雷清單,推薦 。

結論:2025 年如何選擇最適合的網頁爬蟲工具?

我的建議是:cURL 依然是快速、精準抓取 API、靜態頁面或除錯的最佳利器。想測試網站能不能抓,cURL 最快。

但只要你需要結構化資料、動態內容或團隊協作,該換上更強大的工具了。 讓你省去手動解析、輕鬆處理複雜網站,資料一鍵送到你要的地方。

所以,根據需求選工具。小型、可腳本化的任務用 cURL,規模大、內容動態或團隊需求就交給 Thunderbit。

常見問題:2025 年用 cURL 網頁爬蟲 Q&A

1. cURL 能抓 JavaScript 動態內容嗎?

沒辦法。cURL 只會下載原始 HTML,動態載入的資料抓不到。這時要找 API 或用 Thunderbit 這類瀏覽器型工具。

2. 用 cURL 爬蟲怎麼避免被封鎖?

設置真實的標頭(User-Agent、Accept)、輪換 IP 與 User-Agent、加延遲、重複使用 Cookie。遇到強力反爬(像 Cloudflare),可試試 ,或改用無頭瀏覽器或爬蟲 API。

3. 如何把 cURL 輸出轉成結構化資料?

JSON 可用 jq 處理,HTML 可用 grep、sed 或 htmlq。複雜情境建議用 Python + BeautifulSoup,或直接用 Thunderbit 讓 AI 幫你自動擷取。

4. cURL 適合大規模爬蟲嗎?

可以,但你得自己處理重試、錯誤、代理、資料清洗等。大規模任務通常用 Scrapy 這類框架或瀏覽器型工具更有效率。

5. Thunderbit 如何優化傳統 cURL 爬蟲?

Thunderbit 會自動偵測欄位、支援動態頁面、管理 Session 與分頁,並直接匯出結構化資料到商業工具。完全不用寫程式、選擇器,也不用擔心維護。

想讓爬蟲更輕鬆,歡迎試用 ,或直接安裝 ,體驗 AI 如何提升你的工作效率。

如果你還是最愛終端機和閃爍的游標?放心,cURL 依然會陪你很久。只是記得善待伺服器,也別忘了請辛苦的系統管理員喝杯咖啡。

想獲得更多網頁爬蟲、自動化與 AI 生產力秘訣?歡迎追蹤 ,掌握最新教學與洞見。