你有沒有試過盯著某個網站,心裡想:「如果能一鍵把這些有用的資料全都抓下來,直接丟進 Excel,那該有多爽!」而不是傻傻地花一下午在那邊複製貼上?放心,這種想法絕對不是你一個人的專利。到了 2025 年,資料爬取早就不是宅宅的專利,而是各行各業都要會的基本功。不管你是業務要找潛在客戶,還是電商經理要盯競品價格,大家都想要快速把網路上的資料抓下來。好消息是:Python 讓爬蟲變得超簡單又親民,就算你唯一寫過的程式是改 MySpace 背景,也能輕鬆上手。

這篇教學會帶你用 Python 一步步實作資料爬取,從基本觀念、靜態與動態網站的處理,到怎麼結合 這款 AI 網頁爬蟲,打造更高效的自動化流程。不管你是完全新手,還是想升級資料處理能力,都能在這裡找到實用技巧、範例程式碼,還有我多年 SaaS 跟自動化的精華心得。

什麼是網頁爬取?為什麼大家都愛用 Python?

先來聊聊基本。網頁爬取就是自動化地從網站上把資訊抓下來。簡單說,就是教電腦「看」網頁,把你要的內容(像商品價格、新聞標題、聯絡方式等)自動撈下來,省去人工整理的麻煩(參考 )。企業會用資料爬取來做即時競品監控、市場調查、名單蒐集,甚至訓練 AI 模型(參考 )。

那為什麼Python會是爬蟲界的霸主?首先,它語法直白、超好讀,對新手超級友善。更重要的是,Python 有超強大的生態系:requests、BeautifulSoup、Scrapy、Selenium、pandas 等函式庫,從抓網頁、解析 HTML 到資料清理、匯出,通通一條龍。難怪有大約 。

為什麼用 Python 做網頁爬取?

我玩過不少語言,但說到資料爬取,Python 永遠是新手跟進階用戶的首選。原因很簡單:

- 簡單易懂: Python 語法超直觀,寫爬蟲腳本不容易出錯,debug 也很方便(參考 )。

- 函式庫超齊全: requests(HTTP 請求)、BeautifulSoup(HTML 解析)、Scrapy(大規模爬取)、Selenium(瀏覽器自動化)、pandas(資料分析)等,爬蟲每個環節都包辦(參考 )。

- 社群超活躍: Python 有超多開發者,遇到問題幾乎都能在網路上找到解法。

Python 跟其他方案比起來怎麼樣?這裡有個簡單比較:

| 方法 | 優點 | 缺點 |

|---|---|---|

| Python | 容易學、函式庫多、資料分析強、彈性高 | 要寫程式、遇到大量 JavaScript 網站要額外工具 |

| JavaScript/Node | 原生支援動態內容、非同步友善、跟前端語言一致 | 學習曲線較陡、爬蟲專用函式庫較少、語法對新手較繁瑣 |

| R (rvest) | 適合研究、跟 R 資料分析整合方便 | 生態系較小、對動態網站支援有限 |

| 無程式碼工具 | 不用寫程式、快速上手、AI/視覺化輔助(如 Thunderbit) | 客製化彈性有限、用量有上限、細節控制較少 |

(參考 、)

對大多數商業用戶和資料愛好者來說,Python 真的就是威力、彈性、親和力三合一的最佳選擇。

Python 環境建置:資料爬取前的暖身

要開始爬資料,先把 Python 環境搞定。別擔心,這比組 IKEA 家具還簡單。

1. 安裝 Python:

去 下載最新版 Python 3。Windows 記得勾「Add Python to PATH」。Mac 可以用 Homebrew(brew install python3)。Linux 通常已內建,沒的話用 apt install python3 python3-pip(參考 )。

2.(建議)建立虛擬環境:

讓每個專案的函式庫互不干擾。在專案資料夾下:

1python -m venv venv

2# 啟動虛擬環境:

3# Windows:

4venv\Scripts\activate

5# Mac/Linux:

6source venv/bin/activate3. 安裝常用函式庫:

打開終端機輸入:

1pip install requests beautifulsoup4 pandas selenium lxmlrequests:發送 HTTP 請求beautifulsoup4:解析 HTMLpandas:資料處理與匯出selenium:動態網站用(選用)lxml:高效 HTML/XML 解析

4. 選擇程式編輯器:

- (加裝 Python 擴充套件):輕量、熱門、適合新手。

- :功能完整,專為 Python 設計。

- :互動式,適合資料分析與實驗(參考 )。

5.(Selenium 用)安裝 WebDriver:

Selenium 需要瀏覽器驅動(像 ChromeDriver)。最簡單的方式是裝 webdriver_manager:

1pip install webdriver-manager腳本這樣寫:

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))小提醒:如果 pip 指令不能用,請確認 Python 有加到 PATH,虛擬環境也有啟動。

靜態網站爬取教學:Python 實戰流程

靜態網站是爬蟲新手的最佳起點。只要你在瀏覽器「檢視原始碼」能看到資料,就能用 Python 抓下來。

這裡用 當練習:

步驟 1:抓網頁內容

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200 代表成功步驟 2:解析 HTML

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")步驟 3:擷取資料

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")步驟 4:處理分頁

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)這樣就能一次抓下多頁資料並存成 CSV 檔,是不是超簡單?(參考 )

小提醒: 開始爬之前,記得先看網站的 robots.txt 跟服務條款,還有適度延遲請求(像 time.sleep(1)),不要給人家伺服器添麻煩。

動態網站爬取:用 Selenium 處理 JavaScript 網頁

有些網站的資料要等 JavaScript 執行後才會出現(像無限捲動、彈窗、互動式儀表板等),這時就要用 Selenium 這種能模擬瀏覽器操作的工具。

步驟 1:啟動瀏覽器

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")步驟 2:等待內容載入

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)步驟 3:自動捲動或點擊載入更多

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_height步驟 4:擷取資料

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})步驟 5:儲存與結束

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()小技巧:

- 用

WebDriverWait明確等元素出現,才不會抓不到資料(參考 )。 - 想無頭運行(不開視窗),可以加

options.headless = True。 - 如果網站有 API,直接用 requests 抓 JSON,速度更快。

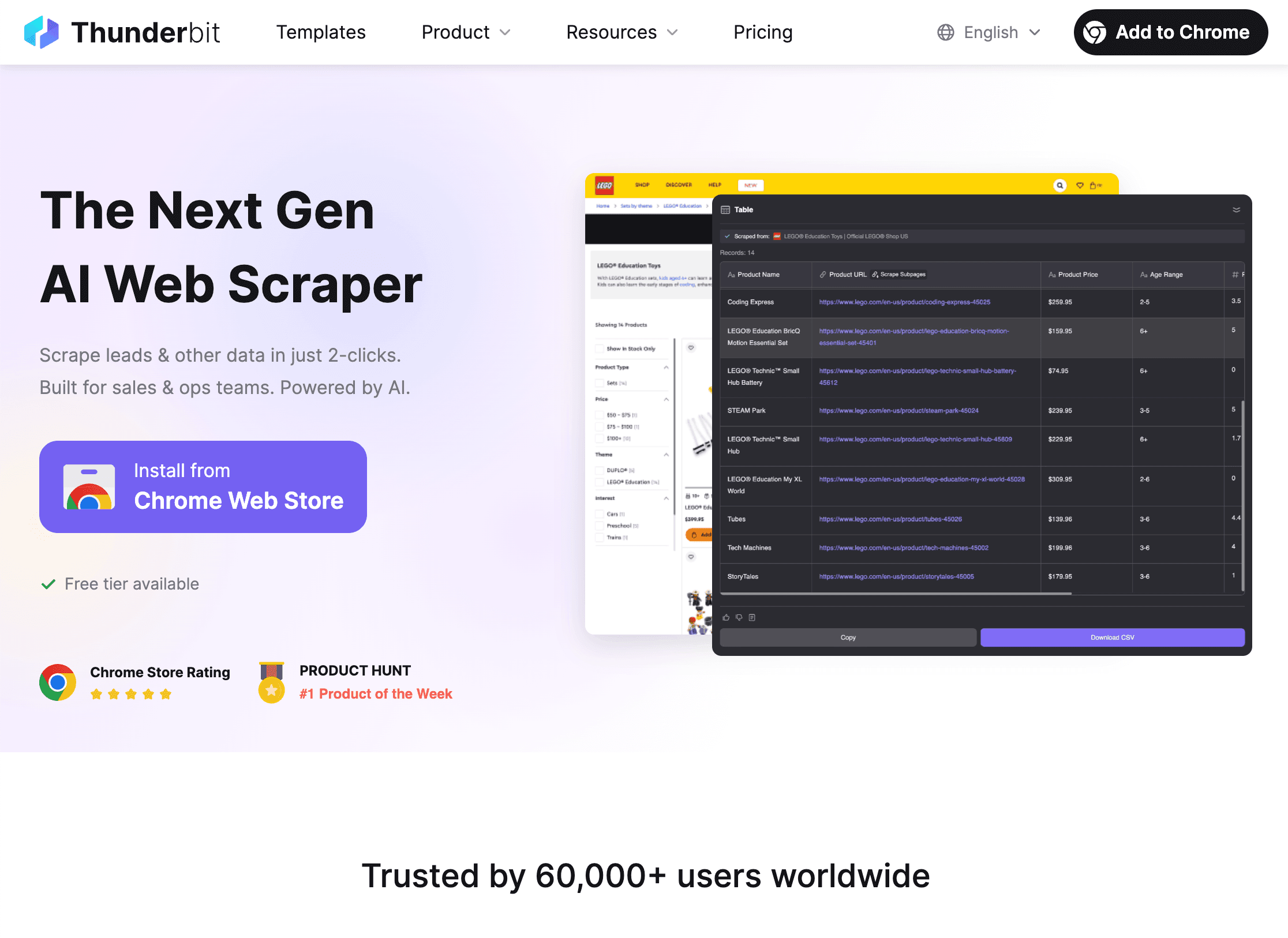

Thunderbit 結合 Python:打造高效資料自動化

有時候,就算你 Python 函式庫用到飛天,遇到結構複雜或很難搞的網站還是會頭大。這時, 就是你的救星。

Thunderbit 是一款 AI 驅動的 Chrome 網頁爬蟲擴充功能,讓你用滑鼠點一點就能抓任何網站資料,完全不用寫程式。對需要即時資料的商業用戶來說超方便,而且還能跟 Python 無縫整合,打造進階自動化流程。

Thunderbit + Python 的強大組合:

Thunderbit + Python 的強大組合:

-

用 Thunderbit 抓資料:

- 開啟 。

- 點「AI 建議欄位」,讓 Thunderbit AI 自動判斷要抓哪些資料。

- 分頁、子頁、圖片、PDF 都能一鍵搞定。

- 資料可直接匯出成 CSV、Excel、Google Sheets、Notion 或 Airtable。

-

用 Python 分析與清理資料:

- 用 pandas 載入匯出的檔案:

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - 之後就能做篩選、清理、合併、視覺化或進階分析。

- 用 pandas 載入匯出的檔案:

-

自動化流程:

- Thunderbit 支援排程爬取,每天自動更新資料。

- 結合 Python 腳本自動產生報表、發送通知或進一步處理。

為什麼要兩者搭配? Thunderbit 幫你省下大量寫程式和 debug 的時間,特別適合處理複雜或臨時性的爬取需求。Python 則讓你能進行資料清理、分析與自動化整合。兩者合體,效率直接翻倍!(參考 )

Python 網頁爬取常見難題與解法

爬蟲路上一定會遇到各種狀況,這裡整理常見問題跟解法:

1. 被封鎖(403/429 錯誤、驗證碼):

- 換 User-Agent 模擬真實瀏覽器。

- 用代理伺服器輪換 IP(參考 )。

- 請求間加延遲(

time.sleep())。 - 遵守 robots.txt 跟 crawl-delay。

- 遇到驗證碼可用 Selenium 手動處理,或考慮第三方解碼服務。

2. 動態內容抓不到:

- 用 Selenium 讓瀏覽器執行 JavaScript。

- 在瀏覽器網路面板找 API,直接抓 JSON。

3. 登入或 Session 問題:

- 用

requests.Session()維持 cookie。 - 需要登入時可用 Selenium 自動操作。

4. 網站結構變動:

- 選穩定的選擇器(ID 比 class 穩)。

- 定期檢查並更新腳本。

- Thunderbit 的 AI 可自動適應版面變化,減少維護負擔。

5. 大量資料處理:

- 用

concurrent.futures或asyncio提升效率。 - 分批寫入檔案或資料庫,避免記憶體爆掉。

(參考 、)

除錯與優化:讓爬蟲腳本更穩

遇到問題時,可以參考這份快速檢查清單:

- HTTP 404/403/429: 檢查網址、headers、請求頻率。

- 連線逾時/錯誤: 加入重試與退避機制。

- AttributeError/NoneType: 先檢查元素是否存在再取值。

- 編碼問題: 設定

response.encoding = 'utf-8'或存檔時指定編碼。 - Selenium 找不到元素: 用明確等待,檢查選擇器。

- 記憶體不足: 分批寫檔、用生成器,或改存資料庫。

- 除錯技巧: 多用 print/log,或把 HTML 存檔檢查。

想提升效能,可以考慮用非同步請求(aiohttp)、多執行緒,或大型專案用 Scrapy 框架。但對新手來說,清楚易懂比炫技更重要。

網頁爬取的道德與法律守則

有了強大爬蟲能力,也要懂得自律。這裡有幾個合規與道德建議:

- 遵守 robots.txt 跟服務條款: 網站明確禁止就不要爬。

- 避免蒐集個資或敏感資料: 只抓公開資訊,尊重隱私。

- 禮貌爬取: 降低請求頻率,避開尖峰時段,不要造成伺服器負擔。

- 標明身份: 有需要可自訂 User-Agent 並附聯絡方式。

- 查詢法律規範: 美國等多數國家公開資料爬取通常合法,但違反 ToS 或抓私人資料可能觸法(參考 )。

- 有 API 優先用 API: 官方 API 更穩定安全。

(參考 、)

結語與重點整理

學會用 Python 抓網頁資料,絕對是現代數據時代最實用的技能之一。重點回顧:

- Python 是網頁爬取首選,因為語法簡單、函式庫齊全、社群活躍(參考 )。

- 靜態網站先用 requests + BeautifulSoup,動態內容再用 Selenium。

- Thunderbit 能快速搞定複雜或臨時性爬取,Python 則負責後續分析與自動化。

- 遇到困難,可以用輪換 headers、代理、延遲、錯誤處理等技巧。

- 守法合規爬取,尊重網站、避免敏感資料。

我的建議:從簡單網站開始,寫出你的第一支爬蟲,看看能抓到什麼。熟悉後,再結合 Thunderbit 跟 Python,打造更強大的自動化流程。記住:每個錯誤都是待解的謎題(Stack Overflow 永遠是你的神隊友)。

想看 Thunderbit 實際操作或學更多爬蟲技巧?歡迎逛逛 ,或訂閱我們的 看教學跟實戰分享。

祝你爬蟲順利,資料乾淨、腳本無 bug,IP 永遠不會被封!

常見問答

1. 什麼是網頁爬取?合法嗎?

網頁爬取是自動化抓網站資料的技術。抓公開資料在美國及多數國家通常合法,但要遵守網站規範、避免敏感資料,並符合隱私法規(參考 )。

2. 為什麼大多數人用 Python 做爬蟲?

Python 對新手超友善,還有強大函式庫(requests、BeautifulSoup、Selenium、pandas)跟龐大社群支援(參考 )。

3. 什麼時候該用 Selenium,而不是 requests/BeautifulSoup?

當資料要靠 JavaScript 載入、原始 HTML 沒有時,就要用 Selenium 模擬瀏覽器操作。

4. Thunderbit 如何與 Python 搭配?

Thunderbit 讓你用 AI 幾下滑鼠就能抓複雜或非結構化資料,匯出成 CSV/Excel/Sheets,再用 Python 做清理、分析或自動化,超省開發時間。

5. 如何避免爬蟲被封鎖?

換 User-Agent、用代理、加延遲、遵守 robots.txt,避免抓敏感或私人資料。大量爬取時可考慮防封鎖工具或服務。

想親自體驗爬蟲?馬上下載 ,感受 AI 跟 Python 結合的資料魔力。如果遇到卡關,記得:每個高手都是從第一行程式碼開始的。

延伸閱讀