還記得我第一次想從網站抓資料的時候,整個畫面還歷歷在目。那時我坐在辦公桌前,手邊一杯咖啡,心裡盤算著怎麼把那個要花好幾個小時複製貼上產品價格的苦差事自動化。打開 Python,裝好 BeautifulSoup,滿懷期待地開始動手,結果馬上被一堆看不懂的 HTML 跟各種錯誤訊息打臉。如果你也用過 Python 處理網頁資料,肯定懂那種又期待又挫折、甚至想直接把筆電丟出窗外的心情。

但現實就是:網路資料的價值比以前更高。不管是要追蹤競爭對手價格、建立銷售名單,還是掌握市場動態,企業都想要即時洞察。python 網頁爬蟲一直是這方面的首選工具,但隨著網站越來越複雜、反爬蟲技術也越來越強,傳統寫程式的方式開始有點跟不上時代。所以今天就帶你一次看懂兩個世界:經典的 python 資料擷取工具組,還有像 這種 AI 驅動的新世代人工智慧網頁爬蟲,怎麼徹底改變銷售、電商和營運團隊的工作方式。

什麼是 python 網頁爬蟲?

先從最基本的說起:網頁爬蟲,其實就是「自動化從網站收集資料」的意思。你不用再傻傻地複製貼上,而是寫個腳本幫你搞定。Python 會成為新手首選,是因為語法簡單、社群超大,還有一堆現成的函式庫,讓 python 資料擷取變得很親民,就算不是工程師也能輕鬆上手。

為什麼大家都愛用 Python?

- 超好學: Python 語法直白,初學者也能很快上手。

- 函式庫超多: Requests、BeautifulSoup、Selenium、Scrapy,從靜態到動態網站都能搞定。

- 社群超熱絡: 卡關時,網路上一定有人遇過一樣的問題(Stack Overflow 永遠有救星)。

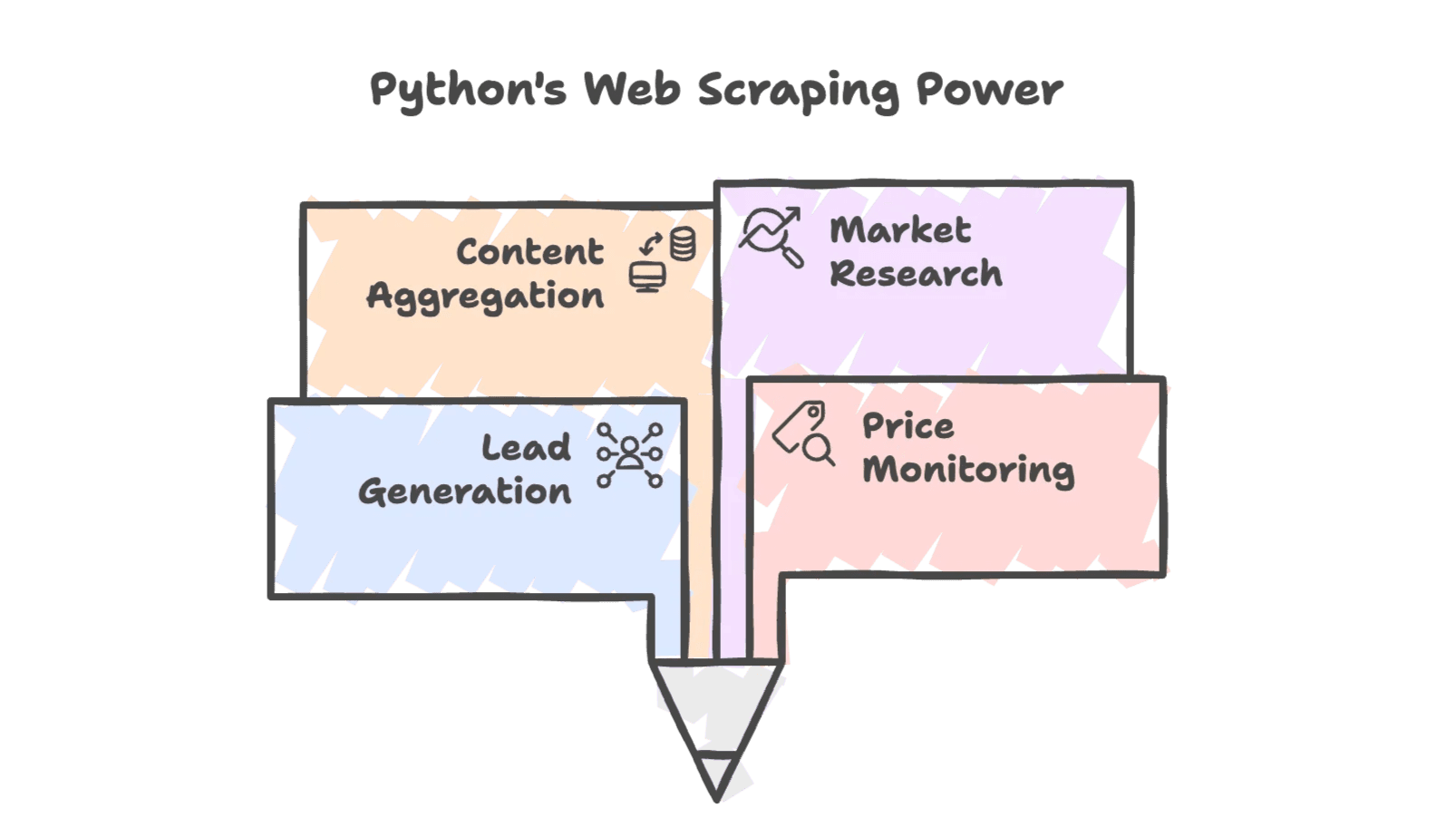

常見應用場景

python 網頁爬蟲在商業領域幾乎無所不在:

- 名單開發: 從目錄或社群網站擷取聯絡方式。

- 價格監控: 追蹤競爭對手價格,調整自家定價。

- 內容彙整: 收集新聞、評論或商品清單。

- 市場調查: 從論壇、社群或搜尋結果蒐集趨勢資料。

這不只是工程師的專利——銷售、電商、甚至房仲團隊都靠爬蟲資料維持競爭力。事實上,都已經用網頁爬蟲打造專屬資料集,做分析和名單評分。

為什麼企業都愛用 Python 來做網頁爬蟲?

Python 靈活又有強大函式庫,天生就是資料擷取的好幫手。來看看幾個實際商業情境:

| 情境 | Python 網頁爬蟲的幫助 | 效益(ROI) |

|---|---|---|

| 名單開發 | 擷取目錄上的姓名、Email、電話 | 一晚就能建立 500 筆潛在客戶名單,手動只能做 50 筆 |

| 價格監控 | 定期抓取競品價格 | 實現動態定價——有零售商靠爬蟲數據銷售提升 4% |

| 庫存追蹤 | 檢查競品庫存狀態 | 競爭對手缺貨時主動出擊,省下大量人工查詢時間 |

| 競品分析 | 爬取產品細節、評論 | 分析 1,000+ 則競品評論,優化行銷與產品策略 |

| 市場調查 | 匯整論壇、社群、搜尋趨勢 | 掌握最新市場動態,讓策略貼近消費者需求 |

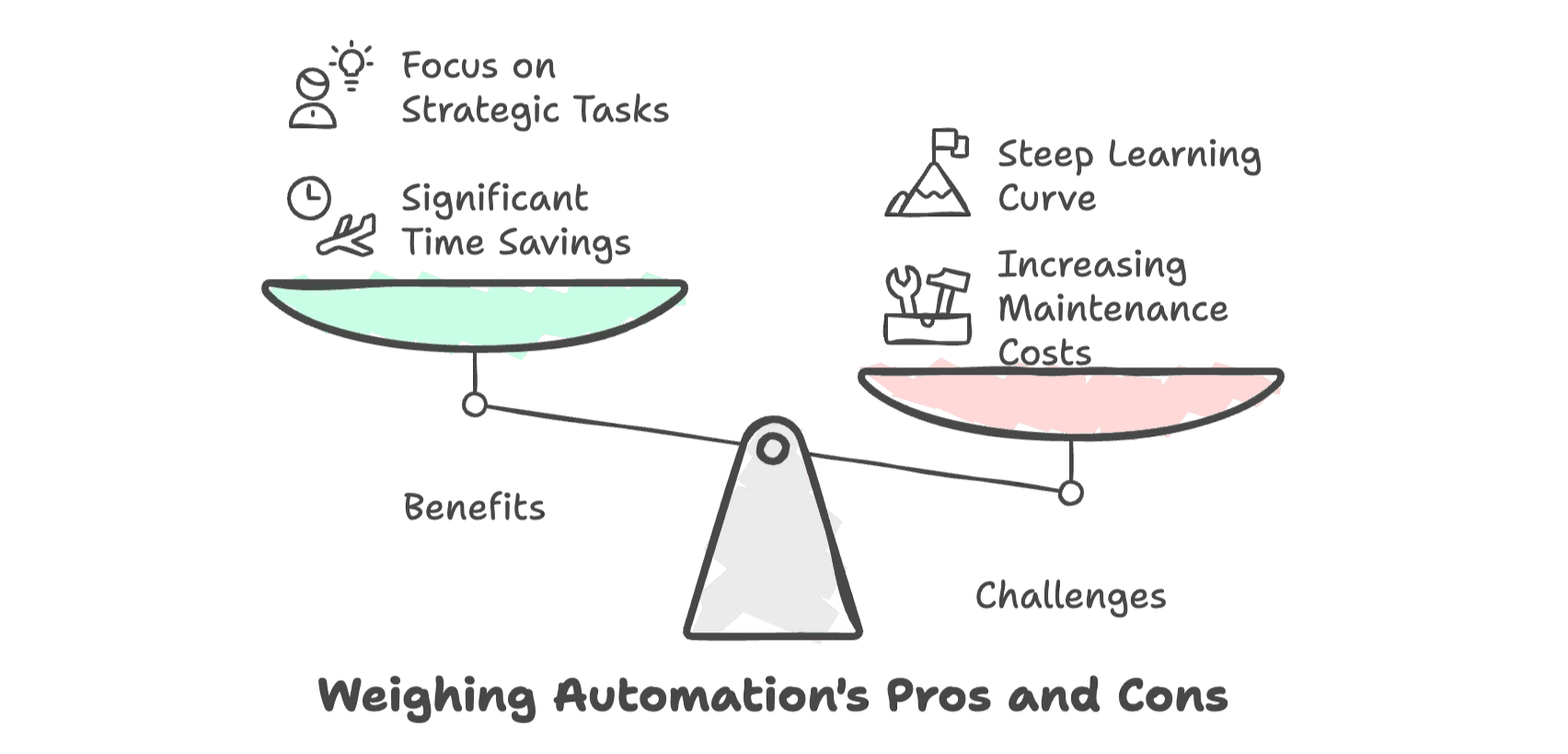

自動化資料收集的好處超明顯:用 Python 可以比人工節省 80% 以上的時間()。團隊能把時間花在成交或分析,而不是重複勞力。

但——這裡有個大重點——隨著網站越來越複雜,維護這些腳本的時間、精力和成本也跟著飆升。對非技術人員來說,學習曲線很陡,挫折感也很真實。

python 網頁爬蟲必備工具

剛入門時,Python 生態圈有幾個經典工具一定要認識,簡單整理如下:

| 工具 | 適合用途 | 支援 JavaScript? | 學習難度 | 速度與規模 |

|---|---|---|---|---|

| Requests + BeautifulSoup | 靜態簡單頁面 | 否 | 低 | 單頁速度快 |

| Selenium | 動態 JS 網站、互動操作 | 是 | 中等 | 單頁速度較慢 |

| Scrapy | 大規模結構化爬取 | 部分(需外掛) | 高 | 高效能、可擴展 |

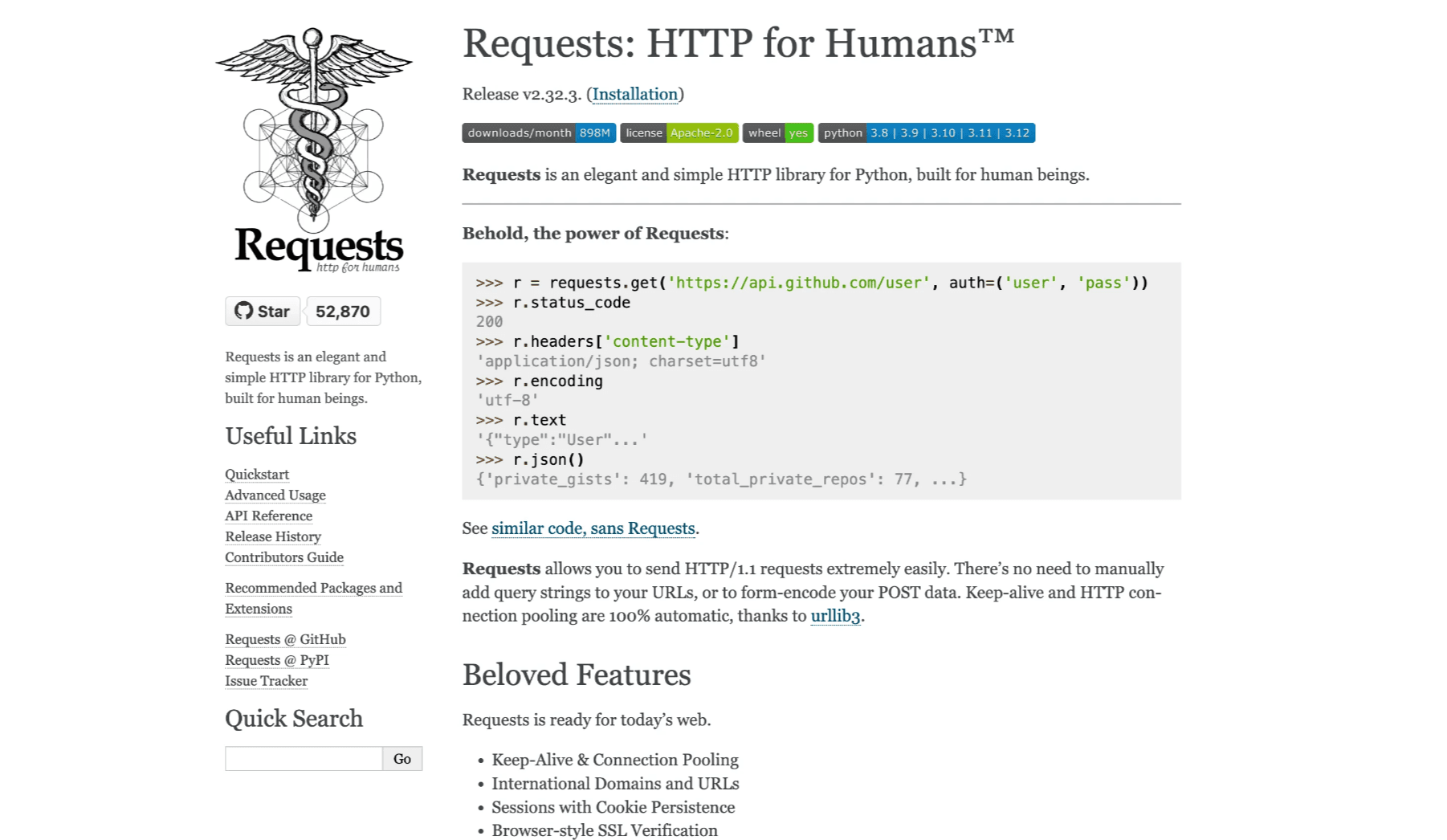

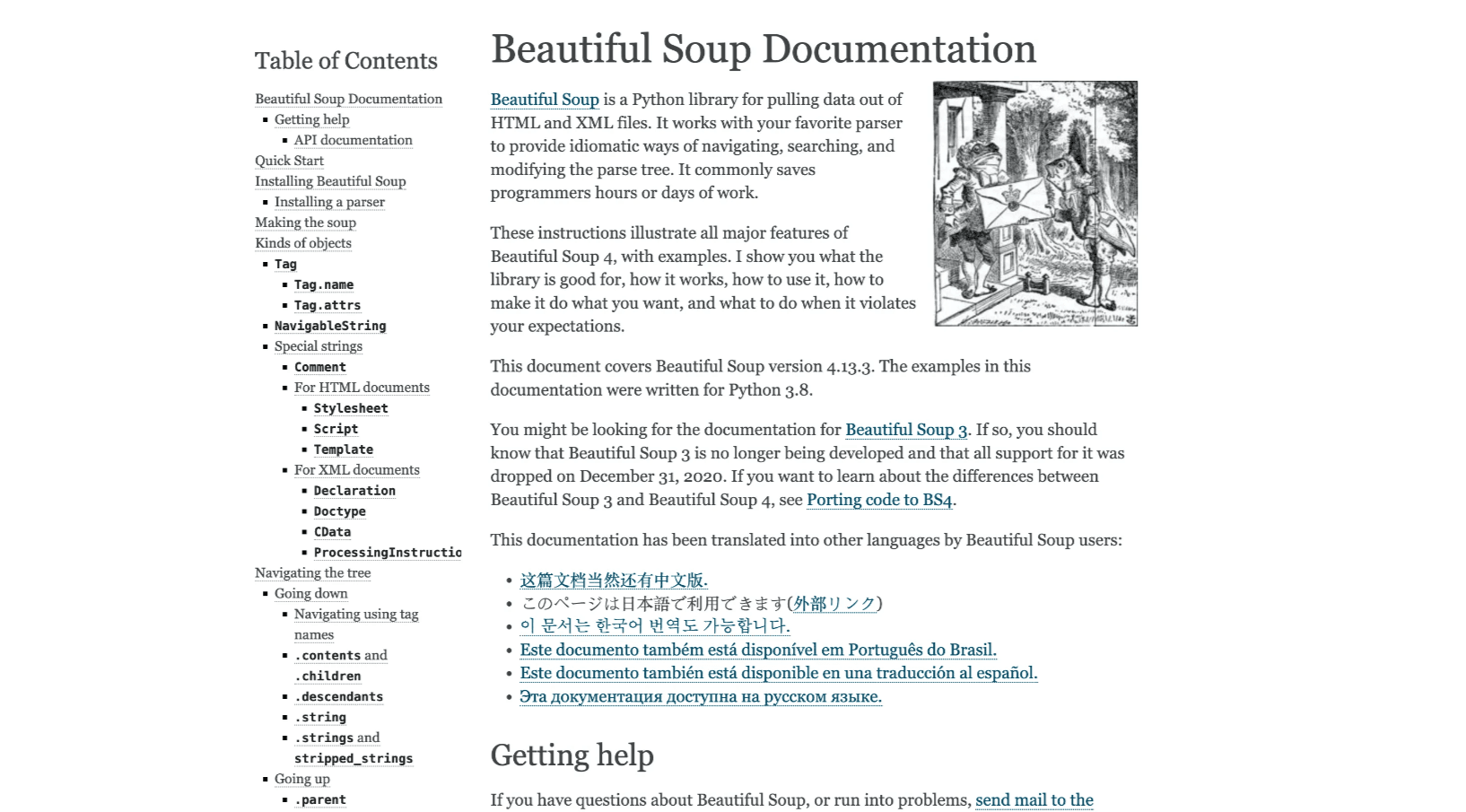

Requests + BeautifulSoup

這是靜態網站的經典組合。Requests 負責抓 HTML,BeautifulSoup 幫你解析並提取需要的資料。輕量、易學,適合小型專案(參考 、)。

Selenium

遇到需要 JavaScript 載入資料的網站,Selenium 就是你的好幫手。它能自動操作瀏覽器,處理登入、點擊、滑動等互動(參考 )。缺點是速度較慢、設定也比較繁瑣。

Scrapy

如果你要爬數千頁、或建立定期自動化資料管道,Scrapy 是專業級選擇。它是完整的爬蟲框架,支援高併發、程式碼結構化(參考 )。學習門檻較高,但大規模專案很值得。

實作教學:打造你的第一個 python 網頁爬蟲

來實戰一下!我們以 這個練習網站,抓取書名與價格。

Python 環境安裝

先確定你已經安裝好 Python,然後在終端機輸入:

1pip install requests beautifulsoup4建議用 VS Code 或 PyCharm 這類新手友善的編輯器,光是語法高亮就能讓你省下不少麻煩。

撰寫你的第一支爬蟲腳本

以下是一個簡單範例,抓取首頁並解析書籍資料:

1import requests

2from bs4 import BeautifulSoup

3url = "http://books.toscrape.com/"

4response = requests.get(url)

5html_content = response.text

6soup = BeautifulSoup(html_content, 'html.parser')

7book_elements = soup.find_all('article', class_='product_pod')

8books_data = []

9for book in book_elements:

10 title = book.find('h3').find('a')['title']

11 price = book.find('p', class_='price_color').text

12 books_data.append([title, price])

13print(books_data)這段程式碼做了什麼?

- 用 Requests 取得 HTML。

- 用 BeautifulSoup 解析內容。

- 找出所有書籍區塊。

- 逐一擷取書名與價格。

匯出爬取資料

讓資料更好用,來存成 CSV 檔:

1import csv

2with open('books.csv', 'w', newline='', encoding='utf-8') as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "Price"])

5 writer.writerows(books_data)這樣你就能用 Excel 或 Google Sheets 開啟 books.csv,輕鬆檢視成果。

實用小技巧:

- 記得檢查輸出結果,避免遺漏或錯誤資料。

- 若出現亂碼,請確認使用 UTF-8 編碼。

- 腳本失效時,先檢查網站結構是否有變動。

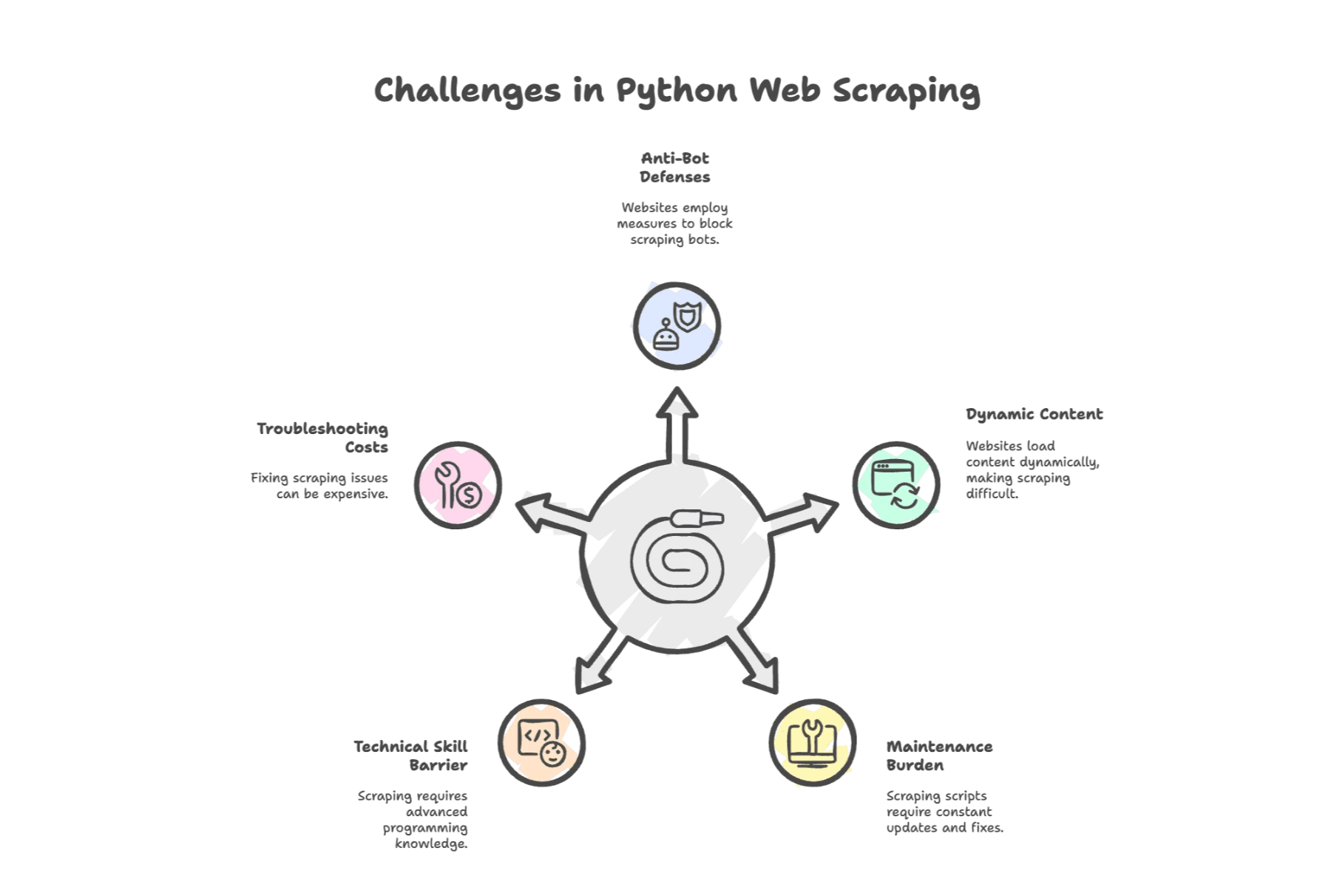

python 網頁爬蟲常見挑戰

這裡開始進入難題。Python 雖然強大,但也有不少坑,最常見的有:

1. 反爬蟲機制

網站會設防。根據調查,認為封鎖(IP 禁止、驗證碼)是最大障礙。網站能偵測腳本,並設下各種阻擋措施——有時直接丟你一個 CAPTCHA。

2. 動態內容

現代網站大量用 JavaScript。如果資料是載入後才出現,單靠 Requests + BeautifulSoup 會抓不到。這時就得用 Selenium,或試著找出 API。

3. 維護負擔

網站常常改版。只要 HTML 結構小改,腳本就可能壞掉。有研究指出,開發者有 都在修爬蟲,公司一年光維護就可能花掉 1.5 萬美元。

4. 技術門檻

即使 Python 已經很簡單,你還是得懂 HTML、CSS 選擇器,有時還要會 HTTP 協議。對非工程師來說,這就像學一門新語言。

5. 除錯與額外成本

出問題時(一定會遇到),你可能得買代理、用無頭瀏覽器,甚至外包第三方服務。每花一小時除錯,就是少一小時做正事。

自動化網頁爬蟲工具:進階選擇

那對於商業用戶(或忙到爆的銷售營運人員)來說,該怎麼辦?這時就輪到自動化網頁爬蟲工具,尤其是近年崛起的人工智慧網頁爬蟲。

這類工具幫你搞定所有繁瑣細節。你不用每個網站都寫程式,也不用熬夜 debug。只要點一點、選一選,資料就自動到手。

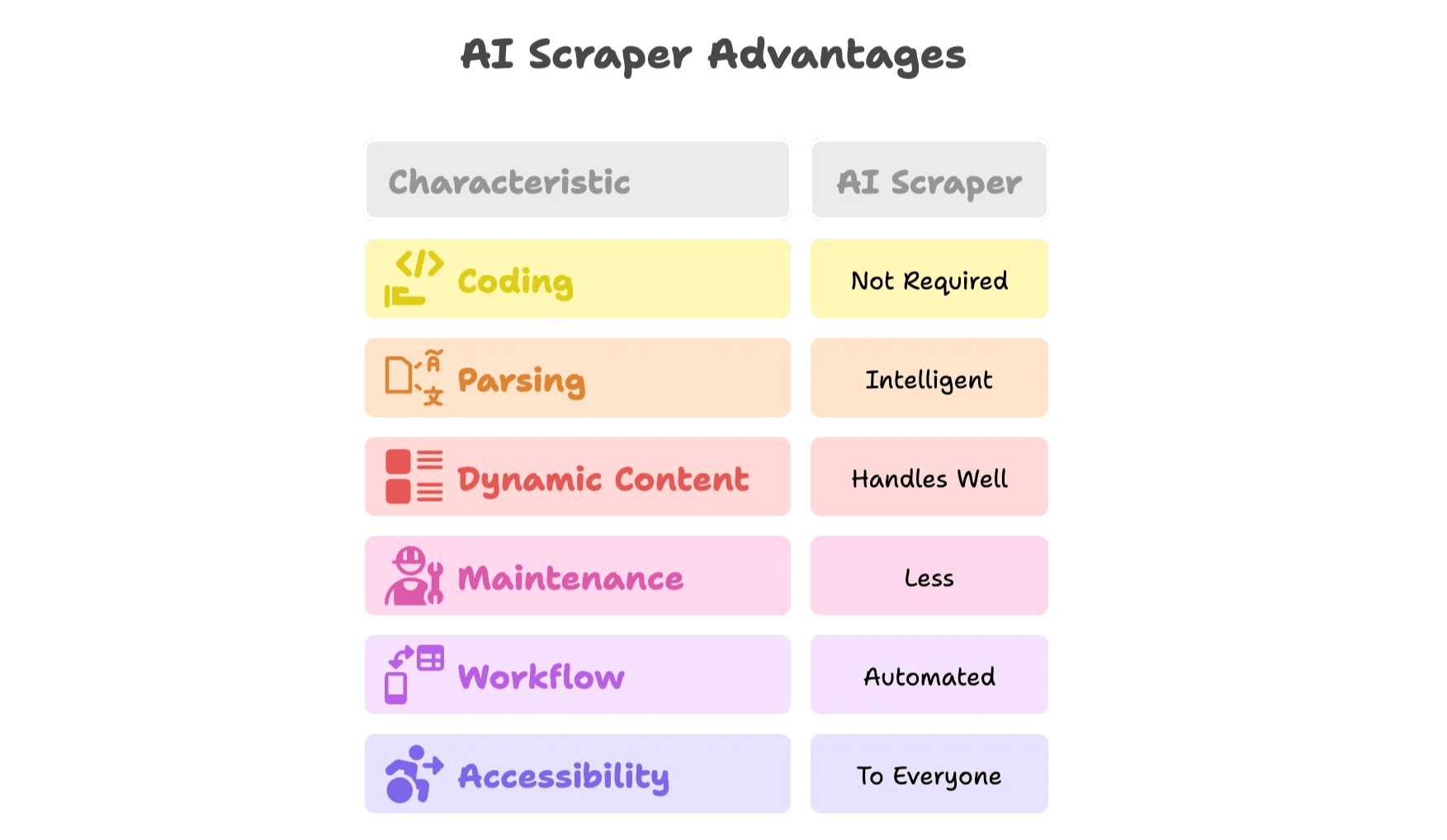

人工智慧網頁爬蟲有什麼不同?

AI 爬蟲是質的飛躍,原因如下:

- 完全免寫程式: 視覺化介面或瀏覽器擴充,直接點選頁面資料,AI 幫你判斷欄位。

- 智慧解析: AI 模型能自動辨識欄位(如姓名、價格、Email),不用你手動查 HTML。

- 支援動態內容: AI 爬蟲在真實瀏覽器運作,能處理 JavaScript、滑動、點擊等互動。

- 維護負擔低: 網站改版時,AI 會自動調整,或由工具團隊更新範本。

- 自動化整合: 可排程擷取,直接匯出到 Google Sheets、Airtable、Notion 或 Excel。

- 人人都能用: 不用再等團隊裡的「Python 達人」有空。

來看看 的實際應用。

Thunderbit:更聰明的 python 網頁爬蟲替代方案

我創立 Thunderbit,就是因為親眼看到團隊在手動爬蟲上浪費了多少時間與精力。我們的目標很簡單:讓每個人都能輕鬆取得網頁資料——不用寫程式、不用煩惱,只要成果。

Thunderbit 人工智慧網頁爬蟲的亮點

- 2 步驟 AI 網頁爬蟲: 只要打開網站,點「AI 建議欄位」,Thunderbit AI 就會自動推薦最佳擷取欄位。再按「開始擷取」,資料就到手。

- 內建範本: 支援熱門網站(Amazon、Zillow、LinkedIn 等)即時套用,完全免設定。

- 子頁面與分頁自動擷取: Thunderbit 能自動點擊子頁(如商品詳情)、處理分頁或無限捲動。

- 免費資料匯出: 資料可直接匯出到 Excel、Google Sheets、Airtable 或 Notion——無需付費牆。

- Email 與電話擷取器: 一鍵抓取任何頁面的聯絡資訊,銷售開發超方便。

- AI 資料轉換: 即時摘要、分類、翻譯或格式化資料。

- 排程擷取: 支援自然語言設定定期自動擷取。

- 雲端與瀏覽器雙模式: 可選擇高速雲端擷取,或用瀏覽器模式處理需登入的網站。

- 支援 34 種語言: 全球團隊都能輕鬆使用。

想看實際操作?歡迎試用我們的 或到 看教學與案例。

什麼時候該從 Python 換用 AI 網頁爬蟲?

這裡有個快速檢查表,幫你判斷:

| 情境 | Python 腳本 | AI 網頁爬蟲(Thunderbit) |

|---|---|---|

| 單次、簡單靜態頁面 | ✔️ | ✔️ |

| 動態內容(JS、登入、無限捲動) | ⚠️ | ✔️ |

| 網站常改版、維護負擔大 | ⚠️ | ✔️ |

| 非技術團隊、追求效率 | ⚠️ | ✔️ |

| 多平台資料整合(Sheets、CRM) | ⚠️ | ✔️ |

| 大規模、定期擷取 | ⚠️ | ✔️ |

| 需要排程、自動補充或自動化 | ⚠️ | ✔️ |

如果你發現目前流程裡有很多 ⚠️,就該考慮試試人工智慧網頁爬蟲了。

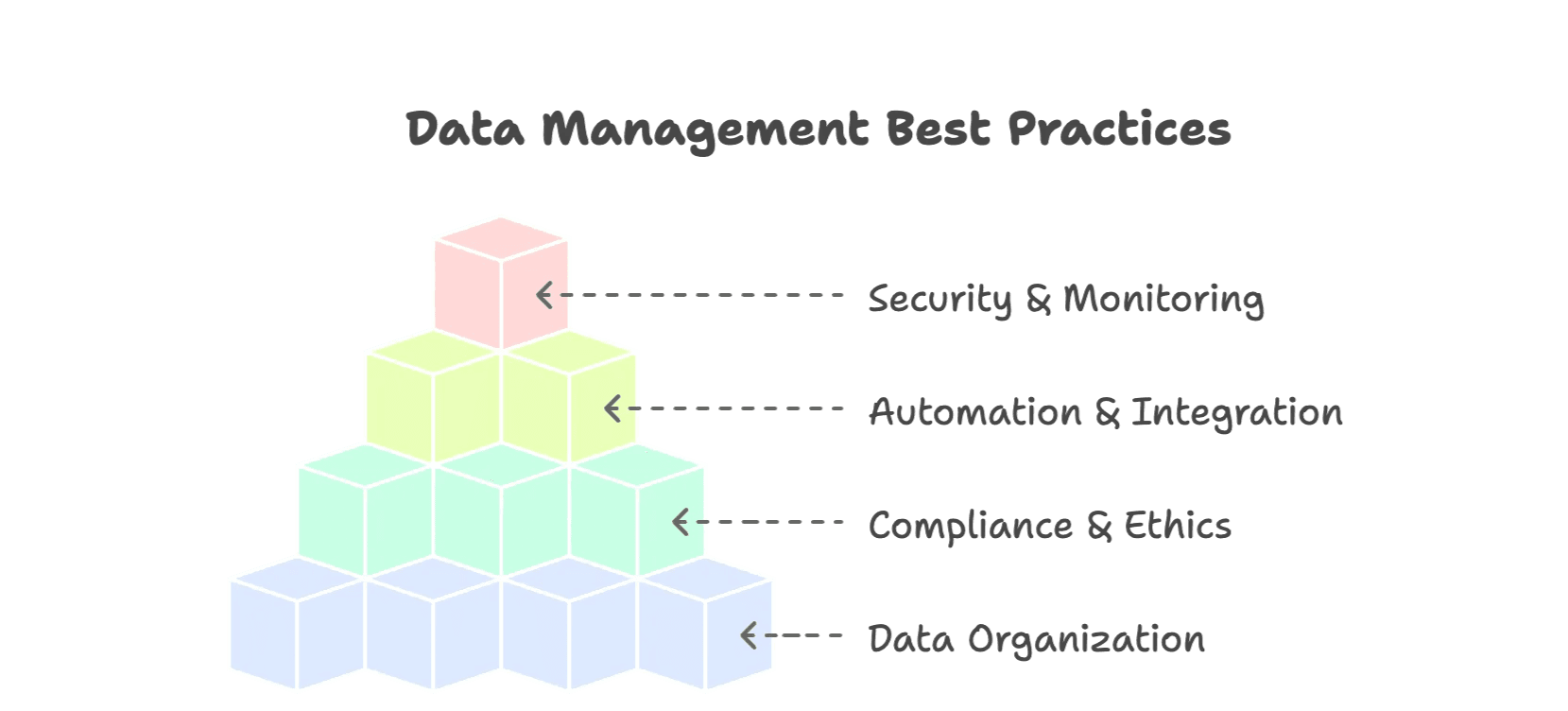

加碼:高效且永續的網頁資料收集建議

不論你用 Python 還是 AI 工具,這些實用原則都能讓你事半功倍:

1. 資料要有組織

- 儲存成結構化格式(CSV、Excel、資料庫)。

- 欄位標準化(日期、幣別、分類)。

- 加上來源、擷取日期等中繼資料。

- 去除重複、驗證正確性。

2. 合法且合乎道德

- 遵守 robots.txt 與網站服務條款(參考 )。

- 適度延遲,避免對網站造成負擔。

- 不要擷取個資或敏感資料。

- 有 API 就優先用 API。

3. 自動化與整合

- 設定定期自動擷取,確保資料即時。

- 直接匯出到工作流程工具(Sheets、Airtable、Notion)。

- 用警示或監控機制,及早發現錯誤。

4. 資料安全與監控

- 記錄每次擷取與錯誤。

- 定期備份資料集。

- 限制敏感資料的存取權限。

想了解更多最佳實踐,推薦參考。

結語:網頁爬蟲的未來更聰明

從手寫 Python 腳本、修 selector 修到天荒地老的時代,我們已經走了很遠。網頁資料已經成為企業的戰略資產——都花在公開網路資料上,AI 驅動的爬蟲市場預計到 。

Python 依然是學習基礎、處理小型爬蟲任務的好選擇。但隨著網站複雜度提升,工具也要跟上時代。像 Thunderbit 這樣的人工智慧網頁爬蟲,提供更聰明、更高效的資料收集方式,真正貼合現代團隊的需求。

如果你發現自己花在除錯的時間比產出還多,或想看看現代爬蟲長什麼樣,不妨試試 Thunderbit:。你的銷售、電商或營運團隊一定會感受到差異。