2025 年的網路世界變化超快,真的一眨眼就天翻地覆——上一秒你還在盯著競爭對手的價格,下一秒就被動態 JavaScript 和反爬蟲機制搞得頭昏腦脹。身為長期幫銷售和營運團隊打造自動化工具的工程師,我可以很直接地說:網頁爬蟲早就不是什麼「加分技能」,而是企業必備的核心戰力。根據都靠數據分析做決策,加上網路資料量短短四年內暴增,能把雜亂的網頁內容變成有用的洞察,才是領先與落後的分水嶺。

但說真的,現在的網頁爬蟲跟以前完全不一樣。用幾行 Python 抓靜態 HTML 的時代已經過去,現在遇到的都是動態內容、無限滾動,還有讓人頭痛的反爬蟲機制。不管你是剛入門的新手,還是想進階的老手,這篇指南會帶你掌握 2025 年最實用的 Python 網頁爬蟲技巧、工具和工作流程,還會教你怎麼用 這類 AI 工具,讓專案效率直接升級。

從新手到高手:Python 網頁爬蟲基礎全解析

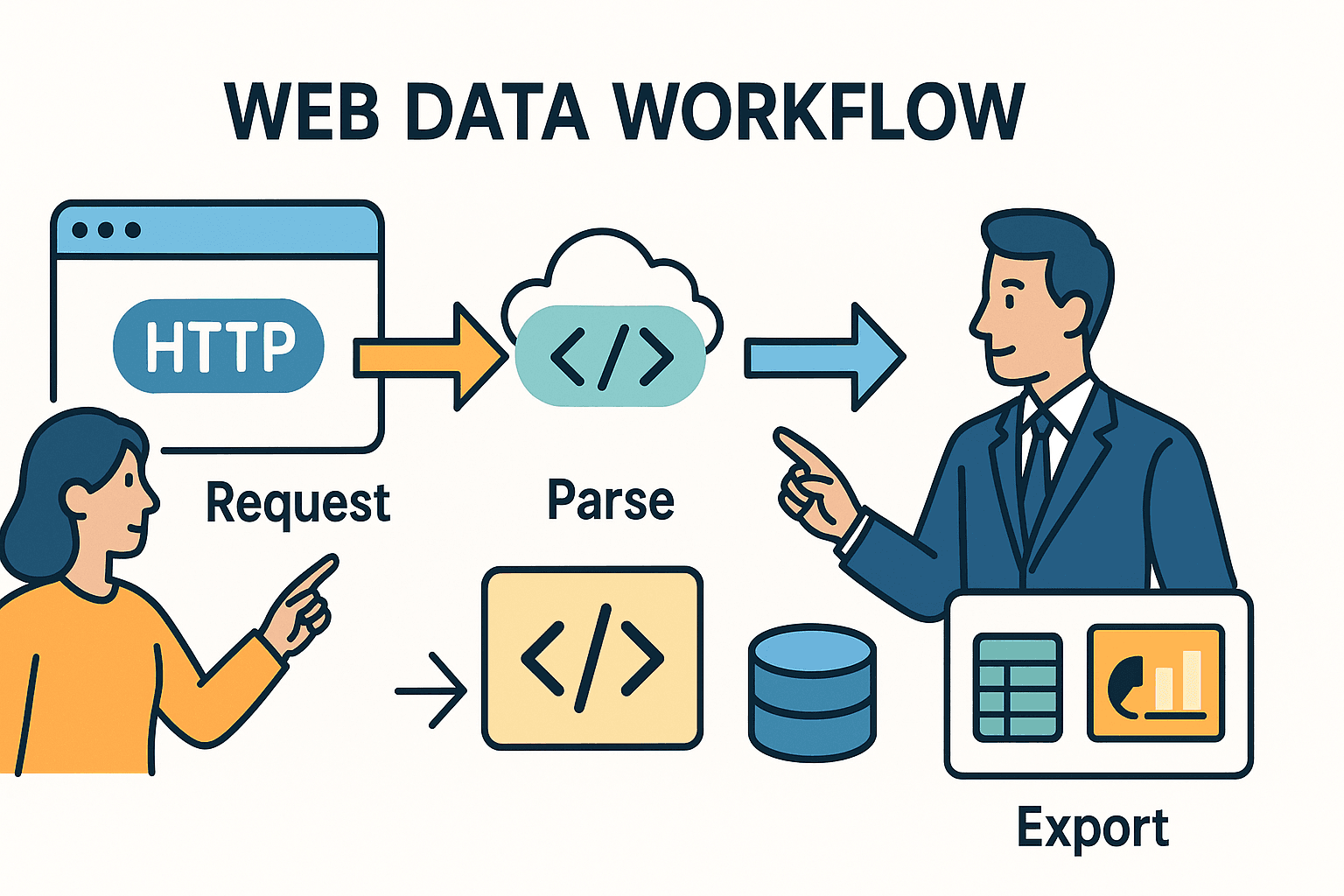

先來聊聊基本觀念。網頁爬蟲的本質,其實就是自動化你平常在瀏覽器做的事:打開網頁、找到你要的資料、然後存下來。用 Python 做的話,通常分三步:

- 發送 HTTP 請求(就像你在瀏覽器輸入網址)。

- 解析 HTML,定位你要的資料。

- 匯出或處理這些資料——可能存成 Excel、資料庫或儀表板。

重點來了:你選的工具(還有遇到的難題)會隨著網站複雜度和目標不同而變。

Python 爬蟲入門:運作原理

你可以把爬蟲想像成請圖書館員幫你拿報紙,然後你用剪刀只剪下你想看的文章。Python 的 requests 就像圖書館員——幫你拿回 HTML;BeautifulSoup 就是剪刀——讓你精準剪出需要的內容。

但如果報紙是用「隱形墨水」寫的(也就是 JavaScript 動態生成),或是文章分散在一堆頁面?這時你就需要進階工具,甚至 AI 來幫忙。

核心工具比較

這裡幫你整理主流 Python 網頁爬蟲工具的比較,還有什麼時候該用哪一個:

| 工具/函式庫 | 適用情境 | 優點 | 缺點 |

|---|---|---|---|

| Requests + BeautifulSoup | 抓取靜態頁面或小型任務 | 簡單、快速、易上手,完全掌控流程。 | 無法處理 JavaScript 或大規模爬取。 |

| Scrapy | 大型專案、多頁/多站點 | 高效能、內建爬蟲、非同步、管道、錯誤處理強大。 | 學習曲線較高,專案設定較繁瑣。 |

| Selenium/Playwright | 頁面需 JavaScript、登入或互動 | 能抓取瀏覽器可見的所有內容,支援動態資料、登入、無限滾動。 | 速度較慢、資源消耗大、部署較複雜。 |

| Thunderbit (AI) | 非結構化資料、PDF、圖片、無需寫程式 | AI 自動辨識欄位、支援子頁面、可匯出 Excel/Sheets,無需寫程式。 | 客製化彈性較低、採用點數制。 |

大部分商業用戶,requests 搭配 BeautifulSoup 就能搞定簡單靜態網站。遇到大規模或複雜需求,Scrapy 很好用。碰到動態內容、反爬蟲或非結構化資料,AI 工具像 就能派上用場。

全流程攻略:打造穩健的進階爬蟲

那要怎麼從「我想要這些資料」到建立一個穩定、可維護的爬蟲?這是我實戰下來的流程:

1. 先觀察、理解目標網站

寫程式前,先打開瀏覽器的開發者工具(F12 或右鍵 > 檢查元素),找出你要的資料在 HTML 裡的位置。是在表格?還是 <div>?有沒有隱藏的 API 回傳 JSON?有時候最簡單的路徑就在眼前。

小撇步:如果你在「下一頁」或「載入更多」時看到有網路請求拿到 JSON,通常可以直接用 Python 呼叫那個 API,省下解析 HTML 的麻煩。

2. 先在單一頁面做原型

從小地方開始。用 requests 抓一頁,再用 BeautifulSoup 抽幾個欄位,印出結果。如果被擋或資料抓不到,試著加 headers(模擬瀏覽器 User-Agent),或檢查是不是 JavaScript 載入(如果是,請看第 3 步)。

3. 處理動態內容與分頁

如果資料不在 HTML 裡,通常是 JavaScript 動態載入。這時可以:

- 瀏覽器自動化: 用 或 開網頁,等內容載入後再抓 HTML。

- API 呼叫: 在 Network 標籤找 XHR 請求,有回傳 JSON 的端點就直接用

requests模擬呼叫。 - 分頁處理: 多頁資料可以用迴圈跑頁碼或點「下一頁」連結。無限滾動就用 Selenium 模擬下滑,或模仿滾動時觸發的 API 請求。

4. 錯誤處理與友善爬取

網站不一定歡迎爬蟲。為了不被封鎖:

- 遵守

robots.txt: 先查example.com/robots.txt,看有沒有禁止路徑或延遲規定。 - 速率限制: 請在請求間加

time.sleep()。如果robots.txt有Crawl-delay: 5,就至少等 5 秒。 - 自訂 User-Agent: 禮貌地標示你的爬蟲(像

"MyScraper/1.0 (your@email.com)")。 - 重試機制: 用 try/except 包裝請求,失敗時重試,遇到 HTTP 429(請求過多)時適當延遲。

5. 資料解析與清理

用 BeautifulSoup 或 Scrapy 選擇器抽欄位。去掉多餘空白、價格轉數字、日期格式化、檢查完整性。大資料集可以用 pandas 做清理和去重。

6. 子頁面爬取

很多重要資訊都藏在細節頁。先抓連結,再一個個訪問抽更多資料。Python 可以用迴圈跑多個 URL; 則有「抓取子頁面」功能,AI 會自動訪問每個子頁並補齊資料。

7. 匯出與自動化

把清理後的資料匯出成 CSV、Excel、Google Sheets 或資料庫。要定期執行的話,可以用 cron、Airflow,或(如果用 Thunderbit)直接用自然語言設定雲端排程(像「每週一上午 9 點」)。

Thunderbit:AI 助力,讓 Python 爬蟲如虎添翼

有時候,就算 Python 寫得再好,也很難處理雜亂、非結構化或受保護的資料。這時, 就是你的救星。

Thunderbit 如何補足 Python

Thunderbit 是一款 AI 驅動的 Chrome 擴充功能,能讀網頁(或 PDF、圖片等)並輸出結構化資料,完全不用寫程式。我自己常這樣搭配:

- 處理非結構化資料: 遇到 PDF、圖片或 HTML 結構亂七八糟的網站,就交給 Thunderbit 的 AI 解析。它能從 PDF 抽表格、從圖片擷取文字,還會自動建議欄位。

- 子頁面與多步驟爬取: Thunderbit 的「抓取子頁面」功能超省時。先抓列表頁,再讓 AI 自動訪問每個細節頁並合併結果,省下寫巢狀迴圈或狀態管理的麻煩。

- 資料匯出: Thunderbit 可以直接匯出到 Excel、Google Sheets、Notion 或 Airtable,之後再用 Python 進一步分析或做報表。

實戰案例:Python + Thunderbit 協作

假設我要追蹤房地產物件。我用 Python + Scrapy 抓多個網站的列表 URL,但有一站的詳細規格只在 PDF 檔。這時我直接把 PDF 上傳到 Thunderbit,讓 AI 抽出表格並匯出 CSV,最後用 Python 合併所有資料,完成市場分析。

又或者我要建立銷售名單,用 Python 抓公司網址,再用 Thunderbit 的郵箱與電話提取器(免費功能!)自動抓聯絡資訊,完全不用寫正則表達式。

打造可維護的爬蟲流程:從程式到自動化管道

一次性的腳本雖然能解決臨時需求,但多數商業爬蟲都需要長期運作。我的建議架構如下:

CCCD 框架:Crawl, Collect, Clean, Debug

- Crawl(爬取): 收集所有目標網址(來自 sitemap、搜尋頁或清單)。

- Collect(收集): 從每個網址抽資料(用 Python、Thunderbit 或兩者結合)。

- Clean(清理): 標準化、去重、驗證資料完整性。

- Debug/Monitor(除錯/監控): 記錄每次執行、處理錯誤,設置異常警報。

可以想像成這樣的流程:

網址 → [爬蟲] → [資料擷取] → [清理] → [匯出] → [商業平台]

排程與監控

- Python 用戶: 用 cron、Airflow 或雲端排程定時執行腳本,記錄日誌,錯誤時發送 Email 或 Slack 通知。

- Thunderbit 用戶: 內建排程功能,只要輸入「每週一上午 9 點」這種語句,Thunderbit 就會自動在雲端執行並匯出資料。

文件與交接

把程式碼放在版本控制(像 Git),記錄流程,確保至少有一個人能維護或更新。如果混合 Python/Thunderbit,記清楚各工具負責哪些網站、資料流向哪裡(像「Thunderbit 抓 Site C 到 Google Sheets,Python 每週合併所有資料」)。

合法與合規:2025 年負責任的爬蟲實踐

能力越大,責任越大。怎麼合法、合規地做爬蟲?

Robots.txt 與速率限制

- 檢查 robots.txt: 一定要看網站的 robots.txt,了解禁止路徑和延遲規定。可以用 Python 的

robotparser自動檢查。 - 友善爬取: 請求間加延遲,特別是有

Crawl-delay時。千萬不要密集請求癱瘓網站。 - User-Agent: 誠實標示你的爬蟲身份,不要冒充 Googlebot 或其他瀏覽器。

資料隱私與合規

- GDPR/CCPA: 如果抓到個資(姓名、郵箱、電話),一定要依照隱私法規處理。只抓必要資料、妥善保管,並能應要求刪除。

- 服務條款: 未經授權不要抓登入後內容。很多網站明文禁止自動化存取,違規可能被封鎖甚至觸法。

- 只抓公開資料: 只抓公開可見的資訊,不要碰私人、版權或敏感內容。

合規檢查清單

- [ ] 已檢查 robots.txt 規則與延遲

- [ ] 已設置友善速率與自訂 User-Agent

- [ ] 只抓公開、非敏感資料

- [ ] 個資處理符合隱私法規

- [ ] 沒有違反網站 ToS 或版權

常見錯誤與除錯技巧:讓爬蟲更穩健

再厲害的爬蟲也會遇到問題。這裡整理常見狀況和我的解法:

This paragraph contains content that cannot be parsed and has been skipped.

除錯流程建議:

- 出錯時,先印出原始 HTML。

- 用瀏覽器 DevTools 比對腳本抓到的內容和實際網頁。

- 每一步都記錄日誌——網址、狀態碼、抓到的項目數。

- 先在小樣本測試,確認沒問題再擴大規模。

進階專案靈感:Python 爬蟲實戰應用

想把這些技巧用在實際專案?這裡有幾個真實案例可以試試:

1. 電商價格監控儀表板

抓取 Amazon、eBay、Walmart 的價格和庫存,處理反爬蟲、動態內容,每天匯出到 Google Sheets 做趨勢分析。可以用 快速上手。

2. 職缺資訊彙整平台

彙整 Indeed 和各大專業板的職缺,解析職稱、公司、地點、發布日期,處理分頁和依職缺 ID 去重,每天排程匯出到 Airtable。

3. 潛在客戶聯絡資訊提取器

給公司網址清單,從首頁和聯絡頁抓郵箱和電話。可以用 Python 正則或 Thunderbit 免費提取器一鍵完成,匯出 Excel 給銷售團隊。

4. 房地產物件比價工具

抓 Zillow、Realtor.com 指定地區物件,標準化地址和價格,分析趨勢並在 Google Sheets 視覺化。

5. 社群品牌聲量追蹤

用 Reddit JSON API 追蹤品牌被提及的次數,彙整貼文數、分析情緒,匯出時序資料給行銷團隊參考。

結語:2025 年 Python 爬蟲的關鍵心法

重點整理給你:

- 網頁爬蟲對商業決策、銷售和營運越來越重要。 網路是金礦,會挖才有機會領先。

- Python 是萬用工具箱: 從

requests+BeautifulSoup入門,進階用 Scrapy,動態網站用瀏覽器自動化。 - AI 工具像 Thunderbit 是你的秘密武器, 對付非結構化、複雜或不用寫程式的需求,Python 結合 AI 事半功倍。

- 最佳實踐很重要: 先觀察、模組化寫程式、妥善處理錯誤、清理資料、自動化流程。

- 合規不能忽略: 一定要查 robots.txt、遵守隱私法、道德爬取。

- 保持彈性: 網站會變,記得監控爬蟲、常常除錯、隨時調整策略。

未來的網頁爬蟲會是混合式、合規又以商業價值為主。不管你是新手還是老手,持續學習、保持好奇,讓數據成為你下一個成功的關鍵。

附錄:Python 爬蟲學習資源與工具

這是我常用的學習和除錯清單:

- – 最好用的 HTTP 請求函式庫。

- – 學會像專家一樣解析 HTML。

- – 適合大規模、商用級爬蟲。

- / – 處理動態內容和瀏覽器自動化。

- – 商業用戶最簡單的人工智慧網頁爬蟲。

- – AI 爬蟲教學、案例和最佳實踐。

- – 隨時掌握合規和道德議題。

- / ** – 社群問答和除錯資源。

想看 Thunderbit 怎麼讓你的爬蟲更輕鬆,歡迎訂閱我們的 ,有超多教學和實戰影片。

常見問答

1. 2025 年最推薦的 Python 網頁爬蟲函式庫是?

靜態頁面和小型任務,requests + BeautifulSoup 還是首選。大規模或多頁爬取,建議用 。動態內容就用 或 。遇到非結構化或複雜資料,AI 工具像 超實用。

2. 如何處理大量 JavaScript 或動態網站?

用 Selenium 或 Playwright 這類瀏覽器自動化工具渲染頁面後再抓資料。也可以在 Network 標籤找回傳 JSON 的 API,這通常更穩定好用。

3. 網頁爬蟲是否合法?

抓公開資料在美國通常合法,但一定要查 、遵守網站條款,還有符合 GDPR/CCPA 等隱私法規。千萬不要抓私人、版權或敏感資訊。

4. 如何自動化與排程爬蟲流程?

Python 腳本可以用 cron、Airflow 或雲端排程。完全不用寫程式的話, 內建排程功能,只要用自然語言描述排程就能雲端自動執行。

5. 如果爬蟲突然失效怎麼辦?

先檢查網站結構有沒有變,或是不是被封鎖(像 HTTP 403/429)。檢查 HTML、更新選擇器、降低請求速度、檢查反爬蟲機制。如果還是有問題,可以考慮用 Thunderbit AI 或改用瀏覽器自動化。

祝你爬蟲順利,資料乾淨、合規又即時!想體驗 Thunderbit 怎麼融入你的流程, 試試看。如果想學更多技巧, 隨時歡迎你來逛逛。