許多開發者第一次接觸網頁爬蟲,通常都是因為好奇,想要抓競爭對手網站上的商品資訊。搜尋相關工具時,BeautifulSoup 幾乎總是最早跳出來的選項之一,但剛開始摸索時難免覺得有點複雜。等你成功執行 pip install beautifulsoup4,順利抓到一個 HTML 元素(像是標題)時,那種「原來我也辦得到!」的成就感,常常就是許多 Python 新手愛上爬蟲的起點。

如果你正準備踏進網頁爬蟲的世界,BeautifulSoup 幾乎一定會是你聽到的第一個工具。這不是巧合:它簡單、強大,而且已經是 Python 網頁爬蟲領域超過十年的經典首選。這篇教學會帶你一步步用 pip 安裝 BeautifulSoup,並用實際程式碼示範基本用法,也會說明為什麼它至今仍然受到開發者和資料分析師的青睞。不過,我也會誠實分享它的限制——以及為什麼越來越多團隊(尤其是不會寫程式的人)開始轉向像 這類 AI 驅動的工具。

什麼是 BeautifulSoup?為什麼開發者還在用?

先從基礎說起:BeautifulSoup 到底是什麼?你可以把它想像成 Python 的「HTML 解析器」。你把一段 HTML 或 XML 給它,它就會幫你整理成一棵可以用 Python 搜尋、瀏覽、分析的樹狀結構。就像擁有網頁的 X 光視角——原本雜亂的標籤和屬性,瞬間變成可用的資料。

為什麼 BeautifulSoup 依然這麼受歡迎?

即使現在有很多新型爬蟲框架,BeautifulSoup 依然是大多數 Python 新手的首選。事實上,它每個月在 PyPI 上的下載量超過 。這不只是熱潮——在 Stack Overflow 上,關於「beautifulsoup」的問題超過 ,代表新手有龐大的社群和資源可以參考。

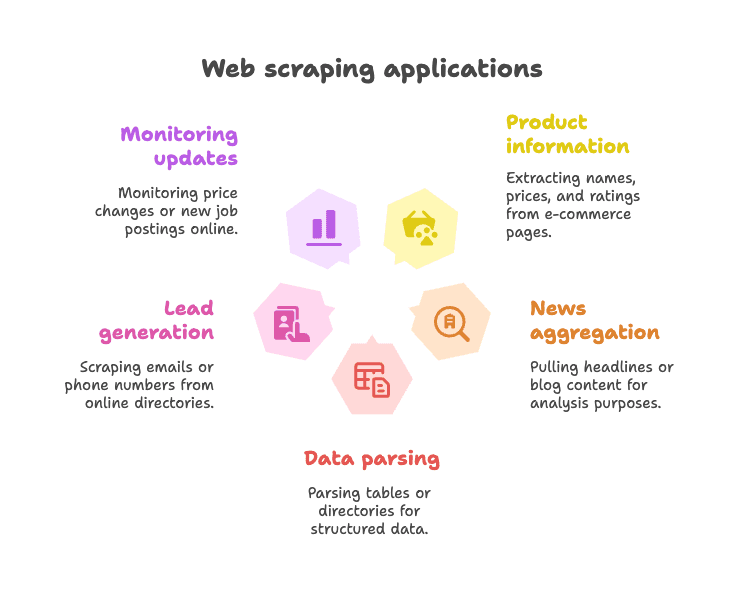

常見應用場景:

- 擷取商品資訊:像是電商網站上的名稱、價格、評分等

- 抓取新聞標題 或部落格內容,方便彙整或分析

- 解析表格或目錄:例如商家名錄、聯絡資訊等結構化資料

- 名單蒐集:從網站抓取 email 或電話

- 監控網站更新:如價格變動、新職缺上架等

BeautifulSoup 對於靜態網頁特別好用——也就是你要的資料直接寫在 HTML 裡的網站。它彈性高、容錯率強(就算 HTML 很亂也能解析),也不會強迫你照著特定框架來寫。這也是為什麼即使到了 2025 年,BeautifulSoup 依然是許多 Python 爬蟲新手的「初戀」工具()。

pip 安裝 BeautifulSoup:最簡單的入門方式

什麼是 pip?為什麼要用它?

如果你剛接觸 Python,pip 就是用來安裝函式庫的套件管理工具,類似 Python 的 App Store。用 pip 安裝 BeautifulSoup 是最快、最穩定的方式。

小提醒:正確的套件名稱是 beautifulsoup4(不是 beautifulsoup),記得加上「4」才能安裝最新版。

安裝 BeautifulSoup 步驟

1. 檢查 Python 版本

BeautifulSoup 需要 Python 3.7 以上。你可以在終端機輸入:

1python --version或

1python3 --version2. 用 pip 安裝 beautifulsoup4

打開終端機或命令提示字元,輸入:

1pip install beautifulsoup4如果你有多個 Python 版本,可能需要:

1pip3 install beautifulsoup4Windows 也可以用:

1py -m pip install beautifulsoup43.(可選但建議)安裝解析器

BeautifulSoup 內建支援 Python 的 "html.parser",但為了更快更準確,建議再安裝 lxml 和 html5lib:

1pip install lxml html5lib4.(可選)安裝 Requests

BeautifulSoup 只負責解析 HTML,不會自動下載網頁。大多數人會搭配 來抓取網頁內容:

1pip install requests5. 驗證安裝是否成功

在 Python 裡試試看:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)如果你看到 <title>Example Domain</title>,就代表安裝成功。

在虛擬環境中安裝 BeautifulSoup

我強烈建議每個 Python 專案都用 ,這樣可以避免套件衝突、管理更方便。

建立虛擬環境的方法:

1python -m venv venv

2# Windows:

3venv\Scripts\activate

4# macOS/Linux:

5source venv/bin/activate

6pip install beautifulsoup4 requests lxml html5lib這樣所有安裝的套件都只會存在這個專案資料夾,不會影響到其他地方。

其他安裝方式(如 Conda)

如果你用的是 ,可以這樣安裝 BeautifulSoup:

1conda install beautifulsoup4解析器則用:

1conda install lxml記得先啟動你的 conda 環境。

BeautifulSoup Python:實戰程式碼範例

來實際操作看看,以下是用 BeautifulSoup 實作的基本範例。

範例 1:抓取網頁並擷取標題

1from bs4 import BeautifulSoup

2import requests

3url = "https://en.wikipedia.org/wiki/Python_(programming_language)"

4response = requests.get(url)

5soup = BeautifulSoup(response.content, "html.parser")

6# 取得網頁標題

7title_text = soup.title.string

8print("Page title:", title_text)這段程式會抓取 Python 的維基百科頁面,解析 HTML 並印出標題。

範例 2:擷取所有超連結

1links = soup.find_all('a')

2for link in links[:10]: # 只顯示前 10 筆

3 href = link.get('href')

4 text = link.get_text()

5 print(f"{text}: {href}")這會列出前 10 個連結的文字和網址。

範例 3:擷取所有標題(h2)

1headings = soup.find_all('h2')

2for h in headings:

3 print(h.get_text().strip())想抓所有 <h2> 標題?這樣就夠了。

範例 4:用 CSS 選擇器

1items = soup.select("ul.menu > li")

2for item in items:

3 print(item.get_text())select() 方法可以直接用 CSS 選擇器。

範例 5:取得屬性與巢狀標籤

1first_link = soup.find('a')

2print(first_link['href']) # 直接取值(缺少會報錯)

3print(first_link.get('href')) # 安全取值(缺少會回傳 None)範例 6:抓取所有文字內容

1text_content = soup.get_text()

2print(text_content)這會把整個網頁的純文字都抓下來,方便快速分析。

新手常用的 BeautifulSoup 操作

以下是新手最常用的幾個技巧:

-

找單一元素:

soup.find('div', class_='price') -

找所有元素:

soup.find_all('p', class_='description') -

取得文字內容:

element.get_text() -

取得屬性值:

element.get('href') -

用 CSS 選擇器:

soup.select('table.data > tr') -

處理找不到元素的情況:

1price = soup.find('span', class_='price') 2if price: 3 print(price.get_text())

語法簡單易懂,對新手很友善,就算 HTML 結構很亂也能解析()。

BeautifulSoup 在現代網頁爬蟲的限制

接下來談談現實面。BeautifulSoup 雖然很適合靜態網頁和小型專案,但也有不少限制。

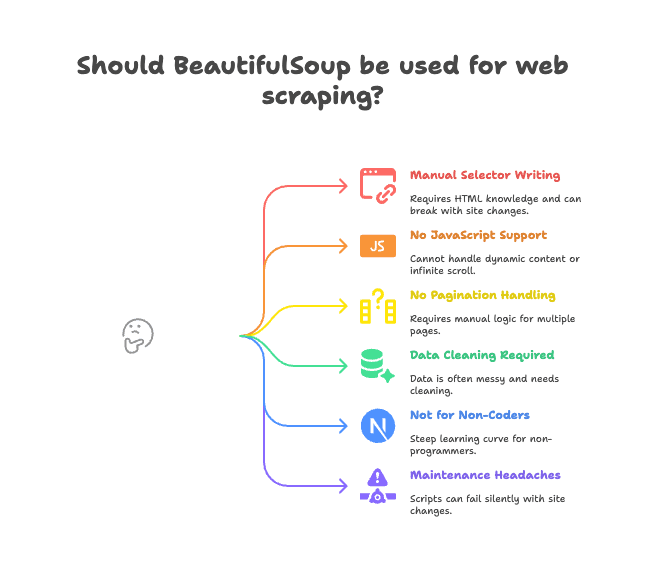

主要痛點如下:

- 需要手動寫選擇器: 你得自己讀 HTML,寫對標籤和 class 路徑。網站一改版,程式就壞了。

- 無法處理 JavaScript 動態資料: BeautifulSoup 只能看到伺服器回傳的 HTML。如果網站用 JavaScript 載入資料(像是無限捲動、動態內容),就抓不到()。

- 沒有內建分頁或子頁面處理: 想抓多頁或點進商品詳情?都要自己寫邏輯。

- 資料常常很亂: 你抓到的資料可能有多餘空白、奇怪字元、格式不一致。

- 不適合不會寫程式的人: 如果你是業務、行銷、營運人員,不會寫 code,BeautifulSoup 上手門檻高。

- 維護麻煩: 網站一改版,程式可能悄悄失效或漏抓資料。

這些「小問題」累積起來,常常讓團隊效率大打折扣。我看過不少專案卡在爬蟲腳本要一直修、一直 debug。

為什麼越來越多團隊改用 Thunderbit 來抓取網頁資料

那有沒有更簡單的選擇?這時候 就派上用場了。Thunderbit 不是另一個 Python 套件,而是 Chrome 擴充功能,像你的 AI 網頁資料小助手。

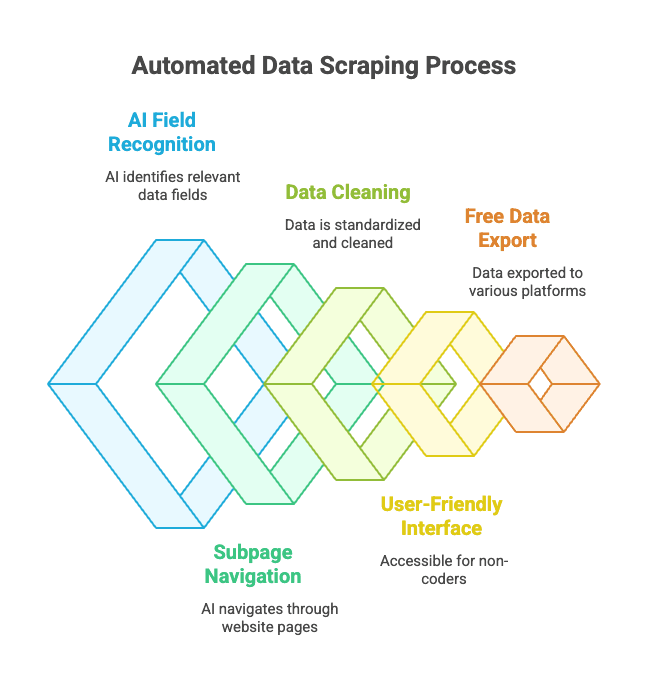

它怎麼運作?

- 你打開想抓資料的網站

- 點「AI 建議欄位」——Thunderbit 的 AI 會自動判斷頁面上的資料欄位(如「商品名稱」、「價格」、「地點」)

- 你可以調整欄位名稱或型別

- 點「開始抓取」,Thunderbit 會自動擷取、清理並結構化資料

- 一鍵匯出到 Excel、Google Sheets、Notion、Airtable 等常用工具

完全不用寫程式、不用選擇器、不用擔心網站改版。

Thunderbit 的亮點功能:

- AI 自動辨識欄位: AI 會自動判斷你要的資料,就算 HTML 很亂也沒問題

- 支援分頁與子頁面抓取: 能自動點進商品詳情或「下一頁」

- 資料自動清理與格式化: 電話、email、圖片等都會標準化

- 不會寫程式也能用: 只要會用瀏覽器就能上手

- 免費匯出資料: 一鍵匯出到 Excel、Google Sheets、Airtable、Notion,基本功能無需付費

- 定時自動抓取: 可以排程自動擷取資料,省時省力

對於商務用戶來說,這徹底改變了網頁資料擷取的方式。你不用再寫 Python 腳本,只要點一點就能拿到乾淨的資料。

Thunderbit vs. BeautifulSoup:哪個適合你?

來快速比較一下:

| 功能 | BeautifulSoup(需寫 Python 程式) | Thunderbit(免寫程式 AI 工具) |

|---|---|---|

| 安裝方式 | 需安裝 Python、pip、寫程式 | Chrome 擴充,兩步驟完成 |

| 取得資料速度 | 第一次寫腳本需數小時 | 每個網站幾分鐘搞定 |

| 支援 JavaScript | 不支援(需額外工具) | 支援(直接在瀏覽器執行) |

| 分頁/子頁面 | 需手動寫程式 | 內建,開關即可 |

| 資料清理 | 需自己寫程式 | AI 自動處理 |

| 匯出選項 | 需自己寫 CSV/Excel | 一鍵匯出到 Sheets、Notion 等 |

| 適合對象 | 開發者、愛好者 | 商務用戶、不會寫程式的人 |

| 費用 | 免費(但花時間) | 免費+付費(小量免費) |

什麼時候適合用 BeautifulSoup:

- 你熟悉 Python,想要完全自訂流程

- 你要抓的是靜態網頁,或需要複雜邏輯

- 你要把爬蟲整合進大型 Python 專案

什麼時候適合用 Thunderbit:

- 你想快速拿到資料,不想寫程式

- 你要抓的是動態(JavaScript)網站

- 你是業務、行銷、營運等非技術人員

- 你想直接把資料匯入常用商務工具

老實說,即使我是開發者,有時候也會直接用 Thunderbit,因為臨時要抓資料時不用再開一個 Python 專案,超級方便。

安裝與使用 BeautifulSoup 的實用建議

如果你決定用 BeautifulSoup,這裡有幾個實戰小技巧:

- 一定要用虛擬環境: 這樣套件不會打架,也方便管理

- 定期更新 pip 和套件: 常跑

pip install --upgrade pip和pip list --outdated - 安裝推薦的解析器:

pip install lxml html5lib,效能更好 - 程式碼要模組化: 把抓取和解析分開,方便除錯

- 遵守 robots.txt 和速率限制: 不要對網站發太多請求,可以用

time.sleep()控制 - 選擇穩定的選擇器: 避免太細的路徑,網站一改就壞

- 先下載 HTML 測試解析: 這樣不會一直重複請求網站

- 多利用社群資源: 是解決問題的好幫手

BeautifulSoup 安裝常見問題排解

遇到問題?這裡有快速檢查清單:

- 「ModuleNotFoundError: No module named bs4」

- 你有在正確的環境安裝

beautifulsoup4嗎?試試python -m pip install beautifulsoup4

- 你有在正確的環境安裝

- 安裝錯套件(裝成 beautifulsoup 而不是 beautifulsoup4)

- 先移除舊的:

pip uninstall beautifulsoup - 再安裝正確的:

pip install beautifulsoup4

- 先移除舊的:

- 解析器警告或 Unicode 錯誤

- 安裝

lxml和html5lib,並指定解析器:BeautifulSoup(html, "lxml")

- 安裝

- 找不到元素

- 資料是不是用 JavaScript 載入?BeautifulSoup 看不到。要看原始 HTML,不是瀏覽器渲染後的內容。

- pip 錯誤或權限問題

- 用虛擬環境,或試試

pip install --user beautifulsoup4 - 升級 pip:

pip install --upgrade pip

- 用虛擬環境,或試試

- Conda 問題

- 試試

conda install beautifulsoup4,或在 conda 環境裡用 pip 安裝

- 試試

還是卡住? 和 Stack Overflow 幾乎都有解答。

結論:安裝與使用 BeautifulSoup 的重點整理

-

BeautifulSoup 是最受歡迎的 Python 網頁爬蟲函式庫,簡單、彈性高,非常適合新手

-

用 pip 安裝最方便:

1pip install beautifulsoup4 lxml html5lib requests -

建議用虛擬環境,管理更輕鬆

-

BeautifulSoup 適合靜態網頁和小型專案, 但遇到 JavaScript、分頁、維護等問題時會比較吃力

-

Thunderbit 是現代 AI 驅動的替代方案, 適合商務用戶和不會寫程式的人——免寫程式、免維護,直接拿到資料

-

選對工具最重要:

- 開發者、愛好者:BeautifulSoup 給你最大彈性

- 商務用戶、團隊:用 快速搞定

兩種方法都可以試試——有時候,最適合你的就是那個能最快解決問題的工具。

常見問答:pip 安裝 BeautifulSoup 與延伸問題

Q:beautifulsoup 和 beautifulsoup4 有什麼不同?

A:請務必安裝 beautifulsoup4——這是最新版且支援 Python 3 的套件。舊的 beautifulsoup 已經不再維護,且不相容。你會用 from bs4 import BeautifulSoup 來引用()。

Q:需要和 BeautifulSoup 一起安裝 lxml 或 html5lib 嗎?

A:不是必須,但非常建議。這兩個解析器能讓解析速度更快、容錯更高。安裝指令:pip install lxml html5lib()。

Q:BeautifulSoup 能抓 JavaScript 動態網頁嗎?

A:不行——BeautifulSoup 只能看到靜態 HTML。遇到 JavaScript 載入的內容,建議用 Selenium 等瀏覽器自動化工具,或直接用像 這種 AI 瀏覽器工具()。

Q:如何移除 BeautifulSoup?

A:在終端機輸入 pip uninstall beautifulsoup4 即可()。

Q:Thunderbit 是免費的嗎?

A:Thunderbit 採用免費+付費模式——小量使用免費,大量或進階功能需付費。你可以直接在瀏覽器免費試用()。

如果你想了解 Thunderbit 和 BeautifulSoup 在實際應用上的差異,歡迎參考我們的。想進一步學習網頁爬蟲,也別錯過我們的和。

祝你爬蟲順利!不管你是 Python 達人還是只想把資料匯出成表格,都有合適的工具和社群等著你。