2026 年,網路世界比以前還要熱鬧,現在有一半的網路流量都是機器人貢獻的,而開源網頁爬蟲就是這些自動化應用背後的無名英雄,撐起價格監控、AI 訓練等各種需求。我在 SaaS 和自動化圈子混了好幾年,深刻體會到選對自架型網頁爬蟲,真的能幫團隊省下超多麻煩(還能少熬幾個夜晚 debug)。不管你只是想抓幾個商品頁,還是要大規模爬數百萬個網址,這份 Firecrawl 開源替代方案清單都能幫你找到最適合的工具——不論規模、技術棧還是複雜度。

不過要提醒一下:沒有哪一套工具能包山包海。有些團隊需要 Scrapy 的強大效能,有些則看重 Heritrix 的完整存檔能力,也有人覺得維護開源程式庫太燒腦。這篇文章會帶你快速掌握 2026 年最值得關注的 9 款 Firecrawl 開源替代方案,分析各自優缺點,幫你精準對應業務需求,省下反覆踩雷的時間。

如何挑選最適合你的開源 Firecrawl 替代方案?

在進入清單前,先聊聊選擇策略。現在開源網頁爬蟲的生態比以前更豐富,選擇時建議考慮這幾點:

- 易用性: 你偏好圖形化操作,還是能接受寫 Python、Go 或 JavaScript?

- 擴展性: 只要抓單一網站,還是要跨數百網域、數百萬頁面?

- 內容型態: 目標網站是靜態 HTML,還是大量 JavaScript 動態載入?

- 整合需求: 你想怎麼用這些資料——匯出 Excel、寫入資料庫,還是串接分析流程?

- 維護成本: 有沒有資源維護自訂程式碼?還是希望工具能自動適應網站變動?

這裡有一張快速對照表,幫你初步篩選:

| 情境 | 最佳工具 |

|---|---|

| 無程式碼、離線瀏覽 | HTTrack |

| 大規模、多網域爬取 | Scrapy, Apache Nutch, StormCrawler |

| 動態/JS 密集網站 | Puppeteer |

| 表單自動化/需登入 | MechanicalSoup |

| 靜態網站下載/存檔 | Wget, HTTrack, Heritrix |

| Go 開發者、高效能需求 | Colly |

接下來,讓我們深入看看 2026 年最值得推薦的 9 款開源 Firecrawl 替代方案。

1. Scrapy:大規模 Python 爬蟲首選

是開源網頁爬蟲界的超級明星。用 Python 打造,特別適合需要大規模爬取(像是數百萬頁面、頻繁更新、複雜邏輯)的開發者。

為什麼選 Scrapy?

- 超大規模處理: Scrapy 每秒能處理數千個請求,很多企業每月都靠它爬數十億頁面( 就是代表)。

- 高度擴充: 可以自訂爬蟲、插入代理、處理登入,還能輸出 JSON、CSV 或直接寫進資料庫。

- 社群活躍: 插件、文件、討論資源超多。

- 實戰驗證: 全球電商、媒體、研究團隊都在用。

缺點: 對非開發者來說學習曲線比較陡,網站結構變動時要自己維護。不過如果你追求彈性和規模,Scrapy 幾乎無敵。

2. Apache Nutch:企業級搜尋引擎首選

是開源爬蟲界的老大哥,專為企業級、網際網路規模的爬取設計。如果你想打造自己的搜尋引擎或大規模抓取數百萬網域,Nutch 絕對是首選。

為什麼選 Apache Nutch?

- Hadoop 架構: 基於 Hadoop,可以在伺服器叢集上爬數十億頁面( 就是用它抓全網)。

- 批次爬取: 只要給種子網址清單就能自動排程大規模任務。

- 整合性強: 能和 Solr、Elasticsearch 及大數據流程無縫串接。

缺點: 安裝和設定比較複雜(要 Hadoop 叢集、Java 配置),偏重原始爬取而不是結構化資料萃取。小型專案不建議,但要網際網路級規模,沒人比它更強。

3. Heritrix:網頁存檔與合規首選

是 Internet Archive 官方爬蟲,專門為網頁存檔和數位保存設計。

為什麼選 Heritrix?

- 完整存檔: 能捕捉每個頁面、資源和連結,適合法規遵循或歷史快照。

- WARC 標準格式: 用 Web ARChive 標準檔案儲存,方便重播或分析。

- 網頁管理介面: 可以用瀏覽器設定和監控爬取任務。

缺點: 需要大量硬碟和記憶體,不支援 JavaScript,輸出是原始存檔不是結構化表格。適合圖書館、檔案館或高度合規產業。

4. Colly:Go 開發者的高效能首選

是 Go 語言開發者的最愛,主打快速、輕量又高併發。

為什麼選 Colly?

- 極速爬取: 利用 Go 的併發特性,Colly 能用很少資源爬大量頁面( 有詳細介紹)。

- 簡潔 API: 可以針對 HTML 元素設回呼,還會自動處理 cookies 和 robots.txt。

- 靜態網站最佳: 適合伺服器渲染頁面、API 或 Go 後端整合。

缺點: 不支援 JavaScript 動態渲染(要搭配 Chromedp 等工具),而且要會 Go。

5. MechanicalSoup:簡易表單自動化首選

是一款 Python 函式庫,介於簡單 HTTP 請求和完整瀏覽器自動化之間。

為什麼選 MechanicalSoup?

- 表單自動化: 輕鬆登入、填寫表單還能維持 session,適合需要登入後抓資料的情境。

- 輕量易用: 內建 Requests 和 BeautifulSoup,安裝快、上手也容易。

- 互動型網站適用: 如果要提交查詢表單或登入後抓資料,非常合適( 有教學)。

缺點: 不支援 JavaScript,無法處理動態網站。適合靜態或伺服器渲染頁面。

6. Puppeteer:動態 JS 網站首選

是現代動態網站爬取的萬用工具,Node.js 函式庫,能完全操控無頭 Chrome 瀏覽器。

為什麼選 Puppeteer?

- 動態內容處理: 能抓取 SPA、無限滾動、AJAX 載入頁面( 有詳細說明)。

- 模擬用戶操作: 可以點擊、填表、截圖,甚至搭配插件解決驗證碼。

- 強大自動化: 適合測試、監控、抓取所有用戶可見內容。

缺點: 資源消耗大(要啟動完整 Chrome),速度比 HTTP-only 工具慢,擴展時需要強大硬體或雲端協作。

7. Wget:命令列快速下載首選

是經典命令列工具,適合下載靜態網站和檔案。

為什麼選 Wget?

- 極簡操作: 一行指令就能下載整個網站或目錄,完全不用寫程式。

- 高效快速: 用 C 語言寫的,效能很強。

- 靜態內容最佳: 適合文件站、部落格或大量檔案下載( 有教學)。

缺點: 不支援 JavaScript 或表單互動,只能下載原始頁面。可以當作靜態網站的數位吸塵器。

8. HTTrack:無程式碼離線瀏覽首選

是 Wget 的圖形化親戚,提供網站鏡像的視覺化操作。

為什麼選 HTTrack?

- 圖形介面簡單易用: 向導式流程,非技術用戶也能輕鬆上手。

- 離線瀏覽: 自動調整連結,讓你本地瀏覽完整網站。

- 存檔利器: 適合研究人員、行銷人員或想備份網站的人( 有討論)。

缺點: 不支援動態內容,大型網站速度較慢,不適合結構化資料萃取。

9. StormCrawler:即時分散式爬取首選

是現代分散式爬蟲,適合需要即時、持續大規模資料的團隊。

為什麼選 StormCrawler?

- 即時爬取: 基於 Apache Storm,能用資料流方式即時處理,適合新聞監控或搜尋引擎( 有介紹)。

- 模組化擴展: 可以依需求加入解析、索引、自訂處理模組。

- Common Crawl 採用: 是全球最大開放網頁資料集的新聞來源爬蟲。

缺點: 需要 Java 開發和 Storm 叢集經驗,適合有分散式系統背景的團隊。小型專案不建議。

開源 Firecrawl 替代方案比較:哪款免費競品最適合你?

這裡幫你整理 9 款工具的橫向比較:

| 工具 | 最佳應用情境 | 主要優勢 | 缺點 | 語言 / 安裝方式 |

|---|---|---|---|---|

| Scrapy | 大規模、頻繁爬取 | 強大、可擴展、社群龐大 | 學習曲線高,需 Python | Python 框架 |

| Apache Nutch | 企業級、網際網路規模爬取 | Hadoop 架構、規模驗證 | 安裝複雜、批次導向 | Java/Hadoop |

| Heritrix | 存檔、合規爬取 | 完整網站捕捉、WARC 輸出 | 重量級、不支援 JS、僅原始存檔 | Java 應用、網頁介面 |

| Colly | Go 開發、高效能爬取 | 快速、API 簡潔、高併發 | 不支援 JS,需 Go | Go 函式庫 |

| MechanicalSoup | 表單自動化、登入爬取 | 輕量、可維持 session | 不支援 JS、規模有限 | Python 函式庫 |

| Puppeteer | 動態/JS 密集網站 | 完整瀏覽器控制、自動化 | 資源消耗大,需 Node.js | Node.js 函式庫 |

| Wget | 靜態網站下載、離線存取 | 簡單、快速、命令列 | 不支援 JS、僅原始頁面 | 命令列工具 |

| HTTrack | 非技術用戶、網站存檔 | 圖形介面、離線瀏覽 | 不支援 JS、大型站點慢 | 桌面應用(GUI) |

| StormCrawler | 即時、分散式爬取 | 可擴展、模組化、即時處理 | 需 Java/Storm 專業知識 | Java/Storm 叢集 |

自己開發還是直接用現有開源 Firecrawl 替代方案?

老實說,自己寫爬蟲聽起來很帥,但等你卡在維護、代理、反爬蟲的泥沼時,就會知道開源工具的價值。這些工具都是社群多年經驗和最佳實踐的結晶。根據產業報告,直接用現有解決方案是最快、最穩定、最省力的方式( 有分析)。

- 適合用開源: 需求和現有工具吻合、想縮短開發時程、重視社群支援。

- 適合自建: 需求超特殊、團隊技術力夠強、爬蟲是業務核心。

但別忘了,開源雖然免費,實際上還有工程維護、伺服器、反爬蟲更新等隱性成本。如果你想要強大爬蟲但又不想寫程式,還有另一個選擇。

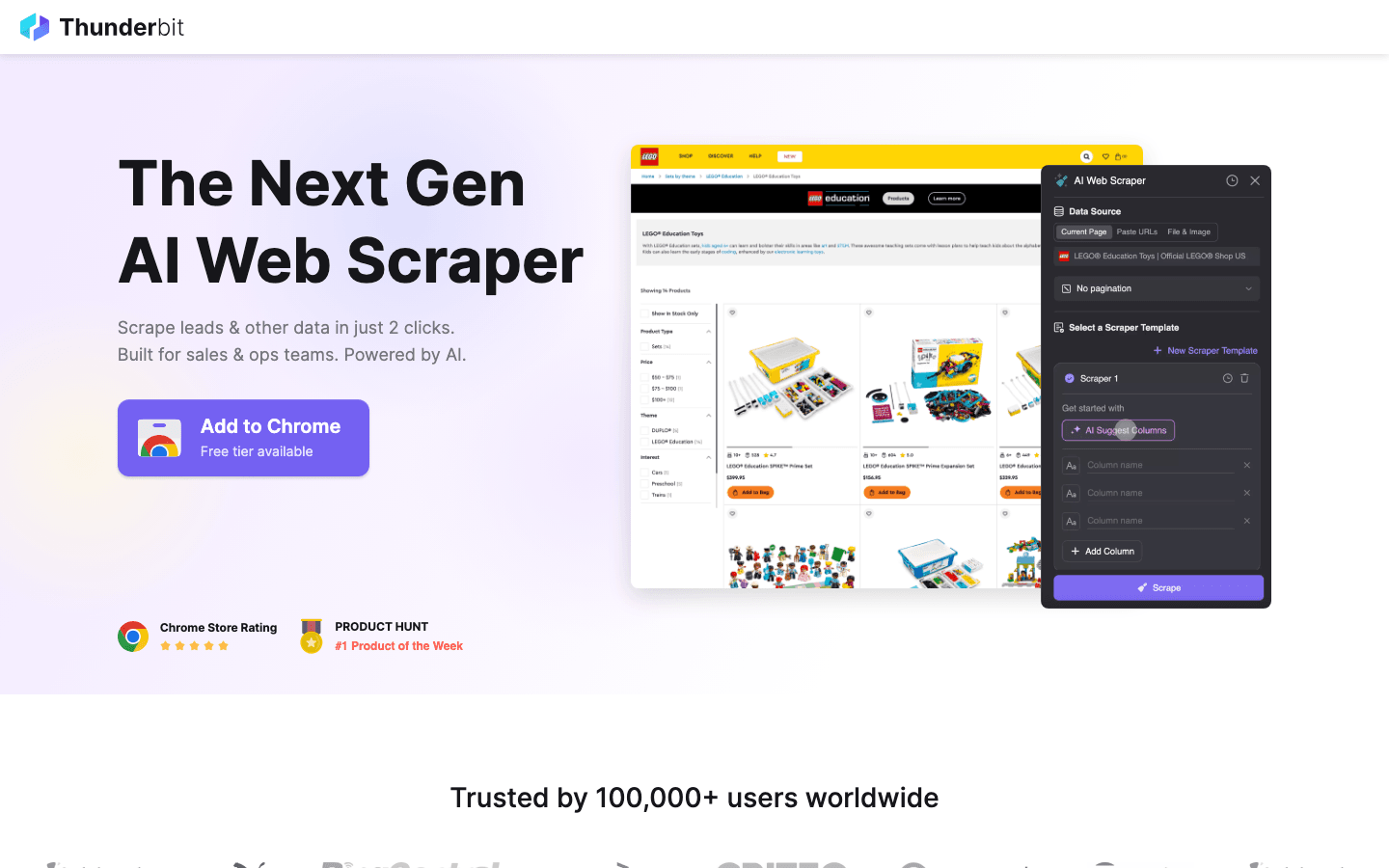

額外推薦:覺得開源太複雜?試試 Thunderbit

雖然上面這些工具對開發者很友善,但都要寫程式、面對 AI 反爬蟲也很吃力,維護成本也高。

是我最推薦給非技術用戶的解決方案。它結合強大爬取能力和極致易用性。

為什麼選 Thunderbit?

- 完全免寫程式: 不像 Scrapy 或 Puppeteer,Thunderbit 是 AI 驅動的 Chrome 擴充,只要點擊「AI 建議欄位」就能自動生成爬蟲。

- 自動處理複雜情境: 動態內容、無限滾動、分頁等難題都交給 AI 處理,省下大量自訂腳本時間。

- 即時匯出: 兩步驟就能把資料匯出到 Excel、Google Sheets 或 Notion。

- 免維護: 網站結構變動時不用手動更新,Thunderbit AI 會自動適應。

如果你是業務、行銷或研究人員,想要馬上取得資料又不想學 Python 或 Go,Thunderbit 絕對是開源工具的最佳補充。

想親自體驗? 試試看。

結論:2026 年自架型網頁爬蟲怎麼選?

現在開源 Firecrawl 替代方案比以前更豐富。不管你需要 Scrapy、Nutch 的大規模處理,還是 Heritrix 的完整存檔,都能找到適合的解決方案。重點是根據需求選工具——只要快速抓資料就別搞太複雜,要大規模爬取就別省小錢。

如果覺得開源太技術導向或維護負擔大,AI 工具像 Thunderbit 也能輕鬆補位。

準備好了嗎?下次大數據專案可以用 Scrapy,或直接,享受 AI 驅動的簡單爬取。想學更多網頁爬蟲技巧,歡迎來 深入探索。

常見問題

1. 使用開源 Firecrawl 替代方案的最大優勢是什麼? 開源方案彈性高、可自架又能自訂,能省下授權費用,還有活躍社群支援和持續更新,不怕被單一廠商綁死。

2. 哪個工具最適合非技術用戶快速取得結果? 是離線瀏覽的開源好選擇。但如果要抓結構化資料(像 Excel 表格),推薦額外工具 ,AI 功能更強大。

3. 如何處理動態、JavaScript 密集的網站? 最適合,能操控真實瀏覽器,抓所有用戶可見內容,包括 SPA 和 AJAX 載入頁面。

4. 什麼情況下該用 Apache Nutch 或 StormCrawler 這類重量級爬蟲? 當你需要跨多網域、數百萬頁面大規模爬取,或要即時、分散式爬取(像搜尋引擎、新聞監控),這些工具最適合。

5. 自己寫爬蟲好,還是用現有開源方案好? 大多數團隊直接用現有開源工具會更快、更省錢、更穩定。只有在需求超特殊又有長期維護能力時,才建議自建。

祝你爬蟲順利,資料永遠新鮮、結構化、隨時可用!

延伸閱讀